视频生成更高质量,更连贯!关键帧插值创新技术——Generative Inbetweening开源

文章链接:https://arxiv.org/pdf/2408.15239

git链接:https://svd-keyframe-interpolation.github.io/

亮点直击

- 关键帧插值的创新方法:提出了一种基于现有预训练图像到视频模型的适应方案,以解决关键帧插值问题,即在两个输入关键帧之间生成连贯的视频序列。

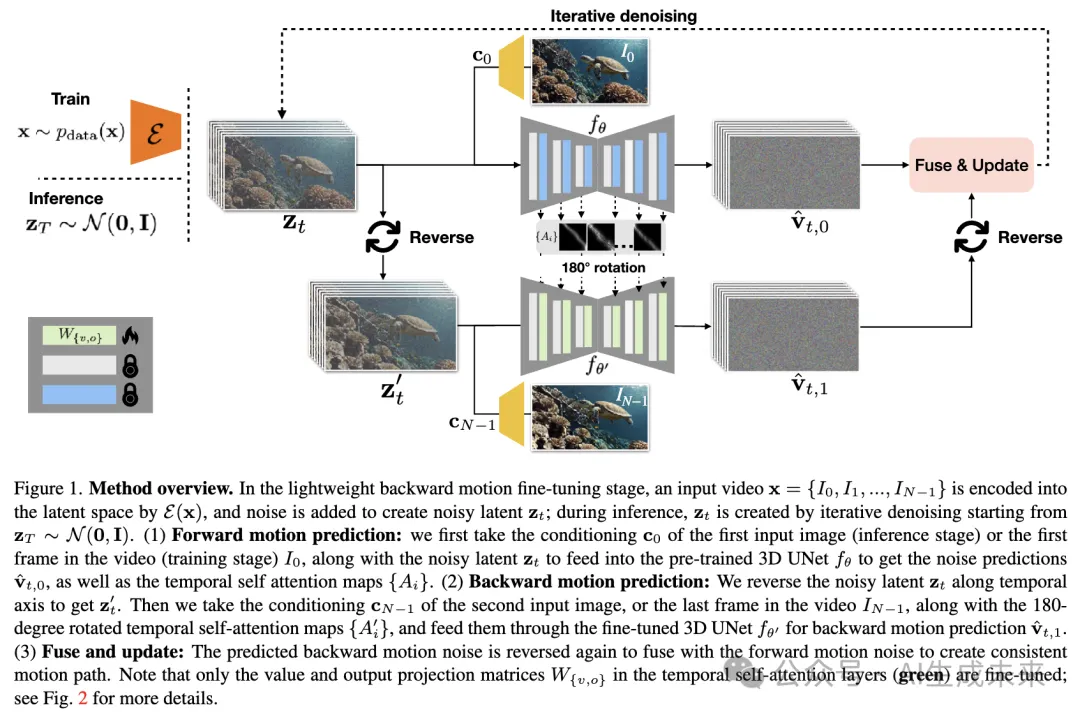

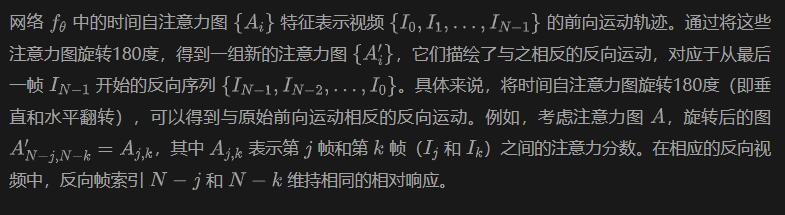

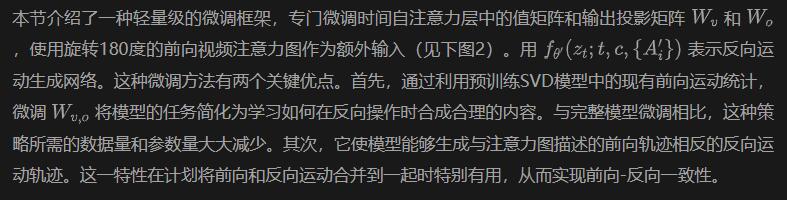

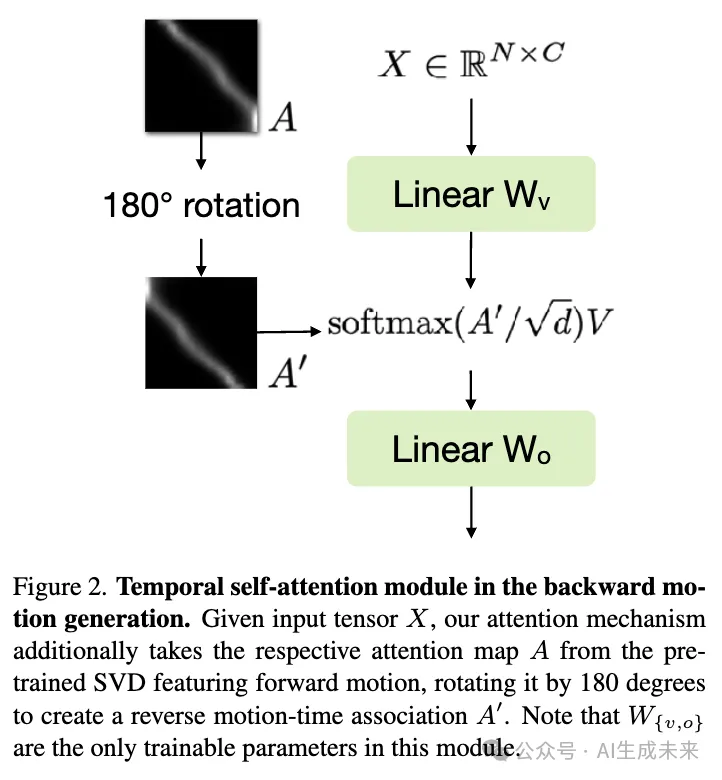

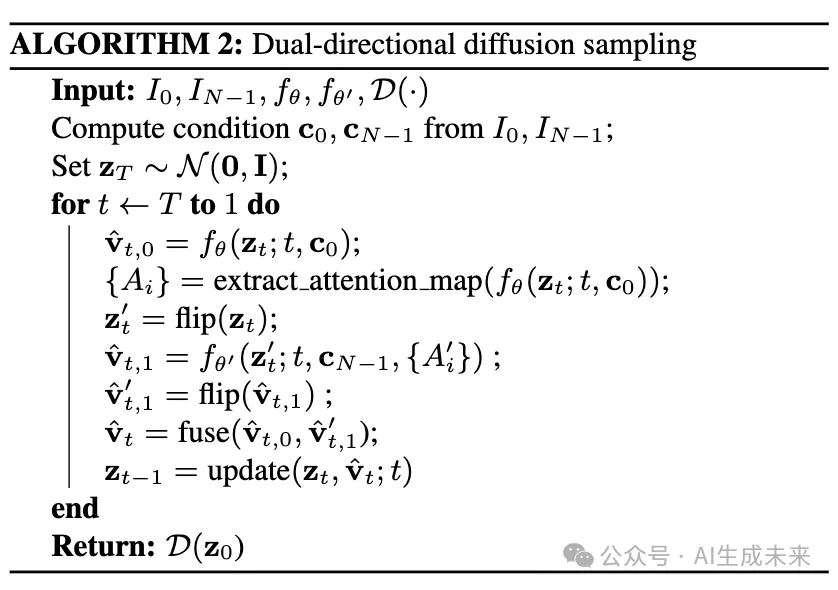

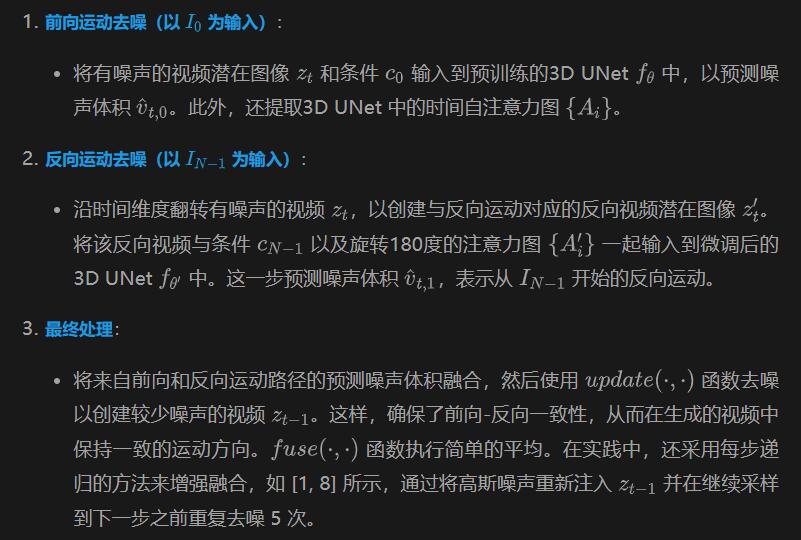

- 双向运动预测机制:开发了一种新的方法,通过将现有图像到视频模型微调为能够生成反向运动的视频,实现了从单一图像生成反向运动的视频。提出了一种轻量级的微调机制,通过旋转时间自注意力图来逆转时间流,从而在现有模型中引入反向运动的能力。

- 双向采样融合:提出了一个双向采样机制,将前向和反向运动的预测结果融合,以生成一个一致的、连贯的插值视频。这个机制通过共享的旋转时间自注意力图实现前后运动的一致性(“前向-反向运动一致性”)。

- 高质量视频生成:通过对比定性和定量的实验结果,证明了该方法在关键帧插值任务中比现有方法和传统技术生成的动态效果更高质量,更具连贯性。

总结速览

解决的问题

在给定的两个关键帧之间生成具有连贯运动的视频序列。

提出的方案

通过对一个预训练的大规模图像到视频扩散模型进行轻量级微调,将其适应为关键帧插值模型。这种适应使得模型可以生成在两个输入帧之间的视频序列。具体而言,将模型调整为从单一输入图像预测反向运动的视频,并结合原始前向运动模型,使用双向扩散采样过程来融合从两个关键帧出发的模型估计结果。

应用的技术

- 预训练大规模图像到视频扩散模型:原本用于从单一输入图像生成前向运动的视频。

- 轻量级微调:将预训练模型调整为能够生成从单一输入图像反向运动的视频。

- 双向扩散采样过程:结合前向和反向运动模型的估计结果来生成最终的视频序列。

达到的效果

该方法在生成视频序列时,比现有的扩散方法和传统的帧插值技术表现更好,能够在两个关键帧之间生成更连贯的运动。

方法

通过自注意力图旋转逆转运动时间关联

轻量级反向运动微调

双向采样与前向-反向一致性

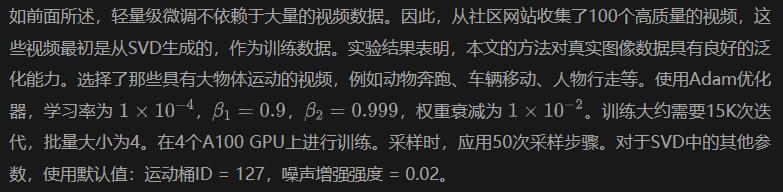

实施细节

实验

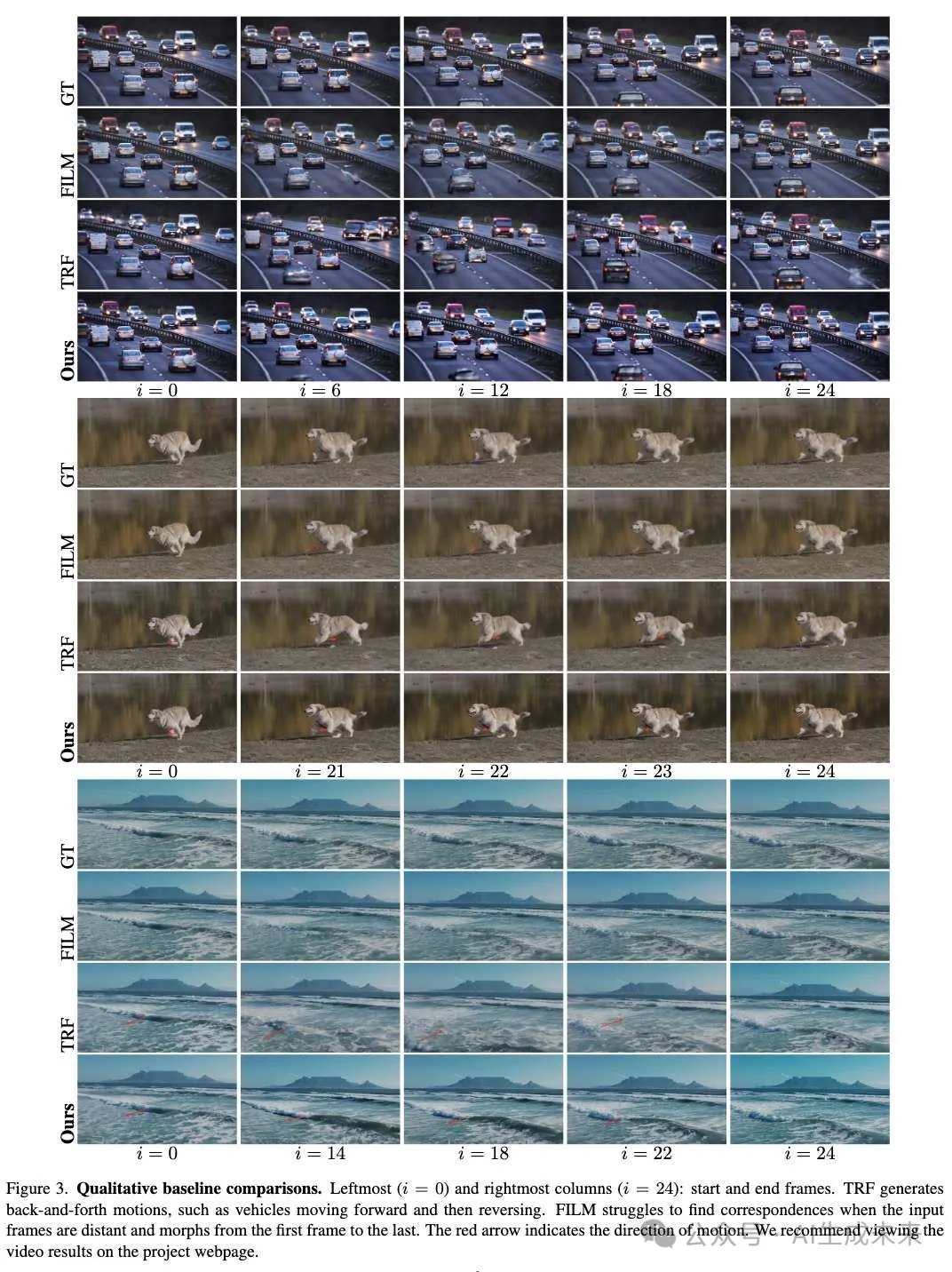

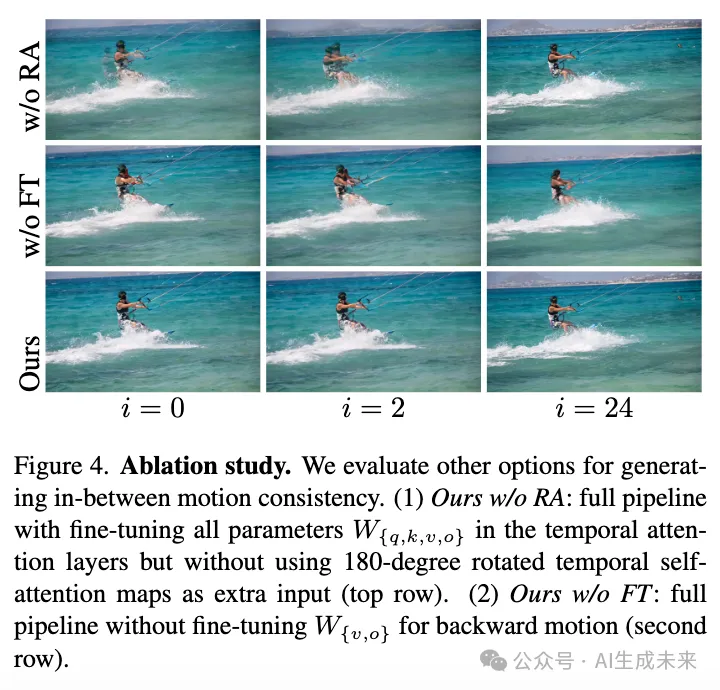

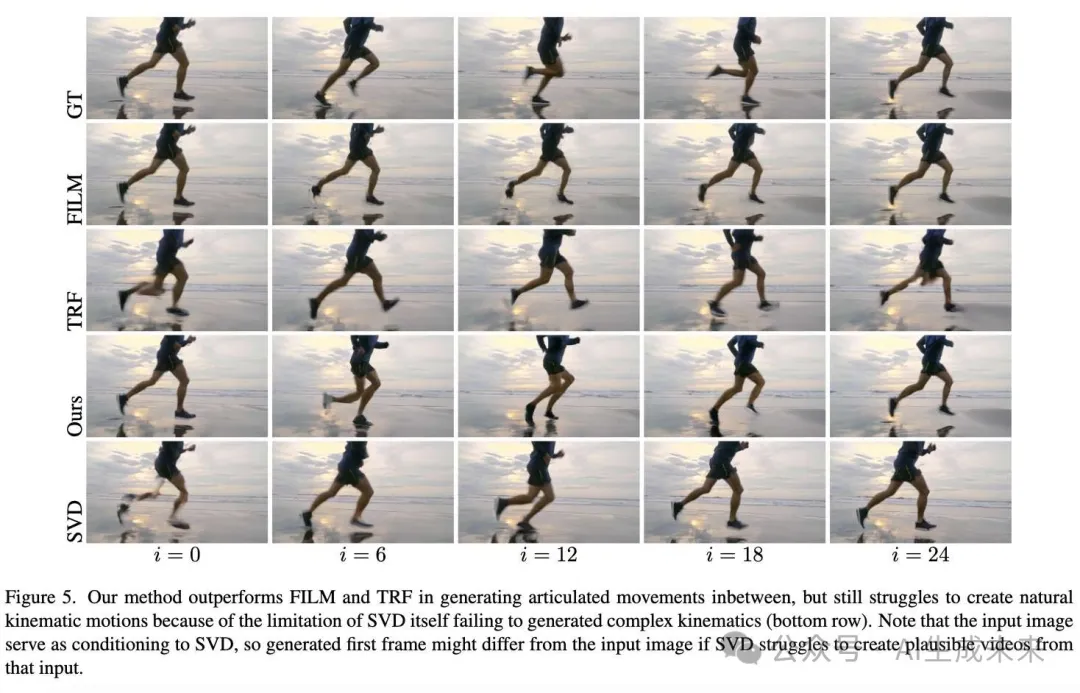

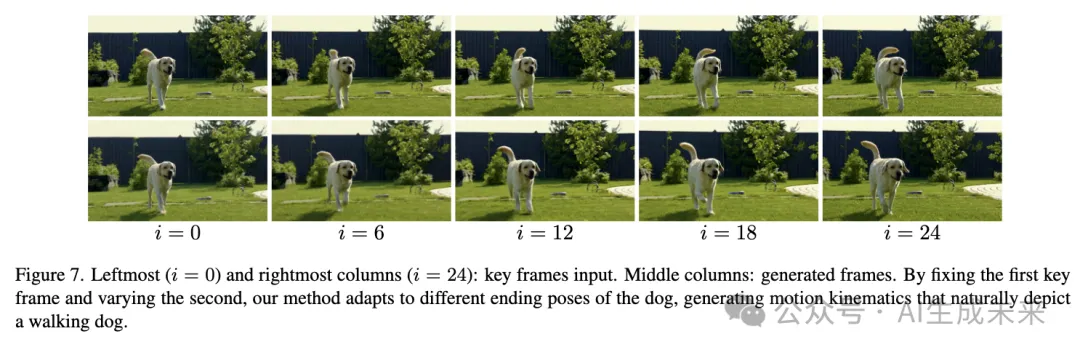

在下面图3、图4、图5、图7中,展示了本文的方法成功生成了高质量的视频,并且在不同时间捕捉动态场景的关键帧之间运动一致。强烈建议在项目页面上查看视频结果,以更清晰地看到结果。本章节先描述了用来评估本文的方法和基线的数据。再展示了本文的方法如何优于传统的帧插值方法FILM,以及最近的工作TRF,该工作也利用SVD进行视频生成。通过消融研究证明了本文的设计决策。以及讨论了本文的方法在最佳场景下的表现以及在亚最佳场景下的表现,即虽然优于基线但仍受SVD本身的限制。展示了本文的方法的适应性,通过固定第一个关键帧并变化第二个关键帧。最后讨论了失败案例。

评估数据集

使用了两个高分辨率(1080p)数据集进行评估:

- Davis数据集,从所有视频中创建了总共117对输入。这些数据集主要特征是对象的关节运动,例如动物或人类动作。

- Pexels 数据集,从Pexels上的高分辨率视频中收集了总共45对输入关键帧对,特征包括方向性的动态场景运动,例如车辆移动、动物、人物奔跑、冲浪、波浪运动和延时视频。所有输入对之间至少相隔25帧,并具有相应的真实视频片段。

Baseline比较

将本文的方法与FILM进行比较,FILM 是当前大规模运动帧插值方法的最新进展,和TRF,TRF 也适配了SVD进行有限生成。在上面图3和图5中展示了代表性的定性结果。此外,还包括了近期工作DynamiCrafter 的关键帧插值特性结果——这是一个大规模的图像到视频模型。关键帧插值特性经过修改,并特别训练以接受两个结束帧作为条件,而研究者们则专注于如何以轻量级的方式适配预训练的图像到视频模型,使用较小的训练视频集合和更少的计算资源。该特性生成分辨率为512X320的16帧视频,而生成分辨率为 1024X576。

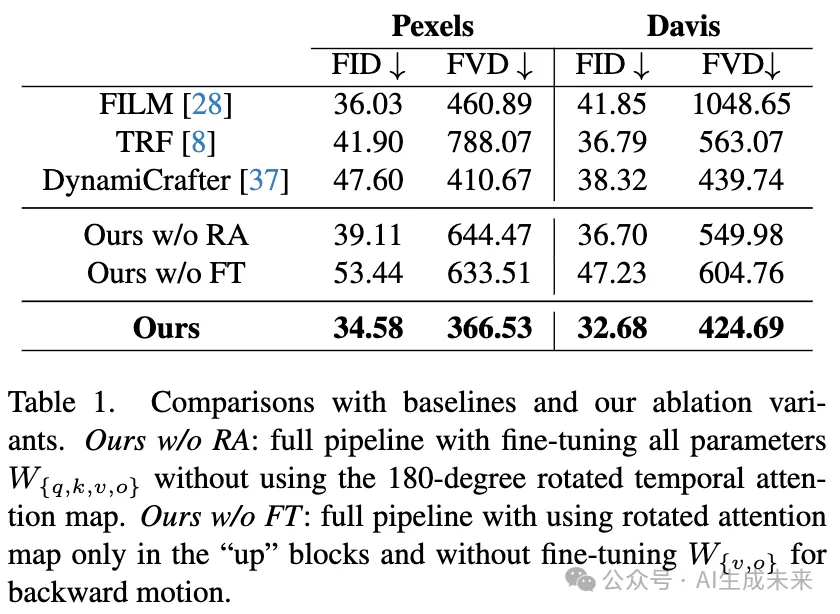

定量评估对于每个数据集,使用FID和 FVD来评估生成的视频。这两个指标用于衡量生成帧/视频与实际帧/视频之间的分布距离。结果如下表1所示,本文的方法在所有baseline方法中均显著优于其他方法。

与FILM的比较基于流的帧插值方法FILM面临两个主要问题。首先,它在处理大运动场景时很难找到对应关系。例如,在上面图3的第二行中,FILM在高速公路场景中无法找到移动汽车在输入关键帧之间的对应关系,导致中间帧的运动不自然。例如,一些汽车在第一帧中消失,在中间帧中消失,最后在结束时重新出现。其次,FILM生成的运动不明确,会沿最短路径在结束帧之间移动。在上图5中的示例中,给定两个看起来相似的帧,捕捉到的是一个人跑步的不同状态,FILM生成的运动仅仅是将人平移到帧之间,丧失了自然的腿部运动。

与TRF的比较 TRF结合了从第一帧开始的前向视频生成和从第二帧开始的反向视频生成,这两者都使用原始的SVD。第二帧的反向前向视频生成了一个反向运动视频,结束于第二帧。将这些生成路径融合在一起会导致生成的视频中出现往返运动。观察到TRF生成的视频有一个显著的效果,就是视频先向前推进,然后反向到结束帧。例如,在前面图3的第三行中,可以看到红色卡车随着时间的推移向后移动;在第七行中,狗的腿向后移动,导致不自然的运动。相比之下,本文的方法通过对SVD进行微调,从第二帧生成反向视频,与从第一帧生成的前向视频方向相反。这种前向-反向运动一致性导致生成的视频中运动保持一致。

消融实验

在前面图4和表1中,展示了本文方法的简化版本的视觉和定量比较,以评估本文方法关键组件的效果。

最佳和次佳场景

本文的方法受限于SVD所学习的运动质量和先验知识。首先,实验证明,SVD在生成刚性运动方面表现良好,但在处理非刚性、关节运动时表现不佳。它在准确渲染动物或人的肢体运动方面存在困难。在前面图5中,尽管本文的方法相比FILM和TRF有了显著改进,但与真实运动相比仍显得不自然。底部行展示了仅使用第一个输入帧生成的序列,确认了SVD本身在生成自然的跑步运动方面存在困难。

自适应中间帧生成

给定相同的第一个关键帧,并变化第二个关键帧,本文的方法仍能生成合理的视频,这得益于大规模图像到视频模型的丰富运动空间(见前面图7)。

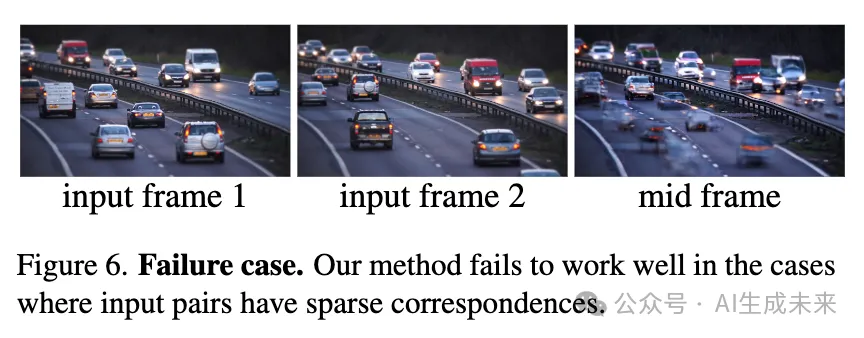

失败情况

当输入对的拍摄间隔过大,导致它们之间的对应关系稀疏时,如下图6所示,仅有一小部分汽车出现在两个输入帧中,本文的方法很难融合前向和反向运动。在重叠区域最小的情况下,会导致中间帧出现伪影。

讨论与局限性

本文的方法受限于SVD中的运动质量。另一个局限性是,SVD具有从输入图像中得出的强运动先验,往往只生成特定的运动。因此,连接输入关键帧所需的实际运动可能不会在SVD的运动空间中体现,从而使得合成合理的中间视频变得具有挑战性。然而,随着大型图像到视频模型如SoRA3的进展,对未来能够解决这些局限性持乐观态度。另一种潜在的改进是使用输入关键帧之间的运动启发式,以引导图像到视频模型生成更准确的中间运动。

本文转自 AI生成未来 ,作者:AI生成未来