腾讯&新加坡国立发布IFAdapter:即插即用,提升文生图模型实例特征和位置生成准确性 精华

文章链接:https://arxiv.org/pdf/2409.08240

项目链接:https://ifadapter.github.io/

亮点直击

- 提出了实例特征生成任务,旨在解决扩散模型在多实例生成中面临的定位和特征准确性问题。此外,引入了COCO IFG基准和验证pipeline,用于评估和比较模型性能。

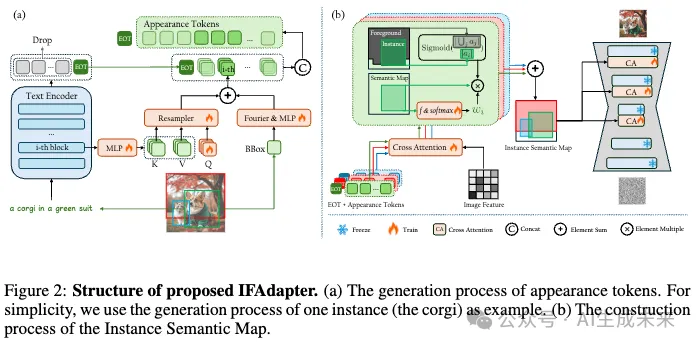

- 提出了IFAdapter,该模块利用新的外观tokens和实例语义图来增强扩散模型对实例的描绘,从而实现高保真度的实例特征生成。

- 全面的实验结果表明,本模型在定量和定性评估中均优于基线模型。

- IFAdapter设计为即插即用的组件,能够无缝增强各种社区模型的布局控制能力,无需重新训练。

总结速览

解决的问题:

传统的文本生成图像 (T2I) 扩散模型在生成单个实例时效果很好,但在多个实例的特征生成和准确定位上存在挑战。尽管布局生成图像 (L2I) 任务通过使用边界框提供空间控制来解决定位问题,但在实例特征的精确生成上仍然不足。

提出的方案:

为了解决这一问题,提出了实例特征生成 (IFG) 任务,旨在同时确保生成实例的准确定位和特征保真度。为此,引入了实例特征适配器 (IFAdapter) ,作为一种模块,能够在不同模型中灵活应用。该模块通过额外的外观tokens和实例语义图对齐实例特征与空间位置,从而增强特征表现。

应用的技术:

IFAdapter 利用了外观tokens来增强特征生成,并通过实例语义图将实例特征与空间位置对齐。这种方法可作为扩散过程中的模块,适配不同的社区模型。

达到的效果:

实验结果表明,IFAdapter 在定量和定性评估中均优于其他模型,有效提升了实例的定位准确性和特征保真度。同时,为此任务贡献了IFG 基准,并开发了验证pipeline,客观比较不同模型生成实例的能力。

方法

问题定义

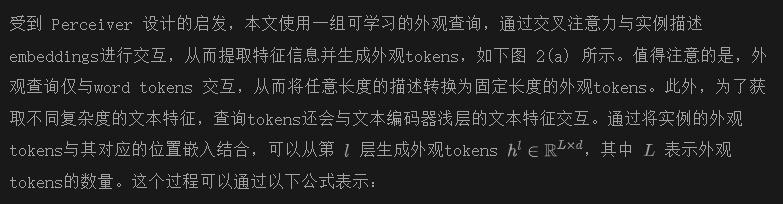

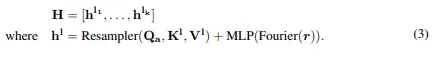

IFAdapter

在本工作中,IFAdapter 旨在控制实例特征和位置的生成。使用开源的Stable Diffusion 作为基础模型。为了解决实例特征丢失的问题,引入了外观tokens,作为高频信息的补充。此外,为了引入更强的空间先验,确保对位置和特征的准确控制,利用外观tokens构建了实例语义图,以引导生成过程。

外观tokens

L2I Stable Diffusion 通过引入局部描述和位置作为附加条件,具有丰富特征的实例。现有的方法通常使用预训练的 CLIP 文本编码器生成的上下文化token(即文本结束token,EoT token)来引导实例特征的生成。尽管 EoT token 在前景生成中起着关键作用,但主要用于生成粗略的结构内容,因此需要额外的标记来补充高频细节。因此,现有的 L2I 方法若丢弃其他所有标记,则无法生成详细的实例特征。

一种简单的缓解方法是使用 CLIP 文本编码器生成的所有 77 个 tokens作为实例级条件。然而,这种方法在推理和训练过程中都会显著增加内存需求。此外,这 77 个 tokens中包含大量的填充token,它们对生成没有贡献。虽然移除填充 token可以降低计算成本,但由于描述长度的不同,这种策略无法与批量训练兼容。为了解决这一问题,本文提出将特征信息压缩到一小组外观tokens中,并利用这些tokens来补充 EoT token。

实例语义图引导生成

除了确保生成详细的实例特征外,IFG 任务还要求在指定位置生成实例。先前的方法使用顺序锚定标记作为条件,这种方法缺乏强健的空间对应性,可能会导致特征错位或泄漏等问题。因此,引入了一种名为实例语义图 (ISM) 的地图,作为更强的引导信号。由于所有实例的生成都由 ISM 引导,在构建该语义图时必须考虑两个主要问题:

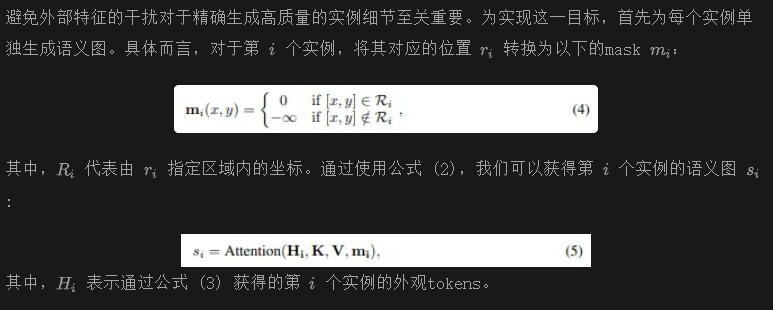

- 为每个实例生成详细且准确的特征,同时避免特征泄漏;

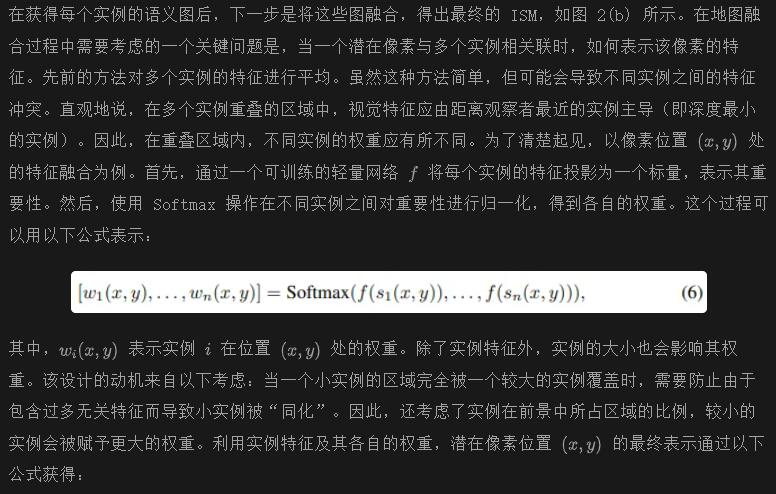

- 处理多个实例存在的重叠区域。

为了解决这些问题,首先独立生成每个实例,然后在重叠区域进行聚合。以下部分将详细解释这些过程。

单实例特征生成

门控语义融合

学习过程

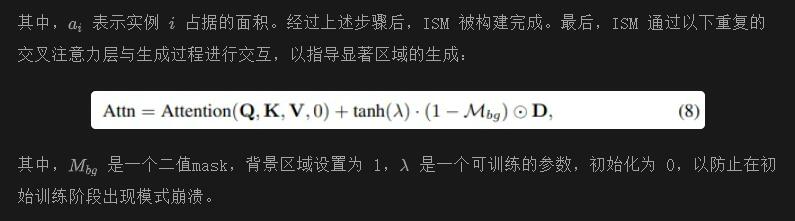

在训练过程中,冻结了 SD 的参数,仅训练 IFAdapter。用于训练的损失函数是包含实例级条件的 LDM 损失:

为了使本文的方法在推理阶段执行无分类器引导 (CFG),在训练期间将全局条件y和局部条件c随机设置为 0。

实验

实施细节

训练数据集。使用 COCO2014数据集和 LAION 5B 的 100 万子集作为数据来源。利用 Grounding-DINO和 RAM对图像中的实例位置进行标注。然后,我们使用最先进的视觉语言模型 (VLMs) QWen和 InternVL为图像和单个实例生成标题。

训练细节。使用 SDXL,因其强大的细节生成能力,作为我们的基础模型。IFAdapter 应用于 SDXL 的中层和解码器层的子集,这些层对前景生成贡献显著。使用 AdamW优化器,以学习率 0.0001 训练 IFAdapter 100,000 步,批量大小为 160。在训练过程中,有 15% 的概率丢弃局部描述,30% 的概率丢弃全局标题。

在推理阶段,使用 EulerDiscreteScheduler进行 30 次采样步骤,并将无分类器引导 (CFG) 比例设置为 7.5。

实验设置

Baselines

将本文的方法与先前的 SOTA L2I 方法进行了比较,包括基于训练的方法 InstanceDiffusion、MIGC和 GLIGEN,以及无训练方法 DenseDiffusion和 MultiDiffusion。

评估数据集

按照先前的设置(Li et al., 2023; Zhou et al., 2024b; Wang et al., 2024c),在标准的 COCO2014 数据集上构建了 COCO IFG 基准。具体而言,使用与训练数据相同的方法对验证集中的位置和局部描述进行标注。每种方法都需要生成 1,000 张图像进行验证。

评估指标

对于 IFG 任务的验证,模型必须生成具有准确特征的实例,并在适当的位置生成。

- 实例特征成功率

- Frechet Inception Distance (FID)

- 全局 CLIP 分数

比较

定量分析

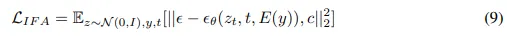

下表 1 展示了在 IFG 基准上的定性结果,包括 IFS 率、空间准确性和图像质量的指标。

IFS 率

为了计算 IFS 率,我们利用了三个最先进的视觉-语言模型 (VLMs):QWenVL、InternVL 和 CogVL。这种多模型方法确保了更全面和严格的验证。如上表 1 所示,本文的模型在所有三个 IFS 率指标上均优于基线模型。引入外观tokens和在训练中纳入密集实例描述显著提升了我们模型生成准确实例细节的能力。值得注意的是,InstanceDiffusion 在 IFS 率上表现优于其他基线模型。这可能是因为其训练数据集也包含了密集的实例级描述。这一观察进一步强调了高质量实例级标注的必要性。

空间准确性

如上表 1 所示,IFAdapter 在 GroundingDINO AP 中取得了最佳结果。这一成功归因于地图引导生成设计,该设计结合了额外的空间先验,从而实现了更准确的实例位置生成。

图像质量

如前面表 1 所示,本文的方法在 CLIP 评分上表现更高,表明增强局部细节有助于图像与标题一致性的同时提高。此外,本文的方法实现了更低的 FID,说明本文的方法生成的图像质量高于基线模型。将这一改善归因于本文模型的适配器设计,该设计使得在不显著妨碍图像质量的情况下实现空间控制。

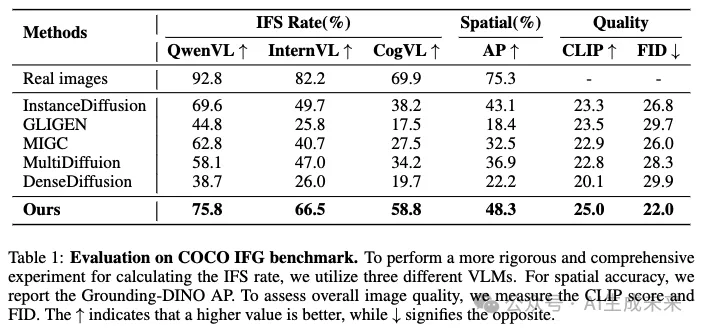

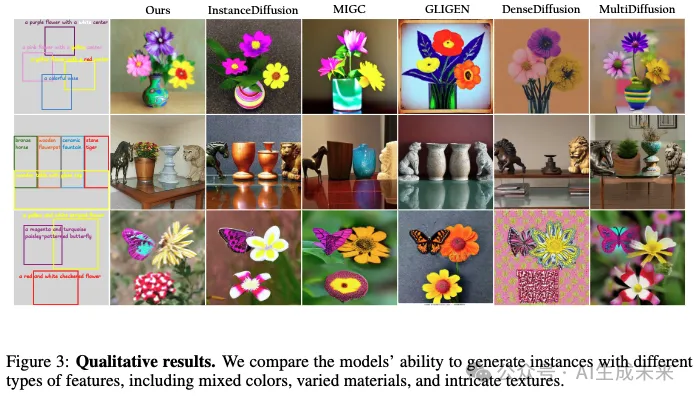

定性分析

在下图 1(a) 中,我们展示了生成的具有多个复杂实例的场景结果。研究者们进一步在下图 3 中评估了模型生成多样化特征实例的能力。如所示,本文的方法在各种实例细节的保真度方面表现最佳。

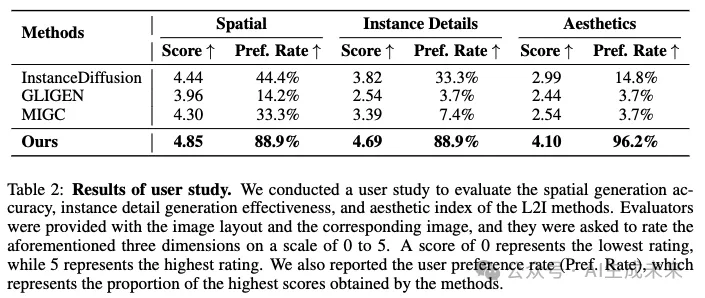

用户研究

尽管 VLMs 可以在一定程度上验证实例细节,但与人类感知相比仍存在差距。因此,邀请了专业标注员进行进一步验证。

设置

进行了一个包含 270 个问题的研究,每个问题都关联到一个随机抽样的生成图像。评估者被要求对图像质量、实例位置准确性和实例细节进行评分。总共收集了 30 个有效响应,产生了 7,290 个评分。

结果

如下表 2 所示,本文的方法在所有三个维度上都达到了最高的分数和用户偏好率。值得注意的是,这些维度的趋势与表 1 中的结果一致,进一步证明了 VLM 验证的有效性。

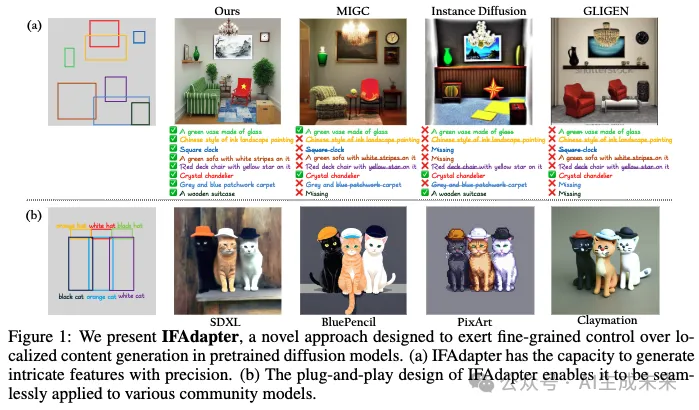

与社区模型的集成

由于 IFAdapter 的即插即用设计,它可以对预训练的扩散模型施加空间控制,而不会显著影响生成图像的风格或质量。这使得 IFAdapter 能够有效地与各种社区扩散模型和 LoRAs集成。如下图 4 所示,将 IFAdapter 应用到几个社区模型,包括 PixlArt、LeLo-LEGO、Claymation和 BluePencil。生成的图像不仅符合指定的布局,而且准确反映了各自的风格。

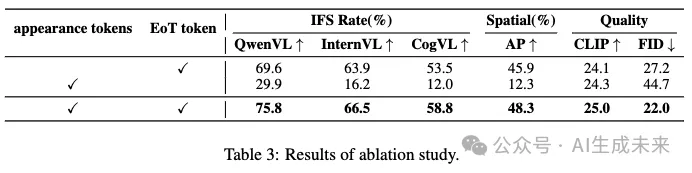

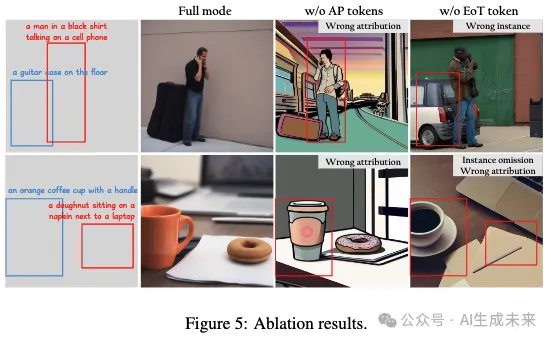

消融研究

本文引入外观tokens以解决 EoT tokens在生成高频细节方面的不足。这个消融研究主要探讨了这两种标记类型在实例生成中的作用。

appearance tokens. 如下表 3 所示,去除外观tokens会导致模型的 IFS 率和 FID 下降,表明详细特征的丢失。此外,如下图 5 所示,没有外观tokens生成的图像表现出实例特征的不匹配,进一步证明了外观tokens主要负责生成高频外观特征。

EoT token. 在没有 EoT token的情况下生成图像时,IFS 率显著下降。这主要是因为 EoT token负责生成实例的粗略语义。此外,上图 5 指出,去除 EoT token会导致语义级别的问题,如实例类别错误和实例遗漏。

结论

本文提出了 IFAdapter,以对预训练的 Stable Diffusion 模型进行细粒度的实例级控制。通过引入外观tokens,增强了模型生成详细实例特征的能力。利用外观tokens构建实例语义图,将实例级特征与空间位置对齐,从而实现了强大的空间控制。定性和定量结果都表明本文的方法在生成详细实例特征方面表现出色。此外,由于其即插即用的特性,IFAdapter 可以作为插件无缝集成到社区模型中,而无需重新训练。

本文转自 AI生成未来 ,作者: AI生成未来