Open LLM集中爆发的一周,卷疯了!

开源大模型领域热闹非凡的一周,各种开源,PaperAgent进行了概括:端侧、Code、RAG、Agent、Reflection(反思纠正)、MoE,你关注的都在这里了。

Reflection Llama-3.1-70B 开源

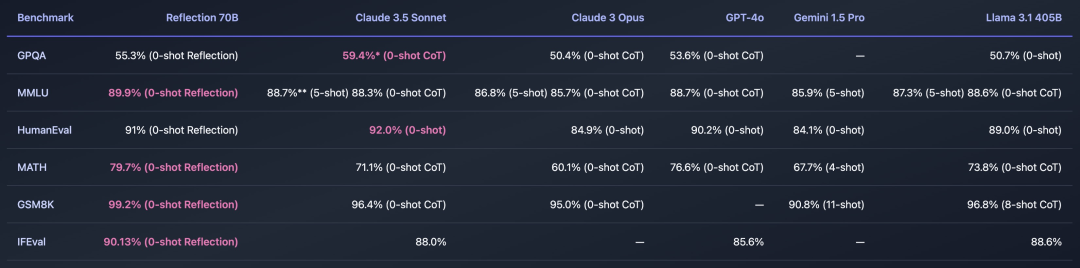

Reflection Llama-3.1 70B是世界上顶尖的Open LLM,通过反思微调技术(Reflection-Tuning)训练,能够检测并纠正推理错误,具有很高的热度,Hugging Face热门排行Top1。

Agent中需要LLM具有很强的推理规划能力,这种反思技术训练的模型是否很契合Agent尼?有待进一步验证

- 该模型使用Glaive生成的合成数据进行训练,Glaive是一个强大的模型训练工具。

- 模型可以通过特定的代码和管道进行采样,使用与标准Llama3.1相同的聊天模板格式。

- 采样时,模型会先在<thinking>标签内输出推理过程,然后使用<reflection>标签修正错误,最后在<output>标签内提供最终答案。

- 这种设计使得模型能够区分内部思考和最终答案,提升用户体验。

从实验对结果看,是击败GPT-4o、Claude 3.5 Sonnet,遥遥领先的,更强405B版本预计下周推出,非常期待

https://hf-mirror.com/mattshumer/Reflection-Llama-3.1-70B面壁小钢炮MiniCPM 3.0开源

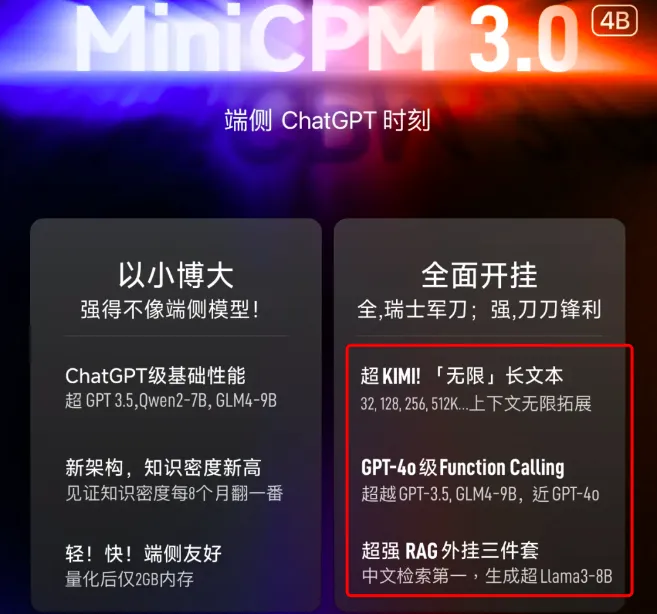

面壁智能开源新一代全面开挂的小钢炮,4B规模达到ChatGPT级能力:

- 长文本方向:无限长文本,榜单性能超Kimi,超长文本也不崩。

- Function Calling方向:性能比肩GPT-4o ,端侧最强,超越 GLM-4-9B-Chat、Qwen2-7B-Instruct。

- RAG 方向:超强 RAG 外挂三件套,基于 MiniCPM 系列模型的MiniCPM-Embedding、MiniCPM-Reranker在中文、中英跨语言检索测试中取得 SOTA 表现;针对 RAG 场景的 MiniCPM3-RAG-LoRA 在开放域问答等多项任务上超越 Llama3-8B、Baichuan2-13B 等模型。

https://github.com/OpenBMB/MiniCPM

https://huggingface.co/openbmb/MiniCPM3-4B零一万物Yi-Coder系列模型开源

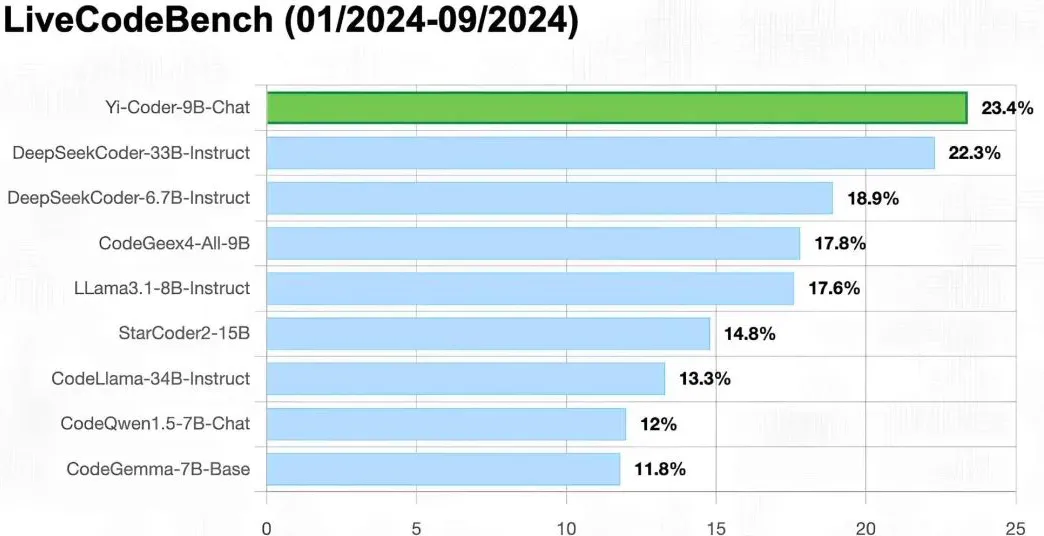

Yi-Coder 有两种规模——15亿和90亿参数——提供基础版和聊天版,旨在实现高效的推理和灵活的训练。值得注意的是,Yi-Coder-9B 在 Yi-9B 的基础上,额外增加了2.4万亿高质量的标记,这些标记精心挑选自 GitHub 上的代码库级别的代码语料库,以及从 CommonCrawl 筛选出的与代码相关的数据。

Yi-Coder 的关键特性包括:

- 在52种主要编程语言上的2.4万亿高质量标记上继续预训练。

- 长上下文建模:最大上下文窗口为128K标记,能够实现项目级别的代码理解和生成。

- 小巧但强大:Yi-Coder-9B 在性能上超越了其他参数少于100亿的模型,如 CodeQwen1.5 7B 和 CodeGeex4 9B,甚至达到了与 DeepSeek-Coder 33B 相当的性能水平。

https://hf-mirror.com/01-ai/Yi-Coder-9B-Chat

https://hf-mirror.com/01-ai/Yi-Coder-1.5B-Chat

https://01-ai.github.io/blog.html?post=en/2024-09-05-A-Small-but-Mighty-LLM-for-Code.mdDeepSeek-V2.5版本发布

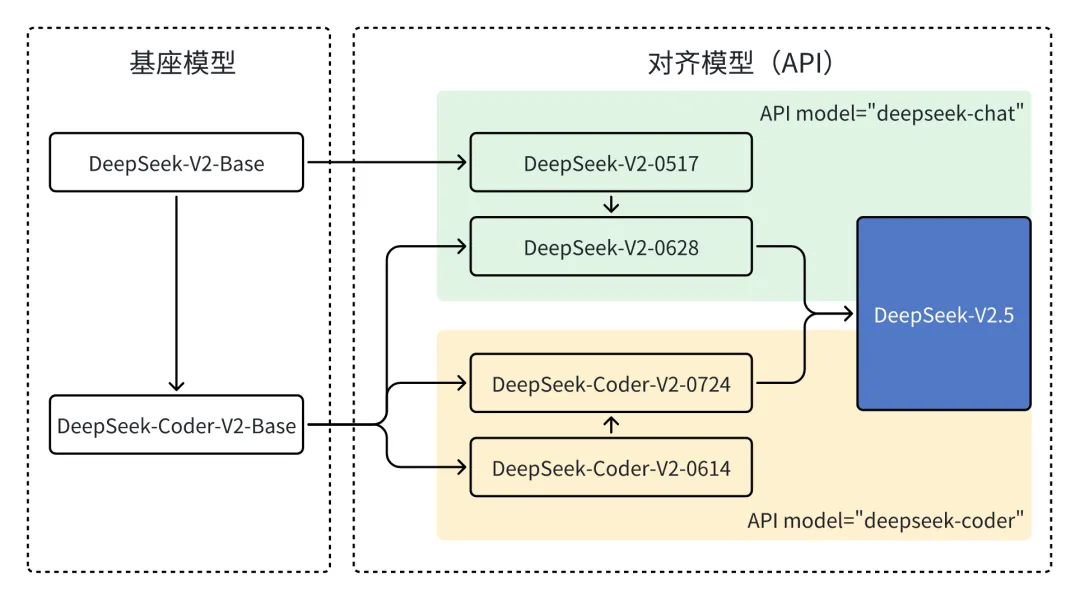

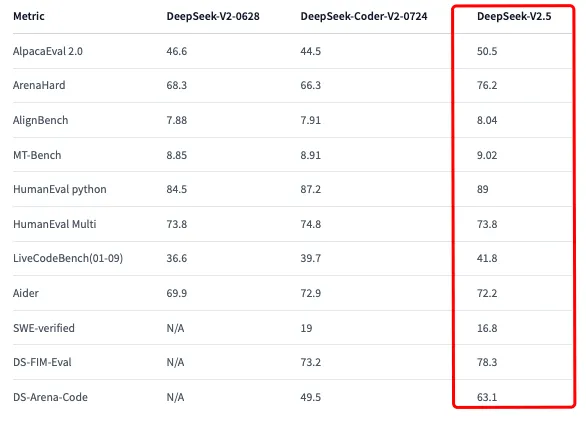

DeepSeek-V2.5 是一个升级版本,它结合了 DeepSeek-V2-Chat 和 DeepSeek-Coder-V2-Instruct。这个新模型整合了前两个版本的通用和编码能力。

DeepSeek-V2.5 更好地符合人类的偏好,并在多个方面进行了优化,包括写作和指令遵循:

https://hf-mirror.com/deepseek-ai/DeepSeek-V2.5首个完全开源MoE大模型:OLMoE

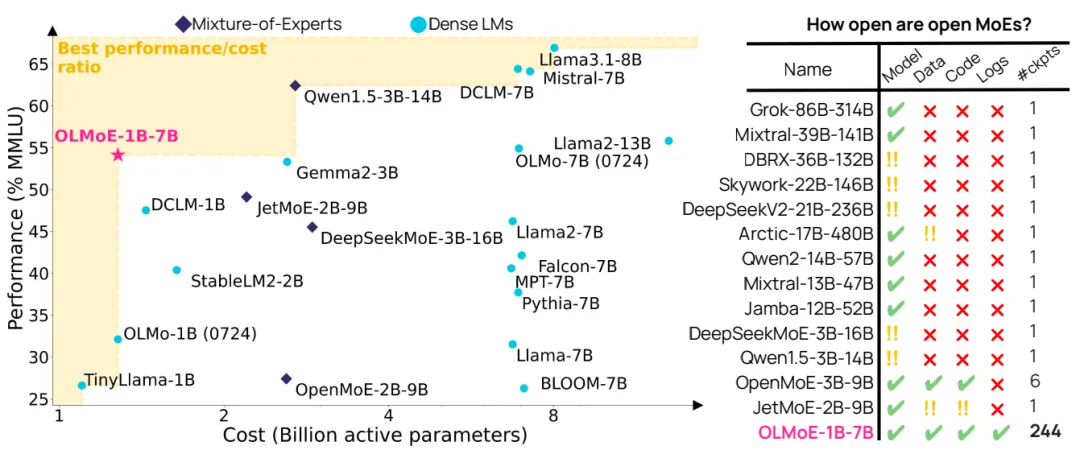

OLMoE-1B-7B 是一个具有10亿活跃参数和70亿总参数的专家混合(Mixture-of-Experts)大型语言模型(LLM),于2024年9月(0924)发布。它在成本相似(10亿)的模型中提供了最先进的性能,并且与像 Llama2-13B 这样的更大模型具有竞争力。OLMoE 是100%开源的。

开放 MoE 和密集型语言模型(LMs)的性能、成本和开放程度

checkpoints: https://huggingface.co/allenai/OLMoE-1B-7B-0924

paper: https://arxiv.org/pdf/2409.02060

code:https://github.com/allenai/OLMoE

data:https://huggingface.co/datasets/allenai/OLMoE-mix-0924

logs:https://wandb.ai/ai2-llm/olmoe/reports/OLMoE-1B-7B-0924--Vmlldzo4OTcyMjU3本文转载自 PaperAgent,作者: PaperAgent