大型语言模型的知识融合(ICLR2024) 原创

摘要: 从头开始训练大型语言模型(LLM)可以生成具有独特功能和优势的模型,但这需要巨大的成本,并可能导致冗余功能。另一种具有成本效益且引人注目的方法是将现有的预训练LLM合并为一个更强大的模型。然而,由于这些LLM架构各不相同,直接融合它们的权重并不可行。在本文中,我们引入了LLM知识融合的概念,旨在将现有LLM的能力整合并转移到一个单一的LLM中。通过利用源LLM的生成分布,我们外化了它们的集体知识和独特优势,从而有可能将目标模型的能力提升到超越任何单一源LLM的水平。我们使用三种具有不同架构的流行LLM——Llama-2、MPT 和 OpenLLaMA——在各种基准和任务中验证了我们的方法。我们的研究结果表明,LLM的融合可以提高目标模型在推理、常识和代码生成等多种能力上的表现。我们的代码、模型权重和数据已公开在(https://github.com/fanqiwan/FuseLLM)。

(论文思想:假设我们有三个大型语言模型(LLMs):Llama-2、OpenLLaMA和MPT,它们分别擅长不同任务。Llama-2在推理任务中表现最佳,OpenLLaMA在常识问答上表现出色,而MPT在代码生成方面非常强大。

现在,我们希望通过FUSELLM方法将这三个模型的知识融合到一个新的目标模型中,让这个目标模型同时具备这三种能力。以下是FUSELLM方法如何工作的一个简化示例:

1. 概率分布提取:我们提供一个文本序列,比如 `"The capital of France is..."`,让Llama-2、OpenLLaMA和MPT分别预测下一个单词是什么,并生成它们的概率分布。Llama-2可能对“Paris”有较高的概率,OpenLLaMA对“Paris”也有类似的预测,而MPT虽然更擅长代码生成,但也会给出一个相对较低的概率。

2. 词汇对齐:由于每个模型使用的分词器可能不同,我们需要对齐它们生成的tokens,确保这些模型的输出可以被比较和融合。例如,如果一个模型预测的是“Paris”,而另一个模型可能将其分为两个token:“Par-” 和 “-is”,我们通过最小编辑距离对齐这些token。

3. 概率融合:我们将三个模型的概率分布进行融合。假设Llama-2和OpenLLaMA在常识问答中表现较好,它们的预测权重会更高。我们选择使用MinCE方法,也就是选择具有最小交叉熵分数的模型概率分布,因此目标模型会倾向于使用Llama-2和OpenLLaMA的预测。

4. 持续训练:接着,我们用这些融合后的概率分布来指导目标模型的训练,通过最小化目标模型的预测与融合分布之间的差异,让目标模型逐步学习这三个模型的能力。

最终,目标模型经过持续训练,不仅可以像Llama-2那样擅长推理,还能像OpenLLaMA一样处理常识问题,并在代码生成任务上有类似MPT的表现。这个融合后的模型将具备更广泛的能力,能够在多种任务中表现出色。)

1、引言

随着大型语言模型(LLMs)如GPT(Brown et al., 2020)和LLaMA(Touvron et al., 2023)系列在各种自然语言处理(NLP)任务中的持续成功,开发属于自己的LLM已成为公司战略的关键。然而,LLM开发成本极其高昂。除了需要大量的训练数据、高级技术、巨大的计算资源和熟练的劳动力外,开发过程还对能源消耗和环境造成巨大压力(Rillig et al., 2023)。虽然这些LLMs在结构和功能上有所不同,但它们在一系列NLP任务上有着相似的能力。因此,除了从零开始训练LLM的传统方法外,还有一种替代选择是将现有的LLM组合成一个新的、更强大的模型,本文称之为LLM的知识融合。如果成功,这种融合不仅可以降低初始训练成本,还能使集成模型受益于所有LLM的优势。该新模型也可以通过微调和适应各种下游任务。此外,融合也可以发生在专注于特定任务的微调LLM之间。

整合多个模型能力的尝试由来已久。例如,集成方法(Littlestone & Warmuth, 1994; Jiang et al., 2023)直接聚合不同模型的输出,以增强预测性能和鲁棒性。然而,这种方法需要维护多个训练好的模型,并在推理时执行每一个模型,这对于LLM来说是不可行的,因为它们需要大量的内存和推理时间。同样,这种方法不支持微调,而微调对于许多LLM来说至关重要。另一种方法是通过参数级的算术操作直接将多个神经网络合并为一个网络(Wortsman et al., 2022; Jin et al., 2022)。这种方法通常假设网络架构统一,并尝试在不同神经网络权重之间建立映射,但在LLM的上下文中,这往往是难以实现的。此外,当参数空间存在较大差异时,权重融合可能会导致次优结果(Li et al., 2022)。

在本文中,我们从概率分布的角度探讨LLM的融合。对于一个输入文本,我们认为不同源LLM生成的概率分布可以反映它们对该文本的固有知识。因此,提出的FUSELLM方法利用源LLM的生成分布,将它们的集体知识和个体优势外化,并通过轻量级的持续训练将这些知识转移到目标LLM中。为此,我们开发了一种新策略,用于对齐来自不同LLM的分词,并探索了两种融合这些多样化LLM生成的概率分布的方法。在持续训练过程中,FUSELLM非常重视最小化目标LLM的概率分布与源LLM的概率分布之间的差异。

为了实证证明FUSELLM的有效性,我们在一个具有挑战性但通用的LLM融合场景中进行实验,其中源模型之间的共性最小。具体来说,我们重点关注三个具有不同架构和功能的流行开源LLM:Llama-2(Touvron et al., 2023)、OpenLLaMA(Geng & Liu, 2023)和MPT(Team, 2023)。通过对跨越推理、常识和代码生成的三个基准共42个任务的评估,验证了我们的方法训练出的目标模型在大多数任务中都优于每个源LLM和基线。此外,我们通过在多个特定领域语料库上持续训练单个基础模型,模拟了具有相同架构但功能不同的LLM的存在。根据困惑度(perplexity)的评估结果表明,FUSELLM在将这些结构相同的LLM的能力组合起来时,表现出比传统的集成和权重融合方法更强的潜力。

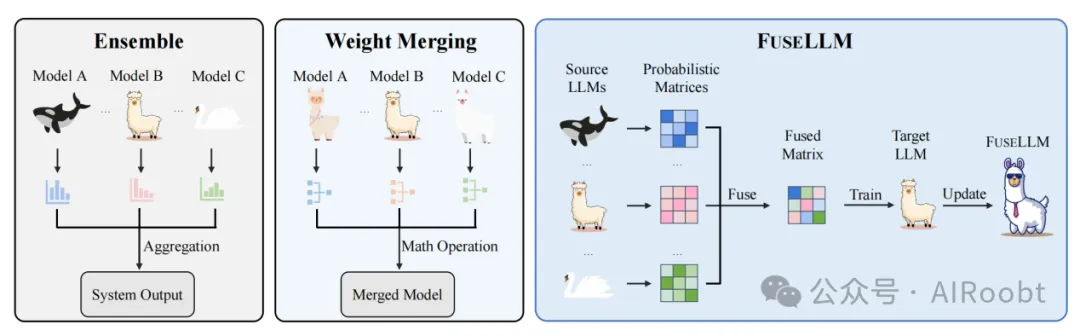

总而言之,本文探讨了一个新的挑战,即LLM的融合,旨在创建一个能够有效利用多样化LLM集体能力和独特优势的统一模型。如图1所示,我们提出的方法区别于传统的集成和权重融合技术,通过优先外化和转移多个LLM的知识进行融合。本研究得出了一些可能引发未来研究的发现。首先,尽管我们通过轻量级的持续训练在紧凑、高质量的语料库上展示了我们方法的有效性,但训练语料库的精心选择可能是一个关键考虑因素,尤其是其与下游任务的相关性。其次,在源LLM能力差异显著的情况下,融合功能对于有效结合各自的优势至关重要。最后,与传统的模型集成和融合技术相比,LLM融合领域似乎是一条更具探索前景的途径,特别是在考虑到LLM的多样化结构和巨大的模型规模时。

图1:展示了传统模型融合技术(集成和权重合并)以及我们针对大型语言模型(LLMs)的知识融合方法(FUSELLM)。不同的动物图标代表不同的LLMs,不同种类表示拥有不同架构的LLMs。FUSELLM将多个LLMs的知识外化,并将它们的能力转移到目标LLM上。

2、相关工作

模型融合

整合不同模型的能力一直是一个长期的目标,现有的方法主要分为两类。首先,传统的模型集成技术通过结合多个模型的输出来增强系统整体性能(Littlestone & Warmuth, 1994;Sagi & Rokach, 2018)。需要注意的是,这种技术并不涉及将多个模型显式地合并为一个新模型。常见的模型集成方法包括加权平均(Littlestone & Warmuth, 1994)或多数投票(Monteith et al., 2011),以整合不同模型的预测结果。最近,Jiang等人(2023)引入了一个集成框架,旨在利用多个开源LLM的多样化优势。该框架首先使用成对比较方法来检测候选输出之间的细微差异,随后结合最优的候选结果以产生增强的输出,发挥其优势并减少其劣势。

其次,权重融合是另一种通过参数层面实现模型融合的方法。Gupta等人(2020)和Wortsman等人(2022)通过不同策略或配置获得的具有相同结构的模型权重进行融合,以提高整体性能。同样,Cha等人(2021)、Rame等人(2022)和Arpit等人(2022)通过加权平均不同配置的模型来提高分布外(out-of-distribution)的泛化能力。此外,Jin等人(2022)将为特定领域或任务设计的模型融合在一起,以创建能够处理所有领域或任务的通用模型。除了对整个模型进行参数融合之外,Wang等人(2022b)、Huang等人(2023)和Zhang等人(2023)还应用线性数学运算对适配器参数进行融合,以实现更好的泛化性能。

总而言之,虽然模型集成需要并行部署多个模型,权重融合通常仅限于结构相同的模型。相比之下,本文提出的方法支持通过显式转移其知识和能力,将具有不同架构的多个LLM进行融合。

知识蒸馏

知识蒸馏(Hinton et al., 2015)最初提出用于模型压缩,它包括在一个或多个教师模型的指导下训练学生模型。在NLP领域,知识蒸馏广泛应用于文本分类任务中。这些应用包括训练学生模型以复制教师模型的输出分布(Sanh et al., 2019;Turc et al., 2019),以及教师模型中间层提取的特征(Sun et al., 2019;Jiao et al., 2020)和关系(Wang et al., 2020)。在文本生成领域,传统方法侧重于最小化学生模型和教师模型生成分布之间的KL散度。这是通过使用教师在每个时间步的概率分布作为监督来实现的(Khanuja et al., 2021;Gu et al., 2023),或者直接在教师生成的文本上进行训练(Peng et al., 2023;Xu et al., 2023)。

尽管我们的方法框架类似于多教师知识蒸馏,但存在两个显著区别。首先,在传统的知识蒸馏中,学生模型通常被限制为比教师模型小的尺寸。然而,在我们的场景中,对目标模型的尺寸没有限制。其次,传统的知识蒸馏通常会导致学生模型在蒸馏后性能低于教师模型。相反,我们期望在融合之后,目标模型的性能能超越任何单个源模型。

3、大型语言模型的知识融合

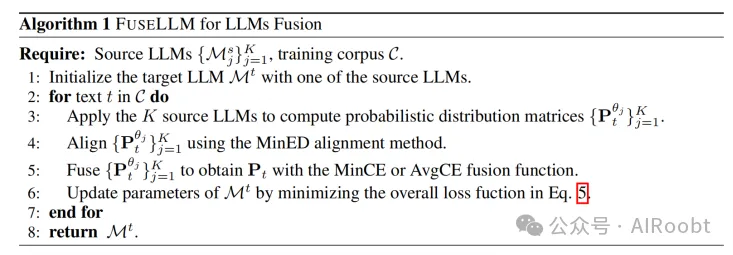

LLM融合的主要目标是外化多个源LLM中嵌入的集体知识,并将它们的能力整合到目标LLM中。给定 K 个源LLM {Msj}j=1K,这些模型架构各异,并分别在不同的数据集上进行预训练或微调。我们提出的核心思想是通过预测下一个token来激发这些LLM展现其固有的知识。通过评估这些预测生成的概率分布,我们使用最准确的预测来对目标LLM Mt 进行持续训练,使用语料库 C 并基于因果语言建模(CLM)目标进行训练。在接下来的部分中,我们首先简要介绍基本概念,然后详细说明我们的LLM融合框架,最后讨论实现细节。

3.1 基本概念

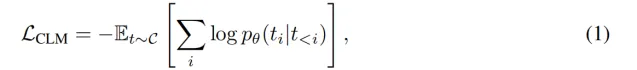

设 t 表示从语料库 C 中采样的长度为 N 的文本序列,t_{<i} = (t_1, t_2, ..., t_{i-1}) 表示第 i 个token之前的序列。基于因果语言建模(CLM)目标对参数化为 θ 的语言模型进行训练,其定义为最小化负对数似然:

其中,p_{θ}(t_i | t_{<i}) 是模型给定前面token后对token t_i 的预测概率。

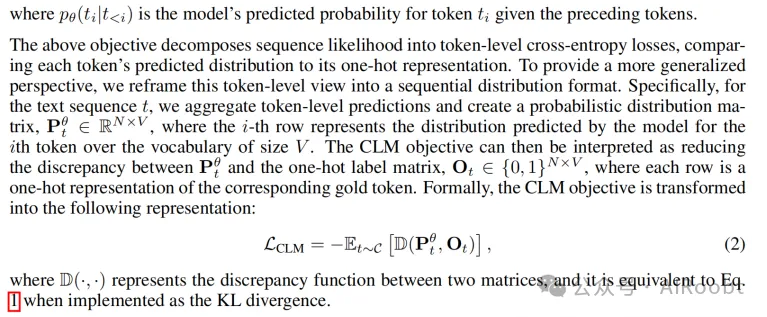

上述目标将序列的似然分解为token级的交叉熵损失,将每个token的预测分布与其单热(one-hot)表示进行比较。为了提供一个更广泛的视角,我们将这种token级的视图重新框定为顺序分布的格式。具体而言,对于文本序列 t,我们将token级预测聚合并创建一个概率分布矩阵 P_{θ}^t in mathbb{R}^{N times V},其中第 i 行表示模型对第 i 个token在词汇表大小为 V 的情况下预测的分布。然后,CLM目标可以解释为减少 P_{θ}^t 和单热标签矩阵 O^t in 0, 1^{N times V} 之间的差异,每行都是对应金标token的单热表示。形式上,CLM目标转化为以下表示:

其中 D(·,·) 表示两个矩阵之间的差异函数,当使用KL散度实现时,等价于公式(1)。

3.2 LLM的融合

基于对语言模型的这一观点,我们认为概率分布矩阵可以反映其对文本理解中的某些固有知识。因此,来自不同LLM的相同文本的不同概率分布矩阵可用于表示这些模型中嵌入的多样化知识。考虑到这一点,所提出的FUSELLM方法通过概率建模来处理LLM的融合,旨在通过融合源LLM的概率分布来创建一个统一的LLM。为实现这一点,在开始融合一组LLM时,FUSELLM会对目标LLM进行轻量级的持续训练,使用一个与预训练数据集类似的原始文本语料库。除了依赖CLM目标外,FUSELLM还重点最小化目标LLM的预测概率分布与源LLM概率分布之间的差异。

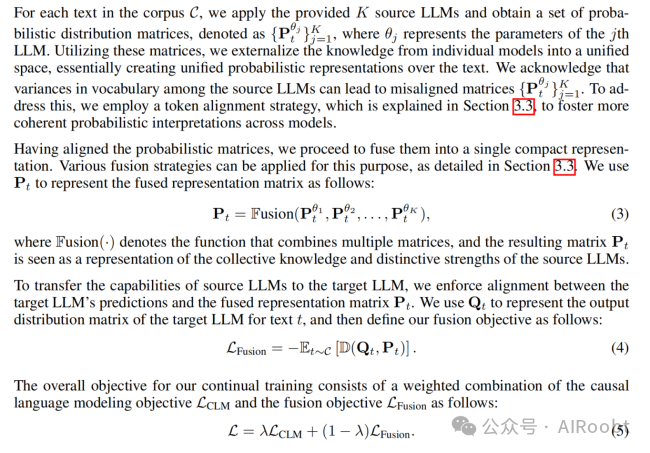

对于语料库 C 中的每个文本,我们应用提供的 K 个源LLM并获得一组概率分布矩阵,表示为 P_{θ_j}^t_{j=1}^{K},其中 θ_j 表示第 j 个LLM的参数。利用这些矩阵,我们将单个模型的知识外化到一个统一的空间,实际上是在文本上创建了统一的概率表示。我们承认源LLM之间词汇表的差异可能导致矩阵 P_{θ_j}^t_{j=1}^{K} 未对齐。为了解决这个问题,我们采用了一个词汇对齐策略,这将在3.3节中进行解释,以促进跨模型的更一致概率解释。

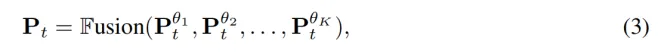

在对齐概率矩阵后,我们继续将它们融合为一个紧凑的表示。可以应用多种融合策略来实现这一目标,具体将在3.3节中详细介绍。我们用 P^t 来表示融合后的表示矩阵,定义如下:

其中 text{Fusion}(·) 表示组合多个矩阵的函数,结果矩阵 P^t 被视为源LLM集体知识和独特优势的表示。

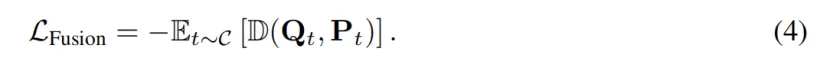

为了将源LLM的能力转移到目标LLM,我们在目标LLM的预测与融合表示矩阵 P^t 之间强制对齐。我们用 Q^t 来表示目标LLM对文本 t 的输出分布矩阵,然后将融合目标定义为:

我们的持续训练的总体目标包括CLM目标 L_{text{CLM}} 和融合目标 L_{text{Fusion}} 的加权组合,公式如下:

3.3 FUSELLM的实现

在本节中,我们介绍FUSELLM方法中词汇对齐和融合函数的实现细节。

词汇对齐

确保多个LLM之间的token对齐对知识融合至关重要,因为它可以保证概率分布矩阵的正确映射。Fu等人(2023)采用动态规划的方法,通过递归最小化将一个token序列编辑为另一个序列的总成本。如果两个token之间存在一对一的映射,则对应的概率分布完全映射。否则,映射的分布退化为单热向量。由于由不同分词器为相同序列生成的token通常差异有限,我们建议通过用最小编辑距离(MinED)策略替换Fu等人(2023)提出的精确匹配(EM)约束,以基于最小编辑距离对不同分词器生成的token进行映射。这种对齐方式的放宽有助于在分布矩阵中保留大量信息,同时引入的误差很小。更多词汇对齐的细节可参考附录A。

融合策略

为了在保留源LLM独特优势的同时整合其集体知识,评估不同LLM的质量并对其相应的分布矩阵赋予不同的重要性是至关重要的。为此,在处理文本 t 时,我们使用分布矩阵与金标标签之间的交叉熵损失作为LLM预测质量的指标(Marion et al., 2023)。较低的交叉熵分数表明源LLM对文本的理解更准确,其预测应赋予更大的权重。基于这一标准,我们引入了两种融合函数:(1) MinCE:该函数输出交叉熵分数最低的分布矩阵;(2) AvgCE:该函数根据交叉熵分数对分布矩阵进行加权平均。

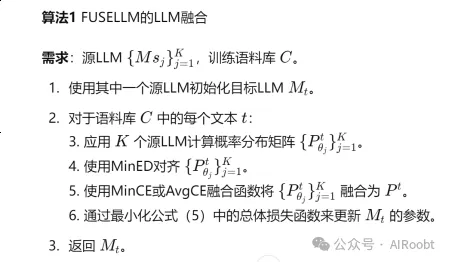

FUSELLM方法的完整流程在算法1中描述。

4、实验

在我们的实验中,我们考虑了一种通用但具有挑战性的LLM融合场景,其中源模型在架构或功能上几乎没有共性。具体来说,我们在7B规模下进行实验,并选择了三个具有代表性的开源模型:Llama-2、OpenLLaMA和MPT作为融合的源LLM。对于目标LLM,我们选择了另一个Llama-2 7B,它通常是三个源LLM中最强大的一个。目标LLM从与源模型相同的预训练权重开始,但在训练期间会更新参数。为了评估FUSELLM的性能,我们在推理、常识和代码生成能力的基准上进行了实验。

4.1 实验设置

用于持续训练的数据集

为了持续训练目标LLM进行LLM融合,重要的是选择一个紧凑且多样化的训练数据集。我们选择了MiniPile,这是通过仔细的聚类和筛选过程生成的精选数据集。MiniPile由大约100万个文档组成,涵盖22个领域,包含18亿个token,约占Llama-2训练token的0.1%。更多数据集的详细信息可参见附录B。

融合函数

对于融合函数,我们使用最小交叉熵(MinCE)。然而,我们将在第4.4节中考察使用其他融合函数的影响。

训练细节

我们使用批量大小为128、最大长度为2048的Llama-2 7B目标LLM,训练在配备8个每个40GB显存的NVIDIA A100 GPU的单节点上进行。我们的训练框架基于Huggingface Transformers(Wolf et al., 2020)并通过FlashAttention(Dao et al., 2022)加速。我们经验性地将公式(5)中的组合权重(lambda)设置为0.9。训练仅进行一个epoch,约需33小时。更多超参数的细节可参见附录C。

评估

我们在三个基准上评估FUSELLM,这些基准代表LLM的不同核心能力,涵盖推理、常识和代码生成。

- Big-Bench Hard (BBH)(Suzgun et al., 2022)是一个评估LLM推理能力的基准。它包含23个选择题任务和4个自由生成任务,来自Big-Bench(Srivastava et al., 2022),可分为四类:算法和算术推理、自然语言理解、世界知识和多语言知识与推理。我们遵循之前的工作(Wang et al., 2023b),基于少样本链式思维(CoT)提示生成预测并计算精确匹配(EM)准确率。

- Common Sense (CS) 是一个评估LLM常识能力的基准。我们考虑了5个标准选择题任务:ARC easy和ARC challenge(Clark et al., 2018)、BoolQ(Clark et al., 2019a)、HellaSwag(Zellers et al., 2019)和OpenBookQA(Mihaylov et al., 2018)。我们使用lm-eval-hardness(Gao et al., 2021)进行基于似然的零样本评估。具体来说,我们选择给定上下文情况下似然最高的选项并报告准确率。

- MultiPL-E (ME)(Cassano et al., 2022)是一个多语言编程基准,用于评估LLM的代码生成能力。它由Python基准(Chen et al., 2021)翻译而成,覆盖18种编程语言的平行数据集。我们使用bigcode-evaluation-hardness(Ben Allal et al., 2022)进行零样本代码生成,涉及10种流行编程语言的HumanEval类任务,并基于每个问题生成的20个样本报告pass@1(Chen et al., 2021)得分。

基线

在我们的实验中,我们将FUSELLM与两组基线进行比较:(1) 原始LLM,包括Llama-2 7B、OpenLLaMA 7B和MPT 7B;(2) Llama-2 CLM:仅使用因果语言建模目标在MiniPile上持续训练的Llama-2 7B。

4.2 总体结果

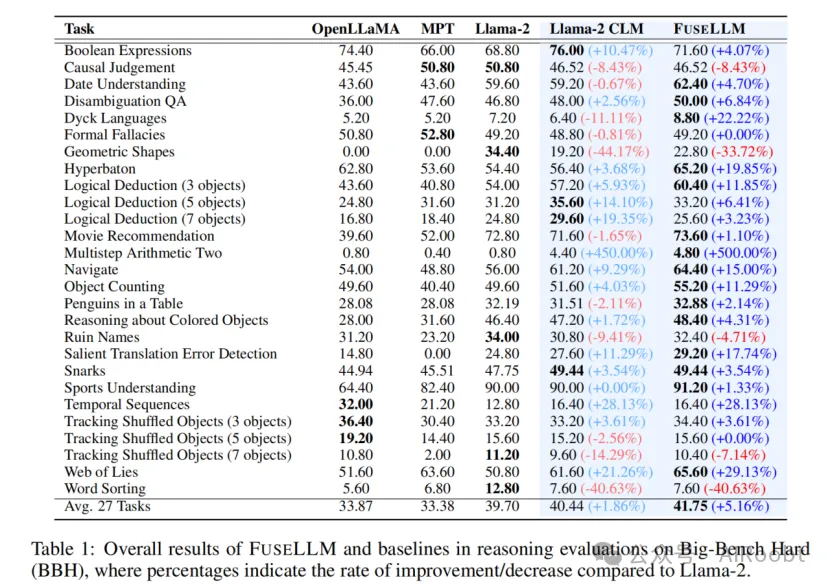

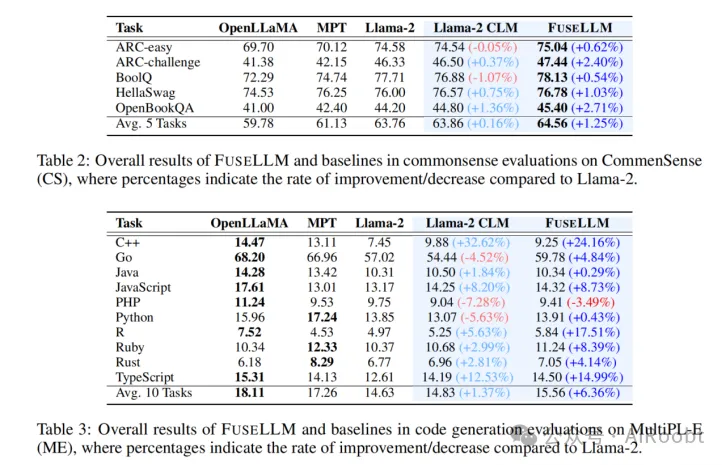

表1展示了FUSELLM与基线方法在BBH上的总体结果。可以看到,三个源LLM在27个BBH任务上的表现各不相同,通常Llama-2表现优于其他模型。使用紧凑且多样的语料库进行持续训练后,Llama-2 CLM相较于Llama-2表现出1.86%的相对提升,尽管这一提升相对温和且在不同任务中的一致性不高。总体而言,FUSELLM在所有27个任务中的平均相对性能提升为5.16%,显著优于原始Llama-2。在某些特定任务中,FUSELLM的增强效果尤为显著(例如,Hyperbaton任务中的准确率从54.40提升至65.20)。在一些简单持续预训练导致性能下降的任务中(如Dyck Languages),FUSELLM通过结合个体源LLM的优势实现了性能恢复。需要注意的是,FUSELLM偶尔在某些任务(如Geometric Shapes和Word Sorting)上表现不佳,这可能有两个原因。首先,除了Llama-2以外的其他源LLM在这些任务上的表现较差,影响了融合结果。其次,持续训练数据集与下游任务的相关性也对性能下降有所贡献。

表2展示了FUSELLM与基线方法在Common Sense基准上的零样本性能。结果表明,FUSELLM在所有五个任务上持续超越基线,平均相对性能提升为1.25%。相比之下,Llama-2 CLM仅表现出0.16%的相对提升,且提升幅度较小。在具有挑战性的ARC-challenge(2.40%)和OpenBookQA(2.71%)任务中,从Llama-2到FUSELLM的显著提升突显了FUSELLM在利用集体知识解决复杂问题方面的有效性。

对于代码生成评估,表3展示了FUSELLM在MultiPL-E基准上的零样本性能。我们观察到,FUSELLM在10个任务中的9个上优于Llama-2,特别是在某些编程语言(如R)的pass@1得分上有显著提升,从4.97提升至5.84。由于OpenLLaMA和MPT在代码生成任务中相比Llama-2表现出色,通过FUSELLM融合的结果在平均表现上提升了6.36%,远高于Llama-2 CLM的1.37%提升。然而,值得注意的是,在该评估中FUSELLM仍然表现出与OpenLLaMA或MPT相比的性能差距。这种差异可以归因于两个主要原因:Llama-2作为目标模型在代码生成上的初始表现较差,以及持续训练语料库中与代码相关的文本比例不足,估计约为7.59%。

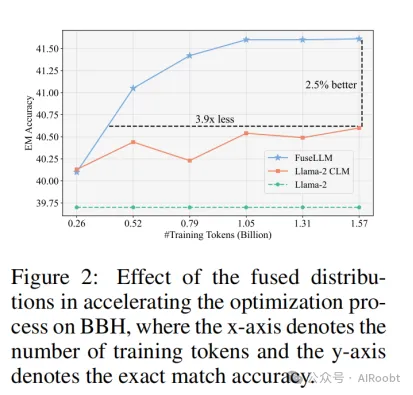

4.3 融合概率分布的效果

我们探讨了从多个LLM获得的融合概率分布的有效性,并跟踪训练过程中性能提升的趋势。图2展示了在BBH上的少样本CoT性能随训练数据规模的变化情况。我们的观察表明,FUSELLM相比Llama-2 CLM在精确匹配(EM)准确率上提升了2.5%,并在仅使用0.52亿个token时达到了Llama-2 CLM最佳性能。值得注意的是,与Llama-2 CLM需要的15.7亿个token相比,这代表了训练token需求的3.9倍减少。这些结果表明,LLM生成的概率分布包含比原始文本序列更易学习的知识,从而加速了优化过程。

4.4 实现过程分析

在本节中,我们深入探讨了FUSELLM实现中的关键要素,包括源LLM的数量、词汇对齐的标准以及融合函数的选择。

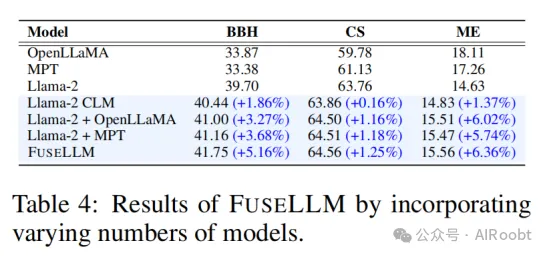

源LLM的数量

我们展示了融合不同数量的LLM的结果。我们注意到,随着模型数量从1增加到3,FUSELLM的性能显著提高。然而,整合更多模型的好处在各个基准中的表现有所不同。在BBH中,性能提升是显而易见的;而在CS或ME中,当融合两个模型时,提升效果更加显著。这种现象可能是由于三个模型在BBH中的各项任务上性能差异较大,而在CS或ME任务上的性能差异相对较小。

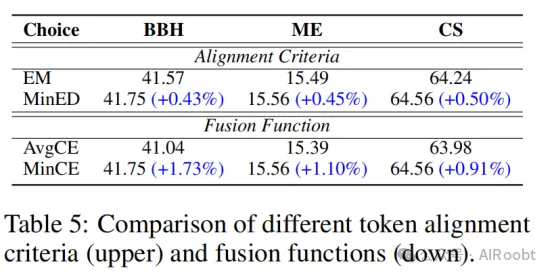

词汇对齐的标准

在LLM融合过程中,确保不同模型生成的tokens和词汇表的一致性至关重要。显然,基于最小编辑距离(MinED)的方法相比Fu等人(

2023)提出的精确匹配(EM)方法表现更优。我们推测这种性能提升源于MinED的宽松限制,能够有效对齐由不同分词器生成的轻微差异的tokens,从而保留了大量有用的token信息,同时引入的错误较少。

融合函数的选择

在3.3节中,我们介绍了FUSELLM的两种融合函数:一种是使用最小交叉熵分数(MinCE)的分布矩阵,另一种是基于交叉熵分数对分布矩阵进行加权平均(AvgCE)。结果表明,FUSELLM使用MinCE在所有基准上的表现优于AvgCE。这可能是由于AvgCE中的简单加权平均引入了扭曲,削弱了各个LLM的独特优势。

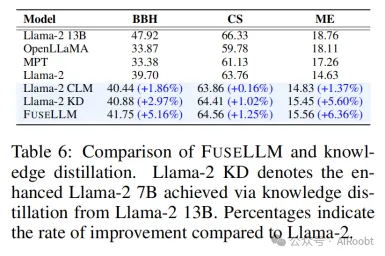

4.5 FUSELLM与知识蒸馏的比较

虽然知识蒸馏技术也可以用于提升LLM的能力,但FUSELLM在两个方面脱颖而出,正如前文所述。在本节中,我们将FUSELLM与传统的知识蒸馏进行比较。具体而言,我们从Llama-2 13B中提取概率分布,并应用传统知识蒸馏方法,将其能力转移到Llama-2 7B中。通过知识蒸馏获得的模型(Llama-2 KD)在所有基准上表现优于原始Llama-2 7B,证明了知识蒸馏的有效性。然而,与FUSELLM相比,Llama-2 KD的提升幅度相对较小,尤其是在BBH中(2.97% vs. 5.16%)。这表明通过持续训练集成三种具有不同架构的7B模型,FUSELLM获得的优越结果超越了从单个13B模型中简单提取知识的收益。这一观察突出了“更多有不同,差异也能成就更多”的理念。

4.6 FUSELLM与集成/融合的比较

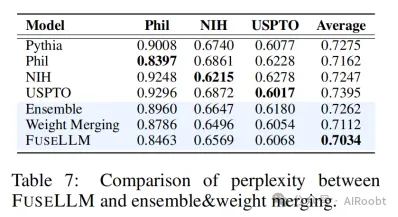

正如之前提到的,传统技术如模型集成和权重融合通常用于融合多个大型语言模型(LLMs)。为了比较我们提出的FUSELLM与这些现有融合方法的有效性,我们进行了实验,模拟了多个LLM来源于相同基础模型但在不同语料库上训练的场景。我们首先从The Pile数据集中选择了三个相关领域(PhilPapers、NIH ExPorter和USPTO Backgrounds),并使用每个领域的10亿个token对Pythia 1B模型(Biderman等人, 2023)进行持续训练,生成了三个结构相同但领域不同的LLM。然后,我们将不同的融合技术应用于这些LLM:(1) 集成方法计算所有LLM生成的概率的加权平均值,权重基于每个模型的表现;(2) 权重融合方法在参数空间中融合多个LLM,融合权重由模型表现决定;(3) FUSELLM在从这三个领域中采样的1亿个token上进行持续训练。

表7展示了FUSELLM和其他融合方法在测试集上的困惑度(perplexity)结果,我们使用The Pile中实现的方法,按每个UTF-8编码字节(BPB)测量困惑度。我们观察到,经过10亿个token的训练后,原始LLM的能力被转移到每个特定领域的LLM中,导致它们在其他领域的表现下降。尽管所有融合技术都能够整合不同模型的优势,但FUSELLM在三个领域中始终实现了最低的平均困惑度,这表明它比集成和权重融合方法更有效地利用集体知识。

5、结论

本文提出了一种称为FUSELLM的新方法,用于实现大型语言模型(LLMs)的知识融合。我们的主要目标是将多个源LLM的集体知识和独特优势外化,并将这些知识转移到一个目标LLM中。通过从不同的LLM中提取概率分布,我们利用源模型的多样化能力,使目标LLM在推理、常识和代码生成等任务上的表现得到提升。与传统的模型集成和权重融合方法不同,FUSELLM能够在架构不同的LLM之间实现知识融合。

我们通过实验验证了FUSELLM的有效性,实验结果表明在不同的评估基准上,FUSELLM的目标模型在大多数任务中的性能超越了任何单个源LLM。尽管我们的方法已经展示了其潜力,未来的研究仍可进一步探索以下方向:研究如何在更多LLM之间实现更有效的融合,并开发更加高效的训练策略,以进一步减少所需的训练时间和资源。

1School of Computer Science and Engineering, Sun Yat-sen University, China 2Tencent AI Lab

本文转载自公众号AIRoobt ,作者:AIRoobt

原文链接:https://mp.weixin.qq.com/s/3ncHDUFWpqhy31QxHpAccg