更小、更弱,却更优:通过计算最优抽样训练大语言模型推理器

一、结论写在前面

论文标题:Smaller, Weaker, Yet Better: Training LLM Reasoners via Compute-Optimal Sampling

论文链接:https://arxiv.org/pdf/2408.16737

利用来自强大语言模型(LMs)的高质量合成数据进行训练是提升LMs推理性能的常见策略。论文重新审视了在固定推理预算(例如,FLOPs)下,这一策略是否为计算最优。为此,论文探究了使用更强但更昂贵(SE)模型与较弱但更廉价(WC)模型生成合成数据之间的权衡。

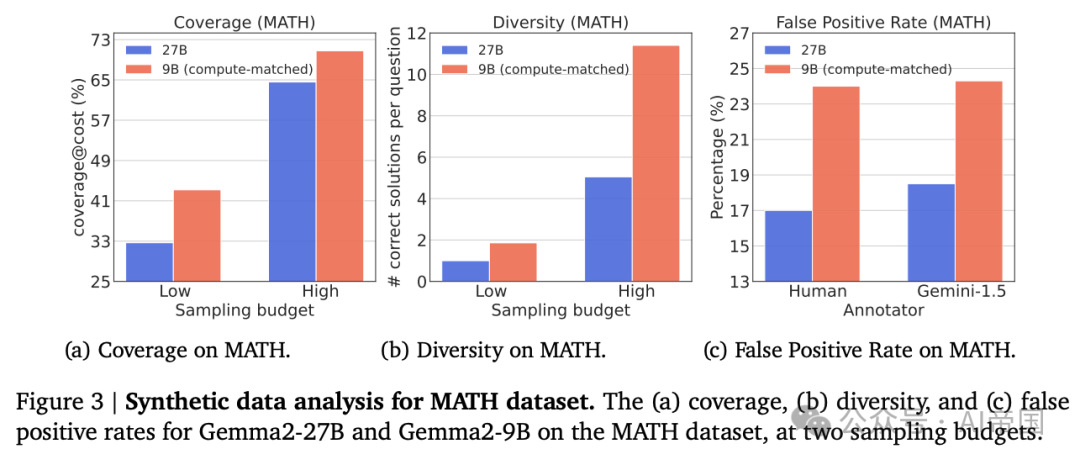

论文评估了生成数据在三个关键指标上的表现:覆盖率、多样性和误报率,并表明WC模型生成的数据可能具有更高的覆盖率和多样性,但也表现出更高的误报率。

随后,论文在不同设置下对LMs进行微调:知识蒸馏、自我改进以及一种新颖的弱到强改进设置,其中较弱的LM向较强的LM传授推理能力。论文的研究发现,在多个基准和多种WC与SE模型选择下,基于WC生成数据微调的模型始终优于那些基于SE生成数据训练的模型。这些结果挑战了当前依赖SE模型生成合成数据的主流做法,表明WC可能是训练高级LM推理器的计算最优途径。

一个具体例子是:对于Gemma2系列在MATH数据集上,Gemma2-9B实现了11%更高的覆盖率和86%更高的多样性,但也伴随着7%的更高FPR,相比于Gemma2-27B。

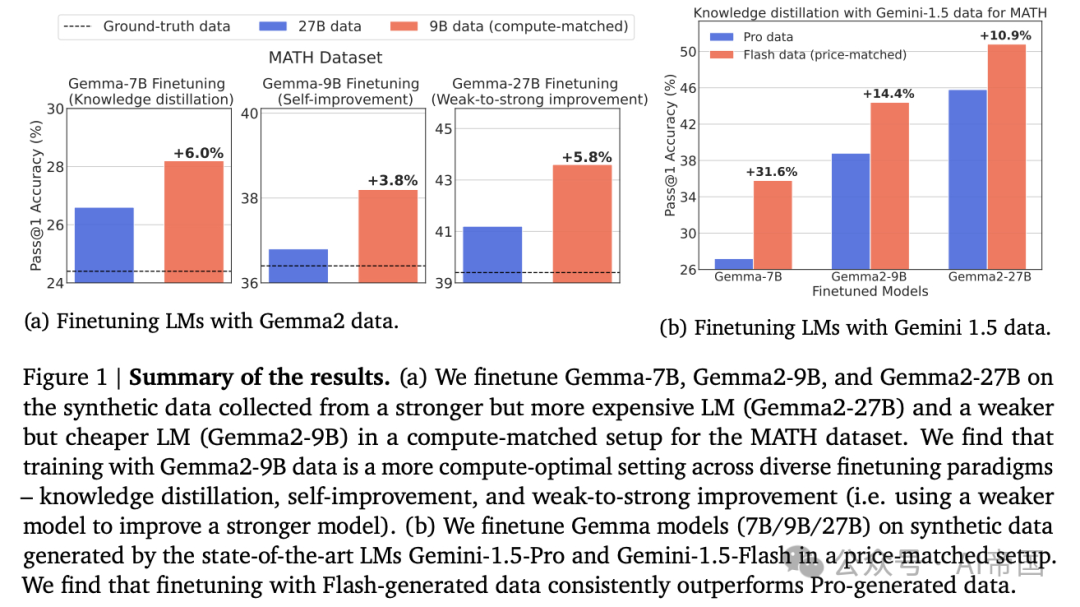

图 1 | 结果总结。(a) 论文在计算匹配的设置下,使用从更强大但更昂贵的LM(Gemma2-27B)和较弱但较便宜的LM(Gemma2-9B)收集的合成数据,对Gemma-7B、Gemma2-9B和Gemma2-27B进行微调,用于MATH数据集。论文发现,在多种微调范式——知识蒸馏、自我改进和弱到强改进(即使用较弱的模型来改进较强的模型)中,使用Gemma2-9B数据进行训练是更计算优化的设置。(b) 论文在价格匹配的设置下,使用由最先进的LM Gemini-1.5-Pro和Gemini-1.5-Flash生成的合成数据,对Gemma模型(7B/9B/27B)进行微调。论文发现,使用Flash生成的数据进行微调始终优于使用Pro生成的数据。

二、论文的简单介绍

2.1 论文的背景

最近的研究表明,通过语言模型自身合成生成这些数据是可行的,这为训练数据的获取提供了一种潜在的更具扩展性和效率的方法。一种广泛采用的方法是从LM中为一个问题采样多个候选解决方案,过滤它们以确保最终答案的正确性,并在正确的解决方案上对模型进行微调。多项研究表明,使用这种合成解决方案训练的LM优于使用人类编写的解决方案训练的LM。从业者通常从强大的LM中采样解决方案以确保高质量。然而,从强大的LM中采样是昂贵且资源密集型的,并且限制了在实际采样预算内可以生成的解决方案数量。

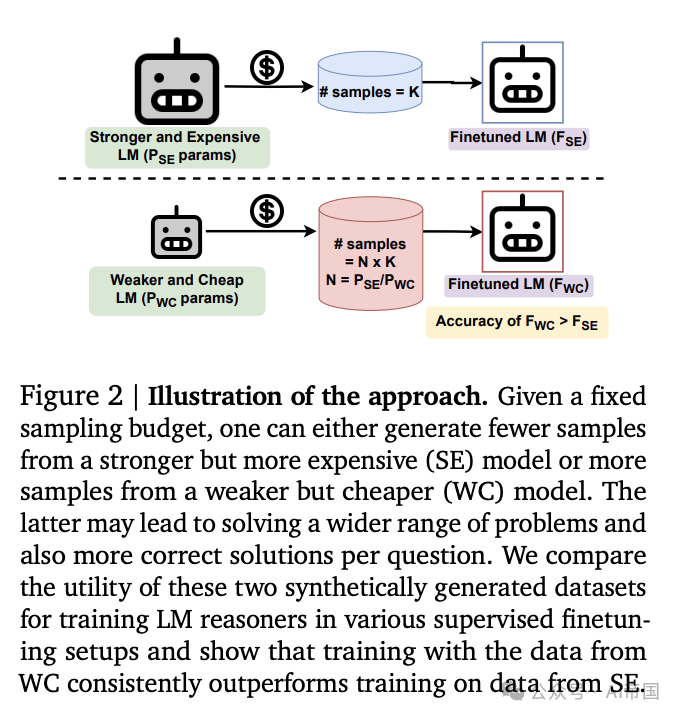

论文探索了一种替代采样方法。在固定的计算预算下,论文研究了从较弱但更便宜(WC)模型采样,而不是通常采用的从较强且昂贵的微调LM(stronger but more expensive,SE)采样的方法。通过比较WC和SE的数据,论文沿着三个在合成数据效用中起关键作用的方向进行分析:1-覆盖率,解决的独特问题的数量;2-多样性,每个问题获得的平均独特解决方案数量;以及3-假阳性率(FPR),即以错误理由得出正确最终答案的问题百分比。

论文发现,由于可以从WC模型生成更多的样本,与后者相比,这可能导致解决更广泛的问题,并在固定预算下提供更多数据。论文在各种监督微调设置中比较了这两种合成生成的数据集对训练LM推理器的效用,并显示使用WC数据训练始终优于使用SE数据训练。作为一个具体例子,对于Gemma2系列在MATH数据集(Hendrycks等人,2021)上,Gemma2-9B实现了11%更高的覆盖率和86%更高的多样性,但也伴随着7%的更高FPR,相比于Gemma2-27B。

2.2. 预备知识

设 D={q_i, a_i} _i=1 ^i=n 为一个包含 n 个推理问题 q_i 及其最终答案(即标签) a_i 的训练数据集。利用此类数据提升模型推理能力的成功方法如下:论文采样k 个样本,其中 r_i j 是模型为 q_i 生成的第 j 个推理链(即解决方案),a_i j 是模型在非零温度下对 q_i 的最终答案,并创建合成数据 D_G={q_i, {( r_i j, a_i j )}_j=1 ^j=k 。

接着,论文通过比较 a_i j 与 a_i 来过滤错误的解决方案,移除那些最终答案与标准答案不匹配的方案。最后,论文在剩余数据 D_G 上监督微调模型,以最大化目标函数𝐽(𝜃),即在给定问题 q 下生成推理 r 和最终答案 a 的概率。

关于 D_G,论文计算了平均值,如 Chen et al., 2010 所述。从概念上讲,coverage@k 衡量了至少有一个正确解决方案的独特问题的比例,假设论文从模型中为每个问题采样 k 个解决方案。论文还定义了多样性 Q k 为每当论文为每个问题采样 k 个解决方案时,平均每个问题获得的独特正确解决方案的数量。最后,论文定义假阳性率 ( F P R ) 为 tD_G 中推理错误但最终答案正确的解决方案的百分比。

不同的语言模型(LM)选择来采样解决方案和微调模型会导致不同的设置。知识蒸馏(Hinton et al., 2015)对应于在从更强和更大的LM中采样的合成数据上训练学生LM。自我改进(Huang et al., 2022)对应于在由其自身生成的样本上训练LM。

2.3. 计算匹配的采样和训练

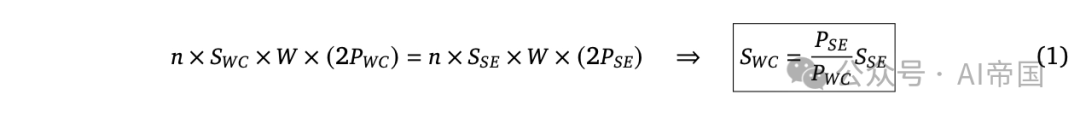

为了从D生成包含合成解决方案的数据集D_G,可以利用不同的模型来生成解决方案。具体来说,在固定的采样预算(FLOPs)下,可以从较弱但成本较低的(a weaker but cheap,WC)模型中生成更多样本,或者从较强但成本较高的(SE)模型中生成较少样本。给定一个具有P_WC参数的WC模型和一个具有P_SE参数的SE模型,论文计算在固定预算下两个模型的采样比例,重点关注仅解码器的Transformer模型。

根据(Kaplan et al., 2020),论文注意到每个推理token的FLOPs是2P,对于具有P参数的模型。因此,T个推理token的FLOPs是2PT。进一步假设生成每个解决方案平均需要W个推理token,对于两种模型都是如此。设S_WC和S_SE分别表示论文为两个模型每个问题生成的样本数量。生成数据集D的样本的总成本将是Cost_WC=n x S_WC x W x (2P_WC)和Cost_SE=n x S_SE x W x (2P_SE),分别对应于廉价和昂贵的模型。在固定的采样预算下,论文有:

公式1表明,在固定的采样预算下,对于每个问题,论文可以生成P_SE/P_WC个从WC中采样更多样本;比例尺与模型参数比例线性相关。从WC中采样更多解决方案可能会增加正确解决更大子集问题(高覆盖率)和每个问题获得更多正确解决方案(高多样性)的可能性。

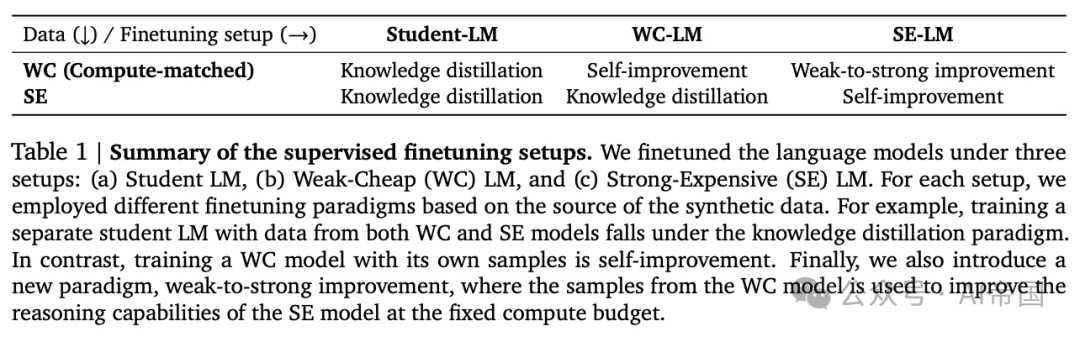

表1 监督微调设置的总结。论文在三种设置下微调语言模型:(a)学生LM,(b)弱-廉价(WC)LM,和(c)强-昂贵(SE)LM。对于每种设置,论文根据合成数据的来源采用了不同的微调范式。例如,使用来自WC和SE模型的数据训练一个单独的学生LM属于知识蒸馏范式。相比之下,使用其自身样本训练WC模型是自我改进。最后,论文还引入了一种新的范式,即弱到强改进,其中WC模型的样本被用来在固定计算预算下提高SE模型的推理能力。

在固定预算下,论文可以选择从SE模型生成较少样本或从WC模型生成更多样本,然后对来自每个模型的数据进行固定步数的微调,以测量和比较每个模型数据的效用。具体来说,论文生成的样本比WC模型比SE模型多P_S E / P_W C。论文考虑了三种包含多样化微调范式的设置。这些范式包括广泛使用的知识蒸馏、新兴的自改进框架,以及论文在本工作中引入的新颖的弱到强改进范式。

论文将弱到强改进(W2S-I)定义为使用从较弱模型生成的样本来增强强模型的推理能力。三种设置如下:

•学生-LM微调:传统上,用于训练学生LM的监督微调数据从SE模型获取,以确保高质量。然而,论文旨在理解WC模型是否能在固定采样预算下替代SE模型进行蒸馏。为此,论文在WC和SE数据上分别对与WC和SE模型独立的学生LM进行微调,这在两种情况下对应于蒸馏。

•WG-LM微调:先前的工作(Singh et al., 2023)表明,通过自生成数据微调WC模型落后于从SE数据蒸馏。然而,他们的设置在从SE模型收集数据上花费了更高的采样预算(FLOPs),而不是从WC模型收集SI数据。在本工作中,论文在固定采样预算下重新审视这一微调设置,并在固定预算下对WC模型在WC和SE数据上进行微调。注意,在自身数据上训练WC模型对应于自我改进,而在SE数据上训练WC模型对应于蒸馏。因此,此设置比较了WC数据上的自我改进与SE数据上的蒸馏。

•SE-LM微调:通常认为要改进SE模型,论文需要来自SE模型自身的合成数据或来自比SE模型更强(且可能更昂贵)的模型。论文采用一种方法来理解WC模型生成的合成数据是否能改进SE模型。为此,论文在WC和SE数据上微调SE模型。在WC数据上训练SE对应于W2S-I,而在SE数据上训练SE对应于自我改进。总体而言,此设置比较了WC数据上的W2S-I与SE数据上的自我改进。

三种设置及其对应的微调范式的总结见表1。

2.4. 实验设置

数据集:论文使用MATH和GSM-8K作为推理数据集,因为它们广泛用于数学问题解决。具体而言,MATH包含不同难度级别的竞赛级问题(级别(1-5)),而GSM-8K包含小学级别的数学问题。每个数据集在其训练分割中包含7500个数学问题。论文在MATH测试分割的500个问题和GSM-8K测试分割的1319个问题上评估模型。此外,论文使用MATH测试分割的500个问题和GSM-8K的500个问题作为验证数据集。论文还使用Functional MATH数据集进行迁移学习研究。此外,论文在附录wedge中展示了一个编码任务的结果。

数据生成:论文使用Gemma2模型进行合成数据生成,其中预训练的Gemma2-9B和Gemma2-27B分别充当WC和SE模型。论文为MATH问题生成解决方案时采用4次提示,为GSM-8K问题生成解决方案时采用8次提示。由于9B模型大约比27B模型小3倍,在固定的采样计算预算下,论文可以为Gemma2-9B每问题采样3倍多的候选解决方案。对于论文的实验,论文考虑两种采样预算:低预算,其中论文分别从Gemma2-27B和Gemma2-9B每问题生成1个和3个候选解决方案;高预算,其中论文每问题分别生成10个和30个候选解决方案。此外,论文研究了在功能性MATH数据集上,针对高采样预算下训练的模型在推理能力上的迁移。

模型微调:论文在表1中总结了微调设置的详细信息。在学生-LM微调设置中,论文对Gemma-7B模型(Team et al., 2024a)进行微调,数据来自Gemma2-9B(WC)和Gemma2-27B(SE)。此外,论文分别使用Gemma2-9B和Gemma2-27B进行WC-LM和SE-LM微调设置。进一步地,论文使用人类编写的解决方案作为基准事实,对不同设置下的LM进行训练。论文在附录中提供了微调的详细信息overlinequadquadquad。

合成数据评估:为了评估SE和WC模型生成的合成数据的质量,论文测量了假阳性率,以及在固定成本下的覆盖率和多样性。论文从7 varphi3 k 心相似的预算中为两个模型提供相同的支持。同样,论文比较了论文的SE和W C模型的diversity@k和diversity@3k。由于FPR不能自动计算,论文使用两个代理来计算它:1 - 对数据子集的人工评估,其中随机选择了每个模型的50个解决方案,并由作者对其推理正确性进行评分,以及 _2 - 自动评估,论文采样了500个解决方案并提示Gemini-Pro-1.5(Reid et al., 2024)来评估推理路径的正确性。为了采样解决方案,对于MATI数据集,论文从每个多样性级别中均匀选择。在论文的实验中,论文发现人工和自动评估的FPR估计值彼此接近。论文在附录B中提供了一些假阳性实例的定性示例。

评估微调模型:论文使用pass@1 准确度来评估微调语言模型(LMs)的性能。具体而言,论文针对测试集中的每个问题生成一个单一解决方案(零样本),使用微调后的LM进行采样温度为0.0(贪心解码),并计算最终答案与标准答案匹配的问题百分比。此外,论文还报告了maj@k ( k=1, 4, 8, 16 ) 的部分实验结果,其中每个问题生成 boldsymbolk 个解决方案,采样温度为 0.7,并选择在 k 个样本中出现频率最高的最终答案。小规模、弱化,但更优:通过计算优化采样训练大型语言模型推理器

图 3 ~ | MATH 数据集的合成数据分析。在两个采样预算下,Gemma2-27B 和 Gemma2-9B 在 MATH 数据集上的正样本率。

2.5. 实验与结果

论文沿着几个轴比较了 WC 和 SE 模型的数据。首先,论文沿着各种质量指标分析数据。随后,论文展示了不同设置下的监督微调结果。最后,论文进行了消融研究,以研究数据集大小、采样策略和质量维度在模型性能中的作用。

2.5.1. 合成数据分析

覆盖率:论文的目标是理解在固定采样预算下,从 WC 和 SE 模型生成解决方案的优缺点。论文在图 3 中展示了 MATH 在低和高采样预算下的覆盖率、多样性和假阳性率。GSM-8K 的结果在附录 - 图 15 中展示。论文发现,在覆盖率方面,Gemma2-9B(WC)在低和高采样预算下分别比 Gemma2-27B(SE)高出 11% 和 6%,对于 MATH 数据集,以及 8% 和 1% 对于 GSM-8K。这突显了 WC 模型更高的样本数量有助于解决更多独特的推理问题。

此外,论文观察到,在 MATH 数据集中,WC 模型的覆盖率在高采样预算下随着不同难度级别的增加而增加(见附录 - 图 16)。这突显了在固定采样预算下,WC 模型生成的合成数据可以解决更多不同难度级别的独特问题,相比之下 SE 模型。此外,论文提供了一个定性示例,该示例通过 Gemma2-9B 的重复采样得到解决,但在固定的高采样预算下,Gemma2-27B 仍未解决(表 5)。

多样性:Gemma2-9B 生成的数据在 MATII 数据集上的多样性比 Gemma2-27B 高出 86% 和 125%,在 GSM-8K 数据集上则高出 134% 和 158%。这表明 W C 模型生成的合成数据中存在许多独特的推理链,这些推理链能够导向正确的解决方案。论文还观察到,在高采样预算下,MATH 数据集的绝对多样性得分低于 GSM-8K,这表明在重复采样时,模型为更具挑战性的数据集生成的正确解决方案更少。

假阳性率(FPR):由于论文利用最终答案的正确性来筛选合成数据,因此并未移除包含错误中间推理步骤的解决方案。论文的人工评估显示,在 MATH 和 GSM-8K 数据集上,WC 生成的解决方案的 FPR 分别比 SE 生成的解决方案高出 7% 和 2%。自动评估的趋势与人工评估相似。鉴于问题难度的差异,论文注意到,绝对值与MATH数据集相比,GSM-8K数据集的FPR(假阳性率)要低得多。论文还注意到,推理步骤的自动验证也可能存在错误,这仍然是一个开放问题。

图 4 监督微调结果(MATH)。在固定采样预算下,对来自WC(Gemma2-9B)和SE(Gemma2-27B)模型的MATH数据进行微调的各种语言模型的结果。论文观察到,使用WC模型样本的训练始终优于使用SE数据的训练。

图 5 mid 监督微调结果(GSM-8K)。在固定采样预算下,对来自WC(Gemma2-9B)和SE(Gemma2-27B)模型的GSM-8K合成数据进行各种语言模型微调的结果。论文观察到,使用WC模型样本进行训练的推理器比使用SE数据训练的推理器更强。

鉴于高覆盖率和多样性与高FPR的混合信号,目前尚不清楚从WC模型还是SE模型采样以训练强推理器是否是计算最优的。论文将在下一节中研究这个问题。

2.5.2. 训练的计算最优性结果

论文比较了从Gemma2-9B(WC)和Gemma2-27B(SE)模型生成的合成数据在MATH和GSM-8K数据集上的效用,这些数据集涵盖了图4和图5中不同的微调范式。此外,论文还展示了使用原始训练集中人类编写的思维链进行训练的结果作为基线。

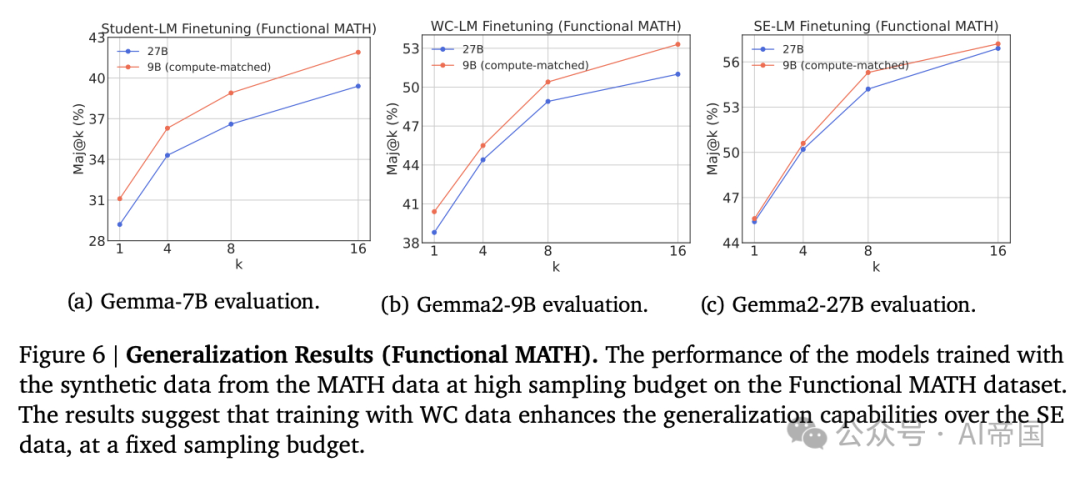

图 6 | 泛化结果(功能性 MATH)。在功能性 MATH 数据集上,使用 MATH 数据在高采样预算下生成的合成数据训练的模型的性能。结果表明,在固定采样预算下,使用 WC 数据训练增强了模型对 SE 数据的泛化能力。

学生-LM 微调。论文发现,使用 WC 生成的合成数据微调的 Gemma-7B 模型,在性能上始终优于使用 SC 数据微调的模型。具体而言,对于 MATH 数据集,在低和高采样预算下分别获得了 6% 和 5.8% 的相对增益,而对于 GSM-8K 数据集,则分别为 4.2% 和 1.3%。与普遍认为更强大的模型更适合知识蒸馏的观点相反,论文的结果表明,使用 WC 数据进行微调在计算上比使用 SE 数据更为优化。

WG-LM 微调。论文比较了Gemma2-9B在WC数据(即自生成数据)和SE数据(即来自Gemma2-27B的数据)微调后的性能。MATH和GSM-8K的结果分别在图 4 和 5中报告。论文观察到,自生成数据(WC数据)相较于从强模型中进行知识蒸馏(SE数据)有所提升,在MATH数据集上,低和高采样预算下分别实现了3.8%和2%的相对增益,而在GSM-8K数据集上,低采样预算下实现了1.5%的增益。然而,论文发现,在高采样预算下,使用WC数据微调的WC模型在GSM-8K数据集上与SE数据相当。这主要是因为GSM-8k数据集的难度较低,在较高采样预算下趋于饱和(见图 15a)。有趣的是,论文的实证发现表明,在自身生成的合成数据上训练WC模型比从更强模型中蒸馏更为计算优化。

SE-LM 微调结果。论文展示了使用 Gemma2-9B 生成数据和自生成数据对 Gemma2-27B 进行微调的结果。MATH 和 GSM-8K 数据集的结果分别在图 angle_big( big) 和图 5c 中报告。令人惊讶的是,论文观察到使用 WC 数据微调的模型在 MATH 数据集上表现优于 SE 数据,在低和高采样预算下分别实现了 5.8% 和 4.3% 的相对增益,而在 GSM-8K 数据集上则分别为 1.2% 和 1.5%。考虑到 Gemma2-27B 数据预期比 Gemma2-9B 数据更符合分布,这一结果更加令人意外。与普遍认为自生成数据或来自更强模型的数据更好的观点相反,论文的实证研究发现,在 W2S-I 设置下使用 WC 数据训练模型可能比在其自身数据上进行自我改进训练更为计算优化。这一结果还确立了一种新的范式,即通过从远小于前沿模型的模型中生成合成数据,以计算高效的方式改进前沿模型。

泛化能力。在此,论文旨在研究使用 WC 和 SE 数据训练的模型的迁移能力。具体而言,论文在高采样预算下,对使用合成解决方案微调的 MATH 数据集模型在 Functional MATH 数据集上进行评估。图 6 的结果显示,使用 WC 数据微调的 Gemma-7B 模型持续优于使用 SE 数据,其中,相对增益范围在不同boldsymbolk值下为5.8%-6.5%。此外,论文观察到,使用自生成数据微调的Gemma2-9B模型在不同boldsymbolk值下实现了2.5%-4.5%的相对增益,超过了使用Gemma2-27B数据进行知识蒸馏的性能。此外,使用WC数据微调的Gemma2-27B模型与SE数据非常接近,除了k=8时存在2%的相对增益差距。论文的结果强调,使用WC数据微调语言模型在固定采样预算下增强了相对于SE数据的泛化能力。

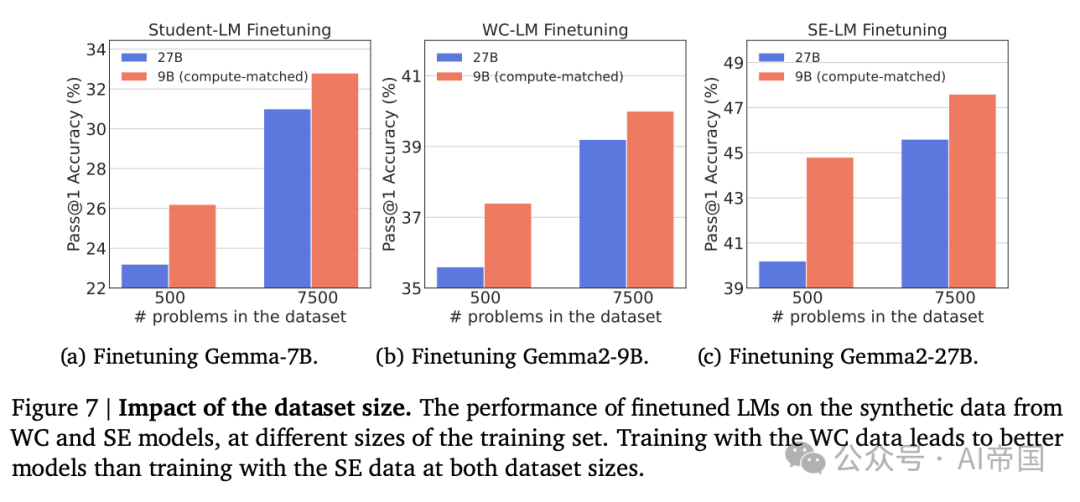

图 7 | 数据集大小的影响。在不同训练集大小下,微调后的语言模型在来自WC和SE模型的合成数据上的性能表现。使用WC数据进行训练的模型在两个数据集大小上都优于使用SE数据进行训练的模型。

要点:总的来说,论文的发现挑战了传统智慧,即主张在SE模型样本上进行训练,通过展示在WC模型样本上训练可能在各种任务和设置中更计算优化。

2.5.3. 消融研究

数据集大小的影响:论文研究了来自WC模型的合成数据在不同数据集大小下的益处是否仍然存在。论文在高预算下对MATH数据集重复了实验,但在仅能访问500个训练数据(从训练集中随机选择)时。论文在图7中展示了微调模型的结果。论文观察到,使用wC数据训练的模型优于使用SE数据训练的模型,分别为三个范式实现了12.939%、11.4%和5.1%的相对增益。这突显了在固定采样预算的低问题体制下,从WC模型生成更多数据而不是从SE模型生成数据的效用。

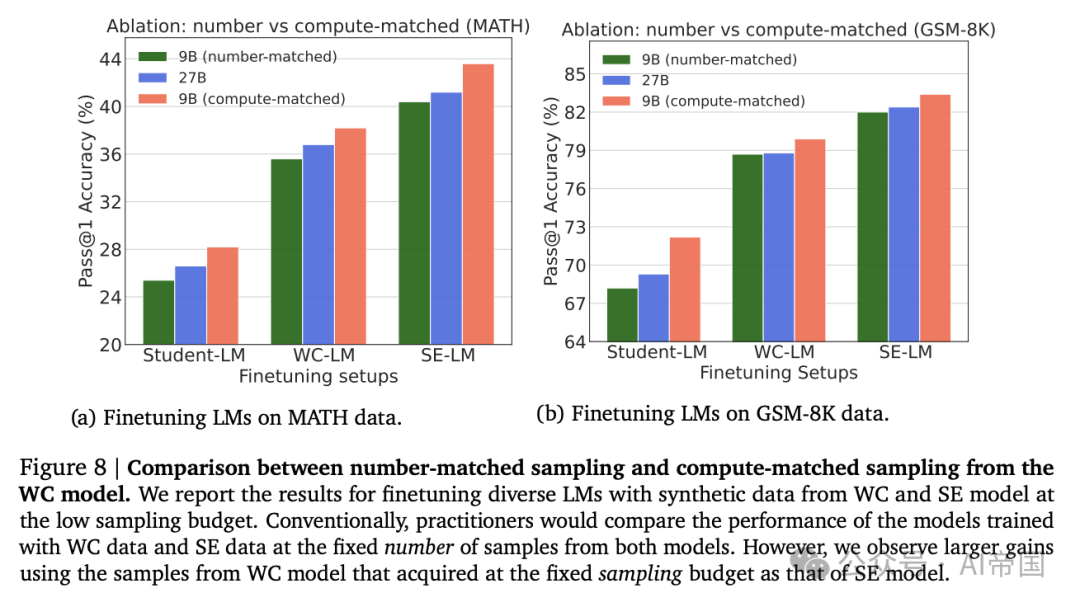

默认与计算最优采样对比:廉价语言模型(LM)的采样策略:论文预期,先前之所以倾向于使用强模型(SE)数据而非弱模型(WC)数据,是因为它们在测试环境中采用了等量样本生成的方式(例如,参见(Singh et al., 2023)),而非计算资源匹配的设置。为了验证这一点,论文针对MATH和GSM-8K数据集,从WC模型中每个问题仅生成一个解决方案(数量匹配),并在筛选出最终答案正确性的基础上,对这些生成数据在三种微调设置下进行模型训练。随后,论文对比了使用合成数据训练的模型性能,其中每个问题从WC模型生成3个解决方案,采样计算量与SE模型相匹配。结果如图8所示。论文发现,使用数量匹配的WC数据训练的模型,其性能不如使用计算匹配的WC数据训练的模型,且相较于使用SE数据训练的模型效果更差。这表明,未来在比较弱模型与强模型生成的合成数据时,应采用计算资源匹配的采样策略。

图 8 数字匹配采样与计算匹配采样在WC模型中的比较。论文报告了在低采样预算下,使用WC和SE模型生成的合成数据对多种语言模型进行微调的结果。传统上,从业者会在从两个模型中固定数量的样本上比较训练模型的性能。然而,论文观察到,使用与SE模型相同采样预算获取的WC模型样本,其性能提升更大。

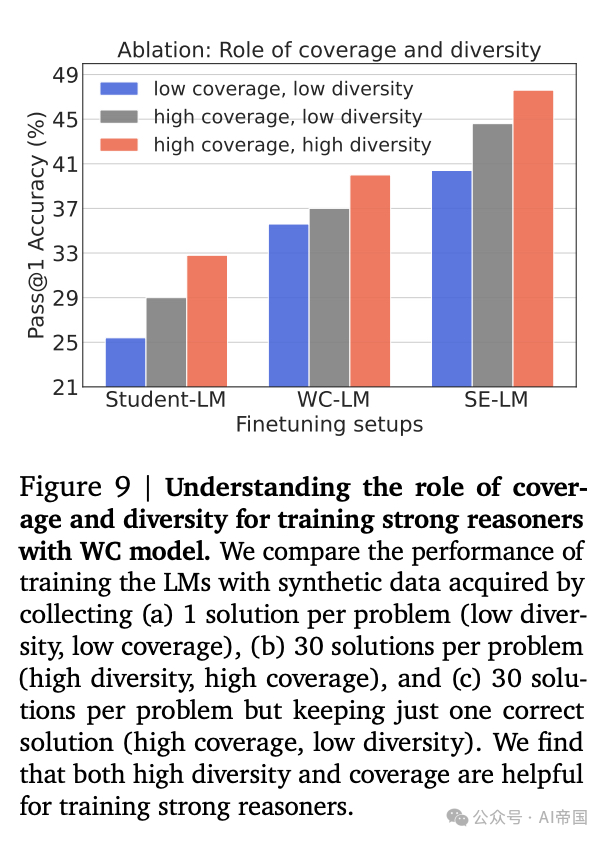

覆盖率和多样性:论文旨在理解覆盖率和多样性在提升使用WC生成合成数据训练模型性能中的作用。为此,对于MATH数据集,论文将原始高采样(每个问题30个解决方案)的WC数据集视为(高覆盖率,高多样性)数据集。然后,论文通过仅从样本中选择每个问题的一个正确解决方案来构建一个(高覆盖率,低多样性)版本。这使得原始WC数据集的多样性从11降低到 1,同时保持了覆盖率。论文还创建了一个(低覆盖率,低多样性)数据集,其中论文仅从WC模型生成每个问题的一个解决方案,并对其最终答案的正确性进行过滤。该数据集的覆盖率(27%)低于每个问题30个解决方案的WC数据集(43%)。论文在这些数据集上对三种微调设置进行模型训练,并在图 emptyset 中展示结果。论文的结果表明,在所有设置中,高覆盖率和高多样性数据优于高覆盖率和低多样性数据,而高覆盖率和低多样性数据优于低覆盖率和低多样性数据。这表明覆盖率和多样性在从小型语言模型训练强大推理器时都起着关键作用。

图 9 | 理解覆盖率和多样性在利用WC模型训练强推理器中的作用。论文比较了通过收集(a)每个问题1个解决方案(低多样性,低覆盖率),(b)每个问题30个解决方案(高多样性,高覆盖率),以及(c)每个问题30个解决方案但仅保留一个正确解决方案(高覆盖率,低多样性)获得的合成数据训练语言模型(LMs)的性能。论文发现,高多样性和覆盖率都有助于训练强推理器。

2.6. 扩展至SOTA的语言模型

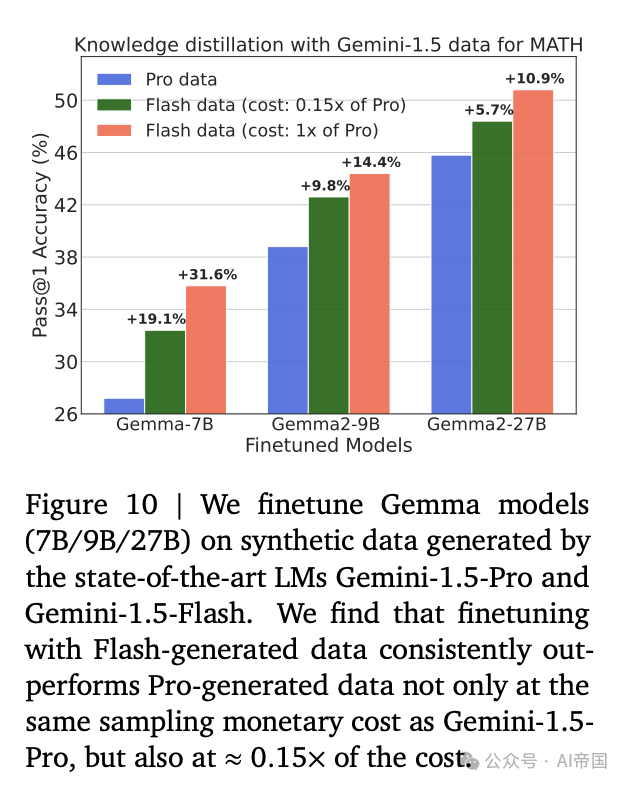

在前述实验中,论文专注于从开放式LMs获取合成数据。在这里,论文的目标是在固定采样预算下,展示来自较弱SoTA LM的数据能够训练出比更强SoTA LM更好的推理器。为此,论文将论文的方法扩展到从Gemini-1.5-Pro和Gemini-1.5-Flash采样数据。由于模型大小未公开,论文利用每输出token的定价比例作为代理来执行计算匹配采样。截至2024年8月,论文注意到每百万输出token的价格分别为Gemini-1.5-Pro的10.5和Gemini-1.5-Flash的0.3。因此,论文从1.5-Pro和1.5-Flash分别采样1个和35个解决方案。论文在MATH数据集上进行了实验。

图10 | 论文在由最先进的语言模型Gemini-1.5-Pro和Gemini-1.5-Flash生成的合成数据上对Gemma模型(7B/9B/27B)进行微调。论文发现,使用Flash生成的数据进行微调不仅在与Gemini-1.5-Pro相同的采样成本下始终优于使用Pro生成的数据,而且在约0.15倍的成本下也表现更佳。

论文对Gemma- 7 B、Gemma2- 9 B 和 Gemma2-27B LMs 进行了知识蒸馏,使用来自Pro(SED)和Flash(WC)模型的合成数据。论文在图10中展示了结果。有趣的是,论文发现使用WC数据进行微调优于使用SE数据,分别为Gemma- 7 B、Gemma2- 9 B 和 Gemma2-27B 分别实现了31.6%、14.4%和10.9%的相对增益。这可以归因于在固定采样预算下模型覆盖率的差异,1.5-Pro和1.5-Flash的覆盖率分别为61.1%和81%。

降低数据采样的成本。此外,论文研究了使用比从SE模型中收集每个问题一个解决方案更经济的WC数据来训练LMs。具体而言,论文通过从最先进的LMs Gemini-1.5-Pro和Flash(WC)模型中为每个问题采样5个解决方案来创建数据集,这在价格上比从Pro(SE)模型生成一个解决方案经济7倍(Phi)。在训练LMs于0.15倍成本数据的情况下(图10),论文发现使用Flash生成的数据进行微调不仅在采样成本上与Gemini-1.5-Pro相同,而且在0.15倍成本下也能表现更优。

要点:论文证明了从较弱的SoTA LM中进行价格匹配采样产生的推理器优于从较强的SoTA模型中微调的数据

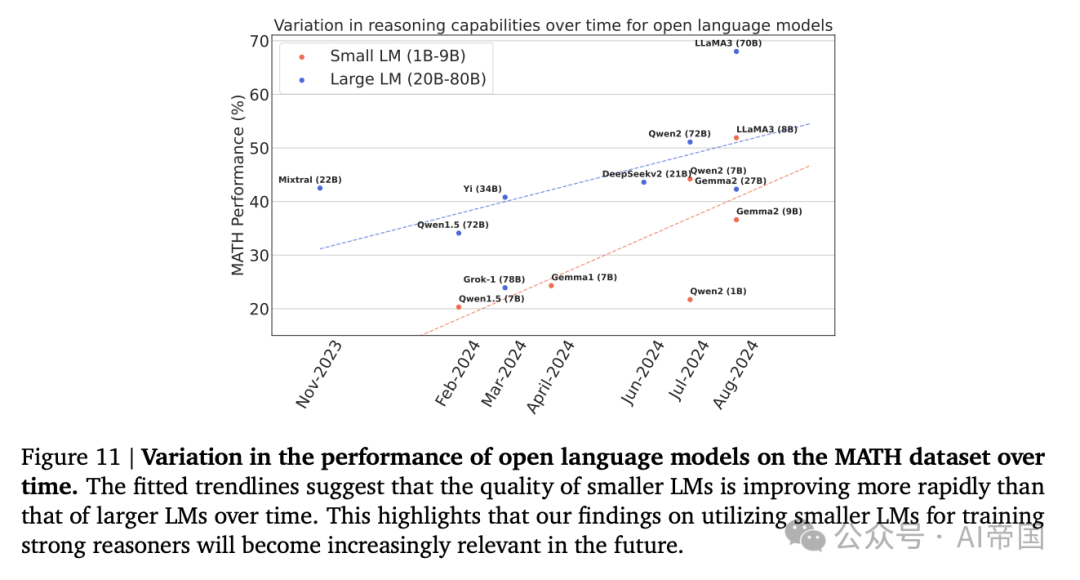

图11 | 开放语言模型在MATH数据集上性能随时间的变化。拟合的趋势线表明,小型语言模型(LM)的质量随时间提升速度比大型语言模型(LV)更快。这突显了论文关于利用小型LM训练强大推理者的发现将在未来变得越来越相关。

本文转载自 AI帝国,作者:无影寺