一文回顾生成式AI的发展:GANs、GPT、自编码器、扩散模型和Transformer系列 精华

ChatGPT的推出引起了全球关注,标志着生成人工智能领域的一个重要里程碑。尽管生成人工智能在过去十年中一直存在,但ChatGPT的引入引发了人工智能领域的新一轮研究和创新浪潮。这种兴趣的激增导致了许多先进工具的开发和发布,如Bard、Stable Diffusion、DALL-E、Make-A-Video、Runway ML和Jukebox等。这些工具展示了卓越的能力,涵盖了从文本生成和音乐创作,图像创建,视频制作,代码生成,甚至科学工作等各种任务。它们建立在各种先进模型的基础上,包括Stable Diffusion、变分自动编码器、生成对抗网络以及像GPT-3(最近的GPT-4)这样的Transformer模型。生成人工智能的这一进展提供了丰富的令人兴奋的机会,同时也带来了前所未有的挑战。在本文中,探讨了这些先进模型,它们能够完成的各种任务,它们带来的挑战,以及生成人工智能充满希望的未来。

引言

ChatGPT于2022年11月30日发布,引发了生成人工智能(GAI)在公众中的突破性和广泛的流行,标志着人工智能领域的一个显著成就。这一卓越的成就可以追溯到1956年由麦卡锡主持的达特茅斯学院夏季项目,标志着人工智能的起源。这一努力的目标是开发具有执行通常需要人类智能的任务的机器,包括计算机视觉、自然语言处理、机器人技术等。从那时以来,在使机器具备像人类一样说话、行走、思考和行动的能力方面取得了重大进展。值得注意的是,一系列算法,包括回归模型、感知器算法、决策树、K最近邻算法、朴素贝叶斯分类器、反向传播、支持向量机(SVM)和随机森林已经出现。这些算法通常被称为经典/传统机器学习算法,大多数在2000年之前开发。此外,深度学习算法也有了进展,包括20世纪80年代卷积神经网络(CNNs)的发展,20世纪85年循环神经网络(RNNs),1997年长短期记忆(LSTM)以及双向长短期记忆(BiLSTM)。然而,直到最近,广泛关注主要受到计算资源和数据集可用性限制的限制。

为了解决数据集有限的限制,斯坦福大学、普林斯顿大学和哥伦比亚大学的研究人员于2010年共同推出了ImageNet大规模视觉识别挑战。这次竞赛在推动神经网络架构方面发挥了关键作用,特别关注卷积神经网络(CNNs)。从那时起,CNN已经被确立为图像分类和计算机视觉的算法。2012年AlexNet的突破性成就标志着深度学习在计算机视觉任务中的实际应用取得了重要进展。ImageNet竞赛的成功引发了对深度学习研究的兴趣和投资的激增。

这种新发热潮导致了不断发展的改进架构创新,包括ResNet、DenseNet、MobileNet和EfficientNet等模型。这些模型为各种尖端技术设立了标杆,例如迁移学习、持续学习、注意机制、自监督学习和生成人工智能。

在2014年之前,所有现有的深度学习模型主要是描述性的,侧重于总结或表示现有数据的模式和关系。这些模型旨在解释数据模式并基于现有信息进行预测。然而,Goodfellow等人在2014年引入了生成对抗网络(GAN),开启了生成人工智能(GAI)实现的新时代。与它们的描述性对应物不同,生成模型(例如GANs)的设计目标是学习数据的概率分布。它们的主要目标是生成新的数据样本,这些样本与训练数据中观察到的模式密切相似。

GAN的突破标志着与传统深度学习方法的显著分离,为生成人工智能带来了令人兴奋的可能性。由于其在生活的各个领域产生的转变性影响,GAI自那时以来一直引起广泛关注。它为复杂问题提供了优雅的解决方案,使合成数据、艺术内容和逼真模拟成为可能。这种对人工智能技术的范式转变深刻影响了对人工智能的新认知、实施和利用,引发了跨行业的创新和新的应用机会。

GAI的出现引发了许多问题,促使对其进行全面探讨。在这方面,本文旨在深入探讨GAI的最新技术,包括模型、任务分类、应用领域、影响领域、挑战和前景。为了实现这一目标,将介绍当代生成模型,生成人工智能中的各种任务。以及审视生成人工智能的各种应用,并深入探讨了生成人工智能的前景。最后,提供结论。

生成模型

在当代,研究人员的关注已从判别学习转向生成学习。出现了多个生成模型,具有生成新数据点的能力,这些数据点类似于基于学习它们的分布的训练数据输入。讨论下生成模型的当前最先进的理论和数学基础。

自编码器

自编码器是一种无监督的机器学习神经网络模型,它使用编码器将输入数据编码成低维表示(编码),然后使用解码器将其解码回原始形式(解码),同时减少重构误差。该模型最初被设计用于降维、特征提取、图像去噪、图像压缩、图像搜索、异常检测和缺失值填补。

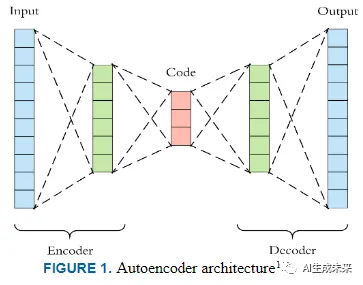

该模型的编码器和解码器都是神经网络,分别写成输入的函数和码层的通用函数。根据下图1,

自编码器由四个组件组成,即:

• 编码器:该组件将输入数据降维压缩为较低维度。由于其输出,它创建了一个称为“码”的新层。

• 码/瓶颈:包含输入数据表示的压缩和可能的最低维度的层。考虑下面的方程1。

• 重构损失:定义解码器的最终输出,衡量输出与原始输入的相似程度。

自编码器的训练涉及最小化输入和输出之间的不相似性,如方程3所示。

编码器和解码器由全连接的前馈神经网络组成,其中输入、码和输出层分别由用户定义的单个神经网络层构成。与其他标准神经网络一样,自编码器应用激活函数,如sigmoid和ReLU。存在各种自编码器的变体,例如收缩、去噪和稀疏自编码器。通常,前面提到的普通自编码器不是生成型的,因为它们不生成新数据,而是复制输入。然而,变分自编码器是一种生成型的变体。

变分自编码器

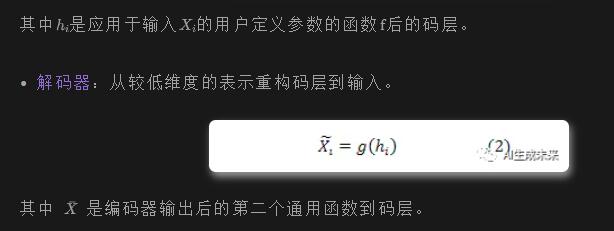

变分自编码器(VAE)是由Kingma等人引入变分推理(一种用于近似复杂分布的统计技术)到自编码器(AE)而演变而来的。它是一种生成模型,利用变分贝叶斯推理来描述使用概率分布生成数据。

与传统的AE不同,VAE除了有一个编码器和解码器层外,还有一个额外的采样层,如下图2所示。

训练VAE模型涉及将输入编码为潜在空间上的分布,并从分布采样生成潜在向量。然后,解码潜在向量,计算重构误差,并通过网络进行反向传播。在训练过程中,明确引入正则化以防止过拟合。

概率上,VAE由潜在表示 z 组成,如下图3所示,

从先验分布 p(z) 中抽取,数据 x 从条件概率分布 p(x|z) 中抽取,该分布被称为概率解码器,可以表示为:

模型的推理通过使用贝叶斯定理计算潜在向量的后验概率来进行检验,如方程5所示。

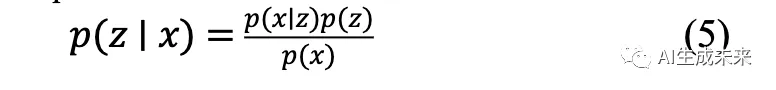

对于任何分布变体,如高斯分布,变分推理可以近似后验概率,其近似的可靠性可以通过度量在近似过程中丢失的信息的Kullback-Leibler(KL)散度来评估。正如下表1所示,这个模型在各个领域都产生了显著影响,突出显示了使用VAE的一些杰出的最新技术示例。

Transformer

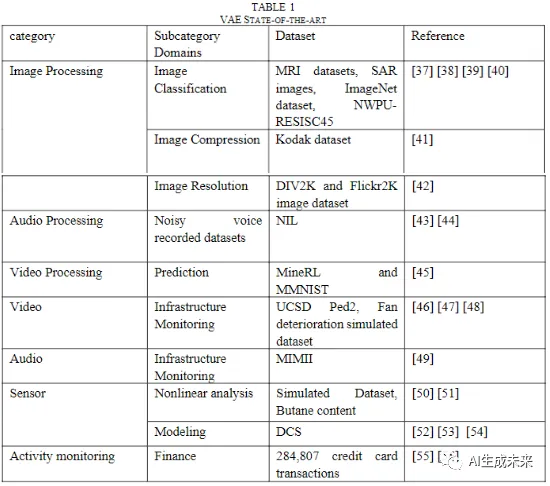

Vaswani等人在Google Brain团队的开创性工作中提出的"Attention Is All You Need"引入了一种可以分析大规模数据集的Transformer模型。Transformer最初是为自然语言处理(NLP)而开发的,但随后被改编用于机器学习的其他领域,如计算机视觉。该模型旨在解决循环神经网络(RNNs)和卷积神经网络(CNNs)的缺陷,如长距离依赖性、梯度消失、梯度爆炸、需要更大的训练步骤以达到局部/全局极小值,以及不允许并行计算的事实。因此,提出的解决方案呈现了一种处理神经网络任务的新颖方式,如翻译、内容生成和情感分析。

「Transformer架构」

Vaswani等人在他们的研究中引入了下图4所示的三个主要概念,包括自注意力(self-attention),允许模型根据其重要性评估输入序列,从而减少长距离依赖性;多头注意力(multi-head attention),允许模型学习输入序列的多个表示方式;以及词嵌入(word embedding),将输入转化为向量。

「编码器和解码器」值得一提的是,Transformer架构(图4)继承了编码器-解码器结构,利用了堆叠的自注意力和point-wise层,以及编码器和解码器的全连接层。编码器由N = 6个相同层的堆叠组成,每个层都有两个子层,包括一个多头自注意力机制和一个全连接的前馈网络。解码器类似于编码器,但有一个额外的子层,用于屏蔽多头注意力。编码器和解码器都对子层应用残差连接,然后对层进行归一化。

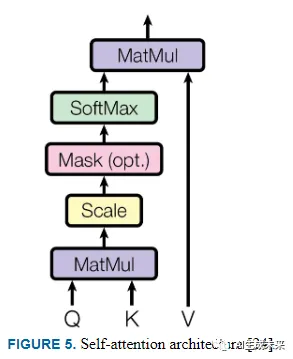

「自注意力」

图5描述了结构注意力,其中SoftMax激活函数用于计算值的权重。

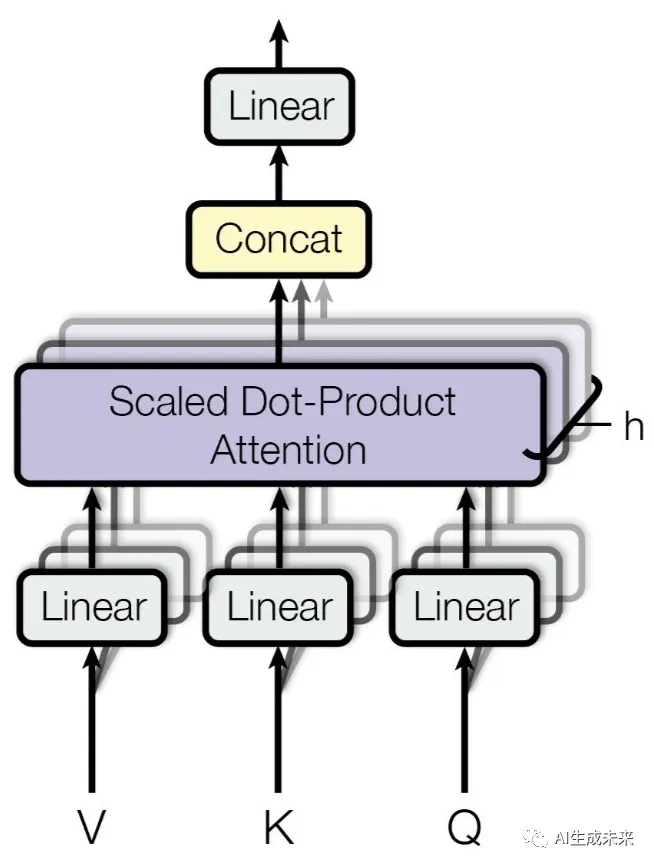

「多头注意力」

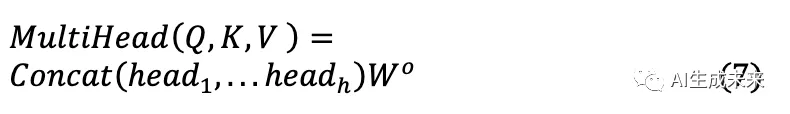

多头注意力机制提出,自注意力可以以并行模式运行多次,通过查询、键和值的不同表示子空间结合相同注意力池的知识。然后,独立的注意力输出被串联并线性转换为期望的维度,如方程7和图6所示。

其中,

自从Transformer被发明以来,已经开发了多个变体,用于解决计算机视觉和自然语言处理中的不同机器学习任务。值得注意的是,现代最先进的模型都是基于Transformer架构构建的。

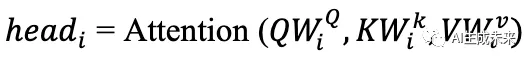

1)生成预训练Transformer(GPT)

生成预训练Transformer(GPT)描述了基于Transformer的大语言模型(LLM),利用深度学习技术生成类似人类的文本。该模型由OpenAI于2018年引入,在Google于2017年发明Transformer之后。它由一堆Transformer解码器组成。他们提出了一个模型,包括两个阶段:从大量文本语料库中学习高容量语言模型,然后在判别任务期间使用带标签的数据进行微调,如下图7所示。

GPT或GPT-1是在BooksCorpus数据集上训练的,该数据集包含超过7,000本不同流派的未发表书籍,如冒险、奇幻和言情小说,所有书籍都有长段连续文本,使生成模型能够学习长距离信息。该模型的训练规格包括以下内容:

- 12层仅解码器Transformer。

- 掩码自注意头(768维状态和12个注意头)。

- 位置逐层前馈网络。

- Adam优化。

- 学习速率:2.5e-4。

- 3072维内部状态。

模型的评估任务来自自然语言处理(NLP)中的四个主要类别,包括自然语言推理、问答和常识推理、语义相似性和分类。在初始发布之后,OpenAI推出了一系列称为GPT-n系列的变体模型,其中每个后继模型都比前身更为重大和高效。GPT-4是最近在2023年3月发布的变体。

2)GPT-2

在GPT-1取得巨大成功后,OpenAI于2019年发布了第二个版本(GPT-2),具有15亿个可学习参数,比其在WebText上训练的前身的预训练语料库和参数多十倍。因此,该模型能够处理复杂问题,并在广泛的主题和风格上生成连贯且上下文相关的文本。

3)GPT-3

这个版本于2020年发布,有2048 tokens的上下文,1750亿可学习参数,比其前身多100倍以上,并需要800GB的存储。使用CommonCrawl对模型进行训练,在NLP的所有领域进行了测试,并具有有希望的few-short和zero-shot性能。这个版本进一步改进为GPT 3.5,用于开发ChatGPT。已进行了大量的研究工作,涵盖了从GPT-1到GPT-3.5的各种任务,如语音识别、文本生成、密码学、计算机视觉和问答。

4)GPT-4

在2023年3月,OpenAI发布了最新的GPT模型,名为GPT-4。这是一个多模态Transformer模型,是一个大规模的语言模型,接受图像和文本输入并生成文本输出。在许多专业和学术基准测试中,包括在高水平通过法律和医学考试等,GPT-4表现出与人类相当的高性能。该模型是使用公开可用的互联网数据和从第三方获得的数据进行训练的,然后通过使用来自人类反馈的强化学习(RLHF)进行微调。它与使用测量大规模多任务语言理解(MMLU)的最先进模型进行了比较,该任务涵盖了初等数学、美国历史、计算机科学、法律等57个任务,并在所有任务中表现出色。

生成对抗网络(GAN)

1)GAN概述

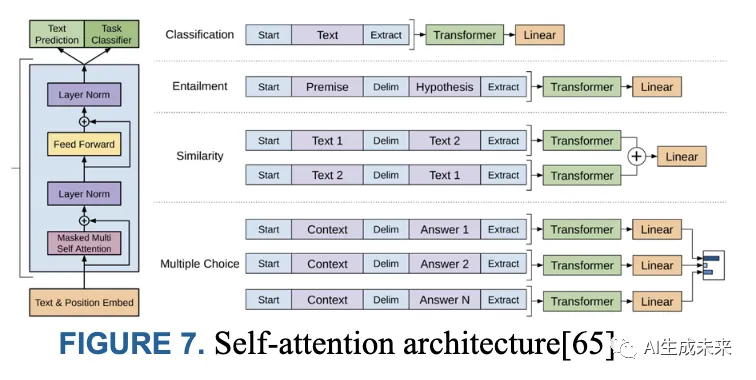

生成对抗网络(GAN)是一种无监督的生成模型,由两个神经网络组成:一个生成器和一个判别器。生成器试图制造与真实数据无法区分的新数据(伪造数据),而判别器则试图区分真实数据和伪造数据。下图8展示了GAN的原理架构(也称为普通GAN)。

生成器网络以噪声作为输入并生成伪造数据。判别器网络以真实数据和伪造数据作为输入,并使用Sigmoid激活函数和二元交叉熵损失将它们分类为真实或伪造。由于生成器没有直接访问真实图像,它只能通过与判别器的交互进行学习;判别器可以访问合成和真实图像。在完成分类后,进行反向传播以优化训练过程。此过程重复进行,直到真实数据和伪造数据样本之间的差异可以忽略不计。

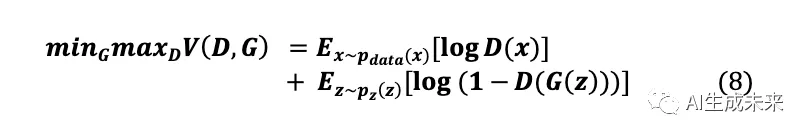

根据Goodfellow等人的研究,生成器(G)和判别器(D)一起在一个极小极大博弈(零和博弈)中进行训练。如方程8所示,在这个博弈中,G试图最大化D错误分类其输出为真实数据的概率,而D试图最小化其错误分类G输出的概率。

其中E表示期望值,是真实数据分布,(𝒛)表示噪声数据分布。

2) GAN 挑战

尽管 GAN 具有强大的特性,但传统 GAN 存在一些局限,例如:

「模式崩溃(Mode Collapse)」:

在这种现象中,生成器只能生成单一类型的输出或有限数量的输出 。这是因为生成器陷入了特定的模式或模式,无法生成覆盖整个数据范围的多样化输出 。主要原因包括灾难性遗忘 和鉴别器过拟合,导致生成器损失消失。

「不收敛和不稳定」:

上面方程 8 中的损失函数可能导致生成器出现梯度消失的问题 。当鉴别器学习得太快,可以轻松区分真实和伪造的样本时,就会发生这种情况,而生成器可能具有较低的学习率并且无法跟上。这可能导致训练过程停滞,因为生成器无法从鉴别器提供的反馈中学习。GAN 也对超参数的选择敏感,这意味着一点点的超参数更改可能会显著影响结果。

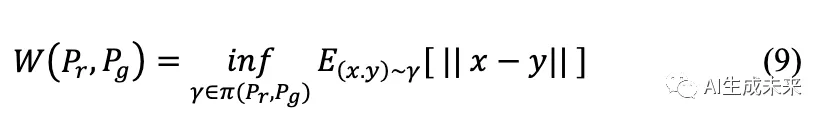

为了解决梯度消失问题,可以使用不同的损失函数,例如 Wasserstein 损失。

Wasserstein 损失对鉴别器的学习率不太敏感,可以防止生成器的梯度消失。另一个解决方案是使用学习率较小的生成器,以避免大权重导致的梯度消失。对于生成器,必须使用良好的初始化技术。通过这种方式,生成器将有一个良好的起点,训练过程可能会成功。

3) GAN 变体

针对上述 GAN 挑战,已经开发了各种变体来解决这些弱点并优化模型。以下是自 2014 年以来 GAN 的一些最著名的变体:

「有条件生成对抗网络 (cGAN)」

由 Mirza 等人于 2014 年引入,cGAN 通过将额外的辅助信息引入生成器和鉴别器网络中,如类别标签或风格属性,从而增强了经典 GAN 。通过引入一个包含条件信息输入到生成器的额外层,指导生成器生成什么。

「深度卷积生成对抗网络 (DCGAN)」

该框架使用卷积神经网络 (CNN) 作为鉴别器和生成器组件,省略了传统的在卷积特征之上的全连接层。Batch Normalization 增强了训练的稳定性,对每个神经单元的输入进行规范化。DCGAN 使用步进卷积和分数步进卷积代替池化层。ReLU 和 Leaky ReLU 分别用作生成器和鉴别器的激活函数。

「Wasserstein GAN (WGAN)」

Wasserstein GAN(WGAN)是一种GAN变体,采用Wasserstein距离(也称为推土机距离)作为其损失函数,与传统的GAN不同,后者通常使用Jensen-Shannon或Kullback-Leibler散度。Wasserstein距离(WD)衡量了真实样本和生成样本分布之间的相似性,其基础是一个称为运输问题的经典优化问题的解。在这个背景下,假设存在多个供应商,每个都具有一定数量的商品,任务是将其交付给多个消费者,每个消费者都有特定的容量限制。每对供应商-消费者会产生运输单个商品的成本。运输问题的目标是找到从供应商到消费者的最具成本效益的商品分配。

「Cycle GAN」

Cycle GAN 是一种自动训练图像到图像翻译模型的方法,无需配对的示例,利用了 GAN 架构。它利用来自不同源和目标域的不相关图像集合(例如,域 X 和域 Y)。模型结构包括两个生成器:Generator-X 为域 X 创造图像,Generator-Y 为域 Y 生成图像。每个生成器都有一个相应的鉴别器进行二进制分类。

该变体包含三个损失函数:首先,循环一致性损失确保域之间的转换保持一个连贯的循环,返回到其原始点;其次,对抗损失将生成器与其相应的鉴别器对立起来,生成器努力生成特定于域的图像,而鉴别器区分转换和真实样本;第三,ID损失鼓励生成器忠实地保留输入和输出之间的色彩组合,增强了翻译的保真度。

「StarGAN」

StarGAN 利用 GAN 架构进行多领域图像到图像翻译。正如 Choi 等人所述,这个创新的生成对抗网络巧妙地学习了多个领域之间的映射,只使用一个生成器和鉴别器,并有效地训练了跨足所有领域的图像。该模型利用对抗损失使生成的图像与真实图像几乎无法区分,使用领域分类损失来确保鉴别器的精确分类,以及重建损失,最小化对抗和分类损失。

「总结:」 本节深入探讨了多个生成对抗网络(GANs)的变体。然而,值得注意的是,GANs 领域涵盖了许多其他变体,这些变体在基础 GAN 框架之上取得了显著的进展。这些显著的进展包括 2017 年的 Progressive GAN(PGAN),2018 年的 BigGAN ,2019 年的 StyleGAN 和 StyleGAN 2 ,以及较早的创新,如 InfoGAN ,Stacked GAN ,2016 年的双向 GAN(BiGAN)。

Diffusion 模型

扩散模型的特点是一个两步生成过程。首先,在训练数据中引入高斯噪声,称为前向扩散过程。随后进行逆扩散过程,通常称为去噪,以重构原始数据。随着时间的推移,模型逐渐学会消除添加的噪声。

生成式 AI 任务

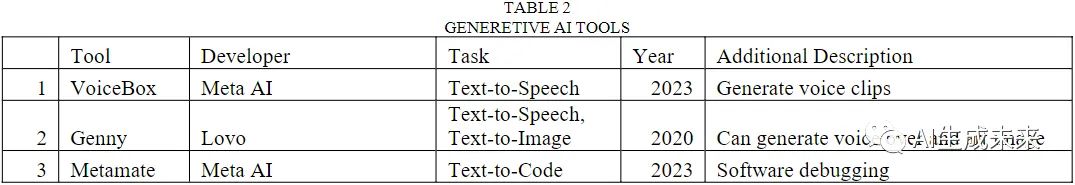

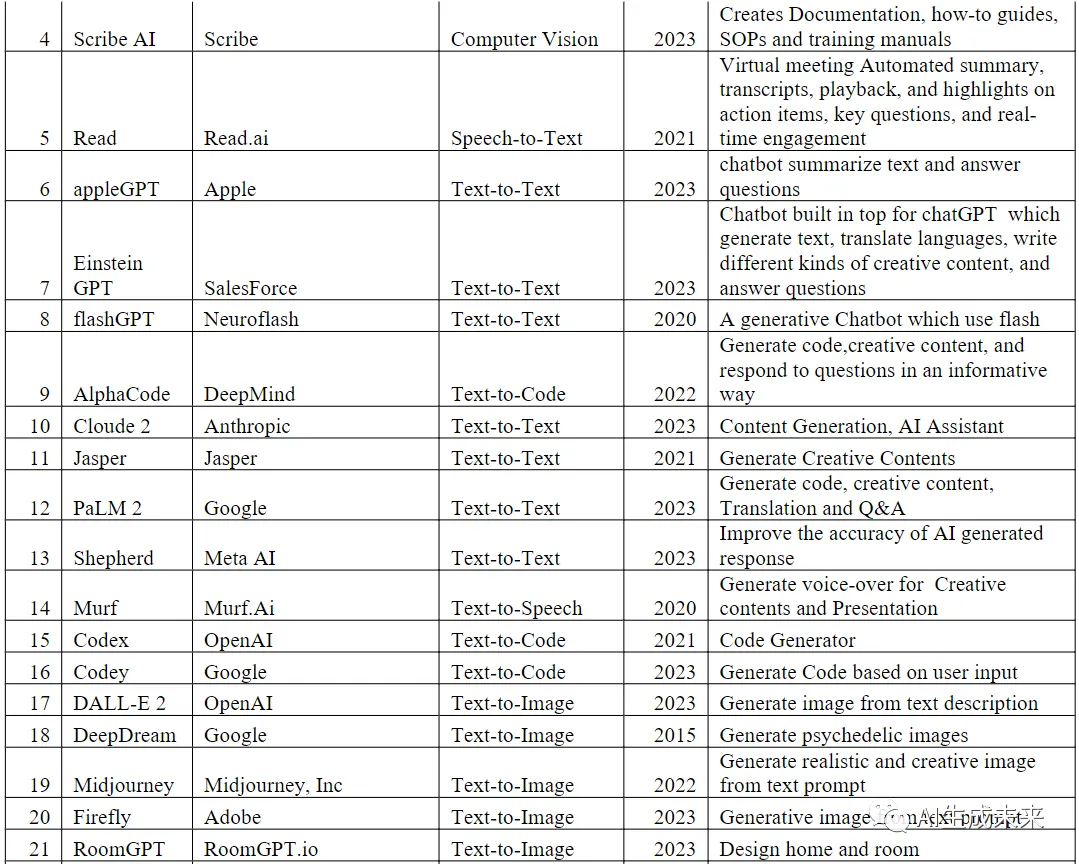

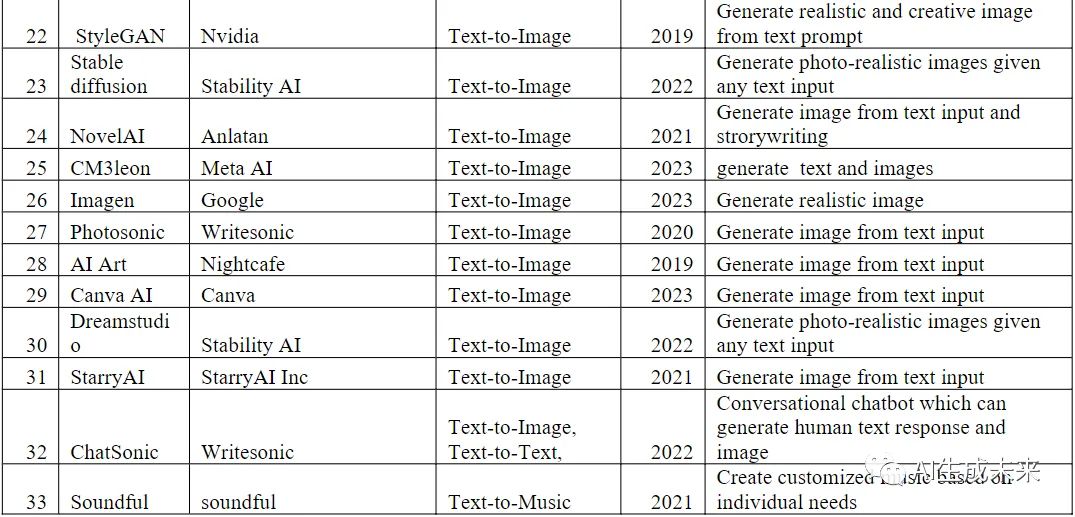

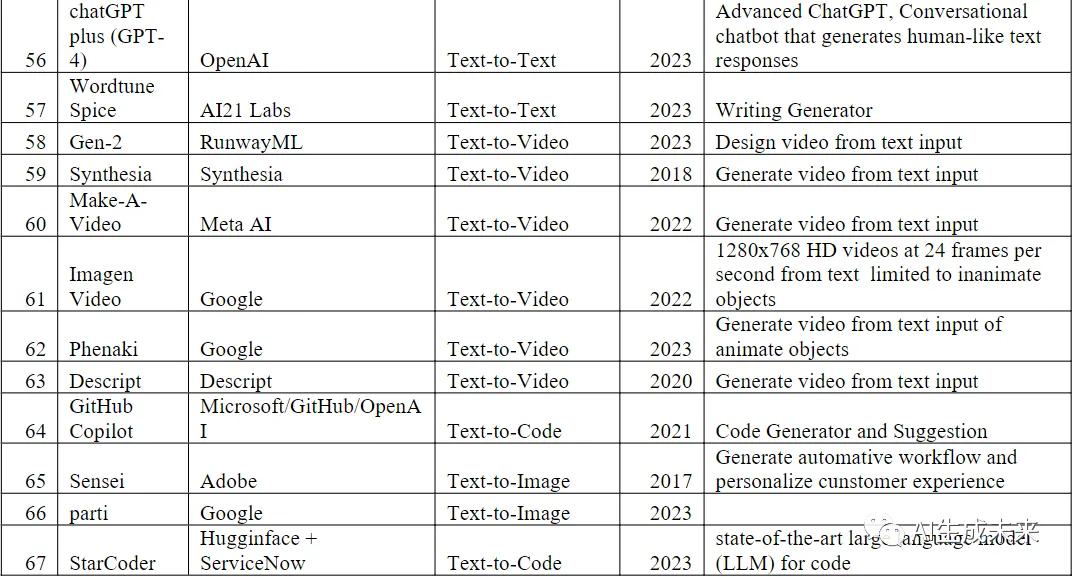

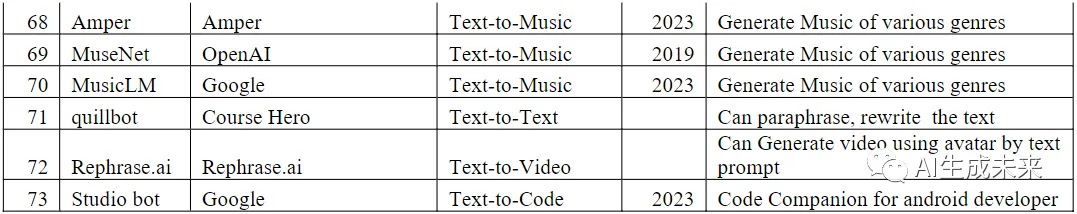

生成式AI涵盖了各种任务,包括语音生成(文本转语音)、图像生成(文本转图像)、文本生成(文本到文本)、代码生成(文本到代码)、音乐生成(文本到音乐)、视频生成(文本到视频)和科学内容生成(文本到科学)。各种先进的工具支持这些任务,如下表2所示,其中谷歌拥有最多的生成工具,其次是Meta AI和OpenAI,如表2所示。这些工具大多数在2023年推出,其中有一些是早些时候引入的。

文本生成

文本生成涉及将文本作为输入并生成相应的基于文本的响应。这个任务通常与问答对话系统相关,通常被称为聊天机器人。许多著名的生成式AI工具属于这一类别,ChatGPT是其中的一个开创性例子。其他显著的工具包括谷歌的Bard、OpenAI的ChatGPT Plus、Wordtune Spice和Cohere的Generate。

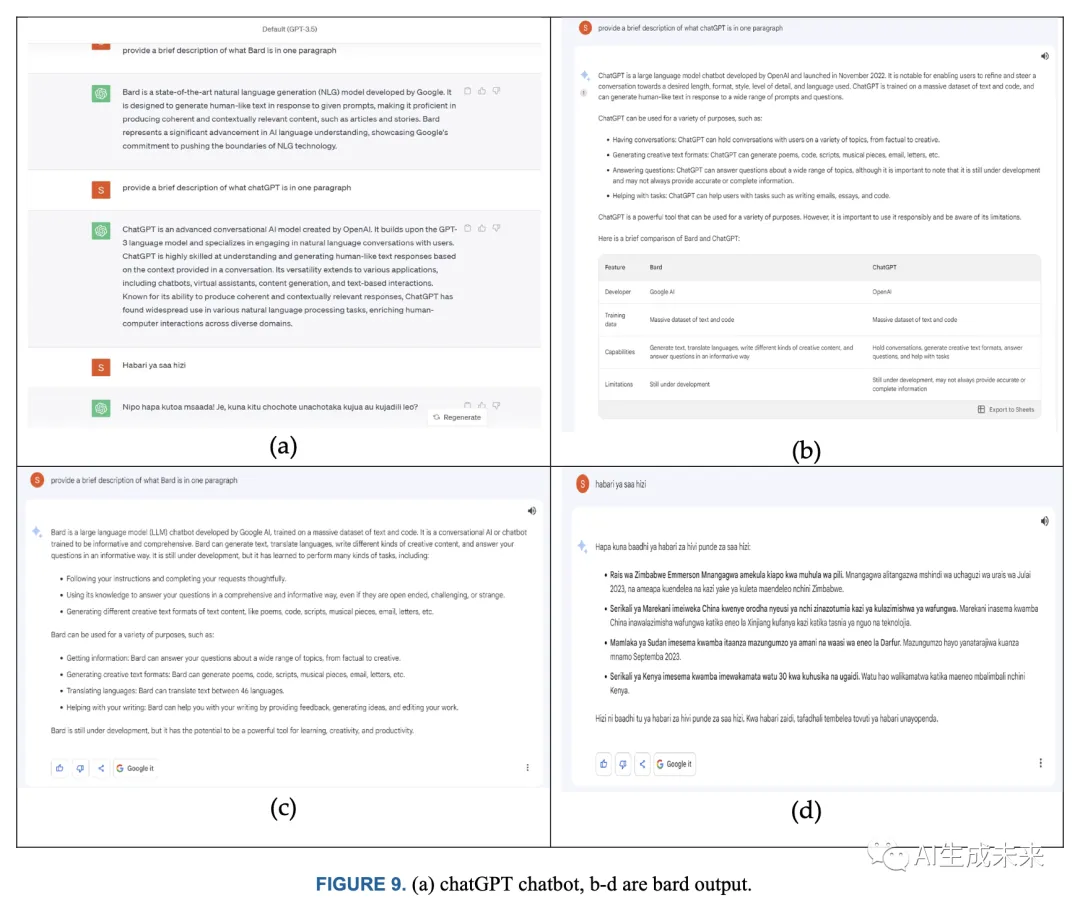

对两个著名的文本到文本工具Bard和ChatGPT进行了全面的性能评估。它们都被提供了相同的查询:“提供Bard的简要描述一段”,“提供ChatGPT的简要描述一段”,以及一个斯瓦希里语的问题,“Habari za saa hizi”。如图9所示的结果明确显示,ChatGPT在提供更精确的答案方面优于Bard。

图像生成

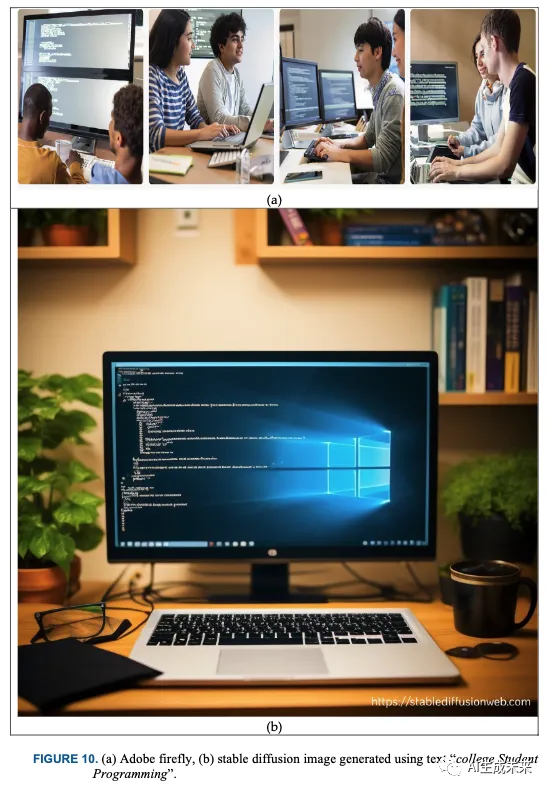

这是一个涵盖了利用文本提示或视觉信息生成相应图像的过程,涵盖了各种视觉领域,包括图形、照片和艺术作品。作为文本到图像概念的示例,使用了Adobe的'Firefly'和Stability的'Stable Diffusion'进行实验。通过使用“大学生编程”来提示这些模型,获得了它们各自的输出,如下图10所示。结果清楚地表明,虽然'Firefly'在提供与输入更精确匹配的输出方面表现出色,但相较于其对手,Stable Diffusion展示了更高的图像分辨率。

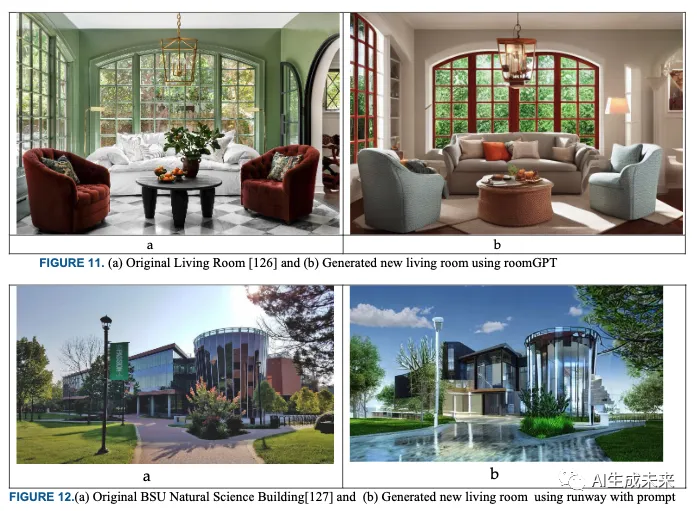

另一个情景的图像生成涉及根据提供的文本描述将图像从一种形式转换为另一种形式。在这个领域,许多工具展示了实现这种转换的有望能力。特别地,我们已经探索了RoomGPT和Runaway的性能,分别如图11和图12所示。

视频生成

这个任务涉及根据文本或视觉输入生成新的视频,其中视觉包括各种内容,包括图像和视频。在这个领域,有一些显著的工具专门设计为接受纯文本描述作为输入。一个典型的例子是Google的'Parti'和openAI的'DALL E-2',它们是专注于仅从文本提示中创建视频的高效工具。尽管如此,视频生成领域仍然在不断发展。工具如RunwayML的'Gen-2'、Google的'Imagen Video'和Meta的'Make-A-Video'已经成为先驱。这些先进的平台不仅拥有出色的能力,可以接受文本描述,而且还可以无缝集成图像和视频作为输入,超越了传统的边界。它们的卓越之处在于它们擅长将这些输入转化为全新的视频作品,从而展示了生成式AI在创意领域中视频制作的激动人心潜力。

代码生成

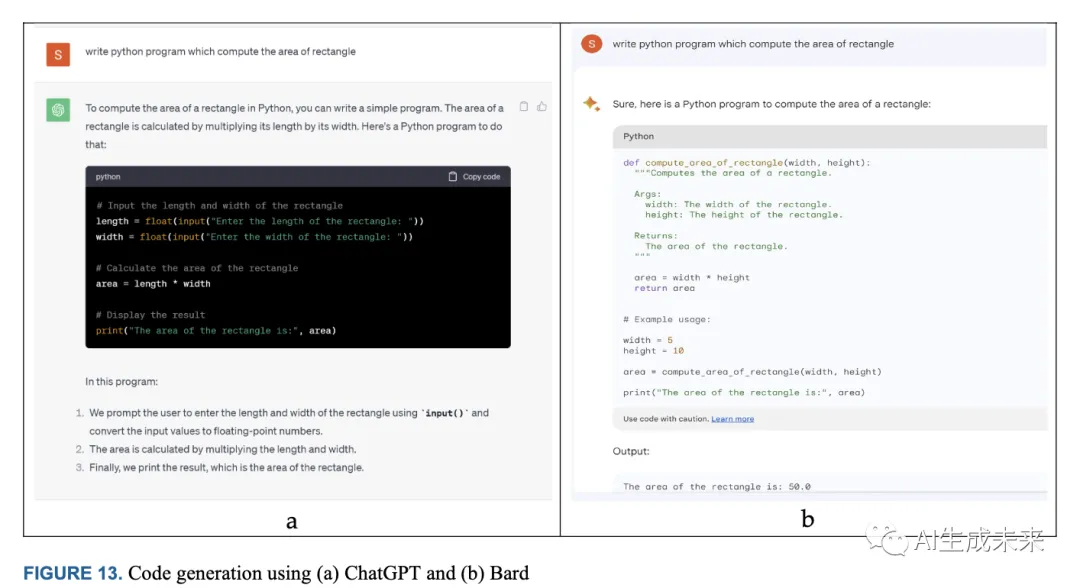

代码生成工具是专门的软件实用程序,能够根据提供的文本描述自动生成各种编程语言的码块。这些工具利用在广泛公开可用的码库上进行训练的复杂模型,拥有数十亿个参数。它们的主要目标是通过理解简单的英语并将其翻译成功能性代码来协助人类开发人员。这类工具的显著例子包括StarCoder 、Codex 、CoPilot、Codey和Code Interpreter。此外,值得注意的是,包括ChatGPT和Bard在内的一些文本到文本工具,如图13所示,也具备生成代码的能力。

音乐生成

这是一个迷人的生成任务,涉及全新音乐的创作。这个创新的过程以各种形式的输入为基础,包括文本描述、音乐音符序列,甚至音频样本。其目标是利用这些输入,并将它们转化为新鲜的音乐作品,涵盖了节奏、旋律、和谐的和弦以及多样的乐器。著名的工具如MuseNet 和Jukebox是音乐生成的杰出例子。这些创新平台利用生成式AI的力量,创作涵盖各种流派和风格的音乐作品。它们在为音乐艺术注入创造力方面表现出色,为艺术家和爱好者开辟了探索和享受的新途径。

语音生成

产生类似人类的语音或声音取决于文本或音频输入。文本输入可以包括书面文本,如句子、段落或整个文档,涵盖多种语言,包括标点符号、特殊符号和格式说明。语音生成模型,如SpeechGAN,进行一系列步骤,涉及语音合成、增强和转换。增强过程包括噪声处理、音调调制、情感传达和其他微妙的特征。在这个领域已经开发了许多工具来促进语音生成,其中一些包括Whisper、Speechelo、Synthesys、Voice Over和WaveNet。这些工具在生成紧密模仿自然语言的语音或言语方面表现出色,有效地模糊了人类和人工语音合成之间的界线。

科学内容生成

科学内容生成是一个多方面的过程,涵盖了在数学、物理、化学和生物等各个科学领域创建信息丰富和学术性内容的过程。这项工作旨在利用生成式AI的力量生成准确而富有洞察力的内容,有助于传播科学知识。在这一领域的一项显著研究由Rodriguez等人进行,探讨了基于文本输入生成科学图表的创新方式。这项开创性研究利用扩散模型,将文本描述无缝转化为视觉上具有信息性的科学图表,从而简化了科学沟通和可视化的过程。此外,谷歌进行中的研究项目Minerva是解决定量推理问题的重要进展。该项目利用大语言模型(LLM)的能力来解决复杂的定量挑战,从而增进我们对数学及其在科学领域的实际应用的理解。与此同时,Meta AI开发的先进工具Galactica 在科学写作中发挥着重要作用。这个平台为科学家和研究人员提供了强大的工具,帮助他们简化表达他们的科学发现、理论和见解的过程。

生成式AI的工业应用

生成式AI技术在当前和未来的相关性不可或缺。目前,生成式AI正对各个行业产生指数级的影响,本节将深入探讨受影响最大的领域。

媒体和娱乐

在娱乐产业中,生成式AI模型尽管仍处于早期阶段,但开始产生显著影响。它们的影响涵盖了各种娱乐领域,包括为小说、戏剧和电影进行剧本编写和故事板设计,涉及音频制作,包括作曲、编曲和混音,游戏设计和角色创建,创造引人入胜的虚拟世界,营销活动以及生成动态和静态图像。值得注意的是,许多易于获取的工具,如表3所示,使生成内容,如短片、笑话和图像更容易。这些工具中许多价格实惠,甚至免费,为传统的内容创作方法提供了替代方案。作为其潜力的一个例证,2022年,RunwayAI在创作奥斯卡获奖影片《Everything Everywhere All at Once》中发挥了作用,该影片获得了七项奥斯卡奖的认可。

教育和研究

生成式AI正在迅速改变教育领域的格局,提供创新解决方案,提升学生和教育者的学习体验。在教育中,生成式AI的一个重要影响是个性化内容生成工具的出现。这些工具,如GPT-3、GPT-4和Bard,使教育工作者能够制作定制的学习材料,包括互动课程、测验和学习指南,精确满足个别学生和教师的独特需求。此外,由AI驱动的聊天机器人和虚拟导师为学生提供实时支持,提供解释、解答问题和提供个性化反馈。这种变革性的技术有望重新定义学生如何获取和参与教育内容,促进根据每位学习者的特定偏好提供的可访问性和适应性。

生成式AI还打开了研究和学术探索的新途径。生成式AI工具的快速发展引起了全球研究人员和学者的兴趣,引发了一系列研究机会。科技巨头和研究机构正在投入大量资源,探索和发明这一领域的新工具和技术。这在生成式AI相关的论文激增的现象上表现得很明显,无论是在像IEEE这样的同行评审数据库,还是在arXiv这样的非评审平台上,生成式AI的主题都得到了突显。教育与生成式AI的融合不仅转变了学习体验,还催生了一个蓬勃发展的学术领域,承诺持续增长和创新。

医疗保健

生成式AI在医疗保健领域取得了重大进展,特别是在医学影像方面。它在克服与有限数据集相关的挑战方面发挥着关键作用,通过实现新数据的合成,最终提高了医学图像的质量和多样性。这一创新将彻底改变疾病检测和诊断,为医疗专业人员提供更准确和详细的信息。此外,生成式AI正在改变患者护理的行政方面。通过简化行政流程并提供虚拟健康助手,它简化了医疗管理并提供个性化的健康建议、用药提醒和情感支持。此外,生成式AI正在革新治疗规划。利用患者特定的数据,它可以生成根据个体的基因组、生活方式和病史定制的治疗计划。这种方法对精准医学表示了重大飞跃,确保患者获得最有效和个性化的治疗。

此外,生成式AI在药物开发和发现领域发挥着关键作用。通过生成分子结构和预测建模,它加速了新型治疗化合物的识别。这些进步可以解决先前难以治疗的疾病,为全球无数患者带来希望。值得注意的是,NVIDIA与Evozyne合作实施生成式AI,特别是ProT-VAE,标志着人工智能与医疗保健领域之间的显著协同作用。通过使用蛋白Transformer变分自编码器,他们已经为合成蛋白质的创造奠定了基础,为在对抗性不治之症的斗争中提供新途径。另一个值得注意的例子是谷歌与Cognizant的合作研究项目。他们的共同努力旨在构建专为医疗应用定制的大型语言模型(LLM),专注于增强医疗保健行政任务。这一努力利用了谷歌云及其框架的能力,为医疗保健领域创建了先进的生成式AI解决方案。

商业

生成式AI已经在商业领域牢牢树立了存在。下表3中列出的许多应用程序采用订阅模式,反映了这些工具不断增长的商业性质。彭博智库预测,生成式AI(GAI)将在2023年创造1370亿美元的价值,并预计到2030年将激增至1.3万亿美元。这种深远的影响横跨各个行业,从制造和批发到零售企业、银行业、农业等等。生成式AI的影响范围从创建新产品和自动化财务数据分析到生成个性化广告活动,为客户提供定制产品推荐,并生成产品描述和新闻文章。越来越明显的是,生成式AI正在重塑商业格局,并在未来具有巨大的经济潜力。

例如,亚马逊积极利用生成式AI的能力,通过对产品的简短描述,为卖家打造引人入胜、有说服力且有效的产品清单。亚马逊利用生成式AI生成高质量内容,卖家可以进一步完善或直接提交以丰富亚马逊的产品目录。

生成式AI的未来

生成式AI无疑具有重要而有前途的未来,在各个领域提供丰富而变革性的可能性。然而,它同样伴随着相当程度的不确定性和一系列值得深入探讨的问题。本节旨在探讨生成式AI的多方面,包括其潜力以及前方的挑战和不确定性。

第五次工业革命(5IR)的先锋

生成式AI代表着第五次工业革命(5IR)的前沿,这是一股力量,注定要革命第四次工业革命,并在各个领域引发变革性变化。这种转变得以实现,得益于互联网基础设施、大规模数据集和超越地理界限的分布式计算资源的深刻相互连接。多个行业,包括医疗保健、安全、网络基础设施、娱乐和教育,都在因生成式AI的能力而面临重大颠覆的边缘。然而,关键是要认识到这种颠覆潜力可能也会带来跨多个领域的基础设施改革,可能导致各种职业领域的高度自动化和优化。

在医疗保健行业中,正如我们所见,生成式AI已经在药物发现方面发挥着关键作用,特别强调探索蛋白质分子。这项技术在药物开发领域的潜力巨大,来自主要技术公司的大量投资强调了不久的将来预期的进展。然而,生成式AI的影响不仅限于药物开发,因为预计它将从根本上转变医疗保健领域的患者体验。通过利用患者的病历数据,它可以通过分析年龄、性别和潜在医疗状况等元数据自主诊断医疗状况。此外,它可以筛选大量患者数据以识别模式、做出预测并建议适当的药物。这一转变旨在优先考虑以患者为中心的临床体验,推动成本效益,最终实现医疗保健协议的显著增强。

在娱乐行业中,未来可预见的是,我们正站在一个变革性时代的门槛,生成式AI很可能主导娱乐和媒体领域的内容创作。从精心设计的剧本和叙述到细致安排的场景和栩栩如生的角色,生成式AI的影响力将渗透到这些行业内容生成的每个方面。此外,潜在的影响是如此深远,以至于它甚至可能挑战生命和艺术的界限。已故艺术家可能会继续发布新的专辑和创作,有效地超越了生命的限制。这不仅将开启艺术探索的新时代,而且承诺显著的成本节省,彻底改变电影和音乐制作的经济学。自动化场景创建和内容生成将降低开支并使创作过程更加高效。

在教育领域,AI聊天机器人(如ChatGPT和Google Bard)的出现,以及其他创新工具,为生成式AI在教育行业的民主化提供了令人信服的证据。这一显著进展使当前的教育体系和资源变得过时,尤其是在发达国家。它预示着对教育系统的全面改革,包括教学资源,以适应生成式AI时代的指数增长,旨在提供高度个性化和适应性的学习体验。

在先进制造业中,在生成式AI出现之前,机器人技术已经展示了令人印象深刻的能力。然而,随着生成式AI的整合,可以期待真正显著的进步。设想一下将生成式AI融入军事技术的后果,我们可能会看到生成核武器的发展,化学配方的制定用于饮料、清洁剂和各种工业产品,以及自动驾驶汽车的广泛采用。可能性的范围是广泛的,它无疑标志着一个新时代的开始——一场工业革命,承诺在众多行业领域实现彻底变革的景观和创新方法。

工作市场的变革

生成式AI对劳动力市场的影响是双重的:

首先,它引入了新的就业机会,涉及新兴领域,如AI可解释性和生成式AI工程。麦肯锡的分析表明,与生成式AI有关的职业的工作机会逐渐增加,这一趋势预计将持续到2030年左右。值得注意的是,美国工作人口中有84%的人占据的职位有潜力利用生成式AI自动执行大部分重复性任务,从而导致整体生产力的显著提升。有47%的美国高管对整合生成式AI表示信心,认为这将提高各行各业的生产力 。

相反,工作恶化;优化和自动化业务流程预计将用创造性和生成式AI功能替代许多现有的职业。生成式AI对劳动力市场的影响有望改变就业格局,逐渐用先进技术替代许多传统角色。根据世界经济论坛的报告,被大语言模型(LLM)自动化的潜力最高的任务是例行和重复的任务。这些任务包括信用授权人员、核对员、文员、管理分析师、电话营销人员、统计助手和出纳员。因此,个体必须优先考虑重新培训技能和增强适应性,以有效准备未来的人工智能驱动的工作。

隐私和安全顾虑

网络安全基础设施领域目前正在经历深刻而迅速的变革,主要是由于生成式AI的整合。这一重大变化引发了一系列迫切的关切和未来的挑战:

- 复杂的网络战争:目前,我们正在目睹恶意活动的显着增长,这一趋势预计将继续上升,同时变得更为错综复杂。例如,先进的网络威胁工具如WormGPT和FraudGPT 的出现迅速确立了它们自己作为网络威胁的开创性元素,它们经过精心设计,非常复杂和难以察觉。此外,由生成式AI提供动力的自动化和复杂的恶意软件和勒索软件的出现对颠覆现有加密方法具有威胁性。这主要是由于生成式AI固有的巨大计算能力。随着这些恶意实体的持续发展,它们对网络安全格局构成了巨大挑战,测试着当代网络安全系统和协议的韧性和稳健性的极限。这些发展的后果是深远的,可能对一个国家的关键基础设施造成毁灭性的影响,特别是在涉及国家赞助或恶意的网络恐怖主义的情景中。

- 增加的冒名顶替和虚假信息:人工智能在各个领域——视觉、语音、音频和文本——的进步大大提高了有关个人隐私侵犯和冒名行骗的担忧。一个相关的例子是音乐行业,AI驱动的“幽灵写手”发布了模仿全球音乐巨星(如德雷克和The Weeknd)声音的伪造音轨。这些音轨,如“Heart on My Sleeve”和“Cuff It”,展示了Rihanna和Beyoncé声音的AI生成版本,因其极具说服力的模仿而引起关注。因此,创意产业面临着重大威胁,尤其是那些依赖先进人工智能的行业。据报道,这些技术可能会危及娱乐行业内的职业。

结论

总的来说,生成式AI为一个充满前所未有的机遇和固有风险的世界打开了大门。需要进一步深入研究,以更好地理解其在各个领域的多方面影响,并制定有效的缓解策略。在潜在的利益和生成式AI可能带来的威胁之间取得平衡对于最好地满足人类需求至关重要。

在本文中,我们深入研究了先进模型,探讨了它们的数学基础,调查了它们的架构复杂性,并预测了它们在未来的发展。还研究了突出的任务,将先进工具与生成式AI进行了基准测试,并评估了它们在现实世界中的应用。生成式AI的影响、挑战和未来前景都得到了全面的讨论。

实现生成式AI的充分潜力的道路仍在进行中,需要监管机构迅速而慎重地采取行动,以确保在AI技术迅猛发展的同时保持秩序和与之协调。在这一背景下,可解释性AI、响应性AI和隐私保护AI的作用变得日益重要。未来充满希望,但在前进的过程中,保持生成式AI所呈现的机遇和风险之间的微妙平衡对于充分发挥其效用并确保其有效服务于人类至关重要。

本文转自 AI生成未来 ,作者:AI生成未来