大模型学习范式之——语境学习(In-context learning) 原创

“ 大模型学习的最终目的,就是提升模型的性能”

在大语言模型技术中,怎么让大模型拥有更好的表现一直是一个值得思考的问题,研究者用了很多办法来提高大模型的输出质量,比如使用大规模高质量参数进行模型预训练和微调。

后续又增加少样本和零样本学习以及提示学习等方法;总之,唯一的目的就是挖掘大模型的潜力,用最小的成本使得大模型性能最大化。

而今天我们讨论的就是另一种方式——语境学习(ICL)。

In-context learning

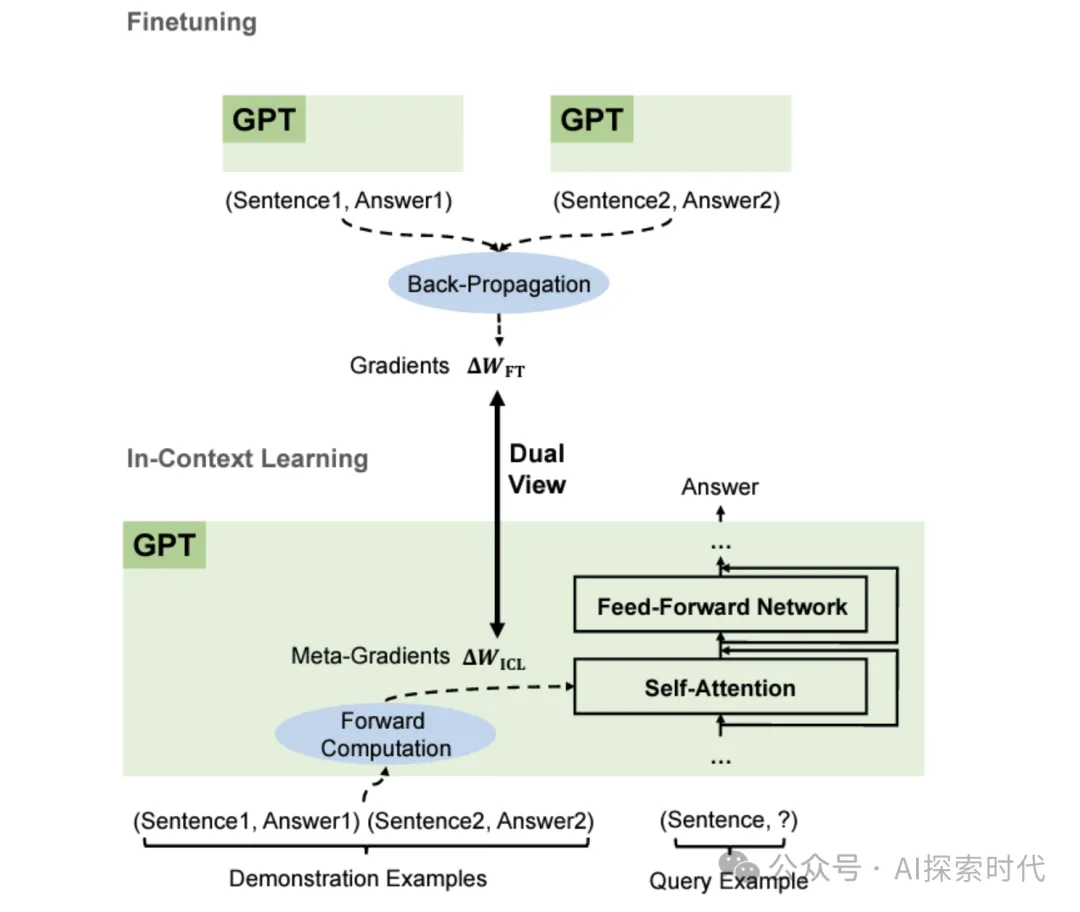

In-context Learning 语境学习是一种学习范式,是现代自然语言处理领域中一种重要的学习方法,尤其在使用大规模,尤其在使用大规模预训练模型时,它允许模型在给定的上下文中进行学习和推理,而无需真正更新模型参数。

这种方法充分利用了模型的预训练知识,并通过在推理阶段提供相关的上下文信息来生成或调整模型输出。

In-context Learning 的核心概念

上下文依赖:ICL的核心在于利用模型的上下文理解能力来完成任务,模型根据输入的上下文信息(包括示例和任务描述)进行推理,而不是依赖于显示的训练过程。

无参数更新:ICL不涉及对模型实际参数的修改,模型保持预训练状态,只是根据提供的上下文信息调整其生成或分类行为。

动态适应:模型在推理时会动态地适应给定的上下文,通过分析上下文中的示例或指示来生成合适的输出,这种适应能力来源于模型在预训练阶段学到的通用知识。

In-context Learning的工作原理

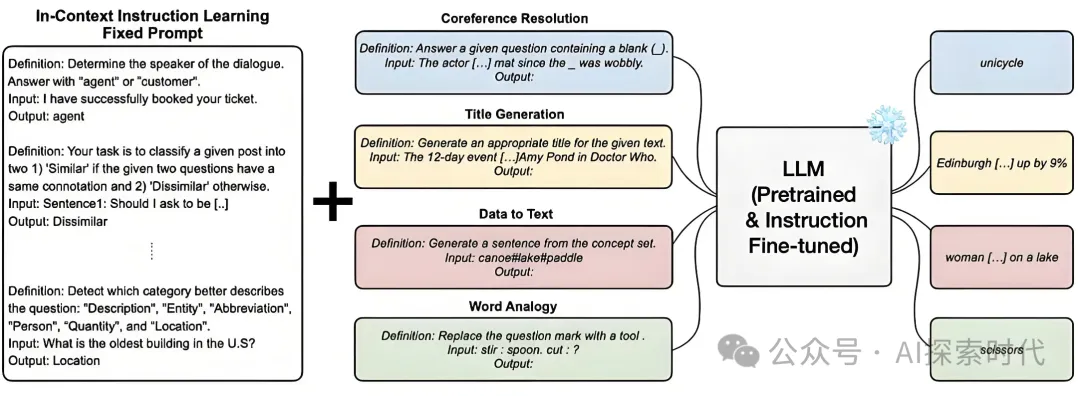

提示词和示例

提示词:ICL常通过提示词来引导模型的生成过程,提示词通常包括任务描述,问题陈述或请求模型执行的操作。

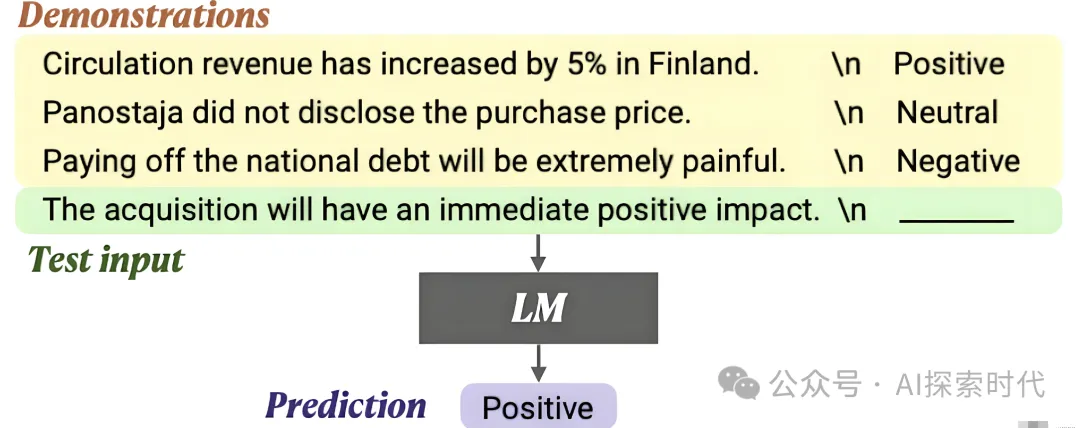

示例:在少样本学习(Few-Shot Learning)中,提示词可能包括一些示例输入和输出,帮助模型理解如何处理类似的任务。

上下文提供

任务描述:在ICL中,任务描述用于告诉模型要完成的任务,例如:生成一个关于人工智能的总结。

示例输入输出:提供几个示例输入和输出对,可以帮助模型理解特定任务的模式或要求,例如:给出一些翻译示例来帮助模型进行语言翻译。

推理和生成

推理:模型根据提供的上下文进行推理,生成与上下文相关的响应或输出。

生成:在ICL中,生成的文本基于模型对上下文的理解,以及预训练中学到的知识

In-context Learning的优势

灵活性

任务适应:能够在没有重新训练模型的情况下,灵活地适应不同的任务和要求

快速适应:通过提供上下文,模型能够快速适应新的任务,而无需对模型进行长期的训练和调整。

无需再训练

节省资源:ICL不需要对模型进行再训练或更新,这节省了计算资源和时间

利用预训练知识

知识复用:利用模型在预训练阶段获得的通用知识,能够在多种任务和场景中发挥作用。

In-context Learning 的应用场景

少样本学习

示例驱动:在少样本学习中,通过提供少量示例,模型能够理解任务并生成所需的输出,如分类,生成等任务。

对话系统

上下文管理:在对话系统中,ICL可以帮助模型根据对话历史或上下文生成更加自然和相关的响应

自动化内容生成

定制化内容:可以根据给定的上下文(如主题,风格,格式要求)生成特定内容,如文章,报告,故事等

跨领域应用

灵活应用:ICL可以用于多个领域,处理不同类型的任务,如法律文本生成,医学诊断,翻译等,只需调整上下文即可。

In-context Learning 的挑战

上下文长度限制

长上下文问题:大规模模型对上下文长度有一定的限制,处理非常长的上下文可能会受到影响

上下文选择

选择适当的上下文:确定哪些信息应该包含在上下文中,以及如何组织这些信息,是ICL的关键挑战之一

一致性和准确性

输出一致性:在不同上下文中,模型生成的内容可能会有所不同,确保生成结果的一致性和准确性是需要关注的问题

总结

In-Context Learning 是一种高效的技术,通过在模型推理时提供上下文信息,能够灵活地适应不同的任务和应用场景。它不需要对模型进行实际的参数更新,而是利用模型的预训练知识和上下文理解能力来生成或调整输出。这种方法具有很强的灵活性和应用广泛性,但也面临着上下文长度限制和输出一致性等挑战。

本文转载自公众号AI探索时代 作者:DFires

原文链接:https://mp.weixin.qq.com/s/skJvMWWF7SbHRnSPIKZd_Q