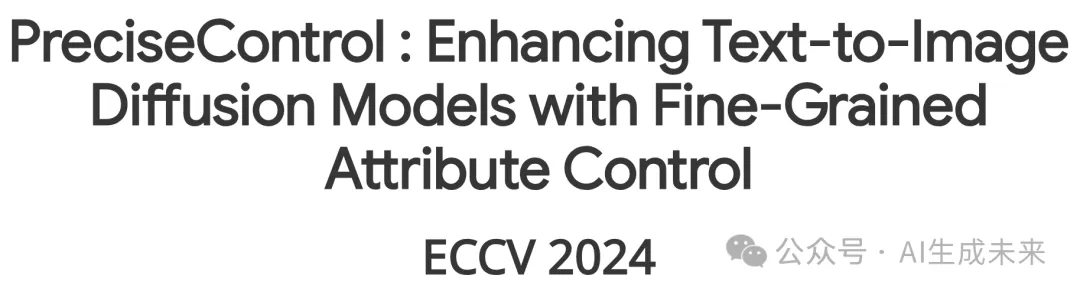

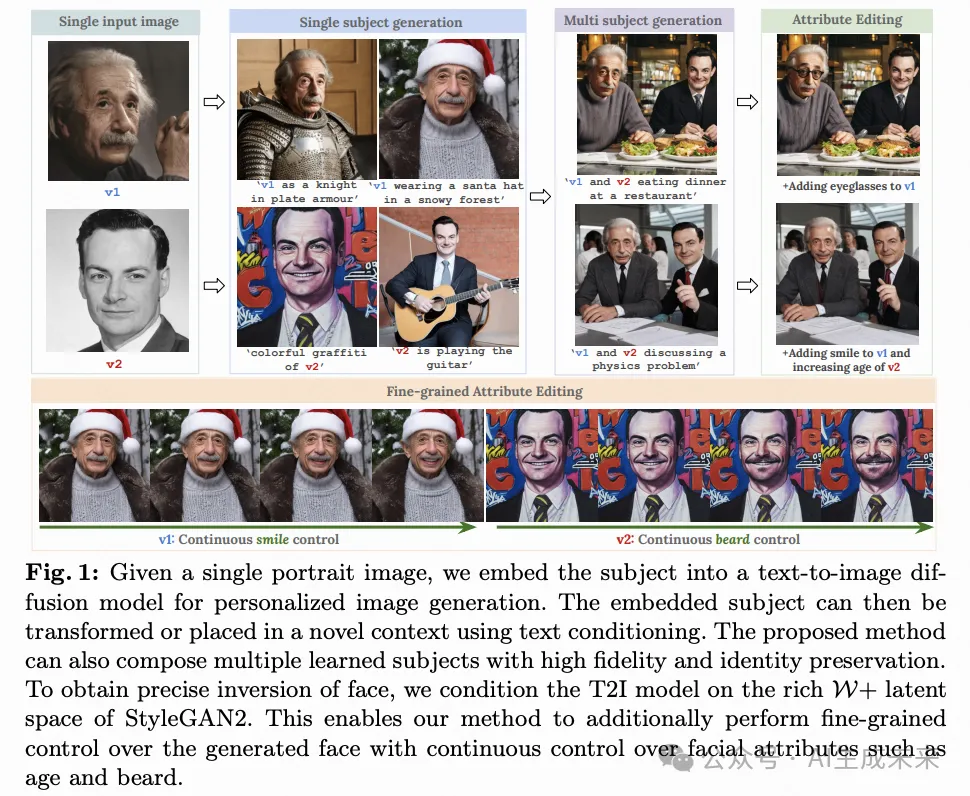

T2I与StlyeGAN2首次联手!PreciseControl:单肖像生成精细个性化图像!

论文链接:https://arxiv.org/pdf/2408.05083

工程主页:https://rishubhpar.github.io/PreciseControl.home/

git链接:https://github.com/rishubhpar/PreciseControl

亮点直击

- 首次提出将大型文本到图像(T2I)模型与StyleGAN2结合的方法,通过将T2I模型条件化在丰富的潜在空间上实现。

- 使用单张肖像图像进行有效个性化的方法,使得在空间中进行细粒度的属性编辑,并通过文本提示实现粗略编辑。

- 引入了一种通过链式扩散过程融合多个个性化模型的新方法,用于多人合成。

最近,大家看到了一波针对文本到图像(T2I)扩散模型的个性化方法的兴起,这些方法通过少量图像来学习一个概念。现有的方法在用于人脸个性化时,难以实现具有身份保留的令人信服的反演,并依赖于对生成的人脸进行语义文本编辑。然而,人们希望对面部属性进行更细粒度的控制,这仅靠文本提示是难以实现的。

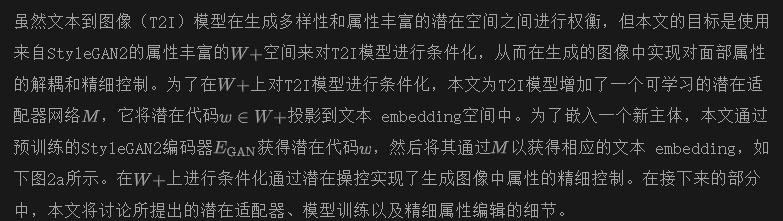

相比之下,StyleGAN模型学习了丰富的人脸先验,并通过潜在空间的操控实现了对细粒度属性编辑的平滑控制。本文利用了StyleGANs的解耦的W+空间来对T2I模型进行条件化。这种方法使我们能够精确地操控面部属性,例如平滑地引入微笑,同时保留T2I模型中固有的粗粒度文本控制。为了使T2I模型能够在W+空间上进行条件化,本文训练了一个潜在映射器,将W+中的潜在编码翻译到T2I模型的token embedding空间。所提出的方法在实现面部图像的精确反演和属性保留方面表现出色,并促进了对细粒度属性编辑的连续控制。此外,本文的方法可以很容易地扩展到生成涉及多个个体的合成图像。本文进行了广泛的实验,以验证本文的方法在面部个性化和细粒度属性编辑方面的有效性。

方法

提要

文本到图像扩散模型。 本研究使用StableDiffusion-v2.1作为代表性的文本到图像(T2I)扩散模型。Stable Diffusion 基于潜在扩散模型,它在潜在空间中应用扩散过程。其训练包括两个阶段:a)训练一个VAE或VQ-VAE自编码器,将图像映射到压缩的潜在空间;b)在潜在空间中训练一个扩散模型,以文本为条件引导生成。这个框架将自编码器中细粒度细节的学习与扩散模型中的语义特征学习分离开来,从而使得扩展更加容易。

基于风格的GAN, [6, 17, 18]已经被广泛应用于生成逼真的特定对象图像,如人脸。此外,这些模型具有解耦的潜在空间W/W+,使得图像之间的平滑插值和细粒度属性编辑成为可能。这些特性是通过将高斯潜在空间映射到一个学习的潜在空间 并使用映射网络实现的。此外,GAN编码器模型可以对真实图像进行编码和编辑,将给定图像反演到W+空间,从而允许对真实图像进行细粒度编辑。

概览

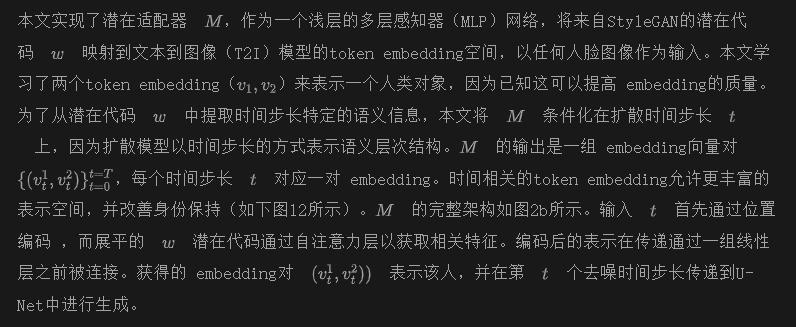

潜在适配器 M

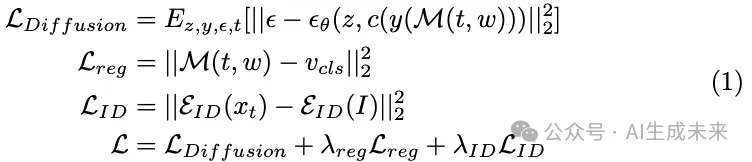

训练

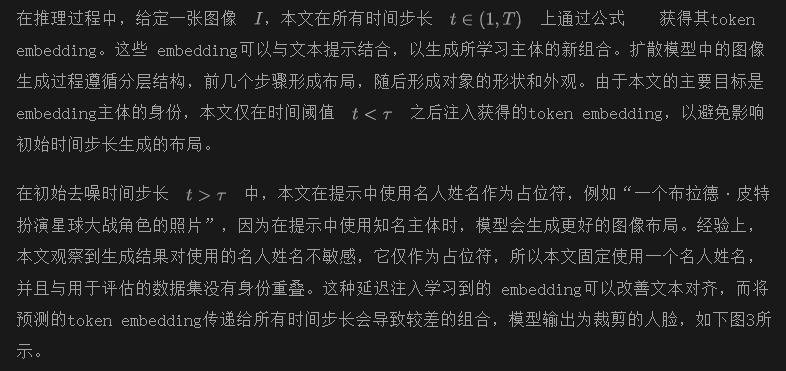

推理

人脸属性的细粒度控制

多人组成

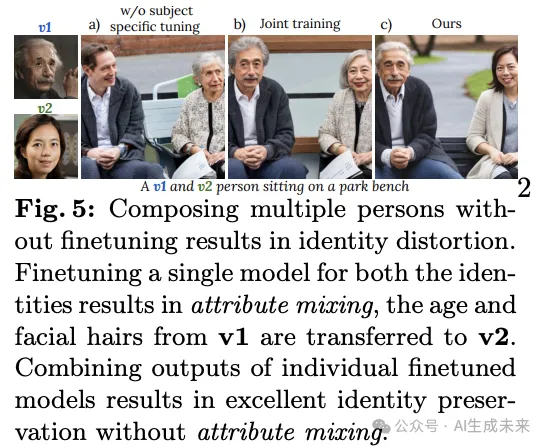

本文的方法可以扩展到在单个场景中组合多个主体身份。简单地在文本提示中 embedding多个令牌 embedding(每个主体一个),而不进行主体特定的调整,会导致身份失真(如下图5a所示)。联合进行主体特定调整可以改善身份识别,但会出现属性混合的问题,即一个主体的面部属性被转移到另一个主体上,如下图5b中的年龄和头发。这是文本到图像(T2I)生成中的一个常见问题,模型在处理场景中的多个对象时,容易绑定错误的属性。本文采用了一种不同的方法,灵感来自于MultiDiffusion,在这个方法中,本文运行多个串联的扩散过程,每个主体和背景各一个。在每一步的去噪过程中,将这些过程的输出进行组合。

本文使用实例分割mask来进行处理。对于每个主体,本文通过其对应的主体特定微调模型运行扩散过程。这种方法能够保留每个微调模型学习到的主体细节,并实现多个人物的高保真组合,而不会出现属性混合的问题。为了获得实例分割mask,本文使用包含两个人物的提示运行单个扩散过程,并在生成的图像上应用现成的分割模型SAM。此外,本文可以在W+空间中通过潜在变量操控对单个主体进行细粒度的属性编辑,同时保留其他主体的完整性,如上图1所示。

实验

本文在StableDiffusion-v2.1上进行所有实验,将其作为代表性的文本到图像(T2I)模型。对于反演,本文使用在面部数据集上训练的预训练StyleGAN2 e4e编码器,将图像映射到W+空间。在接下来的章节中,本文首先讨论数据集和指标,然后是单主体和多主体个性化的结果、细粒度属性编辑以及消融研究。

数据集 & 评估指标

数据集:潜在适配器的训练使用了由StyleGAN2生成的合成图像和来自FFHQ数据集的真实图像的组合。数据集包含了70,000张图像及其对应的通过e4e获得的w潜在代码。本文收集了一个包含30个主体的评估数据集,其中包括科学家、名人、运动员和科技高管。本文还在补充材料中对“非名人”身份和合成面孔进行了评估。本文使用了一组25种多样化的文本提示,包括用于风格化、背景更改和执行特定动作的文本。

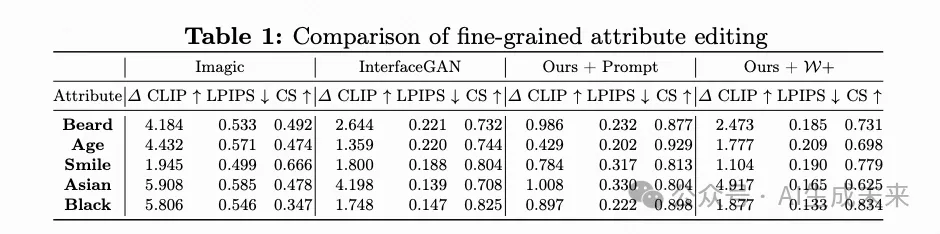

评估指标:本文使用两个广泛使用的指标来评估个性化性能:提示相似性(Prompt similarity)——使用CLIP来测量提示与生成图像的对齐程度;身份相似性(Identity similarity, CS)——通过计算来自面部 embedding的余弦相似度来测量输入图像与生成图像之间的身份相似性。为了评估细粒度属性编辑,本文计算属性提示(例如,“一个微笑的人”)编辑前后的提示相似性变化(∆ CLIP)。此外,本文使用LPIPS和身份相似性来测量编辑过程中图像的变化。对于理想的细粒度属性编辑,较高的∆ CLIP表示有意义的编辑,而较低的LPIPS和较高的身份相似性表示源身份的保留。

与个性化方法的比较。

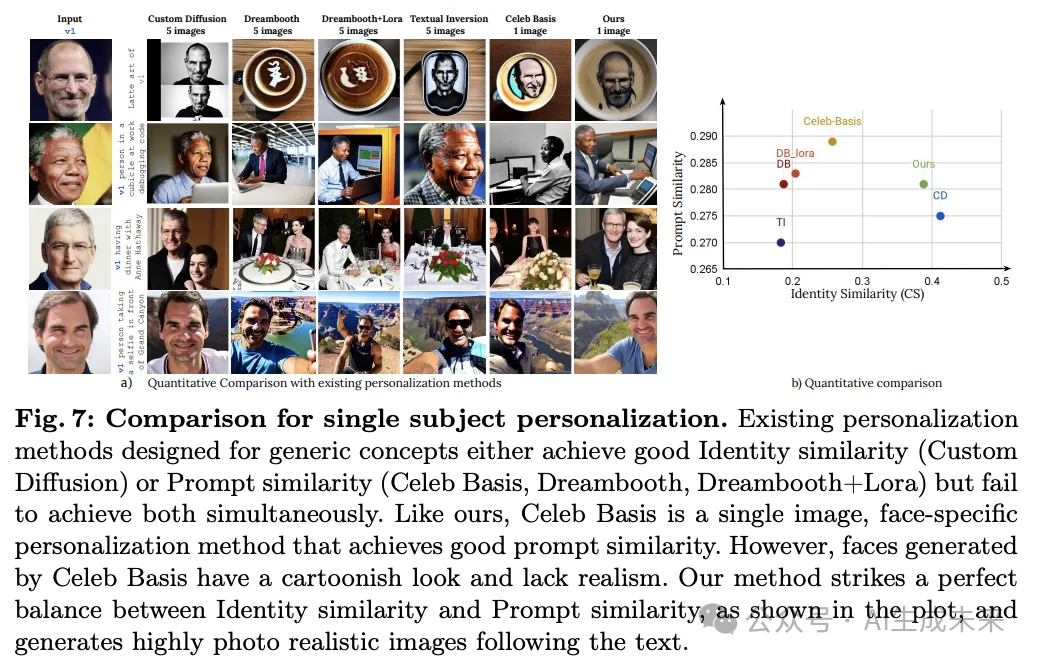

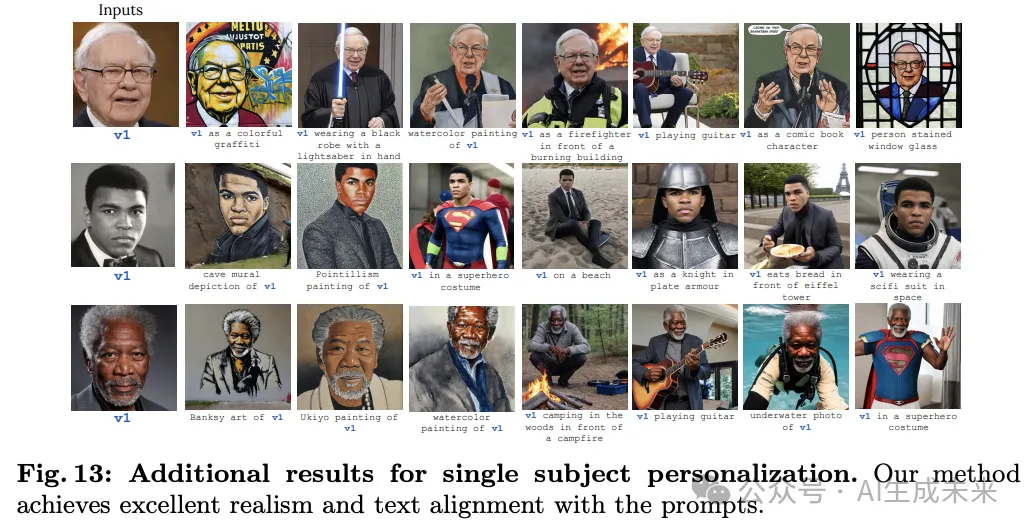

单主体个性化。 本文在评估集中使用多样化的文本提示进行单图像个性化,如下图7、13所示。本文与以下基于微调的个性化方法进行比较:Custom Diffusion、Dreambooth、Dreambooth+LoRA(即通过低秩更新来避免过拟合的Dreambooth)、Textual Inversion 和 Celeb Basis。除了Celeb Basis和本文的方法外,所有方法都使用每个主体的5张图像进行训练,而Celeb Basis和本文的方法仅使用单张输入图像。关于竞争方法的超参数细节在补充材料中提供。

Custom Diffusion能够 embedding主体并保持其身份;然而,它主要生成特写面孔,并且不根据文本提示对主体进行风格化或使其执行动作。Dreambooth无法忠实地 embedding主体的身份,而通过LoRA训练,身份保留得到改善,同时文本对齐性提高,这有助于避免过拟合。Textual Inversion和Celeb Basis的身份保留效果较差,因为它们仅微调token embedding而不是U-Net。

这段文字讨论了Celeb Basis方法在文本对齐方面的表现。由于Celeb Basis方法在跨越名人姓名的基础上施加了强有力的正则化,因此在文本对齐上表现最佳。本文的方法在文本对齐和身份保留之间找到了完美的平衡。需要注意的是,本文的方法和Celeb Basis都只使用1张输入图像,这在一定程度上会影响身份识别,而Custom-diffusion方法需要5张图像。本文还在补充材料中提供了与基于编码器的模型以及最近的IP-adaptor方法的额外比较。

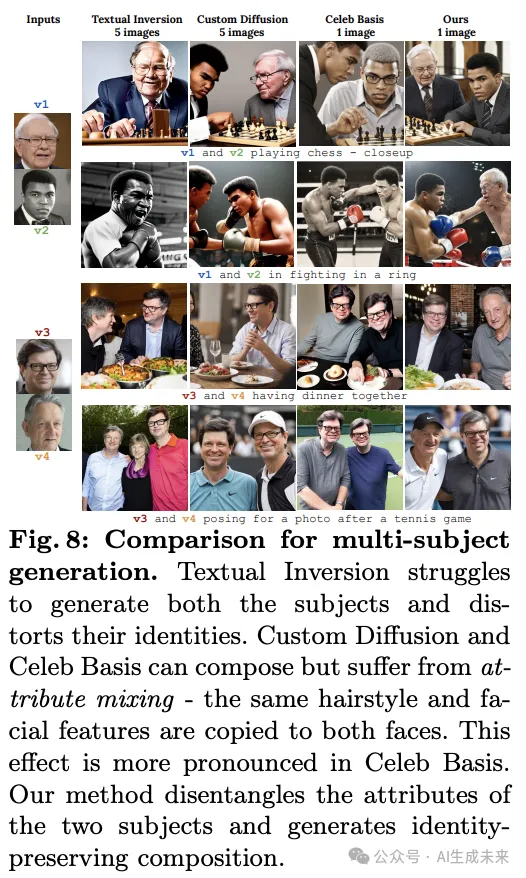

这段文字讨论了多主体个性化的生成结果。本文在下图8、14中展示了 embedding多人物组合的结果,具体来说,本文在生成过程中结合了主体特定调优模型的中间输出。本文与多概念个性化方法、Textual Inversion、Custom Diffusion和Celeb Basis进行了比较。

对于Textual Inversion和Celeb Basis,本文为每个主体分别学习了两个不同的token embedding。对于Custom Diffusion,本文对两个主体的投影矩阵进行了联合微调。Textual Inversion无法在场景中生成两个主体。Celeb Basis和Custom Diffusion能够生成两个主体,但存在属性混合的问题(例如,v4的眼镜被转移到了v3上)。如前所述,Celeb Basis大多数情况下会生成卡通化的面孔。

本文的方法通过运行多个主体特定的扩散过程解决了属性混合问题,并生成了高度逼真的组合。

通过潜在操纵进行细粒度控制

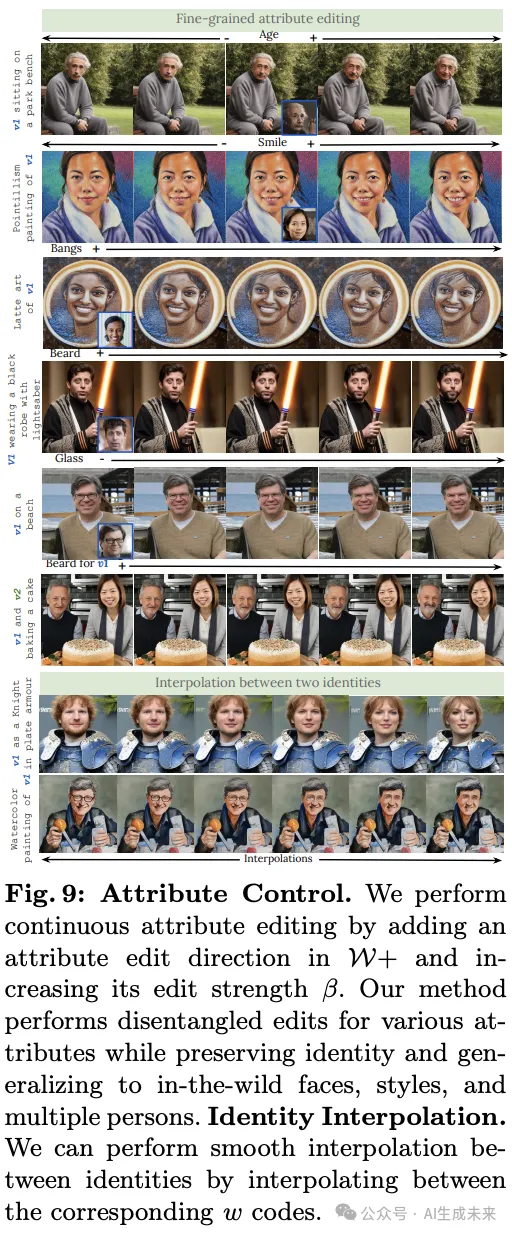

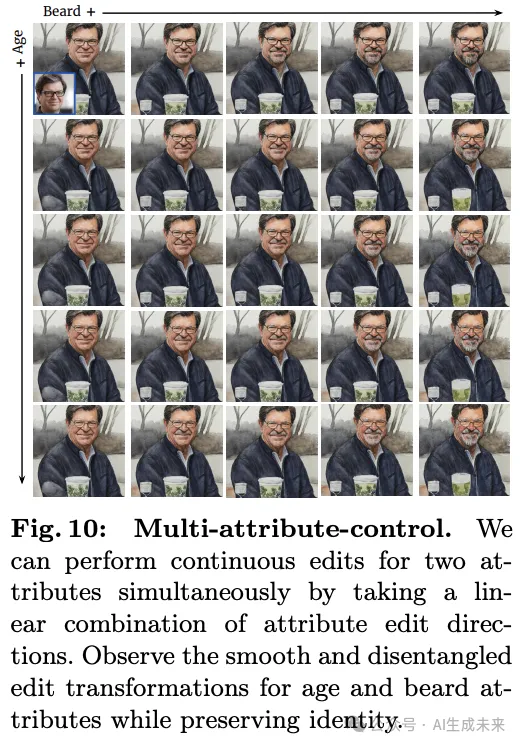

提出的方法将StyleGAN的解耦W+潜空间与T2I模型的token embedding空间匹配,通过潜空间操作实现对图像属性的连续控制。本文展示了由StyleGAN解耦潜空间驱动的两个重要图像编辑应用:1)细粒度属性编辑和2)平滑身份插值。此外,本文的模型还可以恢复受损的人脸图像,如低分辨率或修复被遮盖的面部特征。

细粒度属性编辑。本文通过在输入图像的w编码中添加一个全局潜在编辑方向来执行属性编辑。为了对所有属性采用统一的方法,本文采取了一种简化的方法来获取编辑方向,收集了一小组(<20)的在属性编辑前后的配对人像图像(使用现成的属性编辑方法生成)。接下来,本文计算对应配对的w潜向量之间的差异,并对其进行平均以获得全局编辑方向。

身份插值。W+空间还允许在两个身份之间进行平滑插值。给定两个输入图像,本文获得它们对应的w潜向量,并进行线性插值以获得中间潜向量。当通过潜在适配器作为条件使用时,这些潜向量会产生逼真的人脸插值,面部之间的变化平滑,同时保留背景,如图9底部所示。

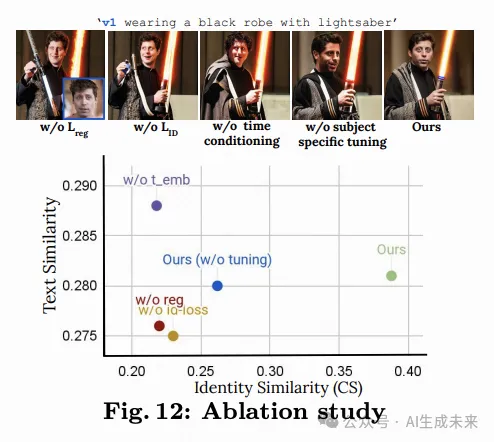

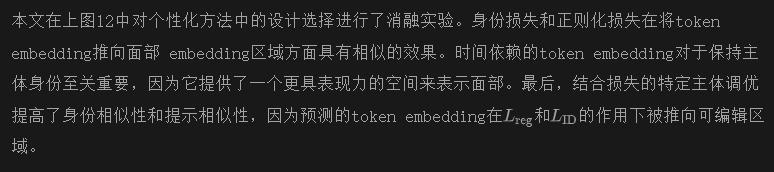

消融实验

结论

本文提出了一种新颖的框架,将T2I扩散模型与StyleGAN2模型的W+空间结合,用于细粒度属性控制。具体来说,本文学习了一种潜在映射器,将来自W+的潜在代码投射到通过去噪、正则化和身份保留损失学习的T2I模型的输入token embedding空间。这个框架提供了一种自然的方法,通过使用GAN编码器模型获取潜在代码来 embedding真实的人脸图像。然后可以通过两种方式编辑 embedding的人脸——粗略的基于文本的编辑和通过在W+中进行潜在操控的细粒度属性编辑。

本文转自 AI生成未来,作者:IISc