从噪声中提取情感:中山大学与腾讯AI实验室基于元学习的多模态情感分析新方法

随着科技的迅猛发展和社交媒体平台的普及,多模态数据在各种下游应用中变得越来越普遍。多模态情感分析(Multimodal Sentiment Analysis, MSA)作为一种能够从语言、声学和视觉数据流中提取人类情感和观点的技术,近年来受到了广泛关注。MSA在多个领域具有重要应用,包括通过分析用户在社交媒体上的文本、语音和视频内容,了解用户的情感倾向和观点,有助于品牌管理和市场营销。在智能助手和聊天机器人中,MSA可以帮助系统更好地理解用户的情感状态,从而提供更自然和人性化的交互体验。通过分析患者的多模态数据,MSA可以辅助心理健康专业人士评估患者的情感状态和心理健康状况。在电影、电视和游戏中,MSA可以用于分析观众的情感反应,优化内容创作和推荐系统。

尽管MSA在多个领域展现了巨大的潜力,但其发展仍面临诸多挑战。其中一个主要问题是单模态标签的缺失。在多模态情感分析任务中,通常只有多模态标签的注释,而缺乏单模态标签。这导致了多模态标签并不总是单模态标签的理想替代品,使用多模态标签来训练单模态信号可能会引入噪声,影响模型的性能。不同模态可能传达不同的情感方面,导致多模态样本中各模态之间的标签不一致,进一步加剧了噪声标签问题。

针对上述问题,8 月 30 日腾讯 AI 实验室和中山大学联合团队团队提出了一种新的元学习框架,名为元单标签生成(Meta Uni-label Generation, MUG),旨在通过弱监督学习单模态标签来改进多模态情感分析。具体目标包括:

- 单模态标签学习:利用多模态标签的弱监督信息,生成准确的单模态标签。

- 多任务训练:联合训练单模态和多模态学习任务,提取更具辨别力和表达力的单模态特征。

- 噪声标签校正:通过设计单模态和多模态去噪任务,显式监督训练元单标签校正网络(Meta Uni-label Correction Network, MUCN),提高单模态标签的质量。

这项技术由中山大学电子与信息技术学院和腾讯AI实验室的研究人员共同完成,具体成员包括来自中山大学电子与信息技术学院的成员Sijie Mai, Ying Zeng, Haifeng Hu。中山大学电子与信息技术学院致力于电子信息技术领域的研究和教育,涵盖人工智能、通信技术、电子工程等多个方向。团队成员在多模态情感分析、弱监督学习和元学习等领域具有丰富的研究经验。来自腾讯AI实验室的成员:Yu Zhao, Jianhua Yao。腾讯AI实验室专注于人工智能技术的研究和应用,涵盖计算机视觉、自然语言处理、语音识别等多个领域。实验室致力于推动AI技术的发展,并将其应用于实际产品和服务中。团队成员在多模态学习、情感分析和深度学习等领域具有深厚的专业知识和研究成果。这个研究团队结合了学术界和工业界的优势,致力于在多模态情感分析领域取得突破性进展。

方法

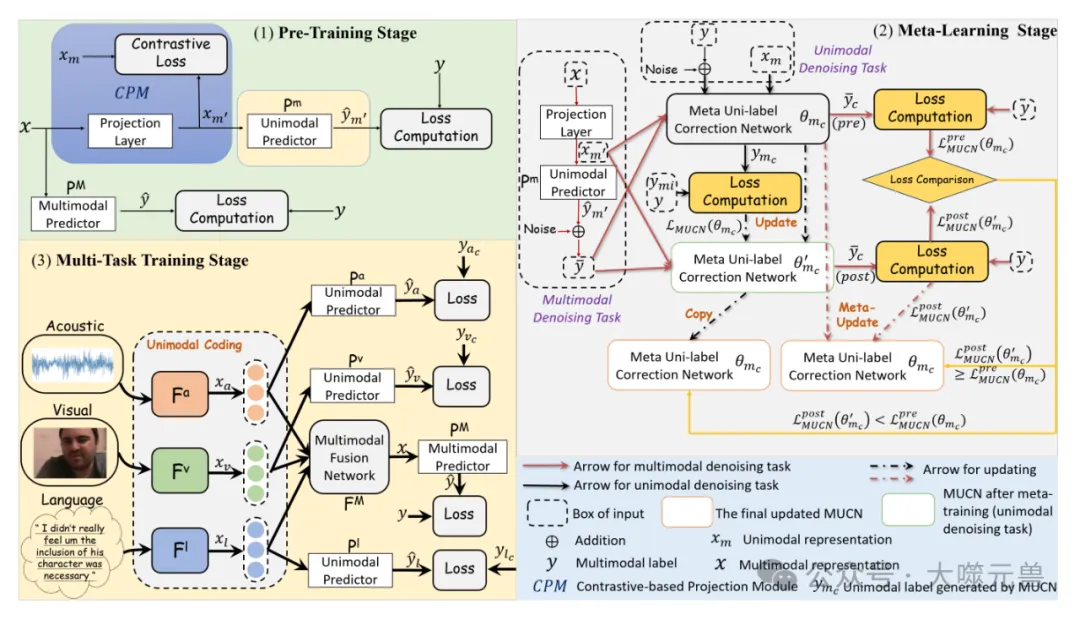

研究团队提出的元单标签生成(Meta Uni-label Generation, MUG)框架旨在通过弱监督学习单模态标签,以改进多模态情感分析。MUG框架包括三个主要阶段:单模态网络的构建、多模态框架的预训练和元学习策略的应用。通过这些阶段,MUG能够生成准确的单模态标签,并联合训练单模态和多模态任务,提取更具辨别力的单模态特征。

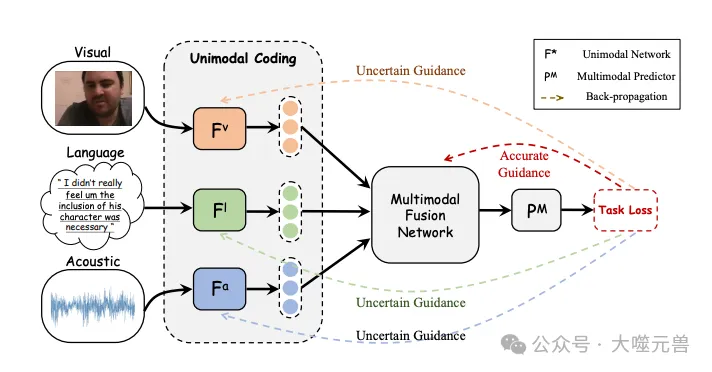

图1:单峰学习的噪声标签问题。多模态标签可以被视为每个单峰网络的不确定指导。

单模态网络的结构和表示生成过程如下:

语言模态

使用BERT(Bidirectional Encoder Representations from Transformers)提取高层次语言表示。具体过程如下:

输入序列Ul经过BERT网络,生成表示xˆl。

通过全连接层将xˆl投影到低维特征空间,得到最终的语言表示xl。

声音和视觉模态

使用LSTM(Long Short-Term Memory)网络生成单模态表示。具体过程如下:

输入特征序列Um经过LSTM网络,生成表示xm。

其中,Um表示输入特征序列,xm表示生成的单模态表示。

在多模态框架的预训练阶段,设计了基于对比的投影模块(Contrastive-based Projection Module, CPM),以缩小单模态和多模态表示之间的差距。具体过程如下:

多模态表示生成

给定三个单模态序列(语言、声音和视觉),通过单模态网络生成单模态表示。将单模态表示输入多模态融合网络,生成多模态表示x。

对比学习

设计CPM,将多模态表示投影到单模态嵌入空间,并使用投影的多模态嵌入训练单模态预测器。通过对比学习提高单模态和多模态表示之间的互信息,减少它们之间的分布差距。

元单标签校正网络(Meta Uni-label Correction Network, MUCN)的元学习过程包括单模态去噪任务和多模态去噪任务。

在元训练阶段,训练MUCN以去噪手动损坏的多模态标签,并恢复原始多模态标签。通过高斯噪声防止MUCN学习身份映射,并提供模型学习子最优单模态标签的能力。

在元测试阶段,设计多模态去噪任务,利用干净的多模态标签和表示指导MUCN的学习。通过估计MUCN是否能恢复干净的多模态标签来评估其有效性。

在元学习过程中,采用双层优化策略以提高MUCN的训练效果。具体过程如下:

在单模态去噪任务训练,通过梯度下降更新MUCN的参数,训练MUCN以去噪手动损坏的多模态标签。

多模态去噪任务评估,通过多模态输入生成后校正损失,评估MUCN的有效性。如果MUCN在元训练后变得更具辨别性,则跳过元测试阶段并更新MUCN参数。如果MUCN在元训练后变得不够辨别性,则使用双层优化策略进行元更新。

在多任务训练阶段,联合训练单模态和多模态学习任务,以提取更具辨别力的单模态特征。具体是单模态任务训练使用元学习阶段生成的校正单模态标签进行单模态任务训练;多模态任务训练使用多模态标签指导多模态任务学习。

图2:拟议MUG的示意图

通过这种方式,MUG能够最大限度地利用现有的多模态信息,提取更具辨别力和表达力的单模态特征,从而提高多模态情感分析的性能。

实验

数据集

研究团队使用了三个主要的数据集来评估MUG框架的性能。

CMU-MOSI是多模态情感分析领域的重要资源,包含超过2000个视频片段,每个片段的情感强度在-3到+3的Likert量表上进行标注。

数据划分:1284个片段用于训练,229个片段用于验证,686个片段用于测试。

CMU-MOSEI是一个大规模的多模态情感分析数据集,包含超过22000个片段,来自1000多名YouTube演讲者,涵盖250个独特的话题。每个片段都标注了六种情感状态和情感得分(-3到+3)。

数据划分:16326个片段用于训练,1871个片段用于验证,4659个片段用于测试。

SIMS是一个独特的中文多模态情感分析数据集,包含2281个片段,来自电影、电视剧和综艺节目。每个片段的情感得分在-1到1之间。

数据划分:1368个片段用于训练,456个片段用于验证,457个片段用于测试。

为了评估MUG框架的性能,研究团队使用了以下评估指标:

- Acc7:7分类准确率,用于细粒度情感得分分类。

- Acc2:二分类准确率,用于区分正面和负面情感。

- F1分数:二分类情感分类的精确率和召回率的调和平均数。

- MAE:平均绝对误差,量化情感预测与标注标签之间的平均误差。

- Corr:相关系数,表示模型预测与情感标签之间线性关系的强度和方向。

实验结果

在各数据集上的实验结果表明,MUG框架在大多数评估指标上优于竞争基线模型。具体结果如下。

CMU-MOSI数据集

MUG (BERT)在Acc7、Acc2和F1分数上分别比HyCon高0.9%、0.6%和0.5%,比AOBERT高7%以上。

MUG (BERT)在Acc2和F1分数上分别比CubeMLP高0.5%和1.1%,在Acc7、F1分数和Corr上优于AOBERT。

CMU-MOSEI数据集

MUG (BERT)在Acc2和F1分数上分别比CubeMLP高0.5%和1.1%,在Acc7、F1分数和Corr上优于AOBERT。

SIMS数据集

MUG在MAE、Corr和Acc2上优于Self-MM和SUGRM,表明MUG的单模态标签学习策略更具优势。

消融实验

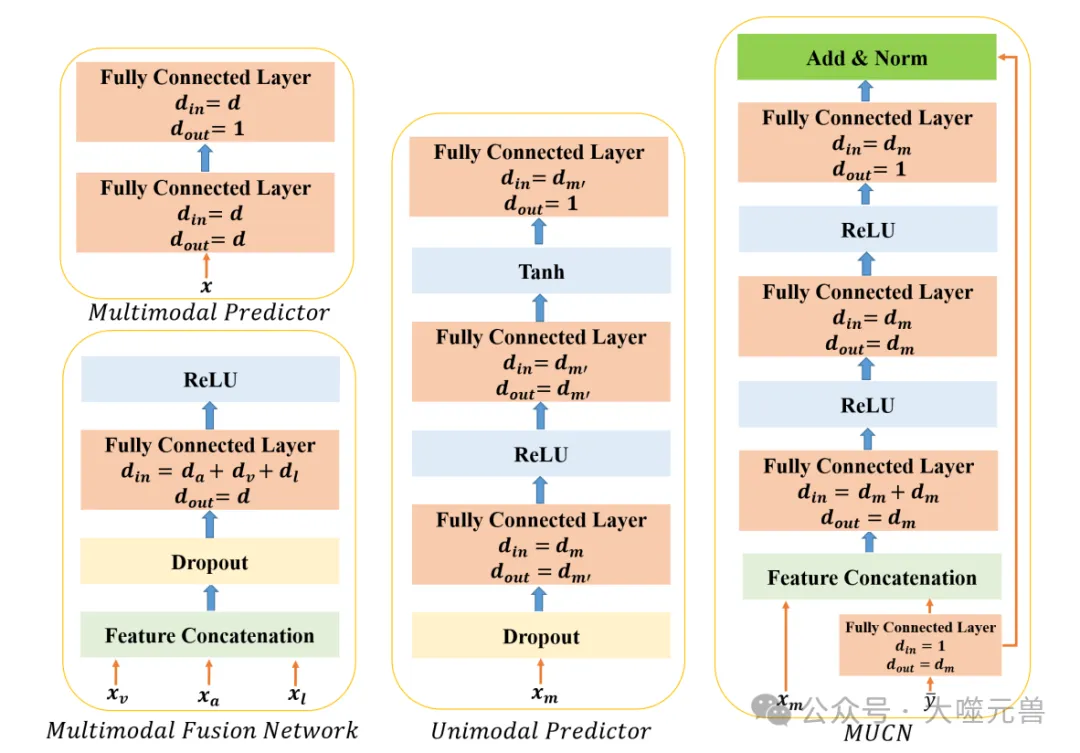

图3:单峰预测器、多峰预测器、多模态融合网络和MUCN的结构。我们应用一个简单的融合网络来实现有竞争力的性能。

为了分析各组件对模型性能的影响,研究团队进行了消融实验。

单模态学习任务:移除单模态学习任务后,性能显著下降,表明多任务训练对于提取更具辨别力的单模态特征和提高多模态系统性能的重要性。

多模态去噪任务:移除多模态去噪任务后,性能下降约1%,表明多模态去噪任务对于单模态标签学习的重要性。

对比学习:移除对比学习后,大多数评估指标的结果显著下降,表明对比学习在减少单模态和多模态表示之间的分布差距方面的重要性。

直接使用多模态标签作为单模态标签:直接使用多模态标签作为单模态标签的性能下降,表明元学习的单模态标签优于直接使用多模态标签。

元学习策略:使用MLC策略替代提出的元学习策略后,所有评估指标的性能下降,表明提出的元学习策略在学习准确的单模态标签方面更优。

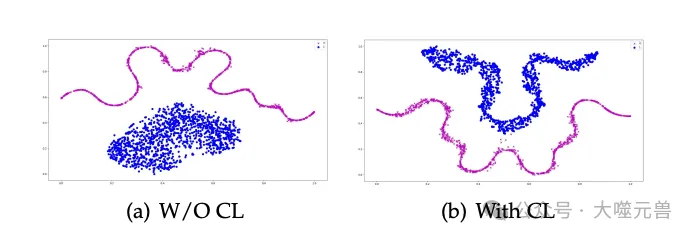

图4:单峰表示和投影多峰表示的T-SNE可视化CL代表对比学习。我们使用语言模态来说明CL的效果,在其他模态中也观察到了类似的结果。

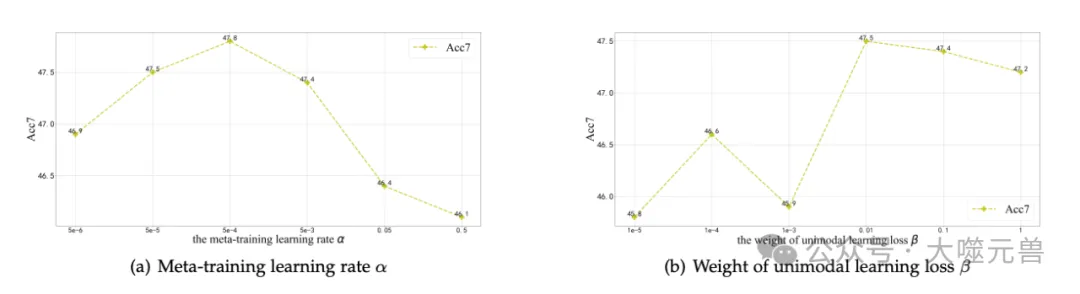

超参数鲁棒性分析

研究团队评估了超参数β(第三阶段单模态学习损失的权重)和α(元训练学习率)对模型性能的影响。结果表明:

- β的影响:当β在0.01-1范围内时,模型性能较好;当β值较小时,模型性能显著下降。

- α的影响:当α值适中时,模型性能较好;当α值过大时,模型性能显著下降。

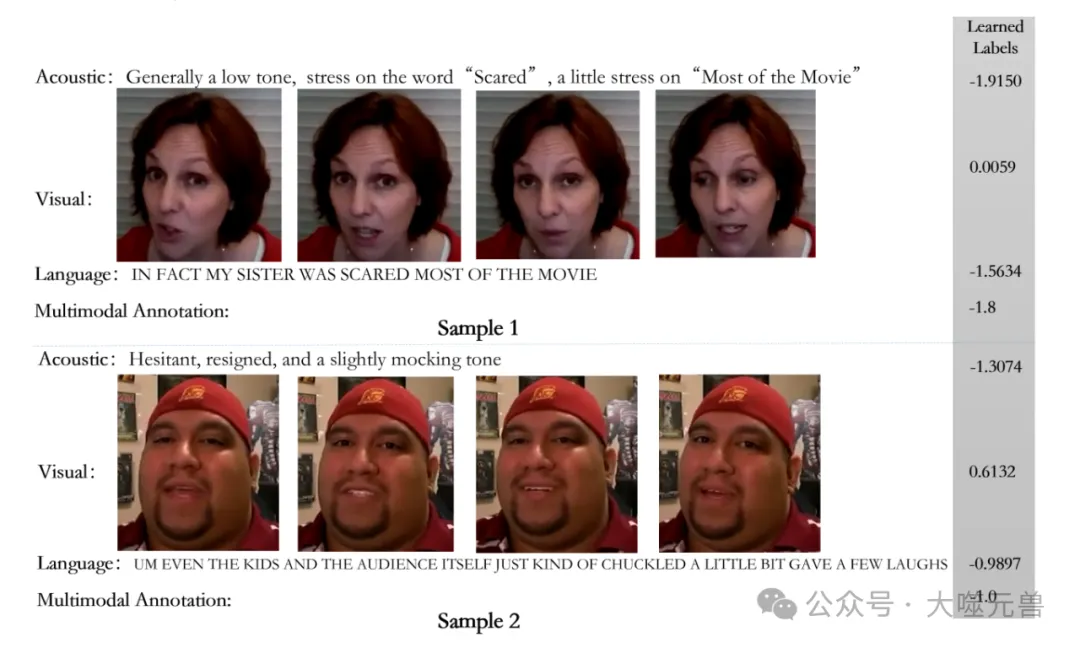

案例分析

图5:关于超参数α和β变化的模型性能。

图6:学习单峰标签的案例分析。

研究团队提供了两个来自CMU-MOSI数据集的定性样本,展示了多模态输入、学习到的单模态标签和多模态标签。结果表明:

样本1:说话者没有明显的面部表情,视觉标签接近中性;语言标签为负面,声学标签为强负面。MUG能够准确识别各模态的辨别水平,并为其分配适当的标签。

样本2:存在矛盾模态,视觉标签为弱正面,语言标签为弱负面,声学标签为强负面。MUG能够处理矛盾模态的情况,通过准确学习单模态标签,提取更具辨别力的特征以进行准确的多模态推理。

通过这些实验结果和分析,研究团队验证了MUG框架在多模态情感分析中的有效性和优势。

讨论

为了分析对比学习模块的有效性,研究团队使用t-SNE对投影的多模态表示和相应的单模态表示在嵌入空间中的分布进行了可视化。t-SNE是一种能够捕捉高维特征局部结构的降维技术。实验结果显示,当移除对比学习时,投影的多模态表示(蓝色点)在嵌入空间中呈现椭圆形分布,而单模态表示则呈现条纹状分布。相反,当应用对比学习时,来自两种不同来源的数据点均呈现条纹状分布,且它们之间的差距显著减小。尽管由于多模态和单模态表示的异质性,分布差距不可避免,但MUG能够有效减少这种差距,使得它们在嵌入空间中的分布形状高度相似,从而使单模态模块能够处理投影的多模态表示,以指导单模态标签的学习。

值得注意的是,在单模态-多模态对比学习中,我们停止了单模态表示的梯度,仅改变投影的多模态表示的分布,以迫使投影的多模态表示具有与单模态表示相同的分布。因此,无论是否应用对比学习,单模态表示的分布几乎相同,而投影的多模态表示在应用对比学习后,其分布变得与单模态表示的分布更加相似。

为了验证使用真实单模态标签对模型性能的影响,研究团队进行了一个实验,使用标注的单模态标签训练SIMS数据集的单模态网络。结果表明,使用标注的单模态标签学习单模态表示可以显著提高多模态系统的整体性能,尤其是与不包含单模态学习任务的MUG版本相比。此外,使用学习到的单模态标签进行单模态学习任务的MUG版本优于不包含单模态学习任务的版本,但略逊于使用真实标签的版本。这些结果表明,学习到的单模态标签是有效的,但仍然包含一定的噪声。

研究团队还对模型的空间和时间复杂性进行了分析。

空间复杂性

使用可训练参数的数量作为空间复杂性的代理。MUG框架的总参数数量为110,089,956个。相比之下,MISA和MAG-BERT的参数数量为110,917,345个,而Self-MM和MMIM的参数数量分别为109,647,908和109,821,129个。因此,MUG的参数数量适中。这是合理的,因为我们为每个模态设计了额外的元单标签校正网络和基于对比的投影模块,而Self-MM没有设计额外的可学习模块来学习单模态标签。

时间复杂性

在训练时间方面,前两个阶段只运行一次以生成联合训练阶段(第三阶段)所需的单模态标签。联合训练阶段和前两个阶段可以解耦,从而大大减少训练时间。因此,MUG的唯一额外时间成本是前两个阶段的训练,这只需运行一次且不需要调优,是可以接受的。在第三阶段,由于我们没有设计复杂的融合机制,也不需要在第三阶段学习单模态标签,训练时间比需要在多任务训练期间计算单模态标签的Self-MM更快。具体来说,在相同环境和相同批量大小下,Self-MM每次迭代约需1.16秒,而MUG每次迭代约需0.86秒。

通过这些分析,研究团队验证了MUG框架在多模态情感分析中的有效性和优势,并展示了其在空间和时间复杂性方面的合理性。

结论与未来工作

研究团队提出了一种新的元学习框架,名为元单标签生成(Meta Uni-label Generation, MUG),旨在通过弱监督学习单模态标签来改进多模态情感分析。

提出了MUG框架,通过设计元单标签校正网络(MUCN)和基于对比的投影模块(CPM),MUG能够生成准确的单模态标签,并联合训练单模态和多模态任务,提取更具辨别力的单模态特征。

单模态去噪任务和多模态去噪任务,通过设计单模态和多模态去噪任务,显式监督训练MUCN,提高单模态标签的质量。

在CMU-MOSI、CMU-MOSEI和SIMS数据集上的实验结果表明,MUG在大多数评估指标上优于竞争基线模型,验证了其在多模态情感分析中的有效性和优势。

通过消融实验分析了各组件对模型性能的影响,并评估了超参数对模型性能的影响,验证了MUG框架的稳定性和鲁棒性。

提供了定性样本,展示了学习到的单模态标签和多模态标签,进一步验证了MUG在处理矛盾模态和提取辨别力特征方面的能力。

尽管研究团队提出的MUG框架在多模态情感分析中取得了显著的进展,但仍有一些未来的研究方向和应用场景值得探索。

MUG框架可以扩展到其他噪声标签学习场景,如图像分类、语音识别等。未来的研究可以评估MUG在这些任务中的有效性。

将MUG框架应用于实时情感分析系统,如智能助手、聊天机器人等,进一步验证其在实际应用中的性能和稳定性。

目前的研究主要集中在英文和中文数据集上,未来可以扩展到其他语言的数据集,评估MUG在多语言情感分析中的表现。

尽管MUG在提取辨别力特征方面表现出色,但其内部机制仍然较为复杂。未来的研究可以探索如何增强模型的解释性,使其更易于理解和调试。

将MUG框架与其他先进的技术结合,如强化学习、自监督学习等,进一步提高模型的性能和适应性。通过这些未来的研究方向和应用场景,MUG框架有望在多模态情感分析及其他相关领域取得更大的突破和应用价值。(END)

参考资料:https://arxiv.org/abs/2408.16029