字节跳动发布统一多模态大模型 Show-o!

引言:多模态理解与生成的新篇章

在人工智能的发展历程中,多模态理解与生成一直是研究的热点领域。随着技术的进步,从单一模态到多模态的转变,使得机器能够更全面地理解和生成信息,极大地拓宽了人工智能的应用范围。本文介绍的研究成果,展示了如何通过一个统一的Transformer模型——Show-o,来实现对多种模态输入的理解与生成,这标志着在多模态人工智能领域的一个重要进步。

1. 论文标题与链接

- 论文标题:SHOW-O: ONE SINGLE TRANSFORMER TO UNIFY MULTIMODAL UNDERSTANDING AND GENERATION

- 论文链接:https://arxiv.org/pdf/2408.12528.pdf

2. 机构

- 主要研究机构:Show Lab, National University of Singapore 和 ByteDance

3. 项目地址

- 项目GitHub链接:https://github.com/showlab/Show-o

通过这项研究,Show-o模型不仅在多模态理解任务中展现出了与现有模型相当或更优的性能,而且在生成任务中也显示出了显著的优势,尤其是在需要较少采样步骤的场景中,展现了其在加速生成过程中的潜力。此外,Show-o模型的灵活性和扩展性,使其能够支持多种下游应用,如文本引导的图像修复和外推,以及混合模态生成等,这些都预示着其作为下一代基础模型的巨大潜力。

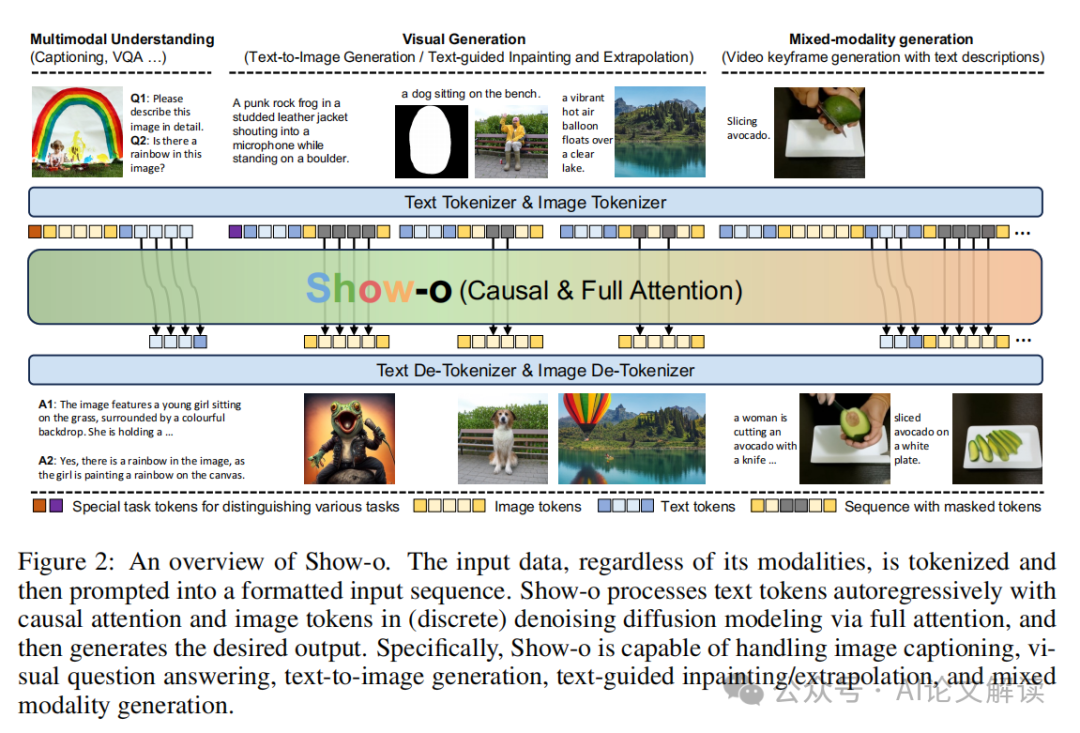

Show-o模型概述

Show-o是一个统一的变换器模型,旨在统一多模态理解和生成。这种模型不同于完全自回归模型,它结合了自回归和(离散)扩散建模,以适应各种混合模态的输入和输出。Show-o模型能够灵活支持包括视觉问答、文本到图像生成、文本引导的图像修复/外推以及混合模态生成等多种视觉-语言任务。

在多个基准测试中,Show-o展示了与现有的单独模型相当或更优越的性能,这些模型具有相等或更多的参数,专门用于理解或生成任务。这突出显示了其作为下一代基础模型的潜力。Show-o的代码和模型已在GitHub上发布,供研究和开发使用。

模型架构与技术细节

1. 模型架构

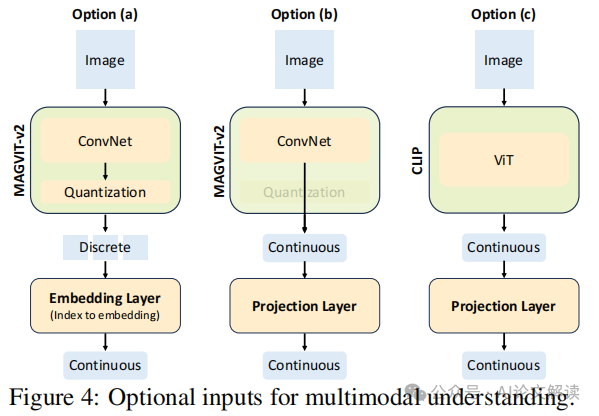

Show-o基于预训练的大型语言模型(LLM)构建,并继承了文本基础推理的自回归建模能力。通过采用离散去噪扩散来模拟离散图像标记,而不是连续表示,Show-o在保持文本条件信息编码的同时,也简化了额外文本编码器的需求。为了适应多样化的输入数据和任务变化,模型采用了文本和图像的标记器来编码它们为离散标记,并进一步提出了统一的提示策略,以将这些标记处理成结构化的输入序列。

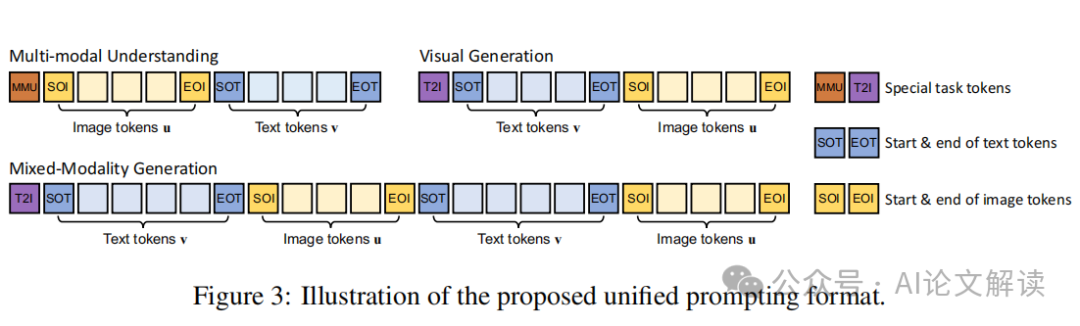

2. 统一提示策略

Show-o设计了一种统一的提示策略,以格式化各种输入数据。给定图像-文本对,首先将其标记化为图像标记和文本标记,然后根据任务类型将它们形成输入序列。这种设计使得模型能够有效地编码多模态理解、文本到图像生成和混合模态生成的各种输入数据为序列数据,从而在这些不同任务中无缝地进行统一学习。

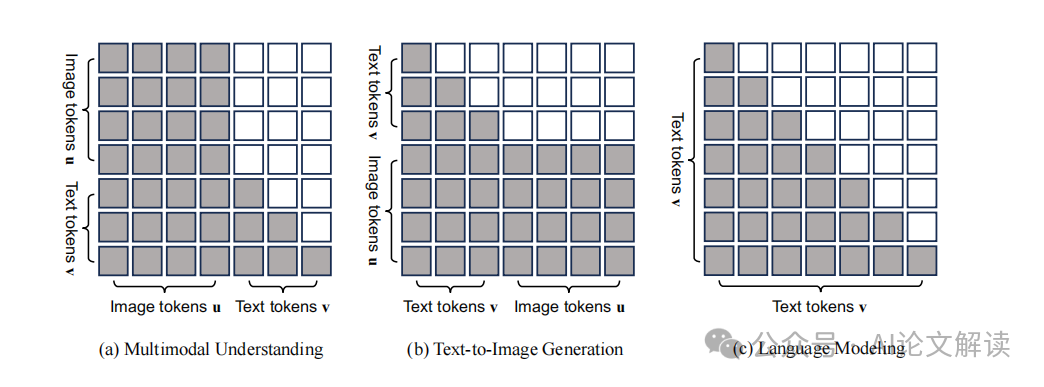

3. 全方位注意机制(Omni-Attention Mechanism)

Show-o提出了一个全方位的注意机制,使模型能够以不同的方式模拟不同类型的信号。这种注意机制结合了因果注意和全面注意,根据输入序列的格式适应性地混合和变化。在多模态理解任务中,文本标记可以注意到所有先前的图像标记;在文本到图像生成任务中,图像标记能够与所有先前的文本标记进行交互。

4. 训练目标

为了同时进行自回归和(离散)扩散建模,Show-o采用了两种学习目标:下一个标记预测(NTP)和掩码标记预测(MTP)。通过这两种方法,Show-o能够在多模态理解中最大化文本标记的可能性,并在输入序列中模拟图像标记,以重建从掩码标记条件化的原始图像标记。

综上所述,Show-o通过其创新的架构和技术细节,展示了处理多模态输入和生成任务的强大能力,是一个具有广泛应用前景的统一多模态模型。

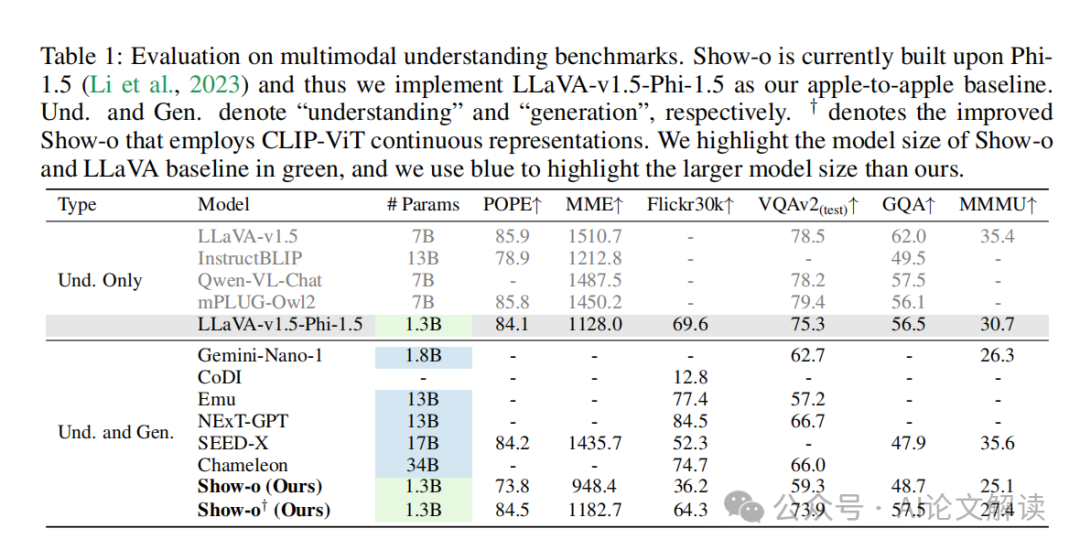

实验设置与基准测试

1. 实验设计

在本研究中,我们提出了一个名为Show-o的统一变换模型,旨在同时处理多模态理解和生成任务。Show-o模型结合了自回归和(离散)扩散建模,以适应不同的输入和输出模态。实验中,Show-o处理文本和图像的输入数据,通过自回归方式处理文本令牌,并通过全注意力方式处理图像令牌,从而生成所需的输出。

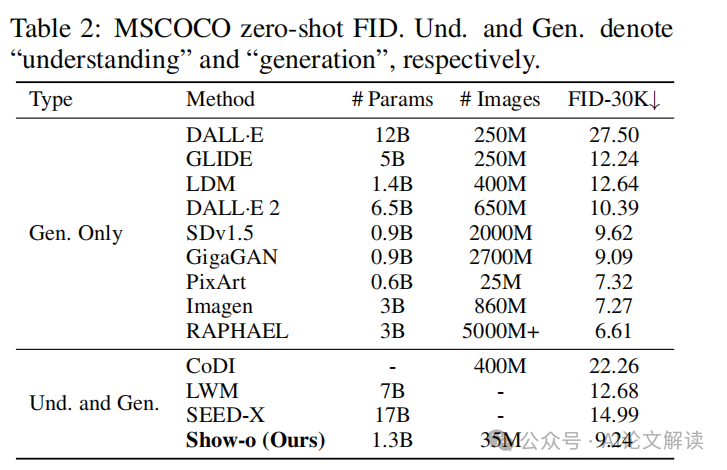

2. 基准测试

为了评估Show-o模型的性能,我们在多个基准测试上进行了评估,包括视觉问答、文本到图像生成、文本引导的图像修复/外推和混合模态生成等任务。这些基准测试不仅涵盖了多种视觉语言任务,还包括了对模型在不同设置下的综合性能的评估。

性能分析与讨论

1. 性能评估

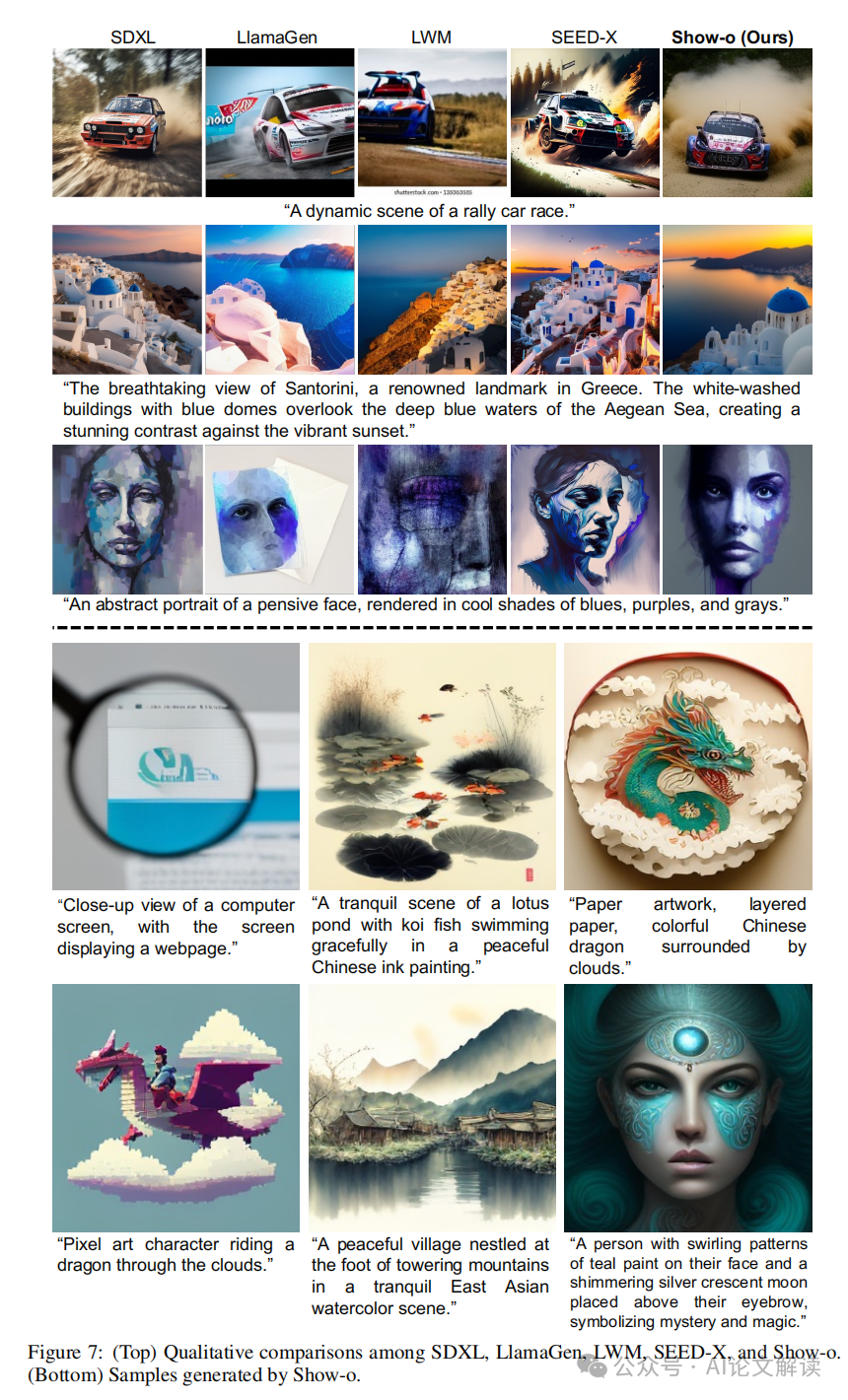

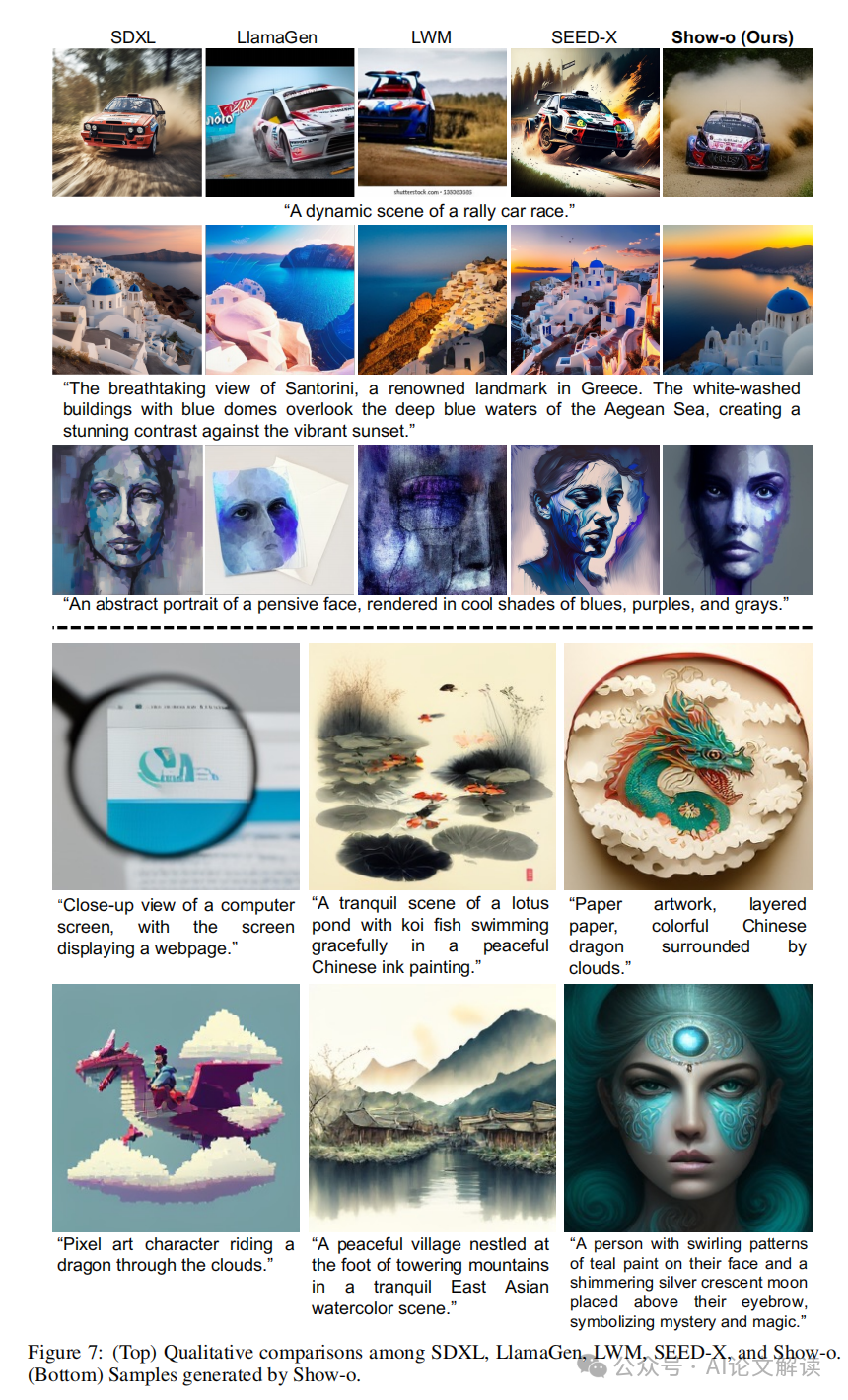

在多个基准测试中,Show-o模型展示了与或优于现有单独模型的性能。例如,在视觉问答任务中,Show-o能够准确回答与图像相关的问题,展示了其对图像内容的深入理解。在文本到图像生成任务中,Show-o生成的图像质量与现有的生成模型相比具有竞争力,显示了其在处理复杂生成任务时的有效性。

2. 讨论

Show-o模型的主要优势在于其能够通过单一的变换器处理多种模态的输入和输出,这在以往的模型中往往需要多个专门的模型来分别处理。此外,Show-o在自回归生成图像时所需的采样步骤大约减少了20倍,这一显著的性能提升不仅减少了计算资源的消耗,也提高了模型的应用灵活性。此外,Show-o还天然支持多种下游应用,如文本引导的图像修复和外推,而无需任何微调,进一步展示了其作为下一代基础模型的潜力。

总体而言,Show-o模型通过在单一框架中整合自回归和扩散建模,成功地处理了多模态理解和生成任务,显示了优异的性能和广泛的应用潜力。

挑战与未来方向

1. 模型的输入/输出空间定义

定义模型的输入和输出空间是一个核心问题。如何有效地处理来自不同模态的输入数据,并将它们统一到一个单一的变换器中,是未来研究的一个重要方向。

2. 不同模态输入数据的统一

对于来自不同模态的输入数据,如何在一个单一的网络中统一处理,是一个挑战。这需要模型能够灵活地处理和理解不同类型的数据,例如文本和图像。

3. 自回归与扩散建模的结合

Show-o模型结合了自回归和扩散建模,这在技术上是一项挑战。这种结合使得模型能够在处理文本和图像时展现出高度的灵活性和效率。

4. 高效的训练策略

如何有效地训练这样一个复杂的模型也是一个挑战。需要开发新的训练策略,以确保模型能够在多模态理解和生成任务中达到最优性能。

5. 长期视频生成的探索

Show-o模型在处理长形视频生成方面展示了潜力。如何进一步发展这一功能,使模型能够生成连贯且高质量的视频,是未来研究的一个重要方向。