超越Text2Video-Zero|无需额外训练,条件生成、专门生成和指令引导的视频编辑全搞定!

论文链接:https://arxiv.org/pdf/2407.21475

github链接:https://densechen.github.io/zss/

亮点直击

- 本文提出了一种新颖的zero-shot视频采样算法,该算法能够直接从预训练的图像扩散模型中采样高质量的视频片段。

- 本文提出了一个依赖噪声模型和时间动量注意力机制,首次能够灵活地控制生成视频中的时间变化。

- 通过广泛的应用展示了本文方法的有效性,包括条件和专门的视频生成,以及由文本指令引导的视频编辑。

将时间维度引入预训练的图像扩散模型中用于视频生成是一种常见的方法。然而,这种方法计算量大,并且需要大规模的视频数据集。更为关键的是,图像和视频数据集之间的异质性常常导致图像专业知识的灾难性遗忘。最近,直接从图像扩散模型中提取视频片段的尝试在一定程度上缓解了这些问题。然而,这些方法只能生成带有简单运动的短视频片段,无法捕捉细粒度的运动或非网格变形。

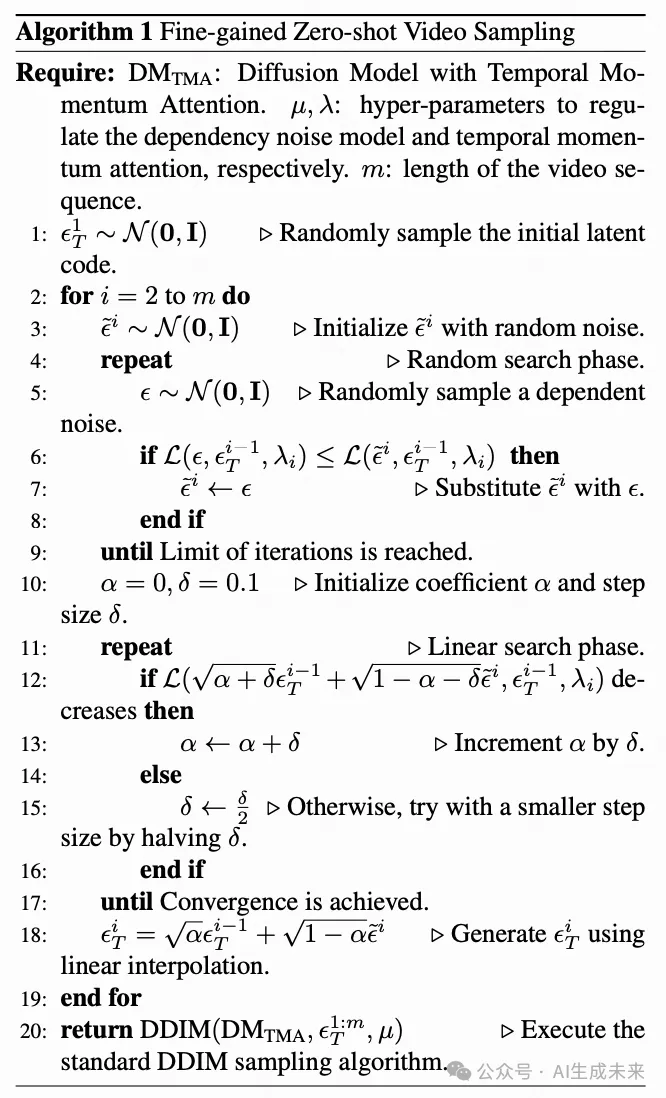

依赖噪声模型

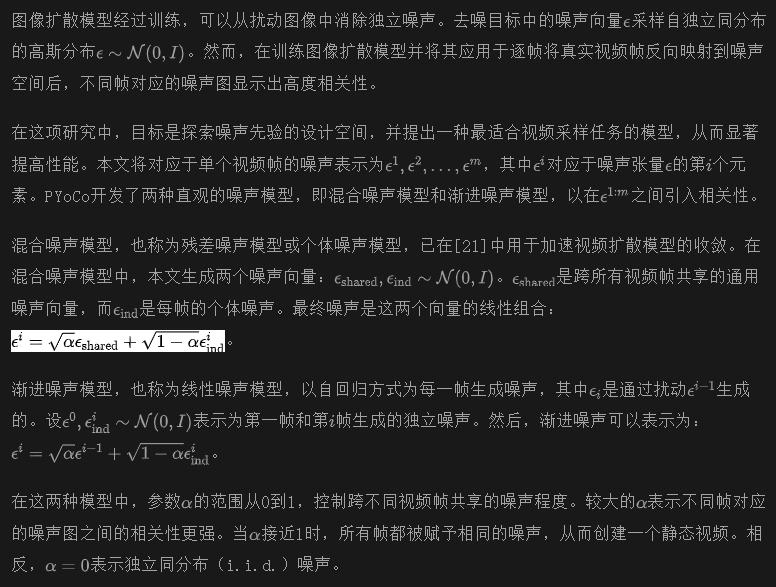

在训练视频扩散模型时使用混合和渐进噪声模型已证明是有效的,如[11]所示。这种方法使得在训练过程中能够有效地学习帧之间的动画过渡。

依赖噪声模型

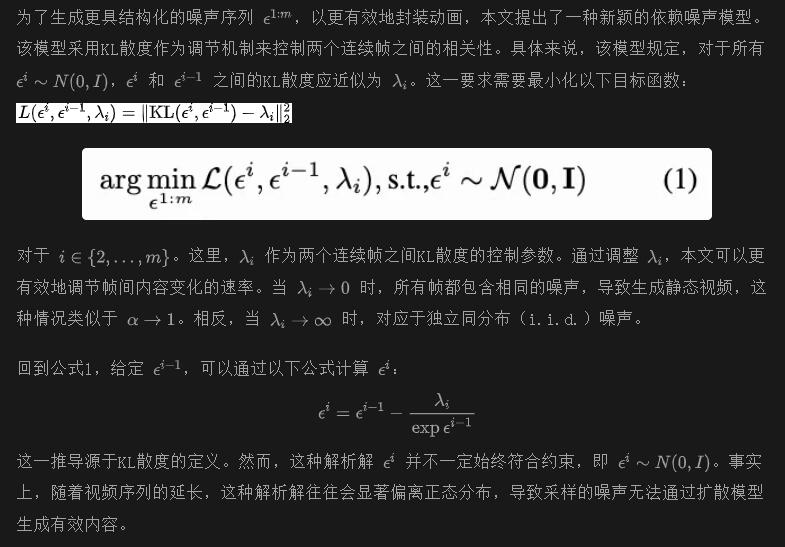

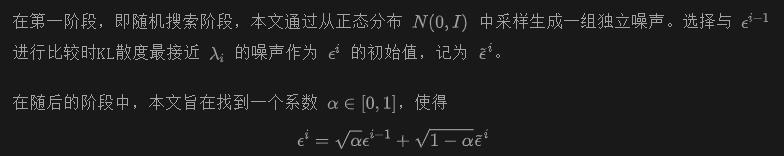

如下面算法1所示,本文提出了一种两阶段噪声搜索算法,这与传统的解析解方法有所不同。

从而最小化公式1。

时间动量注意力

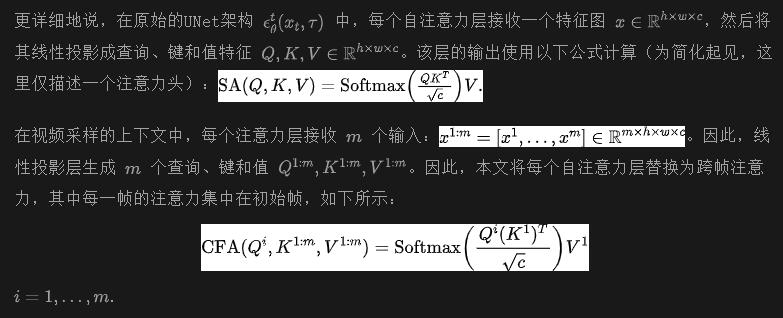

为了利用跨帧注意力的潜力,并使用预训练的图像扩散模型而无需重新训练,FateZero将每个自注意力层替换为跨帧注意力。在这种设置中,每一帧的注意力主要集中在初始帧。类似的结构也在 [19] 中采用。

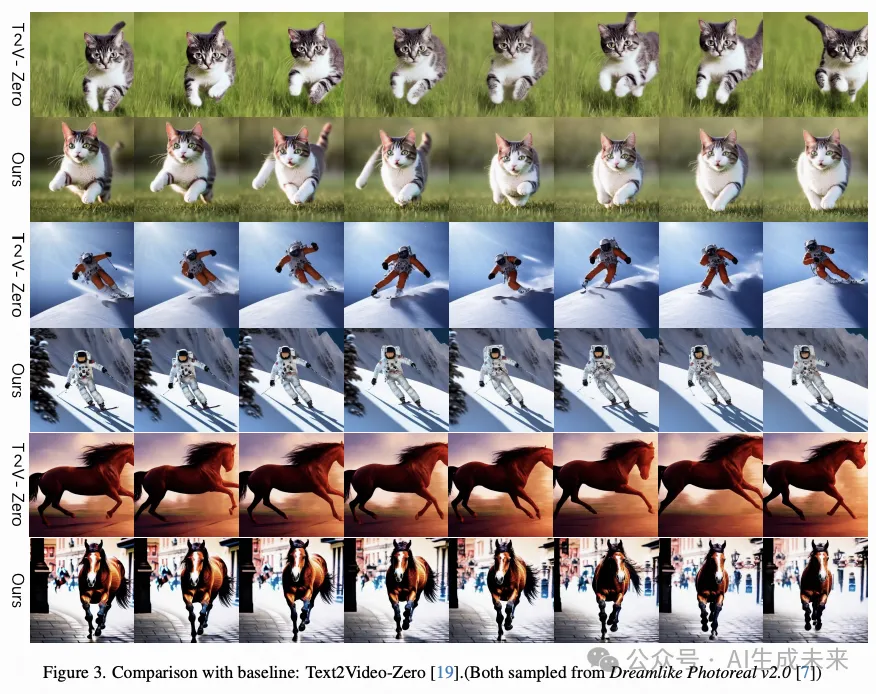

跨帧注意力的应用有助于将外观、结构以及物体和背景的身份从第一帧传递到后续帧。然而,这种方法缺乏相邻帧之间的连接,这可能导致生成的视频序列中出现显著的变化,如下图3所示。

时间动量注意力

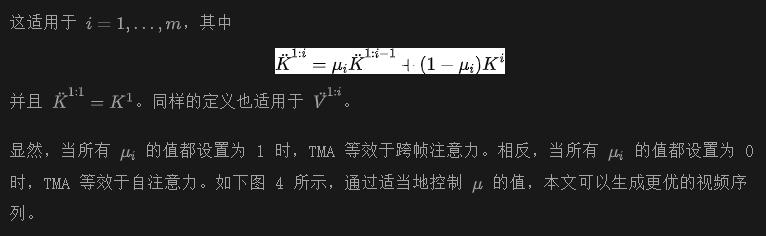

本文的观察表明,自注意力由于缺乏帧间上下文,会导致采样特征的多样性更高。另一方面,跨帧注意力仅依赖于初始帧的信息。这虽然保证了采样结果的一致性,但也导致了多样性的减少。

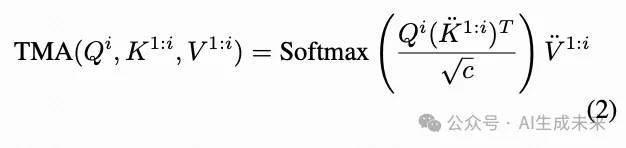

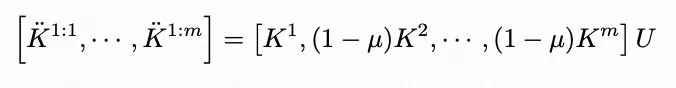

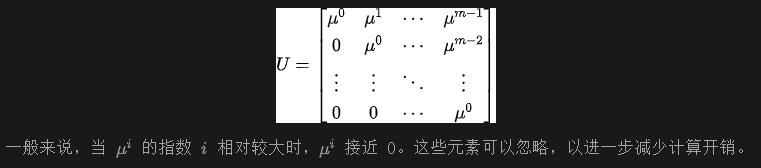

为了在自注意力和跨帧注意力的不同效果之间取得平衡,本文引入了时间动量注意力(Temporal Momentum Attention, TMA)。TMA的数学表示如下:

其中,

Zero-Shot 视频采样算法

通过结合依赖噪声模型和时间动量注意力,本文成功地利用现有的 DDIM 算法从图像扩散模型中采样出高质量的视频。这个过程在上面的算法 1 中进行了概述。

实验

文本与视频任务的综合比较

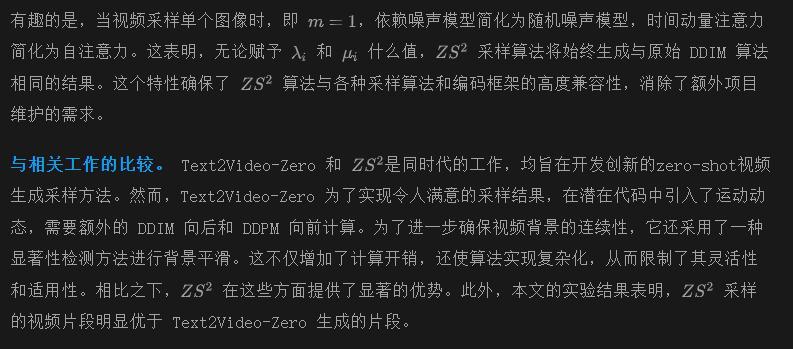

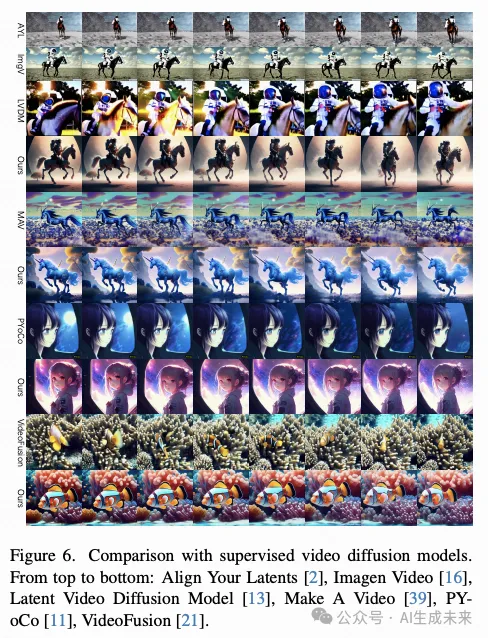

在本研究中,本文从定量和定性两个方面对本文的方法和另一个zero-shot视频合成方法 Text2Video-Zero 进行了广泛的比较。

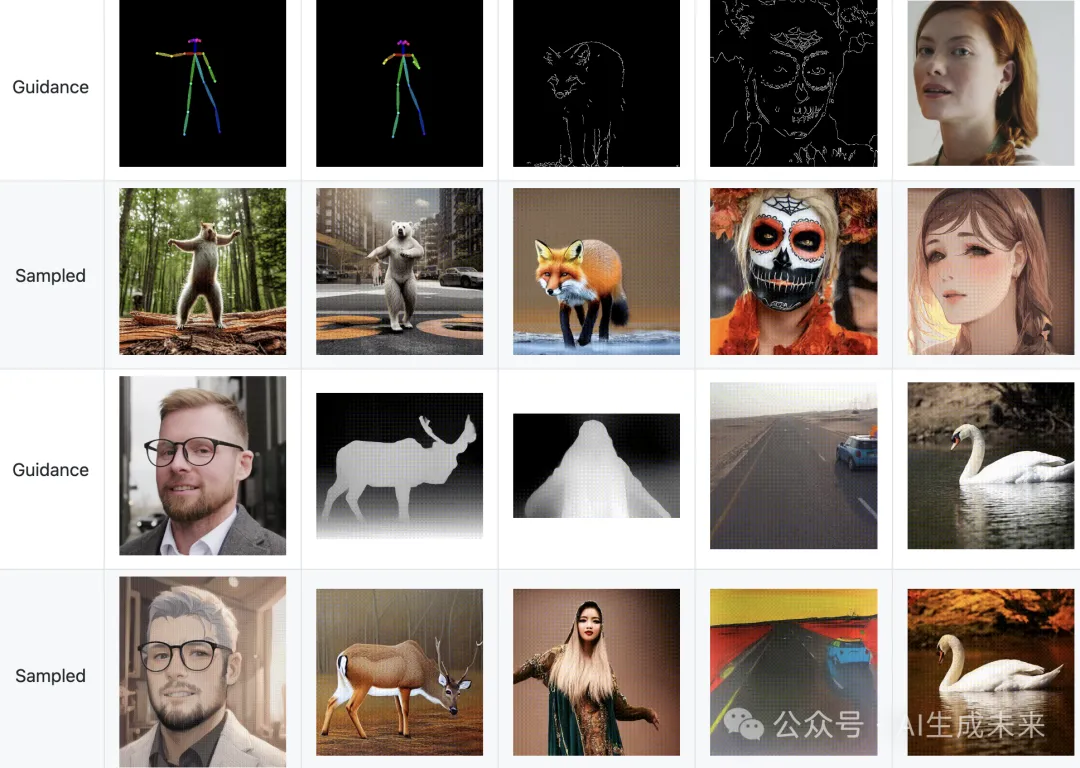

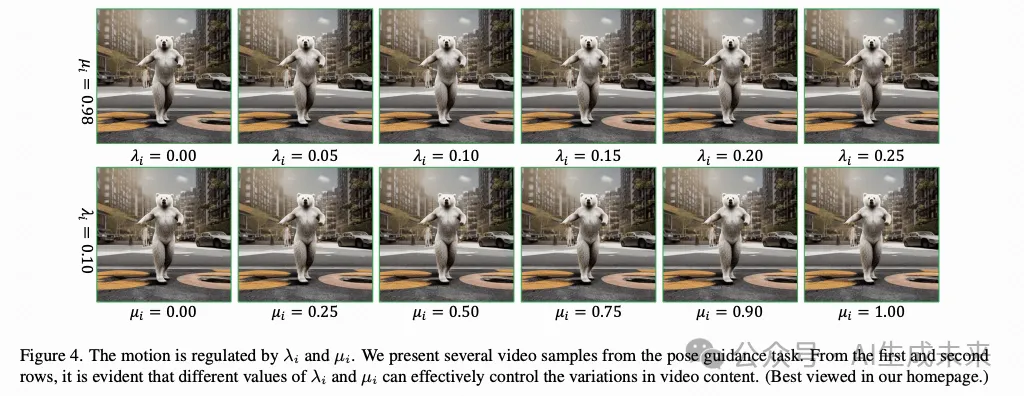

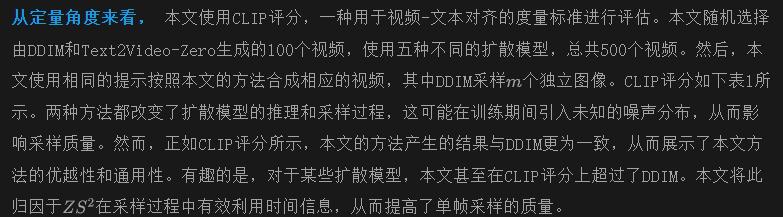

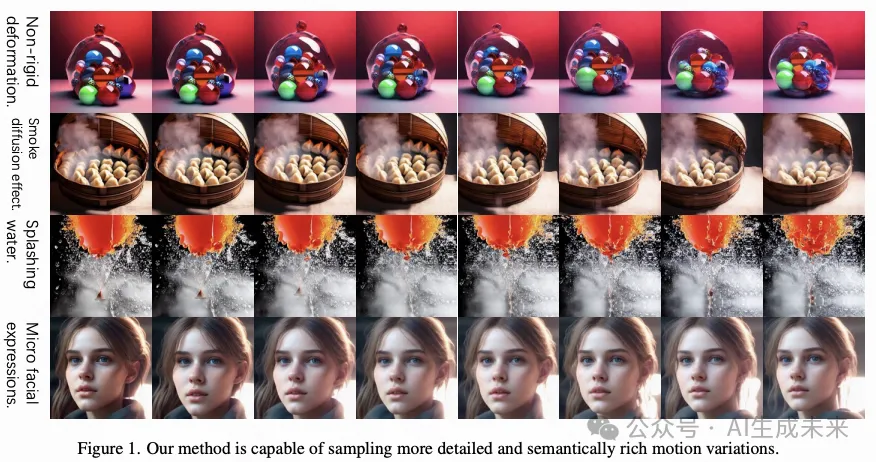

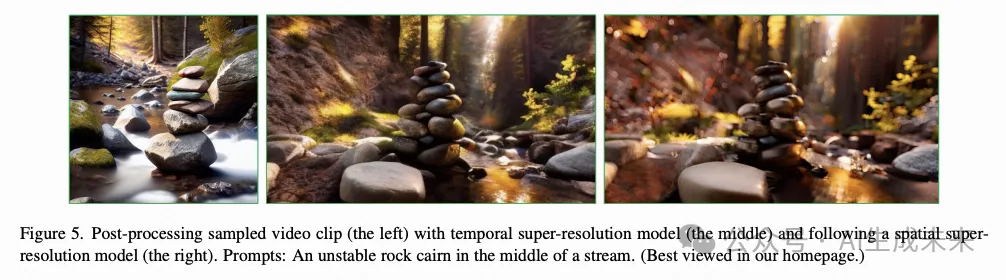

从定性角度来看, 本文在上图3中提供了一些生成视频片段的可视化。本文方法生成的视频片段明显表现出更优越的连续性,显著减少了突兀的帧。与[19]中的简单上下物体运动相比,本文的依赖噪声模型采样的噪声可以扩散出更具体、复杂的运动,并在不同的扩散模型中很好地泛化,如下图2所示。结合时间动量注意力,本文的方法可以为更具挑战性的对象生成更复杂的运动,例如流体的非刚性变形、复杂的烟雾扩散效果,甚至是微妙的面部微表情,如下图1所示。

扩展

结论

本文转自AI生成未来,作者:Dengsheng Chen等