视频生成要有自己的系统!尤洋团队历时半年开源VideoSys 精华

自今年起,OpenAI 的 Sora 和其他基于 DiT 的视频生成模型在 AI 领域掀起了又一波浪潮。但由于起步较晚,视频生成领域的很多基础设施都还有待完善。

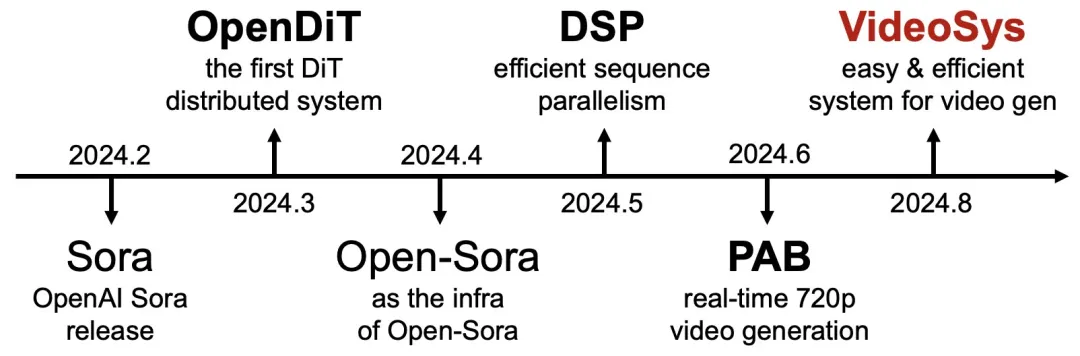

今年 2 月份,新加坡国立大学尤洋团队开源的一个名为 OpenDiT 的项目为训练和部署 DiT 模型打开了新思路。这是一个易于使用、快速且内存高效的系统,专门用于提高 DiT 应用程序的训练和推理效率,包括文本到视频生成和文本到图像生成。

项目上线后非常受欢迎,尤洋团队也一直在继续这方面的工作,包括增加对 Open-Sora 等模型的支持,开发 DSP、PAB 加速技术等。

最近,他们更是把这些进展都融合到了一起,开发出了一个名为 VideoSys 的视频生成系统。

团队表示,与 LLM 不同,视频模型要处理长序列和复杂的执行流程。并且模型的每个组件都具有独特的特征,对内存和计算提出了不同的挑战。

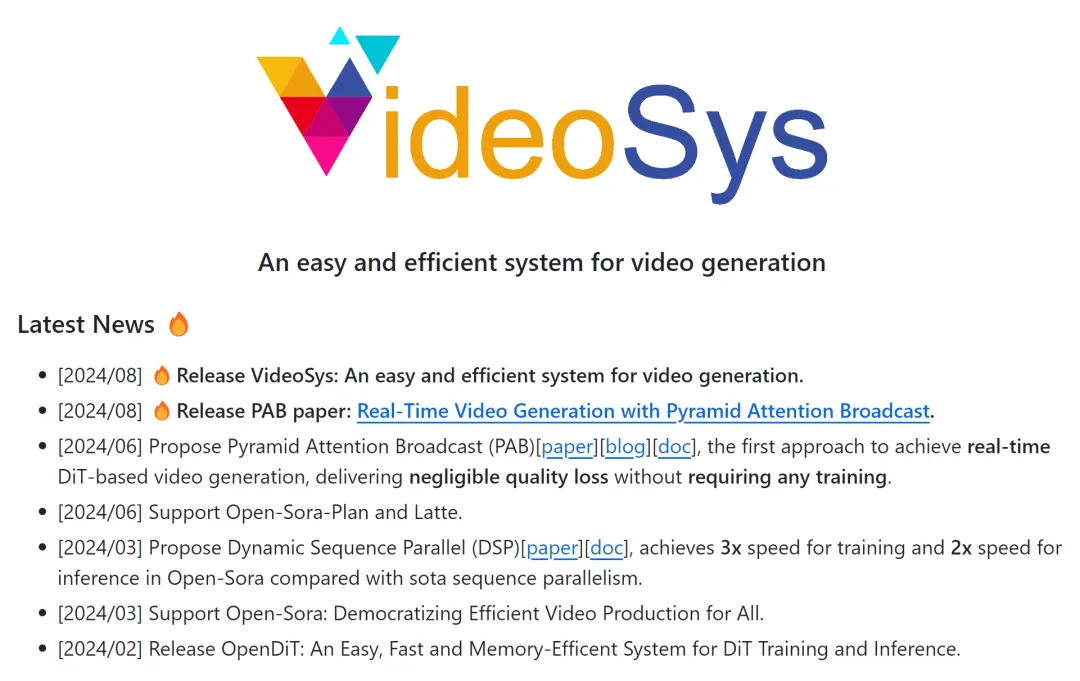

VideoSys 是一个简单高效的视频生成系统,旨在让视频生成对于每个人而言都简便、迅速且成本低廉。

此外,它还是一个开源项目,为视频生成提供了一个用户友好的高性能基础设施。这个全面的工具包将支持从训练、推理到服务和压缩的整个 pipeline。它标志着视频生成的新篇章。

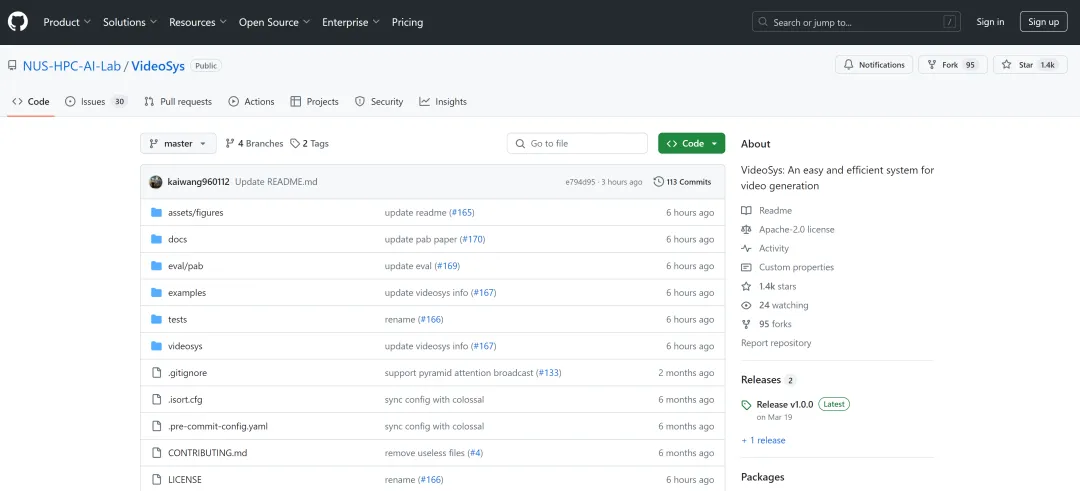

从 OpenDiT 到 VideoSys,尤洋团队的相关工作已经收获了 1.4k 的 star 量。

- 项目链接:https://github.com/NUS-HPC-AI-Lab/VideoSys

VideoSys 的安装、使用方法和相关技术如下。

安装方法

安装准备:

Python >= 3.10

PyTorch >= 1.13(建议使用 2.0 以上版本)

CUDA >= 11.6强烈建议使用 Anaconda 创建一个新环境(Python>=3.10)来运行示例:

conda create -n videosys pythnotallow=3.10 -y

conda activate videosys安装 VideoSys:

git clone https://github.com/NUS-HPC-AI-Lab/VideoSyscd VideoSys

pip install -e .使用方法

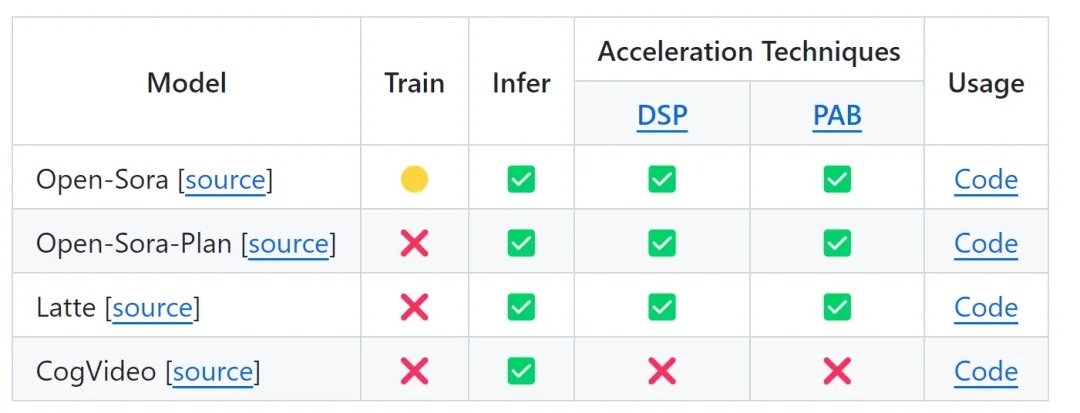

VideoSys 通过各种加速技术支持许多扩散模型,使这些模型能够运行得更快并消耗更少的内存。

你可以在下表中找到所有可用模型及其支持的加速技术。

加速技术

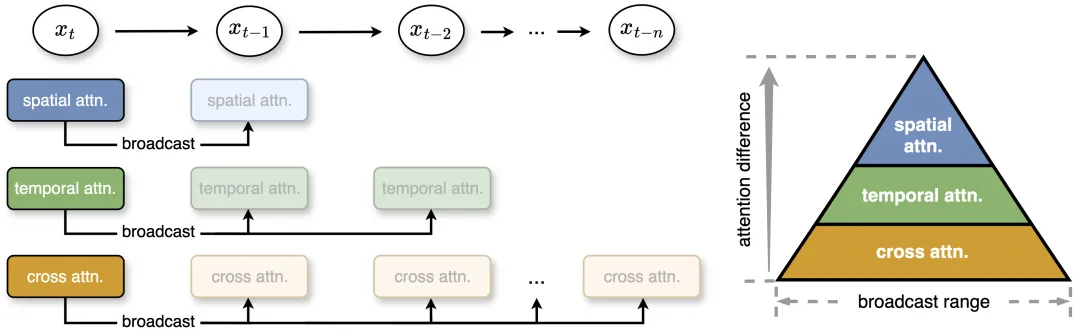

Pyramid Attention Broadcast (PAB)

PAB 是业内第一种可以实时输出的、基于 DiT 的视频生成方法,无需任何训练即可提供无损质量。通过减少冗余注意力计算,PAB 实现了高达 21.6 FPS 的帧率和 10.6 倍的加速,同时不会牺牲包括 Open-Sora、Open-Sora-Plan 和 Latte 在内的基于 DiT 的视频生成模型的质量。值得注意的是,作为一种不需要训练的方法,PAB 可以为任何未来基于 DiT 的视频生成模型提供加速,让其具备实时生成的能力。详情请参见机器之心报道:《史上首个实时 AI 视频生成技术:DiT 通用,速度提升 10.6 倍》

- 论文:https://arxiv.org/abs/2408.12588

- 博客:https://arxiv.org/abs/2403.10266

- 文档:https://github.com/NUS-HPC-AI-Lab/VideoSys/blob/master/docs/pab.md

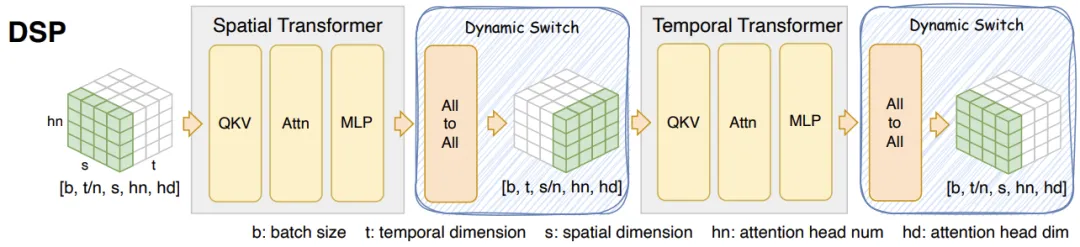

Dyanmic Sequence Parallelism(DSP)

DSP 是一种新颖、优雅、超高效的序列并行算法,适用于 Open-Sora、Latte 等多维 transformer 架构。

与 sota 序列并行方法 DeepSpeed Ulysses 相比,它在 Open-Sora 中实现了 3 倍的训练加速和 2 倍的推理加速。对于 10 秒(80 帧)的 512x512 视频,Open-Sora 的推理延迟如下:

- 论文:https://arxiv.org/abs/2403.10266

- 文档:https://github.com/NUS-HPC-AI-Lab/VideoSys/blob/master/docs/dsp.md

更多详细信息请参考该项目 Github 界面。

本文转自 机器之心 ,作者:机器之心