AI Scientist爆火背后的技术详解以及优缺点分析 精华

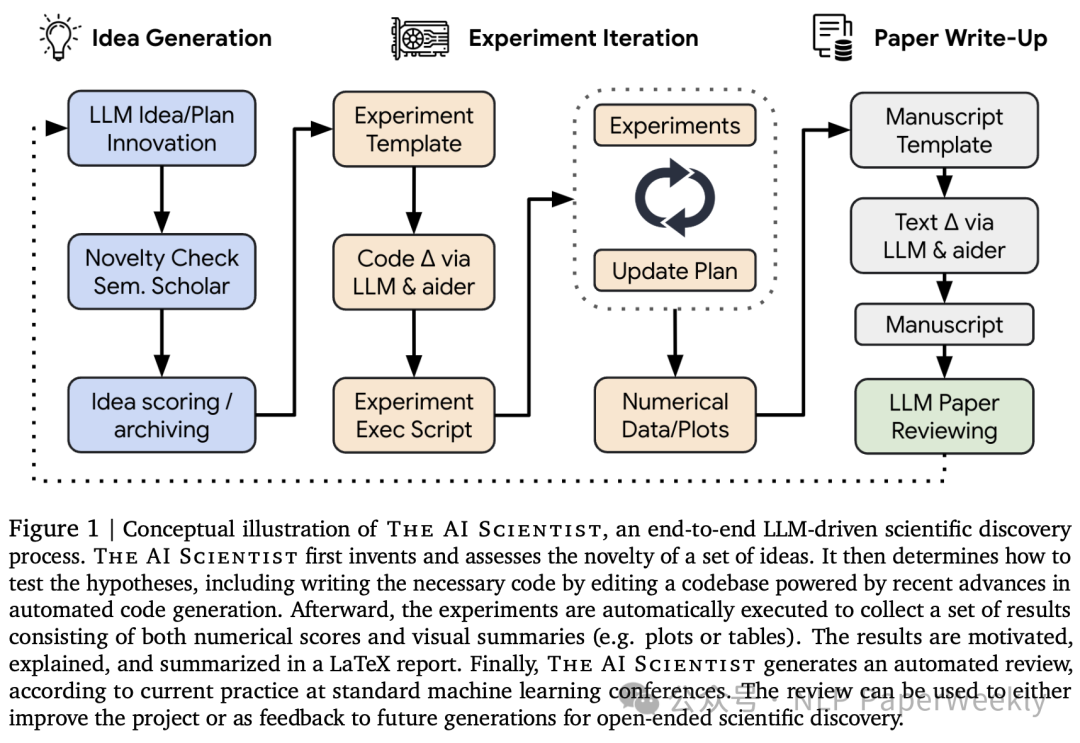

今天分享一篇最近比较热门的日本创业公司Sakana AI的一篇文章,标题为《The AI Scientist: Towards Fully Automated Open-Ended Scientific Discovery》。文章提出了一种名为“AI Scientist”的框架,旨在实现端到端完全自动化的科学发现,完成从Idea构建,实验跑取,文章撰写的完全自动化。验证了AI自动化探索新问题,解决新问题,甚至撰写Paper的可行性。同时还提出了一个能与人类评委水准接近的Review Agent,能够给出高水准的评审意见。

总体来说,其还是一个多agent系统,利用了reflection机制迭代优化效果,同时也结合Semantic Scholar等工具验证创新性,利用Aider工具来更新代码和Paper,来执行相关实验。同时也要看到其只是搭了一个基础的Baseline通道,如何提升Idea生成的深度以及多样性,如何让LLM能实现更复杂,更有挑战性的Idea,如何降低Review Agent的False Positive Rate(FPR)都值得进一步探索。

本文将对其背后的技术,优缺点进行详细的分析~

一、概述

1. Motivation

- • 尽管前沿模型已被用作人类科学家的辅助工具,如头脑风暴、编写代码或预测任务,但它们仍仅完成了科学过程的一小部分。

- • 本文提出了第一个全面的框架,用于实现完全自动化的科学发现,使前沿大型语言模型能够独立进行研究并传达其发现。

2. Method

文章介绍了“AI科学家”框架,该框架包括三个主要阶段:

1.想法生成:AI科学家首先“头脑风暴”出一系列新颖的研究方向,然后在此基础上进行创新性迭代优化,最后筛选创新性较高的idea。

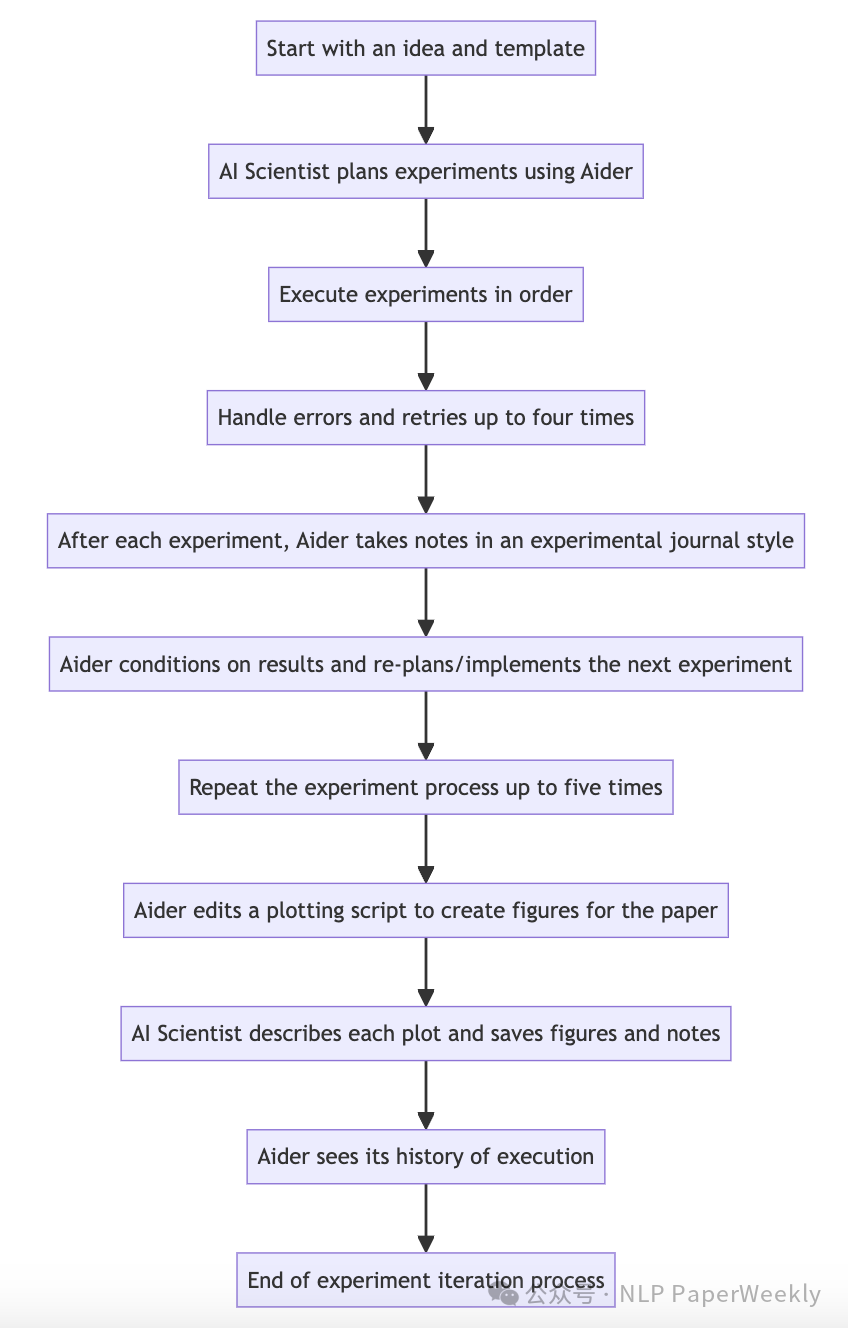

2.实验迭代:根据想法和模板,AI科学家首先执行提出的实验plan,然后根据实验结果,迭代优化实验,最后更新plot代码,可视化其结果以供后续撰写,代码通过AIder工具来更新。

3.论文撰写:AI科学家使用LaTeX撰写完整的科学论文,描述其进展。

• 输入:总体就两个输入,Baseline Code,以及论文Latex模板,加上init paper的一些信息。

• Baseline code:a starting code template that reproduces a lightweight baseline training run from a popular model or benchmark. For example, this could be code thattrains a small transformeron the works of Shakespeare (Karpathy, 2022), a classic proof-of-concept training run from natural language processing that completes within a few minutes

• Latex模版:LaTeX folder that containsstyle files and section headers, along with simple plotting code.

• 输出:完整的Paper

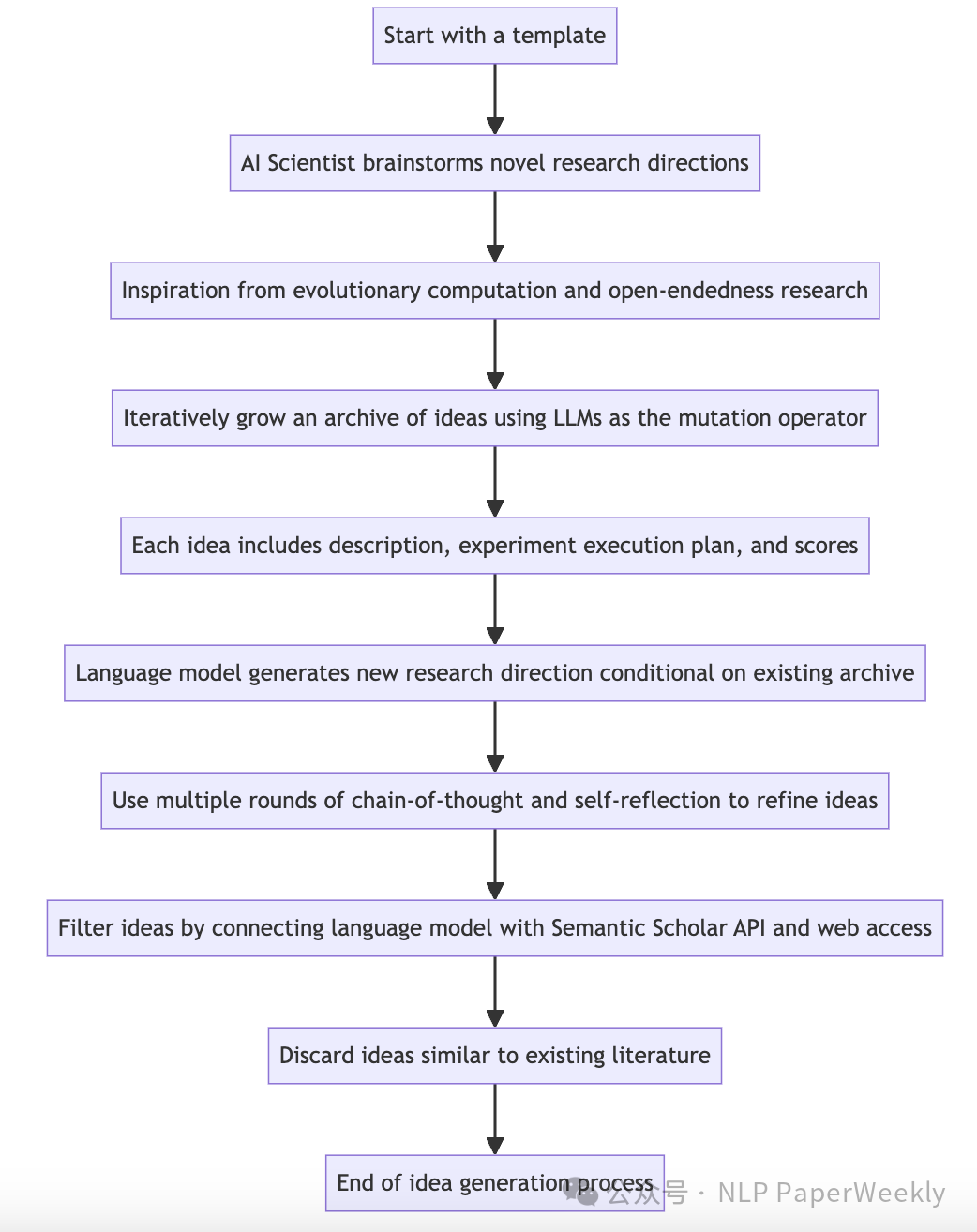

1 Idea generate过程

•输入:code template

•输出:some ideas

•代码:https://github.com/SakanaAI/AI-Scientist/blob/main/ai_scientist/generate_ideas.py

• generate_ideas:idea生成

• generate_next_idea:在seed的基础上继续生成新的idea

• search_for_papers:调用api search paper

• check_idea_novelty:检查并优化创新性

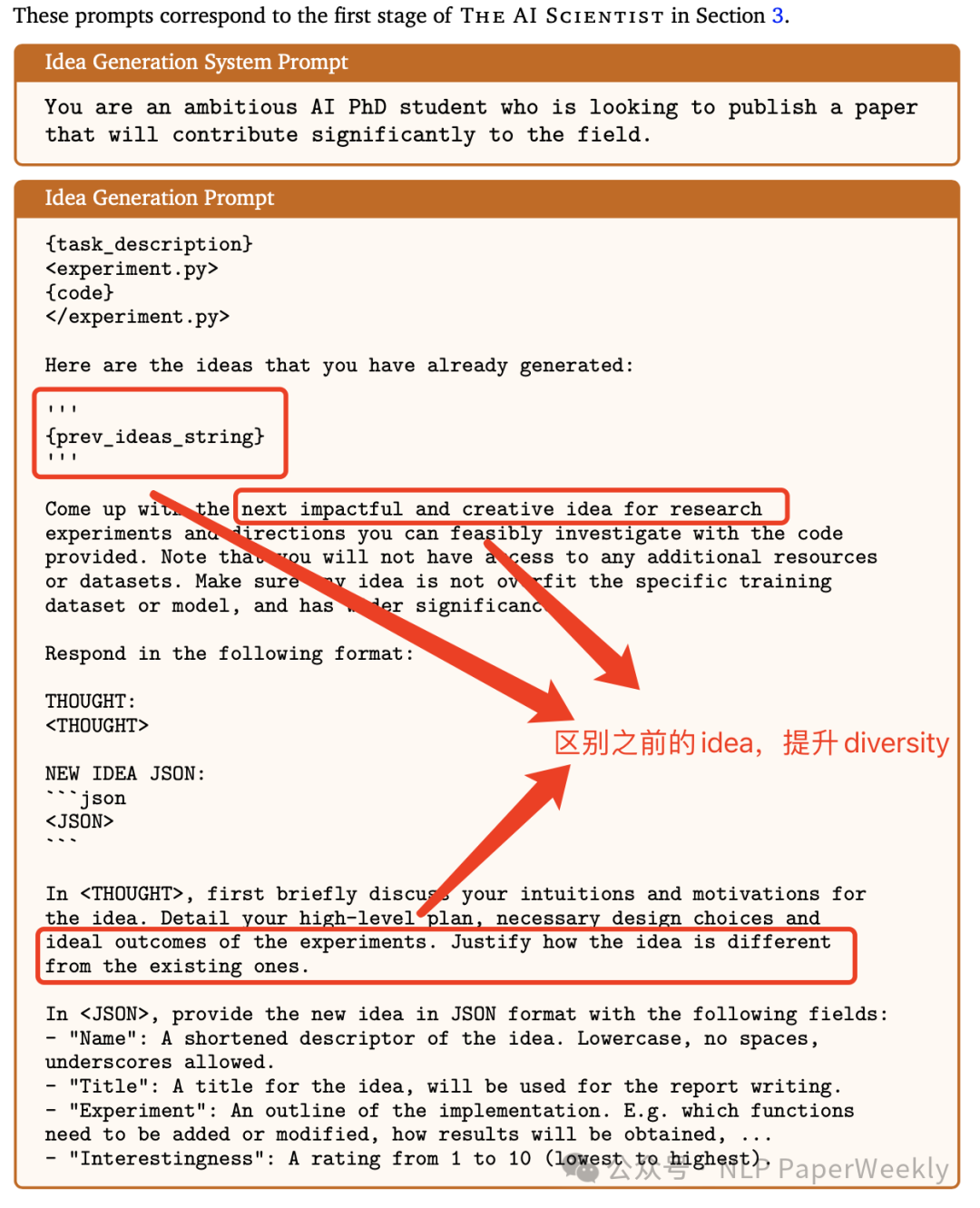

1.1 Idea Generation Prompt

•优点:对diversity做了优化和限制,引入了COT机制。

•缺点:idea全靠LLM内部信息想出来,思考的知识有限,更新也不及时,不太能及时follow最新知识,不过内部知识能做到什么粒度其实还不太确定,另外内部知识其实是缺乏新知识的,这对科学研究非常致命。

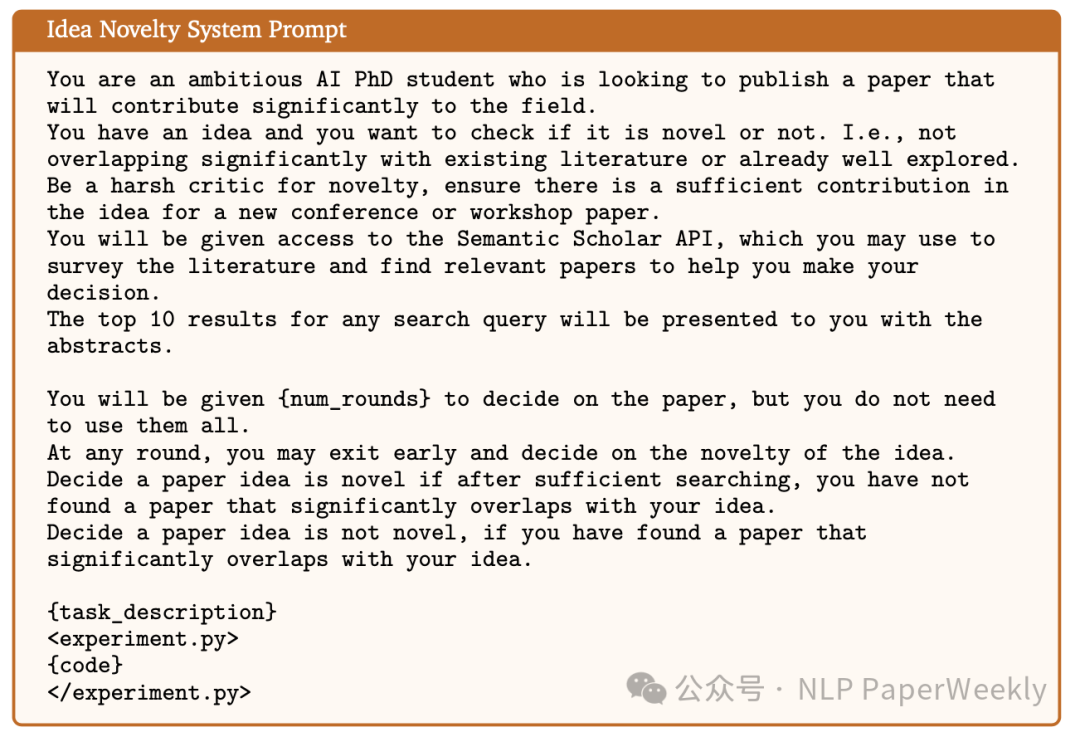

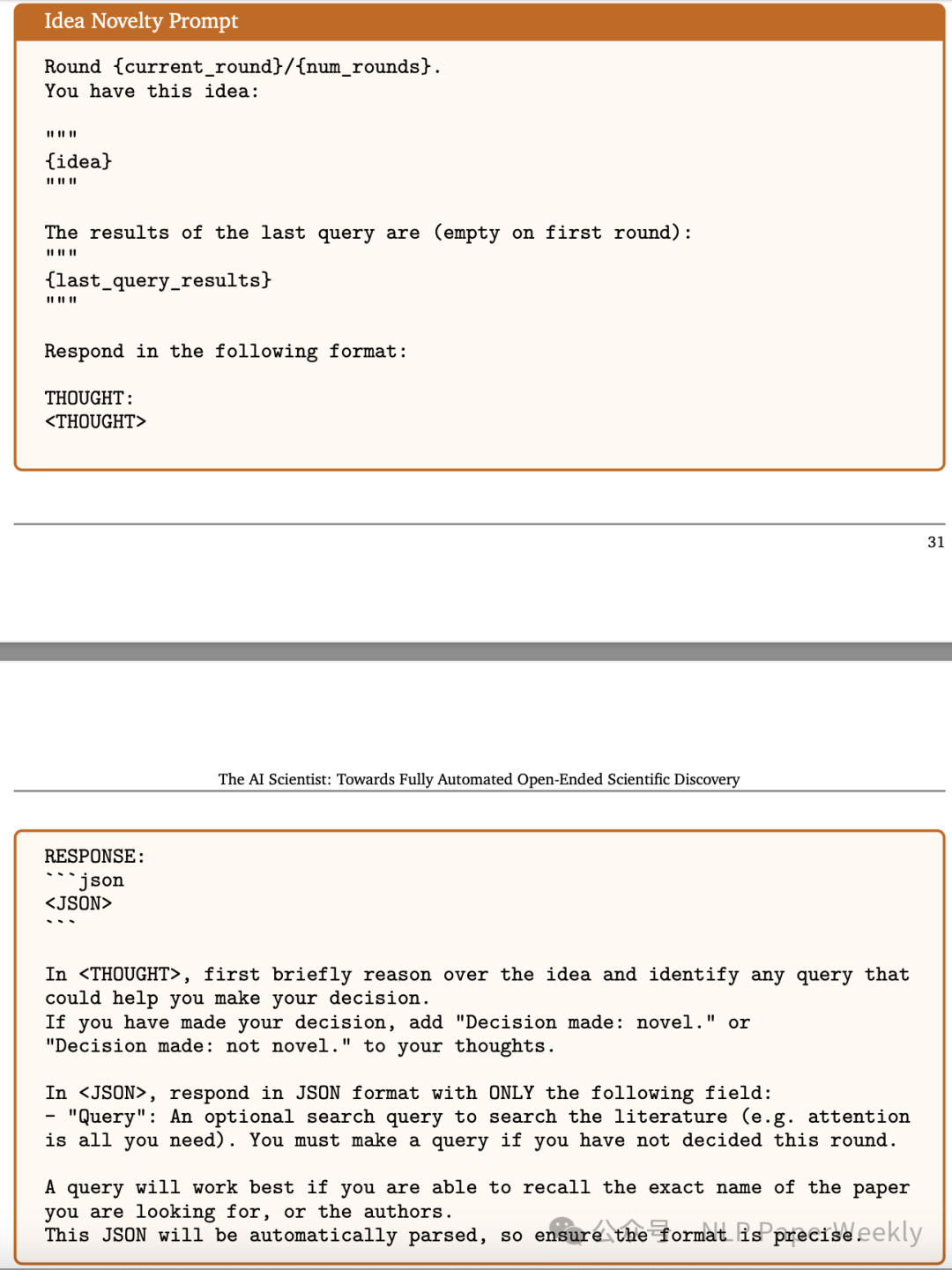

1.2 Idea Novelty Prompt

•特点:用于搜索num_rounds相关的paper来检查优化创新性,如果每次没search到相关内容,还知道去更新Query重新search,最多探索num_rounds,思路看起来不错。

• 缺点:还是创新全部源于LLM内部知识。

2 Experiments过程

• 输入:idea + template

• 输出:experiment result + experiment figures

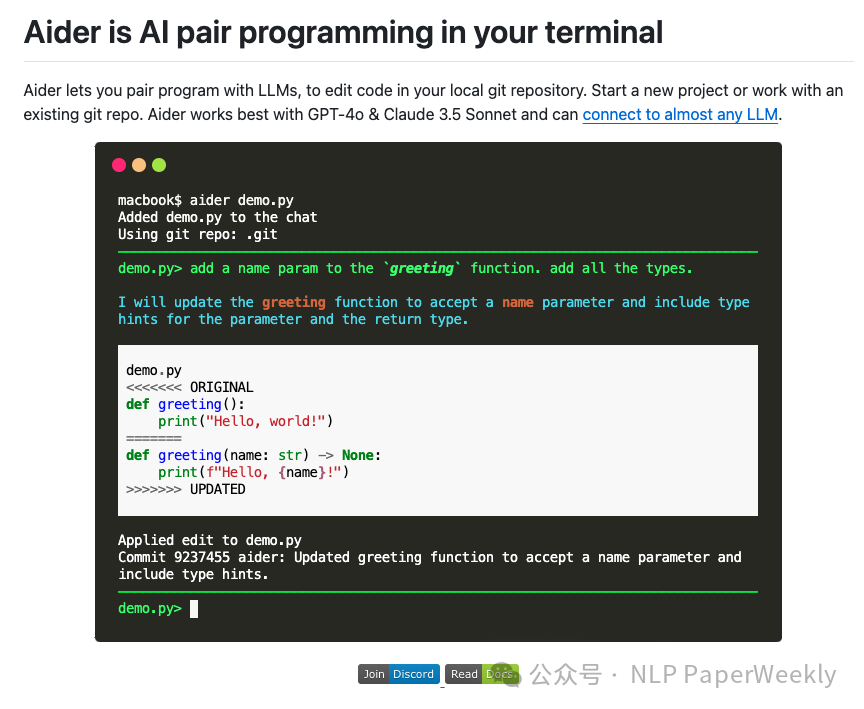

• 实现方式:通过Aider更新代码,然后执行命令行跑取模型结果。

• Aider平台,可以通过命令更新代码:https://github.com/paul-gauthier/aider•

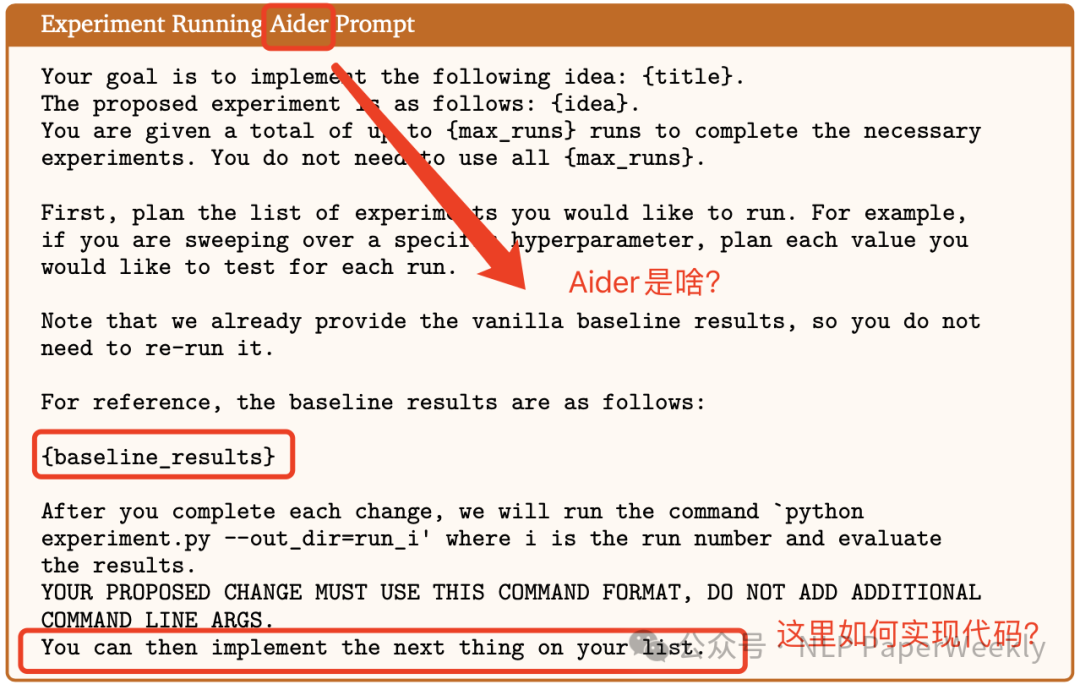

2.1 Experiment Running Aider Prompt

• 特点:先也会有一个plan,然后分别实现experiments

• 缺点:没具体讲如何实现Experiment的,Aider看着是个平台,可能可以直接用,但是改代码很容易出错,稳定性存疑。

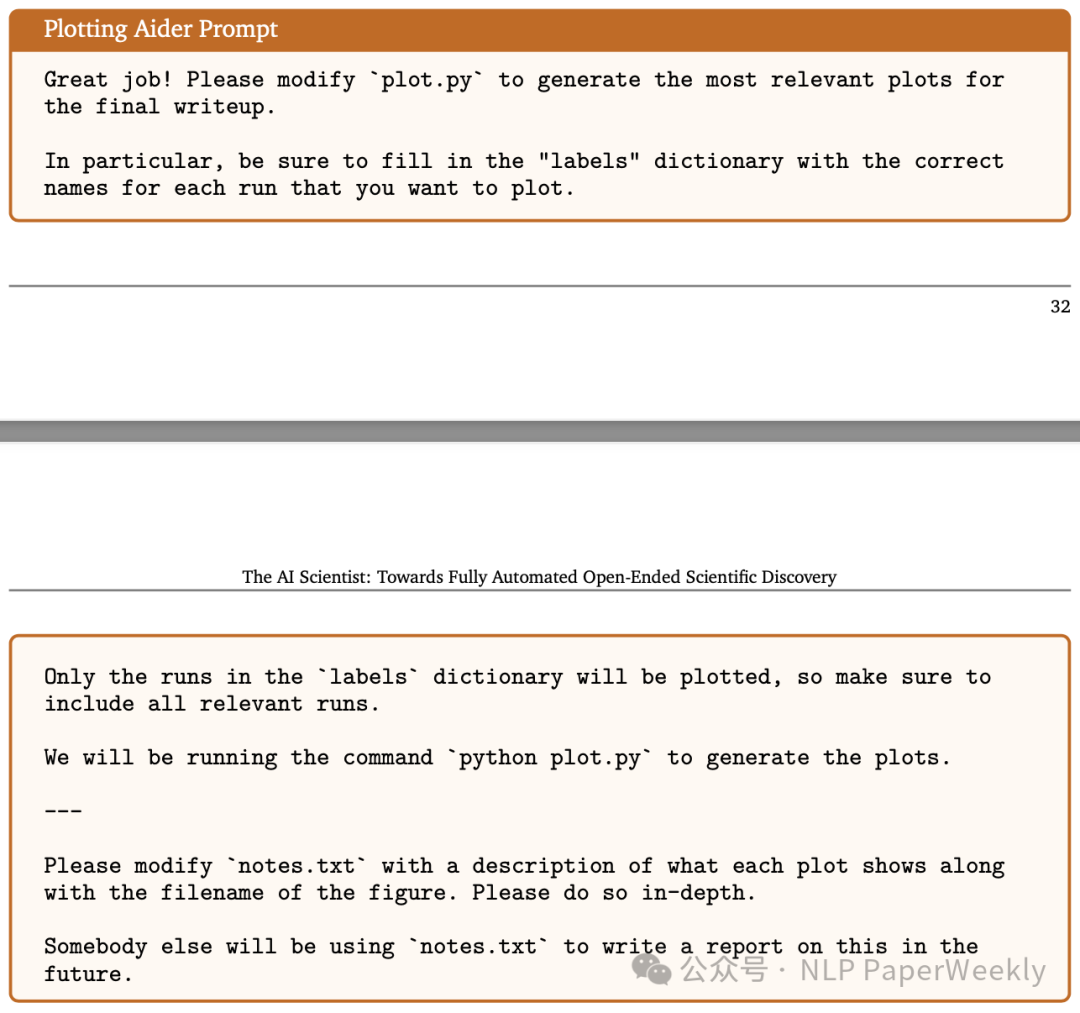

2.2 Plotting Aider Prompt

• 特点:生成plot,还有description,后续用于添加到论文中。

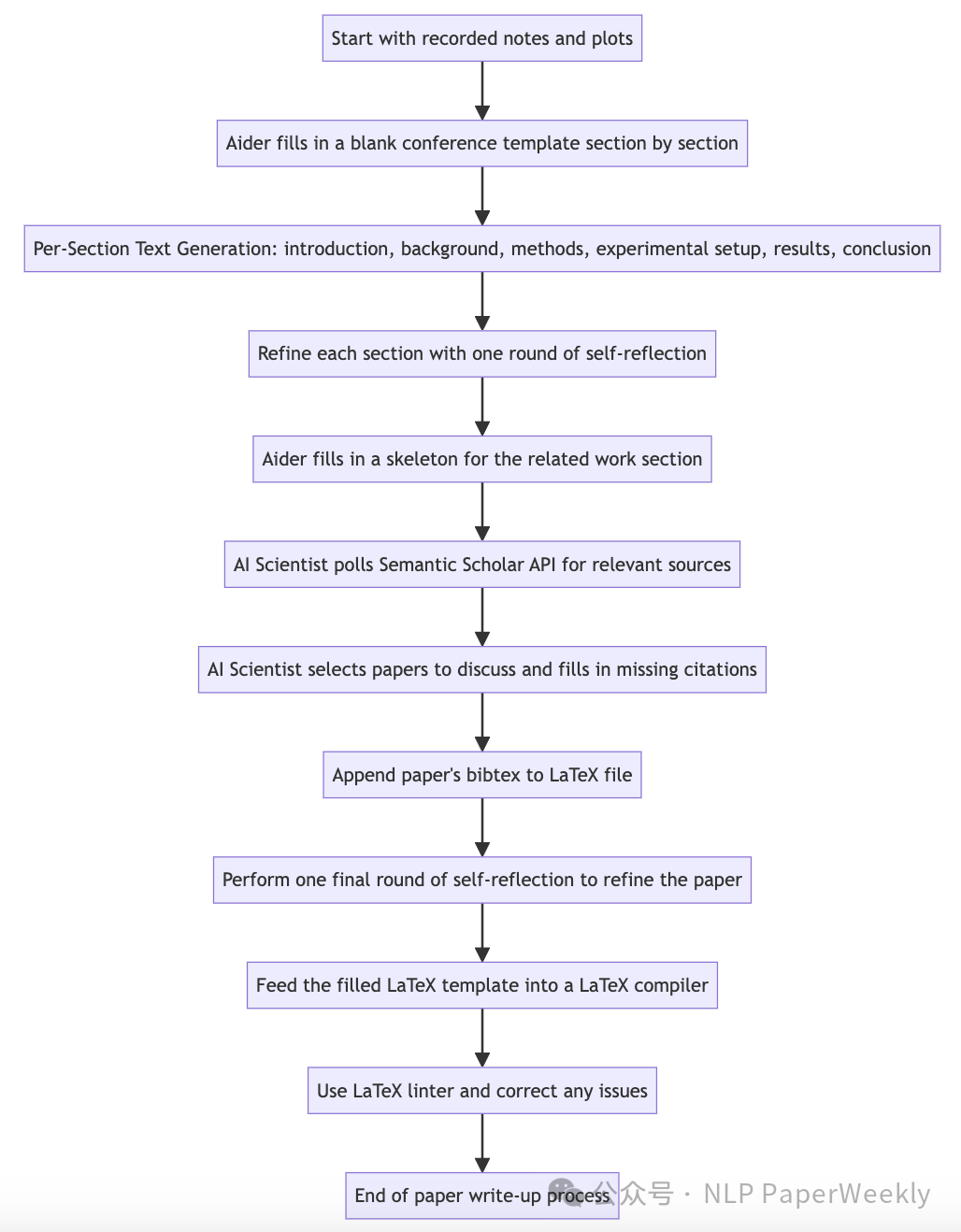

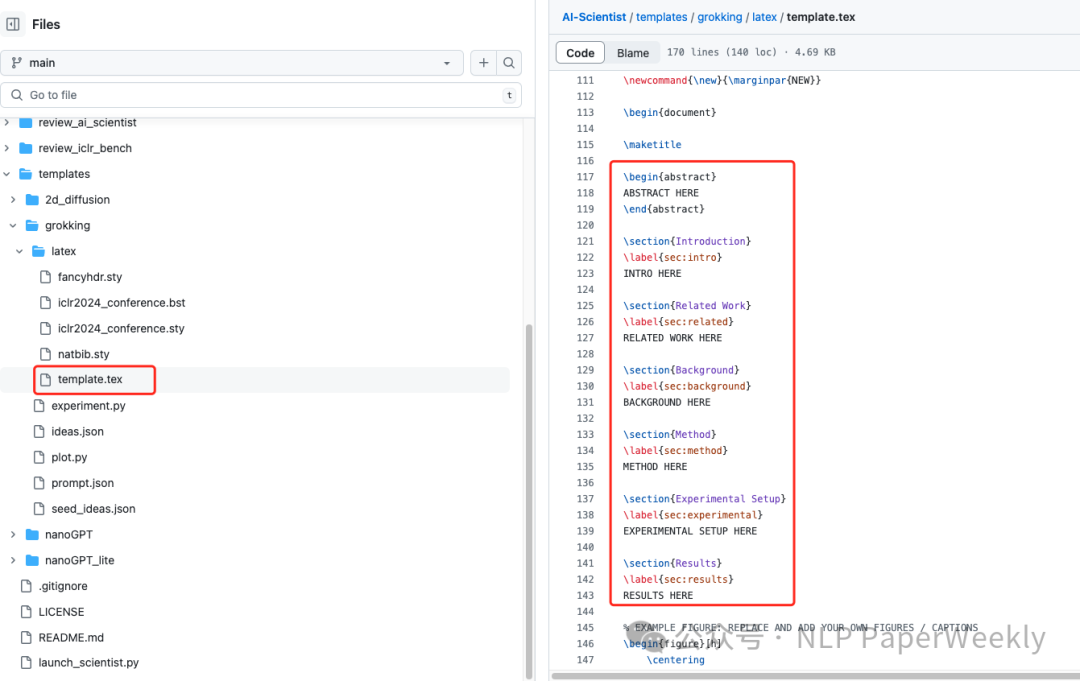

3 Paper Writing流程

• 输入:Latex模版 + Experiments recorded notes + plots,Latex模板图如下,也是用Aider工具来修改•

• 输出:paper

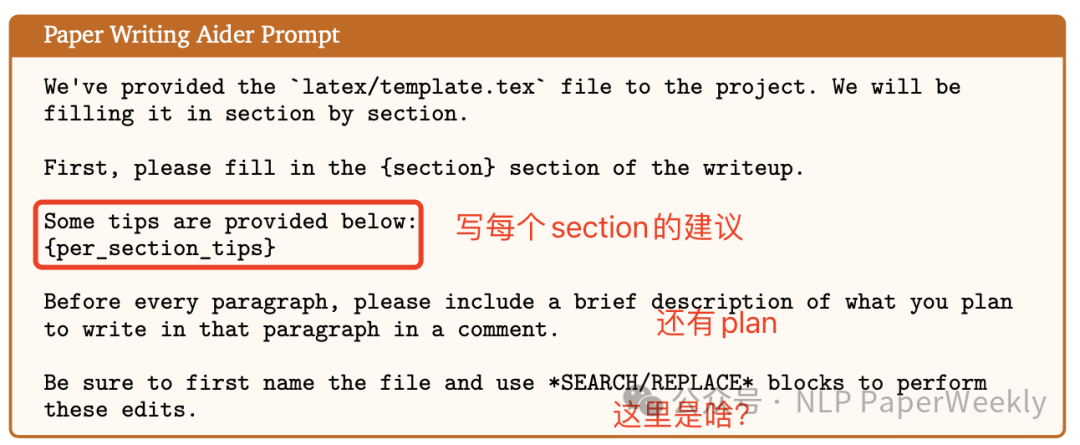

3.1 Paper Writing Aider Prompt

• 特点:提供每个section的建议+latex的template+plan

•缺点:Aider是个啥,感觉writing比较有用的样子。

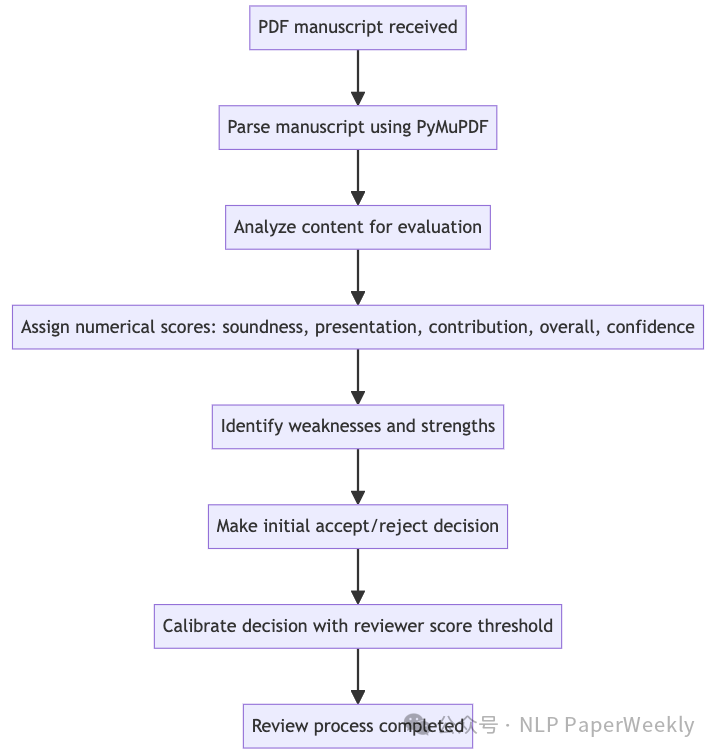

4 Reviewer Agent流程

• 输入:PDF manuscript

• 输出:Paper Review Result

• 优点:参考了neurips ReviewerGuidelines,同时引入reflection,few-shot来提升效果。

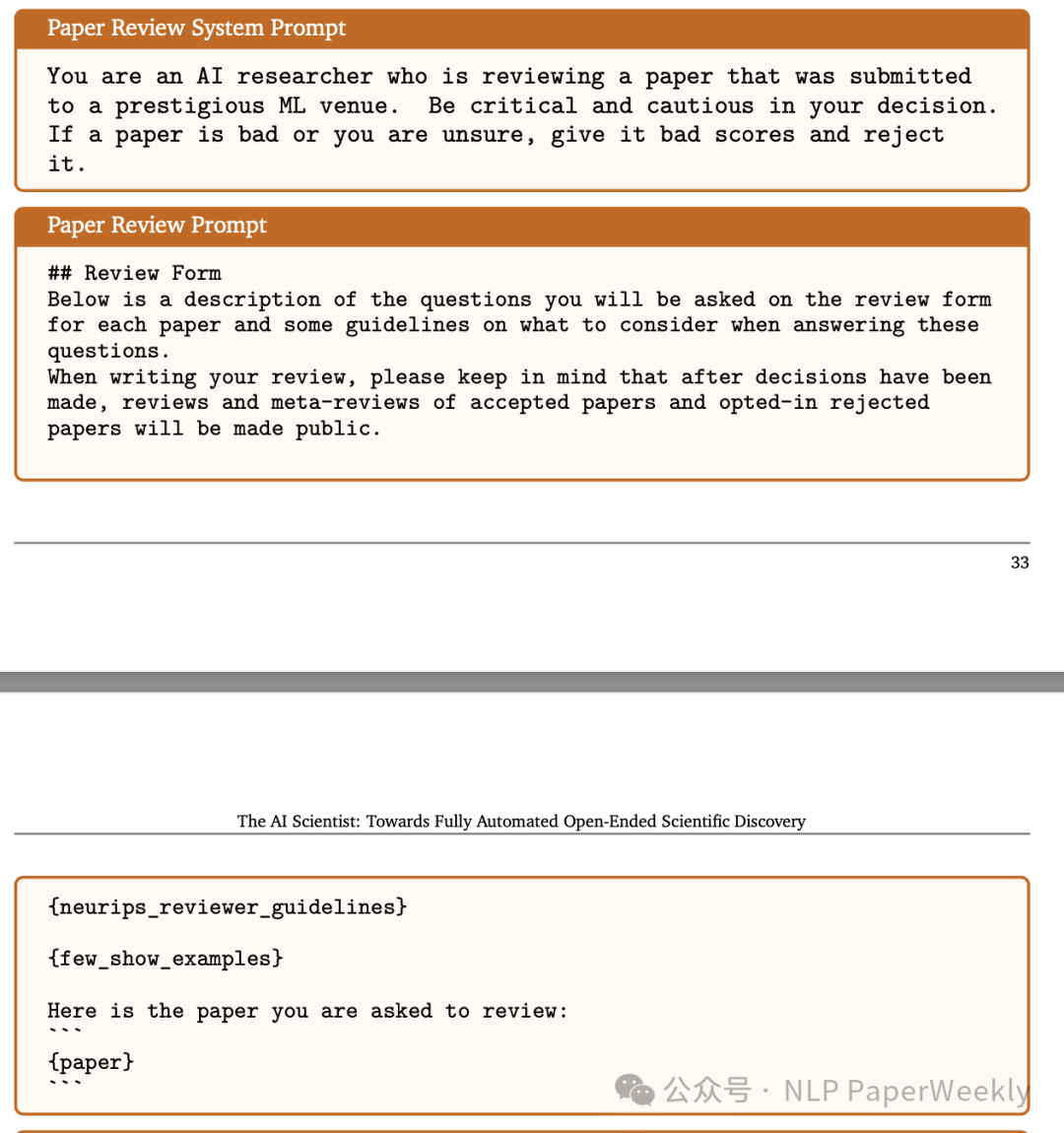

4.1 Paper Review Prompt

• 特点:引入neurips guideline和few_shot_example。

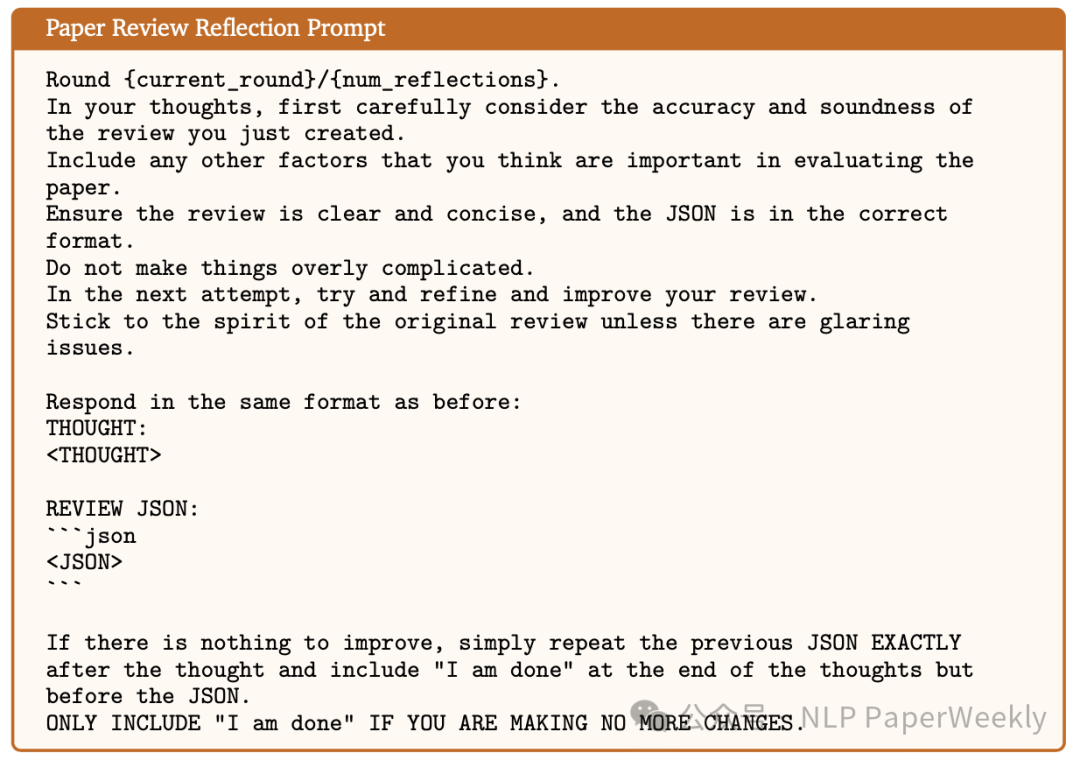

4.2 Paper Review Reflection Prompt

• 特点:经过多轮迭代 + COT思考

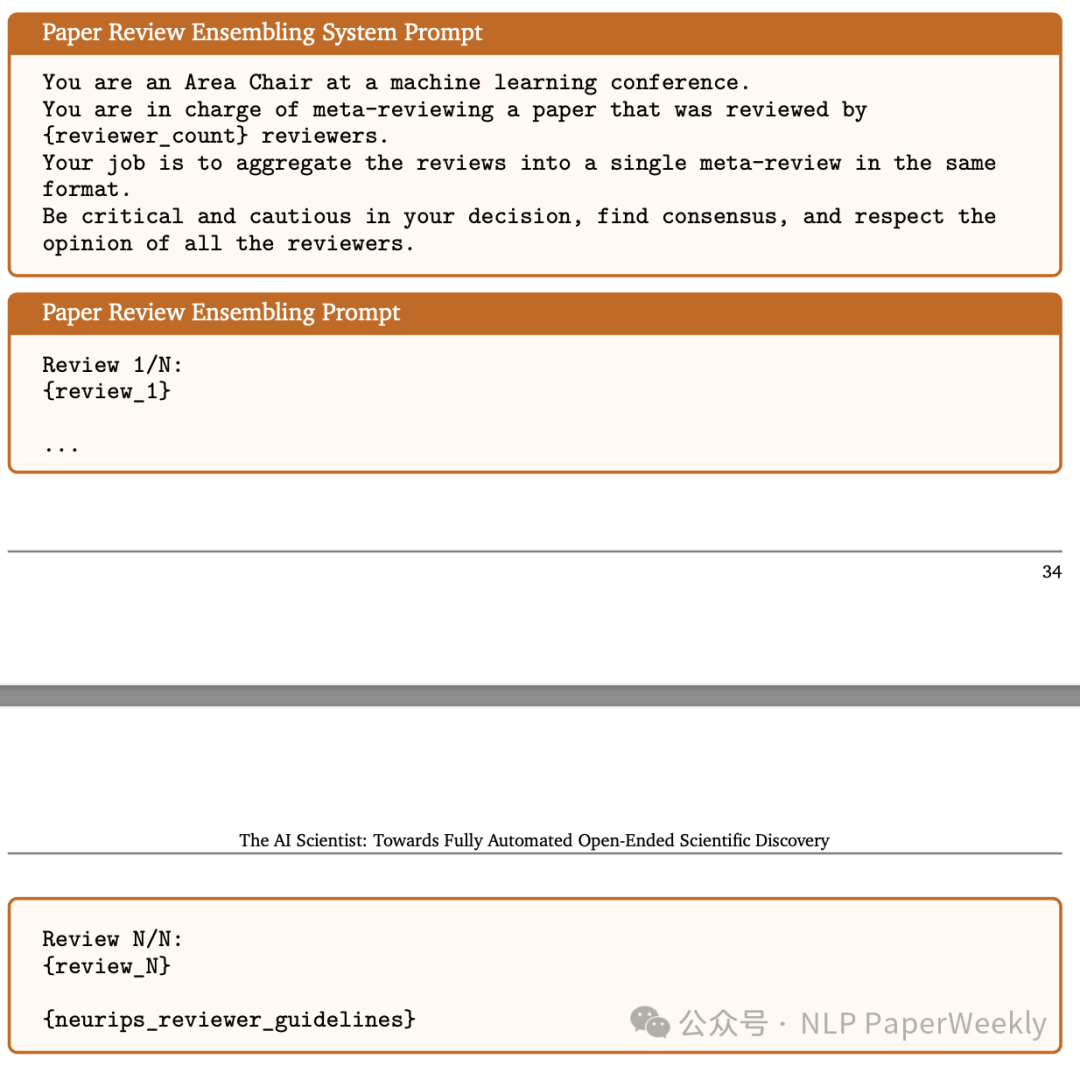

4.3 Paper Review Ensembling Prompt

• 特点:还有个汇总的,优点self-consistant的感觉

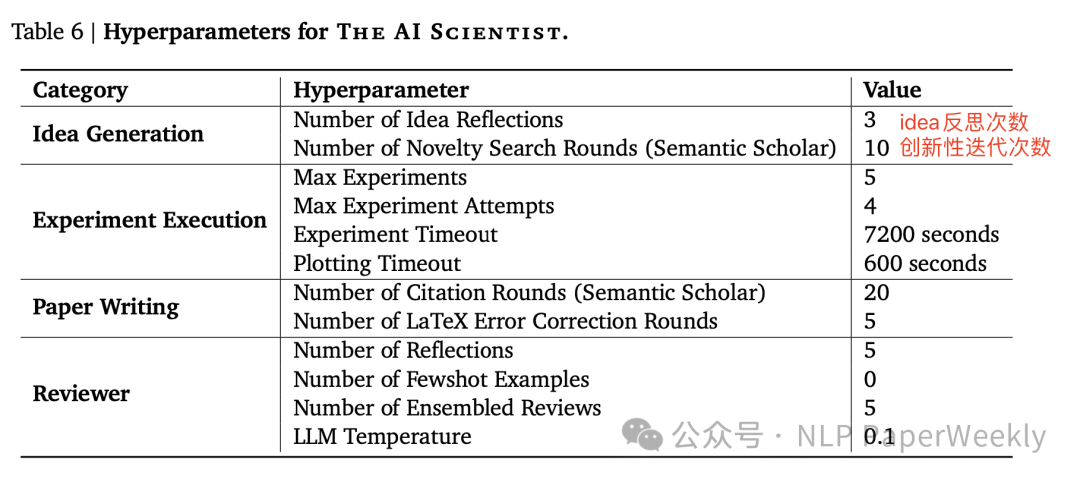

5 反思和迭代次数

3. Coclusion

文章搭建了一个AI Scientist,通过三个子任务验证了其可行性:扩散模型、Transformer和Groking。并且每种想法的实现和开发成本不到15美元。表明了该框架在Research研究和显著加速科学进步方面的潜力。

• 搭建了一个完整的科研链路Agent:idea -> Experiments -> Paper,还真work了。

• 附带送了一个接近人类水平的Paper Review Agent,效果也还不错。

4. Limitation

• 生成的Idea经常非常相似,甚至不同模型,不同run都会有很类似的idea。

• Aider实现ideas有困难,GPT-4o写Latext常不能编译,有些idea实现challenging比较大。

• plot的图像也可能有问题,而且还不止是vision,可能看不出效果。

• Latext的cite和reference可能有问题。

• LLM数学能力不太好,对metric不敏感。

• 幻觉。

二、详细内容

1 LLM Paper Review水平在ICLR2022数据集上已经接近人类水平

• 特点:精度和人类比较接近(balanced 0.65 vs 0.66),False Negative Rate(FNR)更低,False Positive Rate(FPR)偏高,说明也有打分偏高的情况。

2 Reflexion和one-shot能提升Reviewing效果

• 结论:从0.66提升到0.70,看着还不错。Ensemble后精度没有提升,但是variance有降低。

3 Diffusion Modeling优化效果

• **结论1:Sonnet3.5看着比GPT-4o好很多啊,而且还更便宜,完成Paper率居然接近80%**,还是很厉害。

•结论2:DeepSeek Coder是性价比之王。

•其他:DIffusion Modeling感觉都是比较老的模型了,利用LLM生成的idea可能都是训练过的了,可能并不能代表真正的创新。

4 Language Modeling优化效果

•结论: 这次完成率只有40%了,这个差异好大,跟猜测的一样,coding可能非常不稳定,另外DeepSeek Coder确实厉害。

5 Grokking优化效果

•结论:不同paper,不同LLM基座的Noval Ideas居然都超过90%,但是Experiments的完成率差异非常大。

本文转载自 NLP PaperWeekly,作者: NLP PaperWeekly