勇夺三项SOTA!北航&爱诗科技联合发布灵活高效可控视频生成方法TrackGo!

论文链接:https://arxiv.org/pdf/2408.11475

项目链接:https://zhtjtcz.github.io/TrackGo-Page/

★亮点直击

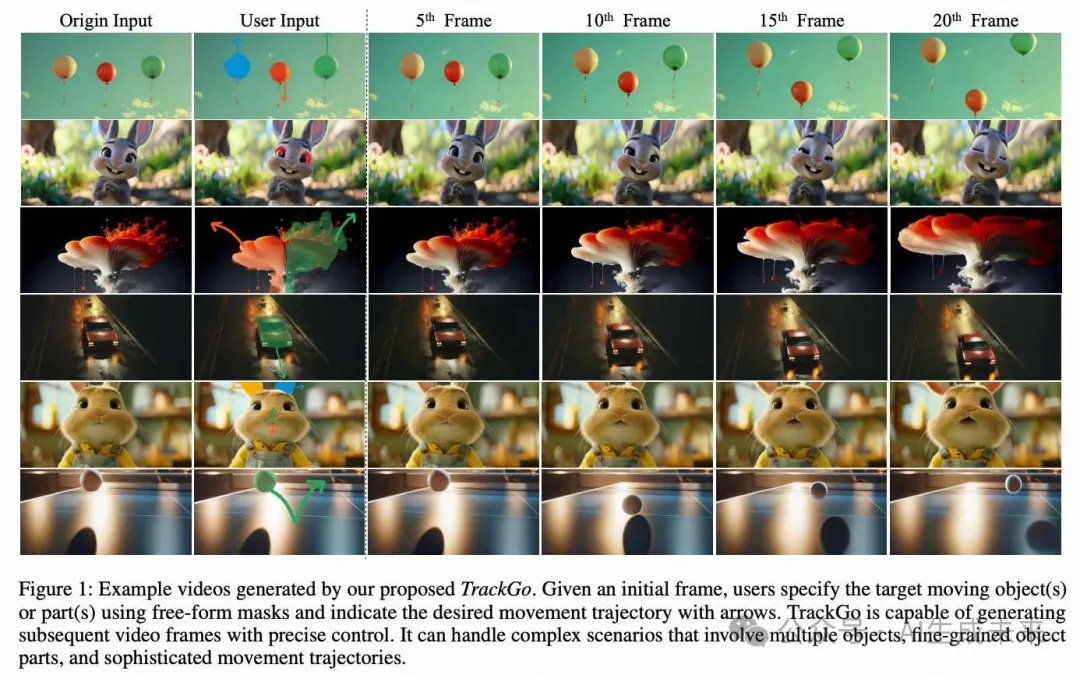

- 本文引入了一种新颖的运动可控视频生成方法,称为TrackGo。该方法为用户提供了一种灵活的运动控制机制,通过结合 masks 和箭头,实现了在复杂场景中的精确操控,包括涉及多个对象、细粒度对象部件和复杂运动轨迹的场景。

- 本文开发了一个新组件,称为TrackAdapter,用于有效且高效地将运动控制信息集成到时间自注意力层中。

- 本文进行了广泛的实验来验证本文的方法。实验结果表明,本文的模型在视频质量(FVD)、图像质量(FID)和运动真实性(ObjMC)方面优于现有模型。

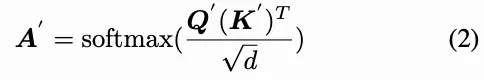

近年来,基于扩散的可控视频生成领域取得了显著进展。然而,在复杂场景中实现精确控制仍然是一个挑战,包括对细粒度的物体部分、复杂的运动轨迹以及连贯的背景运动的控制。在本文中,本文介绍了TrackGo,这是一种利用自由形式的masks和箭头进行条件视频生成的新方法。该方法为用户提供了一种灵活且精确的机制来操控视频内容。本文还提出了用于控制实现的TrackAdapter,这是一种高效轻量的适配器,旨在无缝集成到预训练视频生成模型的时间自注意力层中。该设计利用了本文的观察,即这些层的注意力图可以准确激活与视频中运动对应的区域。本文的实验结果表明,借助TrackAdapter增强的新方法在关键指标如FVD、FID和ObjMC得分上实现了SOTA性能。

方法

概览

在接下来的部分中,将讨论三个主要主题:

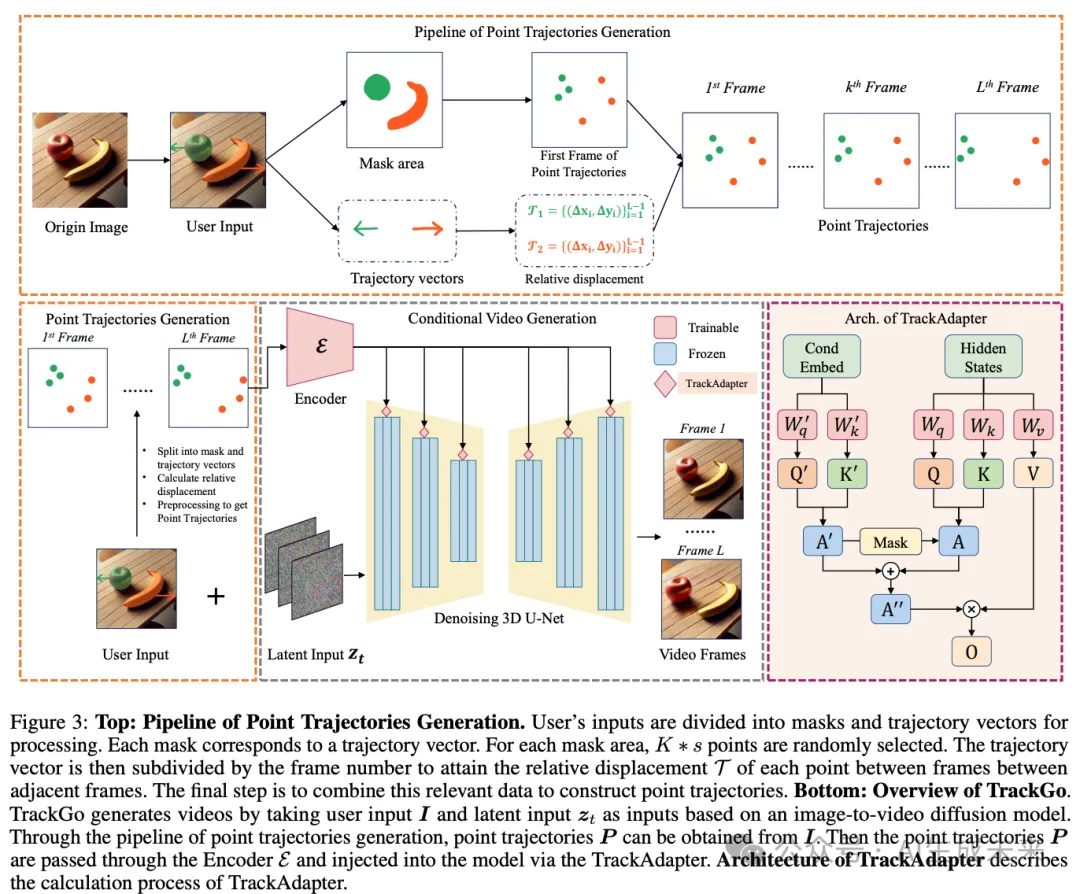

- 点轨迹的优势以及本文如何获取和使用它们。

- TrackAdapter的结构以及它如何帮助SVD理解复杂的运动模式并完成复杂动作的生成。

- 我们模型的训练和推理过程。

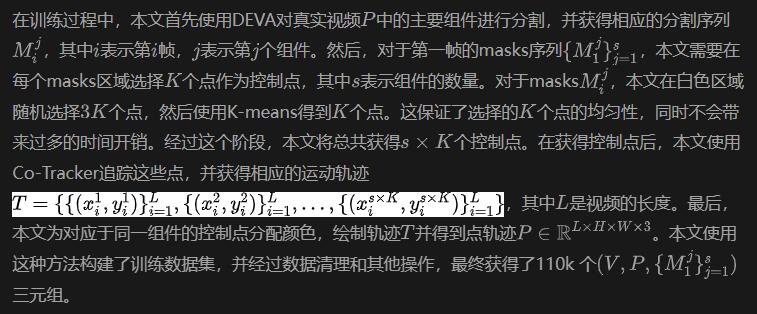

点轨迹生成

在推理过程中,当用户提供第一帧图像、编辑区域的masks以及相应的箭头时,本文的方法可以通过预处理将用户输入的masks和箭头转换为点轨迹,如上图3所示。

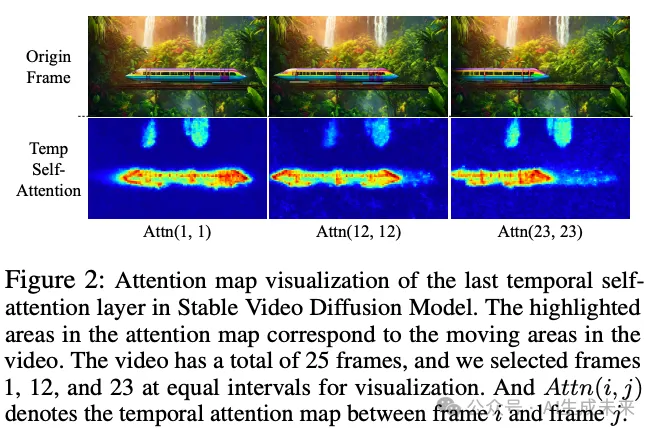

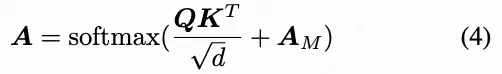

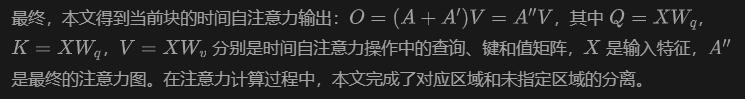

通过 TrackAdapter 注入运动条件

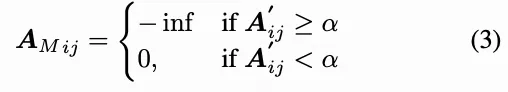

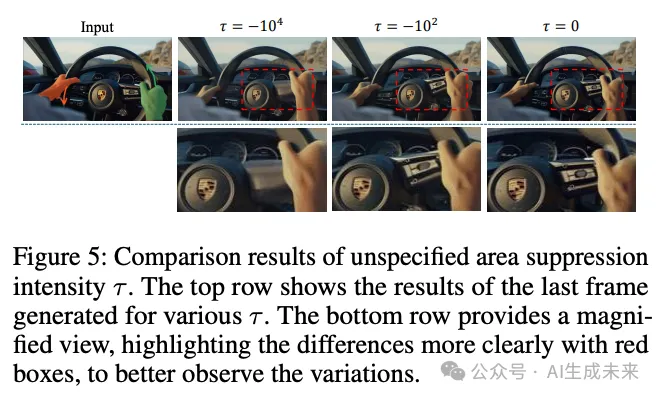

为了避免原始时间自注意力分支对最终活跃区域的影响,本文根据注意力图获得一个注意力 mask ,以抑制由原始时间自注意力分支激活的区域。

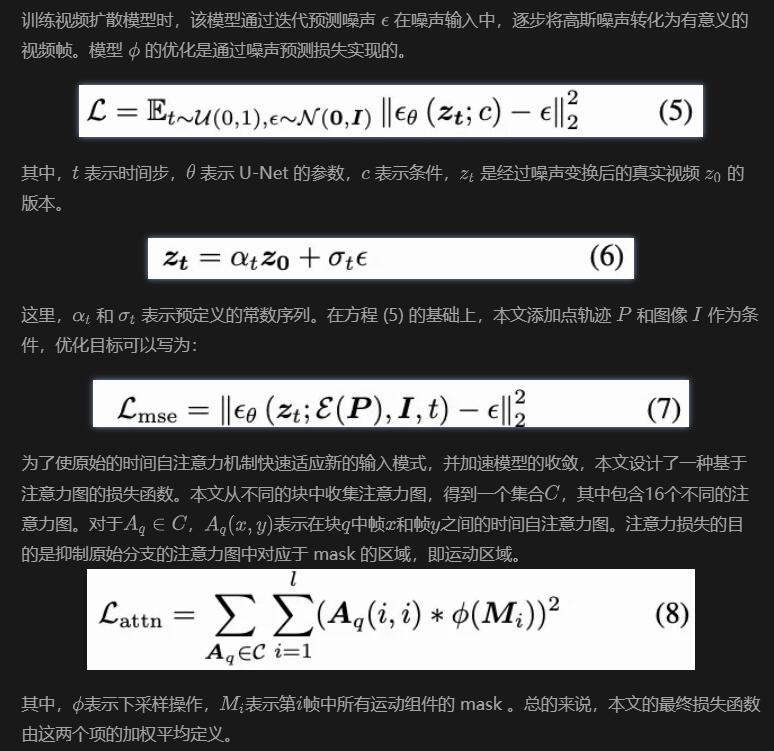

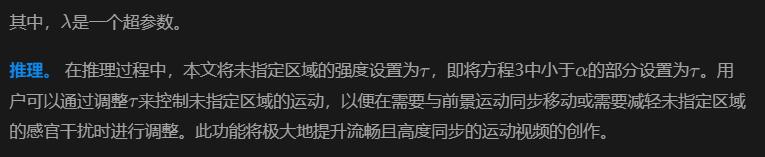

TrackAdapter的训练和推理

Experiment Settings

数据集。 对于本文的实验,本文使用了一个内部数据集,该数据集具有优质的视频质量,包括大约20万段视频。根据实验设计,本文进一步筛选数据,得到约11万段视频作为本文的最终训练数据集。在训练过程中,每个视频被调整为1024 × 576的分辨率,并标准化为每段25帧。

本文的测试集包括VIPSeg验证集以及内部验证数据集中额外的300段视频。值得注意的是,VIPSeg数据集中的所有视频均为16:9的宽高比。为了保持一致性,本文将验证集中的所有视频的分辨率调整为1024 × 576,而不是DragAnything中使用的256 × 256。为了评估,本文从测试集中每个视频的前14帧中提取轨迹。

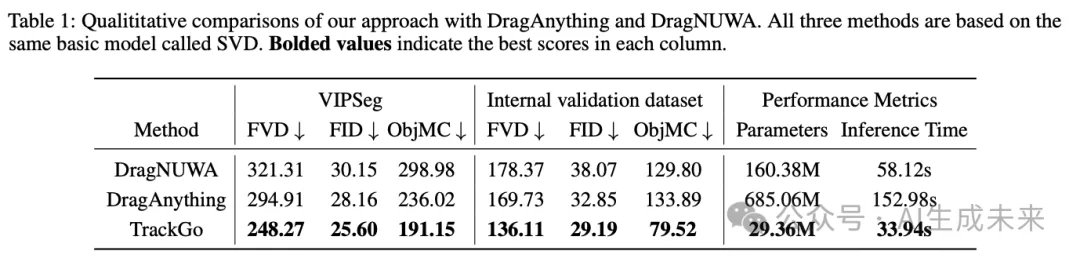

评估指标和基线方法。 本文使用FVD(Frechet Video Distance)来测量视频质量,并使用FID来测量图像质量。本文将本文的方法与DragNUWA和DragAnything进行比较,这些方法也可以使用轨迹信息作为条件输入。根据DragAnything,ObjMC用于通过计算预测轨迹和真实轨迹之间的欧几里得距离来评估运动控制性能。

定量评价

本文的方法与基线方法的定量比较如下表1所示。本文在VIPSeg验证集和内部验证集上测试了所有模型。从结果可以看出,TrackGo在所有指标上都优于其他方法,这表明本文的方法可以生成具有更高视觉质量的视频,并且更加忠实于输入的运动控制。本文还比较了三种方法的模型参数和推理速度。由于这三种方法都使用相同的基础模型,本文的比较专注于新增模块的总权重。为了评估模型的推理速度,本文在NVIDIA A100 GPU上使用相同的输入数据对每种方法进行了100次推理测试。结果表明,本文的方法不仅提供了最佳的视觉质量,还实现了最快的推理速度,同时需要的额外参数最少。

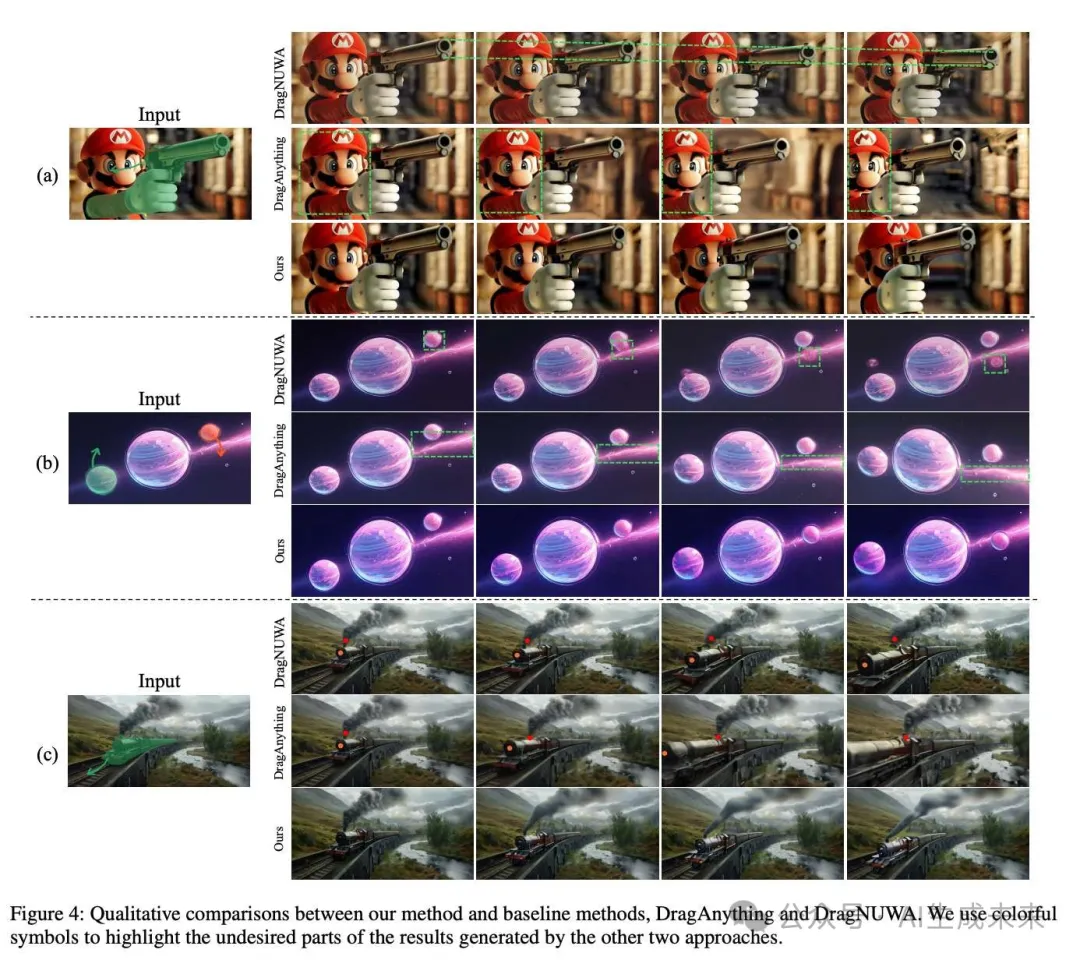

定性评价

可视化。 本文在下图4中展示了与DragAnything和DragNUWA的可视化比较。本文可以做出以下观察:首先,DragNUWA在感知控制区域时存在困难,这可能导致光流不完整或不准确。在案例(b)中,行星未被正确感知,而在案例(a)中,枪的移动也是不正确的。在案例(c)中,虽然成功预测了火车的光流,但烟雾的光流缺失导致了刺眼的视觉效果。其次,DragAnything在处理部分或细粒度物体的移动时也面临困难。如案例(a)所示,只有枪和马里奥的手应该移动,但马里奥的整个位置也意外地移动了。类似的问题也出现在案例(b)中。此外,DragAnything难以生成和谐的背景。在案例(c)中,烟雾没有跟随移动的火车。相比之下,本文提出的TrackGo可以生成视频,使目标区域的移动与用户输入精确对齐,同时保持背景的一致性和和谐性。这一能力显著提高了生成视频的视觉质量和连贯性,展示了TrackGo的有效性。更多本文方法的案例可以在上图1中找到。

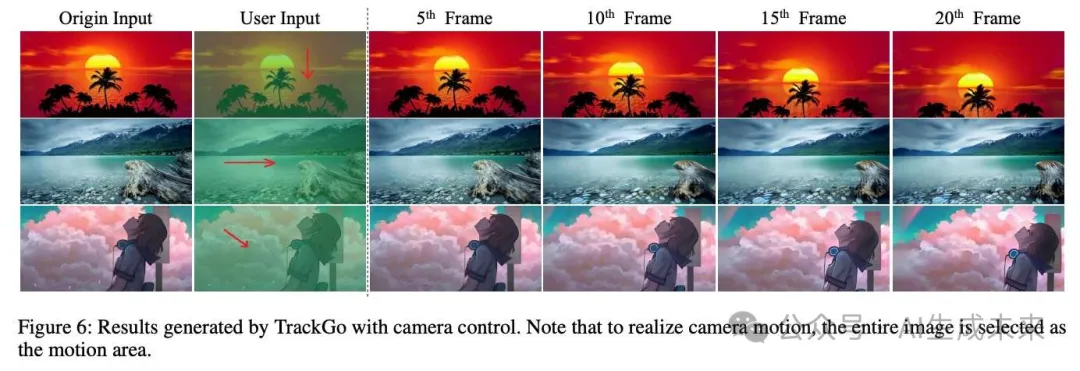

相机运动。 类似于 DragAnything,TrackGo 也能够实现相机运动效果,如下图 6 所示。只需选择整个图像区域作为运动区域,并提供一个运动轨迹,就可以实现相机沿着该轨迹指定方向移动的效果。

消融研究

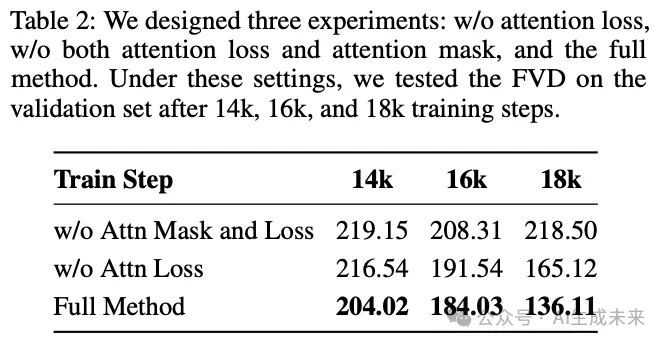

为了验证注意力 mask 和注意力损失的有效性,本文在不同的训练步数下报告了内部验证集上的 FVD 指标,如下表 2 所示。在相同的训练步数下,未使用注意力损失的模型显示出略高的 FVD,与使用注意力损失的模型相比。当不使用注意力损失时,FVD 高于应用注意力损失时的水平。这种差异在 18K 训练步时尤为明显。这表明使用注意力损失可以加速模型训练并有助于收敛。在没有使用注意力 mask 和注意力损失的情况下,FVD 在大约 16K 步时趋于稳定,但仍然显著高于完整设置下的 FVD。

用户研究

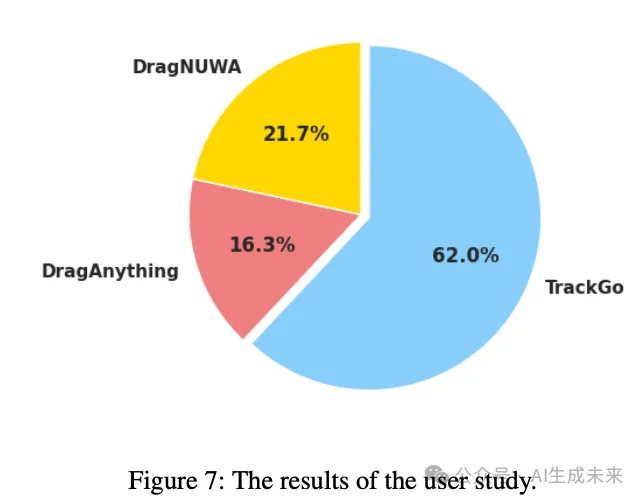

本文进行了一项用户研究来评估合成视频的质量。本文随机抽取了60个案例,并对三种不同的方法进行用户研究。每份问卷包含从这60个案例中随机抽取的30个案例。本文要求用户根据整体质量从两个方面选择最佳视频:生成视频与给定条件之间的一致性,以及生成视频的质量(例如,主体是否失真,未选择的背景是否抖动等)。本文邀请了30人填写问卷,性别比例约为3:1(男性:女性)。大多数参与者是来自不同科学与工程领域的大学生,年龄在18到27岁之间。结果显示,本文的方法获得了62%的投票,高于DragAnything的16.33%和DragNUWA的21.67%,如下图7所示。

结论

在本文中,本文引入了点轨迹来捕捉视频中的复杂时间信息。本文提出了TrackAdapter来处理这些点轨迹,重点关注指定目标的运动,并使用注意力 mask 来减轻原始时间自注意力对指定区域的影响。在推理过程中,注意力 mask 可以调节未指定区域的运动,从而使视频输出更符合用户输入。大量实验表明,本文的TrackGo在FVD、FID和ObjMC评分上达到了SOTA水平。此外,定性分析显示,本文的方法在各种复杂场景中提供了精确的控制。

本文转自 AI生成未来 ,作者:Haitao Zhou等