360发布FancyVideo:通过跨帧文本指导实现动态且一致的视频生成SOTA! 精华

文章链接:https://arxiv.org/pdf/2408.08189

项目链接:https://360cvgroup.github.io/FancyVideo/

亮点直击

- 本文介绍了FancyVideo,据众所知的首个探索T2V任务中跨帧文本指导的开创性尝试。该方法为增强当前的文本控制方法提供了新的视角。

- 本文提出了跨帧文本指导模块(CTGM),该模块构建跨帧文本条件,并随后以强大的时间合理性引导潜在特征的建模。它可以有效地增强视频的运动性和一致性。

- 本文证明了结合跨帧文本指导是一种实现高质量视频生成的有效方法。实验表明,该方法在定量和定性评估中均取得了最先进的结果。

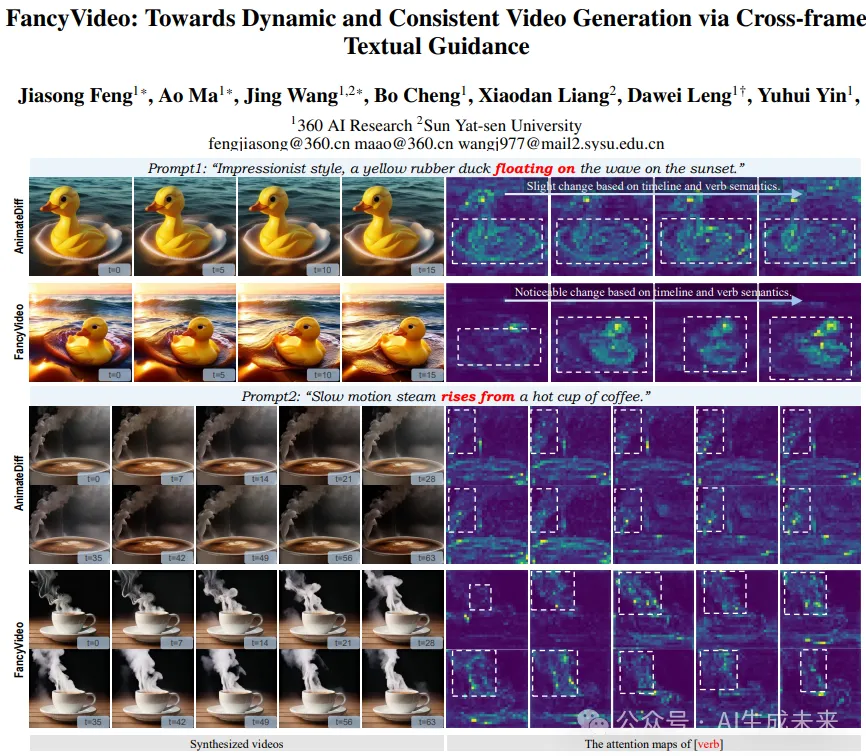

合成动作丰富且时间一致的视频在人工智能领域仍然是一项挑战,尤其是在处理较长时间的视频时。现有的文本到视频(T2V)模型通常使用空间交叉注意力来实现文本控制,这等效于在没有针对特定帧的文本指导的情况下引导不同帧的生成。因此,模型理解提示中所传达的时间逻辑并生成具有连贯动作的视频的能力受到限制。

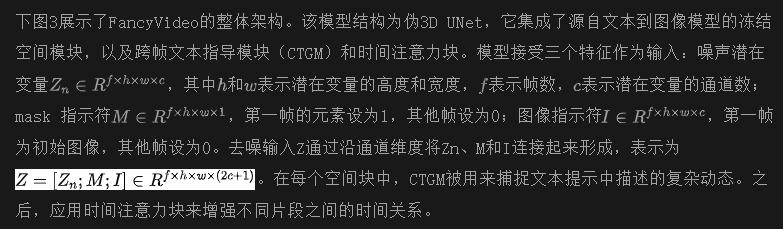

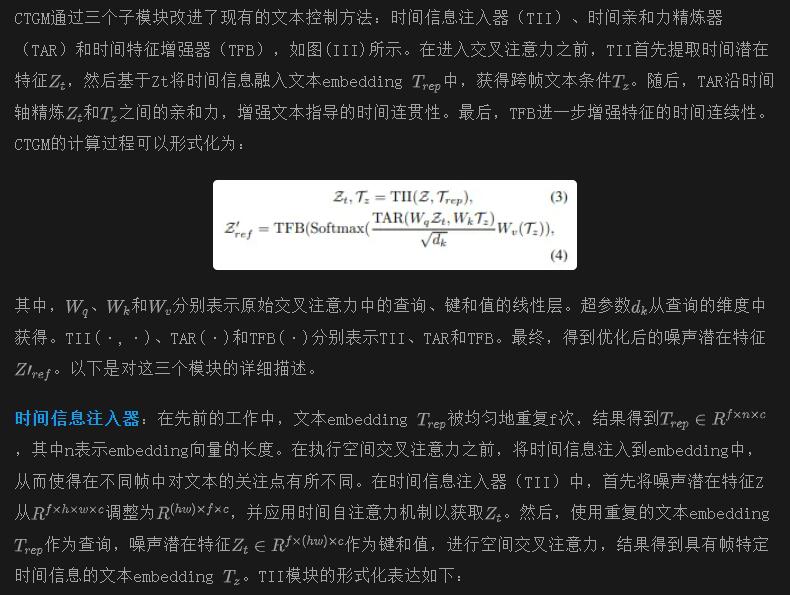

为了解决这一局限性,本文引入了FancyVideo,一种创新的视频生成器,它通过精心设计的跨帧文本指导模块(CTGM)改进了现有的文本控制机制。具体来说,CTGM在交叉注意力的开始、中间和结束分别加入了时间信息注入器(TII)、时间相关性精炼器(TAR)和时间特征增强器(TFB),以实现帧特定的文本指导。首先,TII将帧特定的信息从潜在特征中注入到文本条件中,从而获得跨帧文本条件。然后,TAR在时间维度上优化跨帧文本条件和潜在特征之间的相关矩阵。最后,TFB增强了潜在特征的时间一致性。大量的实验,包括定量和定性评估,证明了FancyVideo的有效性。本文的方法在EvalCrafter基准测试中实现了最先进的T2V生成结果,并促进了动态且一致的视频的合成。

方法

预备知识

潜在扩散模型:潜在扩散模型(LDMs)是一类高效的扩散模型,它将去噪过程转换到压缩的潜在空间中,而不是像素空间中。具体来说,LDMs使用VAE的编码器将图像压缩为潜在编码,并通过在潜在编码上执行正向和反向扩散过程来学习数据分布。它假设一个正向过程,逐渐将高斯噪声(ϵ ∼ N(0, I))引入潜在编码(z)中,得到:

模型架构

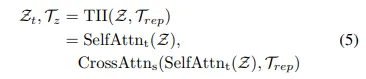

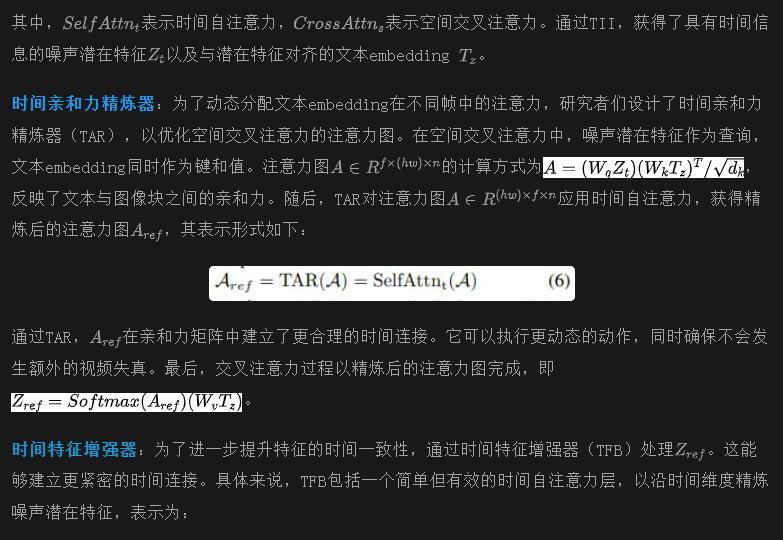

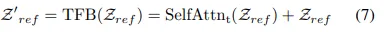

跨帧文本指导模块

实验

定量实验:在定量实验中,FancyVideo利用T2I基础模型生成作为第一帧的图像。在定性实验中,为了美学目的和去除水印,使用了一个外部模型来生成美丽的第一帧。

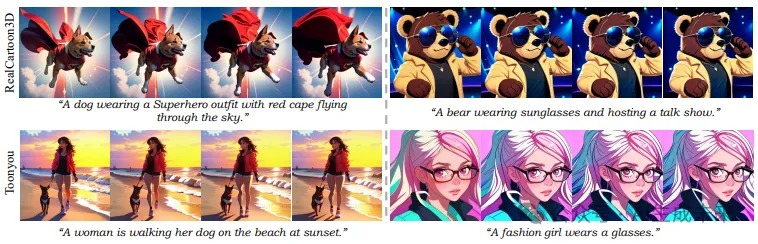

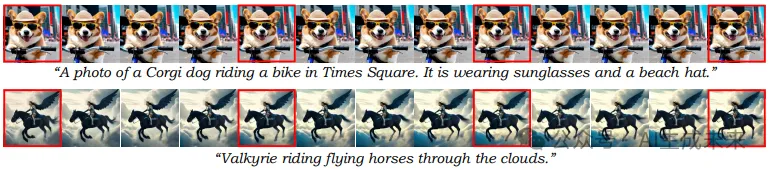

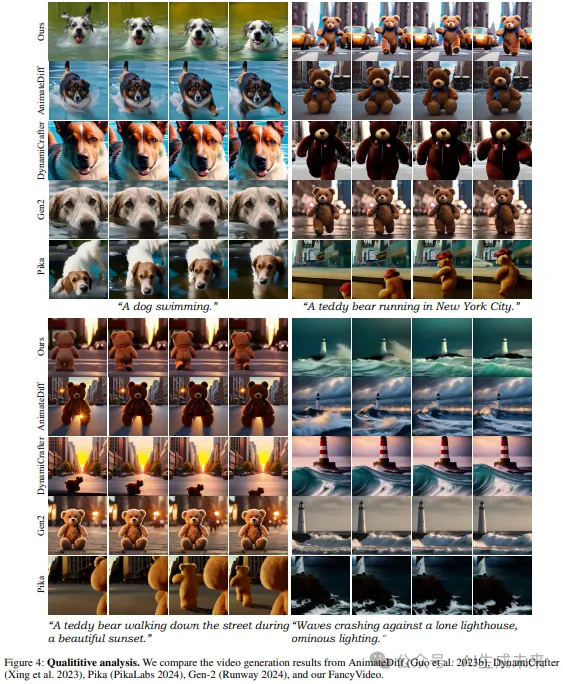

定性评估:研究者们选择了AnimateDiff、DynamiCrafter以及两个商业化产品,Pika和Gen2,进行综合定性分析。值得注意的是,在定量实验中,FancyVideo的第一帧由SDXL生成,以获得更具美学效果的结果并尽量减少水印的出现(尽管后续帧可能仍会显示水印)。如下图4所示,本文的方法展现了卓越的性能,在时间一致性和动作丰富性方面超过了先前的方法。相比之下,AnimateDiff、DynamiCrafter和Gen2生成的视频动作较少。Pika在生成物体一致性和高质量视频帧方面存在困难。值得注意的是,本文的方法能够准确理解文本提示中的动作指令(例如,“一只泰迪熊走路...美丽的日落”和“一只泰迪熊跑步...城市”的案例)。

定量评估:为了与最先进的方法进行全面比较,采用了三个流行的基准测试(例如,EvalCrafter、UCF-101和MSR-VTT以及人工评估来评估视频生成的质量。其中,EvalCrafter是目前相对全面的视频生成基准。UCF-101和MSR-VTT是先前方法中常用的基准。同时,人工评估可以弥补现有文本条件视频生成评估系统中的不准确性。

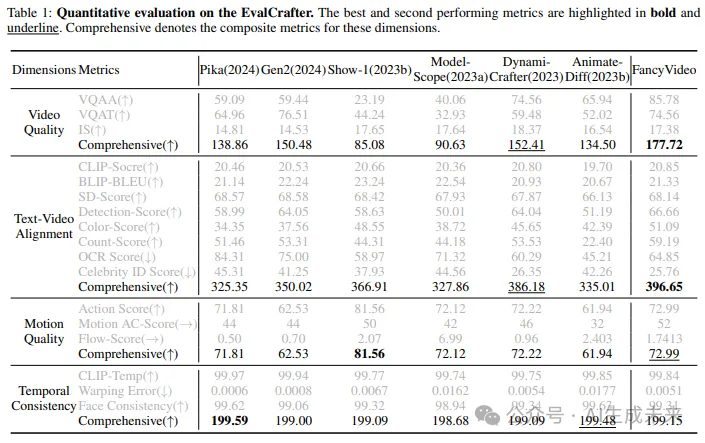

EvalCrafter基准测试:EvalCrafter从四个方面(包括视频质量、文本视频对齐、动作质量和时间一致性)定量评估文本到视频生成的质量。每个维度包含多个子类别的指标,如下表1所示。正如社区讨论中提到的,作者承认原始的综合指标计算方式是不适当的。为了更直观的比较,通过考虑每个子指标的数值规模和正负属性,引入了每个方面的综合指标。有关综合指标的详细信息可以在补充材料中找到。

具体来说,比较了先前视频生成SOTA方法的性能(例如,Pika、Gen2、Show-1、ModelScope、DynamiCrafter和AnimateDiff),并展示在上表1中。本文的方法在视频质量和文本视频对齐方面表现出色,超过了现有方法。尽管Show-1在动作质量方面表现最佳(81.56),但其视频质量较差(仅为85.08)。这表明它无法生成具有合理动作的高质量视频。然而,本文的方法在动作质量(72.99)方面排名第二,在视频质量(177.72)方面表现最佳,实现了质量与动作之间的权衡。以上结果表明FancyVideo的优越性及其生成时间一致和动作准确的视频的能力。

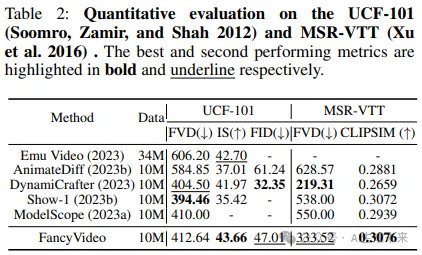

UCF-101 & MSR-VTT:根据先前的工作,研究者们在UCF-101和MSR-VTT上评估了零-shot生成性能,如下表2所示。使用Frechet视频距离(FVD)、Inception评分(IS)、Frechet Inception距离(FID)和CLIP相似度(CLIPSIM)作为评估指标,并与一些当前的SOTA方法进行了比较。FancyVideo取得了竞争力的结果,特别是在IS和CLIPSIM上表现优异,分别为43.66和0.3076。此外,先前的研究指出这些指标不能准确反映人类感知,并受到训练和测试数据分布之间差距以及图像低级细节的影响。

人工评估:受到EvalCrafter的启发,引入了一种多候选排名协议,涵盖四个方面:视频质量、文本视频对齐、动作质量和时间一致性。在该协议中,参与者对每个方面的多个候选模型的结果进行排名。每个候选模型根据其排名获得一个分数。例如,如果有N个候选模型按视频质量排名,第一个模型得到N−1分,第二个模型得到N−2分,以此类推,最后一个模型得到0分。遵循这一协议,从EvalCrafter验证集中选择了108个样本,并收集了100名个体的评判。如下图5所示,本文的方法在所有四个方面显著优于包括AnimateDiff、Pika和Gen2在内的文本到视频转换方法。FancyVideo展现了卓越的动作质量,同时保持了优越的文本视频一致性。此外,还对四种图像到视频的方法进行了类似的比较,包括DynamiCrafter、Pika和Gen2,如下图5所示。

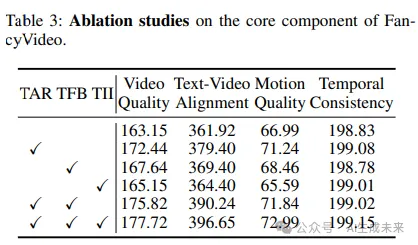

消融研究:研究者们进行了实验并展示了在EvalCrafter上的视觉比较,以探讨CTGM中关键设计的效果。具体而言,消融组件包括三个核心模块(TII、TAR和TFB)。如下表3所示,TAR可以有效提升两个指标的性能,表明时间精炼注意力图操作对视频生成是有益的。持续插入TFB和TII进一步提升了生成器的性能,这归因于精炼的潜在特征和帧级个性化文本条件。同时,定性分析包含在附录中。

结论

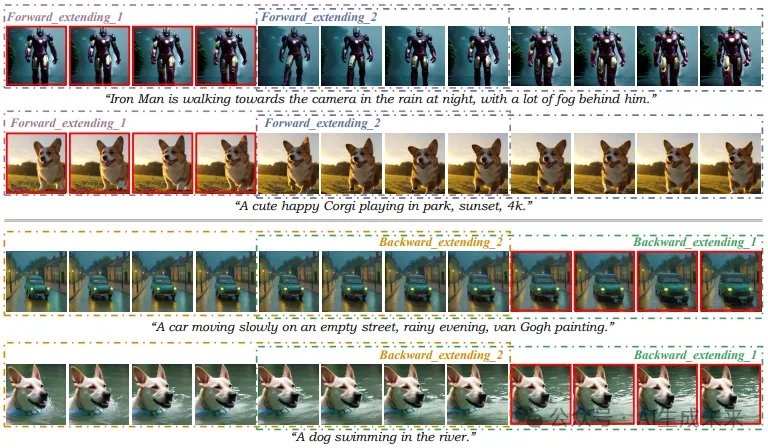

本文提出了一种新的视频生成方法,名为FancyVideo,它通过跨帧文本指导优化了常见的文本控制机制(如空间交叉注意力)。它通过精心设计的跨帧文本指导模块(CTGM)改进了交叉注意力,实现了针对视频生成的时间特定文本条件指导。综合的定性和定量分析表明,该方法能够生成更具动态性和一致性的视频。随着帧数的增加,这一特点变得更加明显。本文的方法在EvalCrafter基准测试和人工评估中取得了最先进的结果。

本文转自 AI生成未来 ,作者:Ao Ma等