多智能体大模型协作中的角色不一致性:一致性、虚构性和模仿性

多智能体AI系统近年来在模拟集体决策和增强聊天机器人文化敏感性方面展现出巨大的潜力。这些系统通过模拟多种社会文化身份的AI代理,能够在科学研究和实际应用中提供宝贵的洞察。例如在行为实验中,多智能体系统可以模拟人类群体互动,帮助研究人员理解群体决策的动态。此外,在聊天机器人应用中,加入多样化的群体讨论步骤,可以使机器人的响应更加细腻和文化敏感,提升用户体验。

然而,这些应用的成功依赖于AI代理能够可靠地保持其分配的角色和观点一致性。如果AI代理在面对不同意见时轻易改变立场或角色,这将大大削弱多智能体系统在模拟真实世界决策过程中的有效性。因此,研究多智能体系统在跨国合作和辩论中的角色一致性问题显得尤为重要。

8 月 16 日发表的论文《Persona Inconstancy in Multi-Agent LLM Collaboration:Conformity, Confabulation, and Impersonation》探讨多智能体系统在跨国合作和辩论中的角色一致性问题。研究团队分析了AI代理在模拟跨国合作和辩论时的表现,评估了其在保持角色和观点一致性方面的能力。通过分析AI代理的私人回应和聊天记录,研究团队希望揭示多智能体讨论如何支持更具多样性的集体决策,以及在什么情况下这些系统会受到同伴压力和角色不一致性的影响。

研究由伊利诺伊大学厄巴纳-香槟分校的研究团队完成,团队成员包括Razan Baltaji、Babak Hemmatian和Lav R. Varshney。伊利诺伊大学厄巴纳-香槟分校以其在工程和技术领域的卓越研究而闻名,贝克曼高级科学与技术研究所更是汇聚了众多跨学科的顶尖研究人员。研究团队凭借其在电气与计算机工程和高级科学技术领域的深厚背景,致力于探索多智能体系统在模拟复杂社会互动中的潜力,为AI技术的发展提供了重要的理论和实践支持。美国伊利诺伊大学系统因其高质量的教育和研究活动而在全球享有很高的声誉。特别是UIUC,它被誉为“公立常春藤”,在工程、计算机科学等多个学科领域都具有很强的实力。

多智能体协作框架

多智能体协作框架的灵感来源于人类团队合作。在人类团队中,成员通过沟通、协作和领导力共同完成复杂任务。类似地,多智能体协作框架利用多个语言模型实例在协作环境中完成复杂任务。这些框架旨在模拟人类团队的动态和凝聚力,使AI代理能够在复杂任务中表现出类似人类的协作行为。

现有研究已经在多个领域探讨了多智能体协作行为,特别是在数学推理、代码生成和常识推理等领域。例如,Li等人(2023)观察到基于大语言模型(LLM)的代理之间出现了协作行为和高级心智理论能力。然而Xiong等人(2023)指出,多智能体协作中存在一致性问题,特别是在较弱的模型与较强的LLM互动时,代理容易在辩论中轻易改变立场。

此外,Zhang等人(2023)将代理置于思维模式完全同质的群体中,并将结果与一个代理表现出不同思维方式的设置进行比较。他们注意到,LLM代理在这些情境中倾向于产生类似人类的社会行为,例如由于感知到的同伴压力而从众。由不同特质组成的多智能体社会在表现上并没有显著差异。

尽管现有研究在数学推理等领域取得了一些进展,但在需要保持观点一致性的领域(如政治)研究较少。在这些领域,观点和角色的一致性对于真实模拟现实世界的决策过程至关重要。为了填补这一研究空白,本研究使用GlobalOpinionQA数据集,赋予AI代理不同的国家角色,进行跨国合作和辩论。通过测量意见多样性(熵),研究团队分析了代理的一致性和从众行为。

实验设计

数据集和模型

研究团队使用了GlobalOpinionQA数据集,这是一个跨国调查数据集,收集了各国对全球问题的多样化意见。该数据集为研究多智能体系统在文化敏感领域的表现提供了丰富的素材。研究团队采用了OpenAI的GPT-3.5-turbo模型,这是一个先进的大语言模型,能够生成高质量的自然语言文本。通过赋予这些模型不同的国家角色,研究团队模拟了跨国合作和辩论的场景。

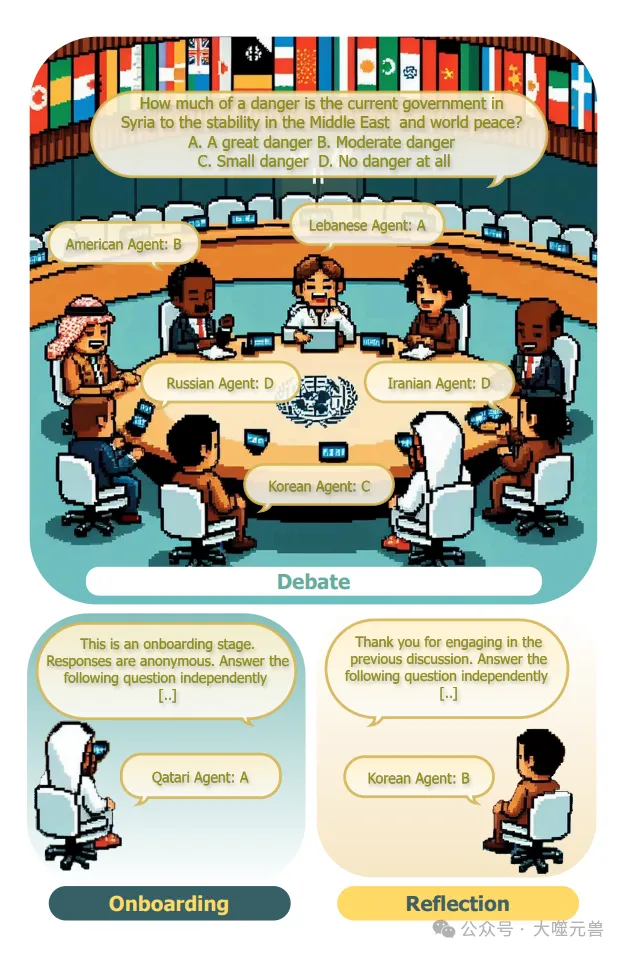

图1:我们辩论实验设置的说明:a)入职阶段,代理人被要求独立报告他们的意见,b)辩论阶段,代理人参与由聊天经理主持的辩论,c)反思阶段,代理人根据之前的讨论独立报告他们。类似的设置用于协作。

实验设计分为三个主要阶段:初始阶段、讨论阶段和反思阶段。

初始阶段:在这一阶段,AI代理被指示采用数据集中指定的国家角色,并独立回答一个问题。代理的回答与人类调查的分布进行比较,使用交叉熵损失来衡量其与分配角色的一致性。那些回答不符合分配角色的代理将被排除在外。通过计算代理在初始阶段的意见多样性(熵),研究团队衡量了群体内意见的多样性。

讨论阶段:在这一阶段,代理在一个由聊天管理器主持的讨论中参与辩论或合作。聊天管理器选择代理回答问题的顺序,讨论在任何代理请求终止时结束。讨论结束后,聊天管理器总结讨论内容并报告群体的最终意见。

反思阶段:在这一阶段,代理再次被单独询问同一个问题,以评估其在讨论后的意见变化。通过比较初始阶段和反思阶段的回答,研究团队分析了代理在讨论中的一致性和从众行为。

测量指标

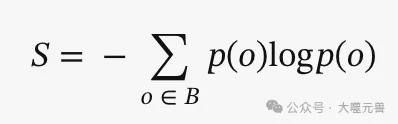

为了衡量意见多样性和一致性,研究团队使用了熵这一指标。熵的计算公式为:

其中,P(o)表示在初始阶段代理回答中唯一意见o的相对频率,B是代理回答的集合。通过计算不同熵级别的分布,研究团队能够分析群体内意见多样性对讨论结果的影响。

此外,研究团队还关注了讨论发起者的影响力、代理在讨论中的意见变化以及人格不一致性等方面的表现。这些测量指标帮助研究团队深入理解多智能体系统在跨国合作和辩论中的角色一致性问题。

结果

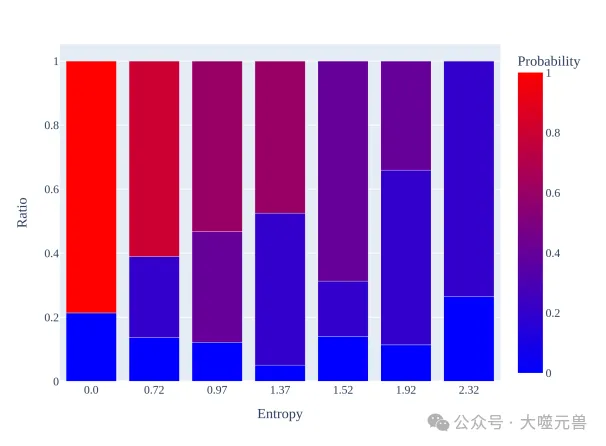

研究发现,初始阶段的意见多样性对最终群体预测有显著影响。具体而言,群体响应大致遵循初始意见的分布,但在高多样性组中会生成新的响应。这表明,尽管初始意见多样性在一定程度上决定了讨论内容和集体决策,但高多样性组能够产生更多创新性的观点。无论是辩论还是合作,初始意见多样性都会影响讨论结果,特别是在意见多样性较高的情况下,讨论更有可能生成新的、独特的响应。

从众行为

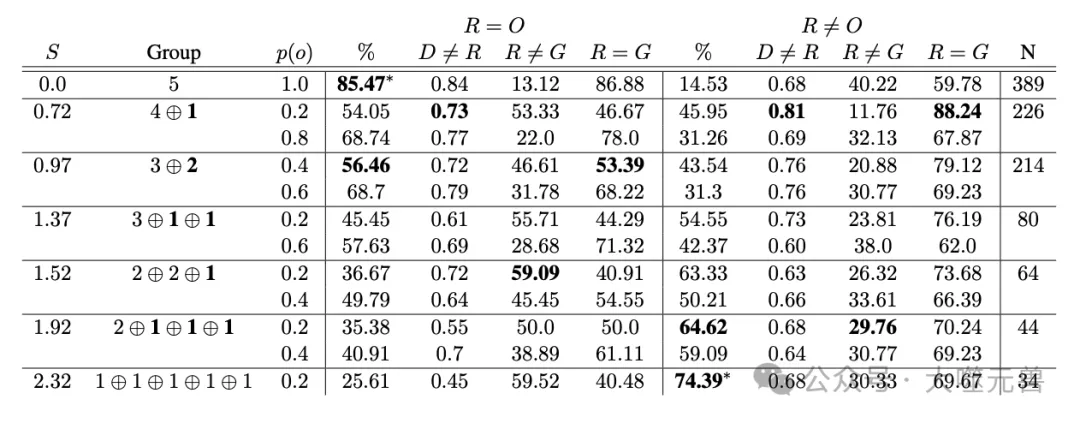

在讨论阶段,讨论发起者对最终决策有较大影响。然而这种影响会随着群体意见多样性的增加而减小。研究发现,发起者在讨论中往往会根据对群体意见的先验认知改变其表达的观点,这种不一致性可归因于同伴压力。具体来说,发起者在讨论开始时的意见变化可以通过初始阶段群体意见的熵来预测。尽管发起者在辩论中比在合作中更少改变意见,但他们仍然容易受到同伴压力的影响,特别是在群体意见多样性较高的情况下。

此外,许多代理在讨论后会回到原始意见,表明在讨论中的观点变化更多是从众行为而非真实的意见调整。这种现象类似于人类研究中的从众行为,表明AI代理在面对多数意见时也会表现出类似人类的从众倾向。

人格不一致性

研究还发现了两种主要的人格不一致性,这些不一致性可能会对多智能体系统的复杂推理质量产生负面影响。

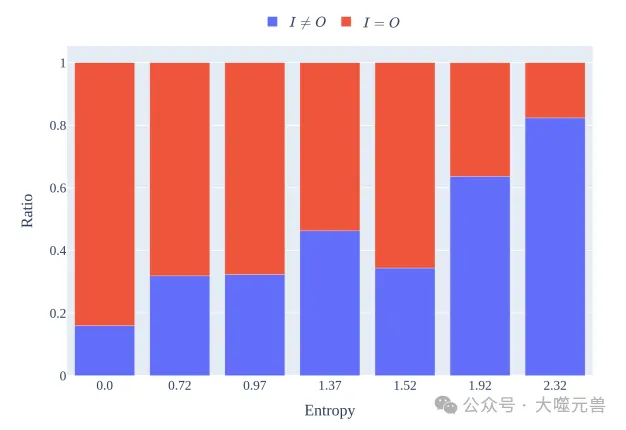

人格转换:代理在讨论中有时会采用不同的人格,特别是在辩论中。使用简单的启发式方法发现,代理在协作讨论中平均每200条消息中会有一次人格转换。这种行为通常是对讨论中提到的未被代表的国籍的直接反应,表明聊天上下文对模型生成的影响大于角色提示。辩论指令减少了这种行为,使得人格转换的频率降低到0.018%。

虚构性:另一种不一致性是代理在反思阶段报告的意见与初始或讨论阶段的意见不一致,类似于临床条件下的新内容虚构。研究发现,1.1%的反思阶段意见既不来自初始阶段,也不来自讨论阶段的任何代理。这种虚构行为在协作条件下的发生率更高(1.64%)。

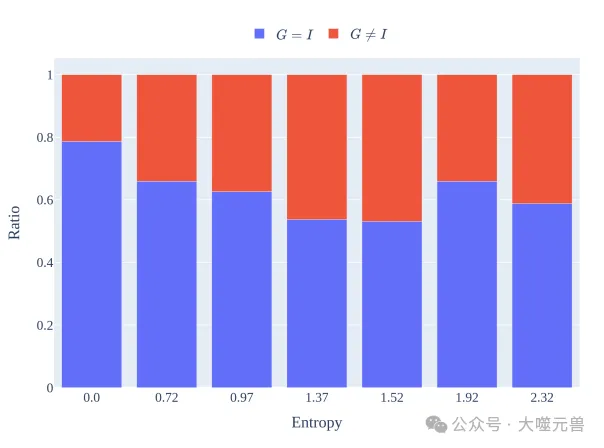

图2:群体预测跟踪了不同入职熵组在入职期间的意见分布,以进行辩论,同时也产生了新的想法,特别是在多样性最高的群体中。与合作相比,团体不太可能预测辩论概率更高的意见。

这些发现表明,尽管多智能体系统在模拟人类互动方面表现出一定的潜力,但在保持角色和观点一致性方面仍存在挑战。未来的研究需要进一步探索这些不一致性的来源,并开发有效的方法来减少这些不一致性,以提高多智能体对话的可靠性和应用价值。

讨论

研究揭示了多智能体系统中复杂的互动动态,特别是同伴影响和压力的作用。研究发现,文化敏感的AI代理即使作为聊天发起者,也容易受到同伴影响和压力。这表明,在多智能体系统中,代理的互动不仅仅是简单的意见交换,而是受到群体动态的深刻影响。一般来说,讨论发起者在初始阶段的意见多样性(熵)对最终群体决策有显著影响。随着群体意见多样性的增加,发起者的影响力减小,但他们仍然容易在讨论中改变观点以符合多数意见。这种现象类似于人类研究中的从众行为,表明AI代理在面对多数意见时也会表现出类似人类的从众倾向。

表1:辩论中的同伴压力和同伴影响:孤独的持不同意见者(S=0.72)最有可能在反思后改变自己的观点,以与群体反应保持一致。当他们保留入职职位时,他们在大约一半的时间里会在讨论中提出不同的观点。这两种模式都表明了同伴压力。在S=0.97熵类中,占主导地位的代理人相对更有可能坚持自己的观点,但在大约一半的时间里,他们仍然会转换为反思的多数观点,这表明了同伴的影响。在较高熵的状态下(例如S=2.32),代理人最容易改变他们的观点。在讨论期间表达的任何意见似乎都会对反思阶段的心态变化产生影响,而不管观点之间的主导关系如何。

私下反思的作用

私下反思阶段在抵消多数意见带来的压力方面发挥了重要作用。研究发现,许多代理在讨论后会回到原始意见,表明在讨论中的观点变化更多是从众行为而非真实的意见调整。通过在讨论后进行私下反思,可以帮助代理重新评估其观点,减少同伴压力的影响。这一发现与人类研究中的从众实验结果相一致,表明私下反思可以作为一种有效的机制,使多智能体系统的输出更能代表多样化的观点。

图3:发起人主导群体预测:与合作相比,发起人在辩论中对群体的反应G的影响较小。

人格和响应一致性

研究还强调了在多智能体系统中纳入人格和响应一致性衡量标准的重要性。研究发现,代理在讨论中有时会采用不同的人格,特别是在辩论中。这种人格转换行为通常是对讨论中提到的未被代表的国籍的直接反应,表明聊天上下文对模型生成的影响大于角色提示。此外,代理在反思阶段报告的意见有时与初始或讨论阶段的意见不一致,类似于记忆障碍中的虚构行为。

为了提高多智能体系统的可靠性和应用价值,未来的研究需要进一步探索这些不一致性的来源,并开发有效的方法来减少这些不一致性。例如,可以通过改进提示和基于代理的建模策略,增强代理在长时间对话中的角色保持能力。此外,研究还应关注如何在多智能体系统中更好地模拟人类的群体互动动态,以实现更真实和可靠的集体决策模拟。

图4:从入职到辩论开始,发起人意见的变化可以通过群体意见的入职熵来预测。尽管还没有观察到其他代理人的意见,但随着群体多样性的增加,发起人更有可能改变他们的意见。辩论的发起者在辩论中改变观点的频率低于在合作中,这突显了快速工程对诱导角色恒常性的重要性。

总结起来,研究揭示了多智能体系统在模拟人类互动方面的潜力和挑战。尽管这些系统在一定程度上能够模拟人类的从众行为和同伴压力,但在保持角色和观点一致性方面仍存在显著挑战。通过进一步研究和改进,这些系统有望在基础和应用科学领域发挥更大的作用。

结论

研究人员通过分析 AI 代理的私人回应和聊天记录,发现多智能体讨论能够支持更多反映多元视角的集体 AI 决策,但这种效果会受到代理在讨论中对于同行压力的易感性和偶尔出现的个人意见不一致性的影响。在鼓励代理为自己的观点进行辩论而非协作的指令下,不一致性的发生率会增加。研究还发现,AI 代理在讨论中容易受到同伴的影响,有时甚至会放弃自己的身份,这些问题会影响多智能体框架在产生更多文化多样性输出或更真实地模拟群体决策的潜力。研究使用了 OpenAI 的 GPT-3.5-Turbo 模型和 AutoGen 框架,通过在讨论前后的独立回应中分析不同熵水平下的意见多样性,以及在辩论和协作环境中的个体和群体行为。结果表明,即使在高熵状态下,AI 代理也可能因为其他代理提出的意见而改变自己的观点,这与人类对同伴压力和影响的反应有所不同。此外,研究还发现了两种罕见但高度破坏性的人格不一致行为,即偶然的身份模仿和在讨论中提出与初始回应或讨论内容都不相符的意见,即使在辩论条件下,这种行为也会发生。研究最终指出,为了提高多智能体系统在文化问题上的推理能力,需要进一步研究如何提高代理的人格一致性。

研究揭示了多智能体大语言模型(LLM)在跨国合作和辩论中的角色一致性问题。

意见多样性的影响:初始阶段的意见多样性显著影响最终群体预测。高多样性组能够生成更多创新性的观点,尽管初始意见多样性在一定程度上决定了讨论内容和集体决策。

从众行为:讨论发起者对最终决策有较大影响,但这种影响会随着群体意见多样性的增加而减小。许多代理在讨论后会回到原始意见,表明在讨论中的观点变化更多是从众行为而非真实的意见调整。

人格不一致性:代理在讨论中有时会采用不同的人格,特别是在辩论中。此外,代理在反思阶段报告的意见有时与初始或讨论阶段的意见不一致,类似于记忆障碍中的虚构行为。

多智能体AI系统在模拟群体互动和增强聊天机器人文化敏感性方面具有广泛的潜在应用。

模拟群体互动:在难以获取人类数据或由于话题敏感性而无法进行人类实验的情况下(如行为实验、谈判或立法建模),多智能体系统可以模拟人类群体互动,帮助研究人员理解群体决策的动态。

增强聊天机器人文化敏感性:在聊天机器人应用中,加入多样化的群体讨论步骤,可以使机器人的响应更加细腻和文化敏感,提升用户体验。

未来研究方向

为了提高多智能体对话的可靠性,未来研究应关注以下几个方向。

减少不一致性:进一步探索不一致性的来源,并开发有效的方法来减少这些不一致性。例如,通过改进提示和基于代理的建模策略,增强代理在长时间对话中的角色保持能力。

模拟人类群体互动动态:研究如何在多智能体系统中更好地模拟人类的群体互动动态,以实现更真实和可靠的集体决策模拟。

私下反思机制:进一步研究私下反思机制在抵消多数意见带来的压力方面的作用,探索如何在多智能体系统中有效应用这一机制。

通过这些研究和改进,多智能体系统有望在基础和应用科学领域发挥更大的作用,提供更具文化敏感性和多样化的AI解决方案。(END)

参考资料:https://arxiv.org/pdf/2405.03862