半监督学习:如何克服数据标签缺乏问题 原创

本文将深入理解半监督学习的概念,探索其原理、应用以及彻底改变人们处理数据密集型机器学习任务的方式的潜力。

所有成功实施的机器学习模型都至少由两个强大的组件支持:数据和模型。一些机器学习工程师表示,他们宁愿把时间花费在模型开发上,也不愿将大量的时间用于数据准备上,其中包括监督学习中的数据标签。当已解决大多数问题时,对大量数据添加标签的难度远远超过最初获取数据的难度。

无标签数据在训练过程中无法达到所需的准确性,而为监督学习的大量数据集添加标签既耗时又昂贵。如果数据添加标签的预算有限怎么办?哪些数据应该首先添加标签?这些只是那些宁愿做有成效的工作的机器学习工程师所面临的令人望而生畏的问题中的一部分。

事实上,在许多领域,标签缺乏是很自然的情况。以下是一些字段的例子,可以观察到数据标签缺乏以及发生这种情况的原因。

研究人员和从业人员已经制定了几种策略来应对数据标签缺乏的挑战:

- 迁移学习和领域适应

- 合成数据生成

- 半监督学习

- 主动学习

在这些方法中,半监督学习作为一种特别有前途的解决方案脱颖而出。这种技术用户允许同时使用少量标签数据和大量无标签数据。通过结合监督学习和无监督学习的优点,半监督学习在保持模型性能的同时,为应对数据标签缺乏的挑战提供了一个潜在的解决方案。

本文将深入理解半监督学习的概念,探索其原理、应用以及彻底改变人们处理数据密集型机器学习任务的方式的潜力。

一、理解半监督学习

半监督学习是一种结合监督学习和无监督学习的机器学习方法,通过训练模型与少量有标签数据和大量无标签数据相结合。这种方法可以用以下的数学方法表示:

- Let DS:(x, y) ~ p(x,y)是一个小型有标签数据集,DU:x ~ p(x)是一个大型的无标签数据集。像往常一样,使用有标签数据进行监督学习,使用无标签数据进行无监督学习。

- 在半监督学习中,使用两个数据集来最小化一个结合监督学习和无监督学习成分的损失函数:L=μsLs+μuLu。

- 该损失函数允许模型同时从有标签数据和无标签数据中学习。值得一提的是,该方法在有标签数据量较大的情况下更加成功。

当获取一组全面的有标签数据成本过于昂贵或不切实际时,半监督学习尤其有用。然而,其有效性取决于这样一个假设,即无标签数据可以为模型训练提供有意义的信息,但情况并非总是如此。

其难点在于平衡使用有标签数据和无标签数据,以及确保模型不会强化无标签数据生成的错误伪标签。

二、半监督学习的核心概念

业界已经引入了一些半监督学习的概念,以下了解最具影响力的几个概念。

置信度和熵

熵最小化的主要思想是确保在有标签数据上训练的分类器对无标签数据也能做出置信度更高的预测(也就是说以最小的熵产生预测)。在这种情况下,熵指的是模型预测的不确定性。熵越小,置信度越高。这种方法已被证明对分类器具有正则化效果。

一个类似的概念是伪标签,在一些文献中也被称为自我训练,其中包括:

(1)要求分类器预测无标签数据的标签。

(2)使用置信度最高的预测样本作为下一次训练迭代的额外真实标签。

这是一种基本类型的半监督学习,应该谨慎应用。如果管理不当,对模型的强化效应可能会潜在地放大初始偏差或错误。

类似方法的其他例子包括:

- 联合训练

- 多视图训练

- Noisy student

这些方法的典型过程通常遵循以下几个阶段:

(1)首先在一部分有标签数据上训练模型。

(2)该模型通过为更大规模的无标签数据预测标签来生成伪标签。

(3)选择置信度最高的标签(具有最小熵)来丰富训练数据集。

(4)使用步骤3的丰富数据集对模型进行重新训练。

这个迭代过程的目的是利用模型不断增长的信心来提高它在有标签数据和无标签数据上的性能。

标签一致性和正则化

这种方法基于这样的想法——如果对样本应用简单的增强,预测不应该改变类。简单的增强是指对输入数据进行微小的修改,例如对图像进行轻微的旋转、裁剪或颜色更改。

然后,该模型在无标签的数据上进行训练,以确保样本与其增强版本之间的预测是一致的。这个概念类似于基于一致性约束的自监督学习方法。

使用这种方法的技术示例包括:

- Pi-Model

- Temporal Ensembling(时序集成)

- Mean Teacher

- FixMatch算法

- 虚拟对抗训练(VAT)

这种方法的主要步骤是:

(1)获取一个无标签数据的样本。

(2)创建所选样本的几个不同视图(增强视图)。

(3)应用分类器并确保这些视图的预测大致相似。

该方法利用了这样一个假设,即输入的微小变化不会显著地改变模型的预测,从而鼓励模型从无标签数据中学习更健壮和可推广的特征。

与专注于最大化预测置信度的置信度和熵方法不同,标签一致性和正则化方法强调跨相似输入的预测的稳定性。这有助于防止对特定数据点的过度拟合,并鼓励模型学习更有意义的表示。

生成模型

半监督学习中的生成模型使用与监督学习中的迁移学习类似的方法,其中在一个任务中学习到的特征可以转移到其他下游任务中。

然而,有一个关键的区别:生成模型能够学习数据分布p(x),从该分布中生成样本,并最终通过改进具有给定目标标签y的给定样本x的p(y|x)建模来增强监督学习。这种方法在半监督学习中特别有用,因为它可以利用大量无标签数据来学习底层数据分布,然后为监督学习任务提供信息。

用于增强半监督学习的最流行的生成模型类型是:

- GAN(生成对抗网络)

- VAE(变分自动编码器)

该过程通常遵循以下步骤:

(1)构造损失函数的生成部分和监督部分。

(2)使用组合损失函数同时训练生成模型和监督模型。

(3)对目标任务使用训练好的监督模型。

在这个过程中,生成模型从有标签数据和无标签数据中学习,帮助捕获数据空间的底层结构。然后,这种学习结构可以为监督模型提供信息,从而可能提高其性能,特别是在有标签数据缺失的情况下。

基于图形的半监督学习

基于图形的半监督学习方法使用图形数据结构将有标签数据和无标签数据表示为节点。这种方法在捕获数据点之间的复杂关系方面特别有效,当数据具有固有的结构或关系属性时非常有用。

在这种方法中,标签通过图形进行传播。从无标签节点到有标签节点的路径数有助于确定其标签。这种方法利用了一个假设——相似的数据点(通过图中的边连接)可能具有相似的标签。

该过程通常遵循以下步骤:

(1)构造一个图形,其中的节点表示数据点(有标签数据和无标签数据)。

(2)通过边连接节点,通常基于数据点之间的相似性度量(例如,k近邻或高斯核)。

(3)使用图形算法(例如标签传播或图神经网络)将标签从有标签节点传播到无标签节点。

(4)根据传播的信息为无标签节点分配标签。

(5)可选地重复该过程以优化无标签节点上的标签。

当处理具有自然图形结构的数据(例如社交网络和引文网络)或当数据点之间的关系对分类至关重要时,这种方法特别有利。然而,性能对图形的构造方法和相似度度量的选择很敏感。这种方法的常用算法包括标签传播、标签扩散以及最近的图形神经网络。

三、研究实例

半监督学习在许多领域取得了重大进展,包括语音识别、网页内容分类和文本文档分析。这些进步不仅提高了标签数据有限的任务的性能,还引入了有效利用无标签数据的新方法。

以下推荐的一些论文代表了半监督学习领域最具影响力和最有趣的贡献。这些论文塑造了人们对这一主题的理解,并继续影响着当前的研究和应用。

半监督学习的时间整合(2017):Laine和Aila

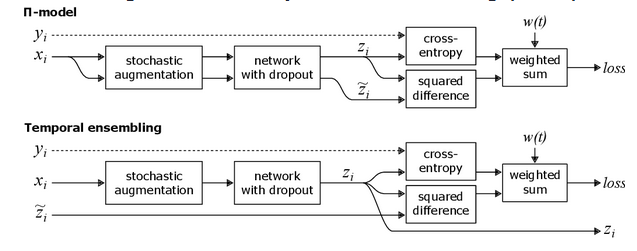

本文介绍了一致性正则化的概念,这是后来许多半监督学习方法的基础。本文作者首先提出了Pi-Model,该模型对每个无标签的输入应用两次随机增强,并鼓励对两个版本进行一致的预测。这种方法利用了模型应该为同一输入的扰动版本产生类似输出的想法。

在Pi-Model的基础上,作者引入了Temporal Ensembling(时序集成)方法。该方法通过降低一致性目标中的噪声,解决了Pi-Model的一个关键局限性。Temporal Ensembling没有比较两个并发过程的预测,而是为每个无标签的示例保持过去预测的指数移动平均值(EMA)。EMA作为一致性损失的更稳定的目标,有效地整合了模型随时间的预测。

Temporal Ensemblin方法在Pi-Model的基础上得到了显著改进,表现出更好的性能和更快的收敛速度。这项工作对该领域产生了重大影响,为半监督学习中许多基于一致性的方法奠定了基础,并展示了如何利用模型自己的预测来改进对无标签数据的学习。

虚拟对抗训练(2018):Miyato等人

虚拟对抗训练(VAT)巧妙地将对抗性攻击的概念应用于半监督学习。这个想法源于众所周知的图像分类中的对抗性示例现象,其中输入图像的微小、难以察觉的扰动可能会极大地改变模型的预测。研究人员通过使用反向传播来最大化模型输出的变化,但相对于输入而不是模型权重,发现了这些扰动。

虚拟对抗训练(VAT)的关键创新是将这种对抗性扰动概念应用于半监督学习设置中的无标签数据。虚拟对抗训练(VAT)不是使用反向传播来寻找改变模型预测的扰动,而是使用它来寻找最显著地改变模型预测分布的扰动。然后对模型进行训练以抵抗这些扰动,即使在输入对抗性的小变化情况下也能鼓励一致的预测。

该方法解决了半监督学习中提高模型鲁棒性和泛化能力的问题。虚拟对抗训练(VAT)的影响是显著的,它展示了如何在半监督学习中有效地使用对抗性技术,并为对抗性鲁棒性和半监督学习的交叉研究开辟了新的途径。它表明,对抗性机器学习的原理可以被重新用于从无标签数据中提取更多信息,从而提高半监督学习的性能。

Mean Teacher (2017):Tarvainen和Valpola

Mean Teacher方法引入了一种简单而有效的方法在半监督学习中创建高质量的一致性目标。其关键创新是使用模型权重的指数移动平均来创建一个“教师”(teacher)模型,该模型为“学生”(student)模型提供了目标。这解决了稳定训练和提高半监督学习性能的问题。

虽然Mean Teacher和Temporal Ensembling都使用EMA,但它们的应用方式不同:

(1)Temporal Ensembling将EMA应用于不同时代的每个数据点的预测。这创建了稳定的目标,但更新缓慢,特别是对于每个示例不经常出现的大型数据集。

(2)另一方面,Mean Teacher将EMA应用于模型自身权重。这创建了一个“教师”模型,它是最近“学生”模型的集合。然后,“教师”模型可以为任何输入生成一致性目标,包括不可见的增强,从而允许更频繁的更新。

这种微妙的差异使Mean Teacher能够更快地适应新数据,并提供更一致的目标,特别是在训练的早期和更大的数据集。它还允许对学生和教师模型使用不同的增强,从而可能捕获更广泛的不变性。

Mean Teacher演示了简单的平均技术可以显著提高半监督学习性能。它激发了对半监督学习中师生模型的进一步研究,并展示了如何扩展和改进Temporal Ensembling的思想。

无监督数据增强(2020):Xie等人

无监督数据增强(UDA)利用先进的数据增强技术在半监督学习中实现一致性正则化。关键的创新是使用了最先进的数据增强方法,特别是在NLP任务中,这些技术的探索较少。

通过“高级数据增强”,作者指的是超越简单扰动的更复杂的转换:

(1)对于图像任务:UDA使用RandAugment,它会自动搜索最优的增强策略。这包括颜色调整、几何变换和各种滤镜的组合。

(2)对于文本任务:UDA引入了使用TF-IDF的回译和单词替换等方法。回译包括将一个句子翻译成另一种语言,然后再翻译回原文,创造一个意译版本。基于TF-IDF.的单词替换将单词与同义词交换,同时保留句子的整体含义。

这些高级增强功能创建了输入数据的更多样化和语义上有意义的变体,帮助模型学习更健壮的表示。UDA解决了在不同领域提高半监督学习性能的问题,特别关注文本分类任务。它的影响是显著的,展示了半监督学习中特定于任务的数据增强的强大功能,并在有标签数据有限的几个基准测试中获得了最先进的结果。

UDA的成功凸显了在半监督学习中精心设计数据增强策略的重要性,特别是在传统增强技术有限的领域。

FixMatch (2020):Sohn等人

FixMatch代表了半监督学习技术的显著简化,同时实现了最先进的性能。关键的创新在于其巧妙地结合了两个主要思想:

(1)一致性正则化:FixMatch对无标签数据使用强增强和弱增强。模型对弱增强数据的预测必须与对强增强数据的预期相匹配。

(2)伪标签:当模型的预测置信度高(高于设定的阈值)时,它只保留弱增强的无标签数据的伪标签。

FixMatch的独特之处在于它对一致性正则化组件使用了极强的增强(如RandAugment),并结合了一种简单的基于阈值的伪标签机制。这种方法允许模型从弱增强图像中生成可靠的伪标签,并从强增强图像中学习鲁棒表示。

FixMatch在有标签数据极其有限的情况下表现出色,有时每个类只使用10个标签示例。它的成功表明,设计良好并且简单的半监督学习算法可以超越更复杂的方法,在该领域树立新的基准,并影响后续在低标签体系下的研究。

Noisy Student (2020):Xie等

Noisy Student为半监督学习引入了一种带有噪声注入的迭代自我训练方法,这是该领域的一个重要里程碑。关键的创新是使用一个大型的EfficientNet模型作为“学生”,在“教师”模型的嘈杂预测上进行训练,并迭代地重复这个过程。

Noisy Student的独特之处在于其开创性的表现:

(1)超越监督学习:它是第一个超越纯监督学习的半监督学习方法,即使在有大量有标签数据可用的情况下也是如此。这一突破挑战了半监督学习仅在低标签数据体系中有用的传统观念。

(2)规模和有效性:该方法表明,通过利用大量无标签的数据(3亿张无标签的图像),它可以改进在所有128万张标签的ImageNet图像上训练的最先进的监督模型。

(3)噪声注入:“噪声”方面涉及在训练期间对“学生”应用数据增强、丢弃和随机深度,这有助于学习更健壮的特征。

Noisy Student在像ImageNet这样具有挑战性的大规模数据集上突破了性能的界限。它表明,即使在具有丰富的有标签数据的场景中,半监督学习技术也是有益的,从而扩展了半监督学习的潜在应用。该方法还激发了对可扩展半监督学习技术及其应用的进一步研究,以改进各个领域的最新模型。

Noisy Student在使用大量有标签数据的情况下,成功地超越了监督学习,标志着研究人员和实践者如何看待半监督学习技术的潜力的范式转变。

半监督学习与深度生成模型(2014):Kingma等人

这篇开创性的论文介绍了一种使用变分自编码器(VAE)进行半监督学习的新方法。关键的创新在于它如何在一个框架内结合生成学习和判别学习。

该方法的核心是组合损失函数,它有两个主要组成部分:

(1)生成组件:这部分损失确保模型学习有效地重构输入数据,捕获底层数据分布p(x)。

(2)判别组件:这部分侧重于分类任务,优化对标记数据的准确预测。

组合损失函数允许模型同时从有标签数据和无标签数据中学习。对于有标签数据,这两个组件都使用。对于无标签数据,只有生成组件是活跃的,但它通过学习更好的表示间接提高了判别性能。

这种方法解决了利用无标签数据来提高分类性能的问题,特别是在标签数据缺失的情况下。它为在半监督学习中使用深度生成模型开辟了新的方向。该方法还展示了生成模型如何改进判别任务,弥合无监督学习和有监督学习之间的差距,并激发了生成建模和半监督学习交叉领域的大量后续研究。

这项工作为半监督学习的许多未来发展奠定了基础,展示了如何有效地利用深度生成模型从无标签数据中提取有用的信息以进行分类任务。

四、应用实例

半监督学习已经在各个领域取得了重大进展,证明了它在处理大量无标签数据方面的多功能性和有效性。以下是一些值得注意的应用:

语音识别

2021年,Meta公司(其前身为Facebook)在一个基础模型上使用半监督学习进行自我训练,该模型训练了100小时有标签的音频和500小时的无标签数据。这种方法将单词错误率降低了33.9%,显示了半监督学习在改进语音识别系统方面的潜力。

网页内容分类

像Google这样的搜索引擎使用半监督学习对网页内容进行分类并提高搜索相关性。该应用程序对于处理庞大且不断增长的网页量至关重要,可以实现更准确和有效的内容分类。

文本文档分类

半监督学习已经被证明在构建文本分类器方面是有效的。例如,韩国延世大学开发的SALnet文本分类器利用LSTM等深度学习神经网络进行情感分析等任务。这展示了半监督学习在自然语言处理任务中管理大型无标签数据集的能力。

医学图像分析

2023年,斯坦福大学的研究人员利用半监督学习技术提高了MRI扫描中脑肿瘤分割的准确性。通过利用一小部分有标签的图像和大量无标签数据,与监督学习相比,他们在肿瘤检测精度方面提高了15%。这个应用程序突出了半监督学习在医学成像中的潜力,在医学成像领域,有标签数据往往稀缺且获取成本高昂,但无标签数据却很多。

结论

半监督学习如今已经成为一种重要的机器学习技术,有效地弥合了大量无标签数据和有标签数据稀缺之间的差距。通过巧妙地结合监督学习和无监督学习方法,半监督学习为数据标记的长期挑战提供了实用而有效的解决方案。本文深入研究了各种半监督学习方法,从基本的一致正则化技术(例如Temporal Ensembling)到尖端的方法(如FixMatch和Noisy Student)。

半监督学习的多功能性在其跨广泛领域(包括语音识别、网页内容分类和文本文档分析)的成功实现中得到了突出的体现。在这个数据生成远远超过标记能力的时代,半监督学习成为机器学习发展的关键技术,使研究人员和从业者能够利用大量无标签数据集的潜力。

展望未来,半监督学习将在人工智能和机器学习领域扮演更重要的角色。尽管挑战依然存在,例如利用极其有限的标签数据增强性能,以及将半监督学习技术应用于更复杂的现实场景,但该领域的快速发展表明将会继续创新。这些发展可能会导致模型训练和数据解释的突破性方法。

半监督学习的核心原则可能会影响并与机器学习的其他新兴领域交叉,包括小样本学习和自监督学习。这种思想的交叉融合有望进一步扩大半监督学习的影响,并有可能重塑人们对从有限的标签数据中学习的理解。

半监督学习不仅代表了一组技术,还代表了人们如何处理从数据中学习这一基本问题的范式转变。随着半监督学习的不断发展,它很可能是释放数字时代特征的大量无标签数据资源的全部潜力的关键。

原文标题:Semi-Supervised Learning: How To Overcome the Lack of Labels,作者:Aleksandr Timashov