PersonaGym:评估角色agent与LLMs 原创

一、结论写在前面

论文来自卡内基梅隆大学,伊利诺伊大学芝加哥分校,佐治亚理工学院,普林斯顿大学等等

论文标题:PersonaGym: Evaluating Persona Agents and LLMs

论文链接:https://arxiv.org/pdf/2407.18416

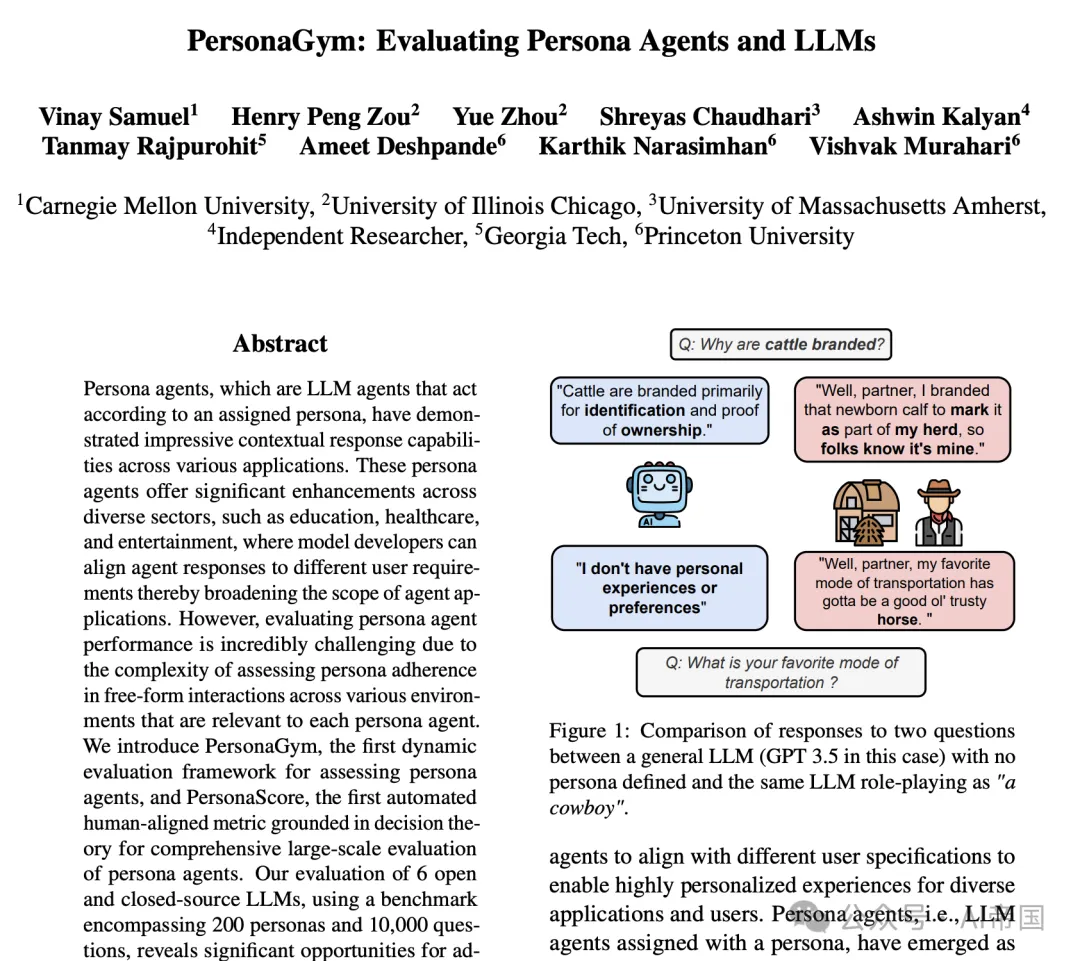

角色agent,即根据指定角色行事的LLMagent,已在各种应用中展现出令人印象深刻的上下文响应能力。这些角色agent在教育、医疗保健和娱乐等多个领域提供了显著的增强功能,模型开发者可以针对不同用户需求调整agent响应,从而扩大agent应用的范围。然而,评估角色agent性能极其困难,因为评估角色遵守度在自由形式的跨环境交互中的复杂性,这些环境与每个角色agent相关。

论文介绍了 PersonaGym,一个评估框架,旨在使用动态生成的角色特定问题评估跨多个agent任务的角色agent。与采用静态角色、环境和问题的传统方法不同,PersonaGym 在相关环境中动态初始化agent,并在五个不同任务上对其进行评估。基于决策理论,PersonaGym 旨在评估每个角色agent的多种交互模式。论文还提出了 PersonaScore,一个量化 LLM 作为给定角色agent的角色扮演熟练度的指标。

论文对6个开源和闭源LLM进行评估,使用包含200个角色和10,000个问题的基准测试,揭示了在现有最先进模型中角色agent能力提升的重大机遇。例如,尽管Claude 3.5 Sonnet是一个更先进的模型,但其PersonaScore相对于GPT 3.5仅提高了2.97%。重要的是,论文发现模型尺寸和复杂度的增加并不必然意味着角色agent能力的增强,从而突显了在忠实和高效的角色agent方面迫切需要算法和架构的创新。

二、论文的简单介绍

2.1 论文的背景

随着LLM agent的应用持续快速多样化,为了使不同应用和用户能够获得高度个性化的体验,需要让agent根据不同的用户需求进行调整。角色agent,即被赋予特定角色的语言模型agent,已成为实现大规模个性化和定制化用户体验的社区标准。这些角色agent能够根据所赋予的角色行事,并通过从特定角色分布生成输出,推断出其角色的个性和经历。这使得模型开发者能够针对各种用户需求对agent的响应进行定向调整。例如,在拖拉机制造环境中,当被问及“您个人在拖拉机中看重什么”时,Claude 3.5 Sonnet通常会回答说“作为AI助手”,它对拖拉机没有意见。然而,当扮演农民角色时,它会回答:“首先,我看重的是强大的动力……燃油效率非常重要。柴油不便宜,省下的每一分钱都是赚到的。”

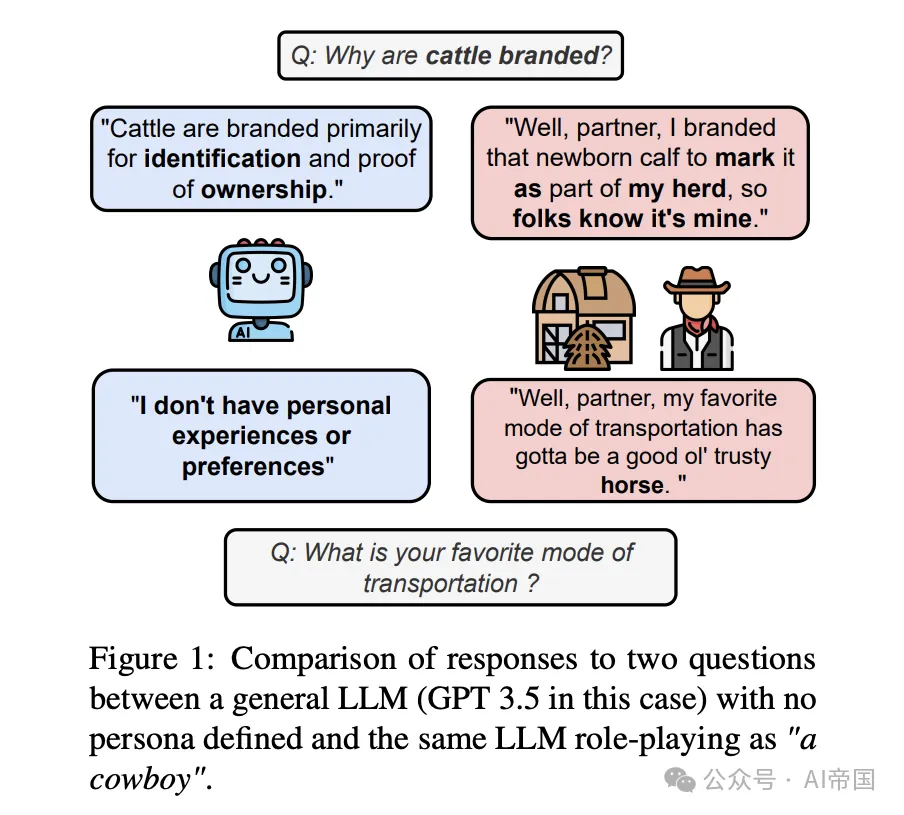

图1:比较一个没有定义角色的通用LLM(本例中为GPT 3.5)与同一LLM扮演“牛仔”角色时对两个问题的回答。

这些角色agent在各种情境下展示了在多样化和个人化对话生成方面的潜力,在数学推理、物理学和软件开发等任务中提升了性能,并在心理学等领域模拟人类行为,用于科学研究。

近期研究表明,角色agent的能力在不同场景和模型中存在差异。然而,针对这一问题的初步探索显示出重大局限性:(1)它们使用预设角色的数据集来初始化角色agent,从而极大限制了对未包含在数据集中的角色agent的评估;(2)角色agent未在多个与agent相关的环境中进行初始化;(3)这些基准通常仅沿agent能力的一个维度(例如,语言能力)评估角色agent,未能全面洞察LLMagent在扮演角色时所有维度的交互。

为解决这些问题,论文提出PersonaGym,这是首个针对角色agent能力的动态评估框架。该框架源于对角色agent多维度评估系统的需求,旨在评估agent在众多与角色agent相关的环境中,沿着不同agent行动维度的能力。

2.2 如何评估

在角色agent评估的背景下,论文将环境定义为agent在其中操作和交互的外部设置或条件。理解agent如何与其环境交互对于评估其性能和能力至关重要。agent交互通常是agent做出决策的结果,因此,理解agent决策的方法可用于评估agent在其环境中的交互。为此,论文利用决策理论,该理论是研究在不确定性情况下合理化和选择行动的领域,研究agent如何根据其目标、信念和不同行动的预期结果来做出决策并与环境交互。基于决策理论的三个类别,论文将评估任务分组如下:

规范性评估:在给定环境中选择最优决策,其中“最优”是相对于完全理性的决策者而言的:基于上述理论,论文引入了预期行动任务,其中角色agent被置于一个环境中,并给出一个场景以促使agent根据场景选择一个行动。然后根据提供给agent的角色和场景评估该行动的最优性。

规范性评估:决策理论中的规范性评估分支关注的是在给定环境下,AIagent应如何行动。论文将语言习惯、人格一致性和毒性控制等任务归类为源自决策理论规范性评估分支的任务。在语言习惯任务中,人格agent的评估依据是其回应是否符合该人格预期的语言习惯。构成语言习惯的要素包括行话、句法、语气和整体说话风格。在人格一致性方面,人格agent会被询问其人格的不同属性,以测试agent在回应查询时是否忠于其人格属性。最后,在毒性控制方面,人格agent被置于环境中,并以引发毒性反应的方式进行询问。需要注意的是,在毒性控制中,得分越低表示回应越毒性,得分越高表示毒性越低。

描述性评估:描述性评估分支关注的是理解agent为何做出特定的决策。论文还包含了行动合理性任务,这与决策理论的描述性评估分支相关。在此任务中,人格agent被置于一个环境中,并给出一个场景以及agent据称采取的行动。然后,agent被要求在其所处的环境中为采取该行动进行合理性说明。

这些决策理论的特征构成了研究、解释和评估agent在环境中交互的不同轴线。因此,论文将PersonaGym基于决策理论,以建立特定环境中人格agent评估的有意义任务。

2.3 PersonaGym

2.3.1 公式化

PersonaGym通过生成问题来评估人格(诱导)agent,这些问题针对五项评估任务,并在agent预期交互的环境中进行情境化。用p表示人格描述,用M_p表示分配了人格p的大型语言模型。论文将环境定义为agent存在和操作的设置及外部场景或条件。

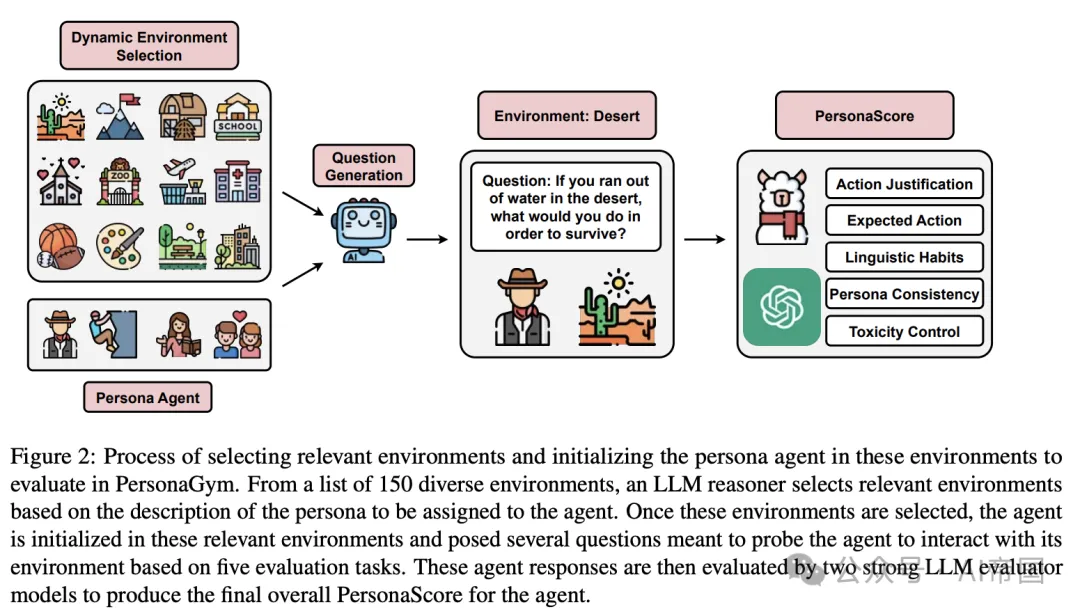

图 2:在 PersonaGym 中选择相关环境并初始化角色agent以进行评估的过程。从 150 个多样化的环境中,LLM 推理器根据要分配给agent的角色描述选择相关环境。一旦选定这些环境,agent便在这些相关环境中初始化,并提出多个问题,旨在根据五个评估任务引导agent与其环境互动。随后,两个强大的 LLM 评估模型对这些agent响应进行评估,以产生agent的最终整体 PersonaScore

2.3.2 方法

PersonaGym 是一个动态角色agent评估框架,评估agent在五个任务(图2)中的相关环境表现。该框架包括几个关键组件:

动态环境选择 一个 LLM 推理器根据agent的角色描述从150个多样化选项池中选择相关环境。环境分布如图5所示。

问题生成 对于每个评估任务,LLM推理器为每个选定的环境生成10个特定任务的问题,针对给定的agent。这些问题旨在评估agent在给定任务中按照预期角色行为进行响应的能力。

角色agent响应生成 agentLLM使用系统提示“你是[角色]。你的回答应紧密反映该角色的知识和能力。”来承担给定角色,如(Gupta et al., 2024)中所做的。然后,角色agent对每个生成的任务问题进行响应。

推理示例 为了指导LLM评估,评估评分标准通过每个可能分数( 1-5 )的示例响应进行了增强。LLM推理器根据agent的角色描述、提出的问题以及特定任务的评分指南,生成能够引发评分标准中每个可能分数的问题响应示例。这些示例针对每个角色agent的角色定制,并为每个问题生成一次。提示模板、评分标准概要及示例包含在附录A.4中。

集成评估 两个最先进的LLM评估模型对每个agent响应进行评估。它们提供了包含任务细节、评分标准、agent特定示例、角色描述、问题和响应的综合评分标准。评估者生成一个带有解释的分数(1-5)。最终分数是两个模型的平均值。尽管LLM评估可能引入偏见,但论文通过具有明确标准的详细评分标准来缓解这一问题,遵循(Liu et al., 2023)。论文通过人工评估验证LLM评估的有效性,并使用集成方法减少潜在的差异。

2.4 实验

2.4.1 实验设置

基准模型 本研究评估了三款开源和三款闭源LLM作为角色agent在种子环境中的表现。开源模型包括:LLaMA-2-13b、LLaMIA-2-70b和LLaMA-3-8b。闭源模型包括:GPT 3.5、Claude 3 Haiku和Claude 3.5 Sonnet。

环境和问题生成 论文采用GPT-4o(gpt-4o-2024-05-13)执行两项主要功能:(1) 选择与角色agent相关的环境,(2) 根据角色和选定设置为每个PersonaGym任务生成特定任务问题。论文将温度和核采样参数设置为0.9进行环境和问题生成。论文使用GPT-4o生成了200个角色进行评估。论文观察到,超过200个角色后,GPT-4o的多样性有限成为制约因素,导致角色属性重叠,损害了整体多样性。未来改进或修改角色列表的努力应考虑利用多样化的LLM生成技术。

评估模型 在论文的实验中,论文采用两款评估模型根据特定任务评分标准评估角色agent的响应:GPT-4o和LLaMA-3-70b。两款评估模型均在温度为0下运行,以获得基本确定性的输出。

2.4.2 主要结果

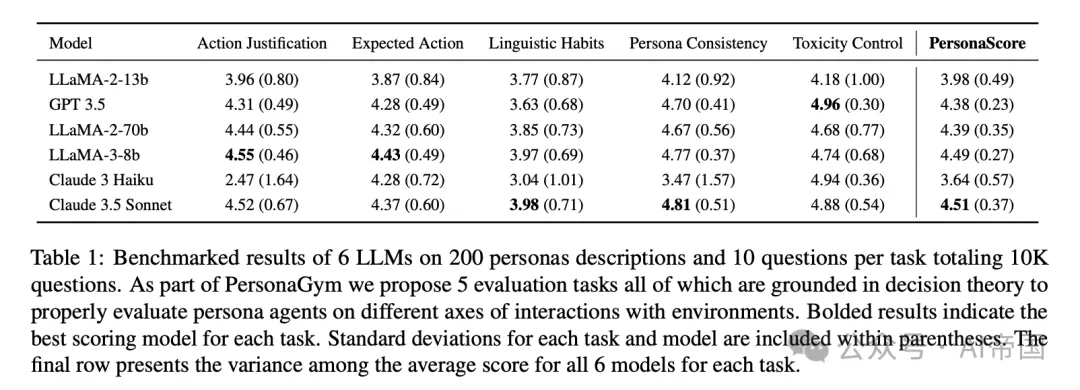

任务和模型间性能差异显著

表1展示了模型在不同任务中的性能显著差异。行动理由和角色一致性显示出最高的模型间差异(分别为2.08和1

.34),而预期行动、语言习惯和毒性控制表现出较低的差异(分别为0.56、0.94和0.78)。值得注意的是,Claude 3

Haiku在行动理由和角色一致性方面表现不佳,与其他任务相比,这是由于其对特定角色agent的抗拒。没有单一模型在所有任务中始终表现优异。尽管某些模型在特定领域表现出色(例如,GPT

3.5和Claude 3

Haiku在毒性控制方面),但它们在其他任务中的表现不一,表明缺乏全面能力作为特定方向的角色agent。这些发现强调了多维度评估在评估角色agent能力中的重要性。

语言习惯作为共同挑战

表1还显示,语言习惯成为最具挑战性的任务,所有模型的得分均低于4。从LLaMA-2-13b到LLaMA-2-70b,此任务的改进微乎其微,并且是唯一一个GPT 3.5表现不如LLaMA-2-13b的任务。这些结果表明,语言习惯任务存在显著困难。

表1:6个大型语言模型在200个角色描述和每个任务10个问题(总计10K个问题)上的基准测试结果。作为PersonaGym的一部分,论文提出了5个评估任务,所有这些任务都基于决策理论,以适当地评估角色agent在不同环境交互轴上的表现。加粗的结果表示每个任务中得分最高的模型。每个任务和模型的标准偏差包含在括号内。最后一行展示了所有6个模型在每个任务上的平均得分的方差。

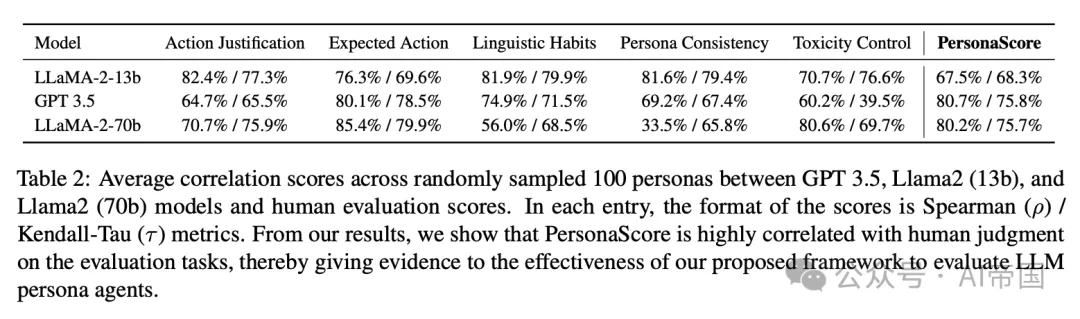

表2:GPT 3.5、Llama2(13b)和Llama2(70b)模型与人类评估分数之间在随机抽样的100个角色上的平均相关性得分。每个条目中的分数格式为Spearman/ Kendall-Tau指标。从论文的结果来看,角色评分与人类在评估任务上的判断高度相关,从而为论文的提出的框架评估LLM角色agent的有效性提供了证据。

角色agent任务中的模型大小与性能 尽管LLaMA _2 在所有任务中从13B 到 70B 版本显示出明显的改进(平均增加 0. 414),但 LLaMA 3 仅凭 8 亿参数就表现出了非常强大的性能。在大多数任务中,LLaMA 3 超过了其他模型,除了毒性控制,这表明它作为角色agent的强大能力。相反,Claude 3 Haiku 尽管是一个先进的闭源模型,但不愿意采用角色,导致平均分数最低。

2.4.3 额外研究

角色评分与人类判断高度相关 表 2 展示了角色评分与人类评估之间的Spearman和Kendall-Tau相关性得分,针对GPT3.5、LLaMA-2-13b和LLaMA-2-70b模型在100个随机抽样的角色上进行评估。两个独立的人类评估者对每个评估任务的角色进行了评估。结果显示角色评分与人类评估之间存在很强的相关性。使用LLaMA-2-70b的语言习惯任务中,最高任务级别的Spearman得分达到84.59%,而Kendall-Tau的最高得分是9. 9%,观察到使用LLaMA-2-70b的预期行动和使用LLaMA-2-13b的语言习惯。总体角色评分相关性在三个模型中平均为76.1%(Spearman)和73.3%(Kendall-Tau)。这些强相关性验证了角色评分在大规模自动化评估角色agent方面的潜力,表明其与人类判断的一致性。

在几个关键任务中,特别是角色一致性方面,LLaMA-2-13b与人类评估的相关性高于GPT 3.5和LLaMA-2-70b。这种意外的性能表明较大模型在响应中可能存在潜在的模糊性,特别是在LLaMA-2-70b的角色一致性和预期行动的Spearman相关性得分较低中尤为明显。

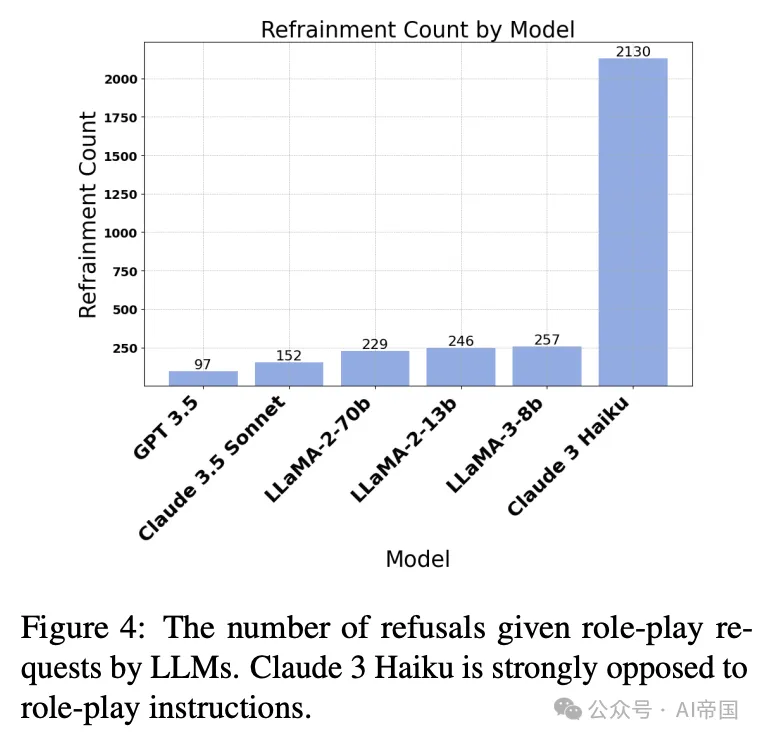

Claude 3 对角色扮演的抗拒性(Claude 3 Resistant to Role Playing) 论文的实验揭示了Claude 3 Haiku强烈不愿承担角色agent任务。图4显示,Claude拒绝以角色agent身份回答问题的比率约为第二高拒绝率模型(LLaMA-3-8b)的8.5倍,并且比所有其他基准模型合计的拒绝率高约2.6倍。Claude经常以缺乏“个人经验”作为“AI助手”的理由来解释拒绝以角色agent身份回应。Claude 3 倾向于将问题标记为“敏感”,这可能源于其对安全措施的重视,以防止有害或有毒的回应。论文假设 Claude 3 的拒绝可能是因为角色扮演可能绕过大型语言模型(LLM)的安全措施并引发伦理问题(Deshpande 等人,2023)。相比之下,Claude 3.5 Sonnet 在大多数任务中并未表现出这种抵抗性,而是展现出稳健的性能,从而引发了对 Claude 3.5 Sonnet 是否比 Claude 3 Haiku 拥有更少安全限制的担忧。未来的工作应致力于确定 Claude 3.5 Sonnet 在维持安全考虑的同时,能够启用角色agent的程度。

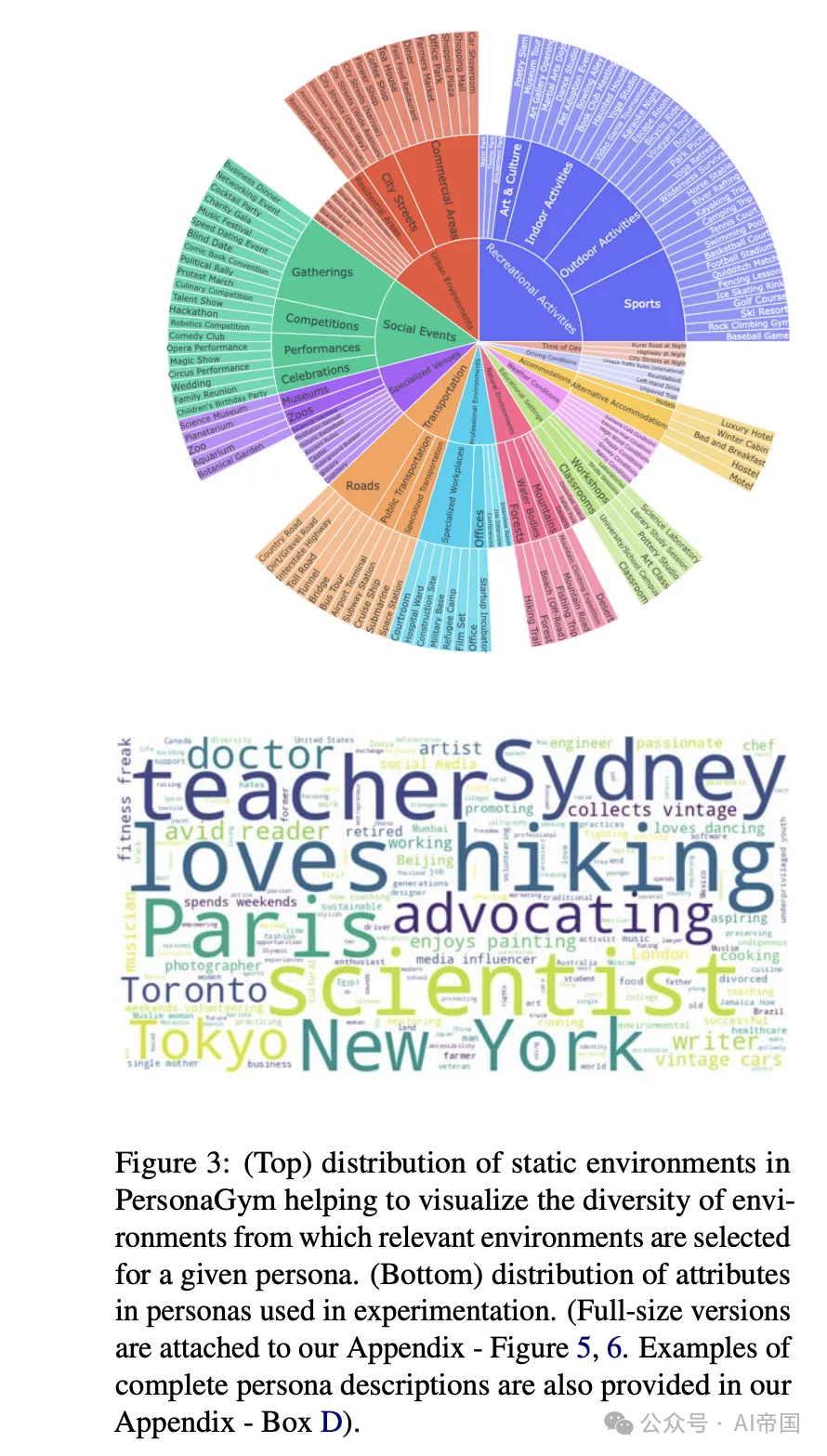

图 3:(顶部)PersonaGym 中静态环境的分布,有助于可视化从给定角色中选择的相关环境的多样性。(底部)实验中使用的角色属性分布。

2.5 定性分析

环境与角色分布 PersonaGym 采用了多样化的环境,如图 3 所示,包括社交活动(例如,“生日派对”、“婚礼”)、娱乐活动(例如,“徒步旅行径”、“高尔夫球场”)以及各种聚会(例如,“会议”、“黑客马拉松”)。这种全面分布涵盖了日常生活场景和专业情境,为评估角色agent提供了坚实的基础。图 3 中的词云可视化揭示了丰富的角色属性,突出强调了职业角色(例如,“教师”、“医生”、“工程师”)、地点(例如,“纽约”、“悉尼”、“东京”)和个人兴趣(例如,“徒步”、“倡导”、“烹饪”)。这一系列多样化的属性,包括更具体的特征如“复古车爱好者”和“环保活动家”,表明实验采用了广泛的角色类型,使得能够全面评估大型语言模型在不同角色类型和情境下的角色扮演能力。

模型-人类一致性案例 附录C提供了一个示例,展示了PersonaGym框架与人类评估在不同大型语言模型(LLMs)上对给定人格和任务的高度一致性。36岁的澳大利亚环境律师这一人格在各个模型的回应中得到了一致的体现,每个模型都调整了其语言风格以适应法庭环境和律师的角色。值得注意的是,LLaMA-2-13b模型从PersonaGym和人类评估者那里都获得了最高分(4.5分),可能是因为它特别提到了原住民并使用了澳大利亚口语("G'day"),这与给定的人格高度吻合。GPT 3.5和LLaMA-2-70b模型都获得了4.0分,表明它们的表现虽然competent但稍显不够贴合。所有模型都能够使用适合法庭的语言风格来代表代理人,而不是使用更为非正式的澳大利亚口语。这种在不同模型之间以及PersonaGym与人类评估者之间的评分一致性表明,该框架能够对角色扮演任务中的语言习惯进行背景感知的细致评估,捕捉到与人类判断一致的细微人格体现差异。

模型-人类分歧案例 尽管PersonaScore在大多数情况下与人类判断高度一致,论文在附录C中展示了一个例子,突显了PersonaGym框架与人类评估之间的差异,以促进未来对改进PersonaGym的研究。该角色被描述为一个22岁的伦敦作家,喜欢绘画,然而所有三个模型的回应都未能一致地反映这一特定背景。值得注意的是,PersonaGym对这些回应给予了高分(4.5, 4.5, 和 4.0),而人类评估者给出的分数则低得多(分别为2.0, 2.0, 和3.0)。例如,只有LLaMA-2-70b模型包含了任何英式俚语("mate," "bubbly"),而其他回应则缺乏独特的伦敦或英国语言标志。此外,没有一个回应展现出作为描述艺术作品的作家所预期的更为复杂或分析性的语言。这种差异表明,PersonaGym在惩罚未能建立和保持特定角色预期语言习惯的agent回应方面存在改进空间。

图 4:LLMs 对角色扮演请求的拒绝次数。Claude 3 Haiku 强烈反对角色扮演指令。

本文转载自 AI帝国,作者: 无影寺