苹果发布新基准,重新定义大模型强弱! 原创

现在的大模型基准评测,苹果要重新定义了!

近日,苹果公司的研究人员推出了ToolSandbox,这是一种全新的基准,旨在比以往更全面地评估人工智能助手的实际能力。这项研究发表在 arXiv 上,解决了使用外部工具完成任务的大型语言模型 (LLM) 的现有评估方法中的关键缺陷。

01、现有评估基准有哪些关键缺陷?

现在大模型评估基准,更多还是从大模型本身的基本功出发,诸如多语言理解、问答推理、数学逻辑等“文理科考试”,像MMLU、GSM8K、ARC、HumanEval、Math、BBH,这些都是大模型的通用能力的基准测试,除此之外,还有行业能力的基准测试,比如FinEval、PubMedQA、JEC-QA等。

但这些数据集存在一个很大的问题,即评估方式非常“自嗨”,忽略了现在AI产品/应用,已经不能单单靠大模型来完成了,大模型还需要具备调用大量的外在工具才能完成真正的应用。

像智能体这样的应用,需要大模型去按照用户预定义的本体去完成复杂的任务,就需要调用N多工具。

难点就在于,用户表述问题的方式虽然变得更加简化,但面向任务的对话仍然具有状态性、会话性和交互性,这为系统且准确地评估使用工具的大型语言模型带来了重大挑战

应用方面,当然也有。智能客服、数据分析、办公助手、代码助手、智能代理等方面,则有测评数据集GAIA、APPS、AgentBench等。

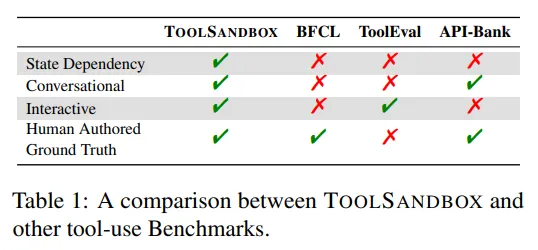

TOOLSANDBOX 提供了一个有状态的、对话式的和交互式的评估基准,用于评估大型语言模型(LLM)的工具使用能力。通过有状态和状态依赖的工具、模拟的用户以及具有里程碑和雷区的灵活评估方式,它展示了开源模型和专有模型之间显著的性能差距,并揭示了即使是对于最先进的模型(包括状态依赖、规范化和信息不足等场景)也极具挑战性的情况,为理解工具使用能力带来了新的见解。

ToolSandbox 包含其他基准测试中经常缺少的三个关键元素:状态交互、对话能力和动态评估。主要作者 Jiarui Lu 解释说:“ToolSandbox 包括状态工具执行、工具之间的隐式状态依赖关系、支持策略对话评估和动态评估策略的内置用户模拟器。”

这项新基准旨在更贴近真实场景。例如,它可以测试人工智能助手是否理解在发送短信之前需要启用设备的蜂窝服务——这项任务需要推理系统的当前状态并做出适当的更改。

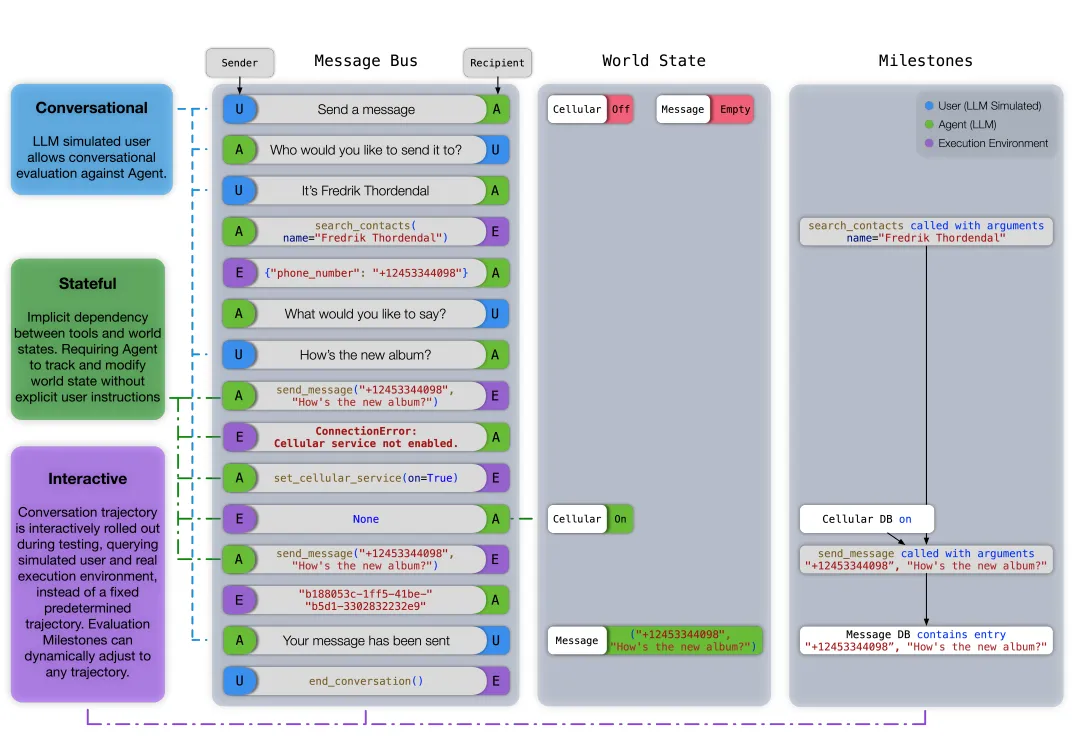

TOOLSANDBOX评估轨迹示例

那么,TOOLSANDBOX究竟是怎么评估的呢?不妨来看论文中的示例。可以看出评估轨迹分为消息总线(Message Bus)、世界状态(World State)、里程碑(Milestones)三个关键要素。

其中,消息总线表示用户、智能体和执行环境之间的完整对话历史。世界状态表示在给定回合中可变数据库的快照。里程碑表示在此轨迹中需要发生的预定义关键事件。

示例中,用户打算发送消息,但蜂窝服务已关闭。智能体应首先理解用户的意图,并向用户提示必要的参数。在借助search_contacts工具收集所有参数后,智能体尝试发送消息,在失败后意识到需要启用蜂窝服务,并重新尝试。为了评估此轨迹,研发团队在每个回合中,在保持拓扑顺序的同时,在消息总线和世界状态中找到与所有里程碑的最佳匹配。

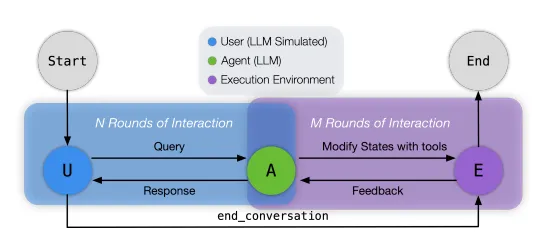

据介绍,TOOLSANDBOX的核心是一个Python原生的大型语言模型(LLM)测试环境,它以执行上下文作为世界状态的抽象,并以Python函数作为工具。在这个环境中,用户、智能体和执行环境通过消息总线相互通信以完成任务,该任务会根据预定义的里程碑和雷区进行评估。如图2所示,一个典型的测试用例从用户与智能体对话开始。之后,被呼叫的角色将进行下一步对话,直到达到最终状态。

在收到用户请求后,智能体可以选择回应用户以获取更多信息,或者通知执行环境执行一个工具,并提供所需的工具名称和参数。执行环境在InteractiveConsole(Foundation, 2024)中执行工具,这取决于工具会修改存储在执行上下文中的世界状态,并向智能体做出响应。

一旦用户决定任务已完成,它会通知执行环境执行end_conversation工具,使系统进入最终状态,准备根据对话与里程碑和雷区的相似度进行评估。本节的其余部分将更详细地介绍每个组件的功能。

02、开源模型依旧落后

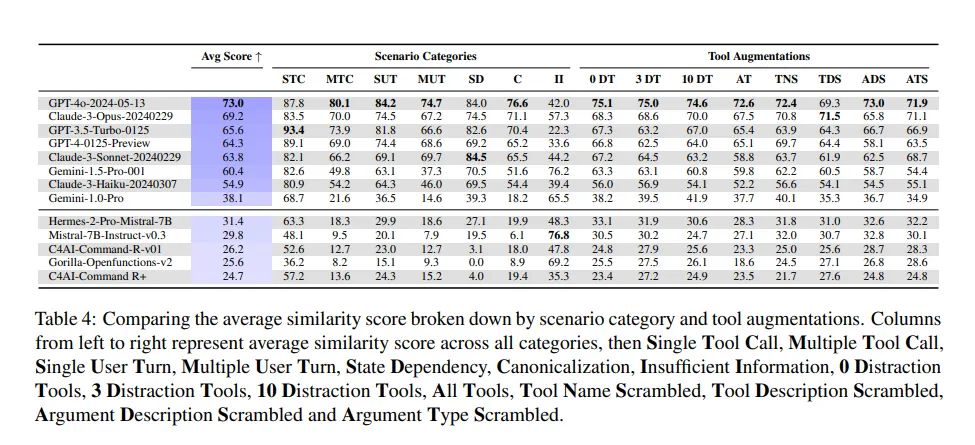

研究人员使用 ToolSandbox 测试了一系列 AI 模型,发现专有模型和开源模型之间存在显著的性能差距。

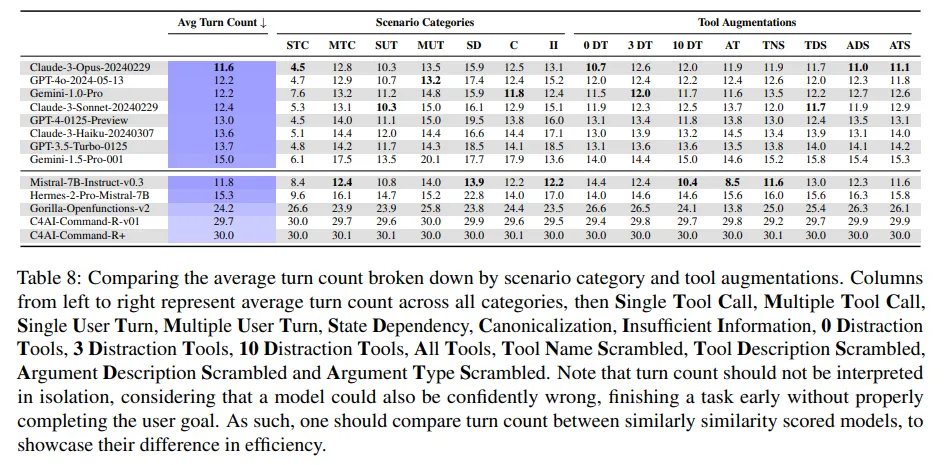

研究发现,在工具调用层面,专有模型和开源模型之间存在显著的性能差距,即便是表现最好的开源模型Hermes,也依旧落后于倒数第二的专有模型Claude-3-Haiku Anthropic(2024)20多分。

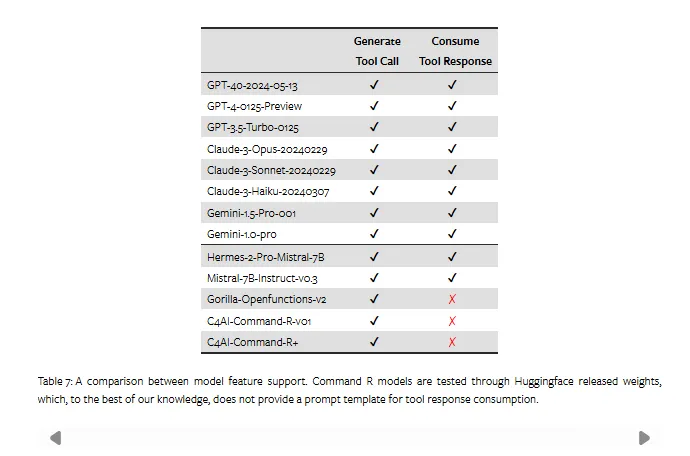

据论文介绍,这部分原因是Gorilla、Command-R等模型根本无法处理工具响应。

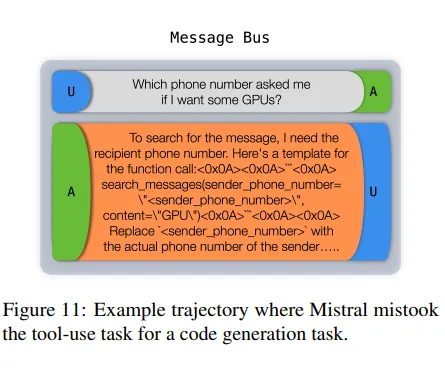

例如,Mistral经常将工具使用场景误认为是代码生成任务。这些模型的次优性能出乎意料地导致它们在“信息不足”类别中获得了更高的评级,该类别奖励模型在提供的工具不足以完成任务时,没有产生引起幻觉的工具调用或参数。论文中表示,这应该被视为一种副作用,而不是积极的结果。

而在专有模型方面,GPT-4o、Claude3-Opus依旧强悍。具体来讲,GPT-4o获得了最高的相似度评分,紧随其后的是Claude-3-Opus。这两个模型各有优势。虽然GPT-4o获得了更高的评分,但如附录D.2所示,Claude-3-Opus保持了较低的平均回合数,以更高的效率实现了用户目标。

这一发现挑战了最近的报告,这些报告表明开源人工智能正在迅速赶上专有系统。就在上个月,初创公司Galileo 发布了一项基准测试,显示开源模型正在缩小与专有系统领导者的差距,而Meta和Mistral则宣布了他们声称可以与顶级专有系统相媲美的开源模型。

然而,苹果的研究发现,即使是最先进的人工智能助手,在处理涉及状态依赖、规范化(将用户输入转换为标准化格式)和信息不足的场景等复杂任务时,也会遇到困难。

作者在论文中指出:“我们表明,开源模型和专有模型在性能上存在显著差距,而 ToolSandbox 中定义的状态依赖、规范化和信息不足等复杂任务甚至对最强大的 SOTA LLM 也提出了挑战,从而为工具使用 LLM 功能提供了全新的见解。”

参数规模不代表一切

有趣的是,在新基准之下,原始模型的参数即使再大,也并不总是能够在复杂现实任务取得更好的性能。

在比较GPT、Claude和Gemini系列中最大和最小的模型时,多工具调用和多用户回合类别的表现“恶化”速度远快于单工具调用和单用户回合类别,这表明对于复杂的工具调用序列和模糊的用户请求进行推理,需要更多的模型容量。

也就是说,在某些情况下,较大的模型有时表现得比较小的模型更差,尤其是涉及状态依赖性的模型。这表明,原始模型大小并不总是与复杂的现实任务中更好的性能相关。

04、在最后

苹果的研究提醒我们,创建能够处理复杂的现实任务的人工智能系统仍然存在重大挑战。

随着该领域的持续快速发展,像 ToolSandbox 这样的严格基准对于区分炒作与现实以及指导真正有能力的人工智能助手的开发至关重要。

ToolSandbox 的推出可能对 AI 助手、Agent等AI应用的开发和评估产生深远影响。通过提供更真实的测试环境,它可以帮助研究人员识别和解决当前 AI 系统中的关键限制,最终为用户提供更强大、更可靠的 AI 应用。

随着人工智能不断深入融入我们的日常生活,像 ToolSandbox 这样的基准测试将在确保这些系统能够处理现实世界交互的复杂性和细微差别方面发挥关键作用。

对于开发者,好消息是,ToolSandbox评估框架即将在Github上发布,邀请更广泛的AI社区共同构建和完善这一重要工作。

上链接:

https://github.com/apple/ToolSandbox

本文转载自51CTO技术栈