大模型的核心之一——大模型预训练之数据预处理 原创

“ 训练数据的好坏,直接影响到大模型的推理质量”

影响大模型质量的原因除了机器学习模型(模型的架构)的之外,更重要的一点就是大模型的训练数据。从某些方面来说,训练数据的质量直接决定大模型的好坏。

那么怎么才能从繁杂的数据中梳理出一批高质量的训练数据是一个值得考虑的问题。

大模型训练数据的准备

准备一个合格的大模型训练数据集是一个关键且复杂的过程,直接影响到模型的表现。

下面是详细的步骤,以及需要注意的点:

确定任务目标

有句老话叫:“有的放矢”,首先要明确你的任务和目标,才能知道你需要什么样的数据,然后应该怎么准备数据,这是一切的开始。

任务类型:明确模型需要解决的任务类型,如文本生成,图像处理,语义理解等

目标:确定模型的预期输出,定义准确度,精度等评价标准

数据收集

数据收集同样包括多个方面,比如数据来源,数据的多样性,数据量等。

数据来源:数据来源包括公开数据集,如维基百科,网络论坛等;企业内部数据集,利用公司内部的日志,文档,数据库等;还有就是自采集数据集,如网络爬虫,接口(API)等。

数据多样性:确保数据覆盖足够广泛的场景和样本,避免模型过拟合特定领域

数据量:大模型通常需要海量数据,通常在百万级以上;因此数据存储也是一个问题

数据清洗

数据清洗是数据处理中的重要环节,由于数据源头不一,直接导致数据质量参差不齐,因此必须要做好数据清洗。

去重:移除重复的样本,确保数据多样性

去噪:过滤掉无意义的数据,如广告,拼写错误,噪声图像等

统一格式:确保所有数据采用一致的编码格式(如UTF-8),并且统一时间,日前等标准格式

数据修复:修正数据中的错误,如拼写,补全等

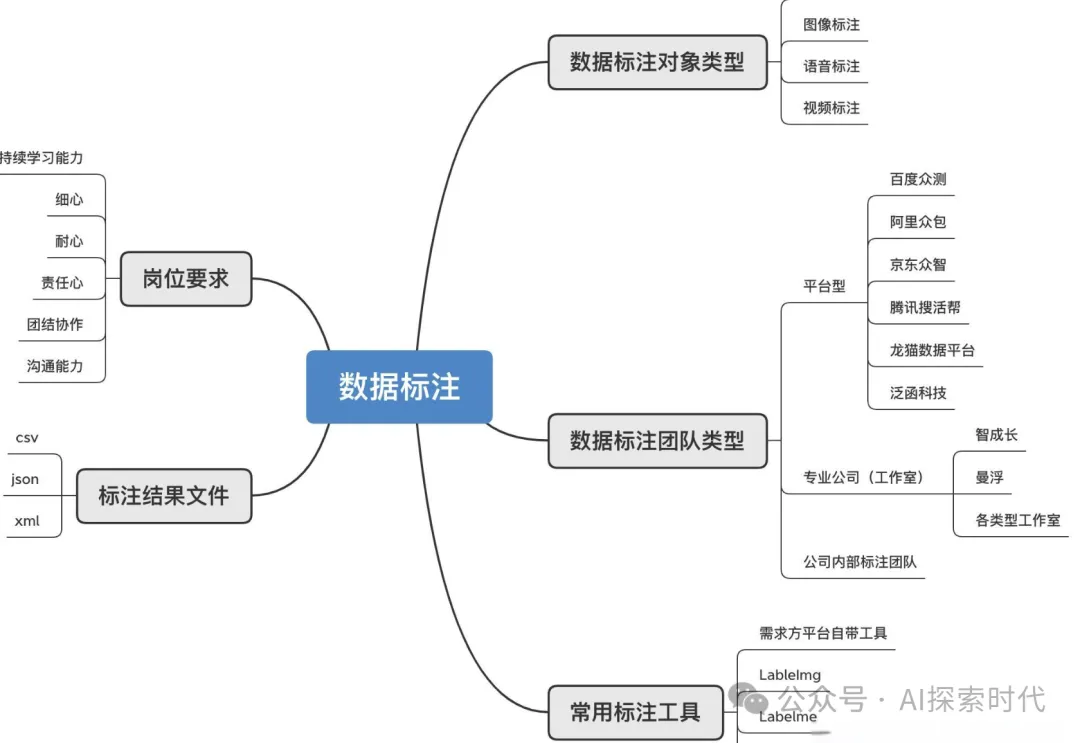

数据标注

数据标注需要注意多种情况,标注类型,标注质量,一致性检查等。

标注类型有文本标注,如命名体识别,情感分析等;图像标注,如物体边界框,图像分类标签等

标注质量:使用自动化工具初步标注,然后进行人工审核和修正

一致性检查:确保标注的一致性和准确性,尤其是多人标注时

数据增强

文本增强:如同义词转换,数据回译,随机插入和删除单词等

图像增强:如旋转,裁剪,颜色调整等

目的:通过数据增强来增加样本多样性,提高模型等泛化能力

数据分割

数据集要分为训练集,验证集和测试集,通常按8:1:1的比例分割数据,确保数据集之间没有交叉

平衡性:确保各个数据集中类别分布的一致性,避免类别不平衡问题

数据处理与转换

文本处理:文本处理分为分词和词嵌入两种形式。

分词:根据任务要求选择适当的分词工具(如BPE,WordPiece);

词嵌入:将分词后的文本转换为向量(如Word2Vec,GloVe等)

图像处理:图像处理也有两种方式,归一化和尺寸调整

归一化:将像素值归一化到一个合理的范围

尺寸调整:统一图像尺寸,便于批处理

特征提取:特征提取是根据任务需求提取特征,如文本的n-gram特征或图像的边缘化特征

数据存储与管理

存储格式:文本使用json,csv,parquet等格式;图像使用jpeg,png等格式

存储系统:使用HDFS,S3,数据仓库/数据湖等分布式存储系统来管理大规模数据

版本控制:对数据集进行版本控制,确保每次实验的可重复性

数据隐私与合规性

隐私保护:确保数据处理过程中遵循数据隐私法规(如GDPR)。

合规性:数据的收集、存储和使用必须符合相关法律法规

数据加载和预处理

数据加载器:实现高效的数据加载机制,如PyTorch的DataLoader或TensorFlow的tf.data。

在线预处理:在加载数据时进行必要的预处理操作,如归一化、标准化等

注意事项

数据偏差:确保数据的代表性,避免模型学习到偏见或不平衡。

质量控制:持续监控数据质量,定期清理和更新数据集。

标注一致性:标注工作中应保持一致性,避免同一类问题不同处理方式。

隐私与合规性:在所有数据处理阶段都应严格遵守相关法规,确保数据安全

总结

通过精心设计的步骤和严格的质量控制,可以确保大模型的训练数据高质量、多样性和合法性,从而为后续模型训练提供坚实的基础

本文转载自公众号AI探索时代 作者:DFires

原文链接:https://mp.weixin.qq.com/s/bx8eLxIWghSIAqSf2CfH5g