GPT-X 模型训练优化技术设计分析 原创

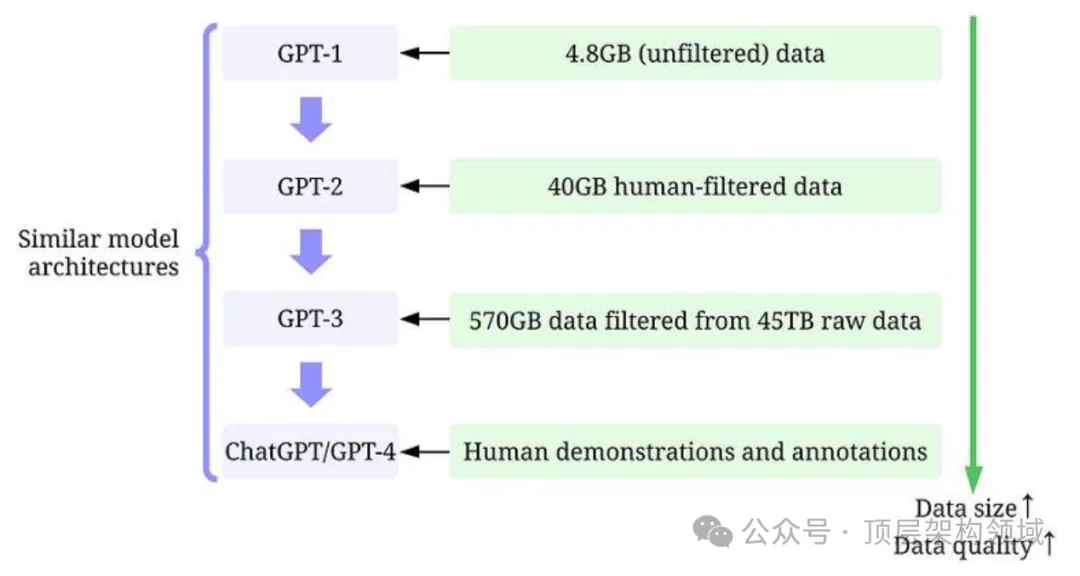

GPT-X模型作为当前自然语言处理领域的代表性模型之一,其训练效率和性能一直是研究的重点。本文将对GPT-X模型训练优化的相关技术进行详细的讲解,包括模型架构、算法优化、模型训练策略、算子优化、并行计算和深度学习加速等方面的内容。

一、模型架构

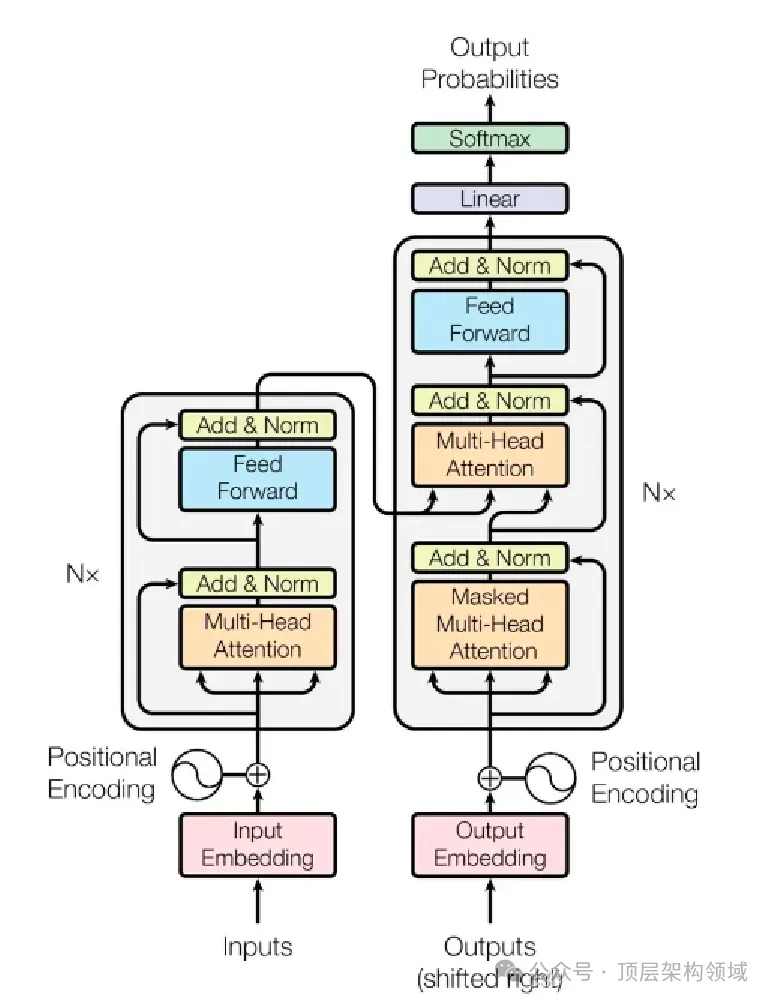

GPT-X的模型架构基于Transformer,这是一种注意力机制的网络架构,能够处理序列到序列的任务,如机器翻译、文本摘要等。Transformer的核心组件是自注意力机制,它能够捕捉序列中的长距离依赖关系。GPT-X模型在大规模语料库上进行预训练,以学习通用的语言表示。

二、算法优化

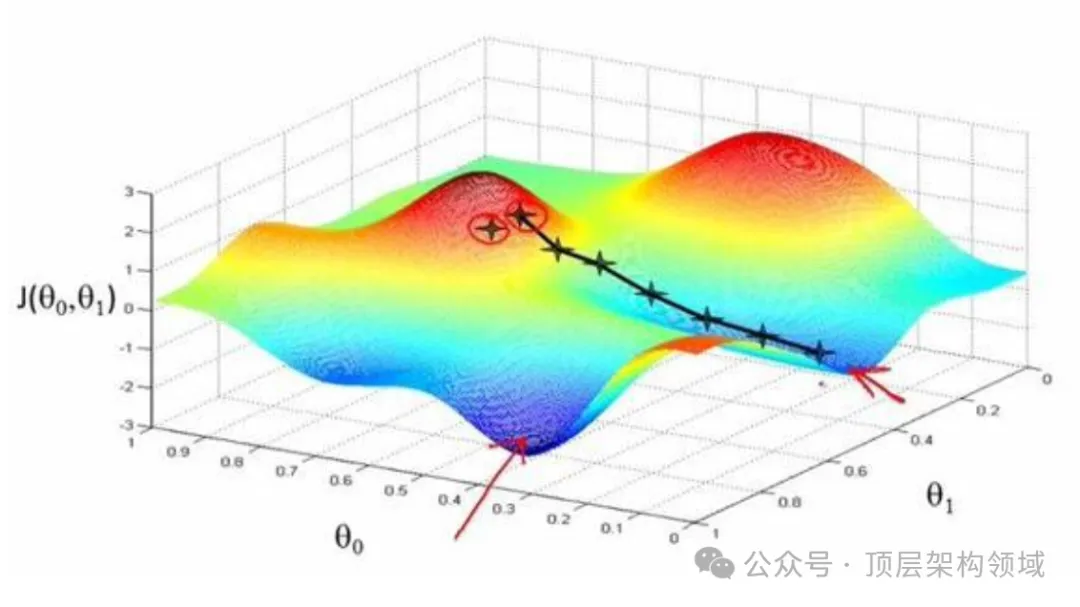

算法优化是提高模型训练效率的重要手段。在GPT-X模型训练中,常用的优化算法包括随机梯度下降(SGD)、Adam、RMSProp等。这些算法通过调整模型参数,使损失函数最小化,从而提高模型的训练效率和精度。例如,Adam算法因其自适应学习率调度和动量机制,在不同的数据集上通常能获得较好的性能。

三、模型训练策略

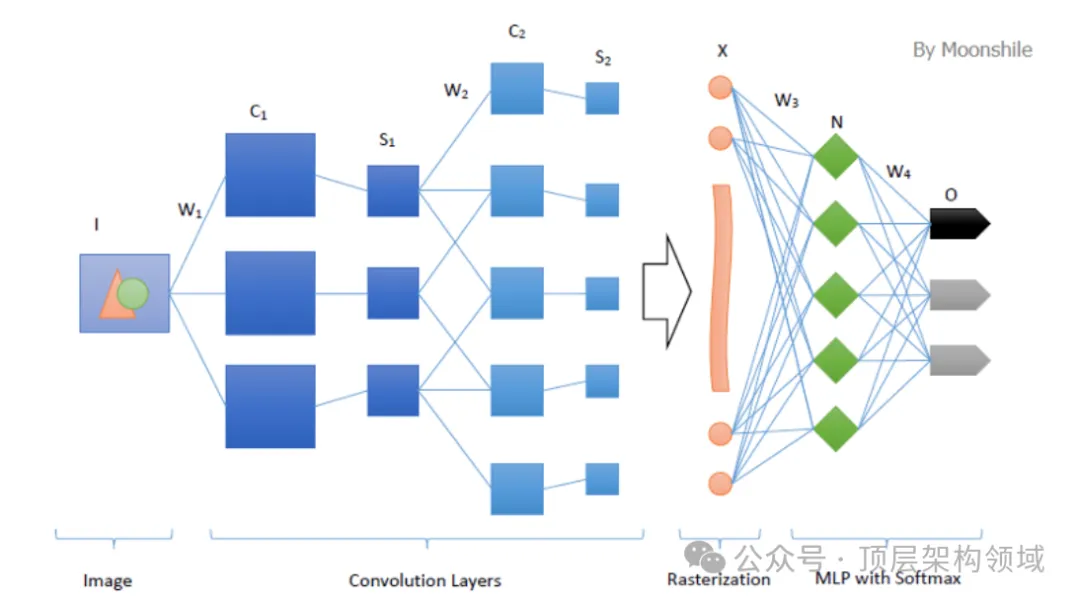

模型训练策略的选择也会对训练效率产生影响。例如,合理设置批量大小、学习率以及使用预训练模型初始化参数等策略,都能有效提升训练效率。此外,数据预处理和特征提取也是重要的训练策略,如使用卷积神经网络(CNN)进行图像特征提取可以大幅提高训练速度和模型性能。

四、算子优化

算子优化主要是指对算法中的基本运算进行优化,以提高计算效率和训练速度。例如,使用GPU进行矩阵运算可以大幅提高计算速度,而使用TensorFlow或PyTorch等框架进行向量化运算可以加快训练速度并减少内存消耗。

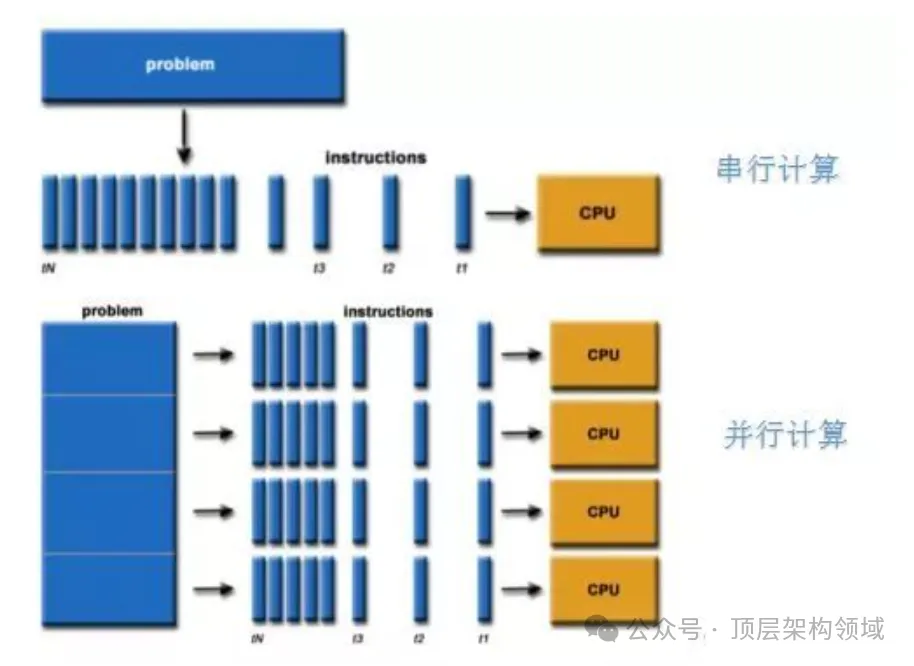

五、并行计算

并行计算是通过将计算任务分配到多个计算单元上执行,以提高计算效率和训练速度的技术。硬件并行和软件并行是并行计算的两种方式,前者使用多个GPU或多核CPU同时进行计算,后者使用多个线程或进程同时进行计算,充分利用多核CPU的计算能力,加快训练速度。

六、深度学习加速

深度学习加速涉及到一系列技术和方法,旨在提高深度学习模型的训练速度和性能。这些方法包括模型压缩、数据并行和通信优化等。模型压缩可通过剪枝、量化、知识蒸馏等技术减小模型的大小和复杂度,提高训练速度和模型的实时性。

总结

GPT-X模型训练优化是一个涉及多个方面的综合技术活动。通过算法优化、模型训练策略、算子优化、并行计算和深度学习加速等技术的综合运用,可以有效提升GPT-X模型的训练效率和性能。未来的研究将继续聚焦在这些方面的深化和细化,以期达到更高的训练效率和更好的模型性能。

本文转载自公众号顶层架构领域

原文链接:https://mp.weixin.qq.com/s/C2ctySAcOjHVAgAXj5g-DA