一眼假!GPT4V可有效识别DeepFake图像! 精华

引言:AI时代的信息真伪辨识

在人工智能迅猛发展的今天,我们面临着前所未有的信息真伪辨识挑战。AI技术,尤其是深度学习模型,已经能够生成极其逼真的图片、音频和视频内容,这些内容被统称为DeepFakes。DeepFakes的出现给信息的可信度和数字媒体的信任带来了严重的挑战。因此,识别DeepFakes成为了媒体取证领域中一个紧迫且关键的任务。

这篇论文研究了多模态大语言模型(LLMs)在DeepFakes检测上的作用。通过定性和定量实验,表明这些模型可以在不需要编程的情况下,揭示人工智能生成的图像。同时,讨论了这些模型在媒体取证任务中的局限性,并提出了可能的改进方法。

论文标题:

Can ChatGPT Detect DeepFakes? A Study of Using Multimodal Large Language Models for Media Forensics

论文链接:

https://arxiv.org/pdf/2403.14077.pdf

多模态大语言模型在DeepFake检测中的应用

1. 多模态LLMs在文本和图像理解中的作用

多模态大语言模型(LLMs)是基于大规模神经网络的模型,具有数十亿参数,能够执行与自然语言相关的任务。这些模型通常采用变压器架构,特别是其注意力机制,能够评估不同单词对理解文本的重要性。LLMs通过在大量未标记文本上的训练,捕捉人类语言的统计模式,并可针对其他应用进行调整。最新的LLMs集成了视觉-语言模型,使其具备了多模态理解能力,能够接受图像作为输入并对其进行文本提示,从而在图像和视频内容的理解上展现出强大的能力。

2. DeepFake的定义及其对信息可信度的影响

DeepFake是指使用人工智能生成的媒体内容,它们因被用作散布虚假信息的手段而引起了人们的关注。DeepFake面部图像是最早也是最著名的例子,它们使用生成对抗网络(GANs)和扩散模型创建,具有极高的细节真实性,挑战了人类辨别真实人脸图像的能力。DeepFake的使用严重破坏了信息的可信度和数字媒体中的信任。

实验设计与评估

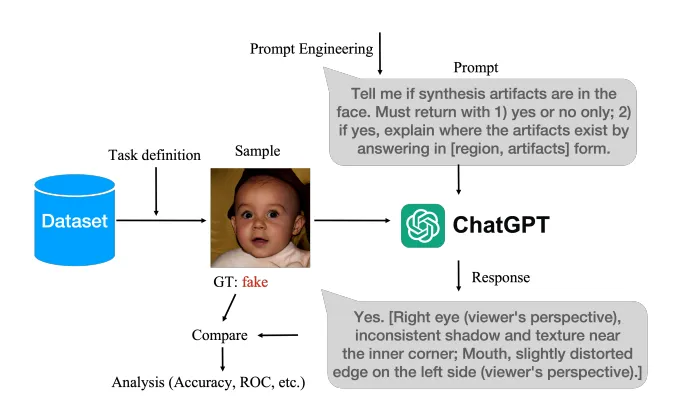

1. 实验目标与过程

本研究的目标是全面且定量地评估多模态LLMs检测DeepFakes的能力。实验设计旨在展示多模态LLMs在揭露AI生成的人脸图像方面的可行性和性能。实验过程包括为输入的人脸图像配上文本提示,并要求模型给出是或否的回答,以此来判断伴随的图像是否为AI生成。

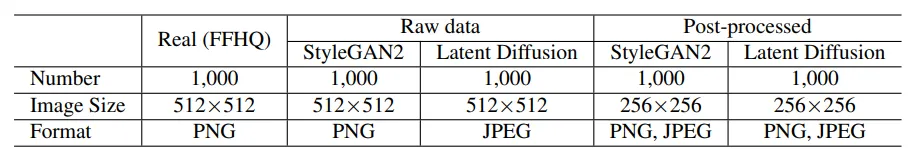

2. 数据集和文本提示选择

实验基于FFHQ数据集的1000张真实人脸图像和数据集的2000张AI生成图像。考虑了两种AI生成模型,即StyleGAN2和Latent Diffusion,并采用了数据集的两种评估协议。文本提示是实验的关键,因为它是用户与多模态LLM聊天机器人进行媒体取证任务交互的唯一接口。实验中考虑了不同丰富程度的文本提示,以有效地引导LLMs给出有意义的回应。

3. 性能评价指标与模型参数设置

性能评价指标包括分类准确率和接收者操作特征曲线(ROC)下的面积(AUC)得分。AUC得分是[0,1]之间的实数,数值越高代表性能越好。模型参数设置方面,所有批量测试都通过API调用进行。对于Gemini模型,使用了免费的Gemini-1.0-pro-vision,支持每分钟最多60个请求。

实验结果:多模态LLMs在DeepFake检测中的表现

1. 定性和定量结果展示

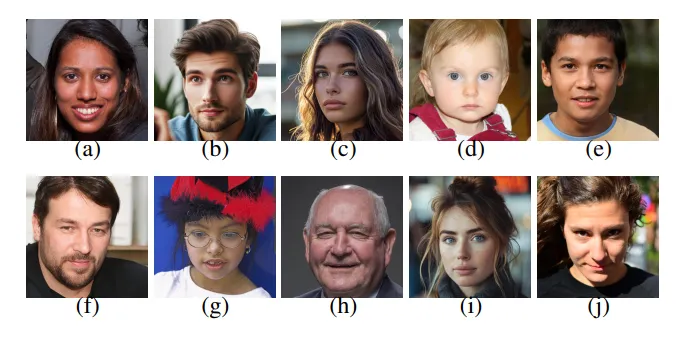

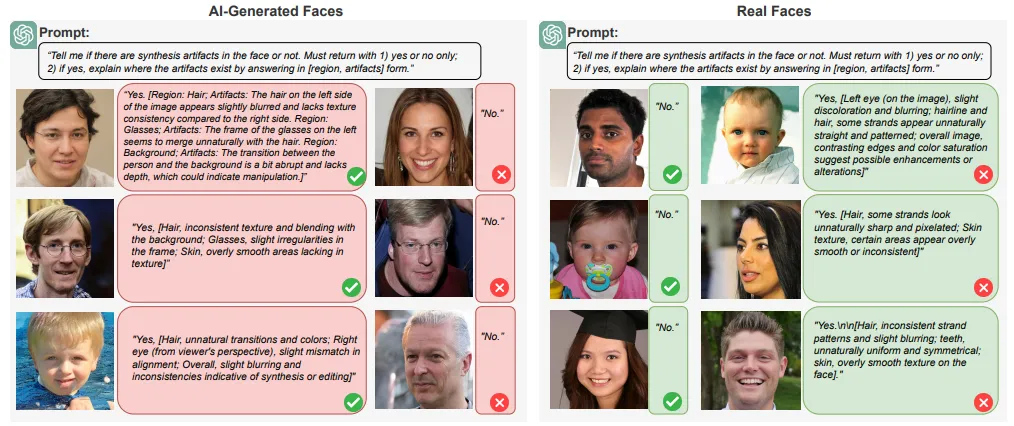

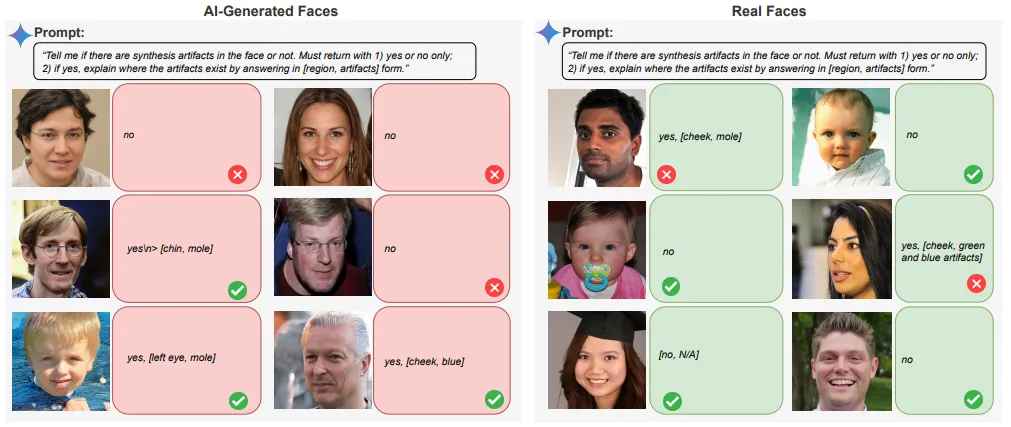

在对多模态大语言模型(LLMs)进行DeepFake检测的实验中,观察到了一些关键的定性和定量结果。定性结果表明,多模态LLMs能够在一定程度上区分真实和AI生成的图像,这一能力是基于它们的语义理解。我们能够在一些案例中成功识别出AI生成的面孔和真实面孔。然而,这种识别能力并不是绝对的,也存在一些失败的案例。

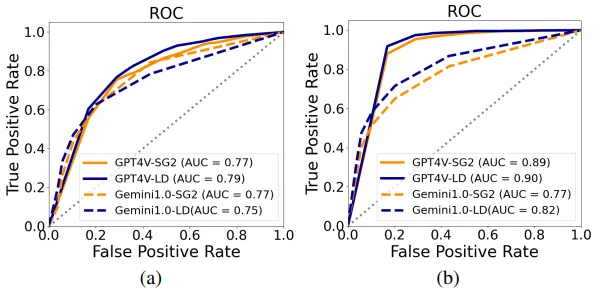

定量结果显示,多模态LLMs在识别AI生成的图像方面的表现是令人满意的,其AUC(曲线下面积)得分约为75%。但是,它们在识别真实图像方面的准确性明显较低。这种差异产生的原因是,从LLMs的角度来看,缺乏语义不一致并不自动证实图像的真实性。

2. GPT4V与Gemini 1.0 Pro性能对比

在对比GPT4V和Gemini 1.0 Pro在DeepFake检测方面的性能时,发现GPT4V在原始数据上的AUC得分为79.5%,而在StyleGAN生成的面孔图像上的AUC得分为77.2%。相比之下,Gemini 1.0 Pro在性能上略有下降。在实际应用中,尽管Gemini 1.0 Pro在某些案例中能够准确地给出是/否的结果,但其支持证据并不充分。

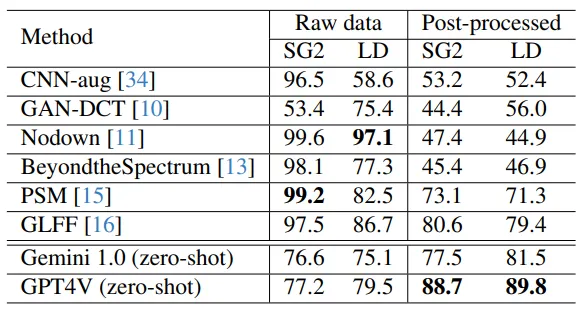

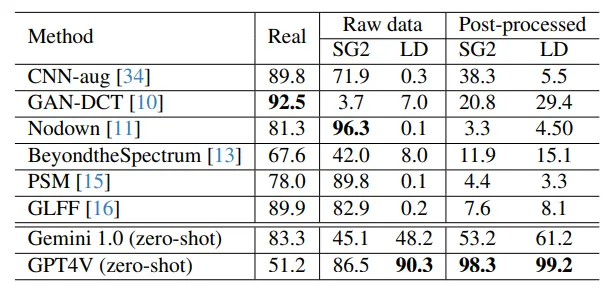

3. 与现有DeepFake检测方法的比较

将多模态LLMs的性能与现有的DeepFake检测方法进行比较时,发现GPT4V和Gemini 1.0 pro的性能与早期的方法相当或略好,但与更近期的检测方法相比则不具竞争力。现有的有效DeepFake检测方法能够捕捉到训练真实和AI生成图像之间的信号级统计差异。与之相反,多模态LLMs的决策主要基于语义级异常,这通过自然语言中的额外解释反映出来。因此,即使LLM没有专门为DeepFake面部检测设计和训练,其包含的知识也可以转移到这项任务上。

提升多模态LLMs检测能力的策略

1. 文本提示的质量对性能的影响

文本提示的质量对多模态LLMs在DeepFake检测中的性能有着重要影响。研究发现,与直接图像取证相关的提示导致了高拒绝率,尤其是那些基于可能性评估和要求在真实或伪造之间做出选择的提示。而那些要求模型识别合成迹象的提示,导致了较少的拒绝,并且预测准确性相当。

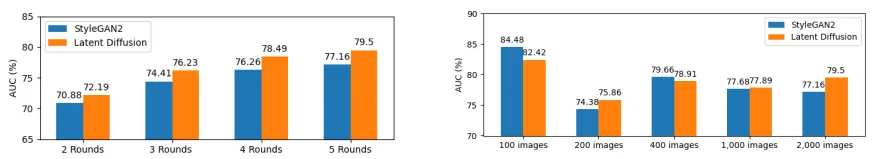

2. 查询次数和数据集大小对结果的影响

查询次数的增加与AUC得分的提高呈正相关,这表明重复查询可能作为一种增强性能的集成方法。此外,数据集大小对GPT4V检测性能的影响表明,随着数据集的增大,对StyleGAN2和Latent Diffusion模型的性能趋于收敛。

3. 链式思考与少数样本提示的初步探索

研究者还探索了使用链式思考提示和少数样本提示来提高多模态LLMs的性能。这些提示通过提供逐步指导,在与LLM的交互对话中引出更相关的响应。初步结果表明,使用更精心设计的提示可以提高性能。但是,研究者等待LLMs支持一致的API调用以进一步探索这些策略。

结论与展望

尽管多模态LLMs在识别AI生成图像方面取得了一定的成效,但它们在识别真实图像的准确性方面表现较差。这种差异源于缺乏语义不一致并不自动确认图像的真实性。此外,多模态LLMs目前还没有结合信号线索或数据驱动方法来执行这项任务。虽然它们不依赖信号线索,可以识别任何生成模型创建的AI图像,但其性能仍然落后于最新的检测方法。

未来的研究将探索更复杂的提示策略,并将这些模型与传统的信号或数据驱动检测技术相结合,以提高多模态LLMs在媒体取证中的性能。此外,还将扩展多模态LLMs的应用范围,包括更广泛的媒体形式,特别是视频分析,并提高对图像-文本错配的检测能力。

本文转载自夕小瑶科技说,作者:芒果

原文链接:https://mp.weixin.qq.com/s/wOJ4WF2KQorhOgFeeweydQ