常见几种大语言模型压缩技术分析详解 原创

大型语言模型(LLM)在自然语言处理任务中取得了显著的成功,但同时也面临着模型过大、计算需求过高的问题。为了解决这些问题,模型压缩技术应运而生,旨在减小模型大小、降低计算复杂度并提升运行效率。本文将对LLM压缩技术进行详细的分析,包括剪枝、知识蒸馏和量化等关键技术,并结合实际应用案例进行分析。

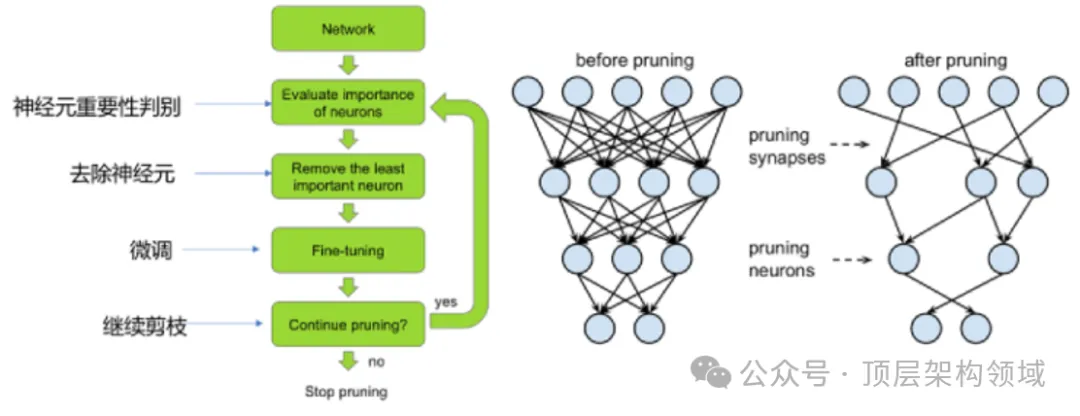

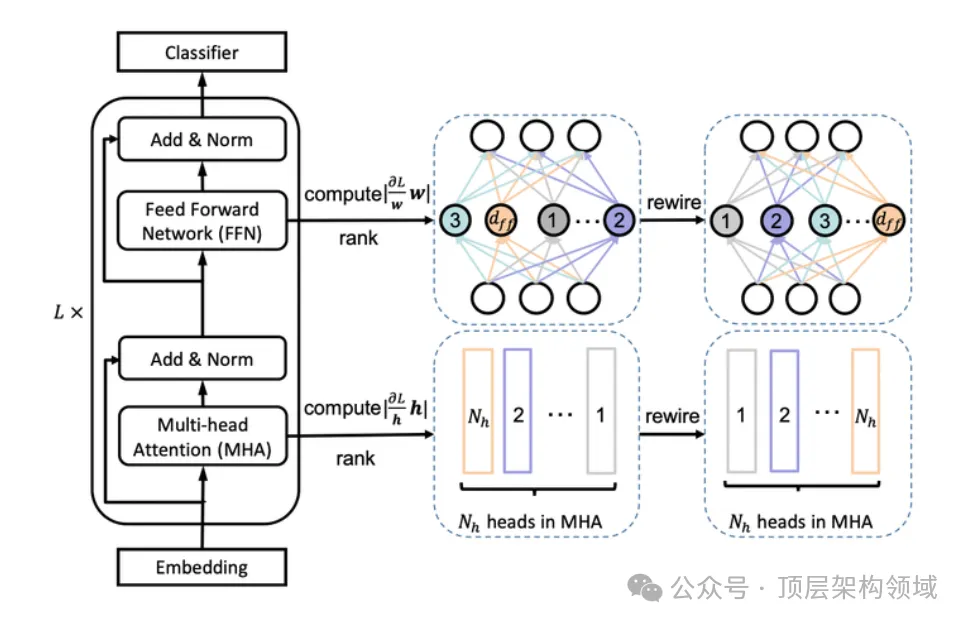

一、剪枝技术

剪枝技术是通过删除不必要或冗余的参数或连接来减小模型大小和复杂度的有效手段。剪枝可以分为非结构化剪枝和结构化剪枝,前者会产生不规则的稀疏结构,后者则按规则删除连接或层次结构,保持网络的规整性。剪枝技术的优势在于可以显著减小模型体积,提高存储和计算效率,但同时也面临挑战,如需要谨慎选择剪枝准则以避免过度剪枝导致的性能下降。

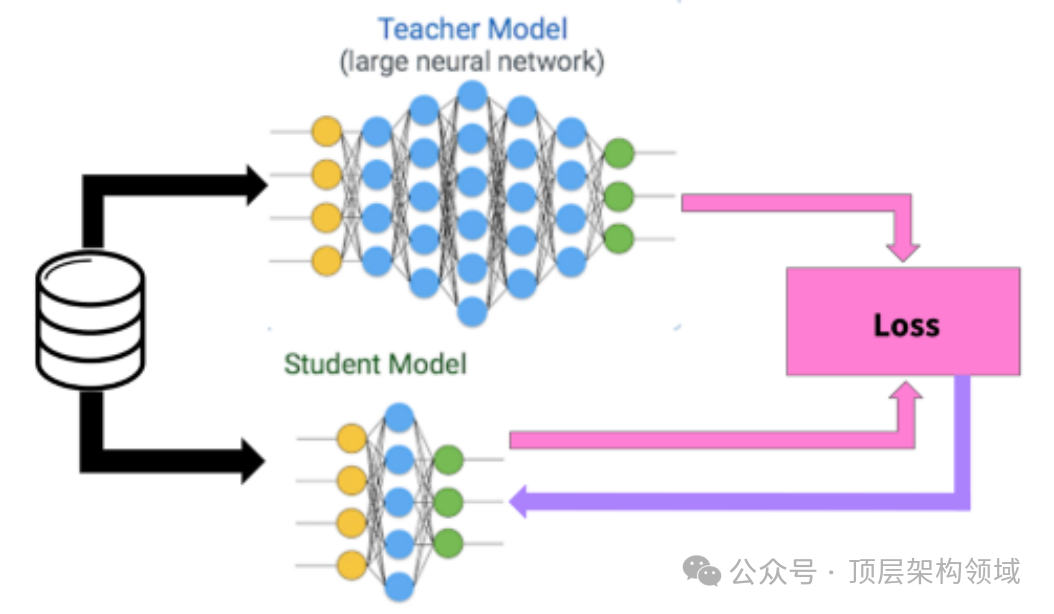

二、知识蒸馏

知识蒸馏是一种将知识从大型模型转移到小型模型的技术,通过训练一个学生模型来模仿教师模型的行为。它的优势在于可以提高模型性能和泛化能力,但同样存在挑战,如需要精心设计模型架构和训练策略,确保知识迁移的有效性。

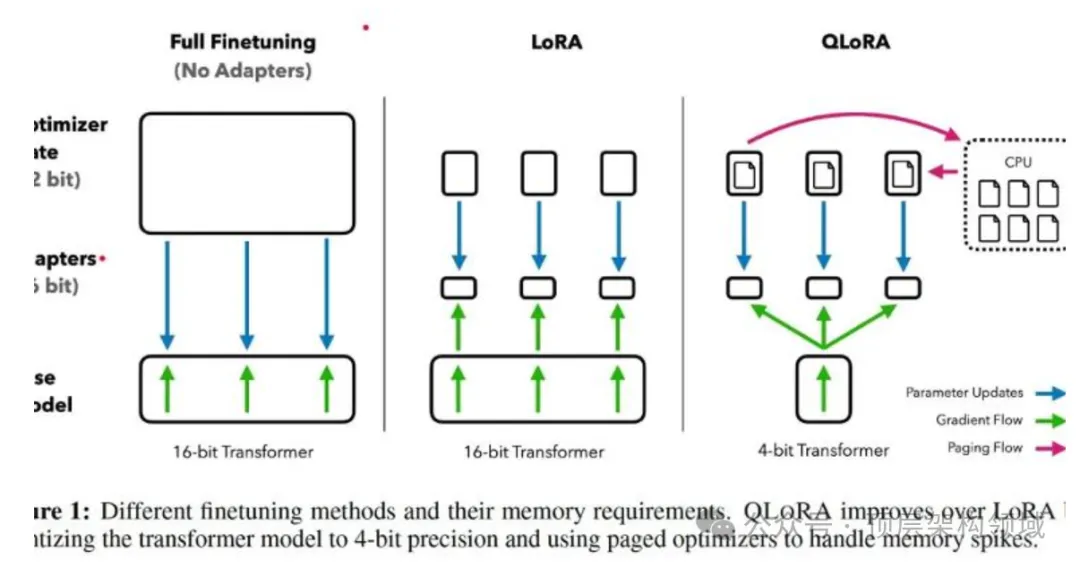

三、量化技术

量化技术通过降低参数的数值精度来减小模型体积和加速推理速度。它可以分为权重量化和激活量化,以及训练后量化(PTQ)和训练时量化(QAT)。量化的优势在于可以大幅减小模型存储需求并提升推理速度,但也可能在极端压缩条件下对模型性能产生影响。

四、实际应用案例

在实际应用中,例如DeepMind的Chinchilla 70B模型,通过剪枝、知识蒸馏和量化等技术,实现了在无损压缩方面的卓越表现,超过了传统的PNG和FLAC压缩算法。这表明压缩技术不仅可以减小模型大小,还能在某些情况下提升模型的性能和适用性。

五、未来研究方向

未来的研究方向包括但不限于探索更高效的剪枝算法、开发更为精细的知识蒸馏策略以及研究更为精确的量化方法。同时,随着新技术的出现,如何将这些技术融合应用到实际的压缩场景中,也是一个值得关注的焦点。

总结

综上所述,LLM压缩技术在模型性能和资源占用之间找到了平衡点,为AI技术的广泛应用铺平了道路。通过深入分析剪枝、知识蒸馏和量化等关键技术,并结合实际应用案例,我们可以看到压缩技术在未来有着广阔的应用前景。随着技术的不断发展和完善,我们有理由相信,LLM压缩技术将为自然语言处理及其他AI领域带来更多的突破和创新。

本文转载自公众号顶层架构领域

原文链接:https://mp.weixin.qq.com/s/KvwdqFeiyFCHKy-h7RXZOw