Agent planning终篇:打造更聪明的智能体!

今天我们从另外一个角度对规划能力进行总结,明天开始我们会分享关于Memory相关的内容。当我们谈论LLM支撑的Agent时,规划模块(Planning Module)是它们智能行为的核心。想象一下,如果你要完成一项复杂的任务,比如组织一场大型活动,你可能会把它分解成一系列小任务,然后逐一解决。智能体的规划模块也是这么干的!

规划模块的设计理念是模拟人类的规划能力,它能让智能体更合理、更强大、更可靠地行动。

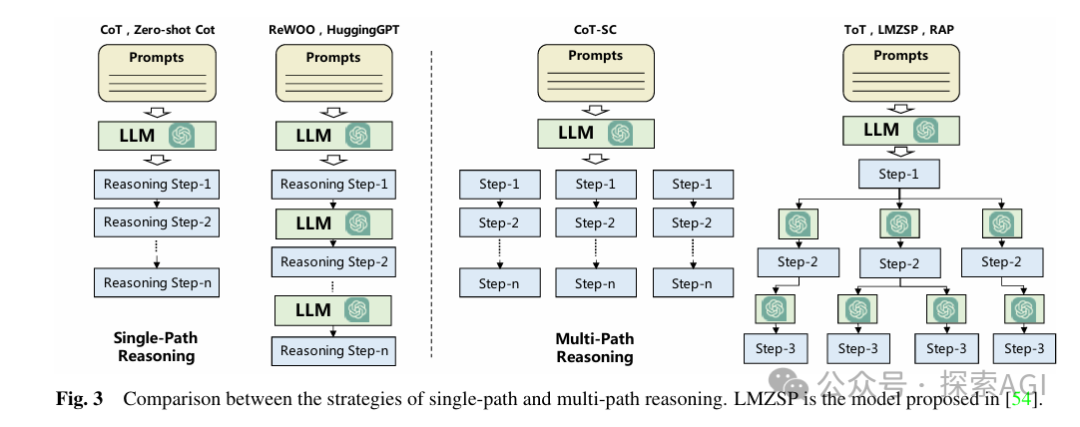

首先,我们得决定智能体在规划过程中是否能接收外部反馈。没有外部反馈的情况下,智能体就像一个孤独的思考者,它依靠内部的逻辑和预设的规则来制定计划。比如,使用CoT(Chain of Thought)模型,智能体会将复杂问题分解成多个推理步骤,每一步都紧密相连,引导LLM按顺序解决问题。这就像按照食谱做菜,食谱上的每个步骤都直接对应下一步,确保了最终的菜肴能够成功完成。

还有一种是多路径推理,这就像我们在做决定时,脑海中可能会同时出现好几个选项。例如,ToT(Tree of Thoughts)模型,它将推理步骤组织成一个树状结构,每个中间步骤都可能有多个子步骤,模拟了人类在每个决策点上的多种可能性。

单路径和多路径推理策略的比较

但是,现实世界是复杂的,有时候我们的计划需要根据外界的反馈来调整。这就是有外部反馈的规划。想象一下,你在建造一个模型飞机,每次试飞后你都会根据飞行情况来调整设计。智能体也是这样,它会根据环境的反馈来调整自己的行动计划。例如,Voyager模型在Minecraft游戏中通过环境反馈来改进其建筑技能的执行代码,或者SayPlan模型使用场景图模拟器来验证和完善其战略规划。

环境反馈是智能体从客观世界或虚拟环境中获得的信号,比如游戏任务的完成信号或者智能体行动后的环境变化。人类反馈则更主观,它可以帮助智能体更好地符合人类的价值观和偏好。例如,Inner Monologue模型通过积极地从人类那里获取关于场景描述的反馈,并将这些反馈整合到自己的行动中。

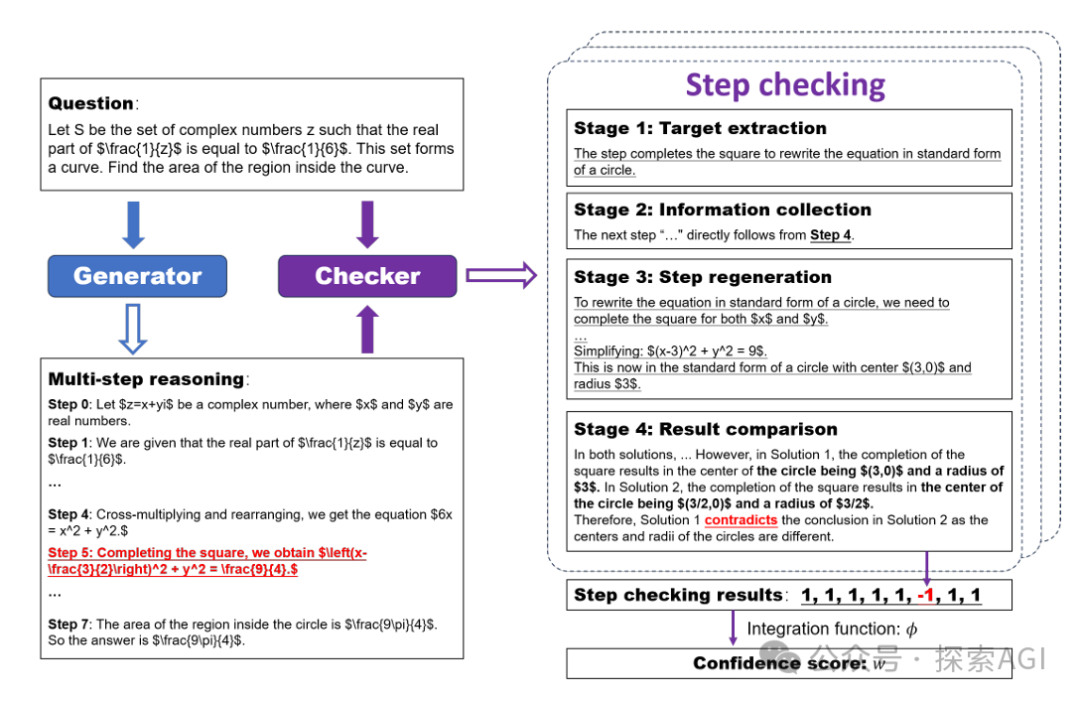

还有模型反馈,这是基于预训练模型生成的内部反馈,可以帮助智能体自我检查和改进。例如,SelfCheck模型允许智能体检查和评估自己在各个阶段生成的推理步骤,并通过比较结果来纠正错误。

总的来说,规划模块是智能体成功完成任务的关键。它需要智能体能够理解任务、制定计划,并根据反馈进行调整。这不仅仅是一个技术问题,更是对智能体如何模拟人类思维和行动方式的深入探索。随着技术的发展,我们可以期待智能体在规划和行动上表现得越来越像人类。

本文转载自 探索AGI,作者: 猕猴桃