为什么最新的LLM使用混合专家(MoE)架构 原创

本文详细介绍了混合专家 (MoE)架构,该架构通过混合或融合不同的“专家”模型共同解决特定的问题。

专业化的必要性

医院有很多具有不同专长的专家和医生,他们擅长解决各自领域内的医疗难题。外科医生、心脏病专家、儿科医生等各类专家紧密合作,为患者提供了全面而个性化的医疗护理服务。同样,人们也可以将这一合作模式应用于人工智能领域。

人工智能中的混合专家(MoE)架构被定义为不同“专家”模型的混合或融合,能够共同处理或响应复杂的数据输入。当涉及到人工智能时,MoE模型中的每个专家都专门研究一个更宏大的问题——就像每位医生都专门在其医学领域内深耕一样。这样的设计提高了效率,并增强了系统的有效性和准确性。

Mistral AI提供的开源基础大型语言模型(LLM)可以与OpenAI相媲美。并且已经在Mixtral 8x7B模型中使用MoE架构,是一种尖端的大型语言模型(LLM)形式的革命性突破。以下将深入探讨Mistral AI的Mixtral为什么在其他基础LLM中脱颖而出,以及当前的LLM现在采用MoE架构的原因,并突出其速度、大小和准确性。

升级LLM的常用方法

为了更好地理解MoE架构如何增强LLM,本文将讨论提高LLM效率的常用方法。人工智能从业者和开发人员通过增加参数、调整架构或微调来增强模型。

·增加参数:通过提供更多信息并对其进行解释,模型学习和表示复杂模式的能力得到了提高。这可能会导致过拟合和幻觉,需要从人类反馈中进行广泛的强化学习(RLHF)。

- 调整架构:引入新的层或模块可以适应不断增加的参数数量,并提高特定任务的性能。然而,对底层架构的更改很难实现。

- 微调:预先训练的模型可以根据特定数据或通过迁移学习进行微调,允许现有的LLM处理新的任务或领域,而无需从头开始。这是最简单的方法,并且不需要对模型进行重大更改。

什么是MoE架构?

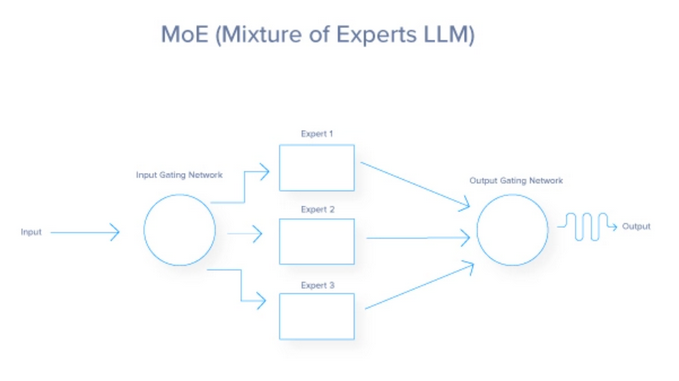

混合专家(MoE)架构是一种神经网络设计,通过为每个输入动态激活称为“专家”的专用网络子集来提高效率和性能。门控网络决定激活哪些专家,导致稀疏激活和减少计算成本。MoE架构由两个关键组件组成:门控网络和专家网络。以下进行分析:

从本质上来说,MoE架构的功能就像一个高效的交通系统,根据实时情况和期望的目的地,将每辆车(或在这种情况下是数据)导向最佳路线。每个任务都被路由到最合适的专门处理该特定任务的专家或子模型。这种动态路由确保为每个任务使用最有能力的资源,从而提高模型的整体效率和有效性。MoE架构利用了三种方法来提高模型的保真度。

(1)通过多个专家完成任务,MoE通过为每个专家添加更多参数来增加模型的参数大小。

(2)MoE改变了经典的神经网络架构,它包含了一个门控网络,以确定哪些专家被用于指定的任务。

(3)每个人工智能模型都有一定程度的微调,因此MoE中的每个专家都经过微调,以达到传统模型无法利用的额外调整层的预期效果。

MoE门控网络

门控网络在MoE模型中充当决策者或控制器。它评估传入的任务,并确定哪个专家适合处理这些任务。这一决策通常基于学习权值,随着时间的推移,通过训练进行调整,进一步提高其与专家匹配任务的能力。门控网络可以采用各种策略,从概率方法(将软任务分配给多个专家)到确定性方法(将每个任务路由到单个专家)。

MoE专家

MoE模型中的每个专家代表一个较小的神经网络、机器学习模型或针对问题域的特定子集优化的LLM。例如,在Mistral中,不同的专家可能专注于理解某些语言、方言,甚至是查询类型。专业化确保每个专家都精通自己的领域,当结合其他专家的贡献时,将在广泛的任务上实现卓越的性能。

MoE损失函数

虽然损失函数不被视为是MoE架构的主要组成部分,但它在模型的未来性能中起着关键作用,因为它被设计用于优化单个专家和门控网络。

它通常结合每个专家计算的损失,这些损失由门控网络分配给他们的概率或重要性进行加权。这有助于在调整门控网络以提高路由准确性的同时,对专家的特定任务进行微调。

从始至终的MoE流程

现在总结MoE整个流程,并添加更多细节。

以下是对路由过程从始至终如何工作的总结解释:

- 输入处理:输入数据的初始处理;主要是在LLM案例中的提示。

- 特征提取:转换原始输入进行分析。

- 门控网络评估:通过概率或权重评估专家的适用性。

- 加权路由:根据计算的权重分配输入;在这里,已经完成最合适的LLM流程的选择。在某些情况下,选择多个LLM来回答单个输入。

- 任务执行:处理每个专家分配的输入。

- 整合专家输出:将各个专家的结果结合起来,形成最终输出。

- 反馈和适应:使用性能反馈来改进模型。

- 迭代优化:不断优化路线和模型参数。

使用MoE架构的流行模型

OpenAI的GPT-4和GPT-40

GPT-4和GPT-40支持ChatGPT的高级版本。这些多模态模型利用MoE来摄取不同的源媒体,例如图像、文本和语音。有传言称,GPT-4有8个专家,每个专家拥有2200亿个参数,整个模型的参数总数超过1.7万亿个。

Mistral AI的Mixtral 8x7b

Mistral AI 提供了非常强大的开源 AI 模型,并表示他们的 Mixtral 模型是一个 sMoE 模型或稀疏多专家混合模型,以较小的封装形式提供。Mixtral 8x7b总共有467亿个参数,但每个令牌只使用129亿个参数,因此以这个成本处理输入和输出。他们的MoE模型一直优于Llama2 (70B)和GPT-3.5 (175B),同时运行成本更低。

MoE的好处以及是首选架构的原因

最终,MoE架构的主要目标是呈现复杂机器学习任务处理方式的范式转变。它提供了独特的优势,并在几个方面展示了其优于传统模式的优势。

增强的模型可扩展性

- 每个专家负责任务的一部分,因此通过增加专家来扩展不会导致计算需求的成比例增加。

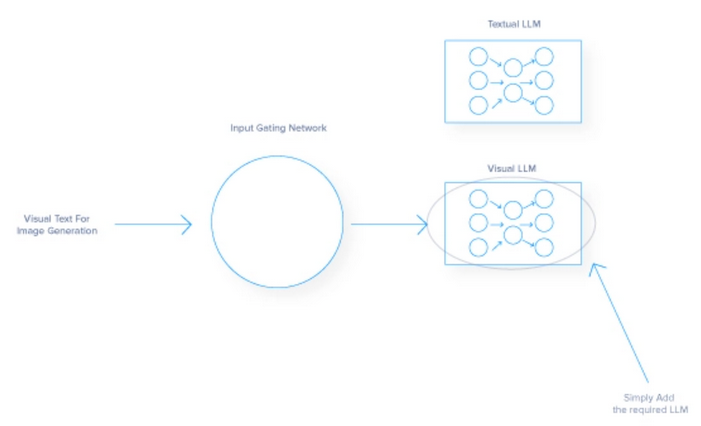

- 这种模块化方法可以处理更大、更多样化的数据集,并促进并行处理,加快操作速度。例如,将图像识别模型添加到基于文本的模型中可以集成额外的LLM专家来解释图像,同时仍然能够输出文本。

- 多功能性允许模型在不同类型的数据输入中扩展其功能。

提高效率和灵活性

- MoE模型非常高效,与传统架构使用所有参数不同,MoE模型只有选择地只让必要的专家参与特定的输入。

- 该架构减少了每次推理的计算负荷,允许模型适应不同的数据类型和专门的任务。

专业化和准确性

- MoE系统中的每个专家都可以针对整体问题的特定方面进行微调,从而在这些领域获得更高的专业知识和准确性

- 像这样的专业化在医学成像或财务预测等领域很有帮助,在这些领域,精确度是关键。

- MoE可以在范围狭窄的领域产生更好的结果,因为它有细致入微的理解,详细的知识,以及在专门任务上优于通才模型的能力。

MoE架构的缺点

虽然MoE架构提供了显著的优势,但它也带来了可能影响其采用和有效性的挑战。

- 模型复杂性:管理多个神经网络专家和用于引导流量的门控网络使MoE的开发和运营成本具有挑战性。

- 训练稳定性:门控网络和专家之间的相互作用引入了不可预测的动态,阻碍了实现统一的学习率,需要广泛的超参数调整。

- 不平衡:让专家闲置是对MoE模型的糟糕优化,将资源花费在不使用的专家身上或过于依赖某些专家。平衡工作负载分布和调优有效门对于高性能MoE AI至关重要。

应该注意的是,随着MoE架构的改进,上述缺点通常会随着时间的推移而减少。

专业化塑造的未来

反思MoE方法及其与人类的相似之处,可以看到,正如专业团队比一般劳动力取得更多成就一样,专业模型在人工智能模型中的表现也优于单一模型。优先考虑多样性和专业知识可以将大规模问题的复杂性转化为专家可以有效解决的可管理部分。

当展望未来时,需要考虑专业系统在推进其他技术方面的更广泛影响。MoE的原则可以影响医疗保健、金融和自治系统等行业的发展,促进更高效、更准确的解决方案。

MoE的旅程才刚刚开始,其持续发展有望推动人工智能及其他领域的进一步创新。随着高性能硬件的不断发展,这种专家AI的混合体可以在人们的智能手机中运行,将提供更智能的体验,但首先需要有人去训练它们。

原文标题:Why the Newest LLMs Use a MoE (Mixture of Experts) Architecture

作者:Kevin Vu

文章链接:https://dzone.com/articles/why-the-newest-llms-use-a-moe-mixture-of-experts。