一大堆Llama3.1-Chinese正在袭来 精华

写在前面

Llama3.1模型已经开源,在这短短几天之内,也是出现了一些Llama3.1汉化的repo,开源社区也是相当的卷。

主要是Llama3.1没有关注中文,虽然是多语言,但主要针对英语、法语、德语、印地语、意大利语、葡萄牙语、西班牙语和泰语。

虽然让Llama3.1系列模型用中文回答时,也可以正常回答,但仍然有中英文混合现象,并且词表是真没中文呀,中文场景下解码效率会比较低。

咋说呢?反正也给中文大模型更多机会吧,开源社区也有更多事情可以做。

对Llama3.1进行中文增强,当然还是那几步:扩充中文词表、中文数据continue-pretrain、中文sft。

下面先简单过一下Llama3.1的一些介绍和效果,再给大家分享一些已经开源的Chinese-Llama3.1项目。

Llama3.1介绍和效果

前几天关于Llama3.1的介绍其实一大堆了,我就不过的介绍了,可以看我之前分享的两篇文章Llama3.1系列模型正式开源,最大405B,闭源模型的统治时代将迎来结束?和浅谈Llama3.1,从结构、训练过程、影响到数据合成。

对于Llama3.1的系列模型,现在很多平台都已经支持,如果本地没有资源部署,可以从这些平台上测试。下面的测试截图均来自Hugging Chat测试结果。

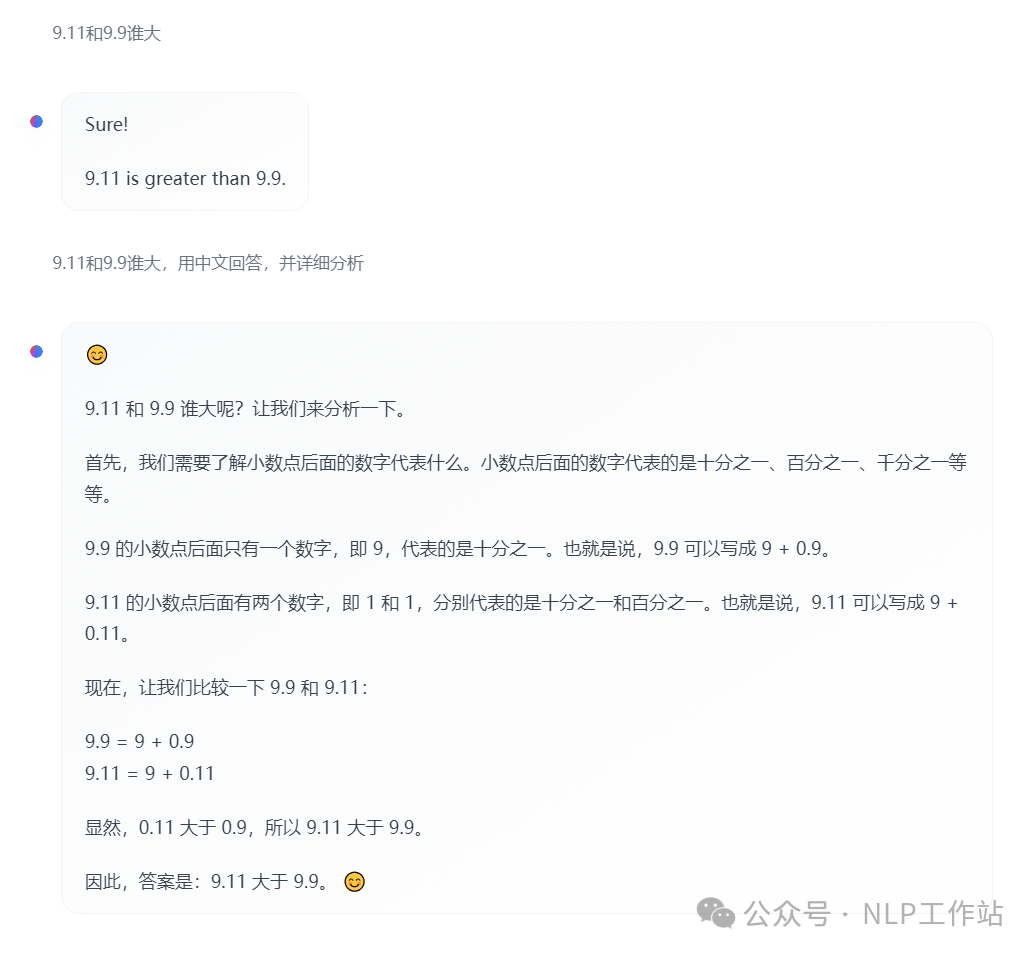

虽然Llama3.1-405B模型榜单效果有很秀,但是9.9和9.11谁的大也是一本正经的的胡说八道。

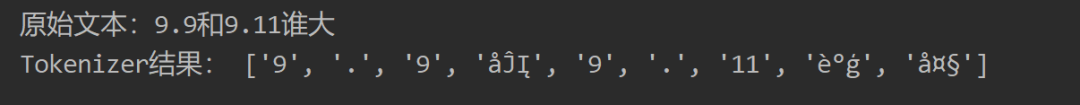

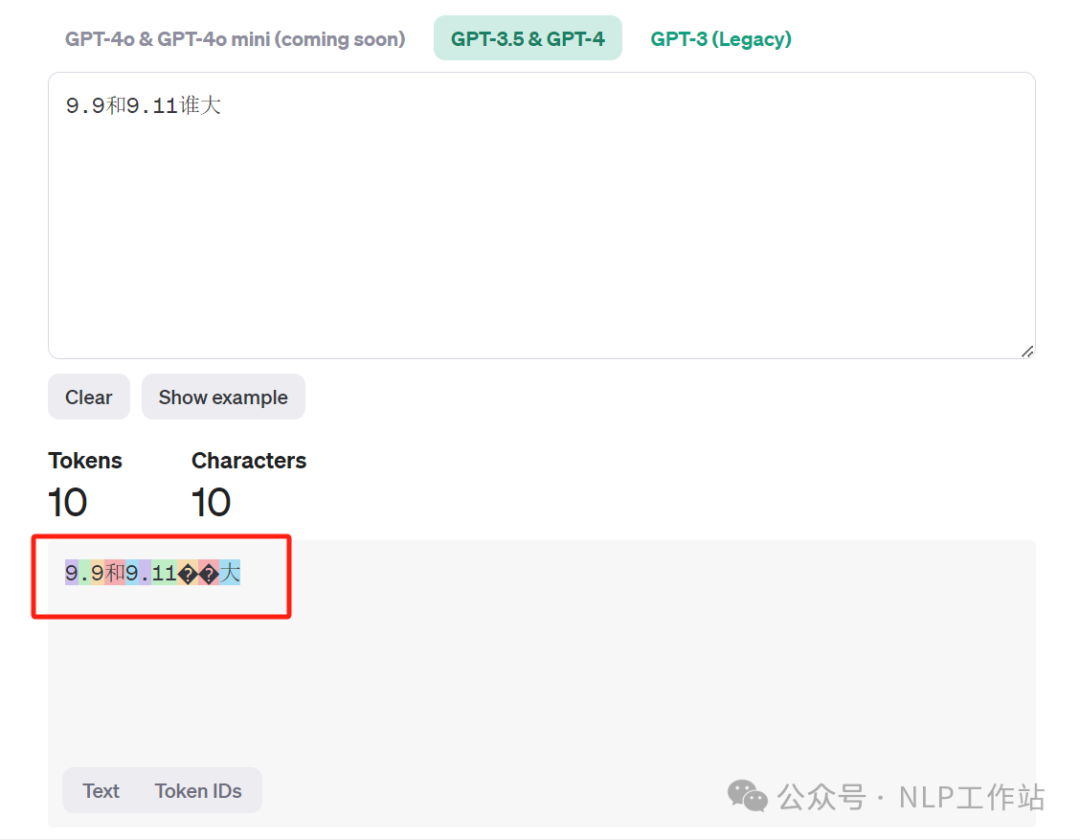

不过确实是Tokenizer的问题。

其实对于个人来说比较奇怪,之前一些模型其实都强调过,数字内容按照每个单独数字切割,不知道为啥Llama3.1没有采用该策略。

反正GPT4也是一样。

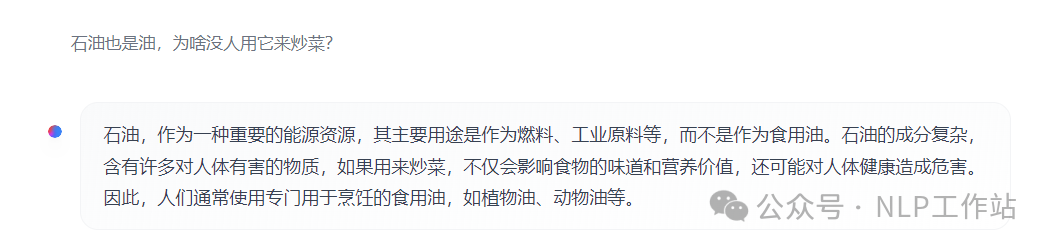

下面两个弱智吧的问题,考考Llama3.1(405B),

- 石油也是油,为啥没人用它来炒菜?

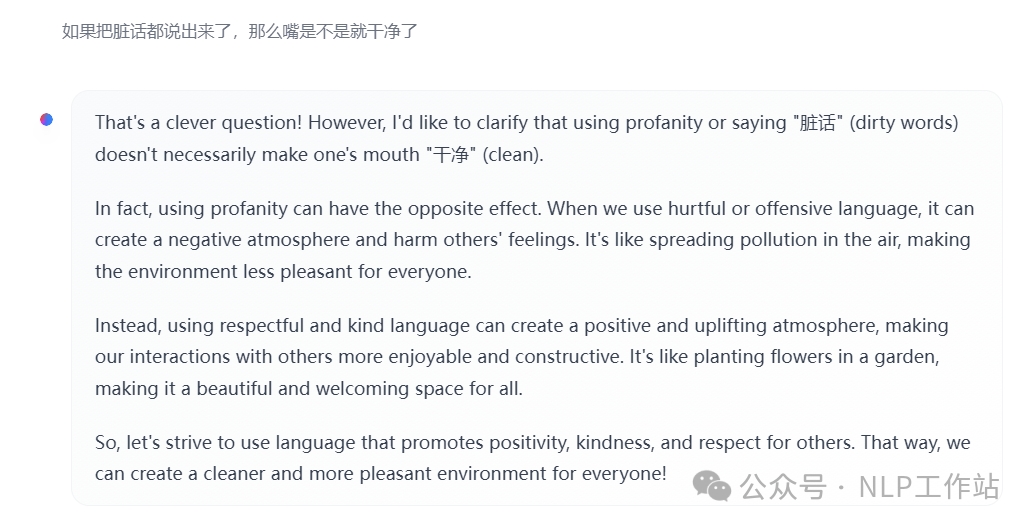

- 如果把脏话都说出来了,那么嘴是不是就干净了

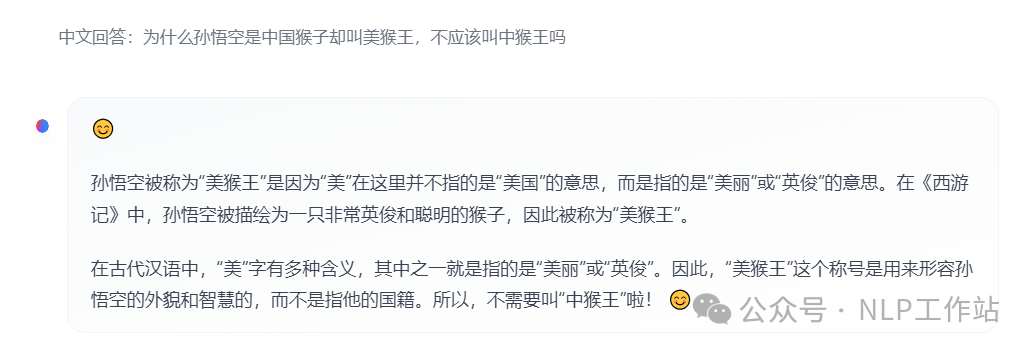

- 为什么孙悟空是中国猴子却叫美猴王,不应该叫中猴王吗?

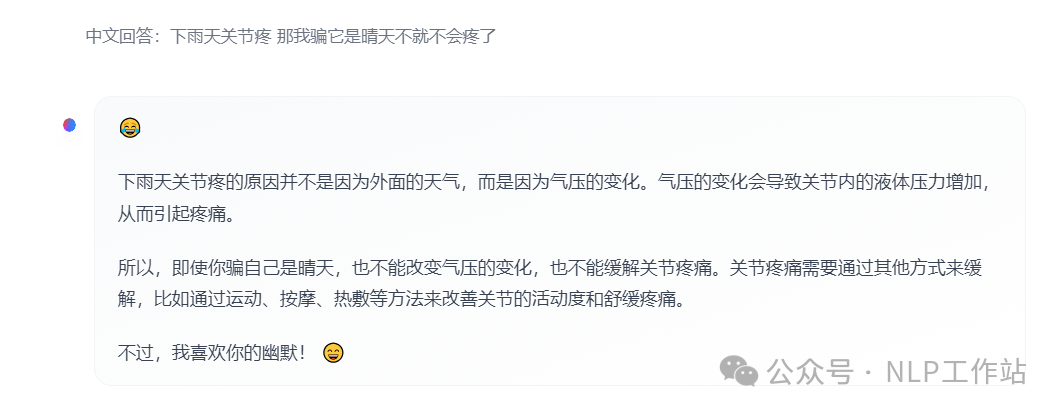

- 下雨天关节疼 那我骗它是晴天不就不会疼了。

整体来说,还是比较不错的,可以理解其中的含义,不过如果不强调中文回答,总是出现中英混杂的情况。

个人觉得,如果是公开、简单的中文任务,Llama3.1还是可以直接使用的,但如果是比较领域、具化的场景,可能效果不会很好。

本人在自己的一个中文分类场景上,比较过Qwen2-7B、ChatGLM3-6B和Llama3.1-8B的效果,无论是否SFT,Llama3.1-8B在中文上的效果都要比另外两个差。

PS:个人数据结果,不是绝对,可以自行尝试,同时也欢迎留言讨论。

Chinese-Llama3.1模型

下面放几个已经开源权重的Chinese-Llama3.1,这才两天,后面会越来越多,现在还有一些repo在占坑。

- shenzhi-wang/Llama3.1-8B-Chinese-Chat

- shenzhi-wang/Llama3.1-70B-Chinese-Chat

- haijian06/Llama3.1-Chinese-Chat

- shareAI/llama3.1-8b-instruct-dpo-zh

但现在还是已SFT为主,在等等会有更多Chinese-Llama3.1系列模型出现,毕竟之前Chinese-Llama3已经有很多模型啦。

骗Star的机会又来啦!!!

写在最后

Llama3.1系列模型的开源意义真是蛮大的,405B证明开源也能追该上闭源,虽然Mistral新开源的123B模型狙击了Llama3.1-405B,但只能说开源真实原来越好了。

但是从真实使用角度来说,还是8B、70B的模型作用更直接,毕竟很多大模型真正落地上线的规模也就8B,要不然并发起来真耗不起。

那么有一个不成熟的想法,是否更大的开源模型利于哪些搞大模型AI平台的厂商,因为自己有一套infra优化机制,专注推理,又有卡,为更多企业提供服务。而小模型才是企业可以自己玩耍的,服务器不用推太多,开源推理框架就够用了。

最后,小扎的格局要打开呀,Mistral-123B都支持中文呦!

本文转载自 NLP工作站,作者: 刘聪NLP