加速AI应用落地,大模型与智能体何以成为“双骄” 原创

嘉宾丨詹坤林

撰稿丨诺亚

出品 | 51CTO技术栈(微信号:blog51cto)

在这个信息爆炸的时代,人工智能正悄然融入生活。然而,将AI技术迅速、高效地转化为实用工具,始终是挑战。在近期的WOT全球技术创新大会上,58同城高级总监、AI Lab负责人詹坤林分享了解决之道:通过使用大模型和AI智能体技术,突破传统AI应用开发的局限,加速其落地,使人工智能成为触手可及的智能伙伴。

1.搭建AI平台,弥合算力到应用之间的巨大鸿沟

詹坤林介绍,“从去年开始我们全面拥抱大模型,尤其是大语言模型。在此背景下,我们构建了我们自己的垂类大语言模型——灵犀大模型(生成式人工智能服务备案编号:Beijing—LingXi—202407050027)。以此为基础,我们对传统的智能对话平台进行了升级,并搭建了我们的智能体平台,核心目的是让我们的AI应用能够快速落地。”

作为知名生活服务平台,58同城的主要业务模式是连接B端与C端用户,促成双方交流,与此同时,近年来也在推动平台内的交易闭环,进行产业化升级,深化产业价值链。

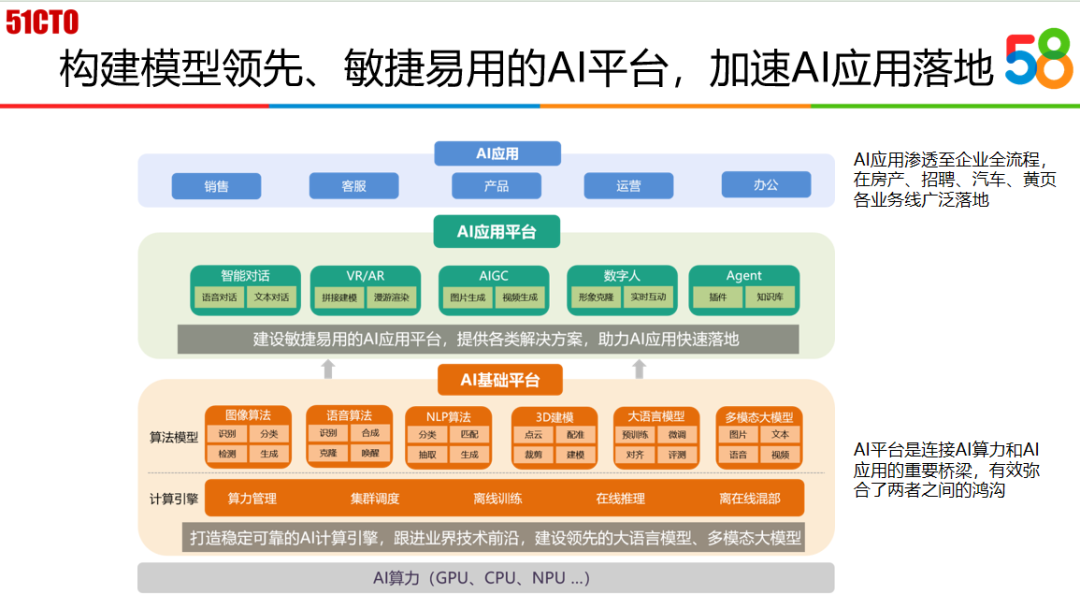

AI Lab作为58同城基础平台部,重点在支撑房产、招聘、汽车、本地服务四大业务线。鉴于从最基础的AI算力到实际的AI应用之间存在巨大鸿沟,AI平台就需要着力搭建桥梁,确保AI应用与算力高效对接,驱动创新实践。

基于这一诉求,AI平台架构分为这样三层:底层为AI计算引擎,统一管理CPU/GPU资源,实现算力调度、模型训练及推理,目标是“模型即服务”。在此基础上,集成图文音算法与大语言模型、多模态模型,供应用方调用构建服务;同时,为加速AI应用,增设AI应用平台层,涵盖智能对话、数字人、Agent等解决方案,使应用方能基于中间的应用平台层的解决方案去快速落地应用;最终,让AI应用渗透至销售、客服、产品及内部办公等全业务流程。

图片

图片

2.构建大模型平台,适应多样化的业务场景和硬件环境

那具体来说要怎么做呢?

詹坤林首先提到了构建大语言模型平台的思路:之所以要打造这样一个平台,一则是因为AI Lab作为平台部门需要提供一个能够满足各业务线需求的通用平台,使大家能够便捷地利用大模型,避免重复造轮子;二则基于这样的认知——通用的大语言模型结合Prompt提示在某些应用场景下可能难以满足特定需求,需要应用方基于特定应用场景进行模型的微调。

在这样的思路指引下,建设路径也渐趋清晰:构建一套支持大语言模型训练、推理的平台,集成各类开源通用大模型,供应用方调用和微调。

落到实处,平台建设遵循了这一路径:集成了主流开源大模型,并嵌入LoRA、QLoRA微调算法及MoE训练策略,支持从模型微调到一键部署的全流程。应用方仅需上传数据,选择微调方法,即可快速上线定制模型,利用开源推理框架如vLLM实现高效推理。

与此同时,詹坤林强调,有了平台还不够,还需要持续追踪业界进展来不断优化。比如,采用MoE架构,通过分割大模型为小模块,减少推理时所需参数,优化GPU资源利用;再比如,针对GPU稀缺场景,采用S-LoRA技术,可以在同一张GPU卡上部署和运行多个微调过的模型,显著降低部署成本。

3.打造垂类大模型“灵犀”,为具体业务场景量体裁衣

在58同城的创新之旅中,除了构建大模型平台之外,打造垂类大模型是另一个重点。

考虑到58同城特有的房产、招聘等垂直场景,通用大模型往往因缺乏针对性数据而在这些领域表现平平。因此,AI Lab在搭建平台之外开始着手开发专属于58的垂直大模型,以期获得更佳的场景适应性和表现效果。

据詹坤林介绍,为了避免从0到1的高昂成本,他们决定在开源模型基础上,利用58同城丰富的业务数据进行增量预训练,从而平衡模型性能与资源消耗。

训练过程分为三个阶段,融入58业务数据的同时引入公共数据,然后进行精心配比,确保模型既能够吸收特定领域的知识,又能够保留通用语言模型的能力,避免灾难性遗忘的问题,之后再进行微调和对齐,确保其在特定任务上的表现达到最优。

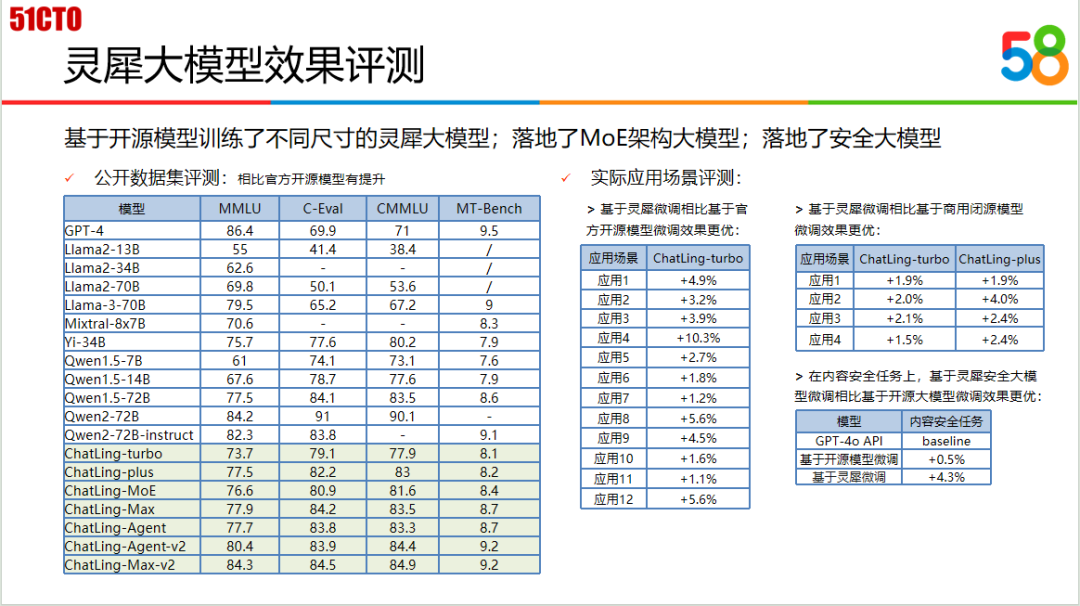

在评测效果方面,灵犀大模型经公开数据集与内部场景双重评测,相较于同尺寸开源模型,在特定指标上展现优势。另外,安全模型的开发尤为关键,针对内容审核需求,如涉政、涉黄信息识别,灵犀安全大模型在与GPT4的对比中也展现出显著优势。

图片

图片

目前,58同城灵犀大模型已经正式通过生成式人工智能服务备案(模型名称:灵犀,备案单位:北京五八信息技术有限公司,上线备案编号:Beijing—LingXi—202407050027)。点击可见

詹坤林还提到,在某些场景下,基于百亿参数的模型去打造应用,相比千亿参数模型更有优势。“去年,在业界未开源大参数模型时,我们的百亿参数模型效果和性能媲美甚至优于某闭源千亿参数模型,证明小规模模型亦可高效应对复杂场景。”

为满足不同技能水平团队的需求,58同城AI Lab构建了全面的大模型API体系,不仅允许迅速部署内部模型,确保新模型发布后能即时上线,而且整合了市场上的商用大模型API,简化了调用流程。

依托这套逻辑,AI平台与应用方的合作形式灵活多样:应用方可直接在平台上微调模型;也可以采用垂直模型定制解决方案;即使是缺乏技术背景的团队也可以直接收获一站式服务。

4.建设AI Agent平台,按下应用落地加速键

需要承认的是,对于不少应用方,尤其是小型团队开发者来说,微调大模型还是成本过高、耗时过长。为此,58同城AI Lab以灵犀大模型作为大脑驱动,构建了一套AI Agent平台,旨在加速AI应用落地。

詹坤林简单说明了这套智能体平台的构建过程:他们基于开源模型微调出适应Agent场景的模型,强化角色扮演(如扮演HR或销售)和工具调用能力。经过优化,不仅提升了工具调用的准确性,还增强了模型的通用性能。

平台的关键特色之一是自主研发的RAG功能,允许上传文档以构建知识库,从而丰富AI的回答。工作流自动化使得AI Agent能独立执行任务。

区别于业界其他智能体平台只能在自有生态下生成智能体页面,该平台可以生成智能体API,提供的API便于开发者将智能体无缝整合进自定义应用,极大地提高了灵活性和创新空间。

对比多家智能体平台,实测表明,在综合场景下,因对文本向量化和大模型进行了针对性微调,平台的RAG方案优势明显借助此技术,运营方即使无算法团队,也能通过AI Agent平台快速搭建应用。只需上传文档,系统便自动完成解析、向量化、检索与排序,由大模型完成回答,大幅简化了文档问答的实现过程。

目前58同城正全面应用大模型技术,涉足销售、客服、用户体验和内部办公等多个领域,已成功部署逾50款AI应用。

以销售培训场景为例,58同城面对高流动性的电销团队,新员工需迅速掌握销售技巧。传统培训耗资费时,涉及大量人力一对一指导话术。为解决此问题,引入了基于大模型的角色扮演机器人作为陪练,它能模仿优秀销售的沟通方式及不同客户的反应,帮助新员工通过互动学习提高销售技能,减少真人培训的成本。

再比如,在内部办公和研发效率方面,SQL智能助手优化了数据分析流程。这款工具专注于生成SQL语句、自动纠错以及响应自然语言查询,例如快速获取部门收入数据或图表展示,极大提升了决策者和业务团队获取关键信息的速度,减少了编写复杂查询的需求。

5.结语

最后,詹坤林分享了他关于大模型开发与应用的实践总结:

第一,对于专注于特定垂直领域的公司而言,基于开源大模型开发的垂直模型展现出了显著的优势。

第二,参数量并非决定一切。不必对于模型大小过度焦虑,选择模型时应更加注重具体应用场景的需求。

第三,无论是垂直模型的构建,大模型平台的搭建,还是智能体平台的开发,所有努力的共同目标都是为了孵化出具有重大影响力的应用。

总而言之,企业应该采取开放态度,积极利用大模型的力量,通过定制化和开放合作,寻求在垂直领域内创造对业务具有高价值、高影响力的新型应用,这一趋势有望在未来几年内持续发展并带来行业变革。

本文转载自51CTO技术栈,作者:诺亚