回复

Meta正式发布Llama-3.1,超大杯405B!千呼万唤始出来!

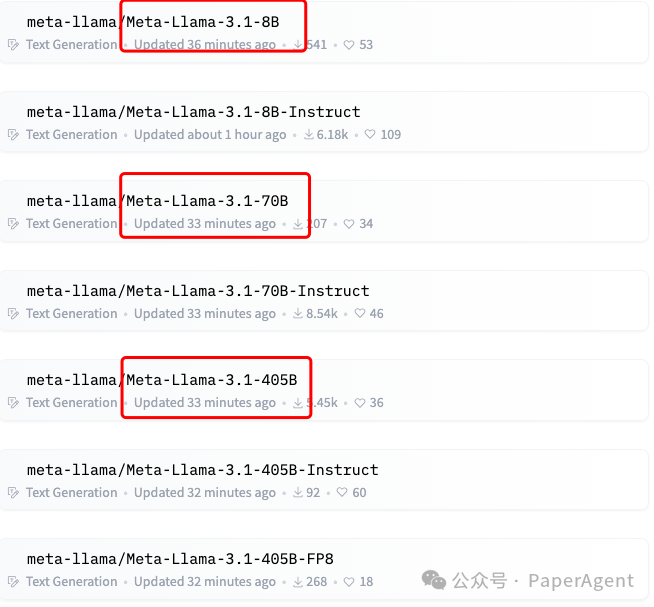

Meta的Llama-3.1再经历过泄露、再泄露事件,酝酿了几天,终于在2024.7.23最后十几分钟发布了,包括8B、70B、405B三个尺寸:

Llama-3.1系列模型特点

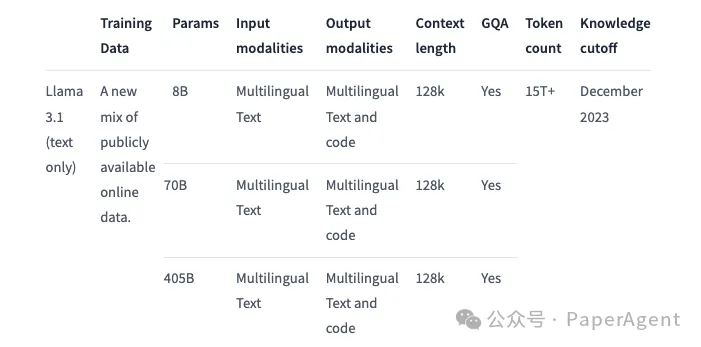

- Llama 3.1 是一个自回归语言模型,使用优化的变换器架构。调整版本使用监督式微调(SFT)和基于人类反馈的强化学习(RLHF)以符合人类对有用性和安全性的偏好。

- 提供 8B、70B 和 405B 三种大小的模型。

- 预训练数据来自公开可用的在线数据,微调数据包括公开可用的指令数据集以及超过 2500 万个合成生成的示例。

- 支持英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。

- 支持多语言文本输入和输出,以及代码。

- 上下文长度为 128k。

- 知识截止日期为 2023 年 12 月。

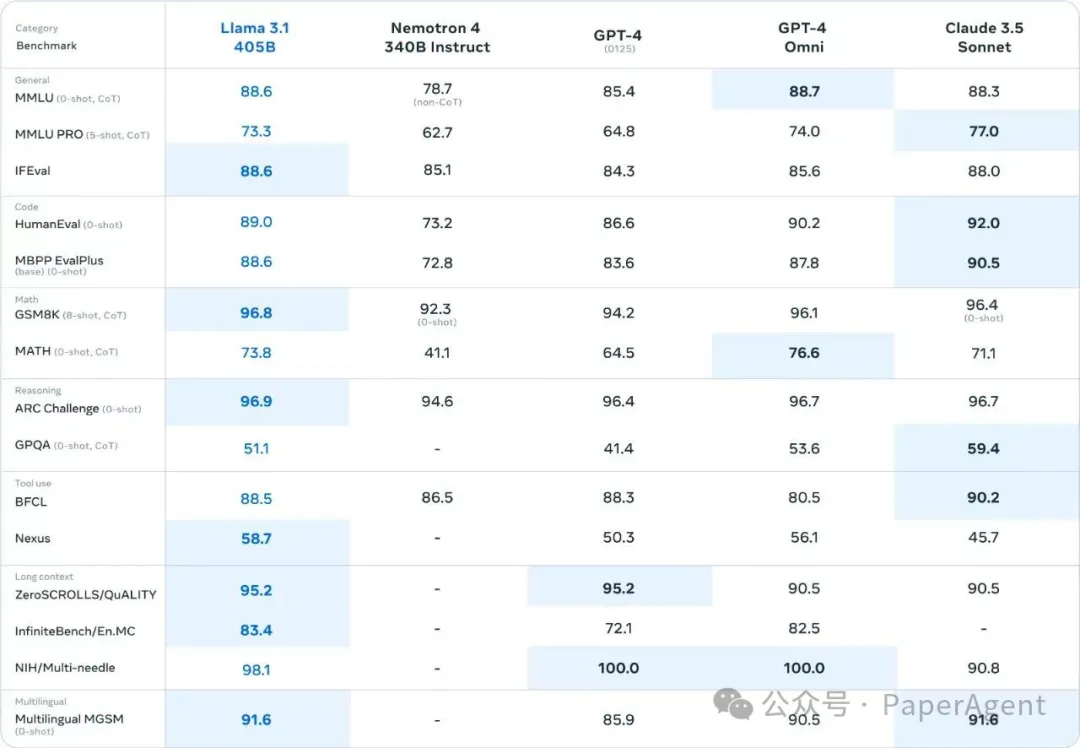

Llama-3.1-405B模型效果评测,整体效果是超过GPT-4与GPT-4 Omni,效果媲美Claude 3.5 Sonnet。

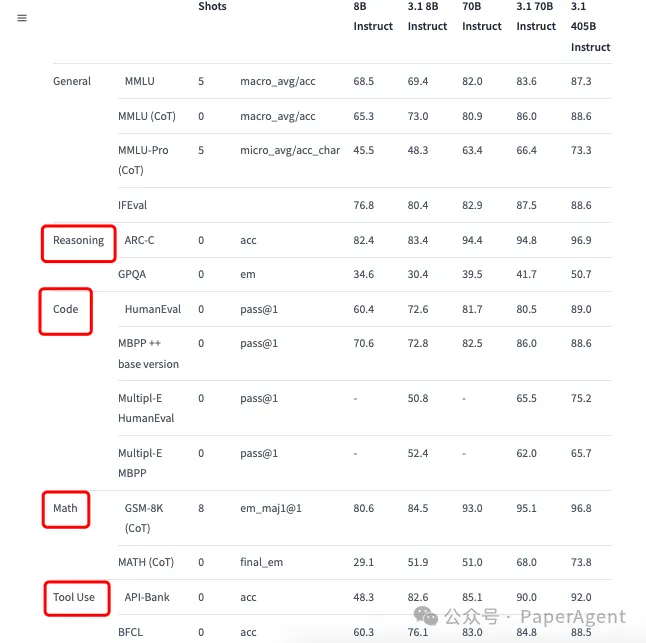

Llama-3.1垂直场景的效果展示:推理、编码、数学、工具使用(Tool Use)。

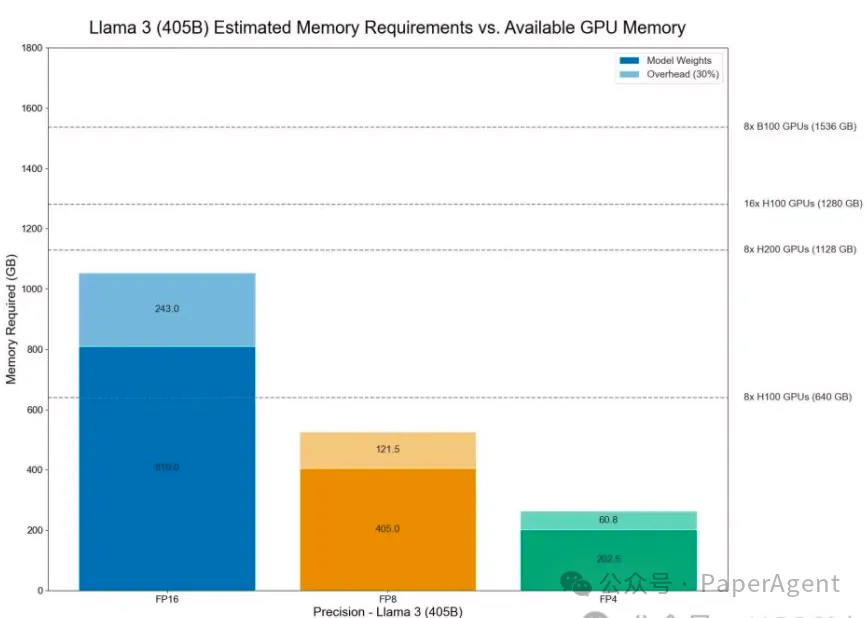

此次发布,大家最关系当属405B,这是此前Llama-3中未发布的尺寸,那么这么大参数模型,需要多大的机器能run起来尼?

- FP16大概需要8*H200 GPUs(1053G)

- FP8大概需要8*H100 GPUs (526G)

- FP4大概需要263G

本文转载自 PaperAgent ,作者: PaperAgent

赞

收藏

回复

相关推荐