Meta 开源最强大模型Llama 3.1,参数多达 405B,超16000块H100训练,燃烧数亿经费!小扎:坚定开源不动摇! 原创

出品 | 51CTO技术栈(微信号:blog51cto)

GPT-4o mini 刚刚将人们的目光吸引到小模型的浪潮上。

而新王Meta直接开大,开源了自己4050亿参数大模型,也是超越GPT-4o的最强模型。

与几个月前推出的小型Llama 3模型相比,Llama 3.1复杂得多。4050亿参数作为其最大的版本,使用超过16,000个Nvidia的高价H100 GPU进行训练。Meta没有透露开发Llama 3.1的成本,但仅从Nvidia芯片的成本来看,可以推测其费用达到数亿美元。

不仅如此,小扎还在Meta官网上发表了《开源是AI前进道路》的长文,他预测“从明年开始,我们预计未来的Llama模型将成为行业中最先进的模型”。

如果这个预言成真,我们就会迎来OpenAI追着Meta跑的新时代。

图片

图片

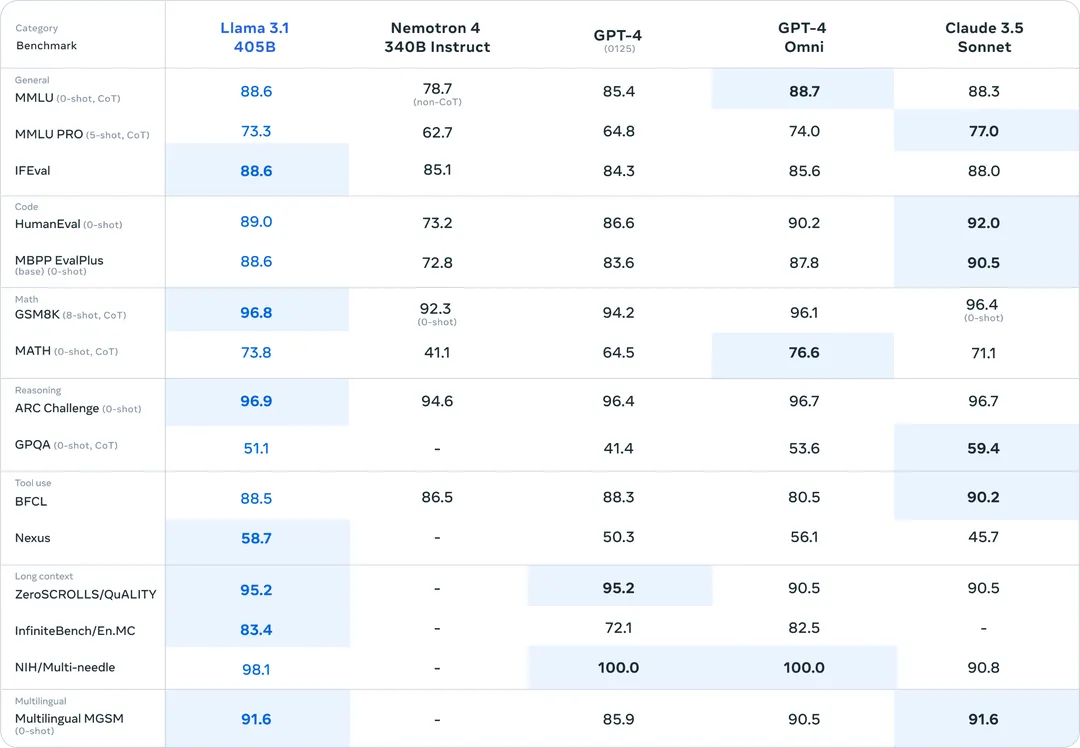

作为Meta向开源标杆迈进的重要一步,Llama 3.1 405B是名副其实的强大,在一众闭源前沿模型中完全不虚,拿到了多个任务的SOTA。

图片

图片

Github地址:

https://github.com/meta-llama/llama-models

huggingface地址:

https://huggingface.co/meta-llama/Meta-Llama-3.1-8B/tree/main

一、合成数据的胜利

Meta将Llama 3.1的4050亿参数版本用于蒸馏较小的70亿和8亿参数版本,并表示训练中使用了大量的合成数据,即由模型而非人类生成的数据。

405B 模型采用了3种合成数据方法来提升自身的代码能力,包括代码执行反馈、编程语言翻译和文档反向翻译。

当媒体采访Meta是否同意业界关于训练模型的高质量数据即将耗尽的共识时,Meta生成AI副总裁艾哈迈德·阿尔-达勒暗示确实有一个上限,尽管可能比一些人想象的要远。“我们认为我们还有几个训练的机会,”他说,“但很难确定。”

二、Llama生态进一步扩张

Meta更新了许可证,首次允许开发人员使用包括405B参数规模的Llama模型的输出来改进其他模型。

在Meta公司博客上发布的一封信中,扎克伯格称,开源AI模型将超越——并且已经比——专有模型发展得更快,类似于Linux如何成为今天大多数手机、服务器和小工具的开源操作系统。

扎克伯格将Meta对开源AI的投资比作其早期的开放计算项目,他说该项目通过让像惠普这样的外部公司帮助改进和标准化Meta的数据中心设计,为公司节省了“数十亿美元”。

展望未来,他预计同样的动态将出现在AI领域,他写道:“我相信Llama 3.1的发布将成为行业的一个转折点,大多数开发者将开始主要使用开源。”

为了帮助推广Llama 3.1,Meta正在与包括微软、亚马逊、谷歌、Nvidia和Databricks在内的两打公司合作,帮助开发者部署自己的版本。Meta声称,Llama 3.1在生产中的运行成本约为OpenAI的GPT-4o的一半。它发布了模型权重,供公司使用定制数据进行训练和调优。

三、Meta自己还在蹚产品的路

走开源路的Meta把壁垒瞄准了产品,Llama的实现被规划为AI助手。

小扎预测,到今年年底,Meta AI将成为使用最广泛的助手,超过ChatGPT。

Llama 3.1将会赋能给一系列Meta系应用,从本周开始,Llama 3.1将在美国首先通过WhatsApp和Meta AI网站提供。在接下来的几周内,Instagram和Facebook上也将上线这些能力。模型还将支持新的语言,包括法语、德语、印地语、意大利语和西班牙语。

尽管Llama 3.1最先进的4050亿参数模型可免费用于Meta AI,但在一周内超过指定数量的提示后,助手将切换到更缩减的70亿参数模型。这表明4050亿参数模型在大规模运行中对Meta来说过于昂贵。

四、开源到底:三方共赢的AI之路

每次Meta发布新模型时,小扎都会再次重申自己的开源信仰。

这次,在自己的长文中,扎克伯格描述了一个开发者、Meta以及世界三方共赢的开源之路,详尽描述了他为何会走开源之路。以下节选了文中的重要观点:

1.开源AI对开发者有利

当我与全球的开发者、CEO和政府官员交谈时,通常会听到几个主题:

我们需要训练、微调和蒸馏我们自己的模型。每个组织有不同的需求,这些需求最好由使用其特定数据训练或微调的不同规模的模型来满足。设备上的任务和分类任务需要小模型,而更复杂的任务需要大模型。现在,你可以使用最先进的Llama模型,继续用自己的数据训练它们,然后将其蒸馏成最适合你的模型规模——而无需我们或其他任何人看到你的数据。

我们需要控制自己的命运,而不是被锁定在一个闭源供应商中。许多组织不希望依赖他们无法运行和控制的模型。他们不希望闭源模型提供商能够改变他们的模型、修改使用条款,甚至完全停止服务他们。他们也不希望被锁定在拥有模型专有权的单一云上。开源使得你可以轻松地在兼容的工具链公司之间移动。

我们需要保护我们的数据。许多组织处理敏感数据,需要确保这些数据的安全,不能通过云API发送到闭源模型。其他组织则根本不信任闭源模型提供商。开源解决了这些问题,因为你可以在任何你想要的地方运行模型。众所周知,开源软件通常更安全,因为它是以更透明的方式开发的。

我们需要一个高效且经济实惠的模型。开发者可以在自己的基础设施上运行Llama 3.1 405B进行推理,其成本大约是使用闭源模型(如GPT-4o)的50%,无论是用户界面还是离线推理任务。

我们希望投资于长期标准的生态系统。很多人看到开源的进展速度比闭源模型更快,他们希望在能给他们带来长期优势的架构上构建系统。

2.开源AI对Meta有利

人们经常问我是否担心通过开源Llama放弃技术优势,但我认为从几个方面来看这忽略了大局:

首先,为了确保我们可以访问最好的技术,并且不会在长期内被锁定在闭源生态系统中,Llama需要发展成一个完整的生态系统,包括工具、高效改进、硅优化和其他集成。如果只有我们一家公司使用Llama,这个生态系统就不会发展,我们也不会比闭源Unix的变体更好。

其次,我预计AI开发将继续非常具有竞争性,这意味着开源任何给定的模型并不会在某一时间点上给予下一个最好的模型一个巨大的优势。Llama成为行业标准的路径是通过一代又一代地始终保持竞争力、高效和开放。

第三,Meta和闭源模型提供商之间的一个关键区别是,出售AI模型访问权不是我们的商业模式。这意味着公开发布Llama不会像闭源提供商那样削弱我们的收入、可持续性或研究投资能力。(这也是为什么一些闭源提供商一直在游说政府反对开源的原因之一。)

最后,Meta有着长久的开源项目和成功历史。通过发布我们的服务器、网络和数据中心设计到Open Compute Project并让供应链标准化我们的设计,我们节省了数十亿美元。通过开源领先的工具(如PyTorch、React以及许多其他工具),我们也从生态系统的创新中受益。这种方法在我们长期坚持时一直对我们有效。

4.开源AI对世界有利

我相信开源是一个积极AI未来的必要条件。AI比任何其他现代技术都更有潜力提高人类生产力、创造力和生活质量——并在加速经济增长的同时推动医学和科学研究的进步。开源将确保世界上更多的人能够获得AI的好处和机会,权力不会集中在少数几家公司手中,并且技术可以更均匀和安全地部署在整个社会中。

关于开源AI模型的安全性存在持续的辩论,而我的观点是开源AI将比替代方案更安全。我认为政府会得出这样的结论,即支持开源符合他们的利益,因为这将使世界更加繁荣和安全。

参考链接:1.https://www.theverge.com/2024/7/23/24204055/meta-ai-llama-3-1-open-source-assistant-openai-chatgpt

本文转载自51CTO技术栈