YYDS!数字人终于实现穿、脱衣自由!上大、腾讯等提出3D服装合成新方法:ClotheDreamer 精华

文章链接:https://arxiv.org/pdf/2406.16815

项目地址:https://ggxxii.github.io/clothedreamer

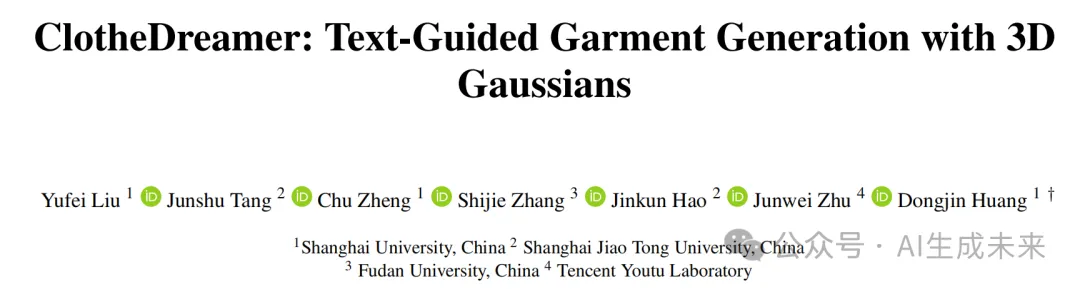

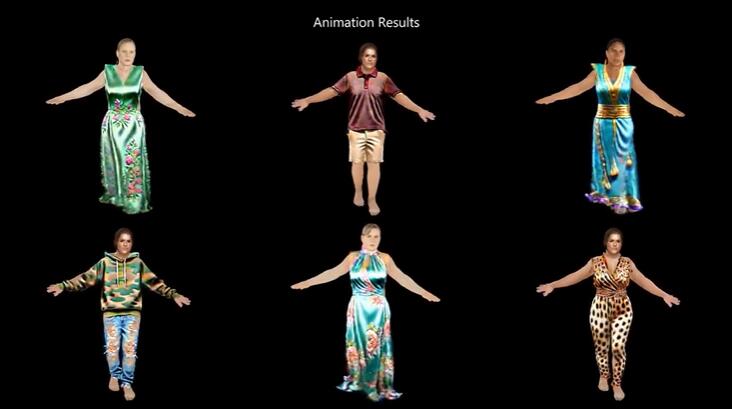

高保真度的基于文本的3D服装合成对于数字化人物创建是可取的,但也具有挑战性。最近基于扩散的方法,通过评分蒸馏抽样(SDS)实现了新的可能性,但要么与人体紧密耦合,要么难以重复使用。

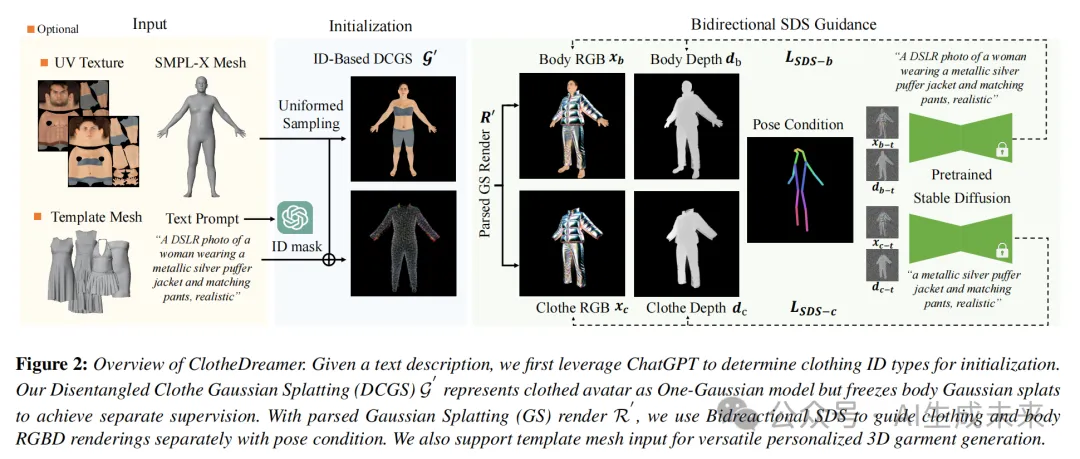

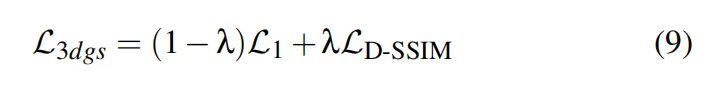

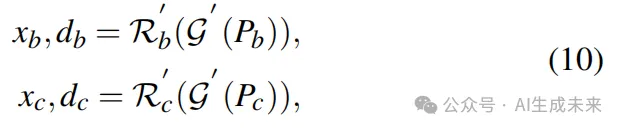

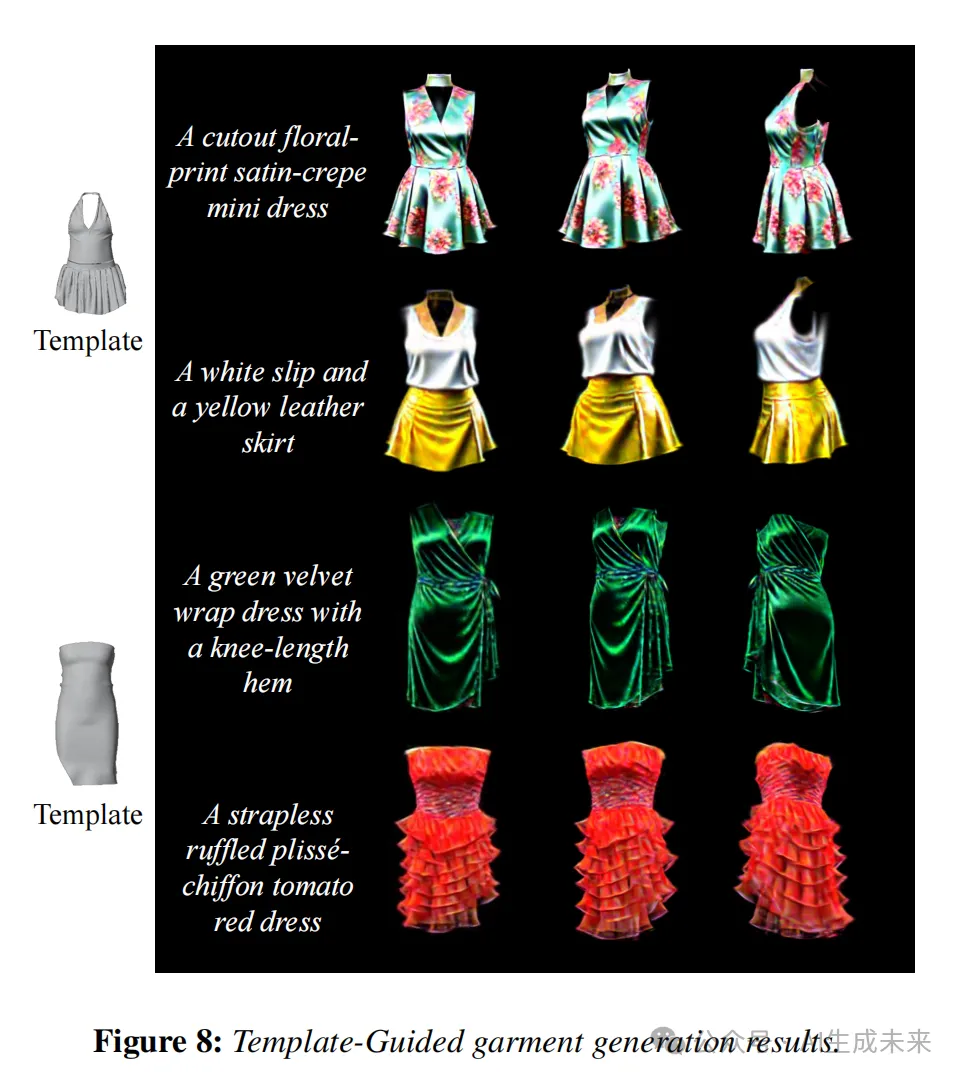

本文引入了ClotheDreamer,这是一种基于3D高斯的方法,用于从文本提示生成可穿戴的、适合生产的3D服装资产。本文提出了一种新颖的表示方法,称为解耦服装Gaussian Splatting(DCGS),以实现分离优化。DCGS将着装的人物头像表示为一个高斯模型,但冻结了身体高斯斑点。为了提高质量和完整性,本文结合了双向SDS来监督着装的人物头像和服装的RGBD渲染,分别带有姿势条件,并提出了一种新的宽松服装修剪策略。

本文的方法还可以支持自定义的服装模板作为输入。通过本文的设计,合成的3D服装可以轻松应用于虚拟试穿,并支持物理精确的动画。广泛的实验展示了本文方法优越且具有竞争力的性能。

亮点直击

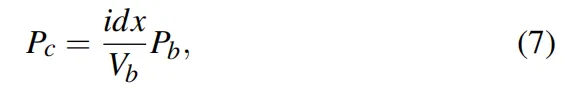

- 本文引入了ClotheDreamer,这是一种结合了解耦服装Gaussian Splatting(DCGS)的新型3D服装合成方法。本文的技术通过基于ID的初始化,有效地将服装与人体分离,便于从文本提示生成多样化且可穿戴的服装资产。

- 本文提出了双向SDS指导,以高效地正则化服装高斯的基础几何,并提出了一种修剪策略,以增强宽松服装的完整性。

- 本文的方法通过模板网格指导支持定制化服装生成,并通过模拟网格先验实现准确的服装动画。广泛的实验表明,ClotheDreamer在文本一致性和整体质量方面优于现有方法。

方法

在本文中,本文介绍了一种基于3D高斯的高保真可重复使用3D服装生成方法,命名为ClotheDreamer。本文的框架概述如下图2所示。为了改善合成服装与人体的互动,本文提出了一种新颖的解耦服装Gaussian Splatting(DCGS),将穿着的身体部分分为SMPL身体部分和服装部分。在第一部分中,本文根据文本指令开始使用来自SMPL的相对语义ID初始化DCGS。然后提出通过操控优化梯度来学习身体部位和服装之间的解耦。在第二部分中,本文介绍了对单个渲染的双向SDS指导和一种新的宽松服装修剪策略。在第三部分中进一步展示了本文框架的有效性,可以实现模板引导生成,以简化定制化。最后展示了合成服装在多样化身体动作下的动画过程。

Zero-shot服装生成

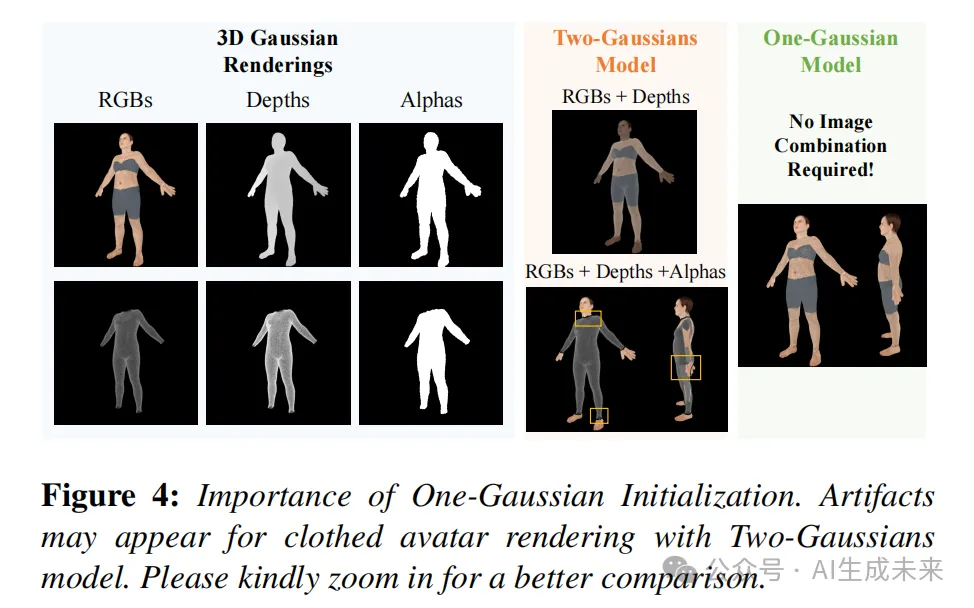

基于ID的DCGS初始化。人类服装展示了多样且复杂的形状。以前的方法使用 SfM 点或 Shap-E 和 Point-E 生成的通用点云作为初始点,这在人体类别中表现不佳,难以提供强有力的先验。最近一种流行的初始化选择是使用一致的身体模型,如 SMPL 或 SMPL-X,因为它们结构良好且可参数化以进行优化。然而,这些方法通常在整个身体网格表面上采样点,使得难以单独操控服装。

本文在每次反向传播过程后跟踪采样的身体点,并屏蔽它们的梯度。在自适应密度化过程中,本文屏蔽了高斯位置梯度积累张量,以在光栅化之前使用部分有效梯度进行更新。此外,本文仅选择服装点进行密度化或修剪确定,以减少计算成本。

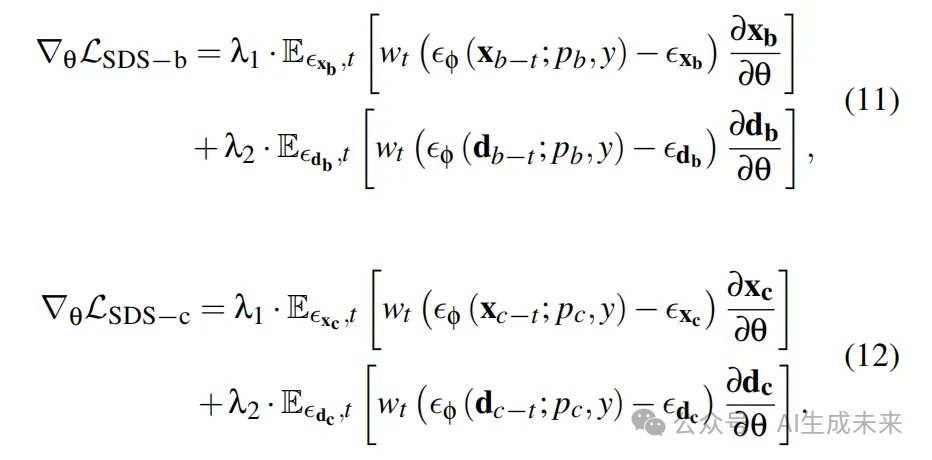

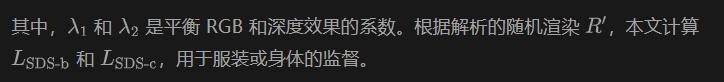

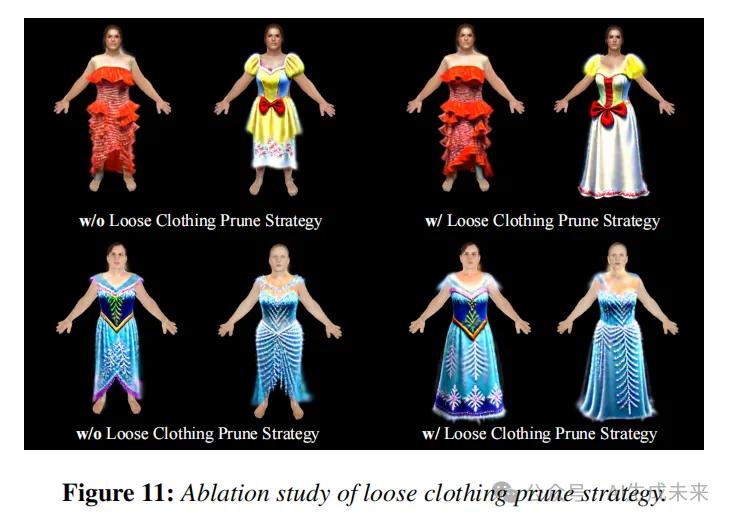

双向SDS引导

本文观察到双向 SDS 指导可以提升生成服装的质量并减少高斯伪影,详见后面消融实验结果。然而,SDS 监督可能不稳定并导致服装几何形状失真。LZT*23 中的尺寸条件高斯修剪策略在仅修剪阶段通常是有效的,但可能误删对于宽松服装(如长裙、礼服)有用的高斯点。如下图5所示,在优化的早期阶段可以获得合理的结果。然而,由于不恰当的修剪策略,大量有用的高斯点被剪除,导致生成结果不理想。因此,本文提出针对宽松服装生成的新的修剪策略。本文在训练的中期仅进行一次修剪,并增加尺度因子范围作为条件。这确保了消除过度拉伸的点同时保持生成服装的完整性。具体细节请参见实验部分。

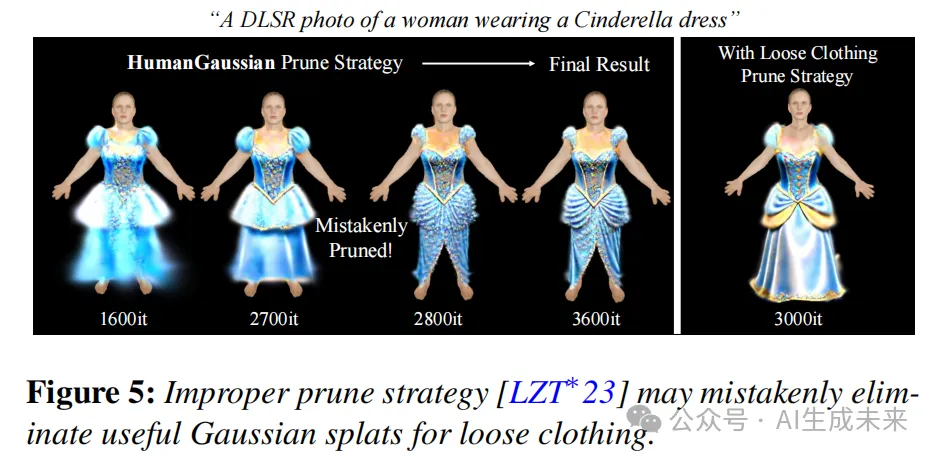

模板引导的服装生成

为了增加个性化实用性,本文展示了一种新颖的技术,用于通过自定义模板服装网格来引导 3D 服装生成。模板网格旨在作为整体形状指导服装生成的基础。本文的目标是鼓励高斯点在一般情况下靠近输入网格形状,但不局限于表面位置。实现这一目标的初始方法是在零射击DCGS初始化期间改变采样的服装点。然而,自定义模板网格可能具有非常不同的比例和位置信息。简单地改变服装采样点会导致3D高斯点位置错误。

因此,本文首先将输入的模板服装和 SMPL-X 网格移动到它们的中心,以在世界空间中进行位置对齐。然后,在局部空间中,将两组顶点连接起来进行统一的缩放和变换。在变换后分别跟踪每个部分并采样3D高斯点。通过基于网格的原始方法,可以从文本描述中生成多样化的服装几何形状和纹理细节,同时利用初始点来约束整体的服装风格。使用Marvelous Designer 创建的服装,如下图8所示,展示了一些模板引导的服装生成结果。

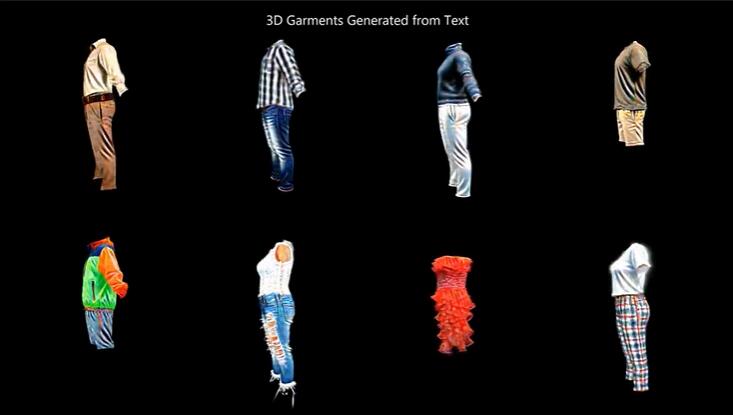

动画化DCGS服装

本文展示了两种可能的方法来动画DCGS服装资产。对于贴身服装(例如衬衫、短袖、牛仔裤), 本文将训练好的高斯化身注册为 SMPL-X,并使用一系列SMPL-X 姿势参数进行动画化。然而,这个过程将生成的高斯视为一个集成模型,并且在尝试动画宽松服装(如长袍、裙子、长裙)时遇到困难。下部服装高斯分别绑定到 SMPL-X 的腿部,导致动画过程中的撕裂伪影。通过本文的表示,生成的服装完全与化身体分离,本文建议使用模拟网格来有效地动画生成的DCGS服装。

基于网格的服装动画。受益于高斯明确的表示,可以将生成的高斯资产视为点云。本文旨在利用时间上的模拟网格作为先验来驱动服装点。Marvelous Designer是一款强大和先进的3D虚拟服装模拟软件,利用物理参数进行操作。通过模拟的服装网格序列,可以通过以下三个步骤轻松地对本文的DCGS资产进行动画化:1. 迭代最近点(ICP)注册;2. K维树绑定;3. 高斯变换。本文首先使用 ICP 注册进行 DCGS 资产与第一个模拟网格之间的粗略对齐。为了加速和精细化最近邻搜索,本文构建 KD 树以找到每个服装高斯的最近网格点。本文利用网格顶点之间的变形来计算服装高斯的变换。需要注意的是,本文的方法能够使用一个模拟的网格序列来动画多个形状相似的服装。

实验

定性比较

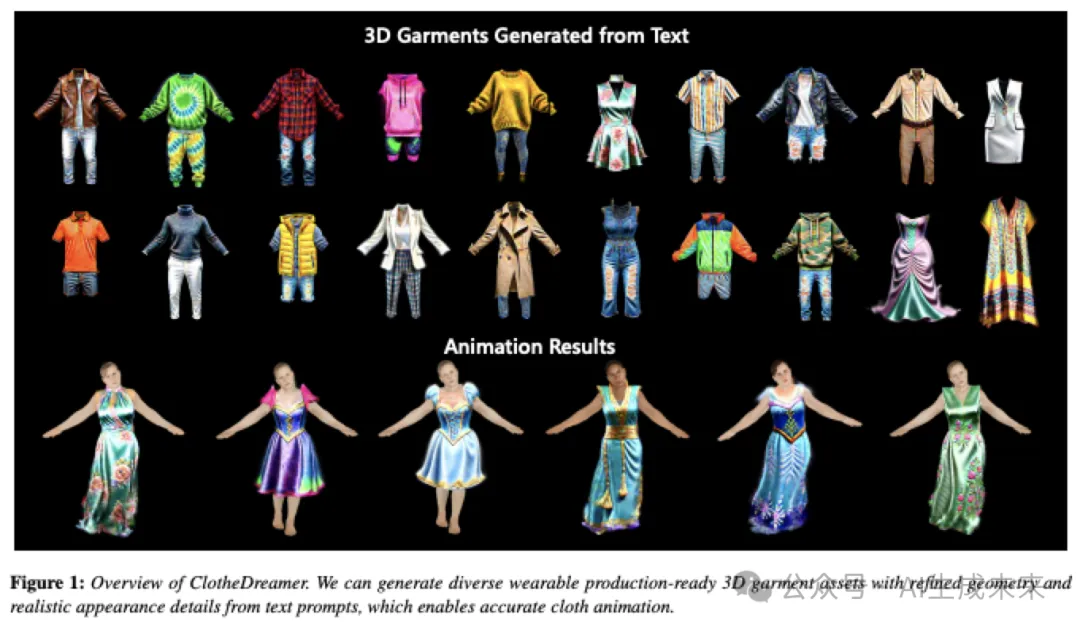

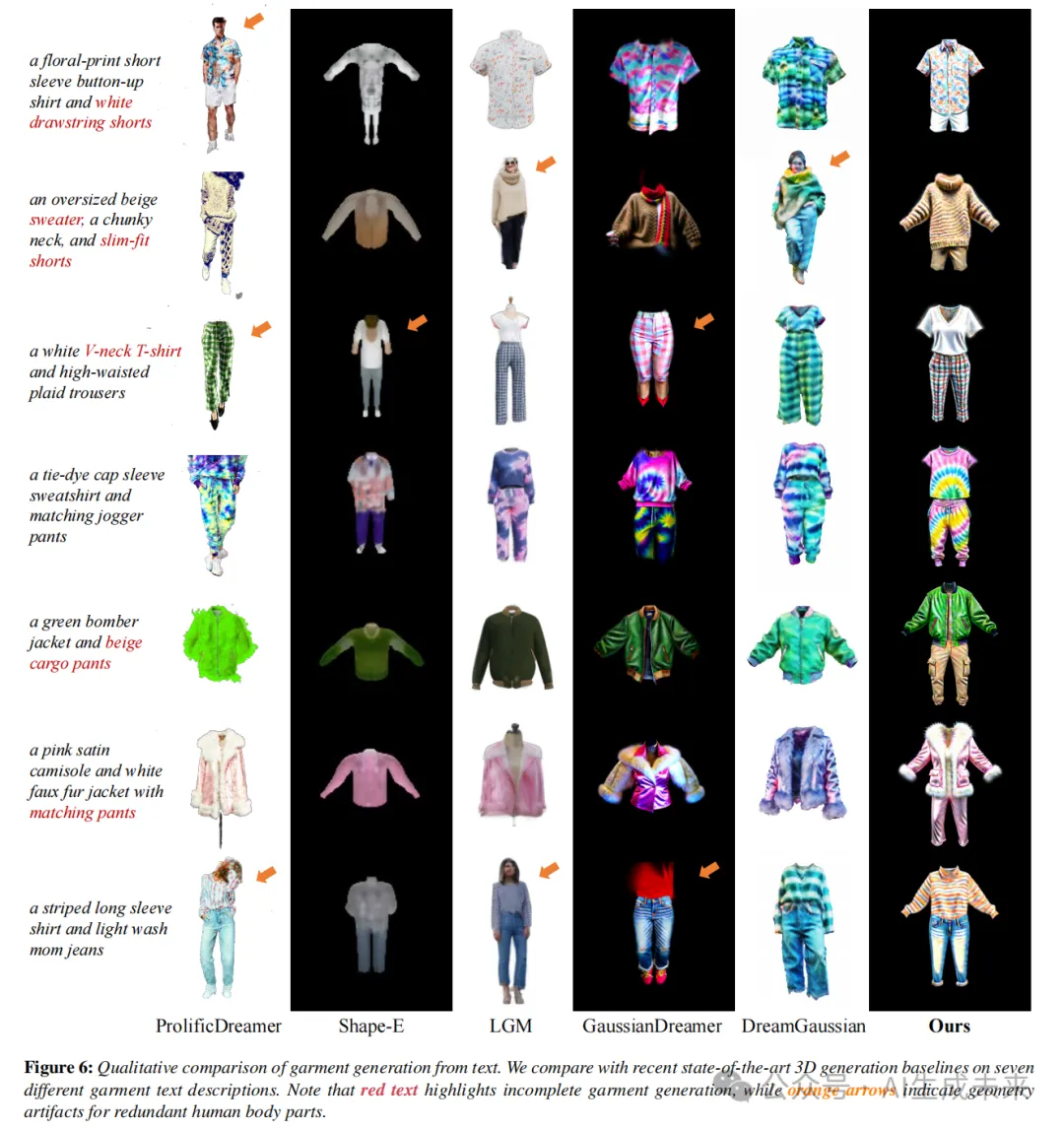

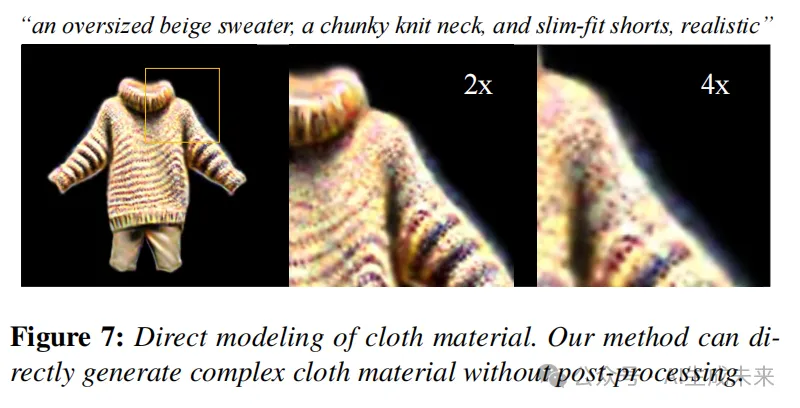

本文将 ClotheDreamer 与最新的文本引导 3D 生成方法进行了比较,包括基于网格的Shap-E、基于神经辐射场(NeRF)的ProlificDreamer、以及基于高斯的LGM、GaussianDreamer、DreamGaussian。本文使用GPT-4 生成了100个描述,并随机选择了6个进行定性比较。如下图6所示,本文的生成结果在整体质量和几何纹理的精细度方面均达到最高水平。需要注意的是,比较的方法往往会生成不完整的服装,或者在某些情况下生成额外的人体部位。此外还可以看到,得益于3D高斯表示,如下图7所示,本文的方法能够生成复杂的衣物材质,例如针织纱线的蓬松外观。

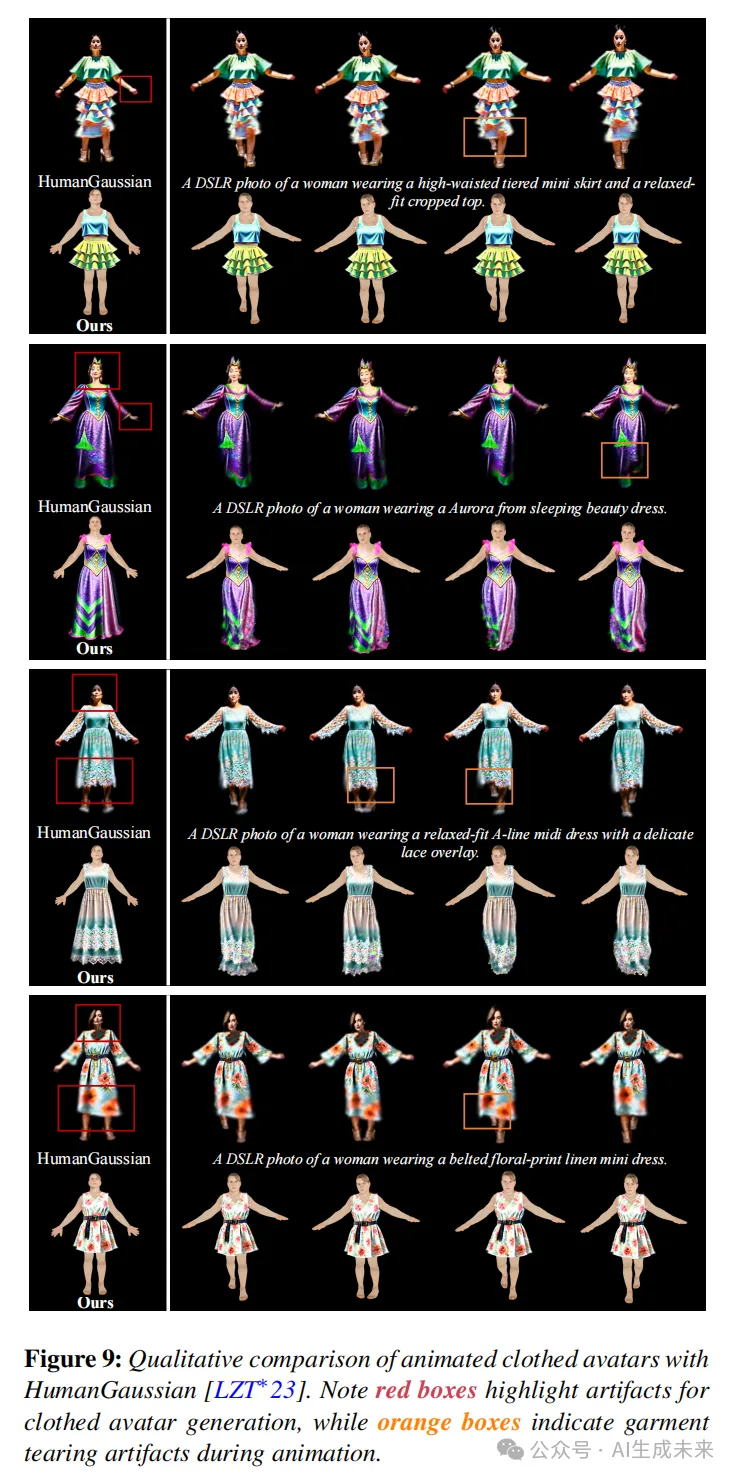

本文在上图8中展示了一些模板引导的服装生成结果。模板网格在整体上指导了几何形状,但不会限制细节部分。本文还在图9中与 HumanGaussian 的穿衣头像生成和动画进行了比较。HumanGaussian 生成的头像与身体集成,往往会导致手部模糊以及衣物上的头部阴影问题。同时,它也难以处理宽松的服装(例如短裙、长裙)。本文使用了两个模拟网格序列,并比较了相同动作下 HumanGaussian 的穿衣头像动画。从180帧中随机选择4帧。直接将整个头像绑定到SMPL-X上并使用线性混合蒙皮(LBS),HumanGaussian动画会产生许多伪影,特别是在膝盖区域。

定量比较

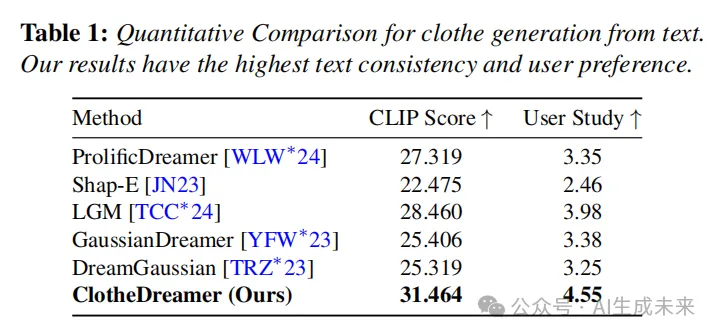

从文本生成的3D服装渲染结果应在参考视图下与输入文本高度相似,并在新视图下展示与参考视图一致的语义。本文使用CLIP评分来评估这两个方面,该评分计算新视图与参考视图之间的语义相似性。本文为每种方法生成100个结果,并采用各自的训练设置。随机选择每个渲染视频中的4帧来计算CLIP评分。如下表1显示,本文的方法在文本一致性方面取得了最佳成绩。

用户研究。本文进一步进行了用户研究,以评估从文本生成的服装。本文收集了20名参与者对30个比较对的600个反馈。要求参与者根据每种方法的整体质量和与给定提示的一致性进行评分(1-6)。如上表1所示,本文的方法获得了最高的偏好评分。

消融研究

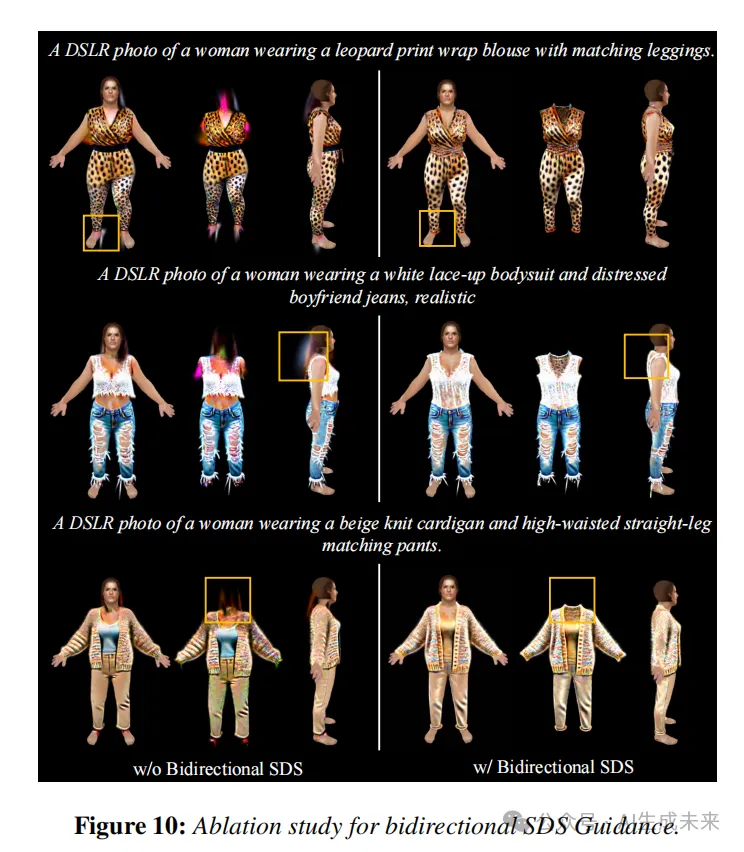

Bidirectional SDS 的效果。在下图10中,本文设计了一个变体,通过去除对单独的服装渲染的额外SDS指导来进行实验。观察到生成的服装质量明显低于本文的方法,尤其是在角色头部区域周围,容易生成多余的浮动高斯伪影。这与本文的直觉一致,即需要对服装进行额外的单独指导以获得更好的服装生成效果。相比之下,本文的双向SDS指导能产生更干净和稳健的生成结果。

松散服装剪枝策略的效果。在图11中,本文设计了一个变体,通过采用 HumanGaussian 中使用的剪枝策略进行实验。将缩放因子作为剪枝条件被证明是消除冗余高斯斑点的有效方法。然而,在松散服装的情况下,鸟窝观察到这种策略会错误地移除许多有用的高斯点。相比之下,本文的方法在几何结构的完整性和细纹理细节方面表现得更加出色。

应用

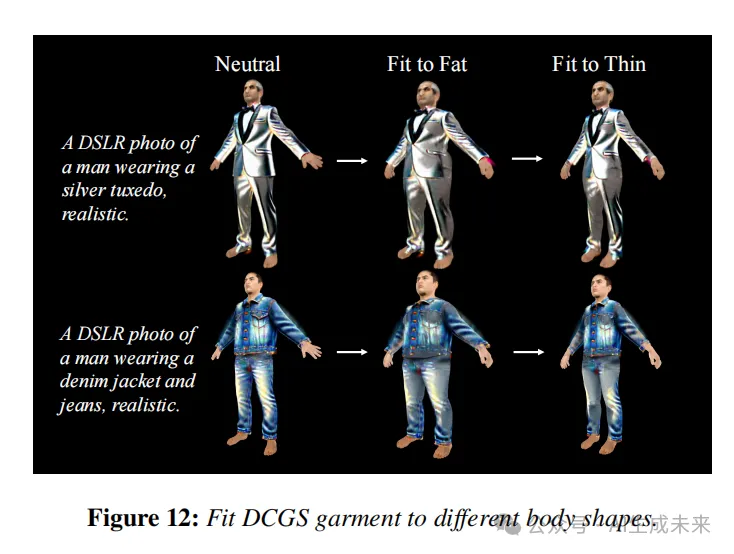

自动适配。本文方法的一个重要优势是能够将服装生成与角色身体解耦。本文生成的3D服装资产可以适配于多种不同的角色体型,如下图12所示。将网格视为密集点云,可以使用ICP配准来计算两个身体网格之间的变换矩阵。由于生成的服装在中性形态下非常贴合,本文可以轻松地将点绑定到其网格表面。基于身体变换矩阵,本文可以优化服装变换矩阵以适应各种体型,可能为快速虚拟试穿开辟新的可能。

结论

本文介绍了 ClotheDreamer,这是一种从文本提示生成多样且可穿戴的3D服装的创新方法。本文提出了一种新颖的表示方法,名为Disentangled Clothe Gaussian Splatting (DCGS),能够有效地将衣服与身体解耦。本文还提出了双向SDS指导,它分别监督带有姿态条件的服装化身RGBD渲染,并引入了一种新的修剪策略,以增强宽松服装的生成完整性。此外,本文展示了通过结合模板网格原语进行个性化生成的多样性。本文的DCGS服装可以通过模拟的网格先验实现逼真的布料动画。实验和用户研究表明,本文的方法在外观和几何质量方面优于最先进的方法。

局限性和未来工作。尽管 ClotheDreamer 展示了令人鼓舞的结果,但它仍然存在一些局限性。首先,本文的方法目前整合了上衣和下衣,更精细的解耦将适用于更复杂的试穿场景。其次,类似于其他基于SDS的方法,本文的方法在某些情况下也会出现颜色过饱和的问题。本文相信,探索改进SDS的方法可以帮助缓解这个问题。最后,探索为3D高斯表示disentangling lighting以增强逼真度也是一个有趣的未来方向。最后,disentangling lighting 增强真实感的 3D 高斯表示也是一个有趣的未来方向。

本文转自 AI生成未来 ,作者:Yufei Liu等