虚拟试衣&人像合成新SOTA!IMAGDressing-v1:ControlNet和IP-Adapter的最佳拍档

文章链接:https://arxiv.org/pdf/2407.12705

github链接:https://imagdressing.github.io/

Demo试用:https://sf.dictdoc.site/

亮点直击

- 为商家引入了一项新的虚拟试衣(VD)任务,并设计了一个综合亲和力测量指数(CAMI)用于评估生成图像与参考服装之间的一致性。

- 提出了IMAGDressing-v1,其中包括一个用于提取细粒度服装特征的服装UNet和一个带有混合注意力模块的去噪UNet,以平衡服装特征与文本提示控制。在所有评估指标上表现优于其他SOTA方法。

- IMAGDressing-v1可以与其他扩展插件(如ControlNet和IP-Adapter)结合,以增强生成图像的多样性和可控性。

- 收集并发布了一个大规模的互动服装配对(IGPair)数据集,包含超过30万对服装和穿戴图像,供社区探索和研究。

目前已经通过使用潜在扩散模型的局部服装修复实现了逼真的虚拟试衣(VTON),显著提升了消费者的在线购物体验。然而,现有的VTON技术忽略了商家全面展示服装的需求,包括对服装、面孔、姿势和场景的灵活控制。

为了解决这一问题,本文定义了一个虚拟试衣(VD)任务,专注于生成具有固定服装和可选条件的可自由编辑的人像。同时,设计了一个综合亲和力指标(CAMI),用于评估生成图像与参考服装之间的一致性。并提出了IMAGDressing-v1,它结合了一个捕捉CLIP语义特征和VAE纹理特征的服装UNet。同时提出了一种混合注意力模块,包括一个冻结的自注意力和一个可训练的交叉注意力,将服装UNet中的服装特征整合到一个冻结的去噪UNet中,确保用户可以通过文本控制不同的场景。IMAGDressing-v1可以与其他扩展插件(如ControlNet和IP-Adapter)结合,以增强生成图像的多样性和可控性。此外,为了解决数据缺乏的问题,发布了互动服装配对(IGPair)数据集,包含超过300,000对服装和穿戴图像,并建立了一个标准的数据组装流程。大量实验表明,IMAGDressing-v1在各种受控条件下实现了最先进的人像合成性能。

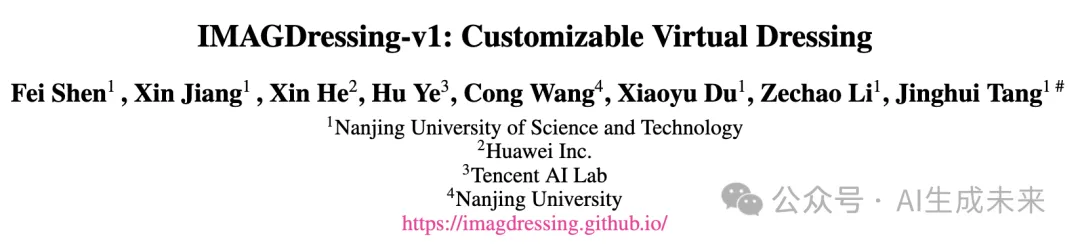

与MagicClothing对比

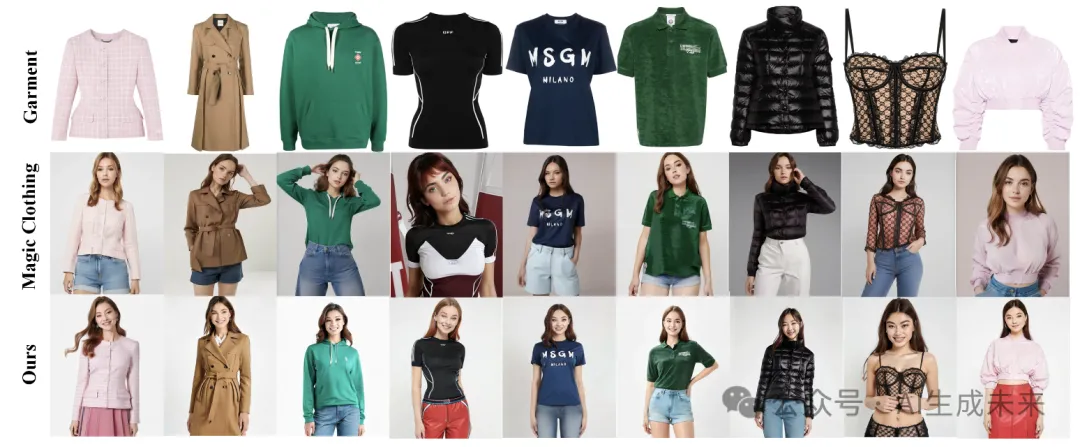

与IP-Adapter结合

与IP-Adapter 和 ControlNet-Pose结合

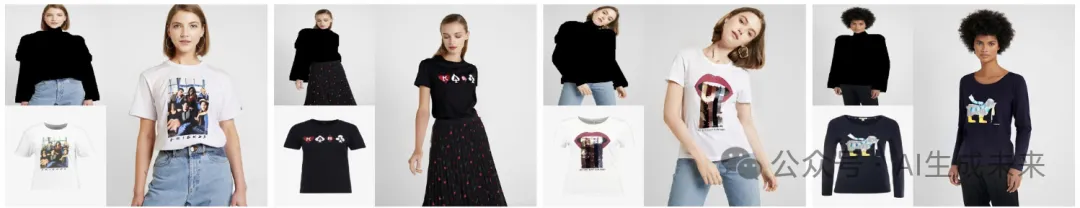

支持不同场景的文本提示

支持在特定区域更换(实验特性)

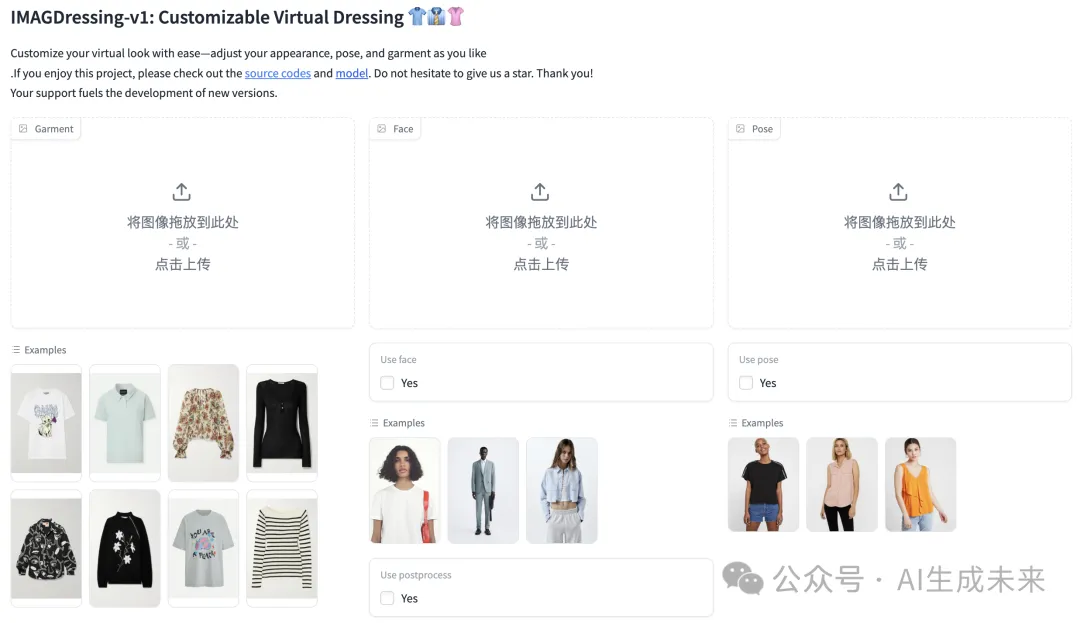

Demo展示:

方法

IMAGDressing-v1

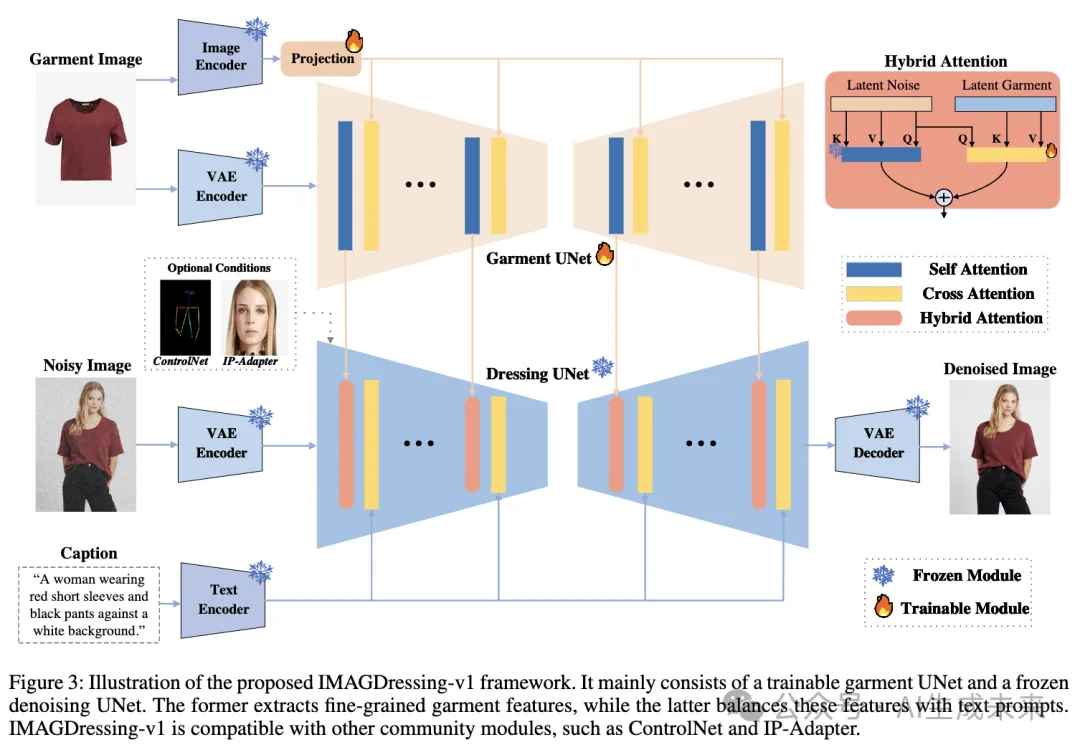

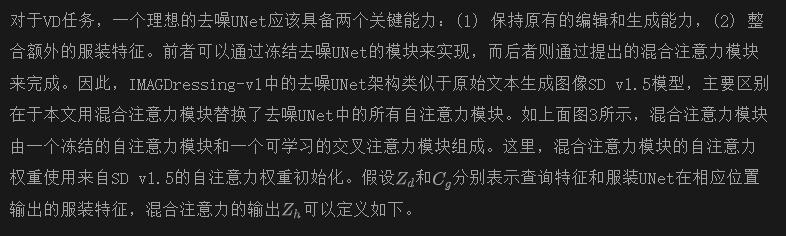

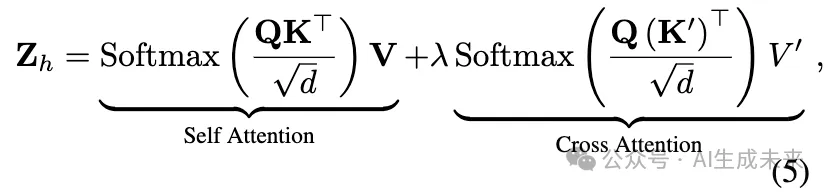

如下图3所示,提出的IMAGDressing-v1主要由一个可训练的服装UNet组成,其架构与Stable Diffusion V1.5(SD v1.5)相同。不同之处在于服装UNet能够同时捕捉来自CLIP的服装语义特征和来自VAE的纹理特征,因为VAE可以近乎无损地重建图像。下部是一个冻结的去噪UNet,类似于SD v1.5,用于在特定条件下对潜在图像进行去噪。与SD v1.5不同,研究者们用混合注意力模块替换了所有自注意力模块,以更容易地整合来自服装UNet的服装特征,并利用现有的文本生成图像功能通过文本提示进行场景控制。此外,IMAGDressing-v1包括一个用于编码服装特征的图像编码器和投影层,以及一个用于编码文本特征的文本编码器。

服装UNet

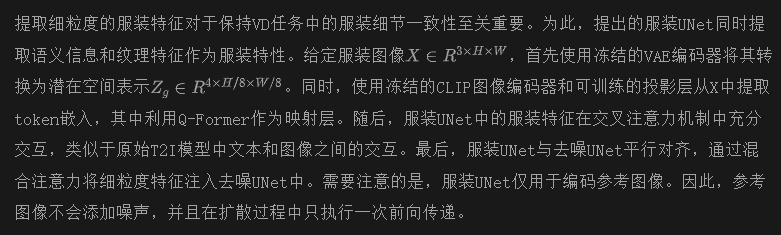

混合注意力

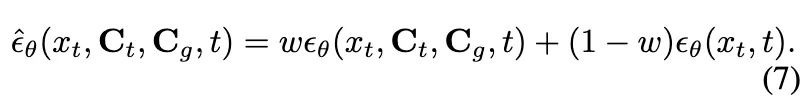

训练和推理

在推理阶段,也根据公式7使用无分类器指导。

➤ Q: 如何支持自定义生成?如前面图3所示,去噪UNet中的基本模块权重是冻结的,这使得服装UNet实际上成为一个适配器模块,与其他社区适配器兼容,以实现自定义面部和姿势生成。例如,要生成穿着给定服装和一致姿势的人的图像,IMAGDressing-v1可以与ControlNet-Openpose结合。要生成穿着指定服装的特定个人,IMAGDressing-v1可以与IP-Adapter集成。此外,如果需要同时指定姿势和面部,IMAGDressing-v1可以与ControlNet-Openpose和IP-Adapter结合使用。此外,对于虚拟试衣(VTON)任务,IMAGDressing-v1也可以与ControlNet-Inpaint结合使用。

实验

实施细节

实验中,通过继承Stable Diffusion v1.5中UNet的预训练权重来初始化服装UNet的权重,并微调其权重。本文的模型在IGPair数据集的配对图像上以512×640的分辨率进行训练。采用固定学习率为5e-5的AdamW优化器。模型在10个NVIDIA RTX3090 GPU上以批次大小为5进行训练,共200,000步。在推理阶段,图像使用UniPC采样器进行50步采样,并将指导尺度w设置为7.0。

主要比较

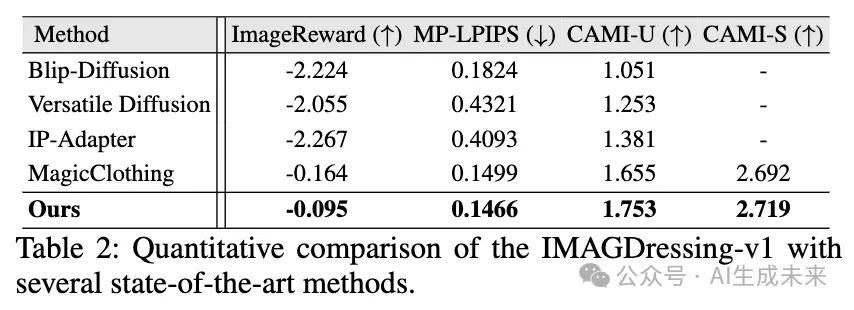

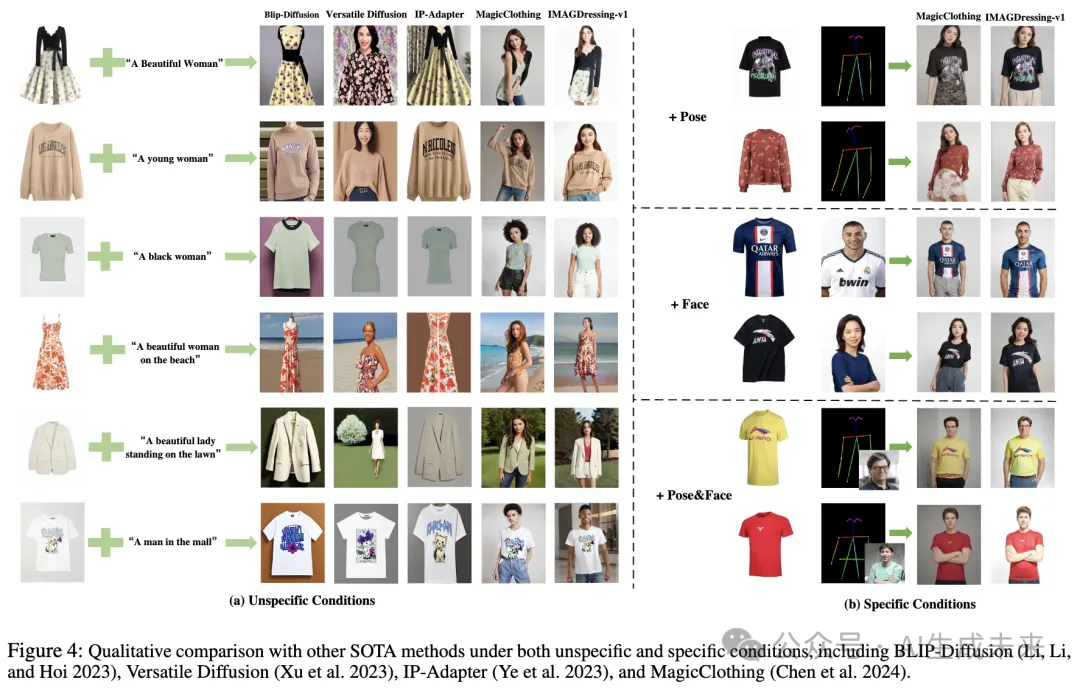

将IMAGDressing-v1与四种最新的(SOTA)方法进行比较:Blip-Diffusion,Versatile Diffusion,Versatile Diffusion,以及MagicClothing。

定量结果

如下表2所示,由于Blip-Diffusion、Versatile Diffusion和IP-Adapter并非专门设计的VD模型,它们难以提取细粒度的服装特征并生成精确匹配文本、姿势和服装属性的角色图像。这导致其在多个指标上表现不佳。此外,这些模型与多个插件不兼容,因此无法计算CAMI-S指标。与MagicClothing相比,IMAGDressing-v1通过其图像编码器分支捕捉更多细节服装特征,并采用混合注意力机制。这种机制在保留原有文本编辑和生成能力的同时,整合了额外的服装特征。因此,IMAGDressing-v1在所有评估指标上表现优于其他SOTA方法。

定性结果

下图4展示了IMAGDressing-v1与SOTA方法的定性结果对比,包括非特定条件和特定条件生成的结果。在图4(a)中,在非特定条件下,BLIP-Diffusion 和Versatile Diffusion未能忠实地再现服装纹理。虽然IP-Adapter保持了服装的整体外观,但无法很好地保留细节,更重要的是,未能准确遵循文本提示。MagicClothing与文本条件高度一致;然而,它在保留服装整体外观和细节(如印刷文字或颜色)方面表现不佳。相比之下,IMAGDressing-v1不仅遵循文本提示,还保留了细粒度的服装细节,在VD任务中表现出色。本文的方法支持自定义文本提示场景,如图4(a)的最后三行所示。此外,图4(b)展示了在特定条件下的定性结果。观察到,IMAGDressing-v1在涉及给定姿势、面部或两者的场景中显著优于MagicClothing。IMAGDressing-v1生成的结果表现出更优越的纹理细节和更逼真的外观。这表明IMAGDressing-v1与社区适配器的兼容性增强,提升了生成图像的多样性和可控性。

消融研究

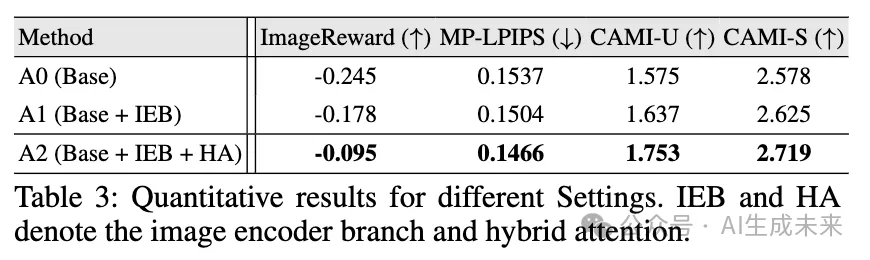

各组件的有效性。下表3展示了一项消融研究,以验证所提出的图像编码器分支(IEB)和混合注意力(HA)模块的有效性。这里,A0(基础)表示没有IEB和HA的设置。观察到使用IEB的A1在所有指标上都有所提升,表明IEB有效地捕捉到了语义服装特征。此外,A2超越了A1,表明IEB和HA的结合进一步提升了定量结果。

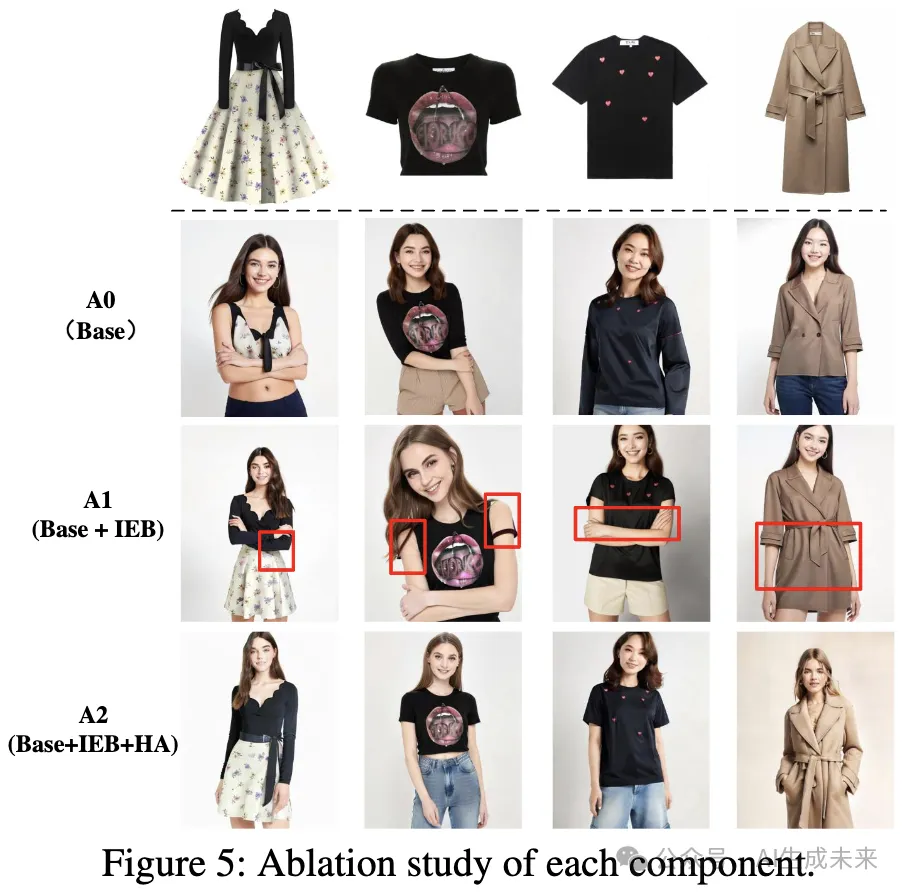

此外,下图5提供了定性比较。A0未能在具有复杂纹理的图像中充分捕捉服装特征(第二行)。尽管IEB(A1)部分解决了这个问题,但将IEB直接注入去噪UNet会导致与主模型特征冲突,导致服装细节模糊(第三行)。因此,HA模块(A2)通过调整服装UNet中服装细节的强度来提高图像保真度(第四行),这与本文的定量结果一致。

潜在应用

下图7展示了IMAGDressing-v1在虚拟试衣(VTON)中的潜在应用。通过将IMAGDressing-v1与ControlNet-Inpaint结合并遮罩服装区域,实现了VTON。结果表明,IMAGDressing-v1可以实现高保真的VTON,展示了显著的潜力。

结论

尽管最近使用潜在扩散模型在VTON方面取得了显著进展,增强了在线购物体验,但它们仍然无法让商家全面展示服装,并灵活控制面部、姿势和场景。为了弥补这一差距,本文引入了虚拟试衣(VD)任务,旨在生成在可选条件下穿着固定服装的可编辑人像。本文提出的IMAGDressing-v1采用了服装UNet和混合注意力模块,整合服装特征,通过文本实现场景控制。它支持像ControlNet和IP-Adapter这样的插件,以提供更大的多样性和可控性。此外,研究者们发布了包含超过300,000对服装和穿着图像的IGPair数据集,提供了一个强大的数据组装流程。广泛的实验验证表明,IMAGDressing-v1在受控人像合成方面达到了业界领先的性能水平。

本文转自 AI生成未来 ,作者:Fei Shen等