百度内容生态视频AIGC新探索 原创

嘉宾 | 张宝玉

编辑 | 云昭

出品 | 51CTO技术栈(微信号:blog51cto)

本文整理自百度内容生态内容架构技术负责人张宝玉WOT2024大会上的主题分享,更多精彩内容及现场PPT,请关注51CTO技术栈公众号,发送【WOT】即可直接领取。

日前,在51CTO主办的WOT全球技术创新大会上,百度内容生态内容架构技术负责人张宝玉带来了主题演讲《百度内容生态视频AIGC新探索》,围绕着大众化的视频创作的场景,详细介绍了百度内容生态加团队在打造一站式AI视频创作平台的实践经验与深入思考。

本文将摘选其中精彩内容,统一整理,希望为诸君带来启发。

如今我们身处内容生产的3.0时代,有了AI技术的加持,内容生产的形式或者门槛进一步拉低,将有望重塑整个内容生产的态势。因此,当视频和AI相结合的时候,会有一个什么样的发展动向,这是我们需要思考的一个问题。

传统的视频内容生产的形式,主要分为这四个环节:视频创意、视频脚本、视频素材、视频剪辑。

图片

图片

那么,在整个视频的生产链路中,AI能在哪个环节去做助力或改造呢?

两年前我们开始研发“度加”产品,它的定位是做一个一站式、全流程的AI视频创作工具,覆盖了刚才提到的完整的视频生产的流程,比如,提供帮你创意文案生成的能力,迅速组装或者成片的能力,海量素材推荐的能力等等。最后,针对一些实际视频生产当中的痛点,比如视频的增益价值的加强方面,我们还辅助做了AI数字人的能力。

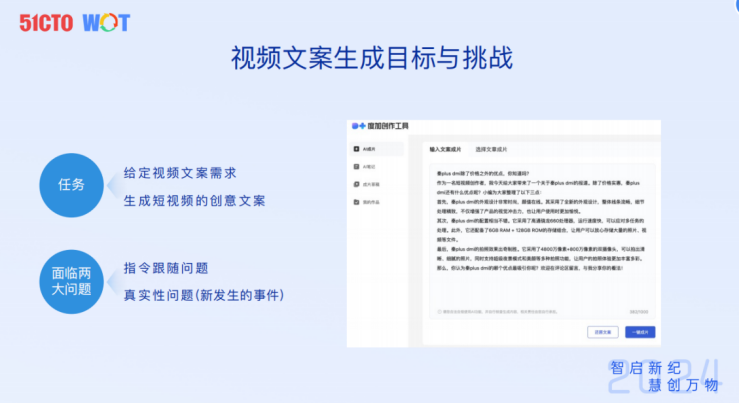

1.视频文案生成的典型问题

首先,创意文案生成方面,这是一条视频内容的起点。

在文案生成上,百度文心一言作为基础模型,有着强大的文案生成能力,基于大模型的接入,我们在现有的产品上做了一些充分、勇敢的应用。

比如,一位作者想要创作视频创作脚本,从零开始写创作难免费时费力,因为不是所有创作者都有很强的文案能力。

这时候,我们首先要解决的就是,为创作者提供根据创意生成一个可实用的文案脚本的能力,这里我们就引入了大模型的改写、润色和扩写的能力。这里面我们发现有两个技术细节的问题:指令跟随和真实性。

图片

图片

对于指令跟随的问题,主要的解决方法就是去基于基座模型去做微调,这里分享几个SFT的原则,沿着这个原则,可以帮助缩短微调的周期,同时效果也能够有较大的提升。

图片

图片

第一,微调的物料要追求质量,而不数量。第二,微调一些指令时,要清晰明确;第三,避免一些模糊的回答。第四,因为我们平台是全垂类的创作平台,不是为某一个垂类覆盖,所以在微调时候的数据要尽量做到多样化和高覆盖。

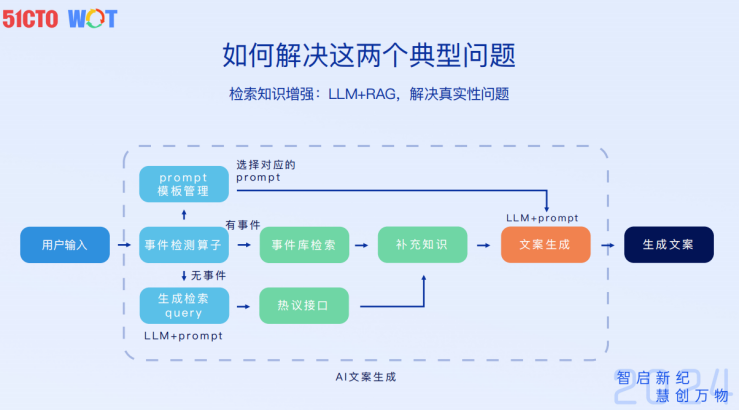

接下来真实性的问题如何解决?我们现在解决的方法还是用RAG增强。这里值得一提的是,我们自建了两个较丰富的事件源:事件检索库、热议接口。

图片

图片

前者依赖的是原来百度的知识图谱所积累出来的事件检索,这个库的丰富性和时效性是能够得到基础保障的。后者则依托于百度热榜和热议搜索的能力,以及搜索事件的首发的特性,根据热议接口我们会去纠正一些事实性的错误。基于这两个增强,我们能够把文案生成的一些事实性错误的概率降到很低的水平。

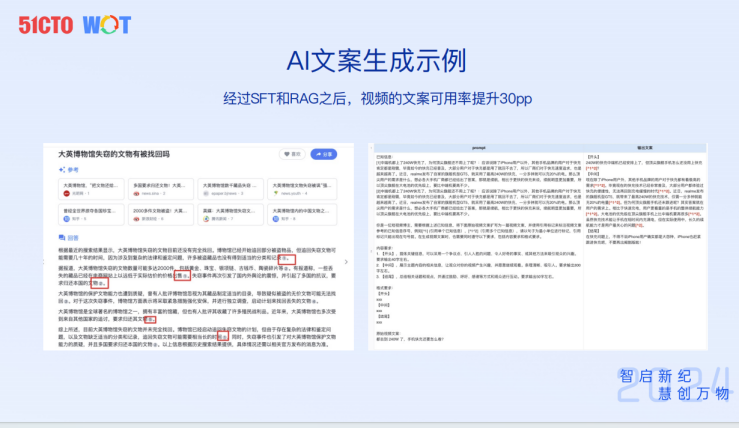

经过这些优化,根据内部自评,文案生成的可用率能提升30%左右。现在这一版的截图的效果是我们线上截下来的一个实际案例,大家也可以在产品上自己进行体验。

图片

图片

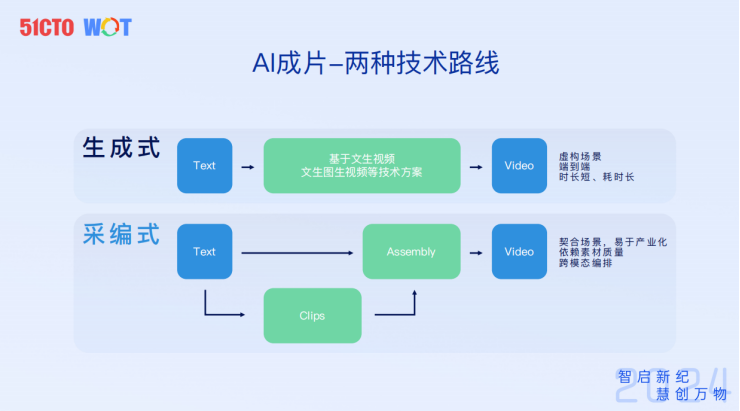

2.AI成片的技术路线及实践优化

生成了可用的视频脚本方案之后,接下来就是视频生成的步骤。目前大家更为熟悉的技术路线是类似Sora的文生视频的生成式方式,但它也面临着很多现实性的问题,我这里边列举了三个。第一,生成视频有虚构场景。第二,虽然是端到端生成的,但目前生成的可用的视频的长度较短;第三,用来生成视频的耗时又很长。因此,在做真正的产品化时,这些问题都需要解决。

于是我们从产品的角度去思考实际能够为用户提供价值的技术路线?我们选择了采编式的技术生成路线。

图片

图片

需要注意的是,采编式跟生成式两种路线是协同,而非冲突的。在采编式的技术路线中,很多素材、片段的生成都采用了一些生成式的成果。采编式路线会先组织生成核心的要素素材,然后通过编排技术去把这些素材按照预设的脚本生成一个可应用的视频结果。

采编式的路线优势在于更契合于生产场景,为创作者提供更可用的视频,同时生产出的视频能够给C端的浏览用户提供价值,而不仅仅是一个demo。

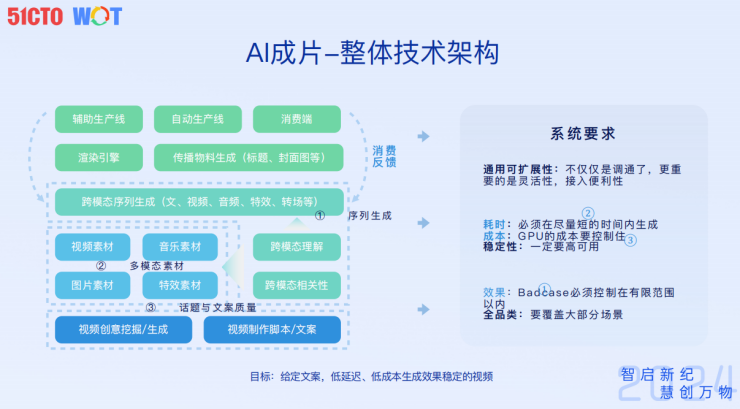

整体上的技术架构,分为三个部分:

- 话题与文档质量,解决可用文案的问题;

- 多模态素材,这里不仅包括这个视频片段本身描述的是人物或风景等等,还包括诸如BGM音乐、特效、片花、动效等等,这些多模态素材,也都会做一个统一的做编排候选。

- 最后则是序列生成。

图片

图片

此外,就整个系统构建来说,还要充分考虑它的产品化落地。因为内部要应用于多个产品线,就要考虑它的通用性、灵活性和接入便利性。

在工程化的角度来看,也要考虑系统的耗时和成本问题。这些都是我们在架构这套系统的时候要考虑的因素。

图片

图片

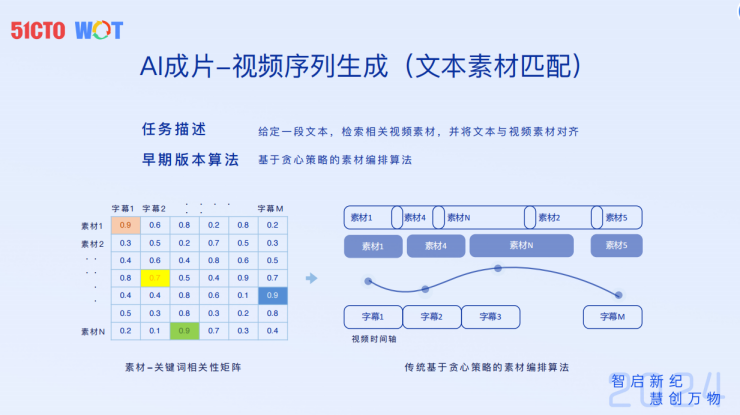

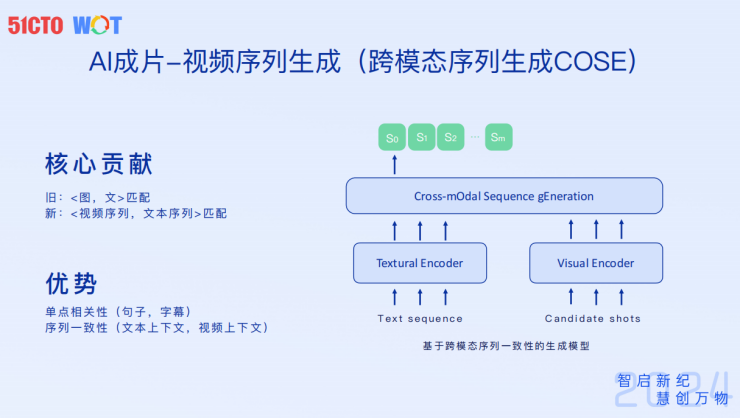

编排过程中,早期采用的传统的基于贪心策略的素材编排算法,贪心策略只能做到局部的最优,保证你句子跟素材之间的相关性,但是从全局看,就会存在诸多问题,比如一致性不够,整个视频的风格会混乱,素材之间有跳跃等等,而这些问题恰恰导致生成的视频变成了一个Demo,而不是一个可产品化落地的结果。

经过迭代,目前线上采用的是跨模态序列生成的方法,迭代的地方在于,除了考虑锚点关键句和素材之间的匹配性以外,我们还要考虑目前已经采编的素材序列的一致性、全文的相关性。这样,整个编排的效果在素材一致性、风格一致性、内容一致性上都得到了显著提升。

图片

图片

这里还有第二个问题,即生成式的内容存在一些片段“无中生有”的情况,这时候就需要一些事件类的素材来补充这个视频的内容。

为了解决这个问题,我们在素材来源方面做了很多工作,将素材分了很多分类,并进行了大规模扩充。

目前素材库大概有几亿条素材,它的更新数量每个月能达到数千万。新热素材的收录和生成式效益能做到五分钟以内,可用性能做到96%。

图片

图片

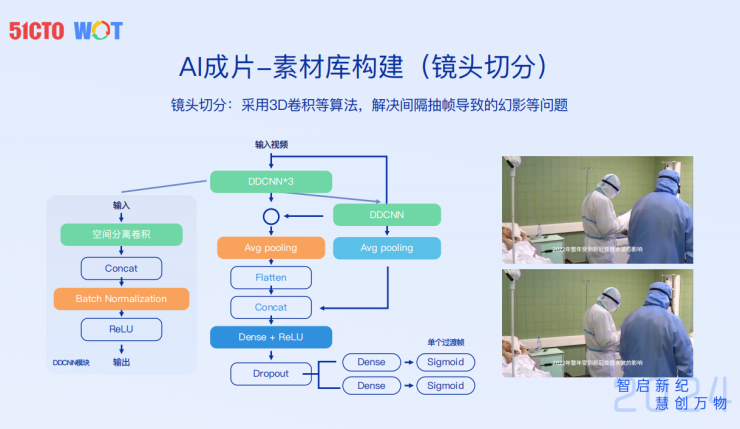

素材库构建方面,有两种方法原生生成和视频抽取。前者只能解决一些创意素材的补充,而对于事实类素材的补充,视频抽取技术会相对成熟一些。

但在实际落地工程化中,会遇到比如在抽帧和跳帧时候一些幻影的问题,可以通过3D卷积的方法做优化,目前抽帧的可用率和单位母视频抽帧的结果的比率都是较高的状态。

图片

图片

此外,对于素材质量良莠不齐的问题,可以采用质量过滤和质量增强的方法进行质量提升。

值得注意的是素材理解。因为我们需要的不仅仅是素材库,不仅是一个原始的视频片段库,更需要相应的描述信息。

大家都知道,短视频是有自己的描述的,但是抽象成素材之后,相关片段的可描述数据,跟原始视频的描述性数据不是一个简单的继承关系,因此在继承的时候,需要做一个质量增强。这里我们应用现在的模型技术把目前的很多的质量控制和增强的小模型做了一个抽象,形成了一个内容理解的大模型。目前线上20多种问题都可以统一由该问题进行解决。

图片

图片

3.AI成片的工程挑战及优化

除了质量效果上的问题以外,还有一些工程的问题。构建过程中,会面临四种挑战:安全、稳定、成本、时延。

图片

图片

这里重点分享成本和时延这两块内容。

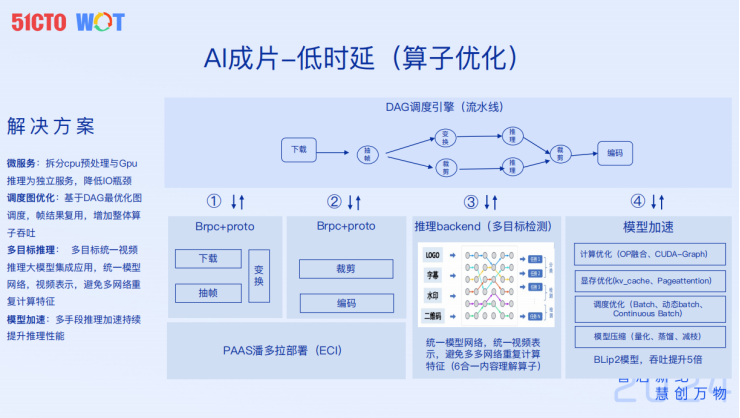

首先是时延方面。从生产链路上看,主要耗时的地方在于素材收集和场景编排。比如其中场景编排耗时的原因是要覆盖全场景、全垂类所导致的。

针对这些耗时的点,可以采用两种优化方法:调度优化和算子优化。改进策略是采用分层异步的调度框架去解决整个吞吐延时的问题,主要目的是减少目前生成任务的阻塞。另外,在整个系统当中,也做了分层缓存处理。

算法优化方面,主要针对生产链路中有一些比较重型的算子,针对这些算子可能要拆开来看,具体做优化,比如,首先,分析算子的瓶颈实在I/O还是CPU/GPU计算,进而对算子进行服务化和拆分;其次,图调度方面的优化:整个帧图的复用、缓存的复用、预处理结果、模型理解结果的复用等;第三,模型层面联合策略同学去做了多目标的视频推理或视频理解模型;第四,模型加速方面,目前有计算优化和显存优化以及模型压缩的方法。

图片

图片

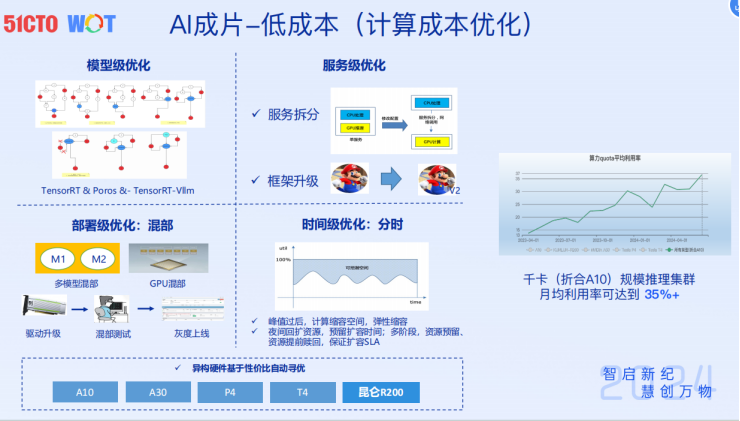

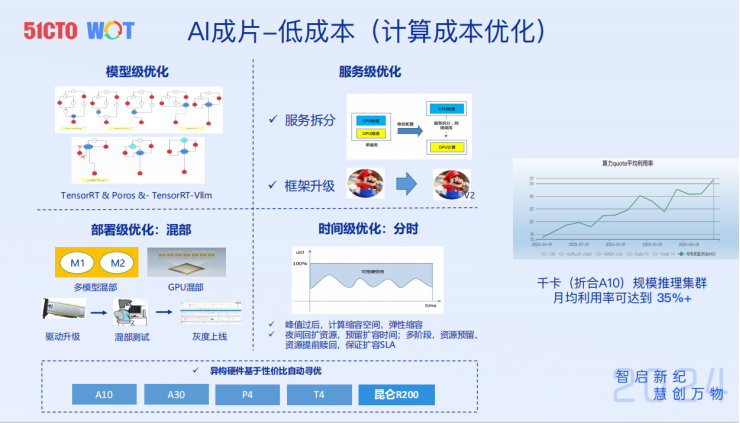

作为一个线上产品化的视频生产系统,不可避免地要考虑成本的问题。目前系统成本的开销主要包含三部分:计算成本、大模型成本,存储成本。

图片

图片

针对计算成本,除了刚才讲到模型的优化,我们还对模型构建的服务框架也做了迭代升级。此外,还在部署级别,内部推动整个算子的混部,时间级调度方面,通过潮汐调度的方法,可以将使整体资源利用更充分; 在硬件层面,我们在一些新的XPU的硬件上采用百度自研的昆仑芯片,在整体利用率上,目前能做到的千卡的推理卡的利用率可以做到月均35%,较之前得到了大幅提升。

图片

图片

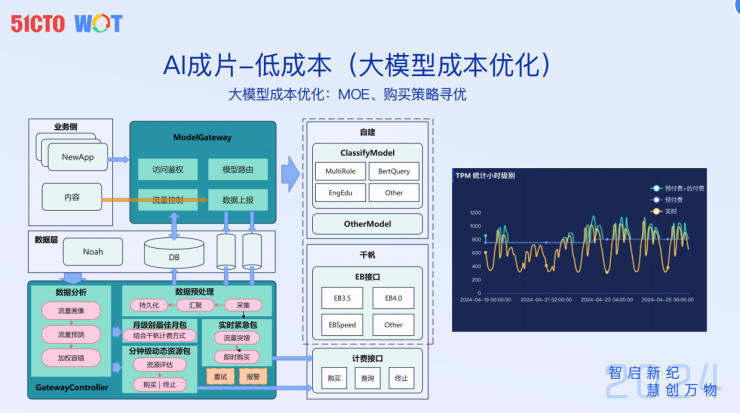

大模型成本方面,我们根据目前的付费模式做了一些优化,比如说大模型应用以类似手机流量的方式去售卖,可以购买月包或者小时包。

应用在全产品线就需要录制自己的流量,这样可以预测流量的波形。预估流量和实际采用的流量是非常接近的,这样就能减少我们不必要的大模型的成本的购买。

图片

图片

4.数字人视频制作案例分享

在数字人视频方向,需要解决以下问题。第一,形象复刻的能力,这方面我们自研和加强了一些绿幕抠像的算法,能够提升整个人物的质感;在成本方面,面向普通的创作者也做到了低成本创作;此外,还需要解决诸如时延、形象逼真等问题。

图片

图片

值得一提的是,在整个数字人录制的过程中,我们增加一些用户可选的关键素材的匹配功能,主播在播放的时候,右侧会弹出一个小窗,来显示出当前的一些关键事件的影像录制,这个能力恰好能解决一些实时播报过程中口播作者的痛点。

图片

图片

本文转载自51CTO技术栈,作者:云昭