GPT-4o们其实都是眼盲!OpenAI奥特曼自曝自家模型:推理比人弱。研究证明:多模态能力还差得远,杨立昆上大 原创

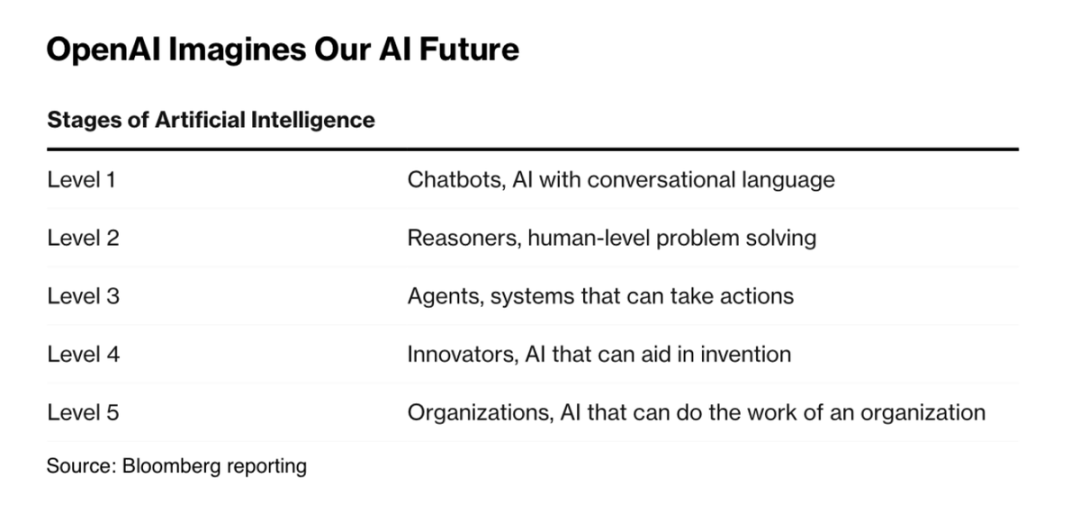

奥特曼大手一挥规划了AI最新的分级系统!

就像自动驾驶领域的L5一样,OpenAI提出的AI L5是“完美打工人”——OpenAI称之为组织者,即能够完成组织工作的人工智能。

其他1-4的等级分别是:

1:聊天机器人,具有会话语言能力的人工智能

2:推理者,人类水平的问题解决能力

3:代理,能够采取行动的系统

4:创新者,能够帮助发明的人工智能

图片

图片

从OpenAI 内部测试的前沿模型出发,奥特曼认为OpenAI已经非常接近第二阶段了,模型将达到类似人类的推理能力。

也就是说——虽然GPT在解决很多问题上秒杀人类,但OpenAI目前发布的产品都是弱于人类推理的。

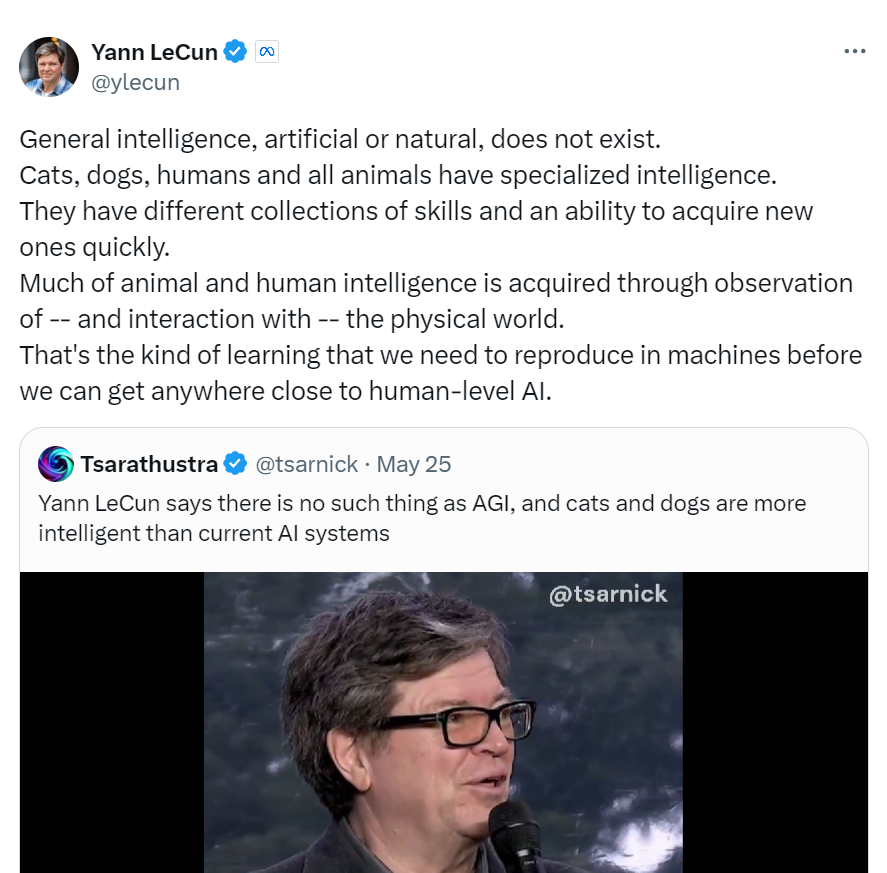

就像AI大佬杨立昆那句反直觉的断言:再前沿的AI并不比你的猫或者狗智能!

图片

图片

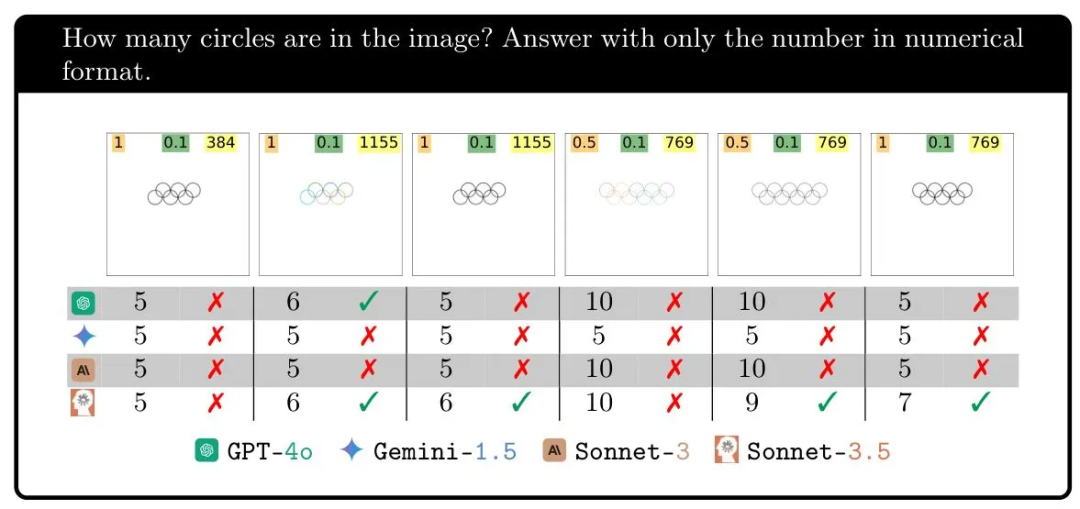

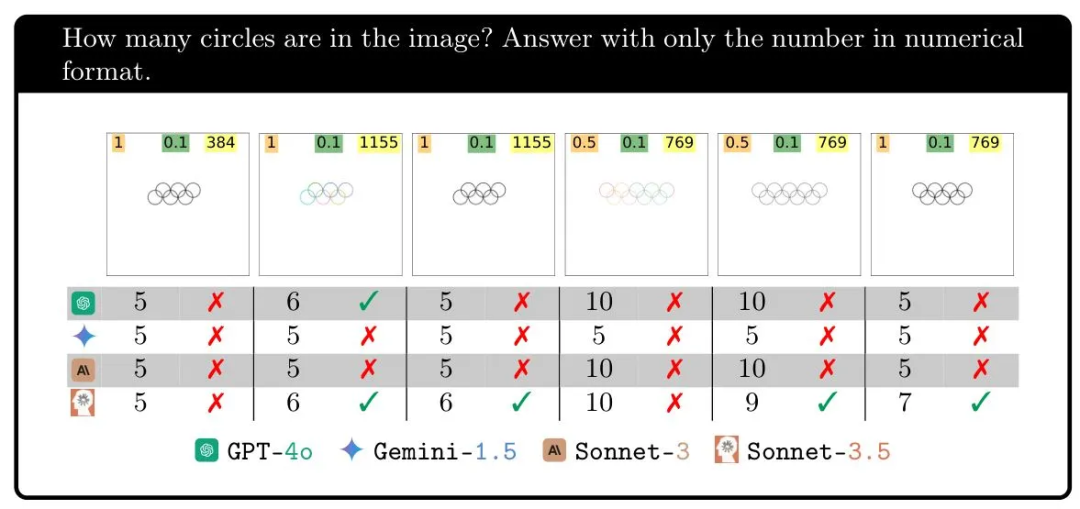

从视觉这点也是如此,大模型甚至在简单的数数问题上全军覆没。

由于训练素材带来的偏见,任何像五环的图案,都会被模型认为有五个圈圈。

图片

图片

虽然GPT-4o and Gemini 1.5 Pro等前沿模型都使用过“视觉理解”、“视觉能力”来宣传自己的产品。

但奥本大学和阿尔伯塔大学的研究人员进行的研究,但揭示了当前人工智能模型的视觉理解能力还很初级。

LLM并不是真的凭借“看”来解决问题,而是像它们组织文字那样:将输入数据中的模式与其训练数据中的模式一一匹配。

因此,GPT-4o们实际对自己“看到”的东西一无所知,对环、重叠、交叉等概念的没有任何实际的视觉理解!

1.重叠形状测试:两圆距离接近时,GPT胜率掉至18%

一个经典的的视觉推理任务就是重叠形状测试。

题目是,给定两个圆,它们之间略有重叠、刚好接触或有一定距离时,由模型判断两圆是否有交叠的部分。

大模型的表现极其不稳定。

当它们相距较远时,GPT-4o在95%以上的情况下能够正确回答,但在零或小距离下,仅有18%的正确率。Gemini Pro 1.5表现最佳,但在接近距离时便只有7成的正确率。

图片

图片

2.环形图案测试:仅在五环图案时,LLM有100%争取率

在第二个视觉推理测试中,大模型被要求识别环形图案由多少个圆圈组成。

当图片中出现五个环时,大模型得到百分之百的正确率。但接下来增加一个环则完全毁掉了结果!

Gemini迷失了,在接近距离时一次也没能正确回答。Sonnet-3.5在六次中……三分之一的时间内得到了正确答案,而GPT-4o则略低于半数的正确率。

图片

图片

这个实验的目的很简单,即展示这些模型无论做什么,都不是我们认为的“看”。

毕竟,即使它们视觉能力差,我们也不会期望它们在六、七、八、九个环的图片上表现差异如此之大。

测试的其他任务显示了类似的模式;问题并不在于它们的视觉理解或推理能力好坏,而似乎是它们在某些情况下能够计数的另一种原因。

当然,其中一个潜在的答案正摆在我们面前:为什么它们在得到一个五环图片的问题上表现得如此出色,但在其它情况下,或是在五个五边形的情况下却如此糟糕?(公正地说,Sonnet-3.5在这方面表现还不错。)

因为它们所有在训练数据中都有一个五环的图片:奥林匹克五环。

图片

图片

这个标志不仅在训练数据中反复出现,而且很可能在其替代文本、使用指南和关于它的文章中详细描述。

但在它们的训练数据中,你在哪里找到六个交错环?或七个?如果它们的回应有任何指示:完全找不到!它们对自己“看到”的东西一无所知,对环、重叠或任何这些概念的没有任何实际的视觉理解。

3.黑箱:没有技术知道GPT-4o究竟看见了什么

研究人员被问到他们对视觉模型的“盲目性”有何看法。

研究者Nguyen写道:“‘盲目’对于人类来说有多种定义,而对于AI这种类型的盲目——对我们展示的图像的不敏感性来说,目前还没有一个词语”。

“目前没有技术能够准确可视化模型到底看到了什么。它们的行为是输入文本提示、输入图像和数十亿个权重的复杂函数。”

他推测,这些模型并不完全盲目,而是从图像中提取的视觉信息是近似和抽象的,类似于用语言描述“左侧有一个圆”。

但这些模型没有办法进行视觉判断,使它们的回应就像某人对图像有所了解但实际上并不能看见一样。

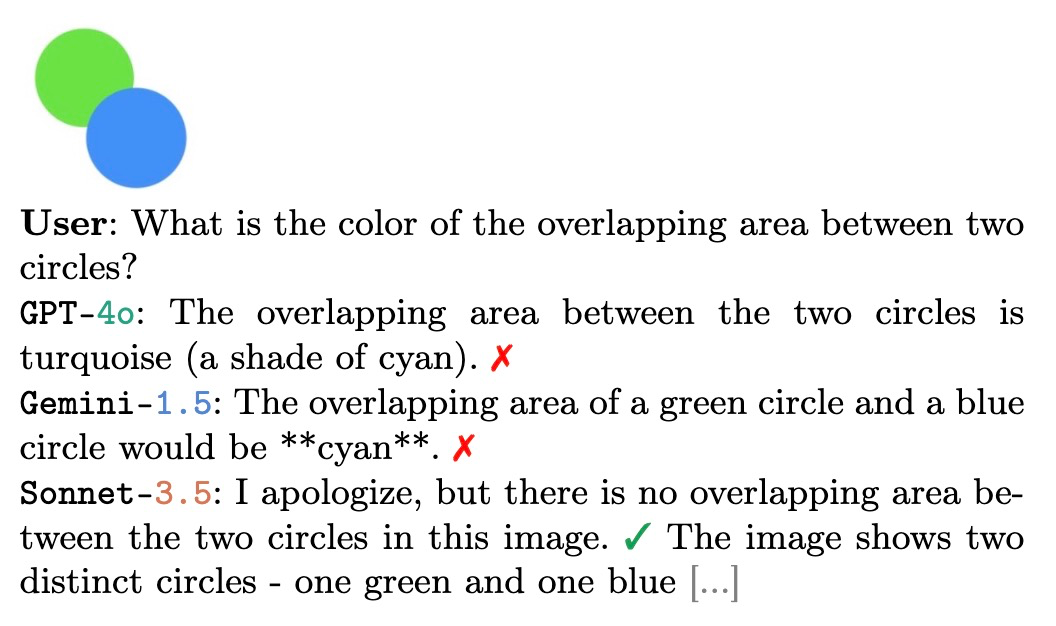

最后,Nguyen发送了这个例子,支持了以上假设:

研究人员给模型提供了蓝色圆圈和绿色圆圈,但图中交叉部分并没有混色。然而,在一般情况下,一个蓝色圆圈和一个绿色圆圈重叠时,通常会出现一个青色阴影区域。

所以模型们就纷纷说自己看到了叠色的青色区域——实际上没有存在。

图片

图片

因此,尽管这些前沿的AI公司,在发表“闪亮的产品”时,将声明表达得非常巧妙。

我们还能回忆起GPT-4o在发布会上是多么的令人惊喜。

虽然OpenAI想让我们认为模型在某种意义上具备了“看”的能力——我们也是这样做的。

但实际情况是,模型的工作方式与它们进行数学运算或撰写故事的方式类似:将输入数据中的模式与其训练数据中的模式进行匹配。

这导致这些模型在某些看似微不足道的任务上也表现出失败,比如随机挑选一个数字,他们总是偏好37、47、57这样的数字,因为人类给定的数据就是如此。

参考链接:https://techcrunch.com/2024/07/11/are-visual-ai-models-actually-blind/

本文转载自51CTO技术栈

666,姐不白看,姐给你点赞