一张图片是否胜过千言万语?微软发表的深入探讨视觉语言模型的空间推理能力 精华

一、结论写在前面

下面介绍的论文是微软发表的。

论文标题:Is A Picture Worth A Thousand Words? Delving Into Spatial Reasoning for Vision Language Models

论文链接:https://arxiv.org/pdf/2406.14852

大语言模型(LLMs)和视觉语言模型(VLMs)在广泛的任务和领域中展示了卓越的性能。尽管有此潜力,空间理解和推理——人类认知的基本组成部分——仍然未被充分探索。

论文开发了涵盖空间推理多样方面(如关系理解、导航和计数)的新颖基准。论文对竞争性的语言和视觉语言模型进行了全面评估。论文的研究发现了几点在文献中被忽视的反直觉见解:(1)空间推理面临重大挑战,竞争模型可能落后于随机猜测;(2)尽管有额外的视觉输入,VLMs往往表现不如其LLM同类模型;(3)当文本和视觉信息均可用时,多模态语言模型在提供足够文本线索的情况下,变得不太依赖视觉信息。

此外,论文证明了利用视觉和文本之间的冗余可以显著提升模型性能。论文希望论文的研究能指导多模态模型的发展,以提高空间智能,并进一步缩小与人类智能的差距。

二、论文的简单介绍

2.1 论文的背景

基础模型的近期突破对研究和产业产生了变革性影响,论文看到这些模型迅速融入产品和新业务中,正为人们的生活带来积极变化。这一巨变最初由大型语言模型(LLMs)推动,这些模型在多种任务上展现出近乎不可思议的人类水平表现。过去一年中,许多模型已扩展到处理图像和文本,导致视觉语言模型(VLMs)尤其是多模态大型语言模型(MLLMs)显著增加,它们在图像相关任务中展现出与文本领域相媲美的突破性性能。

然而,现实并不像宣传的那般美好。尽管这些模型在推进常识推理、数学问题解决和科学问题回答等复杂推理任务的前沿方面发挥了重要作用,但它们在许多问题领域中的效果并不显著。特别是,如本文所示,它们在需要对图像进行详细视觉理解和推理的任务上表现有限。

视觉理解和推理——人类感知和认知能力的内在部分——在视觉语言模型(VLMs)领域中很大程度上未被充分探索。事实上,人们常常认为视觉是人类的主要感官,然而在当前的模型中,它似乎相当次要。特别是空间推理,对日常人类活动如环境导航、地图理解和物体操控至关重要。它涵盖了对于生存和高级认知都至关重要的技能,包括空间导航、模式识别和从空间配置中推断关系的能力。

论文开发了三个新颖的视觉问答(VQA)风格基准测试(Spatial-Map、Maze-Nav和Spatial-Grid),以探索VLMs在空间推理的多个方面的表现,包括关系、导航、位置理解和物体计数。人类在这些任务上表现出色,因此这些能力对于智能系统在现实世界中安全有效地部署至关重要。

论文的数据集构建有一个关键的转折点——论文的基准测试中的每个问题都有一个图像和一个文本表示,足以回答每个空间理解问题。论文将这些来源的使用表示为VQA(视觉问答,标准任务,包括仅视觉输入和问题),TQA(仅文本输入和问题),以及VTQA(结合前两者,包括视觉和文本输入)。

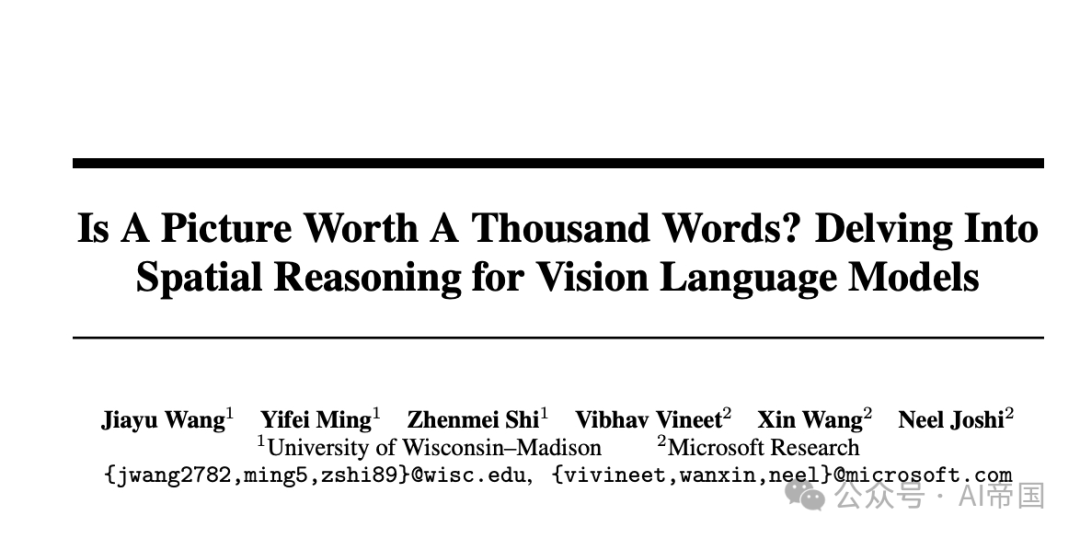

图1:空间地图任务的图示,模拟包含多个位置的地图。为了研究模态的影响,论文考虑了三种输入格式:纯文本、纯视觉和视觉-文本。论文在同一组问题上评估仅使用文本输入的语言模型和使用纯视觉及视觉-文本输入的多模态语言模型

2.2 数据集与任务构建

2.2.1 数据集设置

为了评估大型语言模型(LLMs)和视觉语言模型(VLMs)的空间推理能力,论文构建了包括空间关系、导航、位置理解和计数在内的三个多样化任务。为了系统地研究模态的影响,论文为每个任务设计了三种类型的输入提示:(1)纯文本:输入纯粹是文本形式,包含回答问题所需的所有必要信息。(2)纯视觉:输入仅由一张图片组成,提供了足够详细的信息,使人能够轻松回答,这种格式在文献中也被称为视觉问答(VQA)。(3)视觉-文本:输入包括一张图片及其详细的文本描述,使得两种模态的信息都具有冗余性。论文使用纯文本输入评估语言模型,使用纯文本、纯视觉和视觉-文本输入评估多模态语言模型,在同一组问题上进行。论文选择使用合成数据。

合成数据具有以下几个显著优势:(1)避免数据泄露——由于大型语言模型是在网络规模的数据上预训练的,确保测试数据在训练过程中未被见过至关重要;(2)可配置性——完全可配置允许进行受控实验,并可扩展到其他任务;(3)可扩展性——易于扩展测试样本数量,增强了结果的统计显著性。

空间地图。理解地图上物体之间的空间关系是人类认知能力的基本方面。为了模拟这一环境,论文创建了一个名为Spatial-Map的地图类数据集,包含K个物体,其中K是可配置的。每个物体都关联一个唯一的位置名称,例如独角兽雨伞和盖尔礼品。为了研究模态的影响,每个输入的文本表示包括成对关系,例如“Brews Brothers Pub位于鲸鱼瞭望的东南方”。图1展示了一个K=6的示例,包括仅文本、仅视觉和视觉-文本输入。这些问题涉及询问两个位置之间的空间关系以及满足特定空间标准的物体数量。

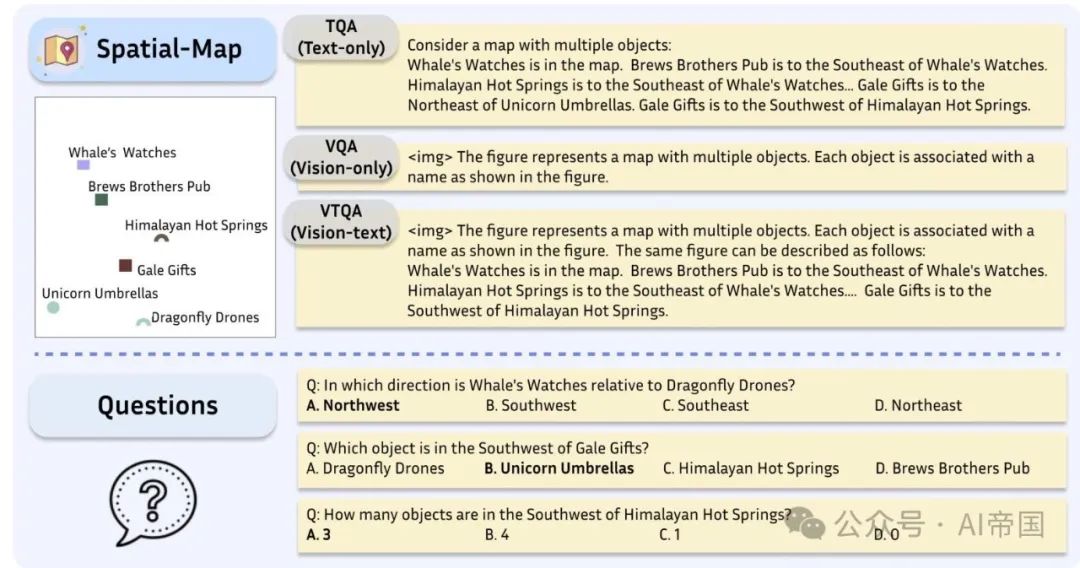

图2:迷宫导航任务示意图,评估模型从起点(S)到出口(E)的导航能力。论文考虑三种输入格式:纯文本、纯视觉和视觉-文本。论文对语言模型(仅文本输入)和多模态语言模型(纯视觉和视觉-文本输入)在同一组问题上进行评估

迷宫导航任务。在复杂空间中的导航能力对智能系统至关重要。为了评估这些能力,论文开发了一个名为Maze-Nav的迷宫式数据集。从视觉上看,每个样本可以表示为彩色块,不同颜色代表不同元素:绿色块标记起点(S),红色块表示出口(E),黑色块代表不可通过的墙壁,白色块表示可通行的路径,而蓝色块则描绘从S到E的路径。目标是沿着蓝色路径从S导航到E,允许在四个基本方向(上、下、左、右)移动。或者,每个输入可以用ASCII码以文本格式表示。图2展示了一个示例,包括纯文本、纯视觉和视觉-文本输入。论文基于一个开源库[24]构建此任务。提出的问题包括计算从S到E的转弯次数以及确定S和E之间的空间关系。尽管这些问题对人类来说很容易,论文将在第4节中展示,它们对现代多模态语言模型构成了重大挑战。

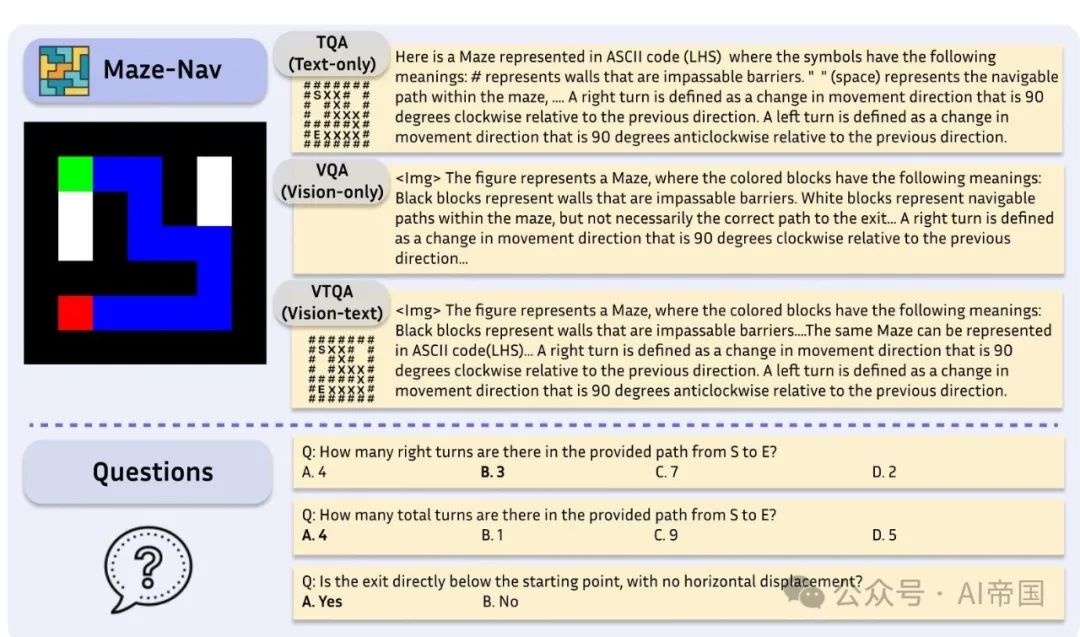

空间网格(Spatial-Grid)。为了研究结构化环境中的空间理解能力,论文引入了一个名为Spatial-Grid的网格状数据集,与对象任意放置的Spatial-Map形成对比。从视觉上看,每个输入由一个包含图像(例如,一只兔子)的单元格网格组成。图3展示了一个示例。或者,这个网格也可以用纯文本格式表示;例如,第一行可以描述为:大象 | 猫 | 长颈鹿 | 大象 猫。评估重点在于任务,如计数特定对象(例如,兔子)和识别位于网格特定坐标处的对象(例如,第一行,第二列)。

2.2.2 模型

论文考虑了多种规模不同的竞争性开源语言模型,包括Phi2-2.7B 、LLaMA系列模型(LLaMA-2-7B、LLaMA-2-13B和LLaMA-3-8B)、Mistral-7B 、Vicuna系列(Vicuna-7B-1.5和Vicuna-13B-1.5),以及Nous-Hermes-2-Yi-34B。

对于多模态语言模型,论文考虑了Bunny系列(Bunny-Phi-2-SigLIP、Bunny-Phi-1.5-SigLlP、Bunny-Phi-2-EVA和Bunny-Phi-1.5-EVA)、CogVLM 、CogAgent 、InstructBLIP系列(InstructBLIP-Vicuna-7B和InstructBLIP-Vicuna-13B),以及LLaVA系列(LLaVA-1.6-Mistral-7B、LLaVA-1.6-Vicuna-7B、LLaVA-1.6-Vicuna-13B和LLaVA-1.6-34B)。论文还评估了专有模型:OpenAI的GPT-4V、GPT-40、GPT-4、Google Gemini Pro 1.0和Anthropic Claude 3 Opus。

图3:空间网格任务的图示,该任务评估模型在刚性格子结构中的空间推理能力。论文考虑三种输入格式:纯文本、纯视觉和视觉-文本。论文评估仅使用文本输入的语言模型和使用纯视觉及视觉-文本输入的多模态语言模型在同一组问题上的表现

评估方法。默认情况下,每个任务中的每个样本关联3个问题(称为Q1至Q3)。由于每个问题包含四个选项,论文采用准确率作为主要评估指标。每个问题末尾附加相同的用户提示:首先,用一句话提供简洁的答案。然后,详细地逐步解释你答案背后的推理过程。对于每个模型,论文采用默认配置和解码策略,例如,确定性解码使用argmax,非确定性解码使用top-p。对于非确定性解码,开源模型的结果在三个独立运行中取平均值。对于专有模型,由于其可用性有限以及计算时间和成本增加,论文仅进行了一次运行。

2.3 主要结果与分析

空间推理仍然出人意料地具有挑战性。开源模型在空间地图、迷宫导航和空间网格任务上的评估结果如图4所示。对于每个任务,报告的准确率是所有问题的平均值。对于视觉-语言模型,论文选择纯视觉输入格式,这是视觉问答(VQA)中常用的格式。

论文在每个图中用一条虚线红线表示随机猜测时的预期准确率。论文的发现揭示了几个显著的见解:(1)纯视觉输入:尽管人类处理这些任务很容易,但大多数竞争性多模态语言模型的表现仅相当于或略高于随机猜测。(2)纯文本输入:文本表示包含了必要空间信息。然而,这种输入格式通常不会增强竞争性语言模型的空间推理能力。在空间网格任务中有一个例外,Llama-3达到了71.9%的准确率,其次是Mistral-7B-Instruct的62.1%,两者都显著超过了随机猜测。尽管取得了这些成功,这些模型的性能仍然远远落后于人类水平。这些结果强调了针对空间理解和推理开发更先进技术的必要性。

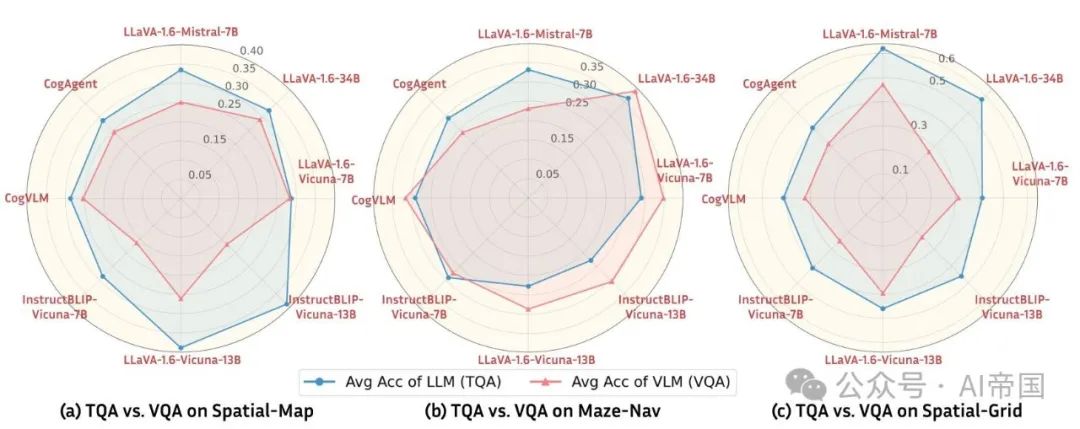

输入模态的影响。为了探究模态的影响,论文比较了具有相同语言骨干的大型语言模型(LLM)和视觉-语言模型(VLM)的性能。论文考虑了视觉-语言模型的VQA(仅视觉)格式。结果如图5所示。蜘蛛图上的每个顶点代表一个(VLM, LLM)对的平均准确率。论文观察到,在Spatial-Map和Spatial-Grid上,尽管VLM具有额外的视觉编码器,但大多数VLM的表现相比其对应的LLM较差。例如,在 Spatial-Grid 任务中,Mixtral-7B 达到了 62.19% 的平均准确率,而 LLaVA-v1.6-Mistral-7B 仅达到 47.1%(相差 15%)。

图4:空间推理任务性能概览。论文报告了所有问题的平均准确率。对于视觉-语言模型,论文考虑了仅视觉(Vision-only)的VQA格式。虚线红线表示随机猜测的预期准确率。在空间地图(Spatial-Map)和迷宫导航(Maze-Nav)任务中,仅有少数模型能显著超越随机猜测的准确率

图 5:TQA 与 VQA 在空间推理任务上的比较。蜘蛛图上的每个顶点代表一个(VLM \mathrm{LLM})对的平均准确率,其中语言骨干相同,即 LLM 与在相应任务上进一步微调的 VLM 的对比。VLM 以红色表示,LLM 以蓝色表示。可以看出,VLM 相对于其 LLM 对应物很少能提升性能

2.4 深入探究视觉-语言模型的空间推理能力

2.4.1 视而不见:多模态语言模型的盲点

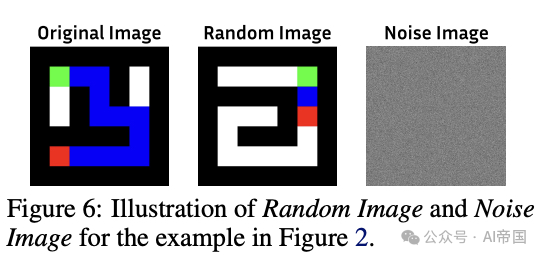

为了更好地理解多模态语言模型如何处理视觉信息,论文在 VTQA(视觉-文本输入)设置下进行了一系列控制实验。对于每个样本,论文将原始图像输入(与文本描述匹配)替换为以下三种之一:(1) 无图像:仅保留文本输入,不包含图像输入;(2) 噪声图像:与任务无关的高斯噪声图像;(3) 随机图像:从数据集中随机选取的不匹配文本描述的图像,如图 6 所示。

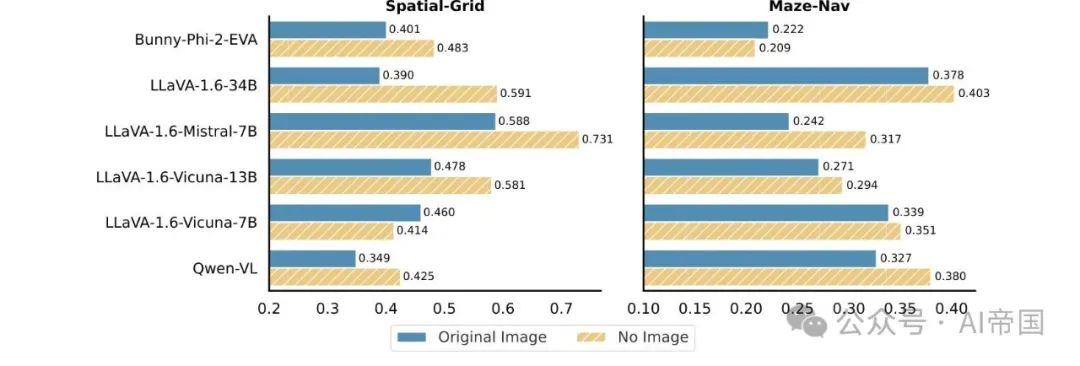

VLMs在视觉输入缺失时表现出更佳的性能。论文通过完全移除原始图像并仅依赖文本描述进行了实验。结果如图7所示。对于每个任务,论文报告了所有问题的平均准确率。值得注意的是,视觉输入的缺失导致了一系列VLM架构性能的提升。例如,在无图像情况下,LLaVA-1.6-34B在Spatial-Grid任务上的表现比有原始图像时提高了20.1%。这一观察强调了当仅凭文本信息就能解答问题时,额外的视觉输入并不一定会增强,甚至可能阻碍性能,这与人类能力形成鲜明对比,因为在人类认知中,视觉线索显著有助于理解。移除视觉输入迫使模型利用文本信息来解决空间推理任务。

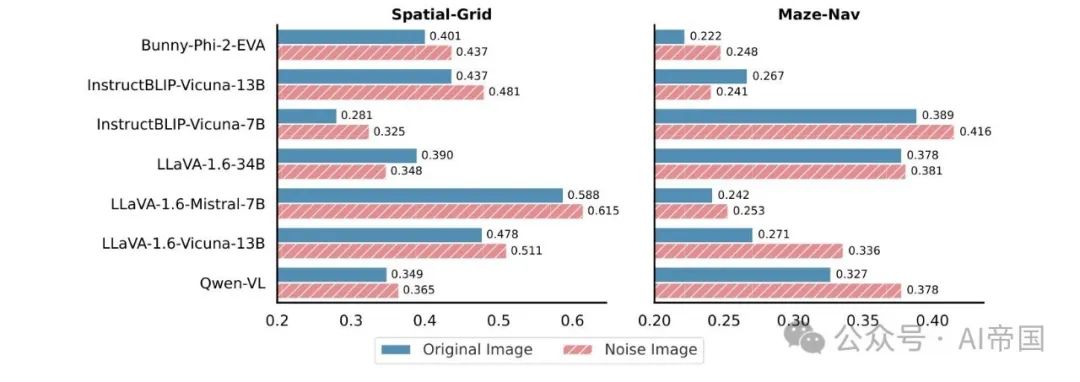

噪声图像可以提升性能。论文用噪声图像替换原始图像,同时保留原始文本描述。结果如图8所示。与原始图像与无图像的发现一致,使用噪声图像也在各种VLM架构中提升了性能。例如,在使用噪声图像而非原始图像的情况下,LLaVA-1.6-Vicuna-13B在Maze-Nav任务上的准确率提高了6.5%。与无图像设置相比,噪声图像提供了有限的视觉线索。尽管如此,模型倾向于优先处理文本信息,尤其是在视觉线索与任务无关时。

2.4.2 利用多模态输入中的冗余

多模态语言模型在处理多模态输入方面展现出极大的灵活性。尽管单独的视觉输入通常足以让人类轻松解决空间推理任务,但论文提出,VLM从视觉数据与文本描述的结合中显著受益,即使这引入了大量冗余。

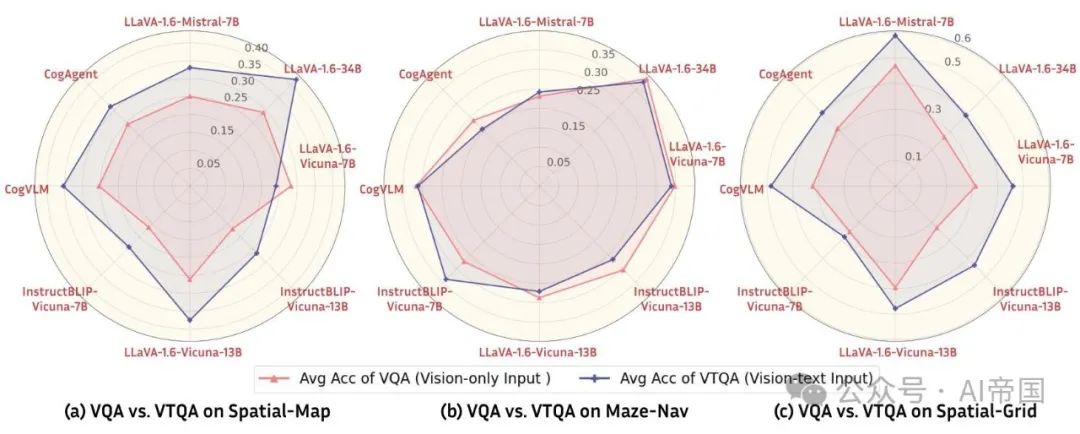

论文通过比较不同VLM架构下的VQA(仅视觉输入)和VTQA(视觉文本输入)来验证这一假设。结果如图10所示,蜘蛛图上的每个顶点代表基于同一VLM的(仅视觉,视觉文本)对的平均准确率。在Spatial-Map和Spatial-Grid任务中,论文可以清楚地看到,与仅使用图像(VQA)相比,增加文本输入(VTQA)在不同VLM架构中提升了性能。这表明文本输入提高了VLM在空间推理方面的准确性。论文进一步在附录C中比较了TQA和VTQA。详细结果包含在附录D中。

图 7:原始图像与无图像在 VTQA 中的对比。当视觉输入缺失时,视觉语言模型在空间推理任务中表现出性能提升

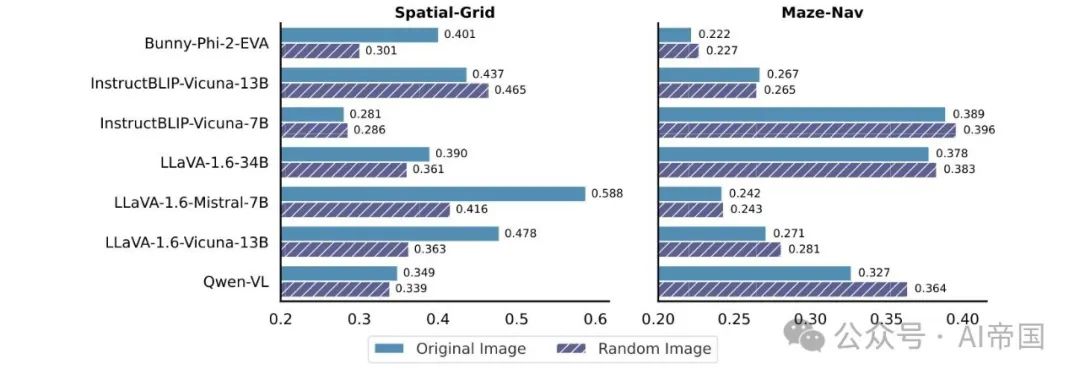

噪声图像的影响。为了建立在先前发现的基础上,论文进一步研究了用随机图像替换原始图像的效果(如图 6 所示)。与噪声图像不同,随机图像与任务相关,但可能提供冲突的信息。直观上,人们可能会预期这种随机图像会因提供矛盾的线索而导致视觉语言模型性能下降。然而,如图 9 所示,这种预期并不总是成立。例如,在迷宫导航任务中,随机图像导致不同视觉语言模型架构的性能提升。这一结果表明,视觉语言模型并不严重依赖视觉信息,尤其是在提供了充分的文本线索时。

图8:VTQA中的原始图像与噪声图像对比。将原始图像替换为高斯噪声图像可提升多种VLM架构的性能

图9:VTQA中的原始图像与随机图像对比。在Maze-Nav任务中,将原始图像替换为随机图像会导致不同VLM架构的性能提升

图10:空间推理任务中VQA与VTQA的比较。蜘蛛图上的每个顶点代表一个(仅视觉,视觉-文本)对的平均准确率,且使用相同的VLM模型。可以看出,相较于仅使用图像(VQA),增加文本输入(VTQA)能提升性能

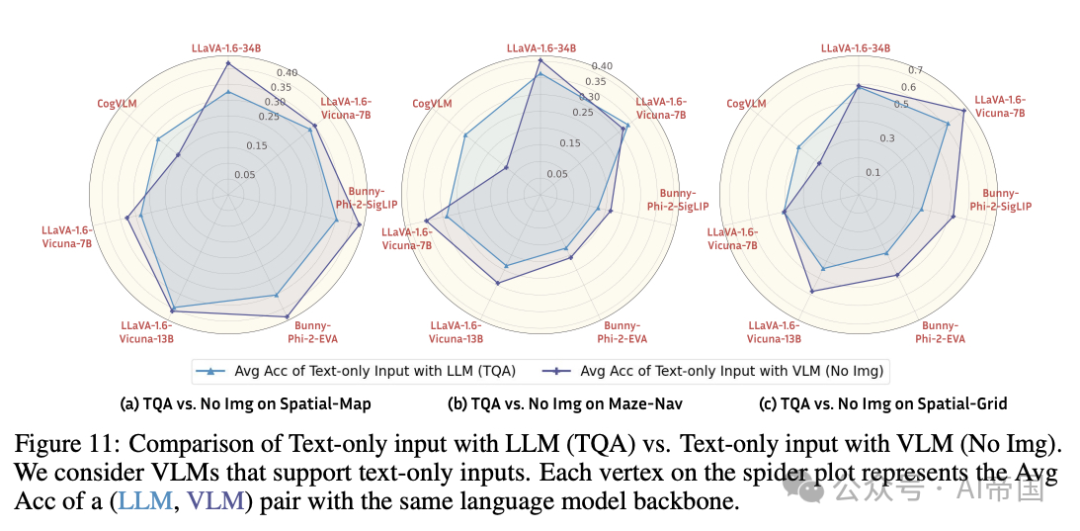

仅文本输入的LLM与仅文本输入的VLM对比。鉴于仅文本输入的有效性,论文进行了一项消融研究,以比较仅使用文本输入的LLMs和VLMs。论文考虑了那些能够在没有伴随视觉数据的情况下处理文本的VLMs。结果如图11所示。除了CogVLM外,大多数VLMs的表现优于其对应的LLM骨干。这表明,VLMs中的语言模型骨干通过多模态学习展示了增强的空间推理能力。相反,增加视觉信息并不一定会带来进一步的好处。

图11:纯文本输入与LLM(TQA)对比纯文本输入与VLM(无图像),论文考虑支持纯文本输入的VLMs。蜘蛛图上的每个顶点代表具有相同语言模型骨干的(LLM, VLM)对的平均准确率(Avg Acc)

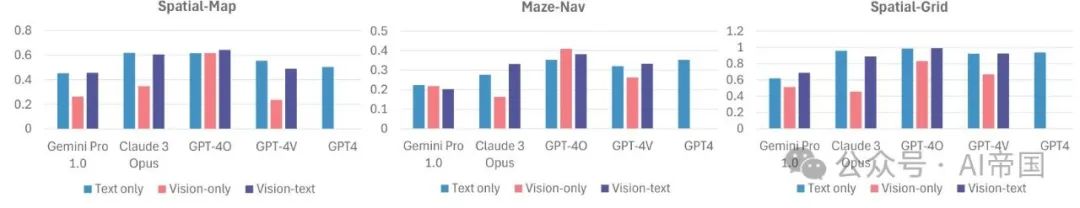

图12:专有模型的结果。与开源模型类似,观察到相似的趋势

2.4.3 专有模型 vs. 开源模型

正如许多最近的基准测试所示,专有模型通常优于开源模型,因此了解论文观察到的趋势是否适用于专有模型至关重要。图12展示了几个顶尖专有模型(GPT-4、GPT-4V、GPT-4O、Gemini Pro 1.0和Claude 3 Opus)的性能。

论文有以下显著观察:(1)正如预期,SoTA开源模型与专有模型之间存在显著的性能差距。此外,无论是纯文本还是视觉-文本格式,GPT-4V和GPT-4O在所有任务中都显著优于随机猜测。例如,在视觉-文本格式中,GPT-4O在Spatial-Grid上的准确率达到0.989(表2)。(2)然而,论文观察到的开源模型的趋势仍然成立,例如,VQA相对于TQA和VTQA持续表现不佳,GPT-4V在从仅视觉切换到视觉-文本输入时,在Spatial-Grid上的性能提升了25.6%;并且在TQA和VTQA之间没有明显的胜者(详见附录C),这表明即使是新的GPT-4O模型,似乎仍然没有完全利用视觉输入。