你想在本地部署大模型吗?本地部署大模型的三种工具 原创 精华

“ 本地部署大模型的本质只是一个客户端”

人工智能的发展如火如荼,也让越来越多的人了解到人工智能;而对大部分人来说使用的都是第三方提供的客户端,不论是网页版,还是PC端或移动端。

那么,我们怎么在本地部署一款大模型呢?下面就来介绍三种工具。

01、本地部署大模型的三种工具

GPT4ALL

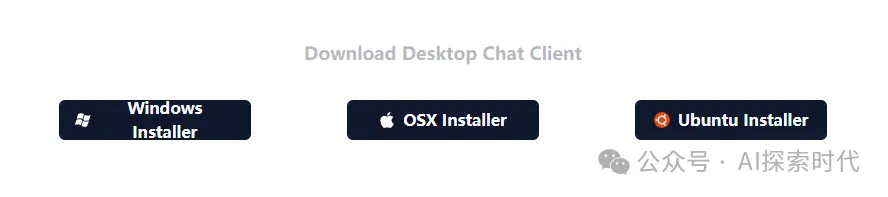

gpt4all是一款可以本地部署大模型的客户端工具,其支持window,macOS和ubuntu(一款linux桌面系统)系列。

其官网地址:https://gpt4all.io/index.html

github地址:https://github.com/nomic-ai/gpt4all

用户可以在自己电脑上安装GPT4ALL客户端,如下图所示:

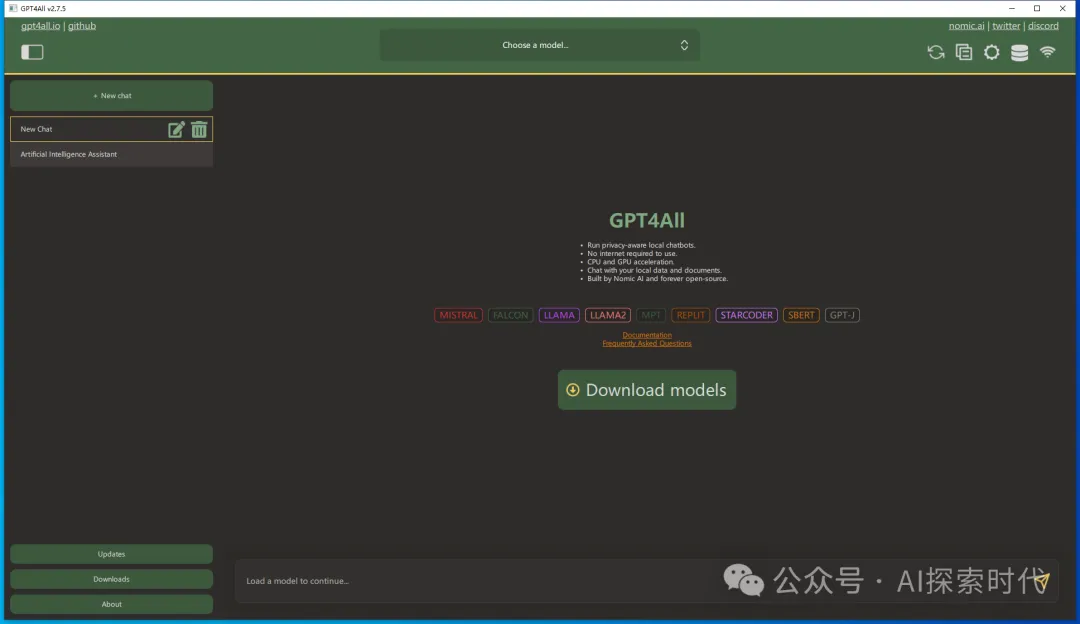

用户可以选择自己需要的模型并进行下载使用,只需要有CPU即可,不需要有GPU的支持。

用户下载完客户端,并加载完模型之后,就可以像使用第三方的大模型一样使用,并且可以脱离网络使用。

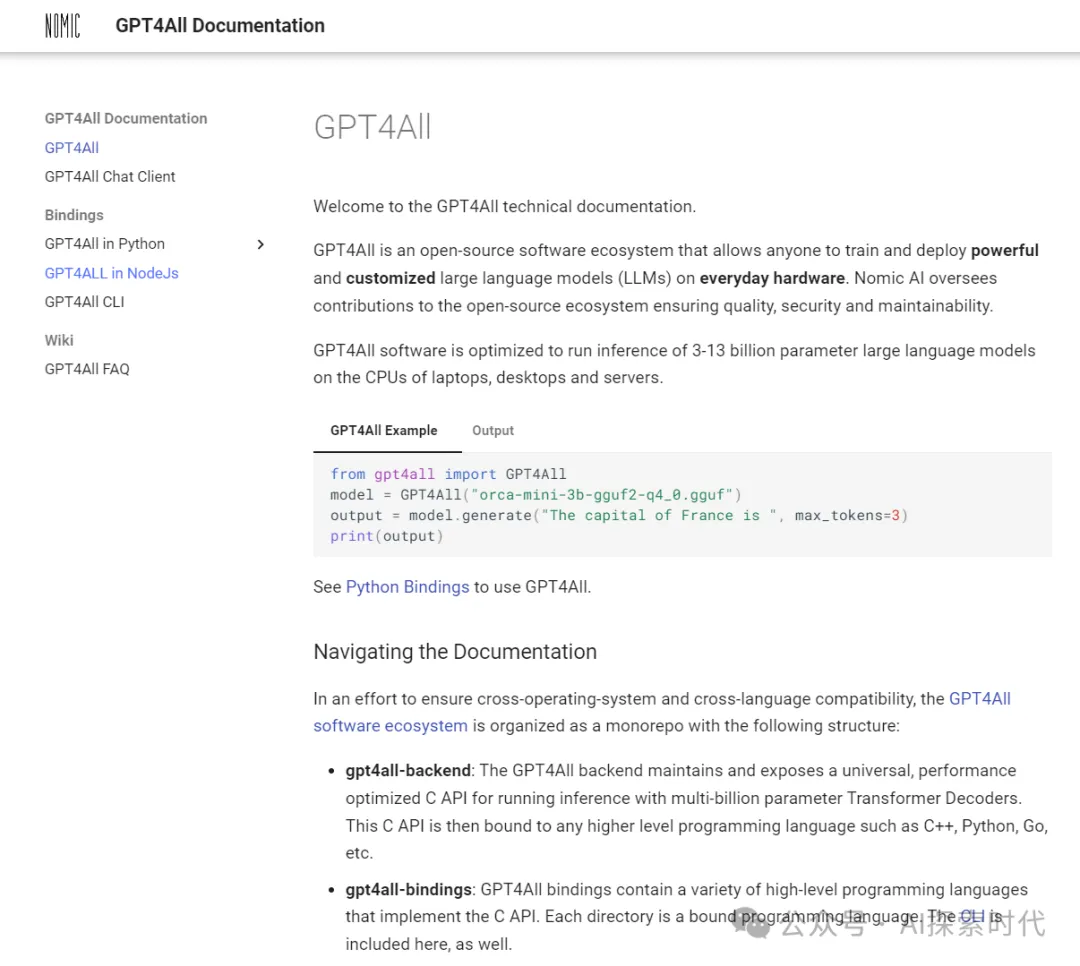

GPT4ALL不但提供了桌面的客户端,对于懂技术的朋友来说,也提供了多语言的编程接口。

如下图所示,GPT4ALL提供了python和nodejs的编程接口。

文档地址:https://docs.gpt4all.io/

LLMStudio

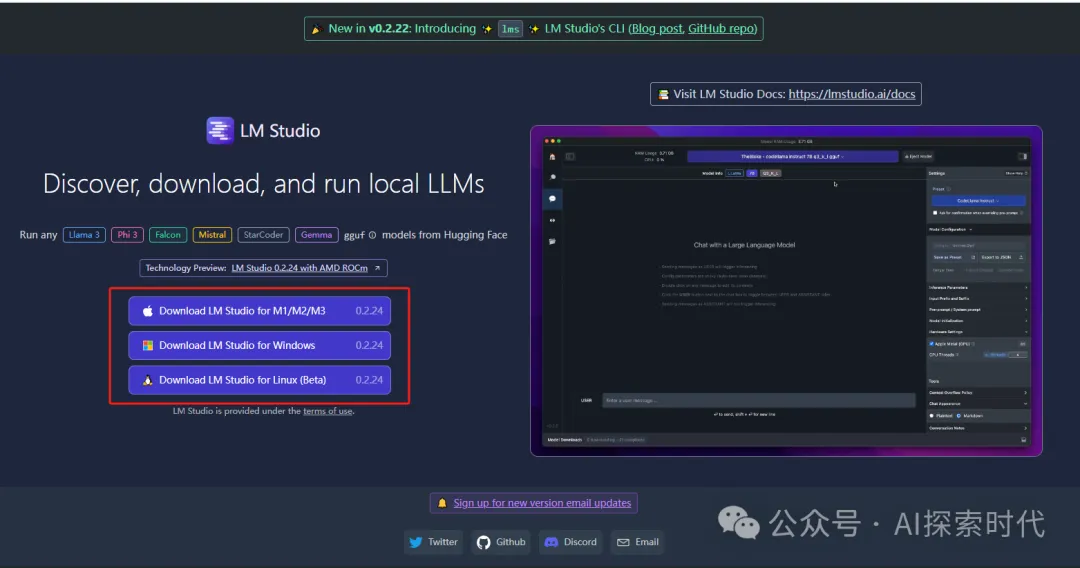

LLMStudio是第二种本地部署大模型的工具,其同样支持多平台的操作系统:

官网地址:https://lmstudio.ai/

github地址:https://github.com/lmstudio-ai/lms

用户界面如下图所示,用户同样可以根据自己的需求下载对应的大模型,并使用。

LLMStudio同样支持接口访问,不过其仅支持通过API调用的方式访问,而不是像GPT4ALL可以直接使用python sdk的方式访问。

文档地址:https://lmstudio.ai/docs/local-server

Ollama

ollama是第三种本地部署大模型的方式,其同样支持三种平台,并且是完全开源的。

官网地址:https://ollama.com/

github地址:https://github.com/ollama/ollama

从使用者的角度来说,三者没有什么本质上的区别;只不过其对不同角色用户友好程度不一样。

比如,个人认为Ollama客户端更适合于开发者,而LLStudio更适合于使用者;因为LLMStudio的UI风丰富,而Ollama更简洁。

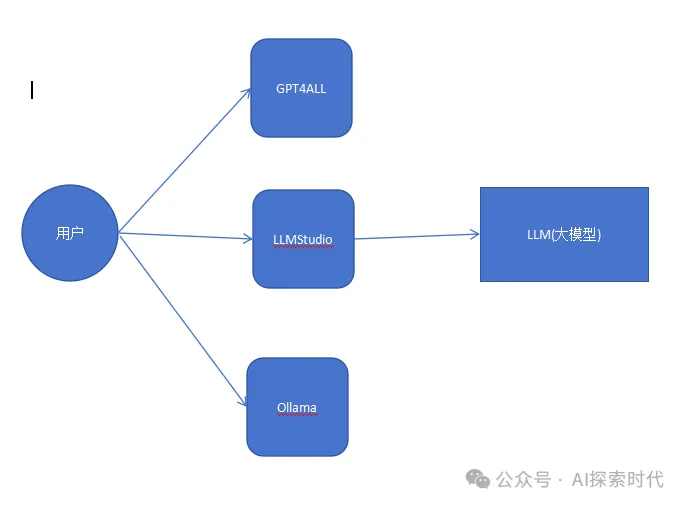

02、技术原理

从本质上来说,三种工具的技术没有本质上的区别,其都作为大模型的客户端来使用,只不过提供了更加丰富的使用方式用户界面和接口的方式。

而因为大模型的编程语言和访问方式的不同,工具可以通过混合编程,使用SDK和网络接口的方式来调用大模型的功能。

调用模型如下图所示:

从技术架构的角度来说,三种工具都采用了C/S模式的架构,LLM大模型作为服务器Server,三种工具作为客户端Client。

当然,对使用者来说需要使用三种工具作为客户端;而对开发者来说,也可以自己开发一款客户端来调用大模型,而如果对人工智能技术也有足够的研究,那么就可以自己开发并训练一款完全符合自己需求的大模型。

对使用者来说,他们需要的是使用好别人提供的大模型客户端;而对开发者来说,可以把大模型作为技术底座,在底座之上构建各种各样的应用。

本文转载自公众号AI探索时代 作者:DFires

原文链接:https://mp.weixin.qq.com/s/egx7Zrw2QoX0ZZajU6TXMA