回复

AI技术新前沿本地LLM模型推理训练加速 原创

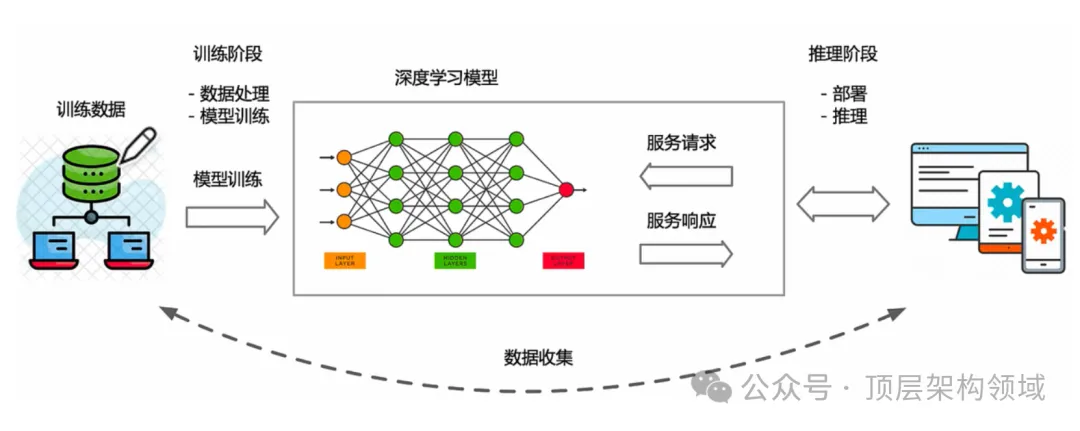

在自然语言处理(NLP)的广阔天地中,大型语言模型(LLM)以其卓越的文本处理能力,引领着智能应用的新潮流。然而,如何高效、安全地在本地环境中部署和运行这些模型,成为了一个待解决的问题。本文将深入探讨七种主流的本地LLM推理框架,评估它们的性能、特性及应用场景,为您提供全面的技术选型参考。

一、Hugging Face的transformers

是一个Python库,可以简化本地运行LLM的过程。

- 技术特性:提供超过40种模型架构,支持150多种预训练模型,提供模型的自动下载和丰富的API接口,具备广泛的NLP任务能力,包括但不限于文本分类、问答、翻译等。

- 优势:拥有庞大的社区和丰富的文档资源,支持快速迭代和实验,提供细粒度的模型控制。

- 缺点:在大规模生产环境中部署时可能需要额外的优化工作,对初学者来说学习曲线较陡峭。

- 应用场景:学术研究、教育、快速原型开发、多样化NLP任务的实验。

二、Llama.cpp

- 技术特性:为高性能多平台硬件优化的推理引擎,支持模型并行和数据并行。提供C++ API,易于集成到现有C++项目中。

- 优势:在Apple Silicon上展现出卓越的性能,支持大型模型的高效推理。针对GPU和CPU都做了推理优化。

- 缺点:目前主要支持Meta的Llama系列模型,对其他模型的支持有限。需要用户具备一定的C++开发能力和对深度学习模型的深入理解。

- 应用场景:高性能计算环境、本地部署大型模型、需要C++集成的应用程序。

三、Llamafile

如果你需要创建一个嵌入模型的单个可执行文件

- 技术特性:Llamafile由Mozilla开发,基于C++开发,使用了Llama.cpp,提供完整的LLM运行时环境,支持模型的创建、加载、运行和导出为单一可执行文件。

- 优势:简化了模型部署流程,便于开发者打包和分发模型。提供了一个简洁的API接口,使得开发人员可以更加方便地与LLM进行交互,从而实现各种复杂的应用场景.

- 缺点:作为较新的技术,可能缺少某些成熟框架的稳定性和全面性。

- 应用场景:需要快速部署和便携式模型执行的环境,如独立应用程序或嵌入式系统。

四、Ollama

- 技术特性:提供图形用户界面和命令行工具,简化了模型的安装、管理和运行过程,支持自动模型下载和版本管理。

- 优势:Ollama是Llama.cpp和Llamafile的一个更加用户友好的替代品。易于安装和使用,可以运行各种模型,运行速度非常快。对用户友好,降低了技术门槛,适合非技术用户。

- 缺点:目前模型库和自定义模型支持有限,须自己管理模型,缺少高级定制功能。可能限制了其在特定场景下的应用。

- 应用场景:适合需要快速运行标准模型且对自定义模型需求不高的用户。

五、vLLM

vLLM是一个高吞吐量和内存高效的大型语言模型(LLMs)推理和服务引擎。它的目标是为每个人提供简便、快捷、经济的LLM服务。

- 技术特性:专注于高吞吐量和内存效率的推理引擎,采用PagedAttention技术,提高了多模型并发处理。

- 优势:高效地管理注意力键和值的内存使用,适合在资源受限的环境中运行大规模模型NLP任务的场景。

- 缺点:需要具备GPU、CUDA和相应的计算环境,对硬件有一定要求。

- 应用场景:大规模NLP任务处理,如批量文本分析、实时文本生成等。

六、TGI

TGI(Text Generation Inference)是HuggingFace推出的大模型推理部署框架。它支持主流大模型和主流大模型量化方案。

- 技术特性:结合Rust和Python的优点,支持模型量化和高效推理,提供连续批处理和多种优化技术技巧。

- 优势:平衡了服务效率和业务灵活性,支持多种硬件环境和量化模型。

- 缺点:相对于vLLM,推理速度可能存在局限,可能需要与传统Transformer模型相结合,以发挥最大效能。

- 应用场景:需要在多种硬件上进行高效推理,对模型大小和推理速度有特定要求的场景。

七、Deepspeed

DeepSpeed是微软推出的一个开源深度学习优化库,它通过系统优化和压缩的方法,深度优化硬件设备、操作系统、框架等方面,并采用模型压缩和数据压缩技术,以提升大规模模型推理和训练的效率。

- 技术特性:提供ZeRO优化器、3D并行技术,支持模型压缩、1比特Adam和张量融合,专为大规模模型设计。

- 优势:显著提升了大规模模型的推理和训练效率,支持多种并行技术,适合复杂模型。

- 缺点:需要较深的系统优化知识,对初学者可能存在较高的技术门槛。

- 应用场景:大规模模型训练和推理,高性能计算环境,复杂的NLP任务。

八、推理框架的选择建议

在选择推理框架时,您可以参考基于以下关键因素做出决策:

- 性能需求:如果您需要高性能的推理能力,特别是在硬件受限的环境中,vLLM和Deepspeed是不错的选择。

- 易用性:对于初学者或非技术用户,Ollama和Hugging Face的transformers提供了更加友好的入门体验。

- 灵活性和定制性:如果您需要高度定制化的模型部署,Llama.cpp和Llamafile提供了更多的控制和灵活性。

- 社区和支持:Hugging Face的transformers和Deepspeed拥有强大的社区和文档支持,适合长期项目和技术发展。

- 特定硬件优化:如果您在特定的硬件平台上运行模型,如Apple Silicon,Llama.cpp可能是最佳选择。

- 多种硬件高效推理:TGI提供了一系列优化技术,如模型并行、张量并行和流水线并行等,这些技术可以显著提升大模型推理的效率。

- 嵌入模型执行文件:Llamafile可能是一个好选择。Llamafile以其便携性和创建单文件可执行文件的能力而闻名。

- 大规模的自然语言处理:vLLM可能是一个好选择。vLLM是一个大规模的预训练模型,可以在各种自然语言处理任务上实现优秀的性能。

- 复杂的自然语言处理:Transformer的模型可能是一个好选择。Transformer模型具有强大的表示能力,可以捕获文本中的长距离依赖关系。

总结:

本地LLM推理框架的选择是一项复杂的决策,涉及性能、兼容性、易用性等多方面的考量。希望能为您的AI项目提供坚实的技术支撑。

本文转载自公众号顶层架构领域

原文链接:https://mp.weixin.qq.com/s/9tjzYSJvVR2-utzzCPdXvA

©著作权归作者所有,如需转载,请注明出处,否则将追究法律责任

已于2024-7-9 11:09:37修改

赞

收藏

回复

相关推荐