2024年了,Diffusion模型还有什么可做的?

纯属brainstorm,欢迎大家一起探讨。我会尽可能举一些具体例子来分析。部分点在我之前的一个相关回答中也有,大家可以移步参考:

当前基于diffusion model的文生图模型有些什么缺陷?

(https://www.zhihu.com/question/647244779/answer/3422163670)

这个回答对之前的回答做进一步的补充完善。我们通过 “数据、模型、优化” 三个角度,再加上能做的 “任务” ,可以将diffusion models的全流程解剖一下,然后一个一个来看,个人比较看好的方向加粗标出:

- 数据

- 生成图像的分辨率

- 生成特定领域图像

- 模型

- 压缩模型

- 网络架构

- 文本编码

- 采样

- 优化

- 对齐特定人类偏好

- 推理

- 任务

- 视频生成

- Instruction-Based Editing

数据

“数据”角度主要还是关注生成图像的一些特性,比如说生成图像的resolution、domain等等。

生成图像分辨率

关注生成图像的“分辨率”其实就是做“High-Resolution Image Synthesis”,个人一直认为属于是 “简单但难解的工程问题” ,原因很简单,分辨率成倍增大,生成模型要生成的像素点就需要以2次方倍的速度增加。

经典的例子一般通过优化压缩模型或者是采用“生成 + 超分”来做。

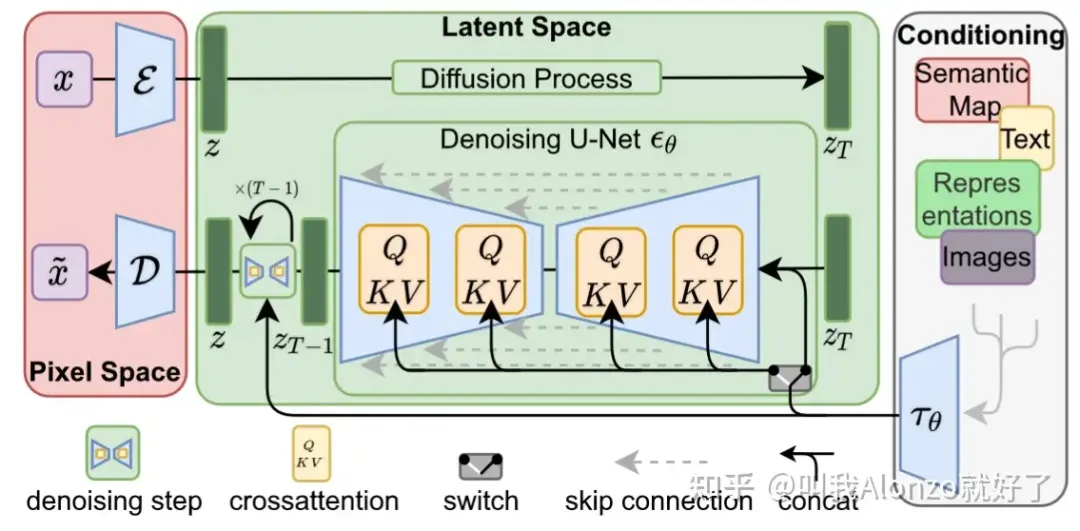

对于前者来说,比较经典的例子就是Stable Diffusion了,将DDPM在pixel space的diffusion process直接搬到VQGAN的隐空间里做,大家都很熟悉了,这里就不再展开。

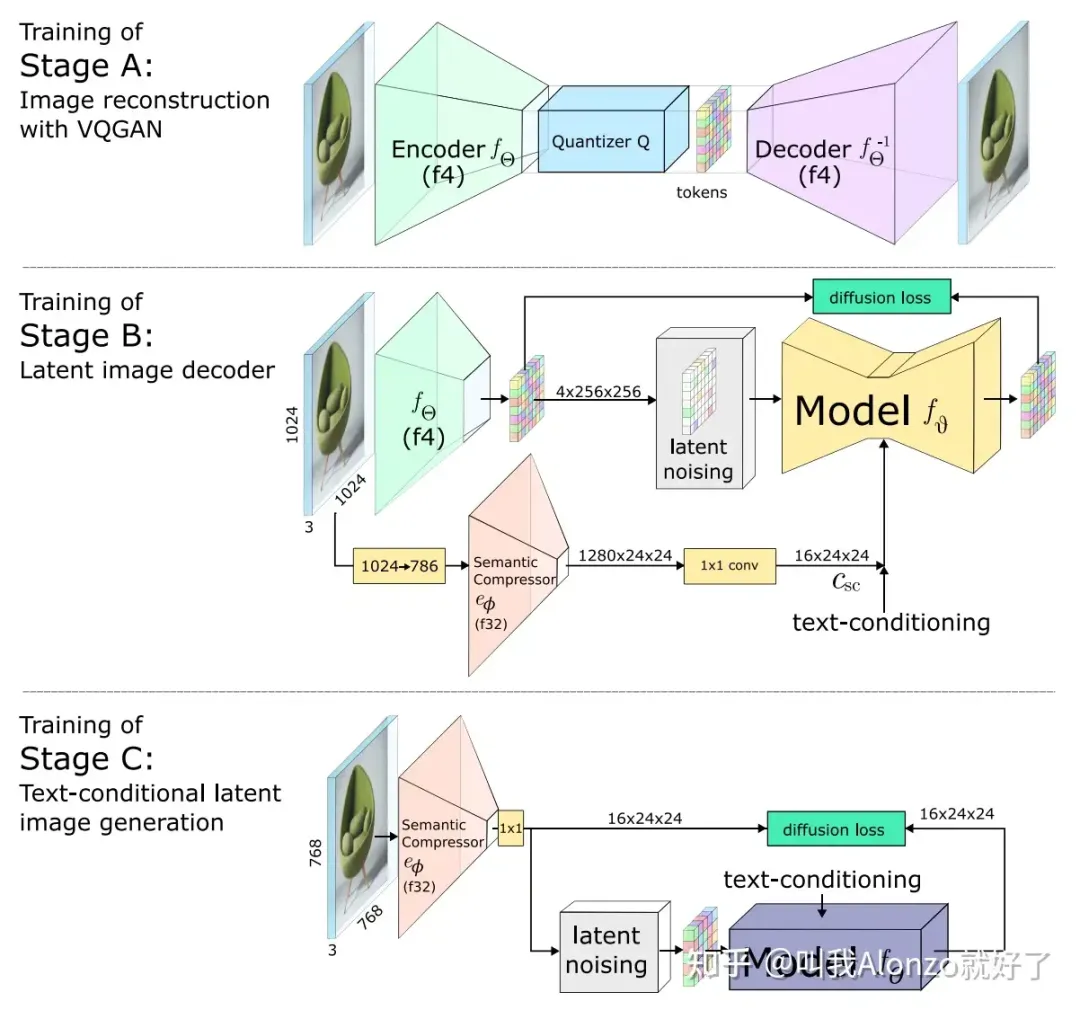

Stable Diffusion的模型架构图

个人感觉这里一个可能的点是怎样优化压缩模型,采用更激进的下采样策略,同时又能保证压缩模型带来的精度损失在可接受的范围内 ,来实现更高分辨率的生成。举个具体例子,Stable Diffusion的VQGAN目前是将512×512的图像,压缩至64×64的latent feature(下采样8倍),假设我们能够拿到这样一个“超级压缩模型”,能够实现512×512到16×16(下采样32倍),那么直接拿Stable Diffusion这一套去用,理论上就能实现2048×2048的更高分辨率生成。

“生成 + 超分”的范式可以关注近期清华 + 智谱AI做的Cogview 3(https://arxiv.org/abs/2403.05121),目前已经能做到最高2048×2048的生成,超分阶

段采用了Relay Diffusion,Relay Diffusion是关于diffusion models的noise scheduling来增强高分辨率生成的工作,挺有意思的,而noise scheduling又属于比较小众的赛道,这一块也还有研究空间。

Cogview 3的结果

关于Relay Diffusion以及Cogview 3的解析,可以参考我的文章:

从Relay Diffusion到Cogview 3:浅谈Noise Scheduling与扩散模型(https://zhuanlan.zhihu.com/p/686899891)

生成特定领域图像

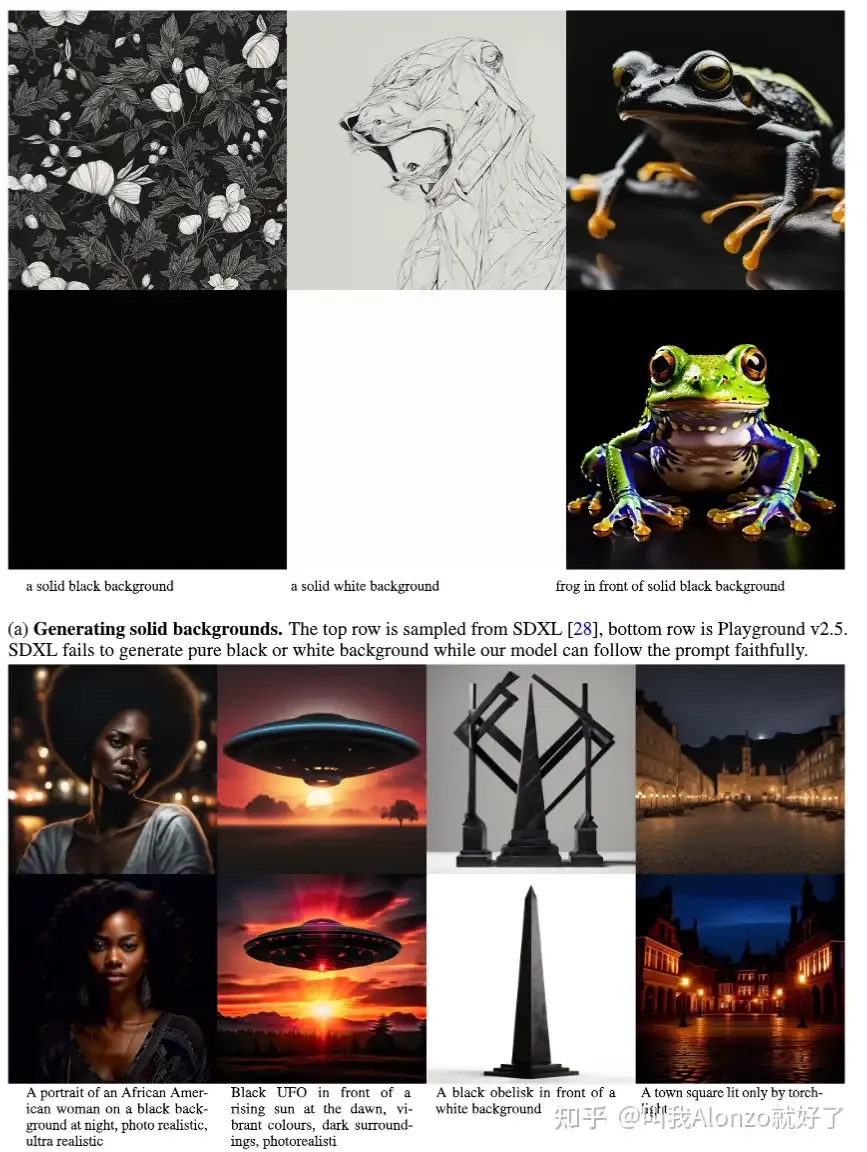

这一块其实涉猎面就挺广的,“特定领域”(specific domain)指的可以是特定“美感”的图片,也可以是灰度图像、线稿图、医疗图像这类专业领域的图片。近期的Playground v2.5其实也是基于这个motivation开展工作的,对比证明了SDXL生成“特定背景下”的图片仍然面临困难:

Playground v2.5的motivation

能做的点,一方面是方法,虽然说Civitai上面众多的SD插件已经证明了LoRA微调是比较有效的方案,但是training-free solution还可以研究;另一方面就是生成什么domain的图像,这就涉及这样做具体有什么应用价值,以及故事应该怎么讲的问题。

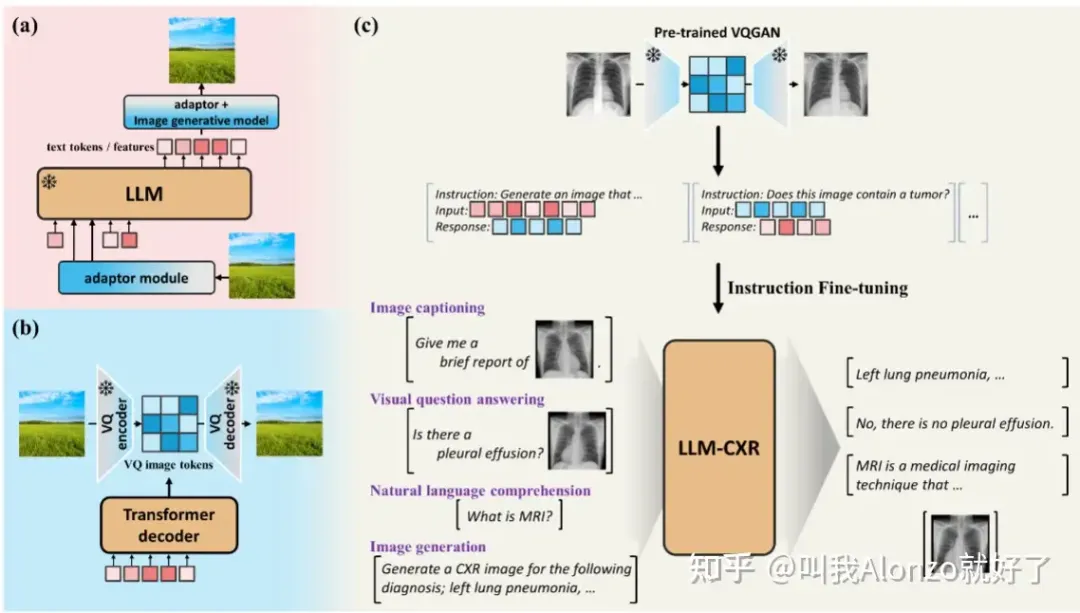

近期有一些做生成医疗图像的工作,尚不清楚其具体应用价值,不过也一同分享出来,有需要的朋友可以参考。例如LLM-CXR(https://arxiv.org/abs/2305.11490):

LLM-CXR的方法流程图

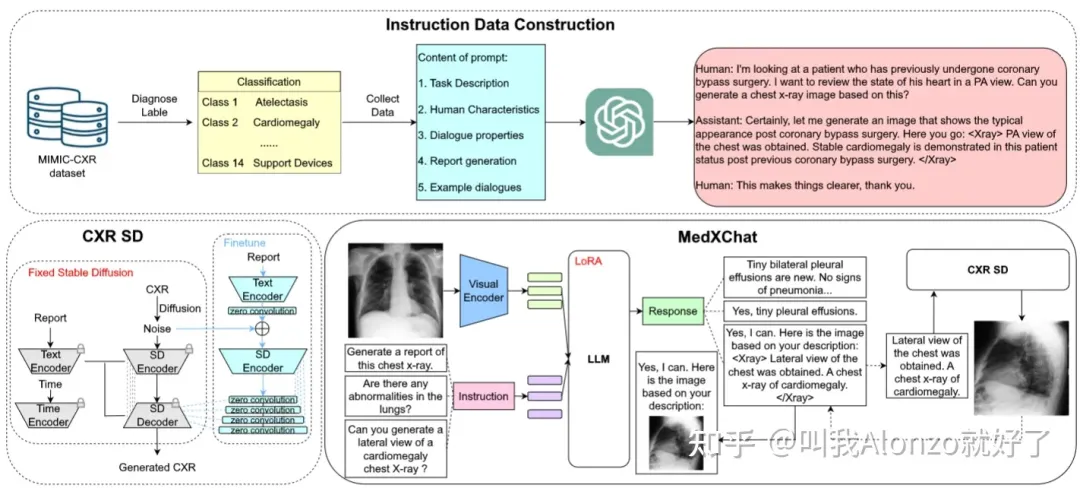

MedXChat(https://arxiv.org/abs/2312.02233):

MedXChat的方法流程图

模型

模型上主要还是按照现有主流latent diffusion models的设计,分为压缩模型、网络架构、文本编码三块,加上模型采样过程的优化。

压缩模型

压缩模型本质是一个图像压缩问题,即怎样尽可能多地节约数据容量,同时又能够保证数据精度的损失可以接受。正是因为这样,懂压缩模型的人其实相对较少,怎样能结合生成的特点设计压缩模型,其实还有较大研究空间。

近期的一些相关研究,例如Wuerstchen(https://arxiv.org/pdf/2306.00637.pdf),提出级semantic compression将图像在像素空间的信息加入到latent diffusion models中:

Wuerstchen的方法流程图

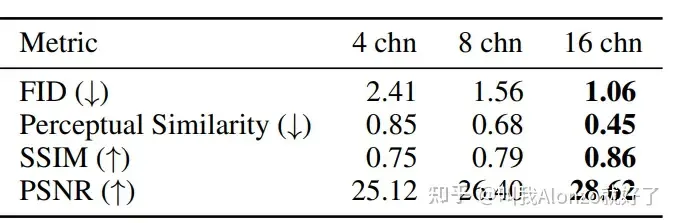

另外近期的Stable Diffusion 3(https://arxiv.org/pdf/2403.03206.pdf)也在压缩模型上做出了改进,将VQGAN latent feature的channel数量增大了,从而减少压缩模型编码-解码过程中的精度损失 ,其重构性能在多个指标上都有显著提升:

Stable Diffusion 3改进后VQGAN的重构性能

尽管如此,现有的改进都偏工程化,压缩模型方面仍有较大的改进空间。关于Stable Diffusion 3的具体分析,可以参考我的往期文章:

一文解读:Stable Diffusion 3究竟厉害在哪里?(https://zhuanlan.zhihu.com/p/685457842)

网络架构

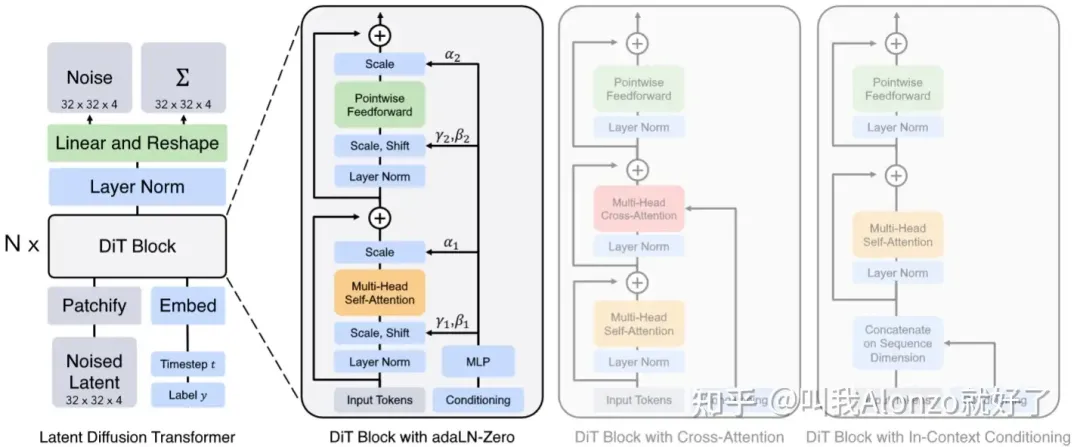

网络架构方面不得不提Diffusion Transformer(https://arxiv.org/abs/2212.09748),既然2024年初OpenAI的Sora(https://openai.com/research/video-generation-models-as-world-simulators)、StabilityAI的Stable Diffusion 3都不约而同采用了这一架构;同时,PixArt系列的工作也一直采用的是这一架构,更加证明了其可行性。这些AI巨头的动作势必会带动一系列基于Diffusion Transformer的工作。

Diffusion Transformer的模型架构图

关于Diffusion Transformer的具体解读,可以参考我的往期文章:

Diffusion Transformer Family:关于Sora和Stable Diffusion 3你需要知道的一切(https://zhuanlan.zhihu.com/p/684448966)

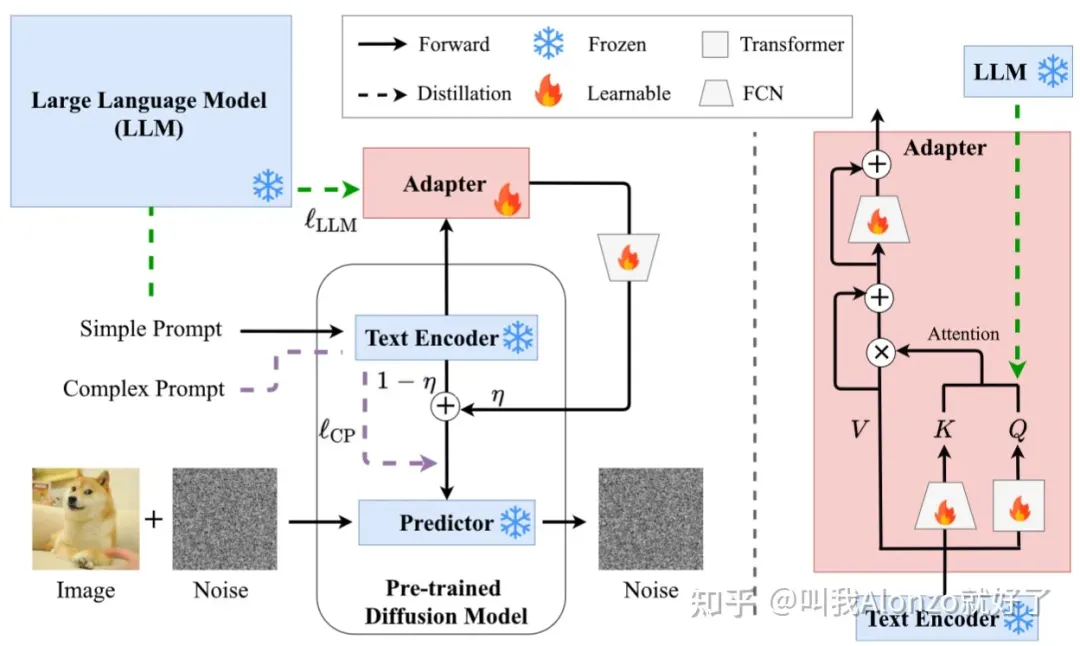

文本编码

文本编码这一块其实是个人比较看好的发展方向,因为目前NLP社区大语言模型的发展也非常快,而大多数diffusion models还是沿用以往工作的CLIP或者T5-XXL来做文本编码。如何将LLM跟diffusion models做结合,以及结合后有什么应用价值 ,目前的工作还不多,例子可以参考ACM MM 2024的SUR-Adapter(https://arxiv.org/abs/2305.05189):

SUR-Adapter的模型架构图

另外值得一提的是,在DALL-E 3的带领下,Re-captioning基本上已成为了现有方法的标配,Cogview 3更是借助GPT-4V的多模态能力通过Visual QA的方式升级了Re-captioning的设计,随着GPT系列多模态能力的进一步增强,通过对GPT做一些prompt engineering拿到更多文本数据,也还大有文章可做。

补充 :“Diffusion + LLM”目前工作也还不多,可能是因为同时需要懂NLP和CV,有一定的技术门槛,具体可以参考我的文章:

When LLMs Meet Diffusion Models:浅谈LLMs与Text-to-Image Diffusion Models中的文本编码(https://zhuanlan.zhihu.com/p/687482566)

采样

采样主要考虑两个方面,一个提升采样质量,二是加速采样。

第一点属于理论性要求比较高的工作,参考Classifier Guidance(https://arxiv.org/abs/2105.05233)和Classifier-Free Guidance(https://arxiv.org/abs/2207.12598),有一定研究难度,但是idea如果work的话也具有巨大的普适价值。

第二点其实是目前主流的趋势,基本上都是基于Progressive Distillation(https://arxiv.org/abs/2202.00512)来做。具体工作可以参考:SDXL-Lightning(https://arxiv.org/html/2402.13929v1)、Stable Cascade(https://stability.ai/news/introducing-stable-cascade)、SDXL Turbo(https://stability.ai/news/stability-ai-sdxl-turbo)、Cogview 3等等,具体不再过多展开。

关于Diffusion Distillation,可以参考我的往期回答:

现如今的知识蒸馏领域,在多模态方面有什么可以做的点子?(https://www.zhihu.com/question/646919153/answer/3420804334)

优化

优化方面个人认为其实也是大有可为的,现有方法大多还是沿用标准的MSE loss,而NLP社区LLM在强化学习方面的研究已经很多了,其实其中可以借鉴的点还比较多。

对齐人类特定偏好

说到LLM结合强化学习,大家第一印象想到的肯定是RLHF。事实上RLHF能做的事情有很多,可以增强样本质量、跟人类偏好做对齐,甚至是跟特定领域对齐,做domain adaptation,等等。

而反观图像生成社区,diffusion models跟强化学习结合的工作其实还不多,比较有名的工作可以参考DDPO(https://arxiv.org/abs/2305.13301)。这方面由于我对强化学习不太熟悉,仅做分享,但从LLM研究的视角来看,在scaled up diffusion models的大趋势下,RLHF想必一定也能有它的用武之地。

推理

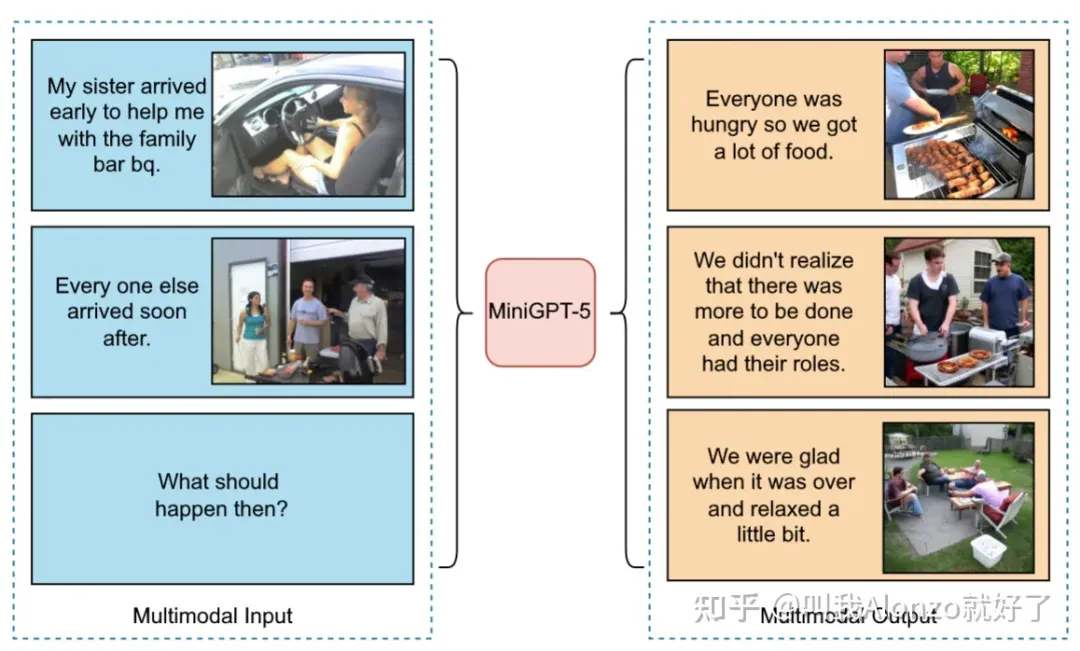

推理方面是个人感觉比较有意思的,相关的工作也还不多。例如名字比较有趣的MiniGPT-5(https://arxiv.org/abs/2310.02239),同样也是“LLM + Diffusion”的工作,可以看下它能做的一个例子:

MiniGPT-5的结果例子

为什么说“推理”值得去做? 个人认为效果如果能够实现图像维度的信息推理,那么就将In-Context Learning又上升了一个高度,具体能做的事情其实很多,比方说Text-to-Comic Generation ,能够生成漫画(如果一致性能保持好的话);Storybook Generation,等等。这些任务如果做得足够好,或许会有新的文生图任务定义,甚至能产生可观的商业价值。

任务

任务上更多的是其他数据模态的生成,或者是文生图的任务变式来考虑。

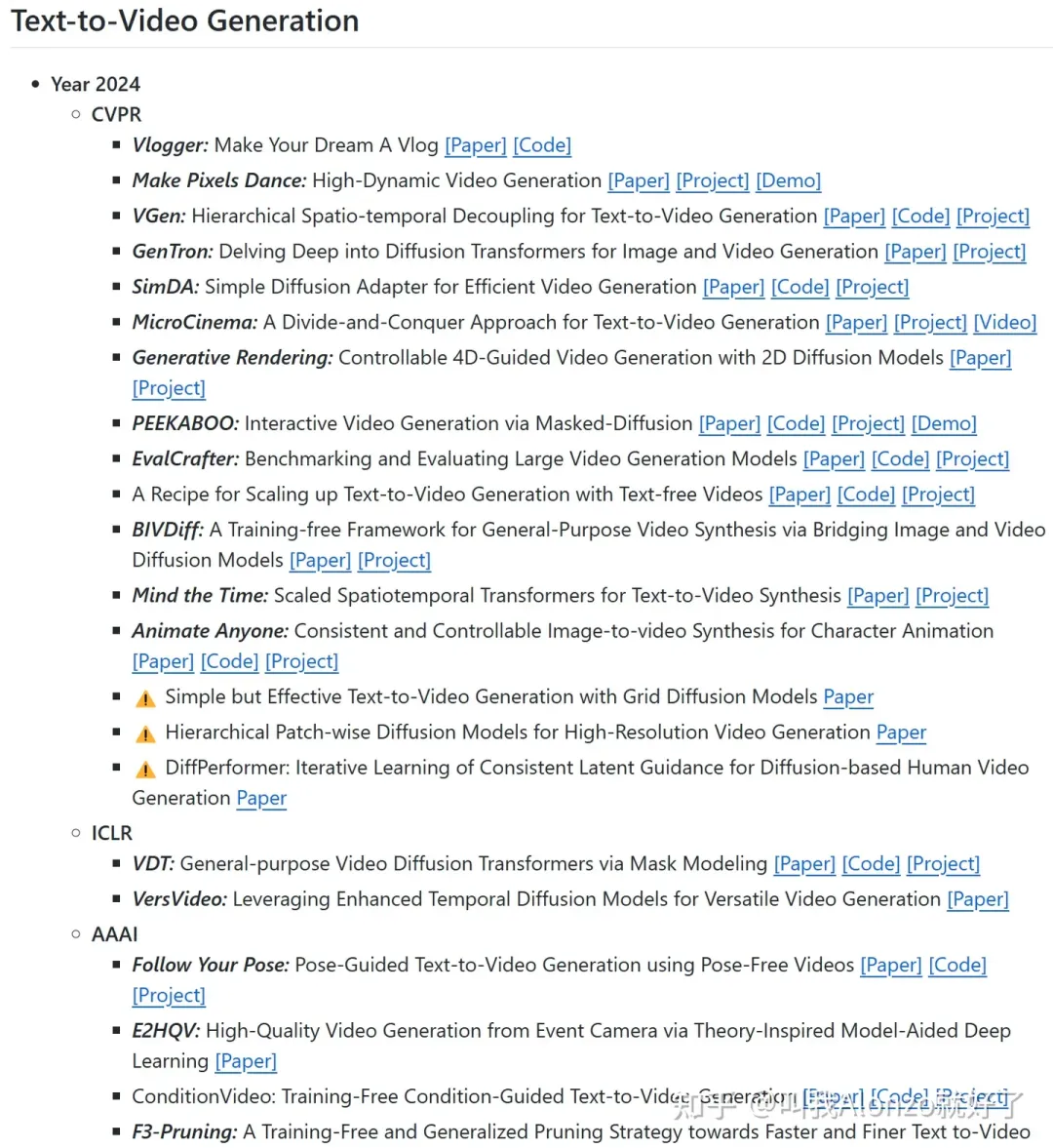

视频生成

视频生成自然不用多说了,年初OpenAI放出的Sora,势必会带来一个视频生成的风口,带动一系列这方面的研究。另一方面,根据个人的调研结果,目前视频生成的工作还不多,仍有较大挖掘空间。关于视频生成的顶会文章,可以参考我GitHub repo收录的paper list:

Video Generation Paper List(https://github.com/AlonzoLeeeooo/awesome-video-generation)

Video Generation GitHub Repo部分截图

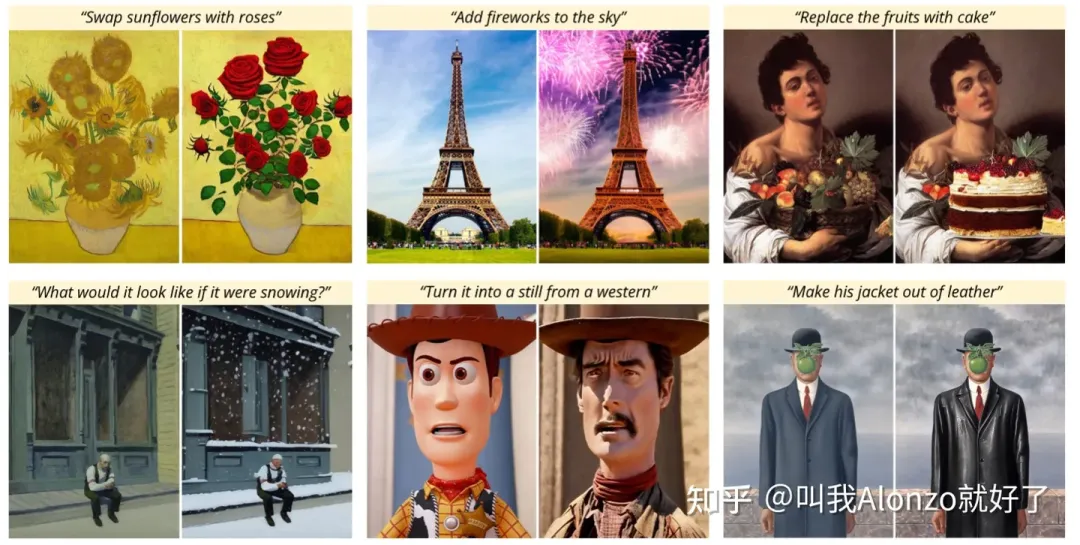

Instruction-Based Editing

Instruction-Based Editing其实属于文生图的一个任务变式,这一任务自从CVPR 2022的InstructPix2Pix(https://arxiv.org/abs/2211.09800)之后,连续两年的CVPR都收录了大约30篇左右的相关工作,而InstructPix2Pix在两年之内也是收获了小600个引用,足以证明这一方向的价值。其本质原理其实也类似前文中说到的 “推理”。

InstructPix2Pix中展示的Instruction-Based Editing的结果例子

关于Instruction-Based Editing的具体研究,可以参考我的往期回答:

对于“扩散模型中的图像编辑”方向,可以推荐论文和相应的开源代码吗?(https://www.zhihu.com/question/647418577/answer/3423639220)

Diffusion Models for NLP

目前从Transformer盛行的NLP社区来看,diffusion models for NLP绝对是一个可以深挖的点,具体可以参考我的回答:

目前有将diffusion model用于文本生成的研究吗?(https://www.zhihu.com/question/558525517/answer/3437058958)

写在最后

从2024年的今天回顾所谓“大模型时代”下diffusion model的发展,总结起来就是一个“大”字——模型规模变大、模型应用范畴变大、应用模态范围变大 。不论是做计算机视觉,还是做NLP相关的研究,diffusion model、large language models、multi-modal learning这些知识似乎都已成为了当下DL研究者必须掌握的技能。然而,想要掌握这些核心技术背后的底层原理,诸如Transformer、Tokenization等等,仅仅通过论文获取信息非常低效,且欠缺系统化;另一方面,论文资源最大的问题就是缺乏实战,尤其是一些未开源/部分开源的工作,这让知识获取的效率、进一步降低了。

其实,书籍资料不失为一种系统化的好方法,一本好的工具书可以通过project-based的讲解,通过实例系统化地给读者呈现底层原理、应用场景,甚至能直观地展示项目的源码,而这些经过提炼的知识在我们刚接触科研、开展新课题、进入新岗位的时候,都能让我们更快地找到状态。笔者在这里给大家推荐一些自己用过书籍资料,这些资料对技术的底层原理都有系统化的讲解和提炼,并且通过实战项目的形式让读者能够学会如何对这些底层原理加以运用。链接如下,有需要的朋友欢迎自行参考:

- 大模型应用解决方案 基于ChatGPT和GPT-4等Transformer

- 快速部署大模型:LLM策略与实践 基于ChatGPT BERT等

本文转自 AI生成未来 ,作者:叫我Alonzo就好了

太棒啦!姐不白看,姐给你点赞👍,感谢分享。

如果需要买阿里云、腾讯云、华为云、AWS可以找我,官网折上折。TG:@ElinaJVcloud 微信/电话:13603048836