智能推理新路径:组合优化在生成式AI中的前沿探索

尽管LLMs在生成自然语言文本方面表现出色,但在推理任务中的表现却不尽如人意。推理任务需要模型具备更高层次的认知能力,包括逻辑推理、因果关系分析和战略规划等。然而现有的LLMs在这些方面的能力有限,主要表现在缺乏深度推理能力,LLMs在处理复杂推理任务时,往往依赖于简单的模式匹配和统计规律,缺乏真正的逻辑推理能力。易受幻觉影响,LLMs在生成文本时,有时会产生与事实不符或无意义的内容,这被称为“幻觉”现象。这在推理任务中尤为明显,因为推理任务需要模型生成高度准确和一致的答案。依赖人工提示,现有的许多推理方法,如链式思维(Chain of Thought, CoT)和自一致性(Self-Consistency),都依赖于人工设计的提示和示例,这限制了它们的泛化能力和自动化程度。

为了解决这些问题,纽约cosa Computing Inc.公司、NASA ARC量子人工智能实验室等多个组织的团队提出了一种新的框架——组合推理(Combinatorial Reasoning, CR)。该框架通过组合优化技术,自动生成用于推理任务的提示,从而提高LLMs在推理任务中的表现。CR框架的核心思想是将从LLM管道中采样的理由映射为二次无约束二进制优化(QUBO)问题,通过优化选择有用的理由子集,构建链式思维风格的提示。

本研究由来自多个机构的专家团队合作完成,涵盖了生成式AI、量子计算、数据科学和优化算法等多个领域。研究团队成员有纽约Icosa Computing Inc.公司成员Mert Esencan, Tarun Advaith Kumar, Can Unlu, Alan Ho。Icosa Computing Inc. 是一家位于纽约的公司,专注于计算技术和人工智能的前沿研究与开发。团队成员在生成式AI和优化算法方面具有丰富的经验。NASA ARC的量子人工智能实验室的成员Ata Akbari Asanjan, P. Aaron Lott, Davide Venturelli。NASA ARC的量子人工智能实验室(QuAIL)致力于探索量子计算在人工智能中的应用。该实验室位于加利福尼亚州的Moffett Field,研究重点包括量子优化和量子机器学习。NASA ARC数据科学组的成员Ata Akbari Asanjan,NASA ARC数据科学组是NASA ARC的一部分,专注于数据分析和机器学习技术的研究与应用。团队成员在大数据处理和分析方面具有深厚的专业知识。USRA高级计算科学研究所的成员P. Aaron Lott, Davide Venturelli,USRA高级计算科学研究所(RIACS)与NASA合作,进行高级计算和人工智能领域的研究。研究所位于加利福尼亚州的Moffett Field,致力于推动计算科学的前沿发展。惠普实验室的LSIP(Large-Scale Integrated Photonics)部门成员Masoud Mohseni,惠普实验室的LSIP(Large-Scale Integrated Photonics)部门位于加利福尼亚州Milpitas,专注于大规模集成光子学和量子计算的研究。团队成员在物理学和计算科学方面具有丰富的研究经验。DataStax 公司的成员Alan Ho, DataStax是一家位于加利福尼亚州圣克拉拉的公司,专注于数据管理和数据库技术。公司致力于提供高性能的数据库解决方案,支持大规模数据处理和分析。

LLMs概述

大型语言模型(Large Language Models, LLMs)是基于深度学习技术的机器学习模型,专门用于处理和生成自然语言文本。与传统的语言模型相比,LLMs拥有极其庞大的参数量,通常达到数十亿甚至上百亿级别。这些模型通过在海量文本数据上进行训练,能够捕捉语言中的复杂模式和结构,从而生成高度连贯和自然的文本。

尽管LLMs在生成和理解自然语言方面表现出色,但在处理需要深度推理的任务时仍存在一定的局限性。为了提高LLMs的推理能力,研究人员提出了多种推理方法,其中最具代表性的是链式思维(Chain of Thought, CoT)和自一致性(Self-Consistency)。

1. 链式思维(CoT)

链式思维是一种通过在提示中加入中间推理步骤来增强LLMs推理能力的方法。具体来说,CoT方法通过手动标注的示例,展示了从问题到答案的推理过程。这些示例被用作提示,指导LLMs生成包含推理路径的回答。

CoT方法能够显著提高LLMs在推理任务中的表现,特别是在需要多步推理的复杂任务中。

局限性是CoT方法依赖于人工标注的示例,这不仅耗时耗力,而且这些示例可能无法泛化到不同类型的任务。此外,手动标注的示例数量有限,难以覆盖所有可能的推理路径。

2. 自一致性(Self-Consistency)

自一致性是一种改进的解码方法,旨在提高CoT提示的性能。与贪婪解码不同,自一致性方法通过在非零温度下收集多个样本,并选择出现次数最多的答案。这种方法基于这样一个直观的假设:推理问题可能有多条正确的推理路径,但错误的推理路径会导致不同的错误答案。

自一致性能够通过对多个推理路径进行边际化处理,生成更准确的答案。这种方法在处理复杂推理任务时表现尤为出色。

自一致性方法同样依赖于手动标注的示例,并且需要大量计算资源来生成和评估多个样本。此外,这种方法在处理具有高度不确定性的任务时,可能会面临性能瓶颈。

尽管这些现有的推理方法在一定程度上提高了LLMs的推理能力,但它们的局限性也显而易见。为了克服这些局限性,本文提出了一种新的框架——组合推理(Combinatorial Reasoning, CR),通过组合优化技术,自动生成用于推理任务的提示,从而进一步提升LLMs在推理任务中的表现。

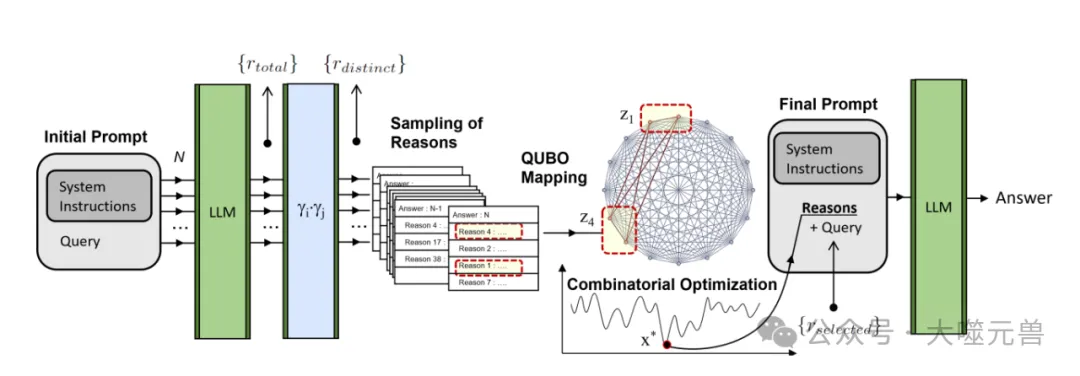

图1:组合推理的工作流程。LLM对初始提示进行N次处理,并通过语义匹配过程对答案进行过滤,以产生具有不同原因的答案。该系综被映射到由Ising机器解决的QUBO问题中。最终解决方案确定了一组要添加到最终LLM调用提示中的原因,该调用将确定最终答案。

组合推理(CR)框架

CR框架的提出

随着生成式人工智能(Generative AI)和大型语言模型(LLMs)的快速发展,这些模型在自然语言处理任务中展现了强大的能力。然而尽管LLMs在生成自然语言文本方面表现出色,但在处理需要深度推理的任务时仍存在显著的局限性。现有的推理方法,如链式思维(Chain of Thought, CoT)和自一致性(Self-Consistency),虽然在一定程度上提高了LLMs的推理能力,但它们依赖于人工标注的示例,难以实现自动化和泛化。

为了克服这些局限性,研究团队提出了一种新的框架——组合推理(Combinatorial Reasoning, CR)。CR框架的核心思想是通过组合优化技术,自动生成用于推理任务的提示,从而提高LLMs在推理任务中的表现。具体来说,CR框架通过将从LLM管道中采样的理由映射为二次无约束二进制优化(QUBO)问题,并利用优化技术选择有用的理由子集,构建链式思维风格的提示。

CR框架的四个阶段

CR框架包括四个主要阶段:理由采样、QUBO映射、组合优化求解和最终提示创建。以下是每个阶段的详细介绍。

理由采样

在CR框架的第一个阶段,研究团队需要从LLM中采样理由。具体步骤如下:

- 准备输入提示:给定一个问题,从数据集中准备N个相同的输入提示,并在固定温度下查询LLM。每个输出将包含一组理由。

- 语义嵌入:使用HuggingFace的Sentence Transformer(如all-mpnet-base-v2)将每个理由嵌入到一个标准化的768维向量中。

- 相似度计算:定义两个理由之间的相似度度量为对应嵌入向量的点积。如果相似度大于某个阈值(如ζ),则认为这两个理由是相同的。

- 理由去重:使用上述相似度计算方法,将所有采样的理由减少为一个较小的独立理由集,并生成嵌入向量集合。

通过上述步骤,研究团队可以得到以下集合:

- {s}:每个样本包含一个答案和一组理由。

- {rtotal}:从LLM中采样的所有理由集合。

- {rdistinct}:通过Sentence Transformer选择的独立理由集合。

- ni:每个独立理由在N个样本中出现的次数。

- nij:每对独立理由在任意一个样本中共同出现的次数。

这些计数是组合推理的基础,研究团队将使用它们来计算QUBO映射中所需的量。

QUBO映射

在CR框架的第二个阶段,研究团队将采样的理由映射为二次无约束二进制优化(QUBO)问题。具体步骤如下:

- 定义变量:将每个独立理由与一个整数变量zi关联。变量的整数范围选择为二进制编码的最大幂。

- 构建目标函数:目标函数由两个部分组成:L和Q。

- L:基于理由出现频率选择理由。定义pi为理由的“流行度”,ri为频率的标准差模块。

- Q:捕捉理由之间的相关性。定义cij为两个理由之间的连接相关性。

- 目标函数公式:

- L = ∑li(µ, α)zi = ∑[µ pi - αri] zi

- Q = ∑qij (β)zizj = ∑[cij - c¯- β δc] zizj

- QUBO形式:通过二进制编码公式,将目标函数转换为QUBO形式。

通过上述步骤,研究团队可以将采样的理由映射为一个QUBO问题,准备进行组合优化求解。

组合优化求解

在CR框架的第三个阶段,研究团队使用伊辛机和其他优化技术求解QUBO问题。具体步骤如下:

- 配置伊辛机:使用预定义的参数设置策略配置伊辛机,旨在找到最合适的解决方案。

- 求解QUBO问题:伊辛机通过模拟退火、自适应并行回火等技术,优化QUBO问题,找到全局最优解或近似解。

- 选择理由:根据优化结果,选择zi > 0的理由,并为每个理由分配一个相对重要性的权重w。

通过上述步骤,研究团队可以得到优化后的理由集合,为最终提示创建做好准备。

最终提示创建

在CR框架的最后一个阶段,研究团队根据优化结果创建最终的提示,并用于LLM的查询。具体步骤如下:

- 映射回理由集合:将QUBO问题的最佳候选解决方案映射回理由集合,每个理由前面加上其权重w。

- 排序和组合:根据权重对理由进行排序,并组合成一个提示字符串。

- 生成最终提示:将组合好的提示字符串用于LLM的查询,以零样本模式进行推理任务。

通过上述步骤,研究团队可以生成一个包含优化理由的提示,提高LLM在推理任务中的表现。

组合推理(CR)框架通过组合优化技术,自动生成用于推理任务的提示,克服了现有推理方法的局限性。CR框架包括理由采样、QUBO映射、组合优化求解和最终提示创建四个阶段,通过优化选择有用的理由子集,构建链式思维风格的提示,从而提高LLMs在推理任务中的表现。

实验结果与分析

实验设置

研究团队使用了GPT-3.5-turbo-0125作为实验所用的大型语言模型(LLM)。GPT-3.5-turbo是OpenAI开发的一系列模型之一,专门用于生成类人自然语言文本。该模型具有16,385个上下文窗口,并能返回最多4,096个令牌的输出。为了确保实验的公平性和一致性,研究团队选择了BIG-bench Hard(BBH)任务集进行评估。BBH任务集包含了一系列推理导向的问题,这些问题在过去对LLMs来说一直是具有挑战性的。

为了节省推理时间和成本,研究团队从每个子任务中随机抽取了50个问题,共计1350个问题,组成了一个评估集。在这个评估集上,研究团队将CR框架与以下几种方法进行比较:

- 修改版零样本提示

- 通用自适应提示(USP)

- 标准三样本链式思维(CoT)提示

在理由采样阶段,研究团队对LLM进行了N=210次采样,温度设为1,以收集足够的独立理由,并计算它们的分布和相关矩阵。相似度阈值ζ设为0.90,这一数值是通过对测试问题的经验确定的。在运行QUBO映射之前,研究团队使用Optuna框架对映射参数进行了调优,选择了最优的参数值。

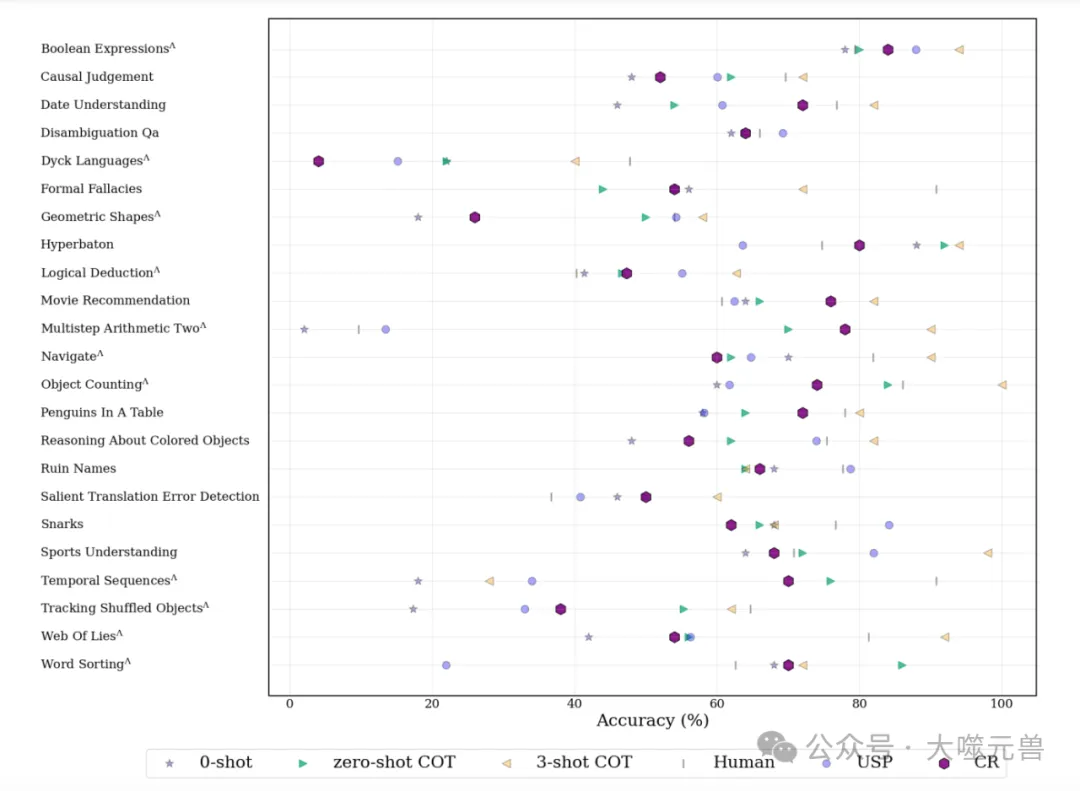

图2:组合推理(CR)相对于其他方法的性能。人类和USP结果分别来自BBH和USP的出版物。USP在不同但可比较的LLM PaLM 2-M上进行评估。

实验结果

实验结果显示,CR框架在BBH任务集上的表现优于其他零样本方法。具体结果如下:

- 平均表现:CR框架的平均准确率为59.88%,显著高于零样本提示(47.68%)和通用自适应提示(55.89%),但低于三样本CoT提示(74.20%)。

- 平均排名:CR框架在所有方法中的平均排名为2.57,优于零样本提示(3.22)和通用自适应提示(2.78),但不及三样本CoT提示(1.35)。

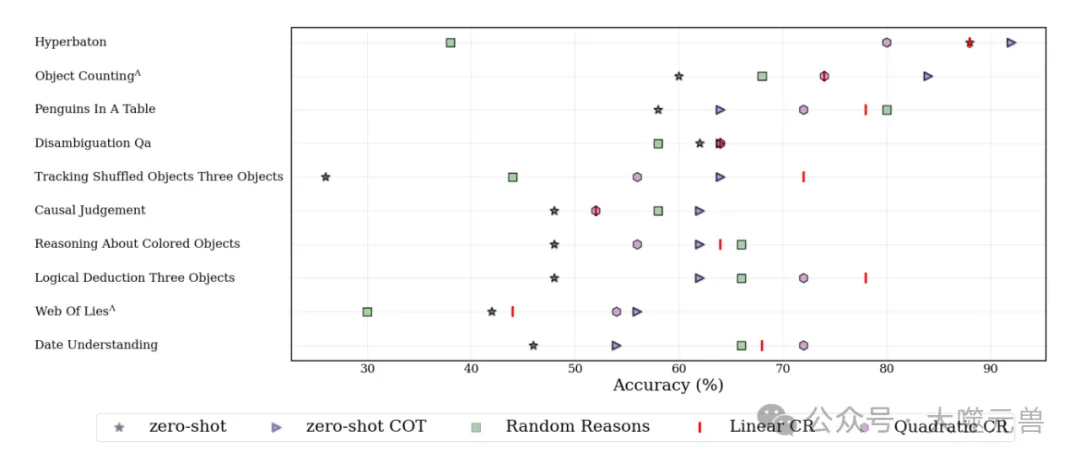

图3:具有线性CR和随机原因的二次CR(与正文相同)的基线分析。十个数据集的总体性能为二次CR:65.2%,线性CR:68.2%,随机:57.4%. 包括0次和0次CoT结果以供参考。根据0-发射CoT的性能对各个任务进行排序。

此外研究团队还进行了人工评估,验证了CR框架在每个阶段的效果。结果表明,CR框架通过优化显著减少了独立理由的数量,提高了提示的质量。

结果分析

通过对实验结果的分析,研究团队发现CR框架在不同任务上的表现具有以下优势和不足:

优势是

- 自动化程度高:CR框架通过组合优化技术,自动生成用于推理任务的提示,减少了对人工标注示例的依赖,提高了提示生成的自动化程度。

- 推理能力增强:CR框架通过选择有用的理由子集,构建链式思维风格的提示,显著提高了LLM在推理任务中的表现。

- 适应性强:CR框架能够适应不同类型的推理任务,通过优化选择最相关的理由,提高了提示的准确性和相关性。

不足的问题是

- 计算资源需求高:CR框架在理由采样和QUBO映射阶段需要大量的计算资源,特别是在处理大规模数据集时,计算成本较高。

- 复杂任务表现有限:尽管CR框架在大多数任务中表现优异,但在一些复杂任务(如形式谬误类别)中,仍存在一定的性能瓶颈。这可能是由于QUBO映射和组合优化求解器的局限性所致。

- 语义匹配改进空间大:在理由采样阶段,尽管使用了Sentence Transformer进行语义嵌入和相似度计算,但仍有许多语义相同的理由被识别为不同。改进语义匹配程序可以进一步提高QUBO映射和整个CR框架的有效性。

CR框架通过组合优化技术,显著提高了LLM在推理任务中的表现,展示了其在生成式AI推理任务中的巨大潜力。然而,未来的研究仍需在计算资源优化、复杂任务处理和语义匹配改进等方面进行进一步探索,以充分发挥CR框架的优势。

研究总结

论文提出的组合推理(Combinatorial Reasoning, CR)框架,通过组合优化技术,显著提升了大型语言模型(LLMs)在推理任务中的表现。

CR框架通过将从LLM管道中采样的理由映射为二次无约束二进制优化(QUBO)问题,并利用优化技术选择有用的理由子集,自动生成用于推理任务的提示。这一方法减少了对人工标注示例的依赖,提高了提示生成的自动化程度。

通过选择有用的理由子集,CR框架能够构建链式思维(Chain of Thought, CoT)风格的提示,显著提高了LLM在推理任务中的表现。实验结果显示,CR框架在BIG-bench Hard(BBH)任务集上的平均准确率为59.88%,优于其他零样本方法。

CR框架能够适应不同类型的推理任务,通过优化选择最相关的理由,提高了提示的准确性和相关性。实验结果表明,CR框架在多个推理任务上表现优异,展示了其广泛的适用性。

通过在GPT-3.5-turbo-0125模型上进行实验,验证了CR框架的有效性。实验结果显示,CR框架在平均表现和排名上均优于其他零样本方法,证明了其在推理任务中的优势。

尽管CR框架在推理任务中表现出色,但仍有一些不足之处需要改进。例如,计算资源需求高、复杂任务表现有限以及语义匹配程序有待优化等。这些问题为未来的研究提供了方向和挑战。

CR框架在生成式AI推理任务中的应用前景广阔,未来的研究可以在以下几个方面进行探索和改进。

优化时间和准确性:进一步优化语义匹配程序,通过调整相似度阈值或采用更高级的语义匹配算法,提高QUBO映射的有效性。QUBO映射:优化目标函数的构建,增加对高阶相关性的考虑,研究图的属性和自旋玻璃的物理特性,以提高最终答案的准确性。组合优化求解器:探索使用更高效的求解器,如硬件高效的数字实现和量子求解器,通过混合策略进一步提高求解效率和准确性。

框架的泛化:将定理证明器(如Z3)集成到CR框架中,作为后处理步骤来消除冲突理由,结合概率求解器和确定性求解器的方法,在开放域问题上实现更高效的推理。与检索增强生成(RAG)的集成:将检索增强生成技术集成到CR框架中,通过语义搜索从知识库中检索相关信息,并将其作为上下文加入到理由采样过程中,提高推理的准确性和相关性。

在不同应用场景中的潜力:在金融领域CR框架可以用于风险评估、投资组合优化和市场预测等任务,通过自动生成推理提示,提高决策的准确性和效率。医疗领域:在医疗领域,CR框架可以用于疾病诊断、治疗方案推荐和医学研究,通过结合医学知识库和推理能力,提供更精准的医疗建议。法律领域:在法律领域,CR框架可以用于法律推理、案件分析和法律文书生成,通过自动生成法律推理路径,提高法律工作的效率和准确性。

组合推理(CR)框架通过组合优化技术,显著提高了LLM在推理任务中的表现,展示了其在生成式AI推理任务中的巨大潜力。未来的研究可以在优化时间和准确性、框架的泛化和不同应用场景的扩展等方面进行进一步探索,以充分发挥CR框架的优势。通过不断改进和扩展,CR框架有望在更多领域中实现广泛应用,为复杂推理任务提供更高效和智能的解决方案。(END)

参考资料:https://arxiv.org/pdf/2407.00071

本文转载自 大噬元兽,作者: FlerkenS