CVPR 2024 | 长时舞蹈生成:数秒钟可生成极长的3D舞蹈

以下视频来源于

THUSIGSICLAB

论文题目:

Lodge: A Coarse to Fine Diffusion Network for Long Dance Generation Guided by the Characteristic Dance Primitives

论文链接:

https://arxiv.org/abs/2403.10518

主页链接:

https://li-ronghui.github.io/lodge

代码链接:https://github.com/li-ronghui/LODGE

一、 研究动机

近年来,随着生成式人工智能的快速发展,现有方法如FineDance[1] ,EDGE[2]已经展示出了数秒钟高质量舞蹈的能力。然而,实际应用中的舞蹈表演和社交舞通常持续3至5分钟,舞蹈剧可以持续15分钟以上。因此,现有的舞蹈生成算法难以满足实际需求,而如何生成高质量的长序列舞蹈动作成为了正待解决的问题。然而,生成长序列的舞蹈仍面临着不少挑战:

- 长序列数据显著增大了计算开销,如何开发计算友好的方法,提高训练和推理阶段的效率?

- 现有的方法主要采用自回归模型,迭代地生成长序列舞蹈。然而这些方法往往面临着误差累积问题,且无法学习到全局的编舞规律。

- 由于神经网络的训练只关注与整体loss的收敛,因此网络更倾向于生成保守的动作,这导致了最终的舞蹈缺少富有表现力的动作,展现出了平淡和中庸的效果。

我们认为现有的方法仅仅将舞蹈生成视为序列到序列的生成问题,他们努力提高细粒度局部细节的舞蹈质量,而忽略了音乐和舞蹈之间的全局编舞规律。参考[3][4],舞蹈通常是以从粗到细的方式编排的。提供完整的音乐,舞蹈设计师首先分析节奏、流派、情绪基调等音乐属性,创造出“characteristic dance phrases”,即一些短暂的动作片段,具有强大的表现力和更丰富的语义信息。在这个阶段,舞蹈设计师可以集中精力设计具有有特点的舞蹈短语,例如“倒立”和“太空步”。这些具有特色的舞蹈乐句按照音乐的结构化信息进行排列,整体的舞蹈结构就奠定了。随后,通过将舞蹈短语与过渡动作连接起来,创作出整个舞蹈。

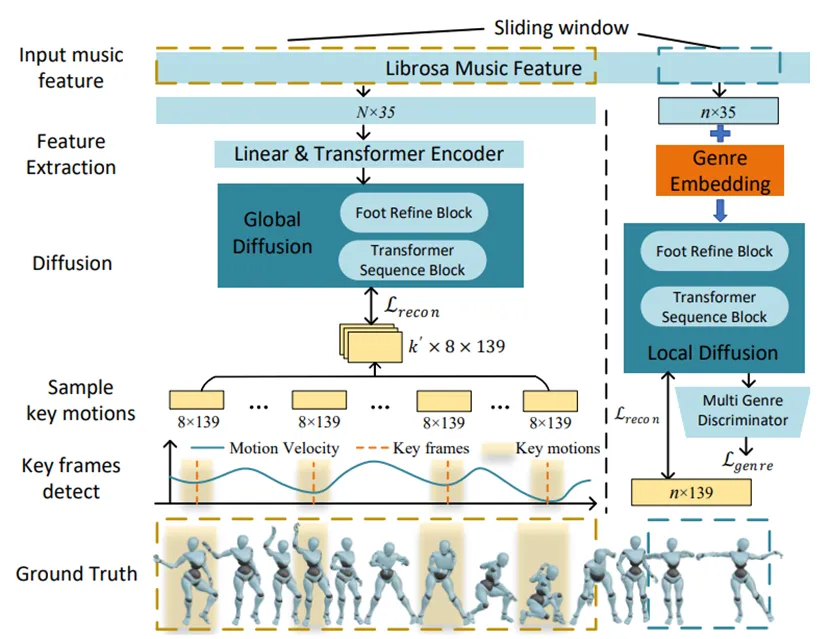

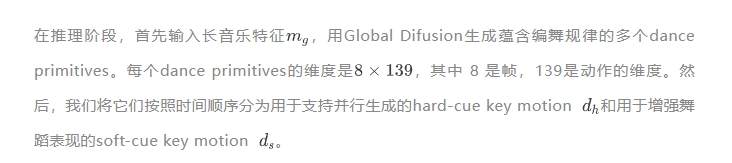

有了以上的认识之后,我们认为“dance phrases”包含丰富的独特动作,可以传递全局的舞蹈模式。因此,与dance phrases类似,我们提出了适合网络学习的 characteristic dance primitives。这些dance primitives是具有高运动能量的富有表现力的8帧关键动作,具有以下主要优点:(1)它们是稀疏的,从而减少了计算需求。(2)它们具有丰富的语义信息,并且可以传递编舞模式。(3)它们具有富有表现力的运动特征,可以指导运动扩散模型产生更多的动态运动并避免单调。

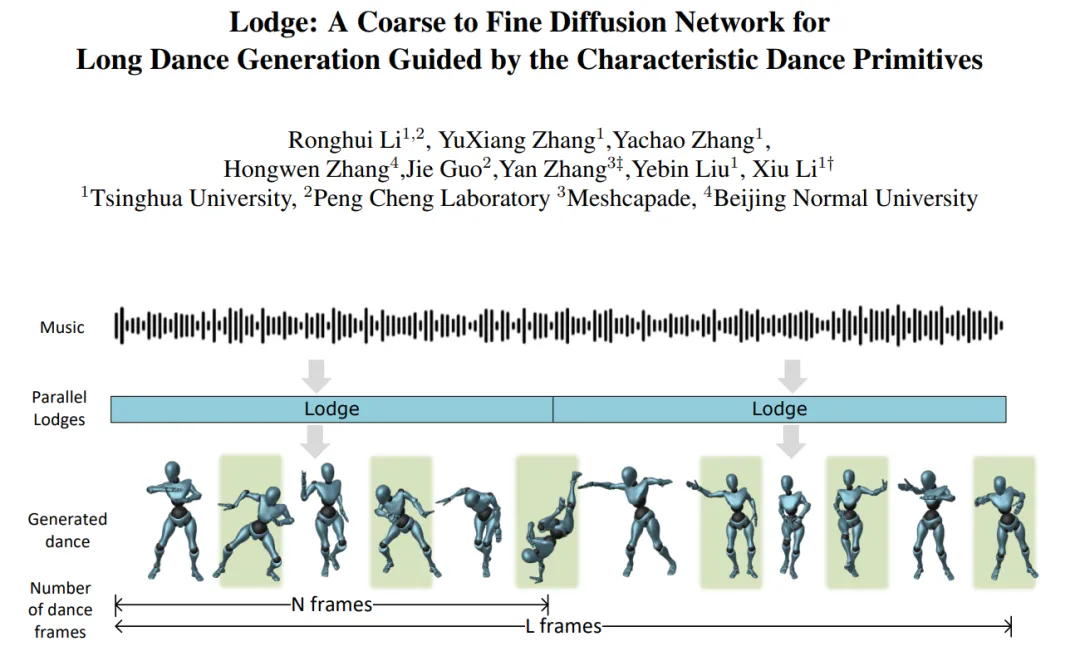

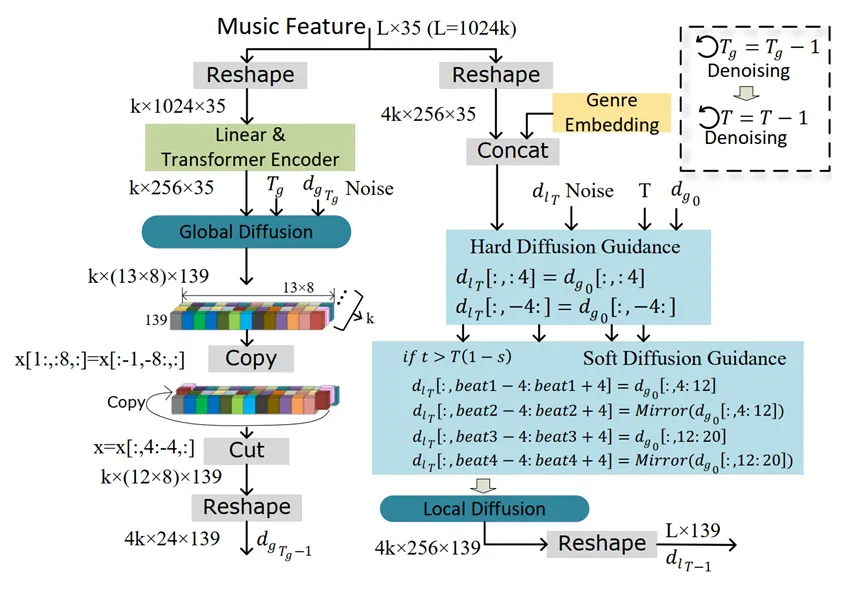

接下来,我们设计了一个具有两个运动扩散模型的从粗到细的舞蹈生成框架,并采用 characteristic dance primitives 作为它们的中间表示。第一阶段是粗粒度的全局扩散模型,它以长音乐作为输入并产生dance primitives。随后,我们采用并行局部扩散模型来独立生成短舞蹈片段。基于一些已经生成的dance primitives,我们可以利用扩散引导来严格限制这些片段的开头和结尾之间的一致性。因此,这些舞蹈片段可以串联成一段连续的长舞蹈。同时,dance primitives的引导下,每个舞蹈片段的质量、表现力和多样性都得到增强。

综上所述,我们的主要贡献如下:

- 我们提出了一个可以并行生成长舞蹈的扩散模型。我们的方法能够学习整体的编舞模式,同时保证局部动作的质量。并行生成策略可以在数秒钟生成极长的3D舞蹈。

- 我们提出了characteristic dance primitives作为两个扩散模型之间的中间表示,提高了生成舞蹈的张力。

- 我们提出了一个脚部优化模块,并采用足部与地面的接触损失来缓解脚步和地面接触的问题诸如脚滑、脚部漂浮和脚与地面穿模等。

二、方法

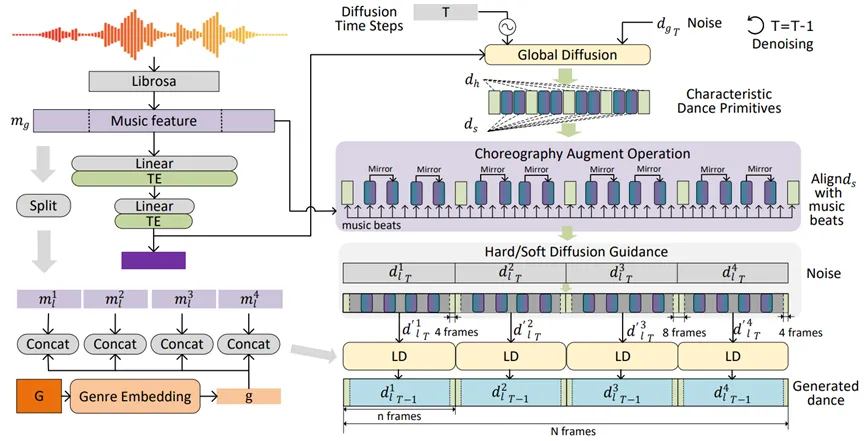

为了同时考虑全局编舞规律和局部舞蹈质量,我们设计了一个由粗到细的两阶段的扩散网络,分别是Global Diffusion Model和Local Diffusion Model。两个模型可以独立地训练。Global Diffusion Model在更大的时间尺度上学习全局编舞规律,为了让Global Diffusion生成characteristic dance primitives,我们从对应的舞蹈序列种提取一些运动速度的极值点,并将这些极值点附近的8帧有表现力的关键动作片段做为Global Diffusion训练的Ground Truth。而Local Diffusion Model在一个较小的时间尺度上学习如何生成高质量的短时舞蹈片段。

图1. Lodge训练过程。

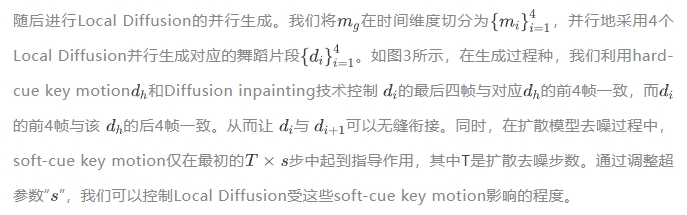

图2. Lodge推理过程。“TE”为Transformer Encoder,“LD”为Local Diffusion。

图3. Hard/Soft Diffusion Guidance

更多的技术细节请参考我们的论文。

三、实验

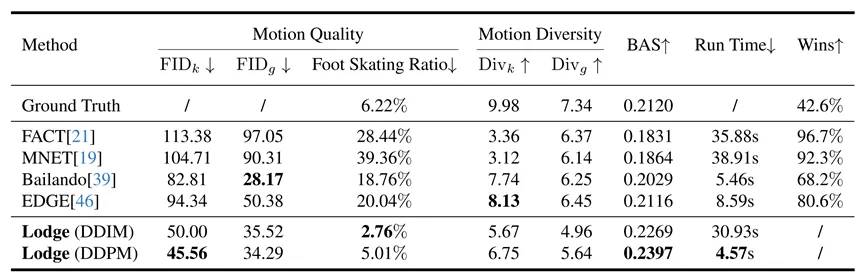

我们在FineDance[1]和AIST++[5]两个数据集上进行实验。由于FineDance平均每段舞蹈的时长是152.3秒,远高于AIST++的13.3秒,因此我们主要用FineDance数据集进行训练和测试。

表1. 在FineDacne数据集上与其他方法对比。

值得一提的是,采用DDIM采样策略可以获得不错的性能,并且生成1024帧舞蹈的推理时间降低到了4.57s。而得益于我们的并行生成架构,继续增大需要生成的舞蹈的序列长度,推理时间也不会显著增大。

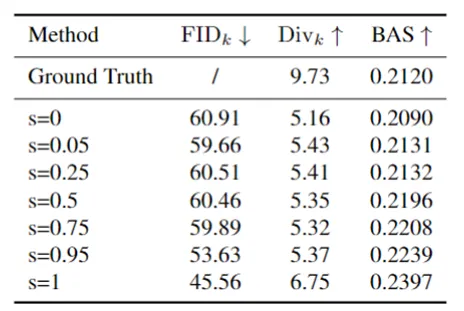

表2. 超参数“s”的消融实验,测试于FineDance数据集。

我们的soft-cue key motion对结果的影响程度可以使用超参数“s”进行调整,其中“s”值越大表示效果越强。表2 展示了设置各种“s”值所产生的结果。随着“s”的增加,和节拍对齐分数BAS也相应增强。当“s”设置为 1 时,可获得最佳的性能。

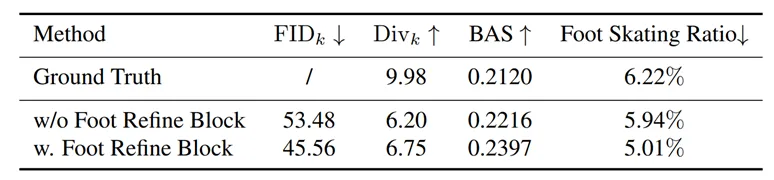

表3. Foot Refine Block的消融实验,测试于FineDance数据集。

如表3所示,加入Foot Refine Block后,运动质量FID_k有了很大的改善,特别是Foot Skating Ratio从5.94%下降到5.01%,这证明我们提出的Foot Refine Block可以有效改善脚部与地面的接触质量,降低脚部脚滑现象出现的频率。

四、总结

在这项工作中,我们引入了 Lodge,一种两级从粗到细的扩散网络,并提出characteristic dance primitives作为两个扩散模型的中间级表示。Lodge 已通过用户研究和标准指标进行了广泛的评估,取得了最先进的结果。我们生成的样本表明,Lodge 可以并行生成符合编舞规则的舞蹈,同时保留局部细节和物理真实感。广泛的消融实验验证了我们不同模块、粗到细框架、舞蹈基元和足部细化网络的有效性。然而,我们的方法目前无法生成带有手势或面部表情的舞蹈动作,这对于表演也至关重要。我们将很高兴在未来看到长序列全身舞蹈生成的新工作。

参考文献

[1] Li, Ronghui, et al. "FineDance: A Fine-grained Choreography Dataset for 3D Full Body Dance Generation." Proceedings of the IEEE/CVF International Conference on Computer Vision. 2023.

[2] Tseng, Jonathan, Rodrigo Castellon, and Karen Liu. "Edge: Editable dance generation from music." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023.

[3] Blom, Lynne Anne, and L. Tarin Chaplin. The intimate act of choreography. University of Pittsburgh Pre, 1982.

[4] Chen, Kang, et al. "Choreomaster: choreography-oriented music-driven dance synthesis." ACM Transactions on Graphics (TOG) 40.4 (2021): 1-13.

[5] Li, Ruilong, et al. "Ai choreographer: Music conditioned 3d dance generation with aist++." Proceedings of the IEEE/CVF International Conference on Computer Vision. 2021.

[6] Huang, Ruozi, et al. "Dance revolution: Long-term dance generation with music via curriculum learning." arXiv preprint arXiv:2006.06119 (2020).

[7] Siyao, Li, et al. "Bailando: 3d dance generation by actor-critic gpt with choreographic memory." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022.Illustration From IconScout By 22

本文转载自将门创投,作者:李镕辉