如你所说的抓取:基于语言指导的灵巧抓取生成 原创 精华

摘要:本文探讨了一项新颖任务“如你所说的灵巧抓取”(DexGYS),使机器人能够根据以自然语言表达的人类指令执行灵巧抓取。然而,这一领域的发展因缺乏具有自然人类指导的数据集而受到阻碍;因此,我们提出了一个基于语言指导的灵巧抓取数据集,名为DexGYSNet,提供高质量的灵巧抓取注释以及灵活和细致的人类语言指导。我们的数据集构建具有成本效益,采用精心设计的手-物体交互重定向策略和大语言模型辅助的语言指导注释系统。借助该数据集,我们引入了DexGYSGrasp框架,用于基于人类语言指令生成灵巧抓取,具有生成意图对齐、高质量和多样性的抓取能力。为了实现这一能力,我们的框架将复杂的学习过程分解为两个可管理的渐进目标,并引入两个组件来实现它们。第一个组件学习抓取分布,侧重于意图对齐和生成多样性。第二个组件在保持意图一致性的同时优化抓取质量。我们在DexGYSNet和真实环境中进行了广泛的实验以进行验证。

1.引言

使机器人能够根据人类语言指令执行灵巧抓取在机器人和深度学习领域具有重要意义,提供了在工业生产和家庭协作场景中具有前景的应用。随着数据驱动的深度学习的发展和大规模数据集的可用性,机器人灵巧抓取方法取得了令人印象深刻的性能。然而,以前的方法侧重于抓取的稳定性,尚未充分利用灵巧手进行意图明确、类似人类的抓取。最近的研究,称为任务导向和功能性灵巧抓取,旨在根据特定任务或物体的功能生成抓取。然而,这些方法通常依赖于预定义的、固定且有限的任务或功能,限制了它们的灵活性并阻碍了自然的人机交互。

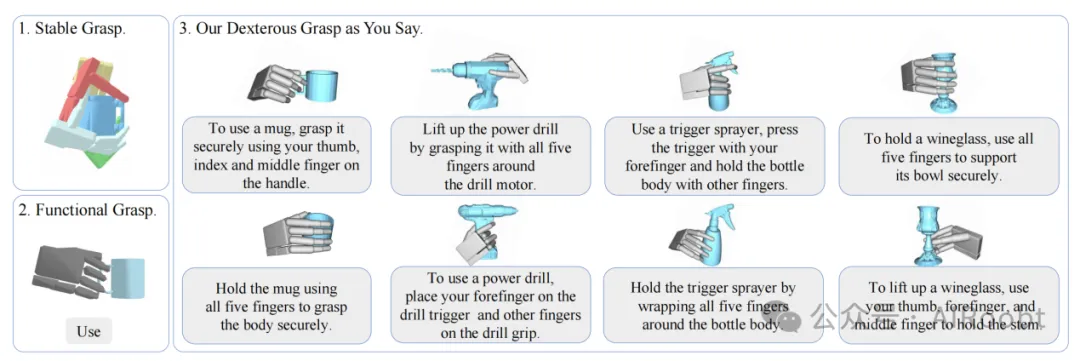

在本文中,我们探讨了一项新颖的任务“如你所说的灵巧抓取”,简称DexGYS,如图1所示。我们可以看到,在该任务中提供了自然的人类指导,可以用来驱动灵巧抓取生成,从而促进更加用户友好的人机交互。然而,这项新任务也带来了新的挑战。首先,标注灵巧姿势及相应语言指导的高成本,构成了开发和扩展灵巧数据集的障碍。其次,生成确保意图一致性、高质量和多样性的灵巧抓取的需求,对模型学习提出了相当大的挑战。

图1:我们的语言指导任务与传统灵巧抓取任务的对比。传统方法要么仅关注抓取质量,要么专注于固定和有限的功能。我们的方法通过基于人类语言生成灵巧抓取,增强了自然的人机交互。

为了解决第一个挑战,我们提出了一个大规模语言指导的灵巧抓取数据集DexGYSNet。DexGYSNet通过利用人类抓取行为和大语言模型的广泛能力,以一种具有成本效益的方式构建。具体而言,我们引入了手-物体交互重定向(HOIR)策略,将易于获得的人类手-物体交互转移到机器人灵巧手,以保持接触一致性和高质量的抓取姿势。随后,我们开发了LLM辅助的语言指导注释系统,在LLM的支持下,为灵巧抓取数据生成灵活和细致的语言指导。DexGYS数据集包含了50,000对高质量的灵巧抓取及其对应的语言指导,涵盖了1,800种常见家庭物品。

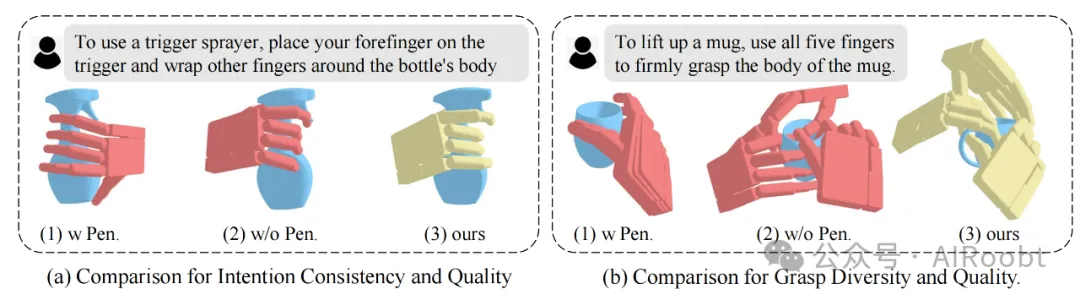

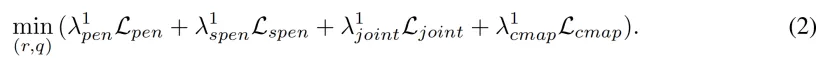

在数据集的支持下,我们开始克服第二个挑战。我们提出了用于灵巧抓取生成的DexGYSGrasp框架,该框架对齐意图,确保高质量,并保持多样性。起初,我们惊讶地发现同时掌握所有目标的难度源于常用的穿透损失,该损失用于避免手-物体穿透。正如图2所示,穿透损失大大阻碍了抓取分布的学习,导致意图不一致和多样性降低。相反,尽管具有高多样性和对齐的意图,移除穿透损失导致了不可接受的物体穿透,使抓取不可行。基于这一发现,我们以渐进策略设计了DexGYSGrasp框架,将复杂的学习任务分解为两个由渐进组件管理的顺序目标。最初,第一个组件学习抓取分布,专注于意图一致性和多样性,有效地在没有穿透损失约束的情况下进行优化。随后,第二个组件对初步粗略的抓取进行优化,使其在保持相同意图和多样性的同时达到高质量。我们的框架允许每个组件专注于特定且可管理的优化目标,显著提升了生成抓取的整体性能。

图2:穿透损失(图中为Pen.)对抓取性能影响的可视化:意图对齐、质量和多样性。(a) 说明了穿透损失导致意图不一致,而没有穿透损失会导致严重的物体穿透。(b) 展示了在相同条件下的三个采样结果,表明穿透损失导致多样性降低。

我们在DexGYSNet数据集和现实世界场景中进行了广泛的实验。结果表明,我们的方法能够为各种物体生成意图一致、高多样性和高质量的抓取姿势。

2.相关工作

2.1 灵巧抓取生成

灵巧手赋予机器人以类似人类的方式操控物体的能力。先前的方法通过分析方法和深度学习方法在确保抓取稳定性方面取得了令人印象深刻的结果。然而,这些方法尚未完全开发出灵巧手在意图明确和类似人类抓取方面的全部潜力。最近,一些工作专注于功能性灵巧抓取,旨在实现超越抓取稳定性的类似人类能力,但仍然缺乏灵活性和泛化能力。在这项工作中,我们探讨了“如你所说的灵巧抓取”这一新颖任务,充分利用机器人手的灵巧性,使机器人能够根据人类自然语言执行灵巧抓取。

2.2 抓取数据集

大规模数据集的发展显著促进了数据驱动抓取方法的进步,包括平行抓取、人类抓取和灵巧抓取方法。尽管取得了这些进展,数据收集的高成本仍然是一个重大挑战,特别是在灵巧手领域。先前的灵巧抓取数据集主要依赖于物理分析方法来缓解这一问题。然而,这些方法通常缺乏构建我们的语言指导灵巧任务所需的特定语义上下文或相应的语言指导。在本文中,我们提出了DexGYSNet数据集,以具有成本效益的方式构建,提供高质量的灵巧抓取注释以及灵活和细致的人类语言指导。

2.3 语言指导的机器人抓取

语言指导的机器人抓取在机器人领域中非常重要。先前专注于平行夹持器的工作在实现任务导向抓取、语言指导抓取和语言指导的操作方面取得了进展。与平行夹持器相比,灵巧手具有更高的自由度(例如,Shadow Hand有28个自由度),从而提供了更广泛的灵巧性。然而,这种高自由度也给模型学习带来了挑战。在本文中,我们提出了DexGYSGrasp框架,能够生成意图对齐、高质量和多样性的灵巧抓取。

3.DexGYSNet 数据集

3.1 数据集概述

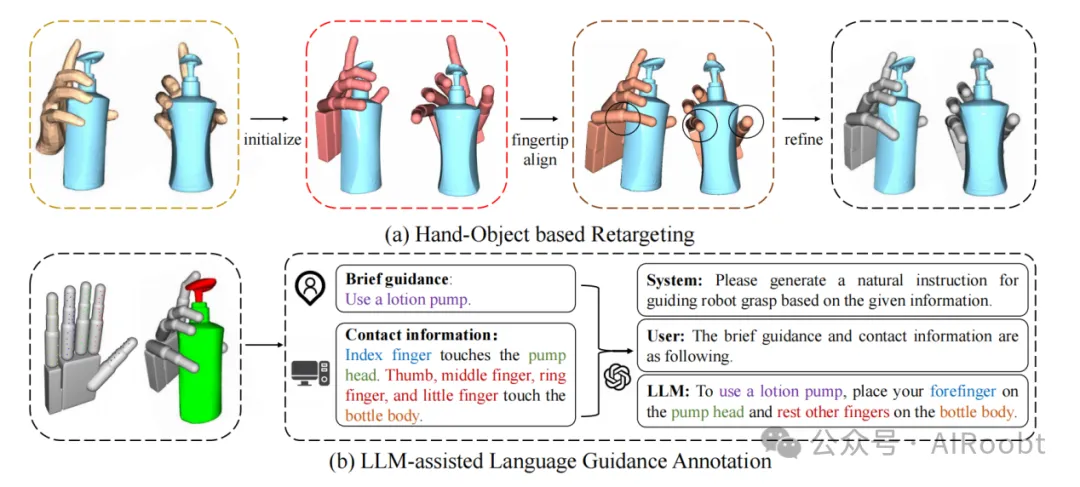

DexGYSNet 数据集采用了一种具有成本效益的策略构建,如图3所示。我们首先从现有数据集中收集对象网格和人类抓取数据。随后,我们开发了手-物体交互重定向(HOIR)策略,将人类抓取转换为具有高质量和手-物体交互一致性的灵巧抓取。最后,我们实施了一个LLM辅助的语言指导注释系统,利用大语言模型(LLM)的知识,为语言指导生成灵活和细致的注释。

图3:DexGYSNet 数据集的构建过程。(a) HOIR 策略通过三步将人类手重定向到灵巧手,保持手-物体交互的一致性并避免物理不可行性(黑色圆圈中所示)。(b) 注释系统在 LLM 的帮助下自动为手-物体对注释语言指导。

3.2 手-物体交互重定向

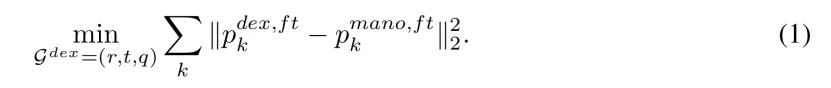

我们的手-物体交互重定向(HOIR)旨在将人类手-物体交互转移到灵巧手-物体交互,如图3所示。源MANO手参数表示为 Gm∈R61。目标灵巧手参数表示为 Gdex = (r, t, q),其中 r ∈SO(3) 表示全局旋转,t∈R3 是世界坐标中的平移,q∈RJ 是具有 J 自由度的灵巧手的关节角,例如,Shadow Hand 的 J = 22。HOIR 包含三个步骤:姿势初始化、指尖对齐和交互优化。

在第一步中,通过从相似的人类姿势复制参数来初始化灵巧手姿势,以建立更好的初始值。在第二步中,在参数空间中优化灵巧手姿势,使指尖位置 pdex,ftk 与人类的 pmano,ftk对齐。这个过程实现了重定向的一致性,优化目标可以表示为:

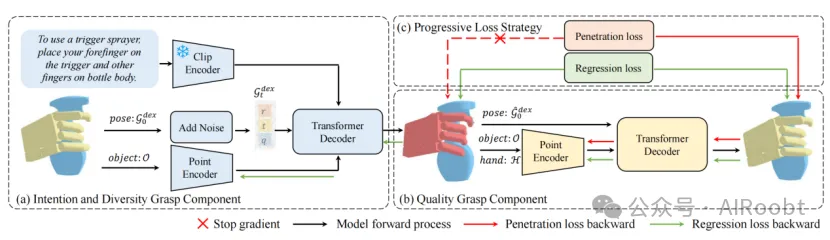

为了在保持一致性的同时提高物理交互的可行性,在第三步中,通过手-物体交互和物理约束损失进一步优化灵巧手姿势。设计了两个关键点以保持一致性:保持优化后姿势的接触区域与第二步输出一致,并在此阶段保持平移固定。优化目标可以表示为:

其中,物体穿透损失 Lpen 用于惩罚手-物体穿透深度。自我穿透损失 Lspen 用于惩罚自我穿透。关节角损失 Ljoint 用于惩罚超出限制的关节角度。接触图损失 Lcmap确保物体上的接触图与第二阶段的输出一致。

3.3 LLM辅助的语言指导注释

为了以低成本为灵巧手-物体对注释灵活和细致的语言指导,我们设计了一个由LLM辅助的粗到细自动化语言指导注释系统,如图3所示,灵感来自于 [40, 28]。具体来说,我们最初基于对象类别和简要的人类意图(例如“使用乳液泵”)生成简短的指导,这些意图由人类数据集 [26] 收集。随后,我们通过计算手上接触锚点到物体不同部分的距离来编写每个手指的接触信息。然后,我们将接触信息组织成语言描述符(例如“食指触碰泵头,其他手指触碰瓶身”)。最后,我们将简要指导和详细的接触信息输入到 GPT-3.5 中,生成自然的注释指导(例如“要使用乳液泵,请用食指按下泵头,同时用其他手指握住瓶子”)。

4.DexGYSGrasp 框架

给定完整的对象点云 O 和语言指导 L 作为输入,我们的目标是生成与意图对齐、高多样性和高质量的灵巧抓取 Gdex。

4.1 渐进抓取目标

DexGYS 中的学习挑战。DexGYS 对意图对齐(例如,准确地用食指按压扳机来使用喷雾器)、高多样性(例如,用不同的姿势握住瓶子)和高质量(例如,确保抓取稳定且避免物体穿透)提出了高要求。然而,我们发现单一模型难以同时满足这些要求,因为常用的物体穿透损失带来的优化挑战,如图2和图4所示,增加穿透损失的权重会减少物体穿透,但会对意图对齐和生成多样性产生不利影响。

图4:不同物体穿透损失权重 λpen 的定量实验结果。意图通过预测与目标之间的 Chamfer 距离(CD)量化。多样性通过手部平移的标准差δt 评估。物体穿透通过从对象点云到手网格的穿透深度(Pen.)进行评估。我们的方法在意图一致性、多样性和避免穿透方面独特地实现了高性能。

渐进抓取目标。为了解决这些挑战,我们提出将复杂的学习目标分解为两个更易管理的目标。第一个目标是生成的:它专注于学习抓取分布,不优先考虑质量,而是专注于学习具有意图对齐和生成多样性的抓取分布。第二个目标是回归的:它旨在将粗略的抓取优化为具有相同意图的高质量抓取。通过分解复杂的目标,我们降低了生成目标的学习难度,因为它不专注于质量,避免使用可能干扰学习过程的穿透损失。此外,回归学习比分布学习复杂度低,因为它仅需要在小空间内调整姿势到特定目标。因此,我们可以使用穿透损失来确保优化后的灵巧手避免穿透物体并具有高质量。

4.2 渐进抓取组件

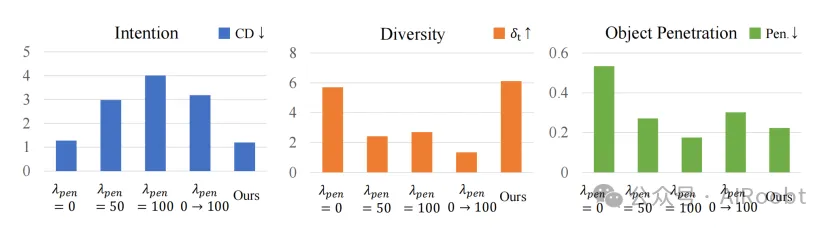

受益于第4.1节中的渐进抓取目标,我们设计了以下两个简单的渐进抓取组件,可以实现意图对齐、高多样性和高质量的语言指导灵巧生成。

图5:我们框架的概述。(a) 在只有回归损失的情况下,意图和多样性抓取组件根据语言和对象条件,从噪声姿势中重建原始手姿势进行训练。(b) 在回归损失和穿透损失的情况下,质量抓取组件通过训练优化粗略姿势,提高抓取质量,同时保持意图一致性。

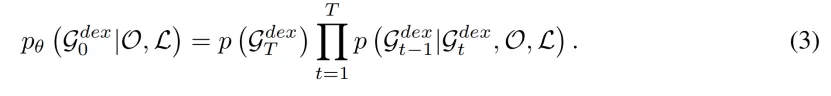

意图和多样性抓取组件。我们引入意图和多样性抓取组件,以高效地学习抓取分布,实现意图对齐和多样性生成。由于分布建模的目标,IDGC 构建在条件扩散模型之上,以预测从噪声化的 GTdex 到灵巧姿势 G0dex。输入的对象点云 O由 Pointnet++ 编码,语言 L 由预训练的 CLIP 模型作为条件进行编码。我们采用 DDPM 作为采样过程,公式如下:

质量抓取组件。第一个组件生成的抓取具有良好的意图对齐和高多样性,但由于显著的物体穿透而质量较差。因此,我们引入质量抓取组件以回归方式优化抓取质量,同时保持意图一致性。特别地,它以粗略姿势 G^dex、粗略手点云 H(G^dex) 和对象点云 O 作为输入,并输出姿势△Gdex。优化后的抓取为 G~dex= G^dex +△Gdex。训练对通过收集第一个组件生成的粗略抓取及其具有相似意图的最相似的真实抓取构建。这确保了训练目标与语言意图对齐,从而保证优化后的抓取与预期操作保持一致。特别地,QGC 以粗略姿势 G^dex、粗略手点云 H(G^dex) 和对象点云 O 作为输入,并输出姿势 △Gdex。优化后的抓取为 G~dex= G^dex +△Gdex。

4.3 渐进抓取损失

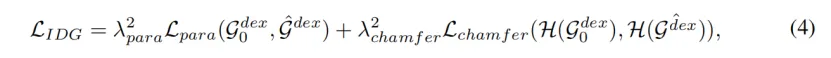

意图和多样性抓取损失。我们策略性地使用回归损失并排除物体穿透损失,以提高意图和多样性抓取组件的训练效果。通过专注于回归学习,该组件促进了更有效的优化过程,实现意图一致性和抓取多样性的提升。具体而言,我们利用 L2 损失进行姿势参数回归,并结合手型 Chamfer 损失以显式辅助手型。意图和多样性抓取组件的损失函数定义为:

其中,H 是相应姿势的灵巧手点云。

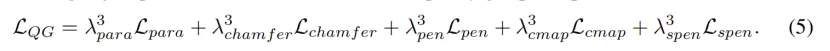

质量抓取损失。受益于简化的训练目标,质量抓取组件专注于在相对有限的空间内将粗略抓取优化为特定目标,从而减少物体穿透的负面影响。因此,我们采用包括物体穿透在内的精心设计的损失函数。质量抓取组件的损失函数可以表示为:

5.实验

5.1 数据集和评估指标

我们在对象实例级别上划分了 DexDYSNet 数据集;在每个类别中,80% 的对象用于训练,20% 用于评估。从意图一致性、抓取质量和抓取多样性的角度,采用三种类型的指标进行评估。1)对于意图一致性,使用 Chamfer 距离(CD)来衡量预测的手点云与目标之间的距离。此外,我们使用接触距离(Con.)来衡量预测与目标之间的对象接触图的 L2 距离。2)对于抓取质量,Q1 衡量抓取的稳定性,并按照 1 cm 的接触阈值和 5 mm 的穿透阈值。最大穿透深度(Pen.)反映了从对象点云到手网格的最大穿透深度。3)对于多样性,我们采用在相同条件下八个样本的平移δt、旋转 δr 和关节角δq 的标准差。

5.2 实现细节

对于 DexDYSNet 的构建,步骤 2 和 3 分别优化了 20 和 300 次迭代,学习率分别为 0.01 和 0.0001。我们将 λ1pen=100,将 λ1pen、λ1joint、λ1cmap分别设置为 10。对于训练我们的框架,意图和多样性抓取组件的训练周期设为 100,质量抓取组件设为 20。损失权重配置如下:

在所有训练过程中,使用 Adam 优化器进行优化,批量大小为 64,权重衰减率为 5.0 ×10-6。初始学习率为 2.0×10-4,并使用余弦学习率调度器衰减到 2.0×10-5。所有实验都在单个 RTX 4090 GPU 上使用 PyTorch 实现。

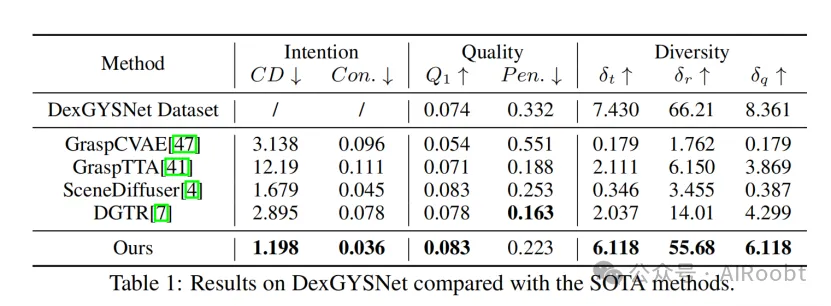

5.3 与 SOTA 方法的比较

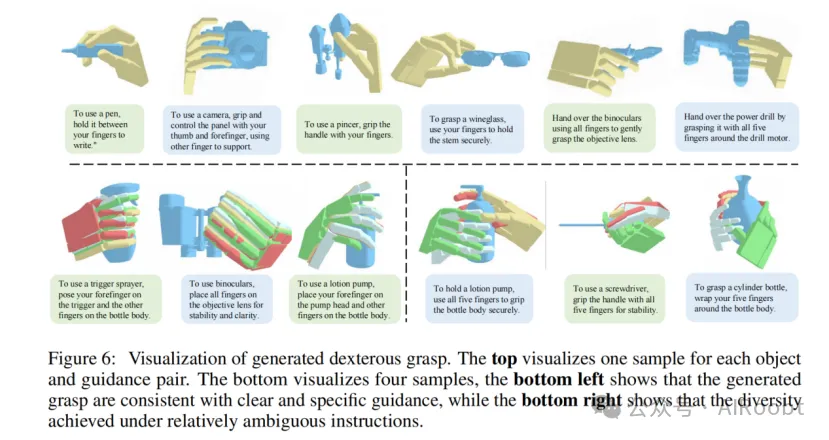

比较结果如表 1 所示。我们重现了 SOTA 方法以适应我们的任务,将语言条件与点云特征连接起来。正如表中所见,我们的 DexGYSGrasp 框架在意图一致性和抓取多样性方面显著优于所有先前的方法,同时在抓取质量上也取得了可比的性能。由于第 4.1 节中概述的优化挑战,先前的方法在学习强健的语言条件抓取分布方面存在困难。它们通常会产生未对齐但高质量的抓取,导致抓取质量相当,但意图不一致和多样性有限,而我们的框架在意图对齐、高质量和多样性方面达到了 SOTA 性能。图 6 中,我们可视化了生成的抓取,以定性展示我们框架的抓取生成能力。底部图展示了四个样本的结果,左下角强调了我们框架在确定性指导下生成精确和一致抓取的能力(例如,使用扳机喷雾器的方式是确定性的)。右下角展示了在提供模糊指导时(例如,握住瓶子的方式是多样的)生成抓取的多样性。

5.4 渐进组件和损失的必要性

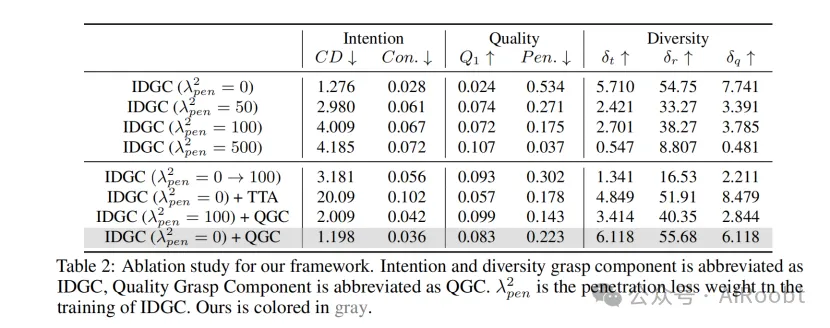

表 2 中的结果验证了我们框架的核心观点:将复杂任务分解为渐进目标,采用渐进组件,并使用渐进损失进行学习。结果的前四行表明,单一组件在没有渐进目标的情况下,无法平衡所有目标。此外,单一组件,即使有渐进目标,在几个训练周期后将 λ2pen 从 0 调整到 100,也不会提升性能。当使用没有相应渐进损失的渐进组件时(IDGC(λ2pen= 100) + QGC),结果也类似。此外,常用的质量优化策略测试时适应(TTA),虽然提高了抓取质量,但导致意图一致性极差。总体而言,只有我们 DexGYSGrasp 框架的渐进设计才能确保意图对齐、高质量和多样性的卓越表现。

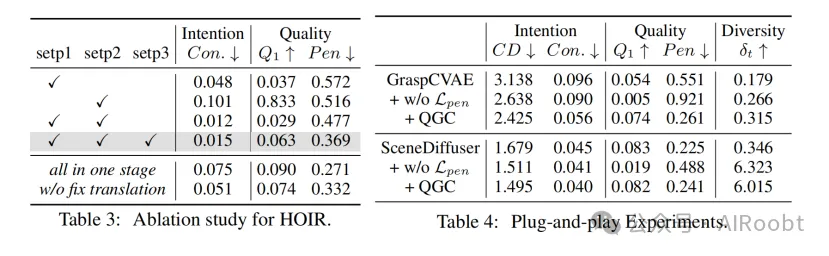

5.5 即插即用实验

我们进行了实验,以评估我们的见解对其他 SOTA 方法的适用性。具体来说,我们在没有物体穿透损失的情况下训练了 GraspCAVE 和 SceneDiffuser。结果表明,移除物体穿透损失可以提高意图一致性,这与第 4.1 节讨论的发现一致。此外,我们的质量抓取组件可以显著提高抓取质量,同时保持意图一致性。

5.6 手-物体交互重定向的有效性

我们进行了消融研究,以评估我们在构建 DexDYSNet 数据集时的手-物体交互重定向(HOIR)策略。如表 3 所示,我们的三步 HOIR 显著提高了质量和意图一致性。我们观察到,将所有损失在一个步骤中优化(所有在一个阶段),会导致接触一致性变差,而抓取质量变好。当在第三步中不固定根平移(不固定平移)时,结果也类似。我们认为这种权衡是由于手-物体交互数据中的固有噪声和人类抓取与灵巧手之间的结构差异,使得在所有方面表现出色具有挑战性。总体而言,我们认为三步 HOIR 策略在手物接触一致性这个最重要方面达到了更全面的结果。

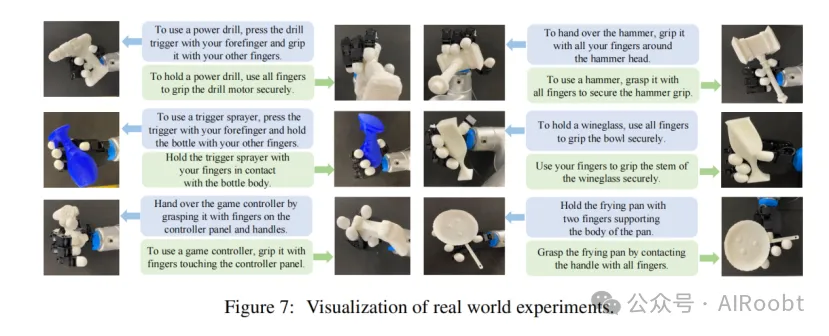

5.7 现实世界中的实验

我们进行了现实世界的抓取实验,以验证我们方法的实际应用,如图 7 所示。实验在 Allegro 手、Flexiv Rizon 4 手臂和 Intel Realsense D415 相机上进行。尽管我们的框架是为完整的对象点云设计的,我们集成了几种现成的方法以增强其实用性。具体来说,通过视觉定位和 SAM 获得部分对象点云,然后输入到点云补全网络以获得完整的点云。在执行中,我们首先将手臂移动到灵巧手根节点的 6-DOF 姿势,然后将灵巧手关节角度控制到预测的姿势。现实世界的实验进一步验证了我们方法的有效性。

6.结论

我们认为,使机器人能够执行与人类语言对齐的高质量灵巧抓取在深度学习和机器人领域至关重要。在本文中,我们探讨了这一新颖任务,称为“如你所说的灵巧抓取”。这一任务并不简单,我们提出了 DexGYSNet 数据集和 DexGYSGrasp 框架来完成它。DexGYSNet 数据集通过对象-手交互重定向策略和 LLM 辅助的语言指导注释系统,以具有成本效益的方式构建。在 DexGYSNet 的基础上,DexGYSGrasp 框架由两个渐进组件组成,可以实现意图对齐、高多样性和高质量的灵巧抓取生成。DexDYSNet 和现实世界设置中的广泛实验表明,我们的框架显著优于所有 SOTA 方法,证实了我们方法的潜力和有效性。

Wei Y L, Jiang J J, Xing C, et al. Grasp as You Say: Language-guided Dexterous Grasp Generation[J]. arXiv preprint arXiv:2405.19291, 2024.

1 Sun Yat-sen University

2 Stanford University

3 Wuhan University

本文转载自公众号AIRoobt ,作者:AIRoobt

原文链接:https://mp.weixin.qq.com/s/vxOl-P1Xxn8-9g_FkC1hDg