KAM-CoT:知识增强多模态链式思维推理 原创

摘要:大型语言模型(LLM)通过利用链式思维(CoT)实现逐步思考,在自然语言处理任务中展示了令人印象深刻的表现。将 LLM 扩展到多模态能力是近期的研究热点,但这会带来计算成本并需要大量硬件资源。为了解决这些挑战,我们提出了 KAM-CoT,一个将 CoT 推理、知识图谱(KG)和多种模态集成起来的框架,以全面理解多模态任务。KAM-CoT 采用了一个包含 KG 基础的两阶段训练过程,以生成有效的推理和答案。通过在推理过程中引入来自 KG 的外部知识,模型获得了更深的上下文理解,减少了幻觉现象并提升了答案质量。这种知识增强的 CoT 推理使模型能够处理需要外部上下文的问题,提供更为知情的答案。实验结果表明,KAM-CoT 优于现有的最先进方法。在 ScienceQA 数据集上,我们达到了 93.87% 的平均准确率,超过了 GPT-3.5(75.17%)18% 和 GPT-4(83.99%)10%。值得注意的是,KAM-CoT 实现了这些结果时,仅使用了 280M 的可训练参数,展示了其成本效益和有效性。

1.引言

大型语言模型(LLM),特别是 GPT-3(Kojima 等,2022a),ChatGPT(OpenAI 2022)和最近的 LLaMA、LLaMA2(Touvron 等,2023a, b),在自然语言处理任务中展示了卓越的性能。此外,在 LLM 中引入链式思维(CoT)方法彻底改变了机器处理推理密集型任务的方式(Zhou 等,2023)。CoT 指的是 LLM 以逐步方式进行思考和推理的能力,类似于人类的认知过程(Wei 等,2022b)。传统的语言模型(LM)在生成响应时没有明确的中间步骤,这可能在复杂推理场景中导致次优答案。CoT 通过引入中间步骤,使语言模型能够进行推理,从而增强模型解决问题的能力,解决了这一局限性。

最近,扩展 LLM 以具备多模态能力的趋势日益增长。视觉和文本信息的融合在视觉与语言任务(如视觉问答(VQA)、图像描述和图像-文本检索)方面取得了显著进展,并开启了变革性进步的潜力。Liu 等(2023a);Gao 等(2023);Lu 等(2023a)作者们认识并提倡将视觉和语言模态结合的价值。然而,这些模型的庞大规模需要大量的计算资源,特别是在硬件基础设施方面。Zhang 等(2023c)提出微调较小的模型以适应多模态并引出 CoT 能力。然而,这种方法往往会导致幻觉现象,即模型生成看似合理但不正确的推理和答案。一个可能的解决方案是集成知识图谱(KG)以增强模型理解。

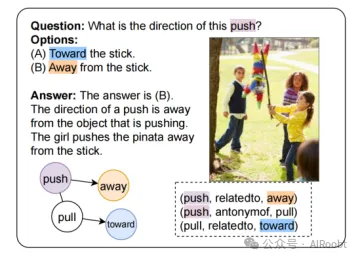

知识图谱作为宝贵的结构化知识来源,捕捉来自各个领域的信息。对于 CoT 推理,知识图谱可以补充逐步推理。通过引入知识图谱中的信息,语言模型可以更连贯地推理,并利用实体和属性之间的上下文关系。考虑图 1 中的问题,关于推动方向的知识对于回答问题至关重要。图 1 右下角显示的关于对象关系和方向的知识图谱三元组,使模型能够正确回答问题。这种集成提高了生成响应的质量,尤其是在需要复杂推理和上下文感知理解的任务中。

图1: 来自ScienceQA数据集(Lu等人,2022年)的一个示例,展示了图表如何辅助多模态问答。

(注释:这是来自ScienceQA数据集的一个例子(Lu等人,2022年),展示了如何利用图来辅助多模态问答(multi-modal QA)。在这个例子中,有一个问题和几个选项,以及一个答案,还有一个图解来帮助理解问题和答案。

问题:这个推力的方向是什么?

选项:

(A) 向棍子方向。

(B) 远离棍子方向。

答案:答案是 (B)

解释:一个推力的方向是远离正在施加推力的物体。在这个例子中,女孩正在推一个彩罐(pinata),使其远离棍子。

图解中还包含了一些词汇和它们之间的关系:

- "push"(推)与 "away"(远离)相关联。

- "push"(推)是 "pull"(拉)的反义词。

- "pull"(拉)与 "toward"(向...方向)相关联。

图解中的箭头和文字说明了 "push" 和 "pull" 的方向性,以及它们与 "away" 和 "toward" 的关系。这种图示可以帮助用户更好地理解问题和答案,尤其是在涉及物理概念或动作方向时。通过视觉化这些关系,可以增强对问题的理解,并帮助找到正确的答案。)

在这项工作中,我们提出通过知识图谱增强多模态,以帮助模型解决复杂问题并引出 CoT 能力。提出的方法 KAM-CoT 包括一个接收语言上下文的语言模型,一个编码视觉特征的视觉编码器,以及一个在知识图谱上进行推理的图神经网络(GNN)。遵循 Zhang 等(2023c),我们将推理过程分为两个连续阶段。在第一阶段,我们生成合理的推理。在第二阶段,我们将生成的推理由作为额外输入并提供答案。KAM-CoT 无缝地将文本、视觉和图形特征结合在一起,使机器能够像人类认知一样连贯地思考和推理。我们在 ScienceQA(Lu 等,2022)基准上评估了我们提出的模型,达到了 93.87% 的平均准确率,超过了 GPT-3.5(75.17%)18% 和 GPT-4(83.99%)10%。此外,KAM-CoT 在实现这些结果时仅使用了 280M 的可训练参数,展示了其成本效益和有效性。

本文的贡献如下:

1. 图谱提取:我们根据给定的问答上下文从 ConceptNet(Speer、Chin 和 Havasi 2017)中提取显著的三元组。

2. 与知识图谱的融合:我们提出了一些指示性机制,将文本和图像模态与知识图谱融合,并检验其效率。

3. KAM-CoT:我们提出了知识增强的多模态 CoT 方法 KAM-CoT。该 280M 模型在不同阶段联合处理视觉、文本和知识图谱,逐步推理以生成合理的推理和答案。

我们在 ScienceQA 数据集(Lu 等,2022)上进行了广泛的实验和评估,达到了新的最先进性能。我们还考察了各组件的效果和贡献,并讨论了未来研究的潜在方向。

2.相关工作

我们从四个关键领域探索相关工作:上下文学习、通过微调方法的CoT(Chain of Thought,思维链)、视觉-语言模型和知识增强方法。

上下文学习的大型语言模型(LLMs,Zhao等人,2023年)通过两种主要模式展示了CoT的能力:零样本(Zero shot)和少样本(Few shot)。零样本不需要任何明确的例子或指导即可进行推理。最近的研究表明,当用“让我们一步一步思考”(Kojima等人,2022a)这样的提示语时,LLMs能够取得令人满意的结果。在少样本情境中,LLMs提供了一组示范性的例子作为指导,使它们能够从这些实例中把握和学习模式。这些例子由人类专家策划。

Auto-CoT(Zhang等人,2023b)引入了使用LLMs自动构建示范性例子的方法。它生成带有固有噪声的例子。通过自动采样多样化的问题和后处理质量控制机制,它得到了可用的链。Wang等人(2022a)提出了一种解码自洽策略,从多样化的推理路径中采样,然后通过边缘化所有可能的路径选择最一致的答案。PROMPTPG(Lu等人,2023b)采用策略梯度技术,获得从有限的训练样本集中辨别上下文相关例子的能力,然后为给定的样本构建相应的提示。Chen等人(2022)提出了思维程序,将计算委托给一个解释器,将复杂计算与推理和理解解耦。另一项有趣的工作,最少到最多提示(Zhou等人,2023)提出将复杂问题分解为更简单的问题,并通过利用之前解决的子问题的答案依次解决它们。

然而,所有这些方法都限于LLMs,合理地超过100B参数(Wei等人,2022a)。

通过微调方法的CoT,Lu等人(2022)提出了一个科学问题-答案(ScienceQA)数据集,它包含有相应讲座、解释和正确答案的多模态多项选择题。作者观察到,通过在少量样本GPT-3和微调后的UnifiedQA(Khashabi等人,2020)中使用CoT,问题回答的准确率分别提高了1.20%和3.99%。MM-CoT(Zhang等人,2023c)提出在ScienceQA数据集上使用CoT方法对LM进行微调。他们提出了两个阶段的模型:理由生成和答案推理。该模型在该数据集上的表现超过了GPT-3.5的16%,并超过了人类的表现。

视觉-语言模型随着视觉问答任务(Antol等人,2015)的提出,已经有大量工作在对齐视觉和语言模态。ViLT(Kim、Son和Kim,2021)提出了一个单一的变换器架构,用于文本和图像模态,促进了无缝的跨模态交互。Patch-TRM(带有跨模态TRM的变换器)将图像解析成有序的块,在层次化的金字塔布局中(Lu等人,2021)。这些块被预训练的ResNet编码,并通过视觉变换器传递。VisualBERT提出了一个统一的架构,利用基于变换器的BERT模型的表达能力,并对齐从图像中提取的特征(Li等人,2019,2020)。特别是,视觉和文本输入都被掩蔽,模型学习预测掩蔽的输入,使其能够捕获上下文对齐。BLIP2(Li等人,2023)提出了QFormer,通过两阶段策略预训练,以对齐图像编码器和LLMs。Liu等人(2023b)提出了Prism模型,该模型使用领域专家的集合。KOSMOS(Huang等人,2023)在包括任意交错的文本和图像、图像-标题对和文本数据的网络规模多模态语料库上从头开始训练模型。

最近,随着LLaMA模型的出现,在指令遵循语言建模方面取得了显著进展。LLaVA(Liu等人,2023a)依赖于仅文本的GPT-4(OpenAI,2023)模型,生成多模态数据。作者提出了两阶段训练:特征对齐的预训练和指令遵循的微调。LLaMA-Adapter V2(Gao等人,2023)提出了一个基于参数高效的适配器的视觉指令模型,将指令遵循能力分布在整个模型中。LaVIN(Luo等人,2023)是另一种基于模态混合的参数高效技术。SCITUNE(Horawalavithana等人,2023)和T-SciQ(Wang等人,2023)是专注于科学的视觉和语言理解模型。Chameleon(Lu等人,2023a)通过为LLMs增加即插即用模块来减轻访问最新信息的限制,用于组合推理。然而,所有这些指令遵循方法都需要更大的模型,通常超过7B参数。

知识增强方法最近几项研究探索了将结构化知识注入LLMs。SKILL(Moiseev等人,2022)提出将知识图谱(KG)三元组转换为句子,然后用于预训练。KagNet(Lin等人,2019)提出将问题-答案对从语义空间定位到基于知识的符号空间作为模式图,然后用层次路径注意力机制训练图卷积网络。QA-GNN(Yasunaga等人,2021)提出使用LLMs来估计知识图谱中节点的重要性,并在统一的图上进行联合推理。Zhang等人(2022)提出了GreaseLM模型,该模型在多层语言-KG交互中融合了预训练LLMs和图神经网络的编码表示。扩展到多模态,VQA-GNN(Wang等人,2022b)提出将图像级场景图与概念知识统一,以在统一的图上进行联合推理。

3.方法

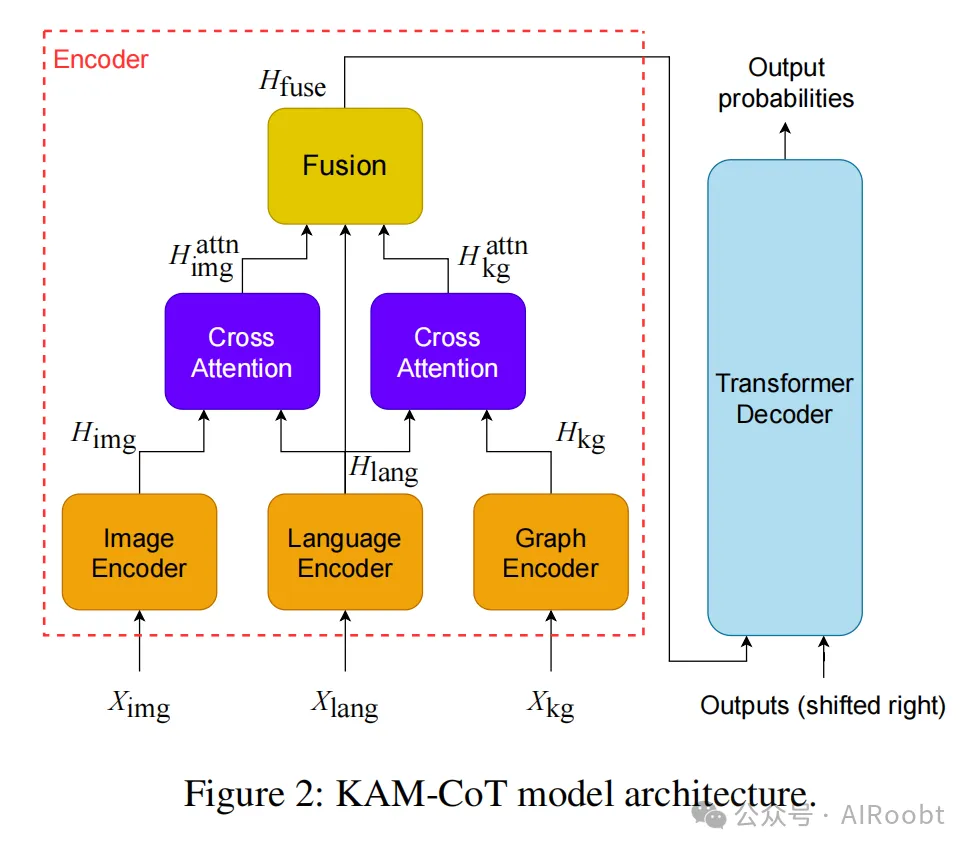

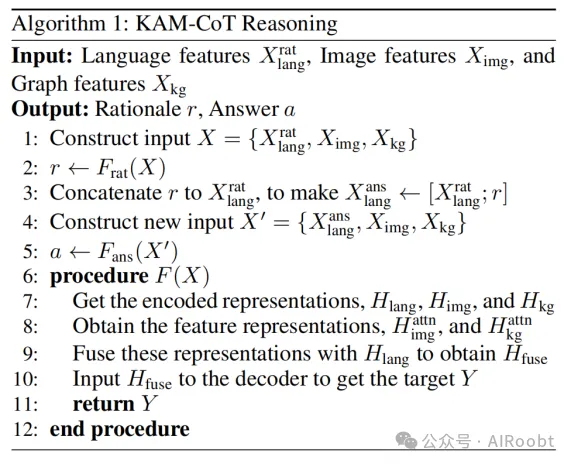

在本节中,我们描述了提出的KAM-CoT方法。概述而言,KAM-CoT包括对语言、图像和图结构输入的编码。需要注意的是,图结构是从语言输入中派生出来的。然后,这三种模态通过交叉注意力机制进行交互。最后,将融合的特征输入到一个transformer解码器中,生成自回归文本。

3.1 任务表述

给定一个问题 q 以及 k 个答案选项 {a1, a2, . . . , ak},,任务是选择正确的选项。问题 q 可选地附带一个图像 Ximg 和一个提供背景信息的文本 c 。

一种可能的方法是使用神经网络直接生成正确的选项。然而,已经证明,链式思维推理有助于得出正确答案,特别是对于复杂推理任务(Wei et al. 2022b; Kojima et al. 2022b)。因此,我们训练模型在第一步生成答案的推理 r 。下一步是在生成过程中结合 r 及现有输入来选择正确答案。推理生成和答案识别模型是相同的,但它们从相同的初始化独立训练。这与Zhang et al. (2023c)处理仅图像和文本模态的方法类似。在我们的案例中,我们扩展了他们的方法,以处理作为附加模态的图结构,从而将生成过程基于事实知识。

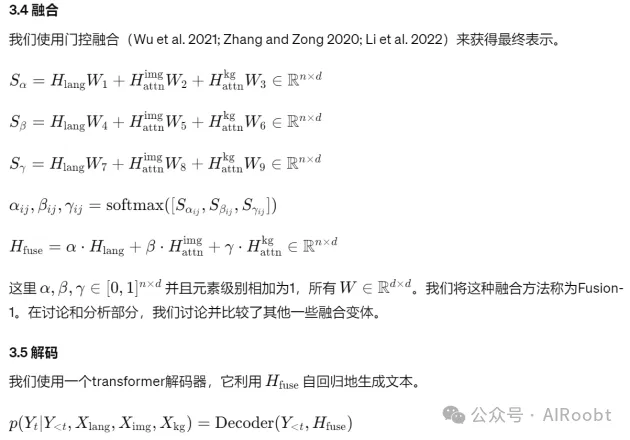

3.2 编码不同模态的输入

4.实验(略)

5.讨论和分析(略)

6.结论

在本文中,我们提出了KAM-CoT,即知识增强的多模态链式推理,以提高语言模型的推理能力和答案质量。我们提出了一个框架,该框架使用链式推理,利用知识图谱和其他模态对多模态任务进行全面理解。我们提供了一些可能的方法来融合这些模态。我们发现,在两阶段训练过程中引入知识图谱有助于减少幻觉现象。我们的方法在参数量仅为280M的情况下,达到了新的最先进水平,准确率为93.87%,分别比GPT-3.5和GPT-4高出18%和10%。未来,我们希望进一步整合特定的知识密集领域,并探索高效的融合机制。我们还希望将我们的解决方案扩展到更大规模的模型,如LLaMA系列。

Mondal D, Modi S, Panda S, et al. Kam-cot: Knowledge augmented multimodal chain-of-thoughts reasoning[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2024, 38(17): 18798-18806.

Samsung R&D Institute India - Bangalore

本文转载自公众号AIRoobt ,作者:AIRoobt

原文链接:https://mp.weixin.qq.com/s/HbgOqHeeJAKT9je1uLHnbA