LLMs并非智能思考者:引入数学主题树基准来全面评估LLMs 原创 精华

摘要:大型语言模型(LLMs)在数学推理方面展示了令人印象深刻的能力。然而,尽管取得了这些成就,当前的评估主要限于特定的数学主题,尚不清楚LLMs是否真正参与了推理。为了解决这些问题,我们提出了数学主题树(MaTT)基准,一个具有挑战性和结构化的基准,涵盖了广泛的数学科目,提供了1958个问题,每个问题都配有详细的分层主题链。在使用MaTT基准评估不同的LLMs后,我们发现最先进的模型GPT-4在多项选择题中仅取得了54%的准确率。有趣的是,即使使用“思维链提示”方法,我们也观察到几乎没有显著的改进。此外,当问题不提供选择时,LLMs的准确率显著下降,最高减少了24.2个百分点。对LLMs在各个主题上的表现进行详细分析后发现,即使在同一一般数学领域内,密切相关的子主题之间也存在显著差异。为了找出LLMs表现背后的原因,我们对在提供选择时由GPT-4生成的解释的完整性和正确性进行了人工评估。令人惊讶的是,我们发现仅在53.3%的情况下,模型提供的正确答案的解释被认为是完整和准确的,即模型真正进行了推理。

1.引言

大型语言模型(LLMs)在数学推理方面表现出令人瞩目的能力,凸显了它们在复杂问题解决领域的潜力(Chowdhery et al., 2022;Touvron et al., 2023;OpenAI, 2023;Team et al., 2023)。最近的研究表明,LLMs在应用于数学问题时,可以展示出高度的推理能力,往往在某些情况下与人类水平相当甚至超越人类。这种数学推理能力通过一些创新技术如思维链(Wei et al., 2022)、思维树(Yao et al., 2024)和自我验证(Weng et al., 2022)得到了进一步增强,强调了在解决数学问题过程中程序步骤的重要性。

尽管有这些进步,我们对LLMs数学推理能力的理解仍存在几个关键的空白。首先,尚不清楚LLMs在哪些特定的数学领域表现出色或不足,因为缺乏跨多样数学领域的全面评估。其次,区分LLMs依赖记忆与真正推理的实例具有挑战性,令人质疑它们理解的深度。第三,对多项选择格式对LLMs行为的影响尚未充分了解,这表明模型的表现可能受到所提出问题结构的影响。这些空白强调了需要一个更为健全的基准,能够全面评估LLMs,帮助我们解析它们的优点、缺点及其解决问题策略的细微差别。

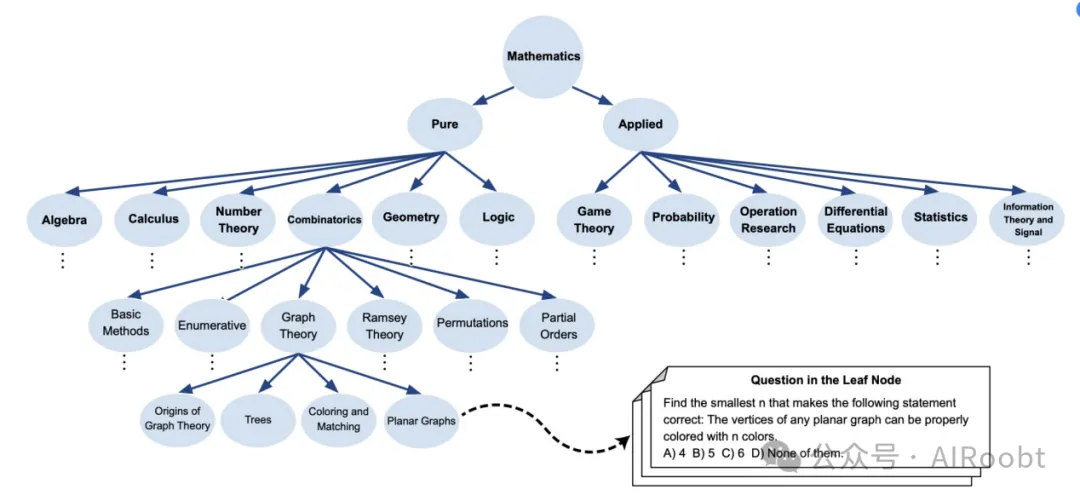

在本文中,我们通过最初利用维基百科的“数学主题列表”2识别数学中的关键领域,开发了数学主题树(MaTT)基准,涵盖了纯数学和应用数学的十二个主要主题。接着从维基百科提取每个主题的重要参考书籍,构建详细的主题树。然后,我们使用这些书籍的目录进一步完善基准,构建反映数学知识层次结构的综合树。在完成主题树后,我们从这些书籍的子章节中提取问题,并将它们收集在叶节点下。最后,我们为每个问题配上多项选择选项,增强了基准在评估数学理解方面的实用性。图1展示了MaTT的示意图。

开发MaTT后,我们评估了各种LLMs的数学推理能力,包括商业模型如GPT-4(OpenAI, 2023)和ChatGPT(Kocón et al., 2023)(turbo版本),以及开源的LLM,Mistral(Jiang et al., 2023)。值得注意的是,在多项选择格式中,最先进的GPT-4仅取得了54%的准确率。此外,使用思维链提示并未显著提高LLMs的表现,这强调了基准的复杂性,并表明单纯的逐步推理可能不足。当问题不提供多项选择选项时,我们观察到LLMs的准确率显著下降,最高下降了24.2个百分点。此外,我们对LLMs在不同主题上的表现进行了全面分析,发现存在显著差异,突显了模型在解决同一数学领域内相关子主题时能力的不一致性。

为了理解LLMs表现不足及其在不同主题上结果不一致的根本原因,我们对GPT-4提供的解释进行了详细评估。令人惊讶的是,在模型回答正确的情况下,只有53.3%的解释被认为是完整的,即GPT-4进行了真正的推理。这些情况通常与较简单或更为人熟知的问题相关,这些问题只需要一些简单的步骤即可解决。对于需要更多步骤、复杂计算或创造性/智能解决问题的更复杂问题,LLMs往往失败或依赖于替代策略。这些策略包括选择工程、不支持的定理使用、循环推理或盲目记忆,而非真正的数学推理。

图 1:数学主题树 (MaTT) 基准的概述,这是一项具有挑战性且结构化的基准,提出了涵盖各种数学科目问题的基准,每个科目都与详细的层次结构主题相关。

2.MaTT:数学主题树基准

近年来,大型语言模型(LLMs)在数学推理方面展示了显著的能力。然而,由于当前基准测试通常集中在特定的数学领域,其能力尚未完全理解。这种局限性阻碍了我们对LLMs推理能力深度和广度的理解。迫切需要更全面的数学基准测试,涵盖更广泛的主题,并深入了解模型的推理过程。这类基准不仅可以在更广泛的数学范围内挑战模型,还可以帮助更好地理解这些模型如何以及在何处应用推理。

为了解决这一差距,本文创建了数学主题树(MaTT)基准。为了创建MaTT,我们首先利用维基百科上的“数学主题列表”作为基础资源。这一探索对于确定我们要涵盖的数学知识范围至关重要。从维基百科提取数学主题列表后,我们确定了十二个主要主题,这些主题全面涵盖了纯数学和应用数学的广度。然后,我们从相应的维基百科页面上提取了每个主题的一个或多个关键参考书籍。这些主题及其对应的资源如下:纯数学包括代数(Meyer, 2023;Herstein, 1991;McGee, 2002)、微积分与分析(Stewart, 2012)、数论(Niven et al., 1991)、组合数学(Bóna, 2002)、几何与拓扑(Coxeter, 1969;Coxeter and Greitzer, 1967;Engelking, 1989)和逻辑(Mendelson, 2009)。应用数学包括博弈论(Osborne and Rubinstein, 1994)、概率(Tijms, 2012, 2017)、运筹学(Hillier and Lieberman, 2015)、微分方程(Boyce et al., 2021)、统计学(Hogg et al., 2013)以及信息理论与信号处理(Cover, 1999;Proakis, 2007)。

接下来,我们利用这些选定参考书籍的目录来丰富和构建MaTT主题树。这种方法使我们能够按照这些书籍中呈现的主题和子主题的层次结构进行映射,从而创建一个反映数学领域深度和互联性的综合图。创建MaTT的最后一步是从参考书籍的各章节中详细提取问题,并将它们收集在主题树的叶节点下。对于每个识别出的问题,我们设计了多项选择选项,以便于客观评估框架的建立。为了生成这些选项,我们选择了与实际答案非常接近的选择,如具有相似数值的选项、通过省略证明中的某一步得到的选项,或提供替代组合的选项。例如,如果正确答案是“A & B”,我们会将“A or B”作为可能的选择之一。图1展示了MaTT的示意图。

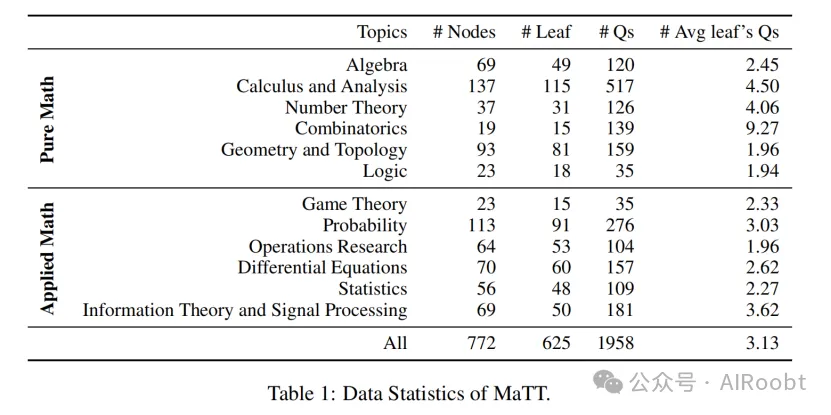

MaTT基准的统计概述详见表1。该基准包含1958个示例,精心策划于12个不同的数学主题,涵盖了纯数学和应用数学的广度。在汇集这些问题时,我们旨在确保所有主题具有广泛而一致的难度范围。在提取问题时,我们排除了过于流行或简单的问题,以减少数据污染的风险。

3.实验细节

我们使用MaTT基准评估了商业LLMs——GPT-4(OpenAI, 2023)和ChatGPT(Kocón et al., 2023)(turbo版本),以及开源LLM,Mistral(Jiang et al., 2023)(Mistral-7B-Instruct-v0.2)的性能。在我们的评估中,我们将提示结构化为要求LLMs首先生成解释,然后再给出最终答案。在多项选择设置中,我们特别指示模型选择提供的选项(A、B、C或D)作为最终答案。此外,对于零样本思维链提示,我们在提示中附加了“让我们一步一步地思考”。实验中使用的提示示例在附录中提供。

4.实验

在本节中,我们首先使用MaTT基准分析LLMs的数学推理能力。随后,我们考察模型在不同子主题上的表现差异。接着,我们通过不提供多项选择选项来评估选择可用性对LLMs的影响。最后,我们重点分析GPT-4的解释,手动注释每个解释中的推理水平,并探索GPT-4用来得出正确答案的策略。

4.1 LLMs在MaTT上的表现

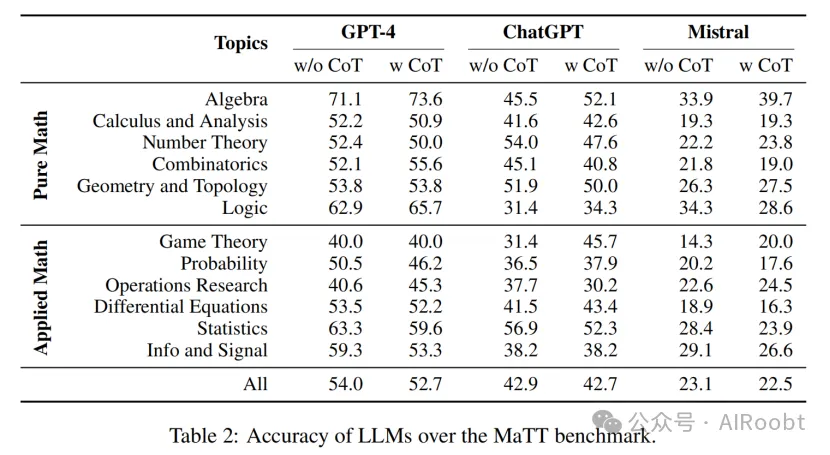

表2展示了LLMs在MaTT基准上各个主题的准确率。所有模型的表现都明显较低,GPT-4仅达到约54%的准确率,而Mistral的表现接近随机选择。详细检查发现,Mistral经常拒绝回答,声称正确选项不在提供的选项中,而其他模型则尝试选择最接近的匹配项,或者在计算的答案不在列表中时,进行某种形式的推理。

此外,LLMs在不同主题上的准确率差异显著,差距高达31%,这突显了LLMs在理解和推理能力方面的显著差异。最后,我们观察到零样本思维链提示大多未能提升模型性能,可能是由于问题的复杂性。MaTT中的许多问题需要复杂或大量的步骤,或需要智能/创造性的思维,仅仅按照几个简单步骤无法解决。这一观察结果对思维链提示在许多推理任务中的有效性假设提出了质疑。许多现有的推理任务评估基准设计为通过几个简单步骤即可解决(Srivastava et al., 2022),而现实世界的推理通常涉及多个步骤并需要创造性的问题解决。

4.2 LLMs表现的按主题细分

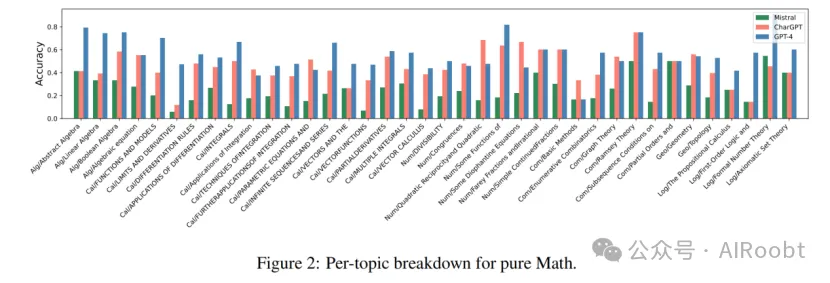

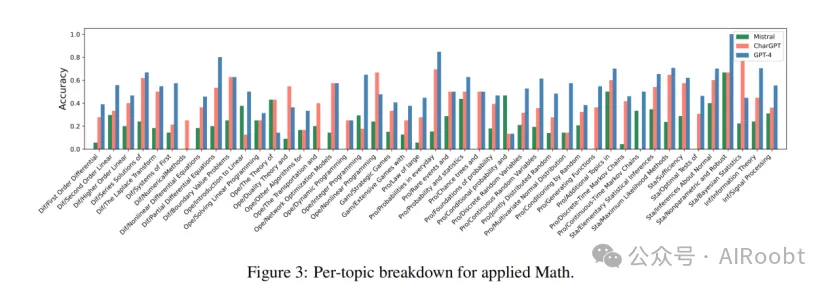

如上一节所述,对LLMs在各种主题或同一数学领域内不同子主题上的数学推理能力的探索仍然显著不足。图2和图3分别详细展示了LLMs在MaTT基准中纯数学和应用数学子主题上的准确率。

这些图表明,模型即使在同一主要主题的子主题内也表现出不同程度的准确率,强调了它们在理解和推理能力方面的差异,即使在密切相关的学科中也是如此。值得注意的是,我们发现,在某些子主题上,如积分的应用、参数方程、二次互反、丢番图方程、对偶理论、非线性规划、条件概率、连续时间马尔可夫链和基础统计学,ChatGPT和Mistral的表现优于GPT-4。这一观察结果进一步强调了不仅要超越高层次主题的整体表现,还要在更细粒度的水平上考察模型的表现,以全面理解它们的数学推理能力。

4.3 LLMs在无选项情况下的表现

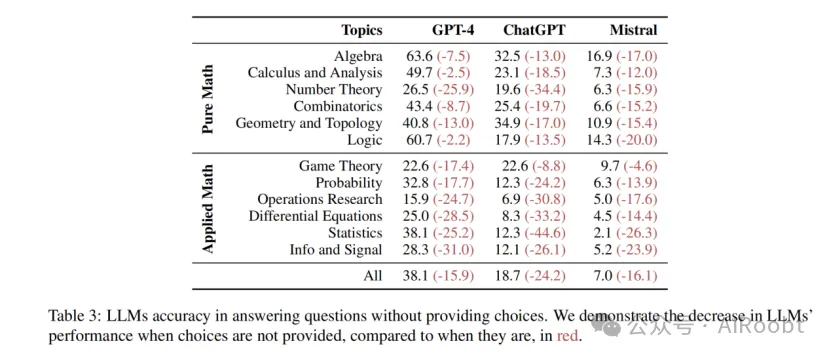

为了更深入地探讨LLMs的数学推理能力,我们评估了它们在没有多项选择选项帮助下的MaTT基准表现。我们手动评估了在没有选项情况下,模型在MaTT上的准确率,并将结果列于表3中。结果显示,性能大幅下降,其中GPT-4、ChatGPT和Mistral分别损失了29.4%、56.4%和69.7%的准确率。这一显著下降突显了模型在推导答案时对选项的依赖性,显示了它们在真正数学推理方面的局限性。这也强调了不能仅依赖单一的总体评分来评估LLMs推理能力的重要性。我们在第4.5节中提供了对选择可用性对LLMs预测影响的更详细分析。

4.4 解释的推理水平

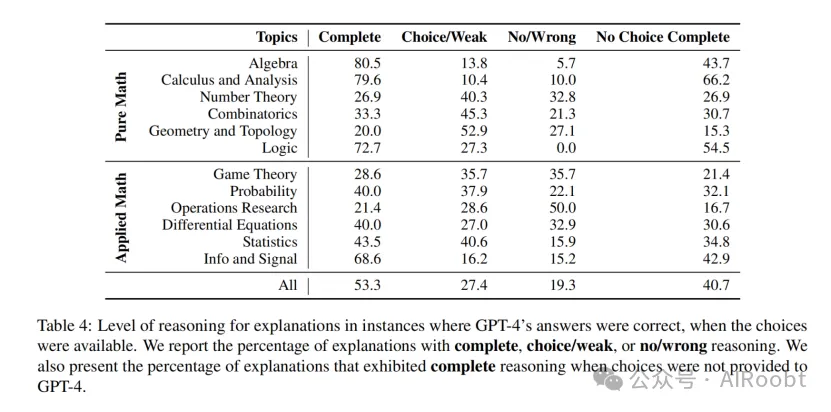

为了理解LLMs在无选项情况下表现不佳及其在不同主题上准确率变化的原因,我们对LLMs为其预测生成的解释的完整性和准确性进行了手动检查。鉴于GPT-4相对于其他评估的LLMs表现较好,本节的分析特别集中在GPT-4生成的解释上。我们的目标是确定在正确预测的实例中(有选项时),解释属于以下类别的百分比:(1)完整推理,解释详尽且逻辑合理;(2)选项/弱推理,模型利用给定选项或提供部分推理的策略;(3)无/错误推理,解释错误或缺失,模型在没有理由的情况下得出结论。此外,我们计算了在所有GPT-4正确回答(有选项)的情况下,GPT-4在无选项时仍提供正确答案并给出完整解释的实例百分比。

我们对GPT-4在有选项时预测正确的样本的解释进行了手动评估,结果详见表4。值得注意的是,我们发现仅53.3%的正确回答问题的解释是完整的,即GPT-4进行了实际推理,这突显了GPT-4在实际推理能力上的显著不一致性。此外,我们观察到不同主题上的解释完整性水平不一,并不一定与GPT-4在这些主题上的总体表现相关。当比较有无选项情况下完整解释的样本时,我们注意到一个显著差距,这表明选项的存在有助于模型更好地导航或回忆推理过程。此外,我们注意到GPT-4主要在解决较简单或更为人熟知的问题时真正进行了推理,这些问题通过几个简单步骤即可解决,而在需要更多复杂步骤或创造性问题解决的情况下,GPT-4经常失败或依赖于不同的策略(我们在第4.5节中更详细地探讨这些策略)。这与思维链提示在提升LLMs性能上的有限有效性观察结果一致。我们在附录中提供了更多关于解释的分析。

4.5 从解释中观察到的现象

除了注释解释的推理水平(如表4所示),我们还指出了GPT-4在不涉及推理时得出正确答案所采用的策略。我们总结了以下策略:

选项工程 指的是模型(如GPT-4)操纵或利用可用的多项选择选项来确定答案,而不是依赖于深刻理解或真正的推理过程。这可以分为以下几种情况:

- 使用选项:在这种情况下,GPT-4直接使用选项并选择最符合问题的一个。例如,在线性规划问题中,尽管没有选项时GPT-4无法回答任何优化问题,但在有选项时,通过这种策略,GPT-4通过简单选择选项中的最小或最大值,取得了很高的表现。

- 推导出一个合理的答案:在这种策略中,GPT-4通过排除不合理的选项来选择答案,而不是实际推理。例如,生成具有参数α和β的贝塔分布的X时,GPT-4通过排除不合理选项并提供类似的论据,正确得出了答案,但没有进行任何实际推理。

- 选项专家:GPT-4似乎了解选项通常是如何设置的。例如,在计算事件X和Y的概率时,GPT-4仅能得出事件X的概率为1/3,然后在没有任何推理的情况下,声称事件Y的概率不能为1/3,然后选择选项A,尽管还有“以上都不是”这个选项。

- 中间地带规则:我们观察到GPT-4倾向于在无法找到正确答案时选择中间值。例如,在计算游戏预期持续时间的问题中,GPT-4选择了中间值作为最合理的选项。

定理使用 指的是模型(如GPT-4)利用一个定理或性质,这实际上是问题的主要挑战部分。通过直接应用它,绕过复杂的推导而达到解决方案。例如,在求范德蒙矩阵行列式的问题中,GPT-4直接给出了定理的结果,而没有解释或证明。

循环推理 是一种逻辑谬误,其中论证的结论作为前提来支持自身。这种策略与幻觉密切相关,且非常难以检测。在这些情况下,推理从同一点开始和结束,论证本质上是说“A是正确的,因为B是正确的,而B是正确的因为A是正确的”。

盲记忆 我们指的是LLMs有时倾向于盲目记住问题的答案,而不学习其必要步骤或背后的推理。例如,在计算单位正方形、单位圆和边长为单位的等边三角形内随机选择的两点之间的期望距离时,GPT-4直接给出了已知的答案,而没有进行任何详细的计算。这些例子说明了盲记忆如何使LLMs在推理和回答相似问题时无能为力。

5.相关工作

随着LLMs的不断增强,它们在现有基准测试中的数学推理能力也显著提升。然而,目前的评估范围在涵盖的数学领域广度上仍有限,无法最终确定这些模型是否真正参与了推理,还是依赖于替代策略来找到答案。

数学基准测试

先前的研究主要集中在为数学文字题(以书面描述形式呈现的数学问题)开发基准测试——这些问题通常只需要几个步骤来解决,通常涉及基本算术或初等代数(Ling et al., 2017;Cobbe et al., 2021;Patel et al., 2021)。此外,Mishra等人(2022)的工作引入了一个全面的数学推理基准,涵盖了四个维度的23项不同任务:数学能力、语言格式、语言多样性和外部知识。此外,Zhang等人(2023)提出了一个多模态基准,重点关注几何学。与我们的研究最相关的是MATH(Hendrycks et al., 2021)和Theoremqa(Chen et al., 2023)基准。尽管提供了各种主题的数学问题,但它们的范围比我们的基准要窄得多,并且没有为每个问题提供详细的主题细分。此外,最近的一项工作(Toshniwal et al., 2024)已经开始为LLMs的指令调优生成大规模的合成数学基准。

LLMs与数学

近年来,LLMs在数学推理方面取得了显著成就(Srivastava et al., 2022;Liu et al., 2023)。这些成就得益于旨在提升LLMs性能的方法,主要通过分解推理。这些策略受到人类问题解决过程的启发,包括提供逐步指导(Wei et al., 2022;Yao et al., 2024;Besta et al., 2023)、采用验证机制以提高模型的一致性和准确性(Weng et al., 2022),以及结合复杂的推理策略(Qi et al., 2023)。

6.结论

本文对LLMs的数学推理进行了全面评估。我们创建了数学主题树(MaTT)基准,一个具有挑战性且系统组织的基准,提出了一系列涵盖广泛数学科目的问题,每个问题都与详细的分层结构主题相关。通过探索LLMs在MaTT上的准确性,我们观察到它们在广泛的数学主题上表现挣扎,特别是在没有多项选择选项的情况下。我们还观察到LLMs在不同主题上的表现差异,以及思维链提示并未显著改进性能。为了调查模型性能的差距,我们手动分析了它们回答问题时的解释。我们发现,GPT-4在提供正确答案的实例中,只有53.3%的解释被认为是完整的。此外,我们观察到模型在解决简单问题时表现较好,而在处理更复杂问题时则采用替代策略。这表明LLMs在进行深度、创造性和复杂数学思维方面存在根本性的差距。我们将公开与MaTT基准相关的所有代码、注释和数据。

7.局限性

本研究提出了几个在解释研究结果时应考虑的局限性。

首先,我们使用MaTT基准仅对三种广泛采用的LLMs进行了数学推理能力评估。这一有限的模型选择可能无法完全代表LLMs的多样化能力。在未来的评估中纳入更多种类的模型,可以更全面地理解LLMs在不同架构和训练模式下的数学推理能力。

其次,我们评估模型推理能力的方法主要依赖于分析其自生成的解释。虽然这种方法使我们能够评估模型如何推理其答案,但它本身存在潜在的偏见和不准确性。LLMs提供的解释可能并不总是准确反映其潜在的推理过程,有时甚至可能具有误导性或不完整性。采用更客观或多样化的评估方法可能是必要的,以更清晰和准确地了解LLMs如何处理和解决数学问题。

Gholami Davoodi A, Pouyan Mousavi Davoudi S, Pezeshkpour P. LLMs Are Not Intelligent Thinkers: Introducing Mathematical Topic Tree Benchmark for Comprehensive Evaluation of LLMs[J]. arXiv e-prints, 2024: arXiv: 2406.05194.

Carnegie Mellon University, Megagon Labs

本文转载自公众号AIRoobt ,作者:AIRoobt

原文链接:https://mp.weixin.qq.com/s/MCXBX9qH2s5dkaDeLYlL1w