多模态思维链推理在语言模型中的应用 原创

摘要:大型语言模型(LLMs)通过利用思维链(CoT)提示生成中间推理链作为推断答案的理由,在复杂推理方面展现出了令人印象深刻的表现。然而,现有的CoT研究一直专注于语言模态。我们提出了多模态CoT,它将语言(文本)和视觉(图像)模态结合到一个两阶段框架中,该框架将理由生成和答案推断分开。通过这种方式,答案推断可以利用基于多模态信息更好地生成的理由。使用多模态CoT,我们的模型在1亿参数以下的情况下,比以前最先进的LLM(GPT-3.5)提高了16个百分点(从75.17%提高到91.68%的准确率),甚至在ScienceQA基准测试中超过了人类的表现。代码已公开可用。

1. 引言

想象一下阅读一本没有图表的教科书。我们获取知识的能力在很大程度上得益于对多种数据模态(如视觉、语言和音频)进行联合建模。近期,大型语言模型(LLMs)(Brown 等人,2020;Thoppilan 等人,2022;Rae 等人,2021;Chowdhery 等人,2022)在通过生成中间推理步骤来推断答案之前,已经在复杂推理任务中展现出了令人印象深刻的性能。这种引人入胜的技术被称为链式思考(Chain-of-Thought,CoT)推理(Wei 等人,2022b;Kojima 等人,2022;Zhang 等人,2022)。

然而,与CoT推理相关的现有研究大多局限于语言模态(Wang等人,2022b;Zhou等人,2022;Lu等人,2022b;Fu等人,2022),很少考虑多模态场景。为了在多模态中激发CoT推理,我们提倡一种多模态CoT范式。鉴于不同模态的输入,多模态CoT将多步骤问题分解为中间推理步骤(理由),然后推断答案。由于视觉和语言是最受欢迎的两种模态,我们在这项工作中专注于这两种模态。一个例子如图1所示。一般来说,有两种方式可以激发多模态CoT推理:(i)提示LLMs和(ii)微调小型模型。

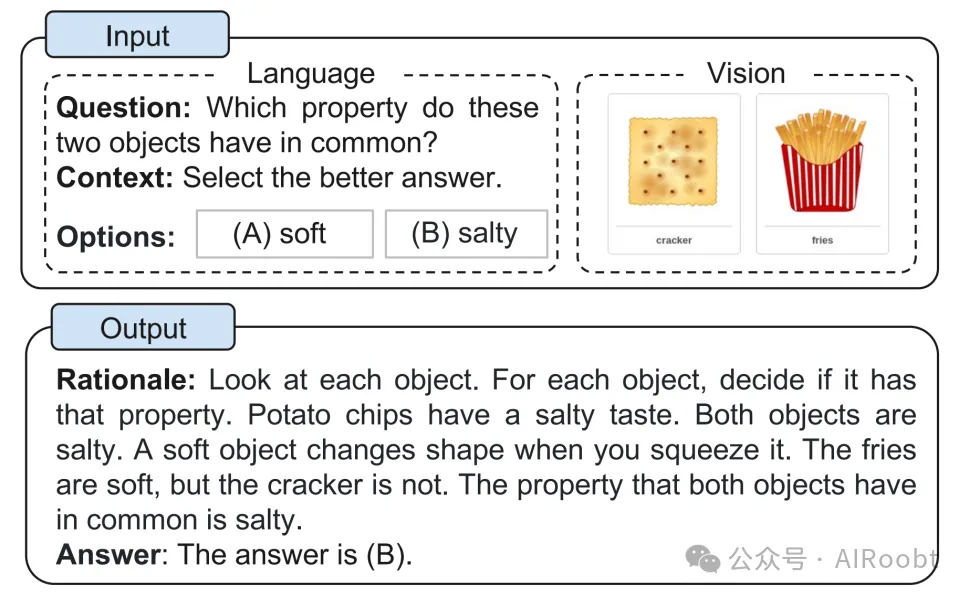

图1. 多模态CoT任务的示例。

执行多模态CoT最直接的方法是将不同模态的输入转换为一种模态,并提示LLMs执行CoT。例如,可以通过标题生成模型提取图像的标题,然后将标题与原始语言输入连接起来,输入到LLMs中(Lu等人,2022a)。然而,在标题生成过程中存在严重的信息丢失;因此,使用标题(而不是视觉特征)可能会因不同模态的表示空间中缺乏相互协同而受到影响。

为了促进模态之间的交互,另一种潜在的解决方案是通过融合多模态特征来微调较小的语言模型(LMs)(Zhang等人,2023)。由于这种方法允许调整模型架构以纳入多模态特征的灵活性,我们在这项工作中研究了微调模型,而不是提示LLMs。关键的挑战在于,参数少于100亿的语言模型往往会生成误导答案推断的幻觉理由(Ho等人,2022;Magister等人,2022;Ji等人,2022)。

为了缓解幻觉的挑战,我们提出了多模态CoT,它将语言(文本)和视觉(图像)模态纳入到一个两阶段框架中,该框架将理由生成和答案推断分开。通过这种方式,答案推断可以利用基于多模态信息更好地生成的理由。我们在ScienceQA基准测试(Lu等人,2022a)上进行了实验,这是最新的具有注释推理链的多模态推理基准测试。实验结果表明,我们的方法在基准测试上超越了以前的最先进GPT-3.5模型16%(75.17%→91.68%)。我们的贡献总结如下:

(i)据我们所知,这项工作是第一个研究不同模态中CoT推理的工作。

(ii)我们提出了一个通过微调语言模型来融合视觉和语言表示以执行多模态CoT的两阶段框架。该模型能够生成有助于推断最终答案的信息性理由。

(iii)我们的方法在ScienceQA基准测试上取得了新的最佳性能,超越了GPT-3.5的准确率16%,甚至超过了人类的表现。

2. 背景

本节回顾了通过提示和微调语言模型来激发CoT推理的最新进展。

2.1. 用LLMs进行CoT推理

最近,CoT已被广泛用于激发LLMs的多步推理能力(Wei等人,2022b)。具体来说,CoT技术鼓励LLM生成解决一个问题的中间推理链。研究表明,LLMs可以使用两种主要的技术范式进行CoT推理:零样本CoT(Kojima等人,2022)和少样本CoT(Wei等人,2022b;Zhang等人,2022)。对于零样本CoT,Kojima等人(2022)通过在测试问题后添加提示,如“Let’s think step by step”(让我们一步步来),来激发CoT推理,表明LLMs是不错的零样本推理器。对于少样本CoT,使用几个逐步推理的示例作为推理的条件。每个示例都有一个问题和一个推理链,该链引导至最终答案。这些示例通常通过手工制作或自动生成获得。相应的技术因此被称为手动CoT(Wei等人,2022b)和自动CoT(Zhang等人,2022)。

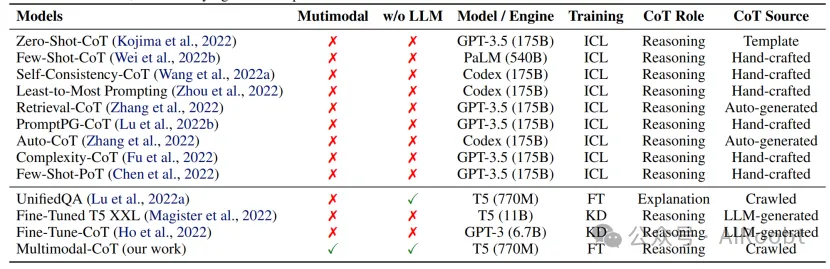

有了有效的示例,少样本CoT通常比零样本CoT表现更强,并且吸引了更多的研究兴趣。因此,大多数最近的研究集中在如何改进少样本CoT上。这些研究被归类为两个主要的研究线索:(i)优化示例;(ii)优化推理链。表1比较了典型的CoT技术。

表1. 典型的CoT技术(FT:微调;KD:知识蒸馏)。第1部分:上下文学习技术;第2部分:微调技术。据我们所知,我们的工作是第一个研究不同模态中的CoT推理。此外,我们专注于10亿参数模型,而不依赖于LLMs的输出。

优化示例 少样本CoT的性能依赖于示例的质量。正如Wei等人(2022b)所报告的,使用不同注释者编写的示例在符号推理任务中导致了显著的准确性差异。除了手工制作示例,最近的研究还探讨了如何优化示例选择过程。值得注意的是,Rubin等人(2022)检索了与测试实例语义相似的示例。然而,当推理链中存在错误时,这种方法显示出性能下降(Zhang等人,2022)。为了解决这个限制,Zhang等人(2022)发现关键是示例问题的多样性,并提出了自动CoT:(i)将给定数据集的问题划分为几个簇;(ii)从每个簇中抽取一个代表性问题,并使用简单的启发式方法生成其推理链。此外,还提出了强化学习(RL)和基于复杂度的选择策略来获得有效的示例。Fu等人(2022)选择了具有复杂推理链的示例(即,具有更多推理步骤)作为示例。Lu等人(2022b)训练了一个代理,从候选池中找到最优的上下文示例,并在与GPT-3.5交互时最大化给定训练示例的预测奖励。

优化推理链 优化推理链的一个显著方法是问题分解。Zhou等人(2022)提出了最少到最多的提示,将复杂问题分解为子问题,然后按顺序解决这些子问题。结果,解决给定子问题的便利性得到了之前解决的子问题的答案的帮助。同样,Khot等人(2022)使用了多样化的分解结构,并设计了不同的提示来回答每个子问题。除了将推理链作为自然语言文本提示,Chen等人(2022)提出了思维程序(PoT),它将推理过程建模为程序,并提示LLMs通过执行生成的程序来推导出答案。另一种趋势是为测试问题投票多个推理路径。Wang等人(2022a)引入了一种自一致性解码策略,对LLMs的多个输出进行采样,然后对最终答案采取多数投票。Wang等人(2022b)和Li等人(2022b)在输入空间引入了随机性,以产生更多样化的输出进行投票。

2.2. 通过微调模型激发CoT推理

最近的兴趣是通过微调语言模型来激发CoT推理。Lu等人(2022a)在具有CoT注释的大规模数据集上微调了编码器-解码器T5模型。然而,当使用CoT来推断答案时,即在答案之前生成推理链(推理),观察到性能显著下降。相反,CoT仅作为答案后的解释使用。Magister等人(2022)和Ho等人(2022)通过在由更大的教师模型生成的思维链输出上微调学生模型,采用了知识蒸馏。提出的方法在算术、常识和符号推理任务中显示了性能提升。

在训练10亿参数模型成为CoT推理器方面存在一个关键挑战。正如Wei等人(2022b)所观察到的,参数少于100亿的模型倾向于产生不合逻辑的CoT,导致错误的答案。换句话说,对于10亿参数模型来说,生成有效的CoT可能比直接生成答案更难。在多模态设置中,回答这个问题还需要理解多模态输入,这使得挑战变得更加艰巨。在接下来的部分中,我们将探索多模态CoT的挑战,并研究如何有效地进行多步推理。

3. 多模态CoT的挑战

现有的研究表明,CoT(链式思考)推理能力可能在一定规模的语言模型中出现,例如超过1000亿参数(Wei等人,2022a)。然而,在1B(10亿)模型中激发这种推理能力仍然是一个未解决的挑战,更不用说在多模态场景中了。这项工作专注于1B模型,因为它们可以使用消费级GPU(例如,32G内存)进行微调和部署。在本节中,我们将探讨为什么1B模型在CoT推理上失败,并研究如何设计一种有效的方法来克服这一挑战。

3.1. 探索CoT的作用

首先,我们在ScienceQA基准测试上微调一个仅文本的CoT推理基线(Lu等人,2022a)。按照Lu等人(2022a)的做法,我们采用UnifiedQABase(Khashabi等人,2020)作为后端语言模型。( UnifiedQA (Khashabi et al., 2020) 被采用,因为它是Lu等人(2022a)中最佳的微调模型。模型信息和实现细节在附录B.1中介绍。)我们的任务被建模为一个文本生成问题,模型将文本信息作为输入,并生成包含理由和答案的输出序列。如图1所示的例子,模型将问题文本(Q)、上下文文本(C)和多个选项(M)的标记连接作为输入。为了研究CoT的效果,我们将性能与三个变体进行比较:(i)无CoT,直接预测答案(QCM→A);(ii)推理,答案推断以理由为条件(QCM→RA);(iii)解释,理由用于解释答案推断(QCM→AR)。

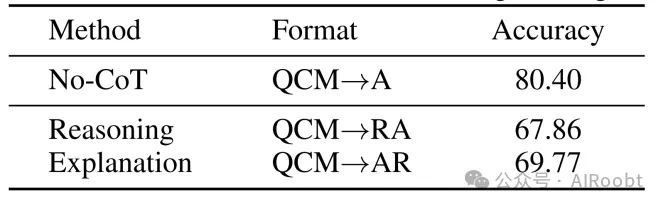

表2. 在单阶段设置中CoT(链式思考)的效果。

令人惊讶的是,我们观察到如果模型在预测答案之前先预测推理过程(QCM→RA),准确率会下降12.54%(从80.40%降至67.86%)。这一结果表明,推理过程并不一定会促进正确答案的预测。在Lu等人(2022a)的研究中也观察到了类似现象,可能的原因是模型在获得所需答案前就达到了最大令牌限制,或者过早停止了预测的生成。然而,我们发现生成的推理过程(RA)的最大长度总是少于400个令牌,这远低于语言模型的长度限制(例如,在UnifiedQABase中为512个令牌)。因此,深入探究为何推理过程会对答案推断产生负面影响,显得尤为重要。

(注释:当我们让一个智能模型先去猜测解题的思考步骤(就像先想好怎么算再给出答案),它的答题正确率降低了12.54%,从原来的80.40%掉到了67.86%。这说明,尽管看似多了一个“思考”的步骤,但这个步骤并不总是帮助模型找到正确答案。其他研究者也发现了类似的问题,可能是模型在还没找到答案时就已经“说”够了它能说的字数,或者是提前结束了回答。有趣的是,这些思考步骤其实并不长,远远没有达到模型能处理的最大字数限制。所以,现在有个重要的问题需要研究:为什么这个“先想后答”的过程反而会让模型答错更多的题呢?)

3.2. 幻觉理由产生的误导

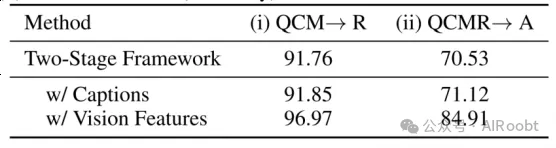

为了深入探究理由如何影响答案预测,我们将CoT问题分为两个阶段:理由生成和答案推断。我们分别报告了理由生成和答案推断的RougeL得分和准确率。表3显示了基于两阶段框架的结果。尽管两阶段基线模型在理由生成上达到了91.76的RougeL得分,但答案推断的准确率仅为70.53%。与表2中的QCM→A变体(80.40%)相比,结果表明两阶段框架中生成的理由并没有提高答案的准确率。

表3展示了两阶段设置的评估指标:(i) 理由生成(使用RougeL评分)和(ii) 答案推断(使用准确性评分)。

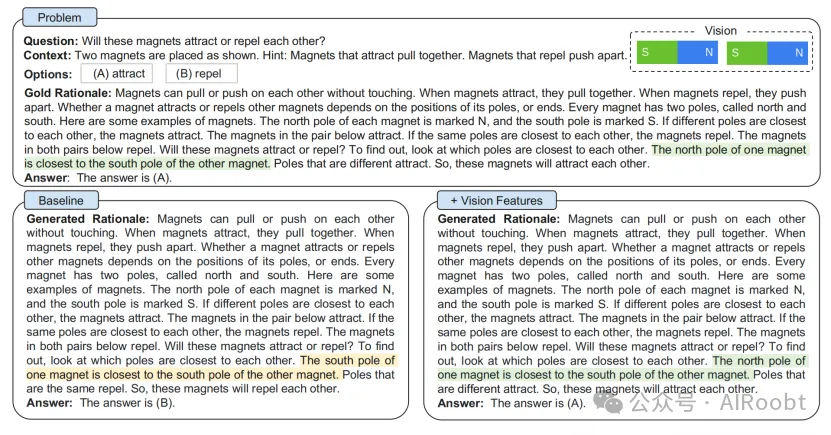

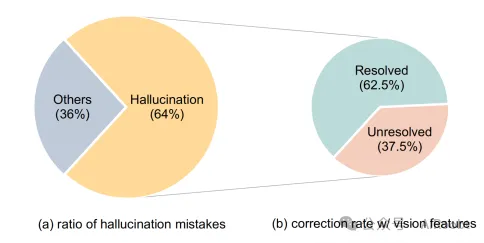

然后,我们随机抽取了50个错误案例,并发现模型倾向于生成误导答案推断的幻想理由。如图2所示的例子,模型(左侧部分)幻想出,“一个磁铁的南极最靠近另一个磁铁的南极”,这是由于缺乏对视觉内容的引用。我们发现,在错误案例中,这类错误发生的比例为64%(见图3(a))。

图2展示了在不使用视觉特征(基线)和结合视觉特征(我们的方法)的情况下,用于生成推理理由和预测答案的两阶段框架示例。上半部分展示了带有真实推理依据的问题细节,而下半部分则展示了基线方法及我们结合视觉特征的方法的输出结果。我们注意到,由于受到虚构推理依据的误导,基线方法未能预测出正确答案。更多示例请参见附录A.1。

(图片解释:两阶段框架的示例,该框架用于生成理由(rationales)和预测答案:

问题(Problem)

- 问题:这些磁铁会相互吸引还是相互排斥

上下文(Context)

- 两个磁铁如图所示放置。提示:相互吸引的磁铁会相互拉近。相互排斥的磁铁会相互推开。

选项(Options)

- (A) 吸引 (attract)

- (B) 排斥 (repel)

理由(Gold Rationale)

- 磁铁无需接触即可相互拉动或推开。当磁铁相互吸引时,它们会彼此靠近;当磁铁相互排斥时,它们会彼此远离。一个磁铁是吸引还是排斥其他磁铁,取决于其磁极(或两端)的位置。每个磁铁都有两个磁极,称为北极和南极。以下是一些磁铁的例子。每个磁铁的北极标有N,南极标有S。如果不同的磁极彼此靠近,磁铁就会相互吸引。如下一对磁铁会相互吸引。如果相同的磁极彼此靠近,磁铁则会相互排斥。如下两对磁铁都会相互排斥。这些磁铁会吸引还是排斥呢?要找出答案,只需看哪些磁极彼此最靠近。一个磁铁的北极离另一个磁铁的南极最近。不同的磁极会相互吸引。因此,这些磁铁将会相互吸引。

答案(Answer)

- 根据黄金理由,答案是(A) 吸引。

基线模型生成理由(Generated Rationale)

- 生成的推理:磁铁无需触碰就能相互拉动或推开。当磁铁相互吸引时,它们会彼此靠近。当磁铁相互排斥时,它们会彼此推开。一个磁铁是否吸引或排斥其他磁铁,取决于其磁极或两端的位置。每个磁铁有两个磁极,分别称为北极和南极。以下是一些磁铁的例子。每个磁铁的北极标记为N,南极标记为S。如果不同的磁极彼此最靠近,磁铁就会相互吸引。如下一对磁铁会相互吸引。如果相同的磁极彼此最靠近,磁铁则会相互排斥。如下两对磁铁都会相互排斥。这些磁铁会吸引还是排斥呢?要找出答案,只需观察哪个磁极彼此最靠近。一个磁铁的南极离另一个磁铁的南极最近。相同的磁极会相互排斥。因此,这些磁铁将会相互排斥。

答案,基线模型的最终答案是(B) 排斥,这与黄金理由相矛盾。回答错误

+视觉特征的生成理由(Generated Rationale)

磁铁能够不通过接触而相互拉扯或推开。当磁铁相互吸引时,它们会聚在一起。当磁铁相互排斥时,它们会分散开来。一个磁铁是吸引还是排斥其他磁铁,取决于其磁极或两端的位置关系。每个磁铁都有两个磁极,分别称为北极和南极。以下是一些磁铁的例子。每个磁铁的北极被标记为N,南极被标记为S。如果不同磁极相互间距离最近,磁铁就会相互吸引。如下图这一对磁铁会相互吸引。如果相同磁极相互间距离最近,磁铁则会相互排斥。如下两对磁铁都显示出相互排斥的现象。要判断这些磁铁会吸引还是排斥,只需查看哪两个磁极距离最近。一个磁铁的北极与另一个磁铁的南极距离最近。不同的磁极会相互吸引。因此,这两个磁铁会相互吸引。

答案是:(A)。回答正确

图3 (a) 幻想错误的比例以及(b) 结合视觉特征后的纠错率。

4. 多模态-CoT

基于第3节中的观察和讨论,我们提出多模态-CoT框架,旨在将语言(文本)和视觉(图像)两种模态融入一个两阶段框架中。本节首先概述该框架的流程,然后详述模型架构的技术设计。

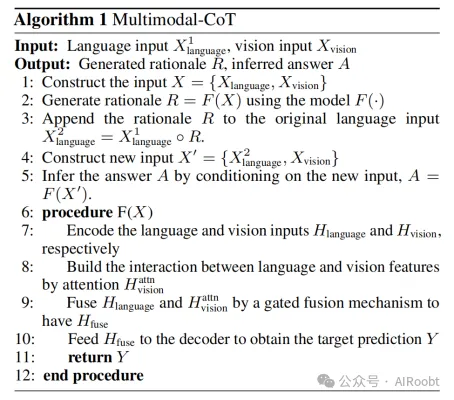

4.1. 框架概览

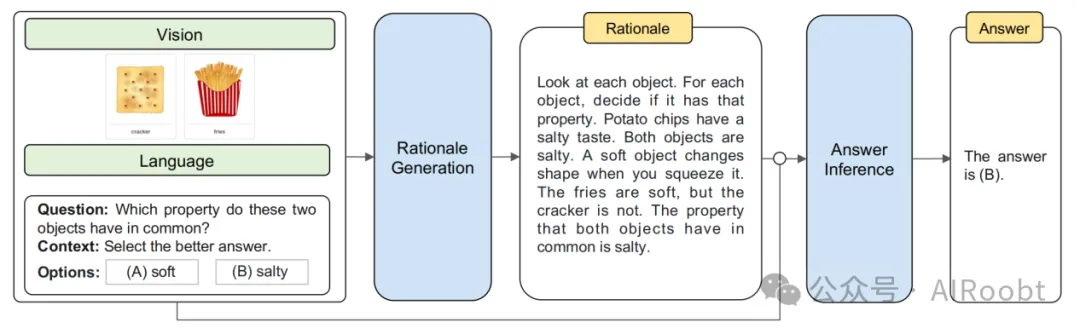

多模态-CoT包括两个训练阶段:(i) 理由生成和(ii) 答案推断。这两个阶段采用相同的模型架构,但在输入X和输出Y上有所区别。整个流程如图4所示。我们将以视觉-语言为例来展示多模态-CoT的工作原理。

图4. 我们的多模态-CoT框架概览。多模态-CoT包含两个阶段:(i) 理由生成和(ii) 答案推断。这两个阶段共享相同的模型架构,但在输入和输出上有所不同。在第一阶段,我们向模型输入语言和视觉信息以生成推理理由。在第二阶段,我们将原始语言输入与第一阶段生成的推理理由相结合。随后,我们将更新后的语言输入与原始视觉输入一起馈送给模型,以推断出答案。

(理由翻译:查看每一个物体。对于每个物体,判断它是否具有那种属性。薯片具有咸味。两个物体都是咸的。柔软的物体会在你挤压时改变形状。薯条是软的,但饼干不是。两个物体共有的属性是咸味。)

在理由生成阶段,我们向模型输入X = {X1language, Xvision},其中X1language代表第一阶段的语言输入,Xvision代表视觉输入,即图像。例如,X可以实例化为一个组合,包含问题、上下文和多项选择推理问题的选项(如Lu等人,2022a),如图4所示。目标是学习一个理由生成模型R = F(X),其中R即为推理理由。

在答案推断阶段,将理由R附加到原始语言输入X1language上,构建第二阶段的语言输入X2language = X1language◦R,其中◦表示连接操作。然后,我们将更新后的输入X’ = {X2language, Xvision}传递给答案推断模型以推断最终答案A = F(X’)。

在这两个阶段中,我们独立地使用相同架构训练两个模型。它们从训练集中取注释元素(例如,X → R,XR → A)进行监督学习。在推理过程中,给定X,使用第一阶段训练的模型为测试集生成理由;这些理由在第二阶段用于答案推断。

4.2. 模型架构

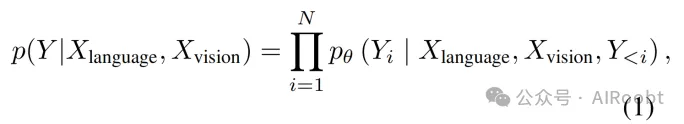

给定语言输入Xlanguage ∈ {X1language, X2language}和视觉输入Xvision,我们计算长度为N的目标文本Y(图4中的理由或答案)的生成概率为

其中pθ (Yi | Xlanguage, Xvision, Y<i) 通过基于Transformer的网络(Vaswani等人,2017)实现。该网络包括三个主要步骤:编码、交互和解码。具体而言,我们将语言文本输入到Transformer编码器中以获得文本表示,然后与视觉表示进行交互并融合,再输入到Transformer解码器中。

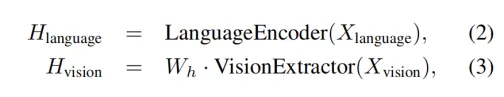

编码 模型F(X)同时接受语言和视觉输入,并通过以下函数获取文本表示Hlanguage和图像特征Hvision:

其中LanguageEncoder(·)实现为Transformer模型。我们使用Transformer编码器最后一层的隐藏状态作为语言表示Hlanguage∈Rn×d ,其中n为语言输入的长度,d为隐藏维度。同时,VisionExtractor(·)用于将输入图像向量化为视觉特征。受Vision Transformers(Dosovitskiy等人,2021)近期成功的启发,我们使用现成的视觉提取模型(如DETR(Carion等人,2020))获取图像的patch级特征。获取到patch级视觉特征后,我们应用一个可学习的投影矩阵Wh将VisionExtractor(Xvision)的形状转换为Hlanguage的形状,因此我们有Hvision∈Rm×d,其中m为patch的数量。

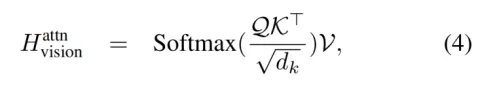

交互 获得语言和视觉表示后,我们使用单头注意力网络来关联文本令牌和图像patch,其中查询(Q)、键(K)和值(V)分别是Hlanguage、Hvision和Hvision。注意力输出Hattnvision ∈ Rn×d定义为:

其中dk与Hlanguage的维度相同,因为仅使用了一个头。

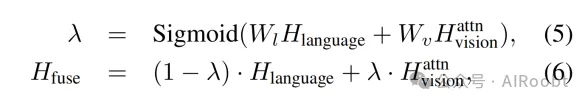

接着,我们应用门控融合机制(Zhang等人,2020;Wu等人,2021;Li等人,2022a)来融合Hlanguage和Hvision。融合输出Hfuse ∈ Rn×d通过以下公式获得:

其中Wl和Wv是可学习参数。

解码 最终,融合输出Hfuse被送入Transformer解码器以预测目标Y。多模态-CoT的完整流程如算法1所示。

5. 实验

本节将介绍基准数据集、我们技术的实现以及用于比较的基线。然后,我们将报告我们的主要结果和发现。

5.1. 数据集

我们的方法在ScienceQA基准测试(Lu等人,2022a)上进行评估。ScienceQA是第一个大规模多模态科学问题数据集,它用详细的讲座和解释注释答案。它包含21k多模态多项选择题,涵盖3个主题、26个话题、127个类别和379个技能的丰富领域多样性。基准数据集分为训练集、验证集和测试集,分别包含12726、4241和4241个示例。

5.2. 实现

以下部分介绍了多模态CoT和基线方法的实验设置。

实验设置 由于多模态CoT任务需要生成推理链并利用视觉特征,我们使用T5编码器-解码器架构(Raffel等人,2020)。具体来说,我们采用UnifiedQA(Khashabi等人,2020)来初始化两个阶段的模型,因为它在Lu等人(2022a)中取得了最佳的微调结果。为了验证我们方法在不同语言模型(LMs)中的通用性,我们还使用FLAN-T5(Chung等人,2022)作为第6.3节的主干。由于在第3.3节中使用图像标题并没有带来显著的性能提升,我们没有使用标题。我们对模型进行最多20个epoch的微调,学习率为5e-5。最大输入序列长度为512。基础和大型模型的批量大小分别为16和8。我们的实验在4个NVIDIA Tesla V100 32G GPU上运行。

基线模型 按照Lu等人(2022a)的做法,我们的基线包括:(i)视觉问答(VQA)模型(Anderson等人,2018;Kim等人,2018;Yu等人,2019;Gao等人,2019;Kim等人,2021;Lu等人,2021;Li等人,2019);(ii)文本到文本的语言模型(Khashabi等人,2020);(iii)GPT-3.5模型(Chen等人,2020)。更多细节在附录B.1中介绍。

5.3. 主要结果

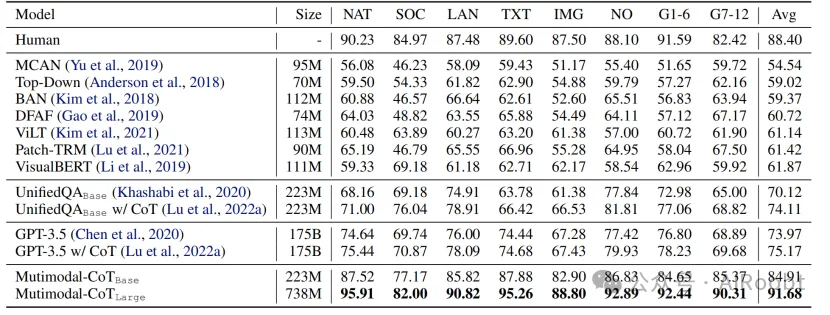

表4显示了主要结果。多模态CoTLarge在性能上超过了GPT-3.5的16.51%(75.17%→91.68%),并且超过了人类表现。具体来说,在8个问题类别中,多模态CoTLarge对于配对图像(IMG)的问题实现了21.37%的性能提升(67.43%→88.80%)。与现有的利用图像标题在上下文中提供视觉语义的UnifiedQA和GPT-3.5方法相比,结果表明使用图像特征更有效。此外,根据我们在表5中的消融研究结果,我们的两阶段框架有助于取得优越的结果。总体而言,结果验证了多模态的有效性以及通过我们的两阶段框架实现1B模型CoT推理的潜力。

表4. 主要结果(%)。大小 = 主干模型大小。问题类别:NAT = 自然科学,SOC = 社会科学,LAN = 语言科学,TXT = 文本上下文,IMG = 图像上下文,NO = 无上下文,G1-6 = 1-6年级,G7-12 = 7-12年级。除我们的结果外,其他结果均摘自Lu等人(2022a)。第1段:人类表现;第2段:VQA基线;第3段:UnifiedQA基线;第4段:GPT-3.5基线;第5段:我们的多模态CoT结果。加粗的结果表示最佳表现。

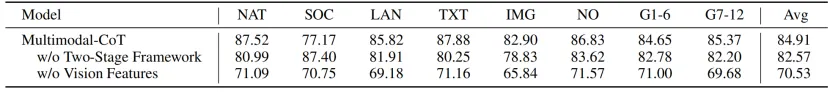

表5. 多模态CoT的消融研究结果。

6. 分析

以下分析将探讨多模态CoT的工作原理,并讨论影响因素和局限性。除非另有说明,我们使用基础大小的模型进行分析。

6.1. 多模态加速收敛

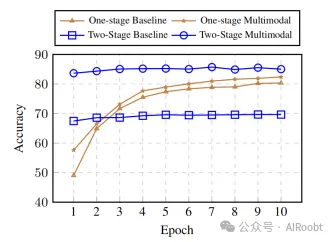

图5显示了不同训练周期下基线和多模态CoT的评估准确率曲线。“单阶段”基于QCM→A输入输出格式,因为它在表2中表现最佳,“双阶段”是我们的双阶段框架。我们发现,与直接生成答案而不进行CoT的单阶段基线相比,双阶段方法在开始时的准确率相对较高。然而,没有视觉特征,双阶段基线随着训练的进行无法产生更好的结果,因为理由质量低(如第3节观察到的)。相比之下,使用视觉特征有助于生成更有效的推理,这有助于我们双阶段多模态变体中更好的答案准确率。

图5. 无CoT基线和多模态CoT变体在各个epoch(训练周期)上的准确率曲线。

6.2. 使用不同的视觉特征

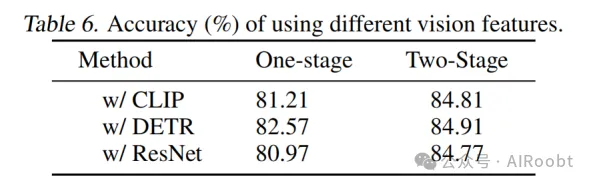

不同的视觉特征可能会影响模型性能。我们比较了三种广泛使用的视觉特征类型,CLIP(Radford等人,2021)、DETR(Carion等人,2020)和ResNet(He等人,2016)。CLIP和DETR是类似补丁的特征,其中DETR基于目标检测。对于ResNet特征,我们将ResNet-50的池化特征重复到与文本序列相同的长度,以模仿补丁特征,其中每个补丁与池化图像特征相同。视觉特征的更多细节在附录B.2中介绍。

表6显示了视觉特征的比较结果。我们观察到使用视觉特征通常比仅使用语言的基线表现更好。具体来说,DETR通常表现更好。因此,在多模态CoT中,我们默认使用DETR。

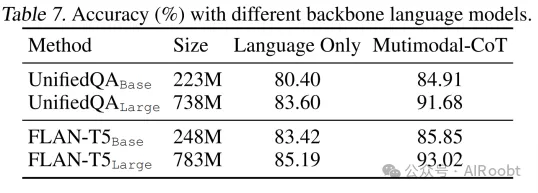

6.3. 在不同主干模型上的普遍有效性

为了测试我们方法的好处对其他主干模型的普遍性,我们将底层语言模型更改为不同大小或类型的其他变体。如表7所示,我们的方法对于广泛使用的主干模型通常是有效的。

6.4. 错误分析

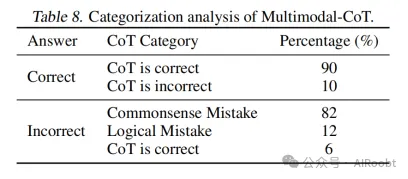

为了更好地理解多模态CoT的行为并促进未来的研究,我们手动调查了我们方法生成的随机选择的示例。表8总结了由多模态CoT生成的分类结果。我们随机挑选了50个答案正确的样本和50个答案不正确的样本。每个类别的相应示例在附录C中介绍。

我们发现正确的样本(即答案正确的样本)包含一定数量的错误思维链(10%)。结果表明,CoT可能并不总是有助于答案推断,而且模型在一定程度上是健壮的——它可以通过忽略错误的推理来预测正确的答案。对于错误的样本(即答案错误的样本),思维链中的常识性错误是最常见的错误类型(88%)。当回答这些问题需要常识知识时,模型经常犯常识性错误,例如,理解地图和计算图像中的数字(图9),以及使用字母表(图10)。另一种错误类型是逻辑错误(12%),推理链中存在矛盾(图11)。此外,还有一些情况是答案不正确,但它们的CoT是正确的(6%),但可能不一定与答案选项相关(图12)。

分析表明,未来的研究有前景方向。通过(i)整合更多信息的视觉特征和改进语言-视觉交互以能够理解地图和计数;(ii)注入常识知识;(iii)应用过滤机制,例如,只使用有效的CoT来推断答案并摆脱无关的CoT,可以改进多模态CoT。

7. 结论

我们正式研究了多模态CoT问题。我们提出了多模态CoT,它将语言和视觉模态结合到一个双阶段框架中,该框架将理由生成和答案推断分开,使答案推断能够利用从多模态信息中更好地生成的理由。通过多模态CoT,我们展示了我们的方法在ScienceQA基准测试中的准确率超过了GPT-3.5的16个百分点。我们的错误分析表明,利用更有效的视觉特征、注入常识知识以及应用过滤机制来改进未来研究中的CoT推理是有潜力的。

Zhang Z, Zhang A, Li M, et al. Multimodal chain-of-thought reasoning in language models[J]. arXiv preprint arXiv:2302.00923, 2023.

本文转载自公众号AIRoobt ,作者:AIRoobt

原文链接:https://mp.weixin.qq.com/s/wA6Zn8VvYNkbBi4usidWNw