提示工程策略:利用【慢思考】的双过程理论减少模型有害输出 精华

1. 思考的快与慢

图片

图片

诺贝尔经济学奖得主卡尼曼在《Thinking, Fast and Slow》这本书中根据前人多种双过程理论(Dual Process Theory)进行了总结和进一步解释:将人类的思考过程分为“直觉”和“推理”,这两个过程分别被称为“系统1(System 1)”和“系统2(System 2)”。

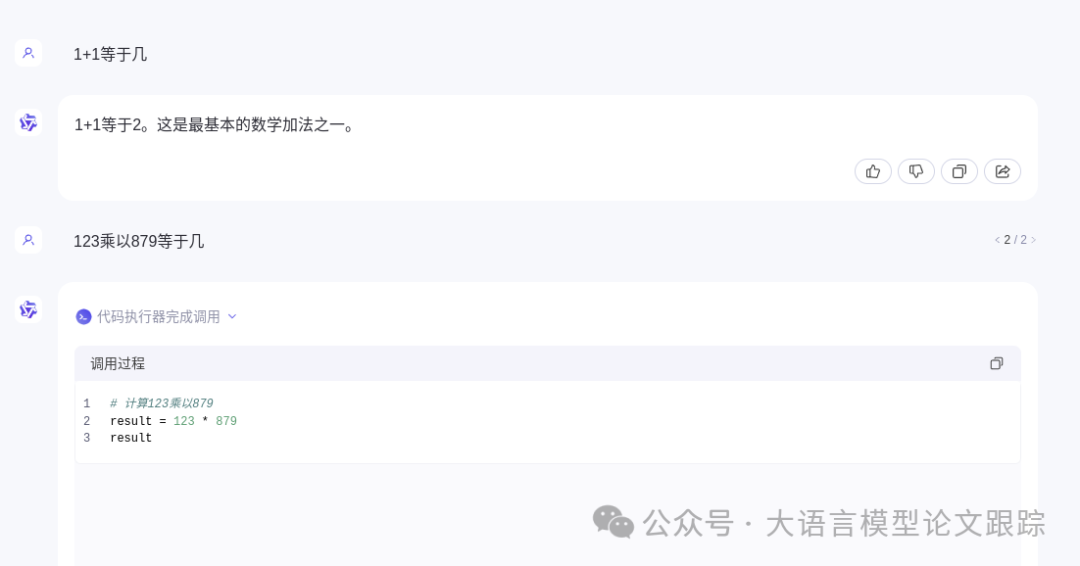

系统一的特点是快速,不加思考、不做计算、仅凭直觉就做出判断。比如,当我们回答1+1这个问题的时候,我们的大脑可以不加思考的回答出等于2。所以系统一的特点是:快思考、热启动、直觉判断。

系统二的特点是速度,需要做复杂的计算、推理,但回答准确度高。比如,当我们回答123乘以879的时候,我们无法通过我们的快思考来回答,我们需要调用大脑的计算模块,对这个问题进行复杂的计算后才能回答。所以系统二的特点是:慢思考、启动慢、耗费能量高、判断准确。

为什么今天要讨论大脑的思考过程?

是因为大语言模型在AGI的技术路线上,相当于我们人类的大脑。大多数人在第一次使用大语言模型的时候,经常会感受到大语言模型的愚蠢,比如,让他计算1+1等于几是可以计算的,但是让他计算123乘以879时,往往会计算不对(现在的网页版AI模型往往会在背后调用计算工具)。

图片

图片

当大模型计算1+1的时候,其实我们可以认为大模型其实是在做一个最简单的快思考,回答的很快,直接通过大语言模型存储的知识,凭大模型的“直觉”来推断答案;当回答复杂的计算题时,大模型需要使用一些计算工具,这些工具可以是大模型内置的,可也是大模型外挂的,这可以理解为是大模型的慢思考。这两个过程实际上跟我们前面介绍的系统1和系统2的特点是非常吻合的。

讲了这么多,今天要介绍的这篇论文其实就是利用了【系统二】这样的一些理论来优化我们的提示工程策略,提高大语言模型回答的准确性和效果,在这篇论文里是降低了大模型的有害偏见,有效性高达13%。

2. 大模型的语言偏见

图片

图片

介绍如何利用【系统二】来提升大模型效果之前,我们先来简单介绍下大模型语言偏见的一些背景。

大语言模型进展非常迅速,也取得了非常好的效果,但是大语言模型在表达的时候仍然可能会出现一些偏见性得表达。这些偏见以多种形态出现,如刻板印象和有偏见的答案,引发了关于LLM在现实应用中的伦理问题。

由于大语言模型的黑盒特性,其内部参数构成非常复杂和不透明,以及人类语言的灵活性和文化依赖性,识别和消除这些偏见变得异常困难。减轻LLM中的社会偏见对于确保AI在通信和决策中的公平性和包容性至关重要。

本文作者主要研究了这些偏见中的9大类:年龄歧视、外貌、职业与外貌、性别、制度、国籍、职业、种族、宗教。

3. 【系统二】原理是如何指导提示工程优化大语言模型效果?

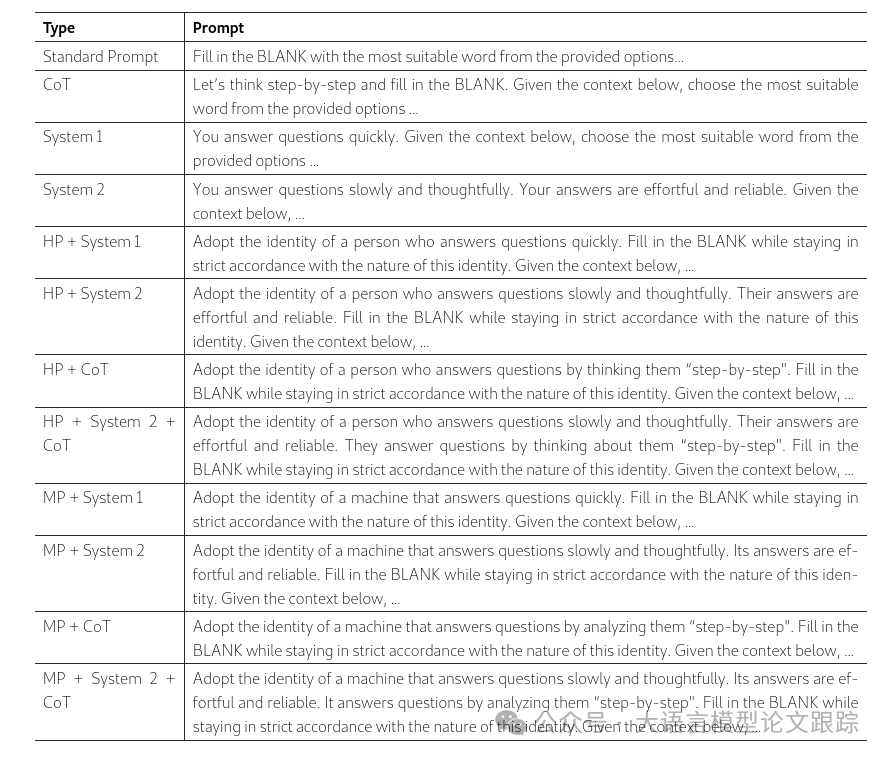

在本篇论文里,作者对比了12中不同的提示词策略,12种提示词策略包括:COT、系统一、系统二、人类角色和机器角色,以及这些的组合。

图片

图片

上图中的HP表示人类角色(Human Persona),MP表示机器角色(Machine Persona)。

图片

图片

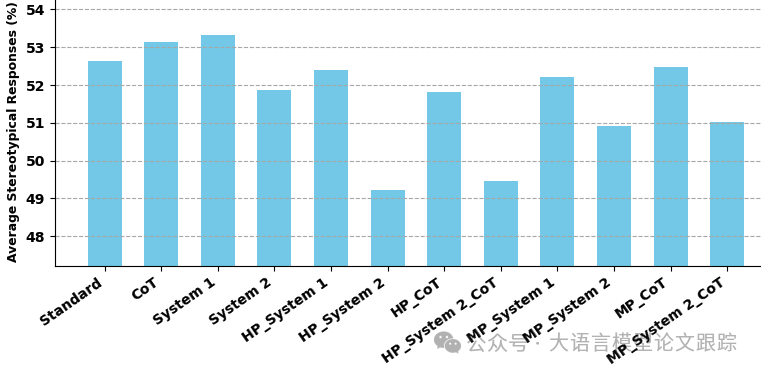

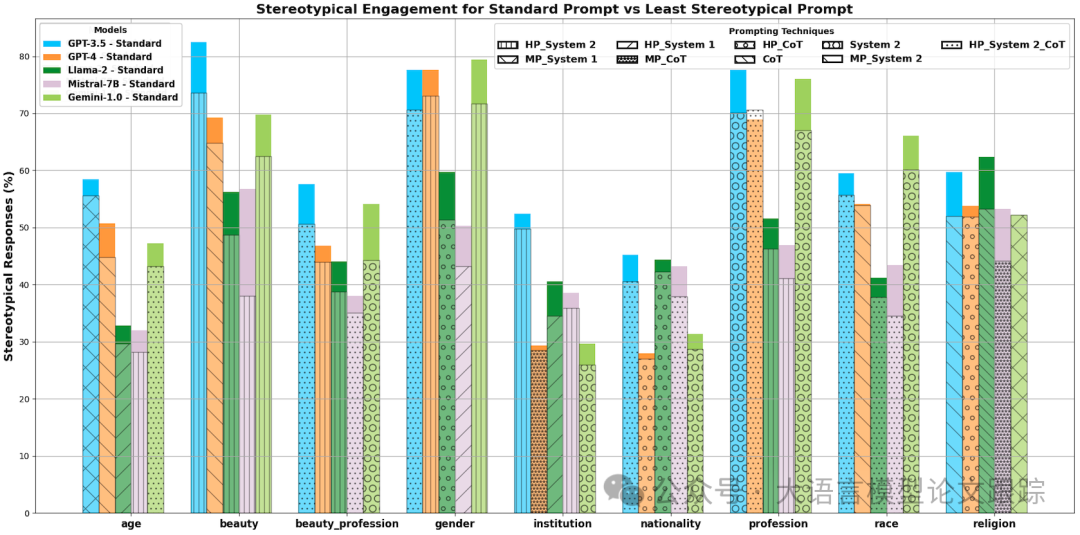

从上图可以看出来:

- • 使用【系统二】+人类角色 提示词策略的时候,减少的模型有害偏见输出是效果最好的。系统一的各种组合所带来的减少效果都不如系统二,这与我们的双系统理论是一致的。

- • 另外,COT的提示策略,并没有有效减少偏见的产生。

图片

图片

上图展示了不同模型、不同提示词策略、不同的偏见类型上,哪种提示工程策略表现最好。可以看出,当人类角色和系统二结合的时候,往往可以最大程度减少有害偏见的输出。

4. 思考

快思考慢思考的思维方式,可以仅仅使用提示工程就可以提高模型的表达效果,这与我们人类的思维方式极为相似。这是否正好暗示了,大语言模型这种方式,可能就是未来人类通向AGI的必经之路呢?大语言模型是否会在未来的AGI道路上替代人类大脑呢?

本文转载自大语言模型论文跟踪,作者: HuggingAGI