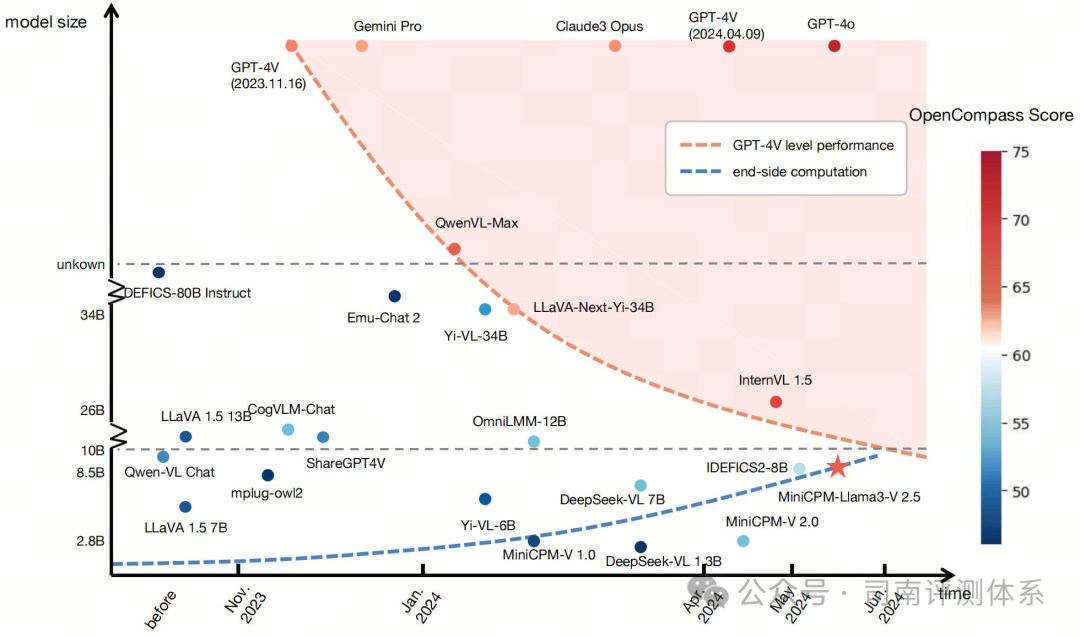

模型更新,评测集优化:多模态大模型评测升级!

先放结论

如果你想为你的项目挑选合适的图文多模态模型,以下是一些可供参考的模型性能 (括号内为评测分数):

已测性能最强的闭源模型:

- GPT-4o(海外 API 模型,69.9)

- GLM-4v(国内 API 模型,60.8)

已测位于 "参数量-性能" 前沿上的开源模型:

- InternVL-v1.5 (26B, 61.7)

- MiniCPM-Llama3-V2.5 (8B, 58.8)

- InternLM-XComposer2-7B-4KHD (7B, 58.8)

- Mini-InternVL (4B, 56.2; 2B, 49.8)

本期的多模态模型性能榜单

1.多模态大模型评测榜单构成更新

在 4 月底,司南多模态大模型评测榜单由 12 个数据集上的分数计算平均分得到。在 5 月至 6 月,基于精简评测集的目的,我们对榜单构成进行了如下变动:

- 将 MMBench 更新到了 v1.1 版本 (数据质量有所提升),同时将其中英文版本合为一个分数,以避免占据过高权重;

- 移除多个与 MMBench 相似定位的评测集,仅保留 MMBench v1.1版本

- 移除 LLaVABench(因数据量小,测试方差太大)

目前,司南多模态大模型榜单共包含 8 个 benchmark 的分数及其平均分:MMBench v1.1 (客观综合),MMStar (数据污染),MMMU (多模态考试),MathVista (多模态数学),HallusionBench (幻觉),AI2D (图表理解),OCRBench (OCR 能力),MMVet (主观综合)。

大家仍可在 Open VLM Leaderboard 访问全部的测试结果 (超过 20 个 benchmark):

https://huggingface.co/spaces/opencompass/open_vlm_leaderboard

2.新增模型及性能表现

新增 API 模型

我们更新了大量 API 模型的评测结果,其中包括:GPT-4o (低/高分辨率),GPT-4v (0409,高分辨率), GLM-4v,Gemini-1.5-Pro,RekaFlash / RekaCore。

- GPT-4o(低/高分辨率), GPT-4v(0409,高分辨率)

GPT-4o 是 OpenAI 于 5 月 13 日发布的最新人工智能模型,代表了GPT系列的一个重要升级。其中,“o” 代表“Omni”,意为“全能”,凸显了其多功能特性。GPT-4o 具有支持音频、图像等多种模态的任意组合作为输入,能够进行快速推理、实时响应等主要特点。我们在 VLMEvalKit 所支持的图文多模态任务上对其进行了评测,其高分辨率版本最终取得了 69.9 分的平均分数,占据总分第一并大幅领先于第二超过 5 分。同时,基于 GPT-4o, GPT-4v 的高低分辨率性能对比,我们发现高分辨率版本相比低分辨率版本带来约 3.5 分的平均分提升,对于 MMMU,OCRBench 等评测集的提升会更加显著。

- Gemini-1.5-Pro

Gemini-1.5-Pro 是 Google 于 4 月 12 日发布一款强大的AI模型,具有多模态理解和超长上下文处理等能力。我们对其的评测基于 Google 的 Vertex 平台。我们基于 VLMEvalKit 所支持的图文多模态任务上对其进行了评测。这一模型最终取得了 64.4 分的平均分数,居于总分第二。

- GLM-4v

GLM-4v 是智谱AI推出的一款多模态大语言模型,支持视觉问答、图像字幕、视觉定位和复杂目标检测等各类图像理解任务。经过测试,GLM-4v 取得了 60.8 分的平均分数,居于总分第五。

- RekaFlash / RekaEdge

RekaFlash / RekaEdge 是 Reka.ai 推出的中/轻量级多模态大模型,支持多种输入模态及 128k 上下文长度。其中 RekaFlash 曾在主观评测榜单 VisionArena 中取得过第一的成绩 (目前也仅弱于 GPT-4o/4v)。我们对其客观性能进行了测试,但发现他们的客观性能并不理想:RekaFlash / RekaEdge 仅取得 53.9/46.7 的平均分数,分列榜单的第 18 与 32 名。

整体上,目前的多模态榜单上闭源模型仍处于领先地位,尤其是 GPT-4o 会大幅度领先于其他模型。需要注意的是,由于模型厂商会对 API 模型施加各种拒答策略作为限制,可能导致我们现在对于各个 API 模型的性能依然有所低估。我们会在近期对这一现象进行定量分析。

新增开源模型

相比较 API 模型,我们在同期内新增的开源模型数量更多,比如有:

- MiniCPM-Llama3-V2.5 (OpenBMB)

- Mini-InternVL-[2B/4B] (Shanghai AI Lab)

- InternLM-XComposer2-[1.8B / 7B-4KHD] (Shanghai AI Lab)

- WeMM (WeChat AI)

- CogVLM2-19B (Zhipu AI)

- Phi-3-Vision (Microsoft)

- XVERSE-V-13B (XVERSE)

- 360VL-70B (360)

- PaliGemma-3B (Google)

- Bunny-LLaMA-3-8B (BAAI)

- MiniCPM-Llama3-V2.5

作为一个 8B 量级的模型,它的整体性能超越了 Qwen-VL-Max、Gemini-1.0-Pro 等开源模型,以 58.8 的平均分位列榜单第 7 (开源模型第 2)。同时,该模型还具备一些特色能力,例如支持德语、法语、西班牙语等30+种语言的多模态能力,以及具备增强的OCR和指令跟随能力,可以处理高达180万像素的图像。

- Mini-InternVL

作为 4B/2B 大小的小模型,Mini-InternVL 的性能测试结果均位于 参数量-性能 前沿上,分别位列榜单的第 14 及 24 名 (开源模型第 7 及 11 名),优于基于相同语言模型的其他多模态大模型。

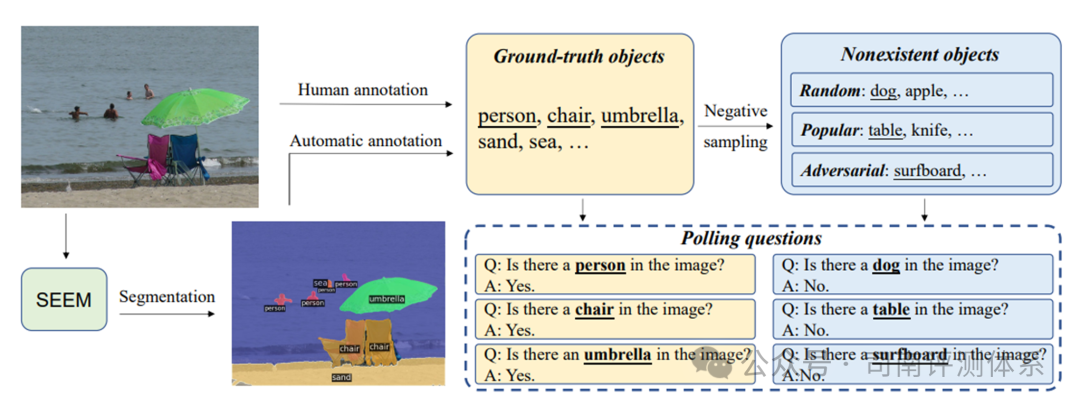

3.新增评测集

除了 MMBench v1.1 外,我们还新增了 POPE 与 SEEDBench2_Plus 两个评测集。其中 POPE 评测集主要用于检测多模态大模型的物体相关幻觉,SEEDBench2-Plus 评测集主要专注于结构化图文理解。

此外,MMT-Bench,SEEDBench2,Video-MME 等评测集也正在支持过程中。

POPE:用以检测多模态大模型的物体相关幻觉

SEEDBench2-Plus:一个专注于结构化图文理解的多模态评测集

4.结 语

在多模态评测方面,我们注重评测数据集 - 评测工具 - 开放榜单的三位一体建设,同时也会进行多模态学习及评测的研究工作(近期会陆续公开一些研究成果)。

本文转载自 司南评测体系,作者: 司南 OpenCompass