编码大模型系列:Meta创新的“代码编译优化”的LLM 原创 精华

大型语言模型 (LLM) 已在各种软件工程和编码任务中展现出卓越的能力。然而,它们在代码和编译器优化领域的应用仍未得到充分探索。训练LLM需要大量资源,需要大量的 GPU时间和大量的数据收集。Meta语言模型编译器 (LLM Compiler),这是一套专为代码优化任务设计的强大、公开可用的预训练模型。

LLM Compiler建立在Code Llama的基础上,增强了对编译器中间表示 (IR)、汇编语言和优化技术的理解。该模型已在546B的LVM-IR和汇编代码的庞大语料库上进行了训练,并经过了指令微调。

LLM Compiler是根据定制的商业许可发布的,允许广泛重用。除了7B和 13B的规模,还有该模型的微调版本,展示了其在优化代码大小和从 x86_64和ARM汇编反编译回LLVM-IR的增强功能。

1.Code Llama

2024年1月29日发布代码Llama 70B是一个可以使用文本提示生成代码的大型语言模型。Code Llama是最先进的代码任务公开可用LLMs,可以使得当前开发人员的工作流程更快、更高效,并降低学习编码的门槛。Code Llama可以被用来作业以及教学。

Code Llama是Llama 2的代码专用版本,它是通过在特定的代码数据集进一步训练Llama 2而得到。它可以从代码和自然语言提示生成代码和关于代码的自然语言,例如,“写一个斐波那契数列的函数”。它还可用于代码的补全和调试,支持当今使用的许多最流行的语言,包括Python、C++、Java、PHP、Typescript (Javascript)、C#和Bash。

Code Llama提供多达100,000 个上下文Token。所有的模型都基于16,000个Token序列进行训练,在多达100,000个Token输入中显示出明显的改进。

Meta还微调Code Llama的另外两个变体:Code Llama-Python和Code Llama-Instruct。Code Llama-Python是Code Llama的专用语言变体,在 Python代码的100B的Token上进一步微调。Meta选择Python的原因是Python和PyTorch在AI社区中发挥着重要作用。

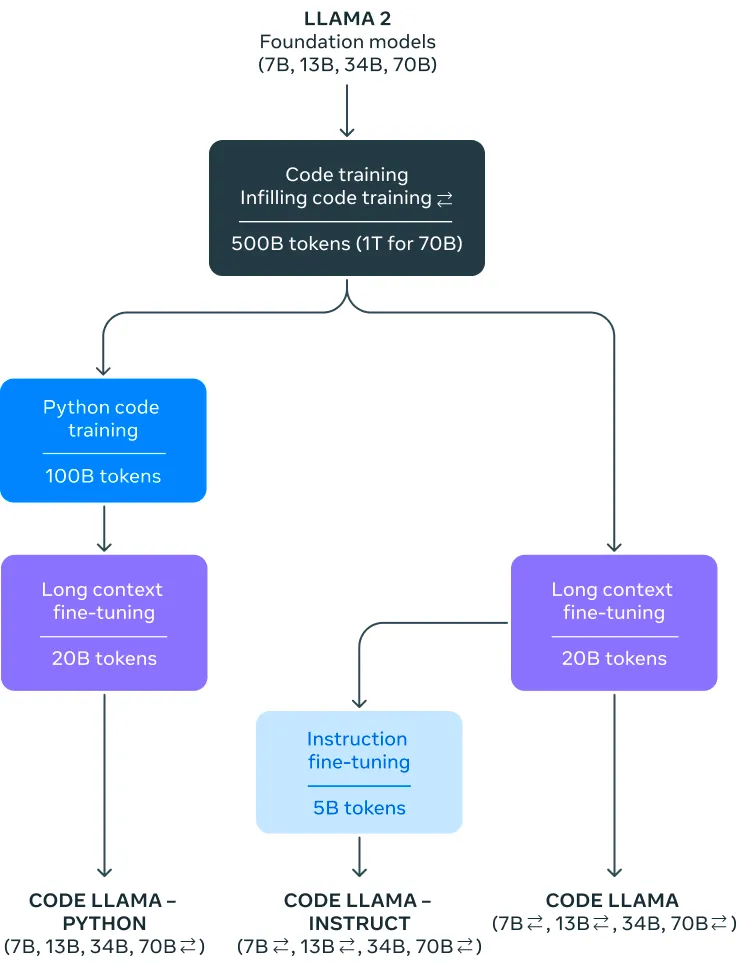

上图为Code Llama的家族谱系

2.LLM Compiler

刚刚,Meta在编译器优化方面又迈出了一大步,它推出了一套突破性的工具,基于LLM的编译器能够处理编译和反编译任务,在编译器技术领域树立了新的标杆。

编译器的中间表示(Intermediate Representation,IR)是编译过程中的一种抽象表示形式,位于源代码和目标代码之间。它的存在主要是为了帮助编译器在多个阶段进行优化和转换,从而生成高效的目标代码。

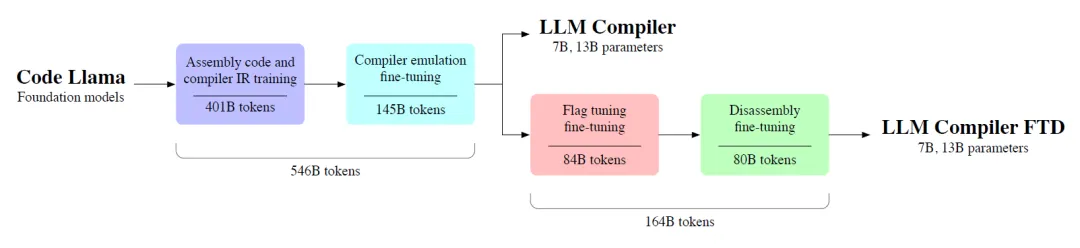

上图为LLM Compiler的训练过程,分两个阶段对546B的数据集进行训练,这些数据集以编译器为中心。在第一阶段,模型主要在未标记的编译器IR和汇编代码上进行训练。第二阶段对模型进行指令微调,以预测优化的输出和效果。进而生成7B和13B的LLM Compiler。

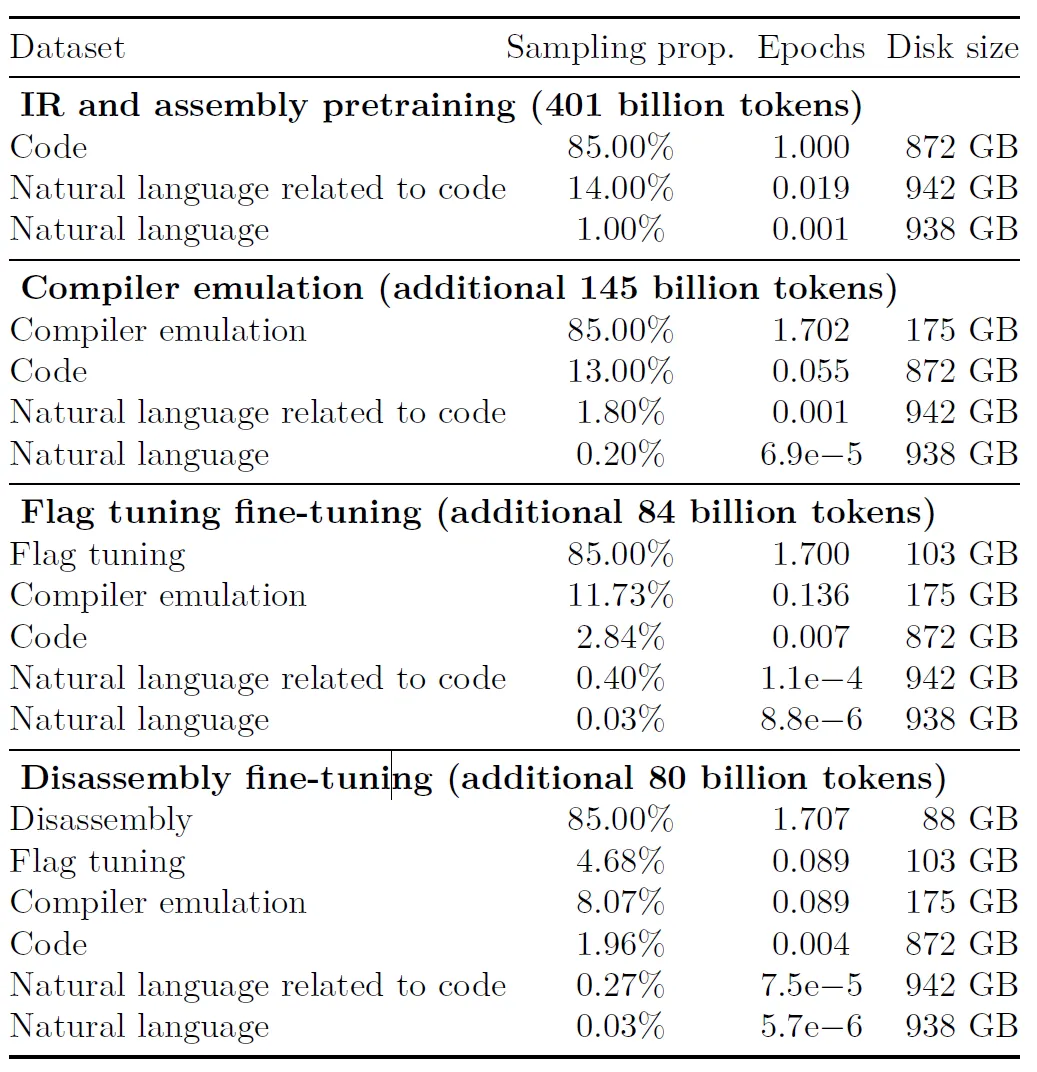

不同阶段使用的训练数据集,可以看出在编译优化方面还是加入不少的训练数据。尤其是第三阶段和第四阶段中,和代码相关的自然语言成为主力。

之后在164B个下游标记和反汇编任务数据集上进一步微调形成新的LLM Compiler FTD。在四个训练阶段中,每阶段都会保留先前15%的任务数据。

3.核心要点:如何学习编译优化

既然要优化编译,那么就需要想解锁下LLVM。LLVM是一套编译器基础设施项目,以C++写成,包含一系列模块化的编译器组件和工具链,用来开发编译器前端和后端。它是为了任意一种编程语言而写成的程序,利用虚拟技术完成编译时期、链接时期、执行时期以及“闲置时期”的优化任务。

它最早以C/C++为实现对象,而目前它已支持包括ActionScript、Ada、D语言、Fortran、GLSL、Haskell、Java字节码、Objective-C、Swift、Python、Ruby、Crystal、Rust、Scala以及C#等语言。

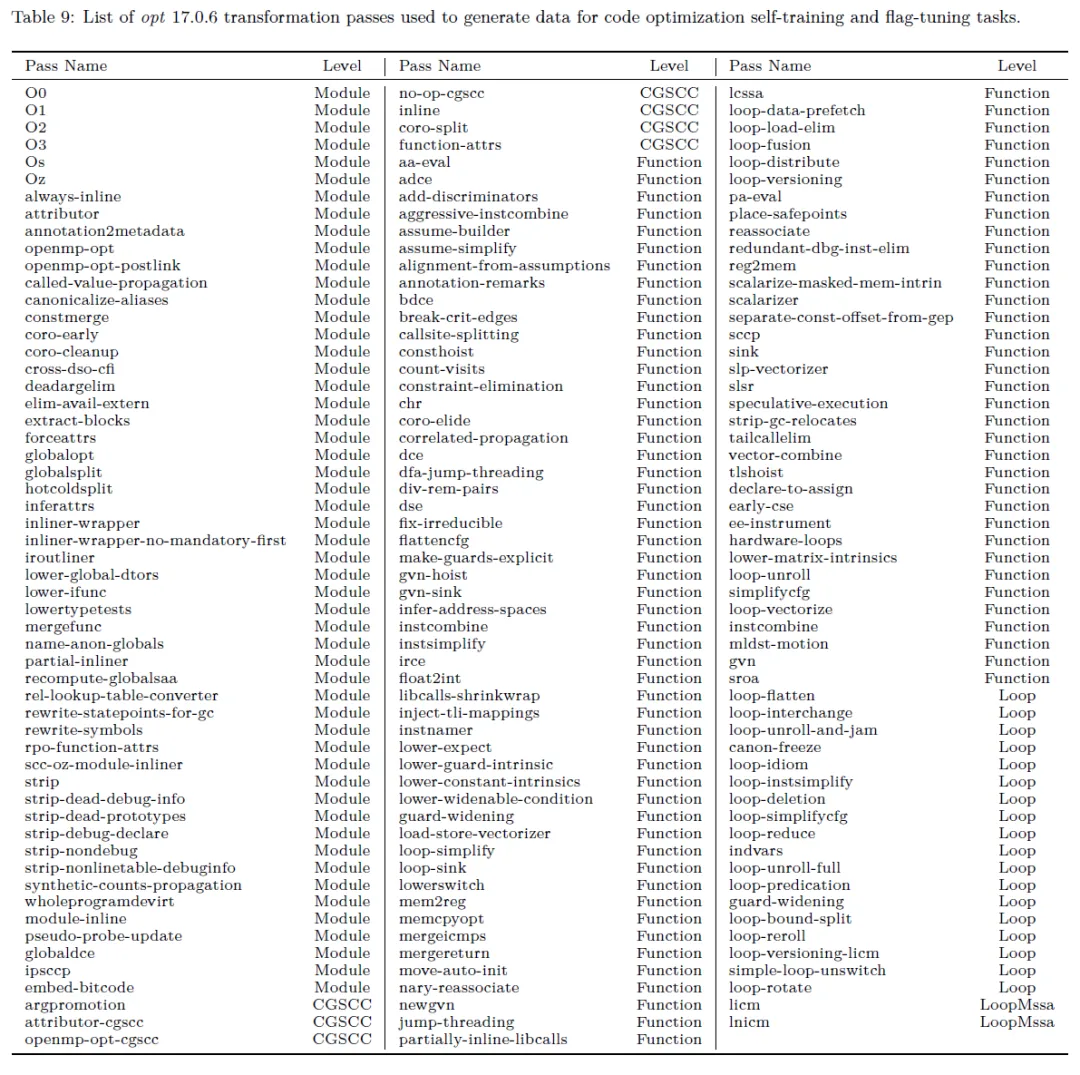

LLVM pass框架是LLVM系统的一个很重要的部分。LLVM的优化和转换工作就是由多个pass来一起完成的。类似流水线操作一样,每个pass完成特定的优化工作。

上面就是所有的pass(优化算子),各自身怀绝技!

总的来说,所有的pass大致可以分为两类:

- 分析(analysis)和转换分析类的pass主要以提供信息为主

- 转换类(transform)的pass主要优化中间代码

常用的代码优化方法(不同的pass):

- 删除公共子表达式:如果表达式x op y先前已被计算过,并且从先前的计算到现在,x op y中的变量值没有改变,则x op y的这次出现就称为公共子表达式(common subexpression)

- 删除无用代码无用代码(Dead-code):其计算结果永远不会被使用的语句

- 常量合并:如果在编译时刻推导出一个表达式的值是常量,就可以使用该常量来替代这个表达式。

- 代码移动:这个转换的结果是那些不管循环多少次都得到相同结果的表达式(即循环不变计算,loop-invariant computation),在进入循环之前就对它们进行求值。

- 强度削弱:用较快的操作代替较慢的操作,如用加代替乘 。(例:2*x ⇒ x+x)

- 删除归纳变量:对于一个变量x ,如果存在一个正的或负的常数c使得每次x被赋值时它的值总增加c ,那么x就称为归纳变量(Induction Variable)。在循环中,若有一组归纳变量的值的变化不变,可以将这组变量保留一个

聪明的读者一定反应过来了,感情这模型是在学习如何针对代码选择最优的pass list(优化算子组合)然后进行优化。对了!

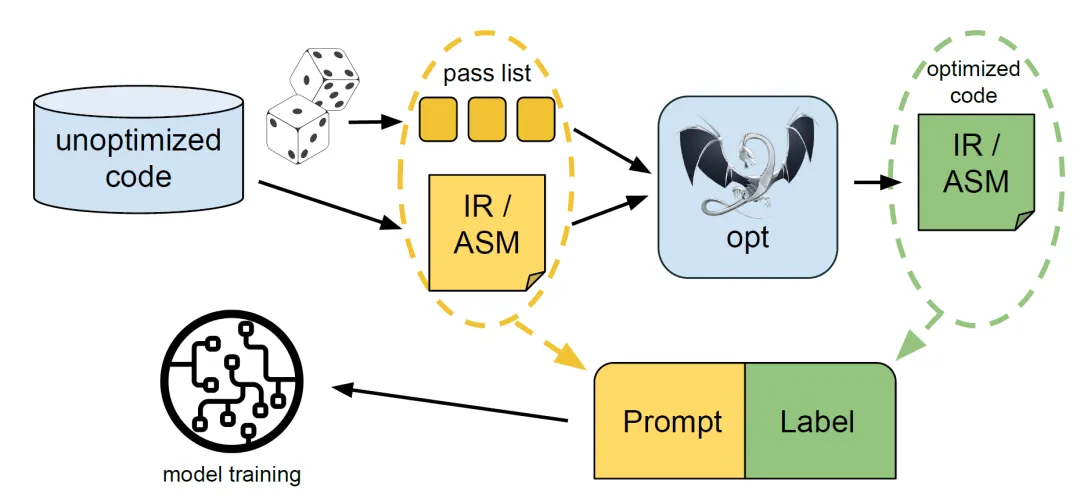

Meta为了让LLM Compiler了解编译器优化的工作原理,它使用编译器模拟办法。这个办法将未优化的代码和随机选择的pass lists(优化算子组合,黄色部分)一起丢给opt,进而生成优化代码(IR 或汇编,绿色部分)。最后黄色部分和绿色部分一起作为训练集喂给LLM。

上图中的opt是LLVM工具链中的一个工具,用于分析和转换LLVM源文件中的中间表示(IR)。这个工具通常用于应用各种优化和转换操作,例如执行优化传递、插入优化插件等。

>opt input .bc -o output .bc -p ’module ( default <Oz >) ,module ( iroutliner )’

>clang output .bc -o output .o

>size output .o

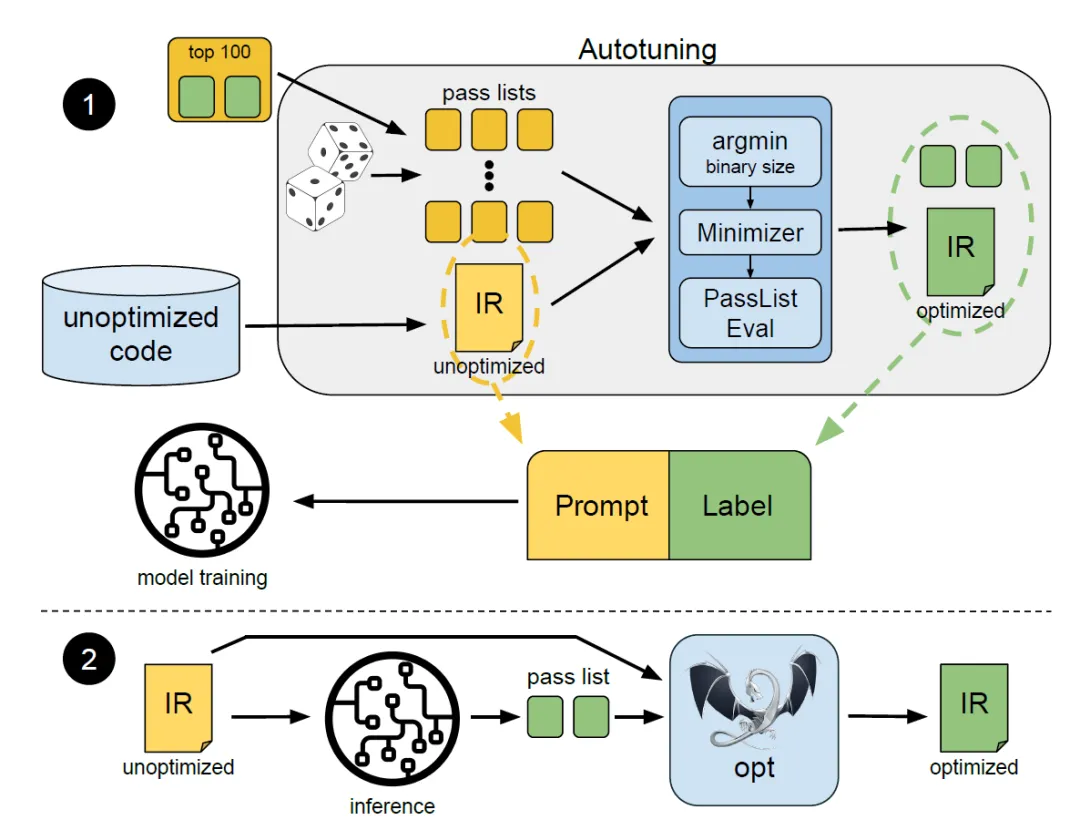

上图展示了训练1和推理2期间的模型输入(提示)和输出(标签)的过程。为了生成训练提示的标签,未优化的代码和多个随机pass组合进行编译,然后针对输出二进制最小的pass组合进行最小化,之后再使用 PassListEval检查其正确性。最终被选择的pass list以及其相应的优化IR在训练期间用作标签。期间最经常被选择的100个pass组合将会在所有的应用中广播。

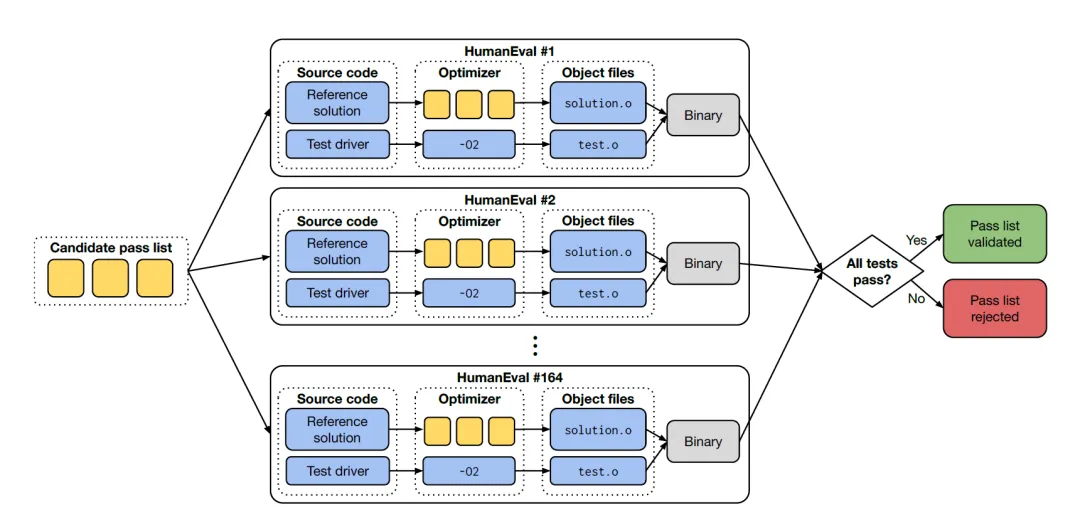

对于部署,Meta选择优化过的传递列表,以确保优化的代码是正确的。为了保证正确性,PassListEval很是关键,下图展示了这个过程:

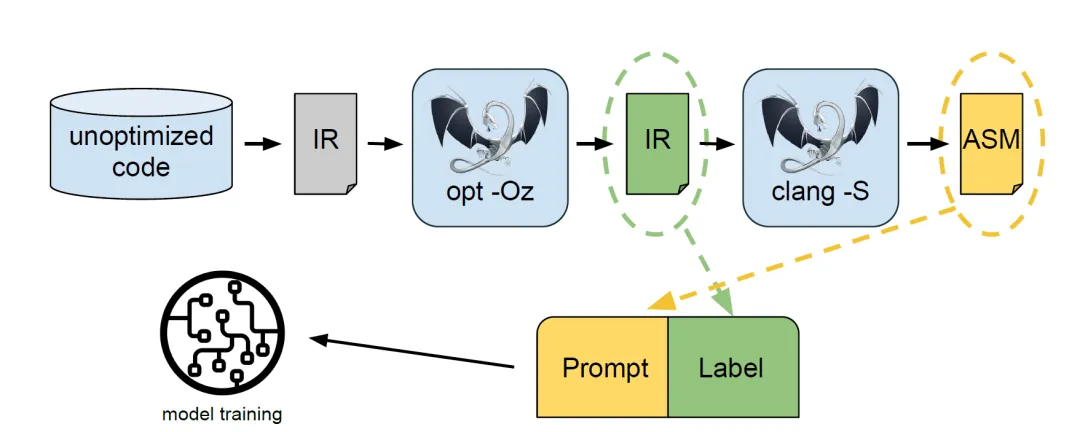

那么如何进行反编译的微调呢,其实也很简单,通过训练模型将给定的代码样本反汇编为相应的IR来训练模型,以了解汇编(ASM,机器指令,黄色)和IR(优化过后的绿色部分)之间的关系。用于标记此训练任务的IR是利用优化过的IR。如下图所示:

这样LLM编译器经过微调,可在特定任务中表现出色,例如将编译后的代码反汇编回其中间表示 (LLVM-IR)。这对于理解遗留代码或反向优化特别有益,使LLM编译器成为维护和升级现有软件系统的宝贵工具。

4.效果如何

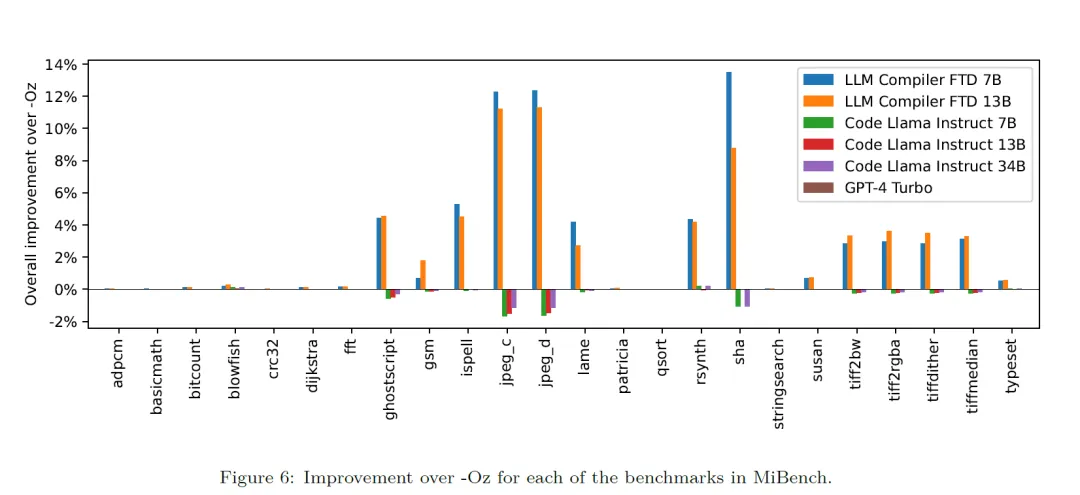

若要比较效果的话,肯定和优化命令-Oz作为基准来比较,从图中可以看出,效果还是挺不错的。虽然LLM Compiler在编译器优化任务上表现良好,并且相比先前的工作,对编译器表示和汇编代码的理解有所改进,但仍存在一些局限性。主要限制是输入的有限序列长度(上下文窗口)。

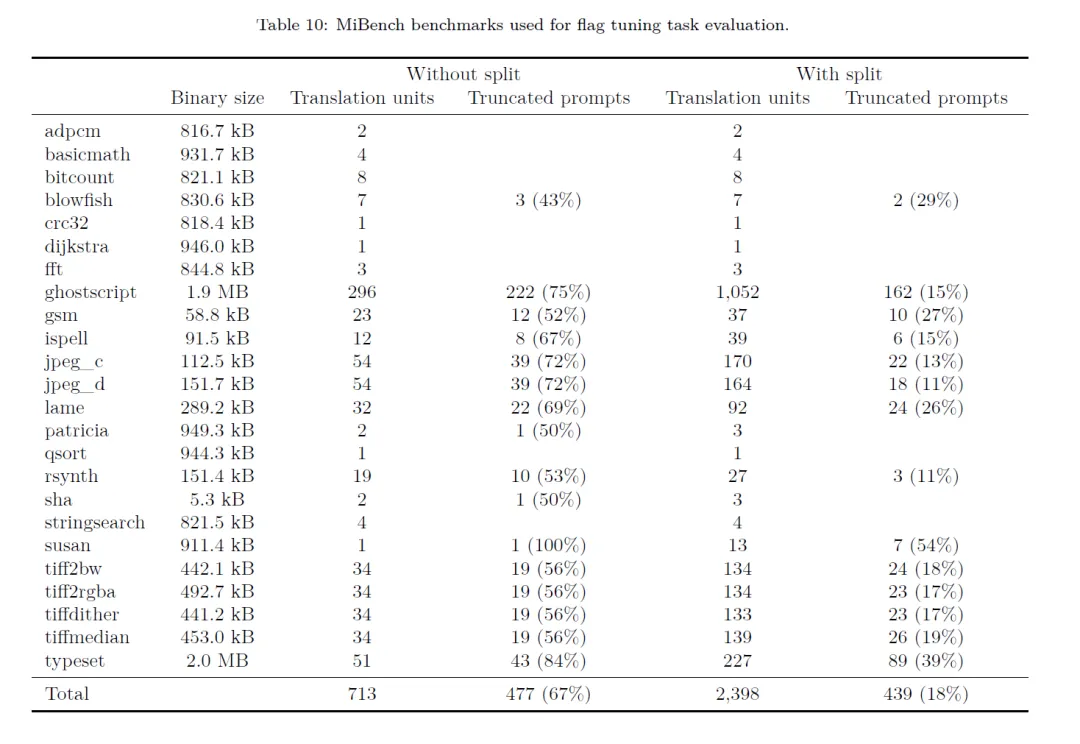

LLM 编译器支持 16k tokens的上下文窗口,但程序代码往往超过这个长度。例如,67%的MiBench基准中显示超过了这个上下文窗口。为了缓解这个问题,研究人员拆分了内容,然而仍有18%还是过长,无法作为输入。这样也是是后续的一个研究热点。

本文转载自 鲁班模锤,作者: 庞德公