最全梳理多模态大模型近期进展(26个最佳方案汇总) 精华

paper:https://arxiv.org/abs/2401.13601

一篇比较不错的综述型文章

- 梳理了多模态大型语言模型(MM-LLM) 的近期进展

- 总结了 MM-LLM 的模型架构和训练流程

- 梳理了 26 个当前最佳的 MM-LLM模型

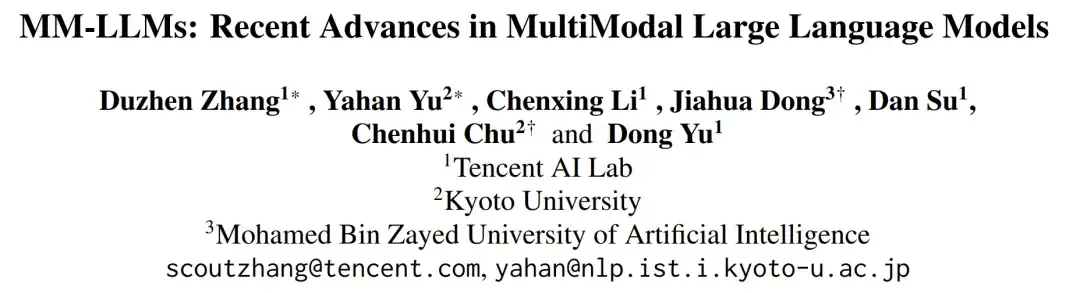

MM-LLM 的时间线

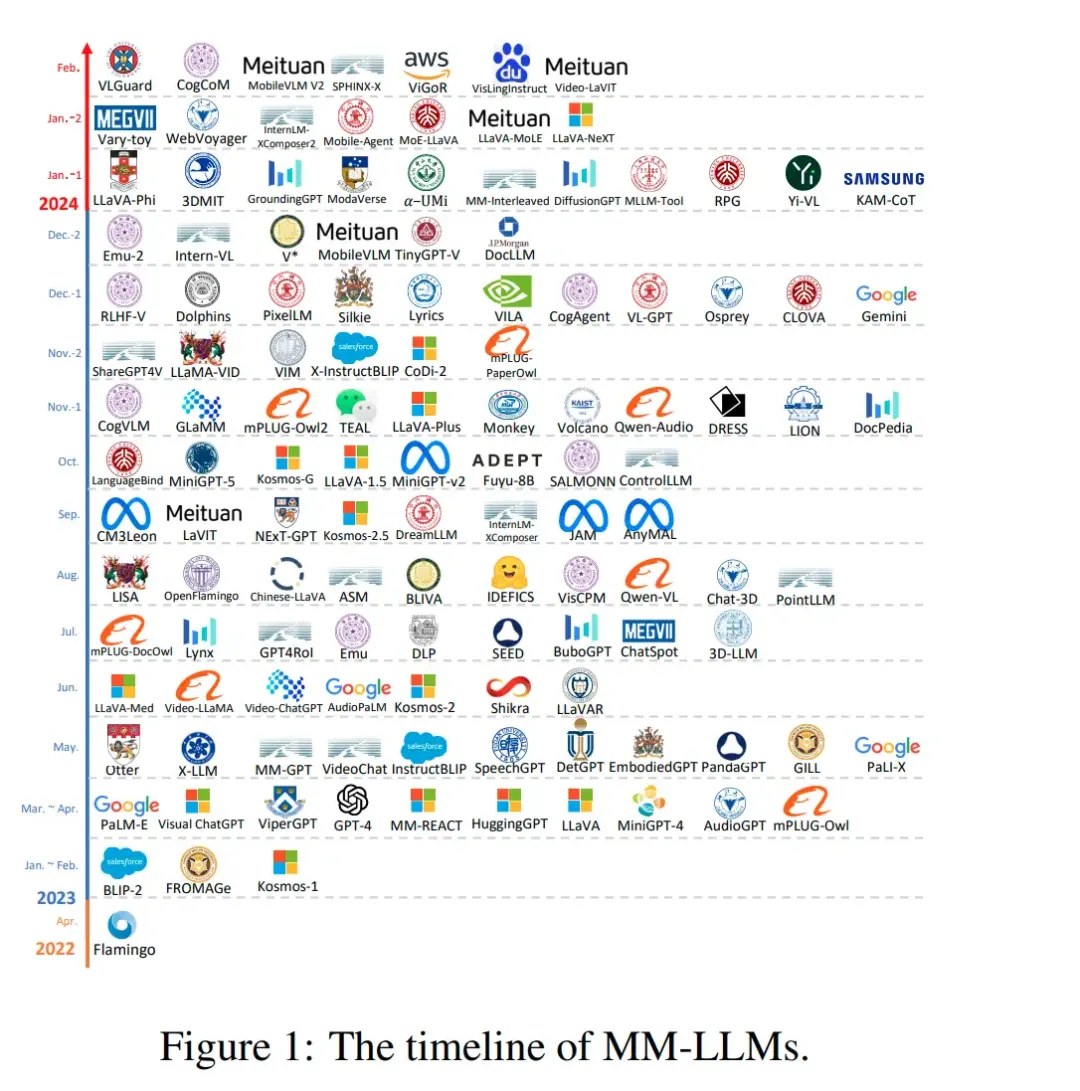

主要模型架构

模型架构

- 模态编码器(Modality Encoder/ME):

- 图像:NFNet-F6、ViT、CLIP ViT等。

- 视频:通常将视频均匀采样成5帧,经过与图像相同的预处理。

- 音频:CFormer、HuBERT、BEATs等。

- 3D点云:ULIP-2与PointBERT后端。

- 负责将不同模态的输入编码成特征表示,例如图像、视频、音频等。

- 针对不同的模态,有多种预训练的编码器选项,例如:

- 输入投影器(Input Projector):

- 将编码的特征与文本特征空间对齐,以便输入到LLM主干。

- 这通常通过线性投影器或多层感知器(MLP)实现,也可以使用更复杂的实现,如交叉注意力、Q-Former、P-Former和MQ-Former。

- LLM 骨干(LLM Backbone):

- 作为模型的核心,处理来自不同模态的特征,进行语义理解、推理和决策。

- 采用大型语言模型作为核心代理,处理来自不同模态的表示,进行语义理解、推理和决策。

- 输出投影器(Output Projector):

- 将LLM主干的输出映射回模态生成器能够理解的特征。

- 这通常通过小型变换器或MLP实现,目的是最小化映射特征与模态生成器的条件文本表示之间的距离。

- 模态生成器:

- 模态生成器的任务是生成不同模态的输出,通常使用现成的潜在扩散模型(LDMs)。

- 例如,Stable Diffusion用于图像合成,Zeroscope用于视频合成,AudioLDM2用于音频合成。

训练流程(Training Pipeline)

- MM-LLMs的训练流程分为两个主要阶段:多模态预训练(MM PT)和多模态指令微调(MM IT)。

- 在MM PT阶段,通过优化预定义的目标来训练输入和输出投影器,实现不同模态之间的对齐。

- 在MM IT阶段,使用指令格式化的数据集对预训练的MM-LLMs进行微调,以提高模型对未见任务的泛化能力。

多模态预训练(MM PT)

在这一阶段,通过优化预定义的目标来训练输入和输出投影器,实现不同模态之间的对齐。

一般而言,只训练输出投影器与输出投影器,实现不同模态之间的对齐,以便LLM主干能够有效地处理多模态输入。在训练阶段,模态编码器、LLM 骨干和模态生成器通常保持在冻结状态;由于投影器是轻量级的组件,因此相比于总参数量,MM-LLM 中可训练参数的占比非常小(通常约为 2%)。总参数量取决于 MM-LLM 中使用的核心 LLM 的规模。因此,在针对各种多模态任务训练 MM-LLM 时,可以取得很高的训练效率。

数据集:通常使用X-Text数据集,这些数据集包含图像-文本(Image-Text)、视频-文本(Video-Text)和音频-文本(Audio-Text)对,以及交错的图像-文本语料库(interleaved Image-Text corpus)。

优化:训练过程中,主要优化的是IP和OP的参数,以最小化条件文本生成损失(Ltxt-gen)。这通常涉及到将模态编码器的输出特征(FX)与文本特征(FT)对齐,生成的对齐特征(PX)作为LLM主干的输入。

多模态指令调优(MM IT)

使用指令格式化的数据集对预训练的MM-LLMs进行微调,以提高模型对未见任务的泛化能力。

MM IT 这种方法需要使用一组指令格式的数据集对预训练的 MM-LLM 进行微调。通过这个微调过程,MM-LLM 可以泛化到未曾见过的任务,执行新指令,从而增强零样本性能。

MM IT 包含监督式微调(SFT)和根据人类反馈的强化学习(RLHF),目标是与人类意图或偏好对齐并提升 MM-LLM 的交互能力。

SFT 可将预训练阶段的部分数据转换成指令感知型的格式。

SFT 之后,RLHF 会对模型进行进一步的微调,这需要有关 MM-LLM 所给响应的反馈信息(比如由人类或 AI 标注的自然语言反馈(NLF))。这个过程采用了一种强化学习算法来有效整合不可微分的 NLF。模型的训练目标是根据 NLF 生成对应的响应。

现有的 MM-LLM 在 MM PT 和 MM IT 阶段使用的数据集有很多,但它们都是表 3 和表 4 中数据集的子集。

26个sota模型

该团队比较了 26 个当前最佳(SOTA)MM-LLM 的架构和训练数据集规模,如表 1 所示。另外他们还简单总结了每种模型的核心贡献和发展趋势。这些模型代表了多模态大型语言模型领域的最新进展,涵盖了从理解到生成、从单模态到多模态交互的各个方面。每个模型都在特定的任务或数据集上展示了其独特的优势和能力。

26个sota模型

- Flamingo:一个视觉语言模型,专为处理交错的视觉数据和文本而设计,能够生成自由形式的文本作为输出。

- BLIP-2:引入了一个资源高效的框架,使用轻量级Q-Former桥接模态间的差距,并利用冻结的LLMs进行零样本图像到文本的生成。

- LLaVA:将指令微调(IT)技术转移到多模态领域,为解决数据稀缺问题,引入了新的开源多模态指令遵循数据集和基准测试。

- MiniGPT-4:提出一种简化的方法,只训练一个线性层来对齐预训练的视觉编码器与LLM,以复制GPT-4展示的能力。

- mPLUG-Owl:提出了一种新的模块化训练框架,包含视觉上下文,并引入了一个评估不同模型在多模态任务中表现的指令评估数据集。

- X-LLM:扩展到包括音频在内的各种模态,并展示了强大的可扩展性,利用Q-Former的语言迁移能力,在汉藏语系的背景下成功应用。

- VideoChat:首次提出了一个以聊天为中心的多模态大型语言模型,用于视频理解对话,为学术界和工业界提供了标准和协议。

- InstructBLIP:基于预训练的BLIP-2模型进行训练,只更新Q-Former,在多模态指令微调中引入了指令感知的视觉特征提取和相应指令。

- PandaGPT:一个开创性的通用模型,能够理解和执行跨6种不同模态的指令:文本、图像/视频、音频、热成像、深度和惯性测量单元。

- PaLI-X:使用混合视觉语言目标和单模态目标进行训练,包括前缀完成和掩蔽标记完成,对下游任务结果和微调设置中的帕累托前沿都有效。

- Video-LLaMA:引入了一个多分支跨模态预训练框架,使LLMs能够同时处理给定视频的视觉和音频内容,并与人类进行对话。

- Video-ChatGPT:专为视频对话设计,能够通过整合时空视觉表示来生成关于视频的讨论。

- Shikra:为指代表话而设计的一个简单而统一的预训练多模态大型语言模型,涉及对图像中区域和对象的讨论。

- DLP:提出了P-Former来预测理想的提示,训练在单模态句子数据集上,展示了单模态训练增强多模态学习的可能性。

- BuboGPT:通过学习共享的语义空间构建的模型,全面理解多模态内容。

- ChatSpot:引入了一种简单而有效的方法,通过精确的指代表达指令微调多模态大型语言模型,促进细粒度的交互。

- Qwen-VL:支持英语和中文的多语言多模态大型语言模型,允许在训练阶段输入多张图片,提高了对视觉上下文的理解能力。

- NExT-GPT:一个端到端的通用多模态大型语言模型,支持图像、视频、音频和文本的自由输入和输出。

- MiniGPT-5:与生成vokens和与Stable Diffusion集成的多模态大型语言模型,擅长执行多模态生成的视觉语言输出。

- LLaVA-1.5:对LLaVA框架进行了简单修改,包括应用MLP投影和引入针对学术任务量身定制的VQA数据。

- MiniGPT-v2:作为统一接口设计的多模态大型语言模型,用于处理多种视觉语言多任务学习。

- CogVLM:一个开源的多模态大型语言模型,通过在注意力和前馈层中嵌入可训练的视觉专家模块来弥合模态之间的差距。

- DRESS:使用自然语言反馈来增强与人类偏好的一致性,将条件强化学习算法扩展到整合不可微的自然语言反馈。

- X-InstructBLIP:引入了一个跨模态框架,具有指令感知的表示,足以使LLMs能够处理包括图像/视频、音频和3D在内的多种任务。

- CoDi-2:一个多模态生成模型,擅长模态交错指令遵循、上下文生成和通过多轮对话的用户体验交互。

- VILA:在视觉任务中表现出色的多模态大型语言模型,展示了卓越的推理能力,同时保持了仅文本的能力。

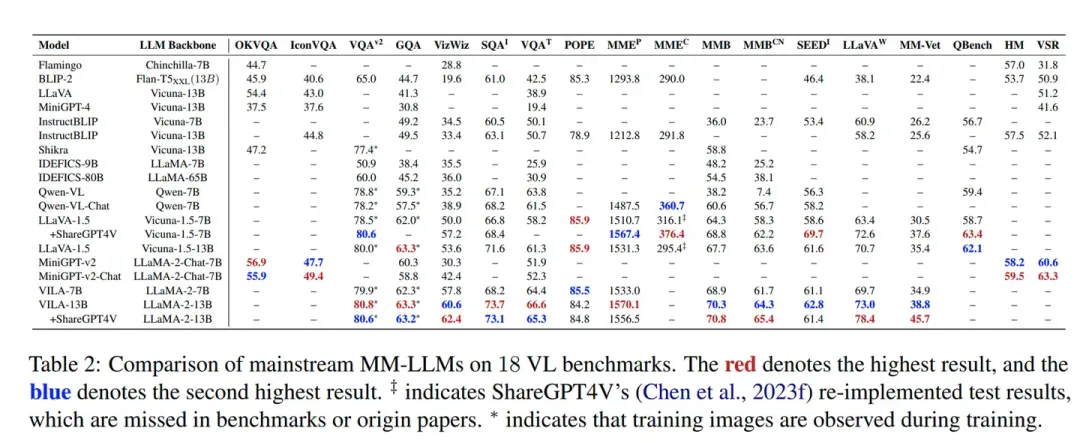

性能评估

性能评估旨在通过一系列标准化的基准测试来衡量和比较不同MM-LLMs的性能。这些基准测试覆盖了多种任务,包括但不限于图像-文本理解、视频-文本理解和音频-文本理解。

基准测试选择

论文中提到了18个主要的VL基准测试,这些基准测试包括OKVQA、IconVQA、VQAv2、GQA等,每个测试都针对特定的多模态任务设计,能够全面评估模型在不同方面的性能。

评估标准

- 准确性:模型回答问题或完成任务的准确度。

- 鲁棒性:模型在面对不同类型或困难的输入时的表现。

- 泛化能力:模型对未见数据的适应能力。

模型表现

论文中对多个MM-LLMs在上述基准测试中的表现进行了比较。例如,对于图像-文本理解任务,BLIP-2、LLaVA和MiniGPT-4等模型在不同的基准测试上展示了它们的能力。

关键训练方法

为了提高MM-LLMs的效能,论文总结了一些关键的训练方法,包括:

- 数据增强:通过增加数据的多样性来提高模型的泛化能力。

- 模态融合:改进不同模态之间的信息融合策略,以提高理解能力。

- 指令微调:使用特定任务的指令来微调模型,提高其对特定任务的适应性。

未来方向

更通用和智能的模型(More General and Intelligent Models)

- 扩展模态(Expanding Modalities):探索将MM-LLMs扩展到更多模态,如网页、热图、图表等,以提高模型的通用性和适用性。

- 多样化的LLMs(Diversifying LLMs):使用不同类型的LLMs,为特定需求提供选择最合适模型的灵活性。

- 提高多模态指令微调数据集质量(Improving MM IT Dataset Quality):改进和扩展现有的MM IT数据集,以提高模型理解和执行用户指令的有效性。

- 加强多模态生成能力(Strengthening MM Generation Capabilities):虽然当前的MM-LLMs主要关注多模态理解,但提高生成响应的质量也是重要的研究方向。

更具挑战性的基准测试(More Challenging Benchmarks)

现有的基准测试可能不足以充分挑战MM-LLMs的能力,需要构建更具挑战性、更大规模的基准测试,涵盖更多模态,并采用统一的评估标准。

移动/轻量级部署(Mobile/Lightweight Deployment)

为了在资源受限的平台上部署MM-LLMs并实现最佳性能,需要轻量化实现。例如,MobileVLM通过战略性地缩小LLaMA模型,实现了无缝的即插即用部署。

体现智能(Embodied Intelligence)

体现智能旨在通过有效理解环境、识别相关对象、评估空间关系和制定综合任务计划,复制类似人类的感知和与环境的交互。

持续学习(Continual Learning)

由于MM-LLMs的大规模训练成本,频繁重新训练是不可行的。因此,需要持续学习机制,使模型能够灵活地、持续地利用新数据,同时避免重新训练的高成本。

减少幻觉(Mitigating Hallucination)

幻觉问题涉及在没有视觉线索的情况下生成对不存在对象的文本描述。需要新的方法来减少这些幻觉,提高输出的可靠性。

偏见和伦理考虑(Biases and Ethical Considerations)

确保MM-LLMs的安全和有效应用至关重要。需要开发新的基准测试来评估MM-LLMs中的偏见,并设计更有效和细粒度的对齐方法。

本文转自 AI生成未来 ,作者:罗清雨