你的文生图模型可以秘密接收多模态提示了!南洋理工&腾讯最新提出EMMA

文章链接:https://arxiv.org/pdf/2406.09162

git链接:https://tencentqqgylab.github.io/EMMA

图像生成的最新进展使得从文本条件创建高质量图像成为可能。然而,当面对多模态条件(如文本结合参考外观)时,现有方法难以有效平衡多种条件,通常表现出对某一种模态的偏好。为了解决这一挑战,引入了EMMA,这是一种基于最先进的文本到图像(T2I)扩散模型ELLA构建的新型图像生成模型,能够接受多模态提示。EMMA通过一种创新的多模态特征连接器设计无缝结合文本和其他模态信息,引导图像生成。该设计使用了一种特殊的注意机制,有效整合了文本和补充模态信息。

通过冻结原T2I扩散模型中的所有参数,只调整一些附加层,发现了一个有趣的现象,即预训练的T2I扩散模型实际上可以接受多模态提示。这一有趣的特性便于适应不同的现有框架,使得EMMA成为一个灵活有效的工具,用于生成个性化和情境感知的图像甚至视频。此外,本文引入了一种策略来组合已学习的EMMA模块,以同时生成基于多模态条件的图像,消除了需要对混合多模态提示进行额外训练的需求。大量实验表明,EMMA在保持生成图像的高保真度和细节方面效果显著,展示了其作为高级多模态条件图像生成任务的强大解决方案的潜力。

主要贡献如下:

- 多模态提示的创新集成机制:本文引入了EMMA,这是一种开创性的方式,将多模态提示的特征融合到图像生成过程中,同时不影响文本控制。本文的方法显著增强了图像生成的灵活性和适用性,能够实现多种模态之间的协同交互。这一创新允许在多种输入条件下生成高质量的图像。

- 模块化且高效的模型训练:本文的框架便于根据不同模态进行模型的模块化组装,从而简化了流程,在引入新条件时无需重新训练。这种高效的训练程序节省了资源,加快了模型适应新任务的速度。

- 通用兼容性和适应性:EMMA作为即插即用模块,可无需微调即适用于各种现有和新兴的模型,包括各种图像和视频生成应用。它与Stable Diffusion框架及其他模型的兼容性增强了其在不同领域的实用性。

- 稳健的性能和细节保留:通过实验,确认了EMMA模型对各种控制信号的稳健性,确保在生成图像时保留文本和视觉细节。模型的架构设计具有可扩展性和灵活性,能够适应广泛的条件和应用,同时保持高保真度和高质量。

方法

模型架构

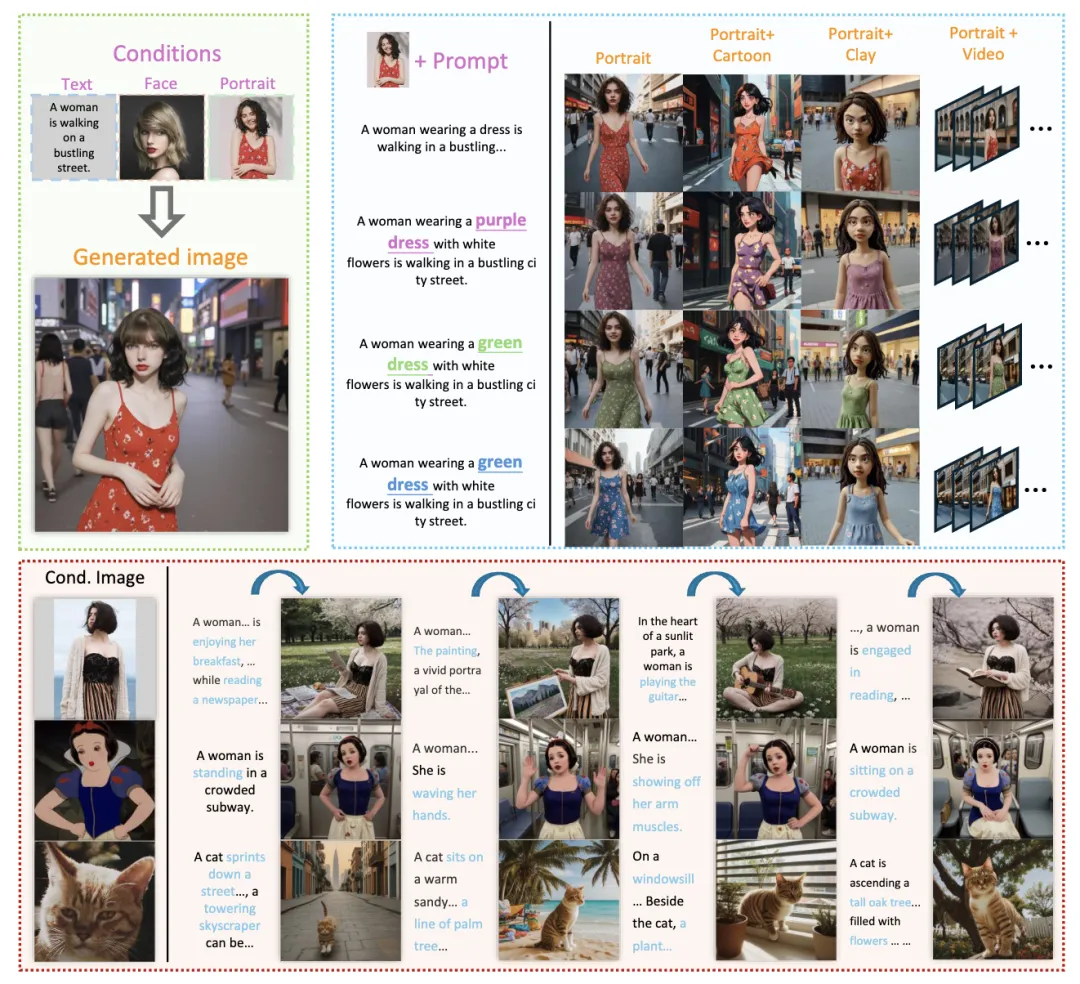

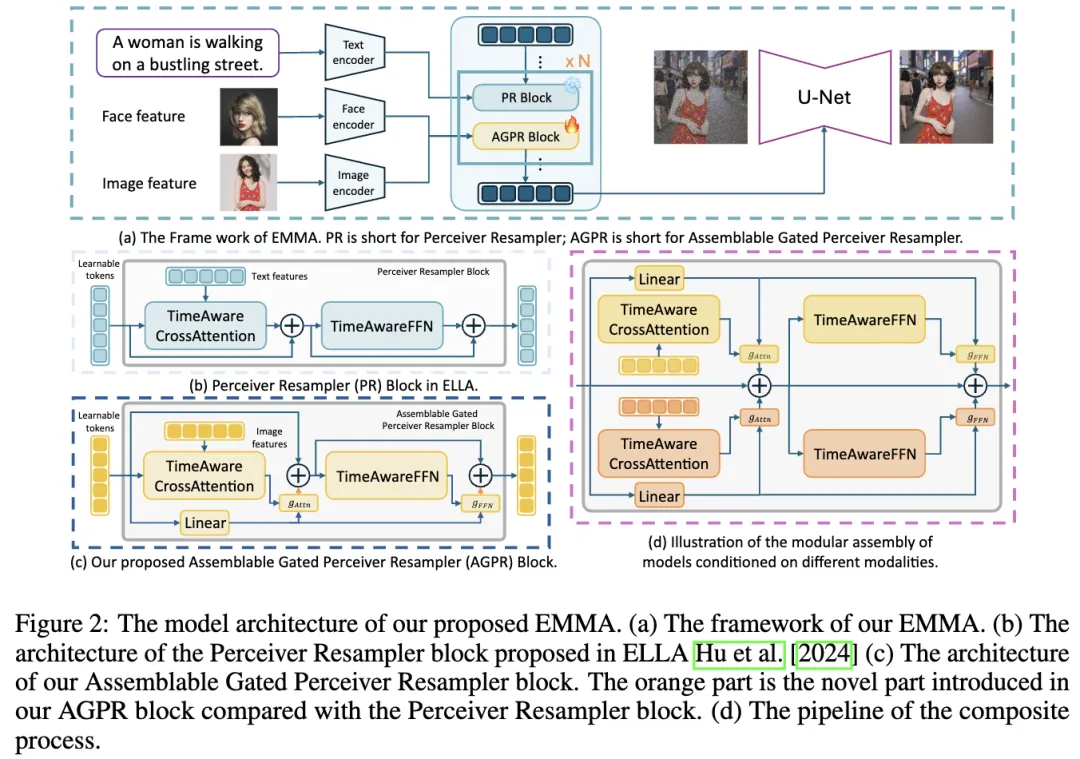

EMMA 的整体流程如下图2(a)所示。本文的模型条件包括两个方面。一是文本特征,另一是自定义图像特征,例如视觉剪辑特征或面部embedding。

在 EMMA 中,通过 ELLA提出的 Perceiver Resampler 块注入文本特征,如上面图 2(b) 所示。图像特征通过新提出的模块 Assemblable Gated Perceiver Resampler 感知,如图 2 (c) 所示。

具体来说,将EMMA分为三个主要组件,并详细描述它们。

文本编码器:配备了T5以理解丰富的文本内容。先前的研究表明,T5 擅长提取文本特征,使其非常适合为下游任务提供文本特征。

图像生成器:在图像生成领域,众多研究人员和从业者根据其具体目标和数据类型微调了各种模型。研究者们致力于使最终网络确保特征的泛化,从而最大限度地利用社区中常见的高质量模型。

多模态特征连接器:网络架构如上图2所示。借鉴 Flamingo和 ELLA 的灵感,连接器由两个交替堆叠的网络模块组成:Perceiver Resampler 和 Assemblable Gated Perceiver Resampler。Perceiver Resampler 主要负责整合文本信息,而 Assemblable Gated Perceiver Resampler 旨在整合其他信息。这些网络模块使用注意力机制将多模态信息同化为可学习的token embedding,然后作为条件提供给 U-net。定义这些模块如下。连接器包含 K 个可学习token,表示为 Latent。时间embeddings、文本特征和附加条件分别表示为 t、T 和 C。

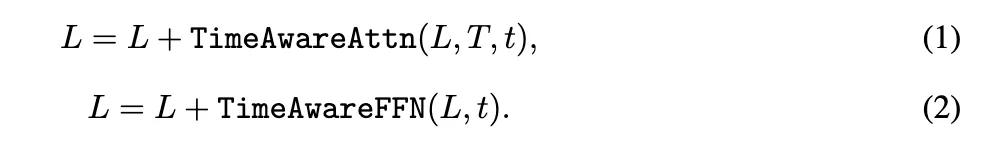

Perceiver Resampler 块可以分为两个部分。

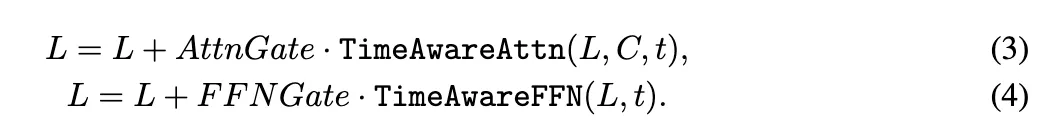

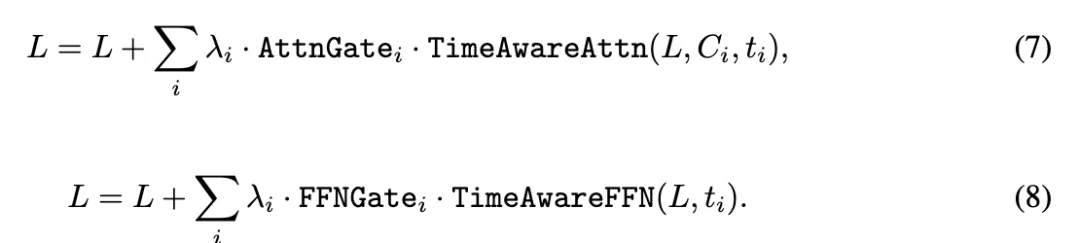

这里,TimeAwareAttn 和 TimeAwareFFN 是自定义的注意力和前馈神经网络 (FFN) 模块,使用 AdaLN 将时间embedding整合到输入中。ELLA 已经证明了这种方法的优势。Assemblable Gated Perceiver Resampler 的公式类似。

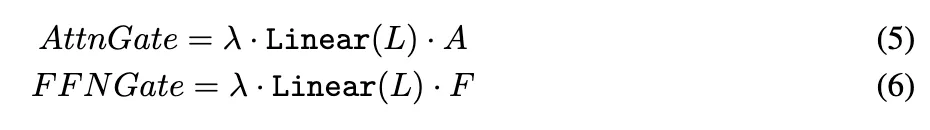

在这些方程中,AttnGate 和 FFNGate 是两组用于调节特征整合的门控。它们的定义如下。

这里,λ 是门控比例,一个固定的超参数,A 和 F 是全局门控。Linear(L) 是可分离门控。

多条件图像生成

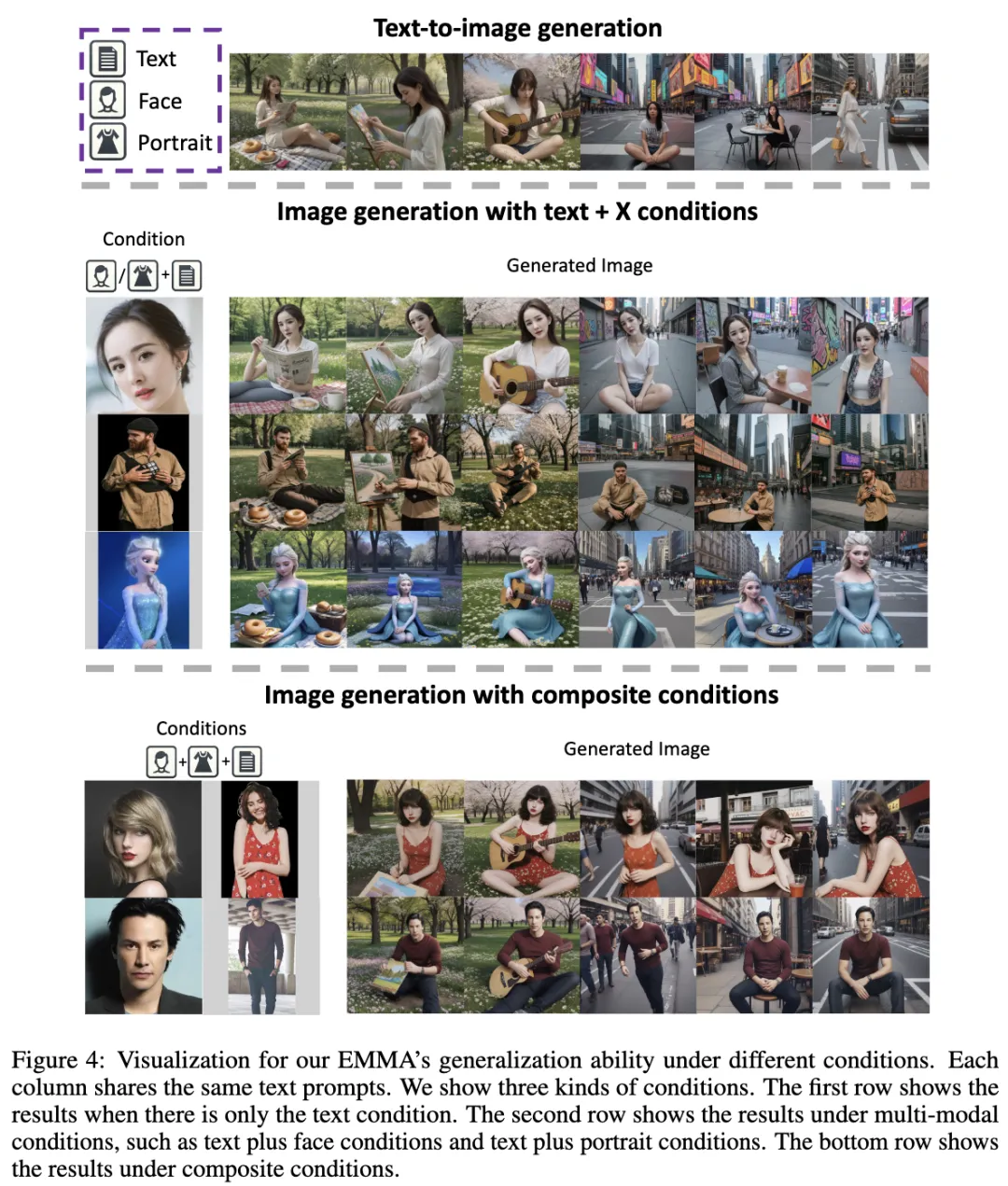

开发文本生成图像能力。通过 ELLA 的训练范式,开发了一个具备强大文本生成图像能力的模型。如图4 第一行所示,ELLA 可以生成严格遵循指令的图像,这构成了 EMMA 多模态指导的基础。

选择性模块化特征训练。为了增强训练过程的稳定性和最终性能,在网络架构中集成了几个创新设计元素。例如,Perceiver Resampler 和 Assemblable Gated Perceiver Resampler 之间的交替结构旨在限制网络中间层的特征空间。这可以防止图像信息传递过多的先验知识,可能会削弱文本的控制力并破坏最终的生成结果。Assemblable Gated Perceiver Resampler 包含分离的门控,使得可以将额外的特征整合到几个可训练的embedding中。

多条件图像生成模块的组装。在为每个单独的条件建立强大模型之后,设计了一种创新方法,使模型能够整合现有模块并生成受多个因素约束的图像。如图所示,集成了 Assemblable Gated Perceiver Resampler。无需额外训练,模型可以合成所有输入条件并生成新颖的输出。这表明在不依赖预先存在的训练数据集的情况下进行图像生成的潜力。

这个过程可以用数学表达式表示为:

以这种方式,可以在无需进一步训练的情况下,将各种条件应用于图像生成过程。

实验

定量评估

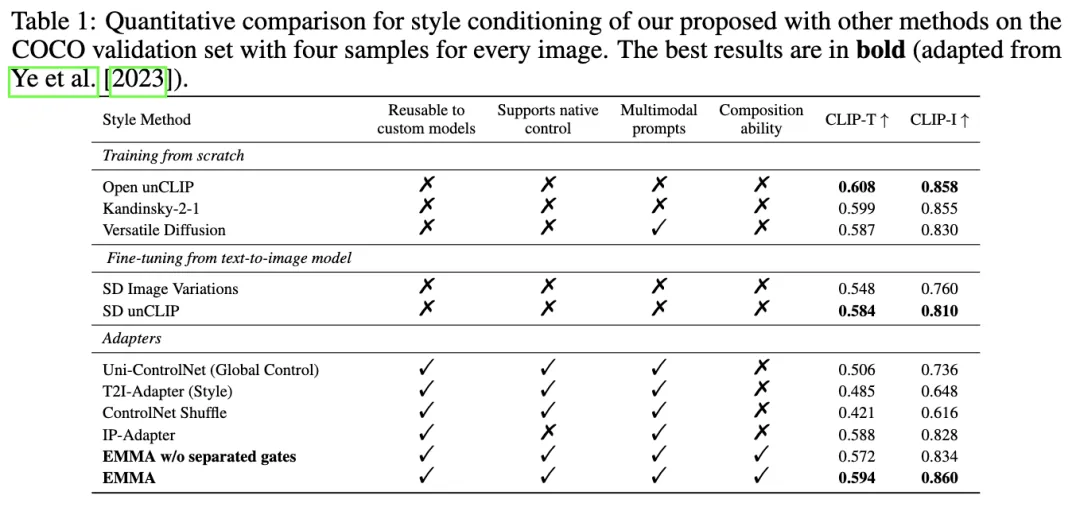

风格条件生成。根据 IP-Adapter的评估设置,评估了所有方法在 COCO 验证集上的 CLIP-T 和 CLIP-I 分数。验证集中有 5000 个提示。按照 IP-Adapter的描述,为每个提示生成四张图像。

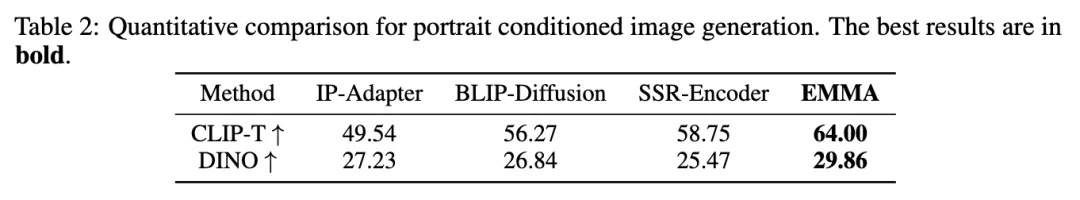

肖像生成。研究者们收集了一个肖像数据集,并基于 ActivityNet 验证集构建了 20 个人体动作提示。在此基础上,测试了各种主体驱动的图像生成方法的生成能力,并使用 CLIP-T 分数和 DINO 分数指标评估了结果。结果如下表 2 所示,本文提出的 EMMA 相较于之前的方法获得了最高分数。

可分离门控机制。如下表 1 所示,比较了在有和没有分离门控的风格条件下训练的 EMMA 模型。带有分离门控的 EMMA 表现更好,这是因为这种设计对不同的token embedding引入了更细粒度的控制。

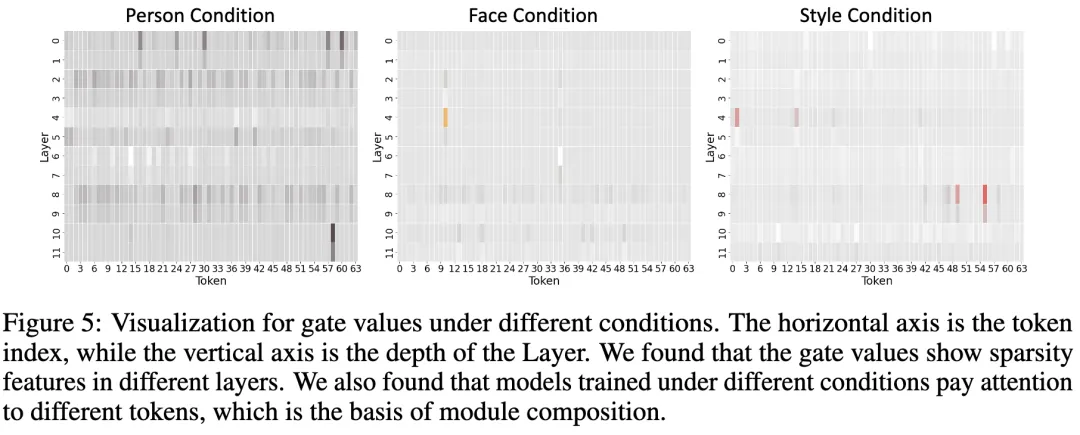

如图 5 所示,在特定条件下,不同的tokens 起到不同的作用。没有分离门控的情况下,生成的结果很容易受到不相关token embeddings的影响。

可视化

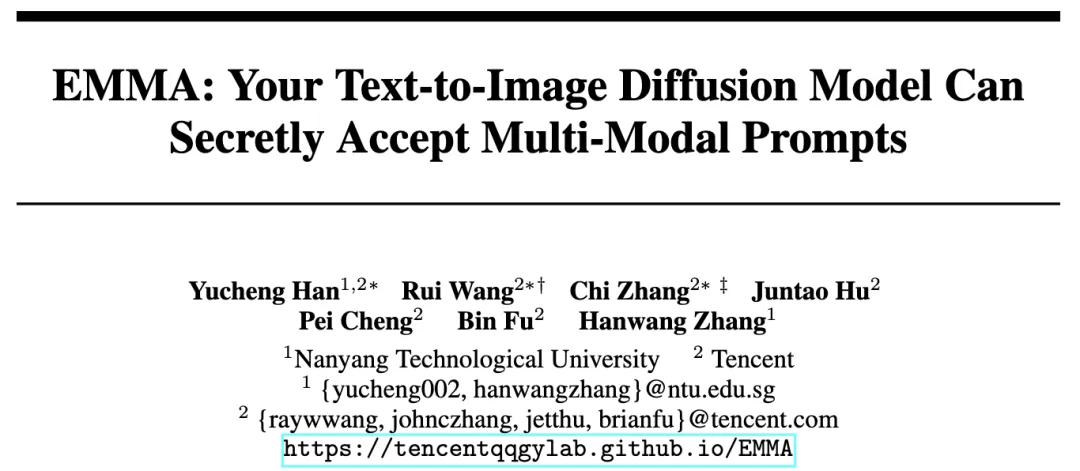

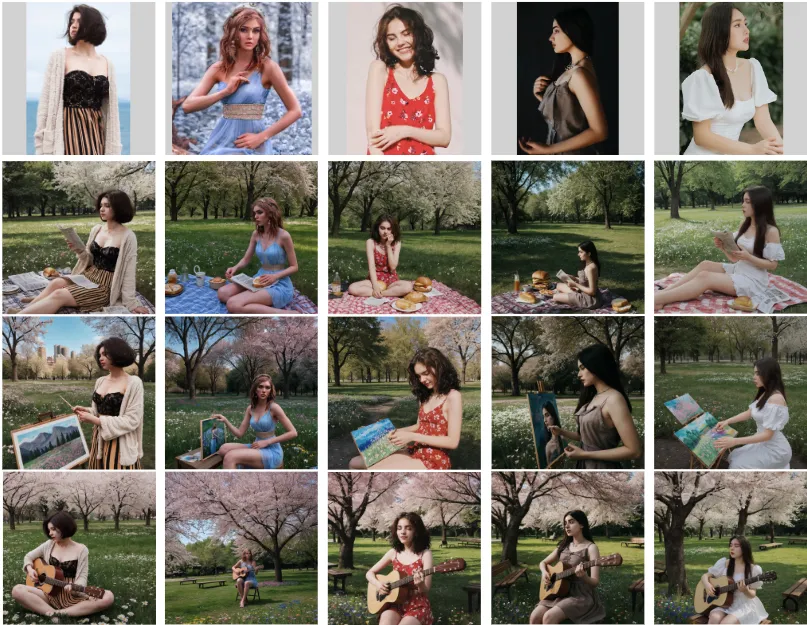

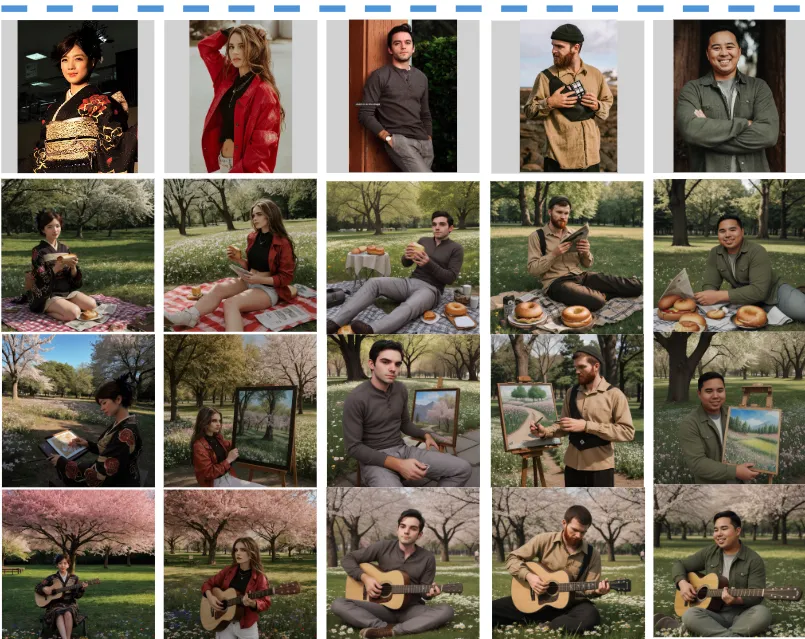

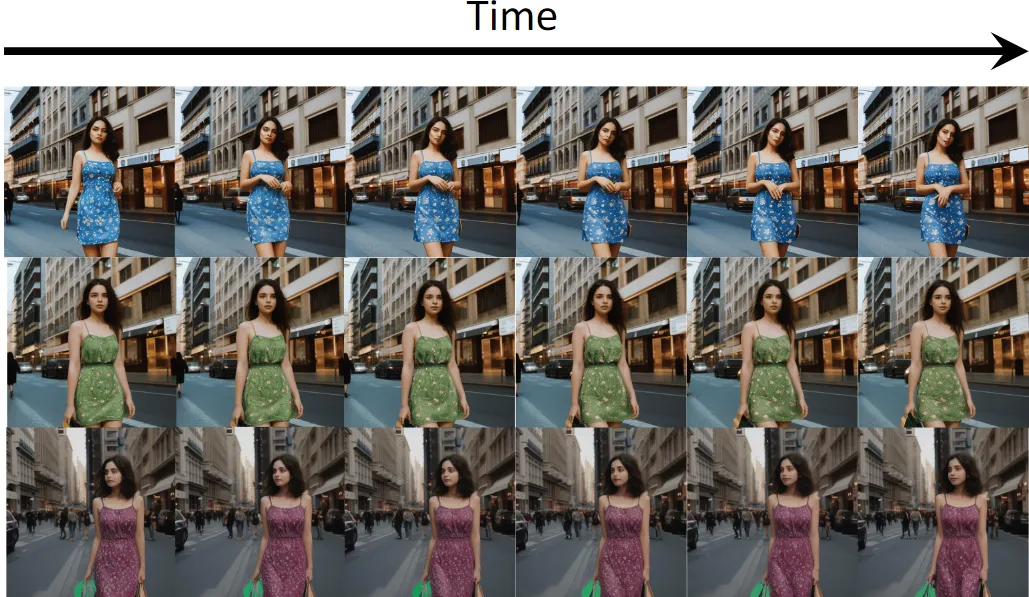

不同条件下的肖像创建。展示了各种肖像生成的结果。如前面图4 所示,本文的方法在保持关键图像元素(如衣物)方面表现出色,并且严格遵循文本指令。第一行展示了文本生成图像的输出,描绘了一位女性在不同场景中从事各种活动。中间行展示了多模态图像生成的结果,附加条件如面部或肖像特征生成了符合给定指令的角色图像。最后一行展示了复合条件图像生成,可以生成既遵循指令又保留一张图像中的面部特征和另一张图像中的肖像元素的图像。

门控值可视化。在本文提出的 EMMA 中,门控设计是一个关键模块,允许在模型内自由组合。该设计引入了更多的模型参数,增强了模型的表达能力。此外,研究者们观察到不同模型中显著门控值的tokens 索引分布具有独特的模式。tokens 索引分布的这种独特模式对于本文方法的适应性至关重要,能够实现灵活和不受限制的模型集成。可视化结果如上面图 5 所示。

结论

本文提出了 EMMA,一种多模态图像生成模型,具有革新从多种条件生成图像方式的潜力。通过独特的多模态特征连接器集成文本和附加模态,EMMA 在图像生成的真实度和细节上达到了现有方法无法匹敌的水平。其模块化设计允许轻松适应各种框架。此外,EMMA 可以组合现有模块以同时生成基于多种模态条件的图像,消除了额外训练的需要。EMMA 为个性化图像生成提供了高效且适应性强的解决方案。

总之,EMMA 在图像生成方面的创新方法为平衡多种输入模态设立了新的基准。随着生成模型领域的不断发展,EMMA 有望成为开发更复杂和用户友好技术的基石,推动 AI 驱动内容创作的下一波创新。

限制。当前版本的 EMMA 只能处理英文提示。未来,研究者们将尝试在支持多语言提示的扩散模型中实现相同的算法。

本文转自 AI生成未来 ,作者:Yucheng Han等