RAG生成任务:Base LLM竟然比Instruct LLM高出20%

检索增强生成(RAG)将检索阶段与生成阶段结合起来,后者通常由大型语言模型(LLMs)驱动,RAG中的当前常见实践是使用“指导”的LLMs,这真的是最优选择吗?

对RAG系统中的“instruct”模型及其模板与基础版本(base)进行了原则性评估。这些“instruct”模型通常经过监督训练来提高遵循指令的能力,并使用最先进技术与人类偏好对齐。使用了两个任务指令来评估模型,任务指令I要求模型从未提供的文档中提取答案,任务指令II要求模型提供证据来支持其答案。

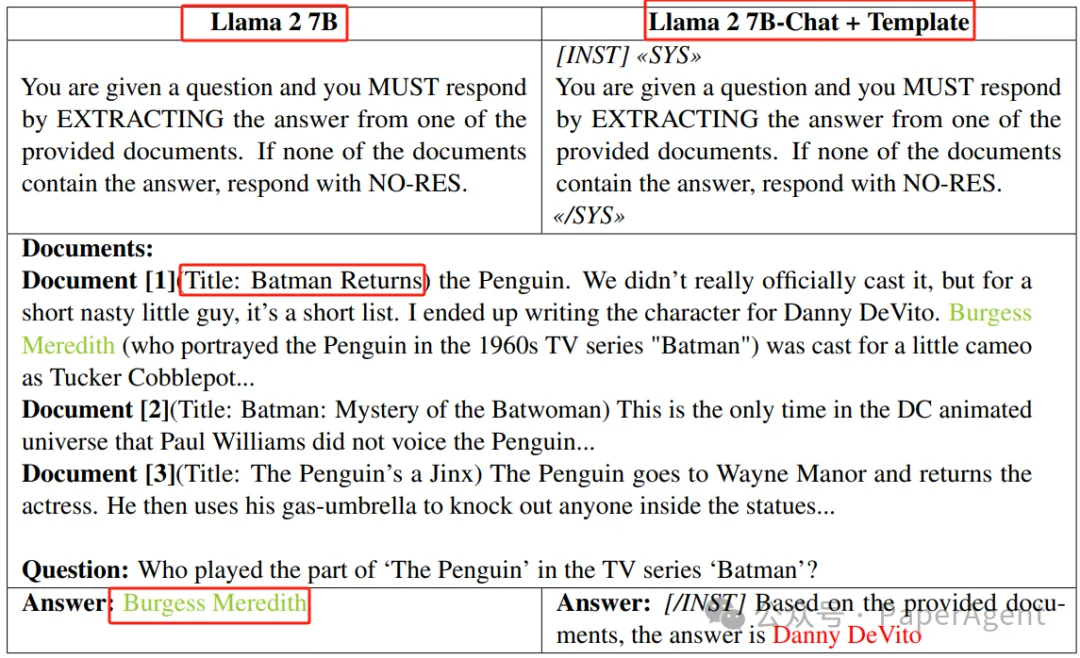

在TriviaQA上的任务指令I下,基础版与指导+模板版之间的比较。该图展示了两个版本的Llama 2 7B模型生成的回答之间的比较:基础版和指导+模板版。每个版本都被赋予了基于提供文档回答同一问题的任务。基础模型正确地识别出答案为“Burgess Meredith”,而指导+模板版错误地将答案归因于“Danny DeVito”。斜体文本表示模板

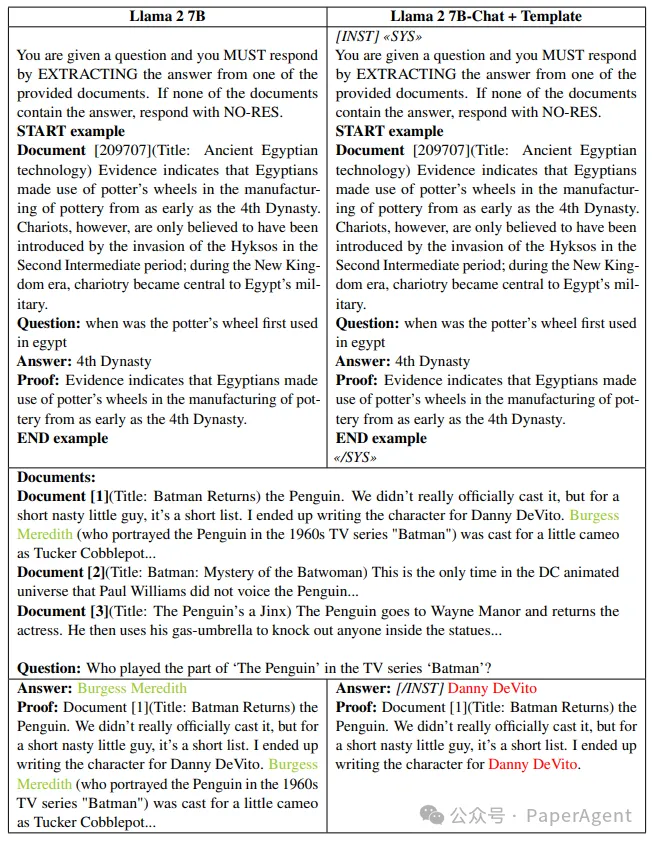

在TriviaQA上的任务指令II下,基础版与指导+模板版之间的比较。这种比较展示了Llama 2 7B的基础版和指导+模板版生成的回答之间的一个例子,其中基础模型正确地识别了答案,而指导+模板版错误地将答案归因于不同的演员。尽管如此,在两种情况下,答案都与证据“一致”,因为每项证据都包含了生成的答案。斜体文本表示模板。

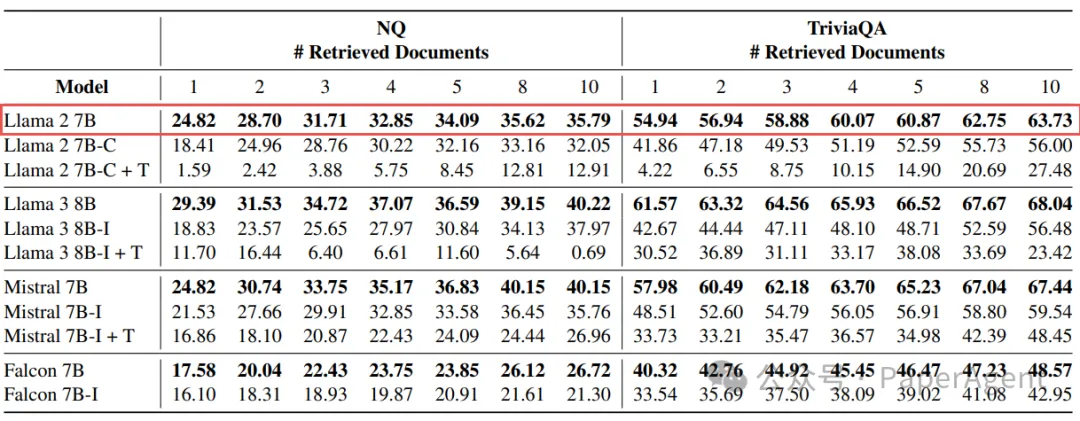

实验结果显示,在RAG任务中,基础模型在没有额外的指令特定微调的情况下,平均性能比“instruct”模型高出20%。这一发现挑战了关于“instruct”LLMs在RAG应用中优越性的普遍假设。进一步的调查揭示了更复杂的情况,提出了对RAG和评估程序的更广泛讨论的需求。

在NQ和TriviaQA上任务指令I的准确度。缩写C和I分别表示指导模型的聊天版和指导版。后缀T表示使用模板来构建其回答的指导模型。准确度是在不同检索文档级别的报告。除了部分例外的Mistral,所有基础模型在性能上都大幅度超过了它们的指导版本。

在NQ和TriviaQA上,需要提供证明的任务指令II的准确度。缩写C和I分别表示指导模型的聊天版和指导版。后缀T表示使用模板来构建其回答的指导模型。准确度是在不同检索文档级别的报告。在所有考虑的情况下,基础模型在性能上都大幅度超过了它们的指导版本。

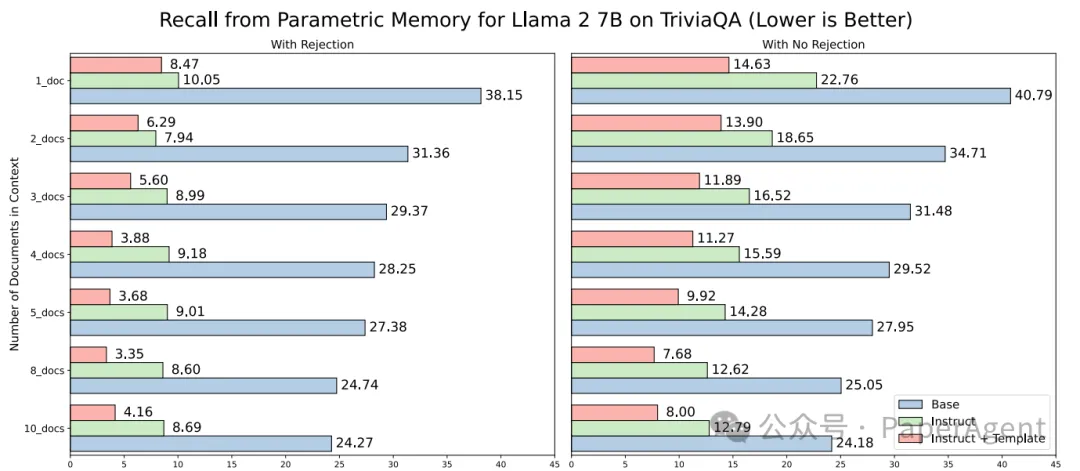

尽管“instruct”模型在遵循任务指令方面更为有效,但它们在准确拒绝回答(即当检索文档中不包含答案时回答NO-RES)方面的表现不如基础模型(备注:这地方的结论貌似与实验数据不匹配,有需要小伙伴自行评测哈)。此外,当不要求模型在答案不出现在检索文档中时回答NO-RES时,基础模型仍然表现更好,这表明监督微调和对齐过程可能对模型在RAG任务中的能力产生了负面影响。

从参数化记忆中回忆 - Llama 2 7B - TriviaQA。报告的是参数化记忆回忆率,定义为模型在检索文档不包含正确答案的情况下仍能正确回答的实例数,除以答案不在上下文中出现的次数。(左)如图1所示的任务指令I;(右)无拒绝设置,即不指定在检索文档中不包含答案时回答NO-RES(如图6所示的示例)。在这种情况下,两个模型版本的参数化记忆回忆率都有所提高。

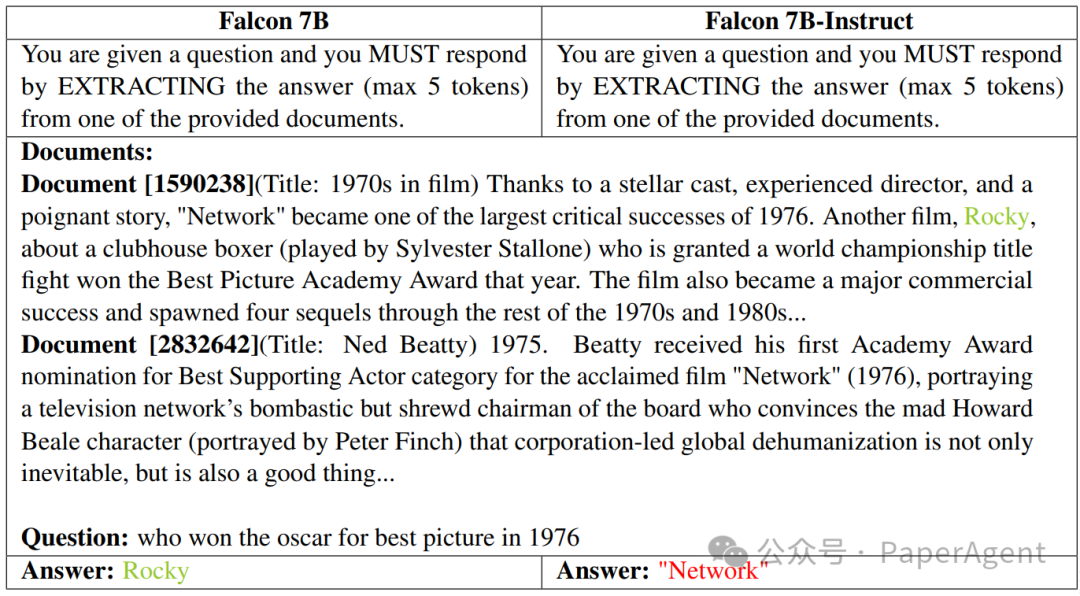

图6:在NQ上,任务指令I下的基础版与指导版,不允许拒绝回答。这张图展示了在不允许拒绝回答的设置下的回答情况,即模型不需要在检索文档中不包含答案时回答NO-RES。它比较了Falcon 7B的基础版和指导版。基础模型准确地识别出“Rocky”(洛奇)是1976年奥斯卡最佳影片奖的获奖者,而指导版错误地引用了“Network”(电视台)。

在整个RAG流程中,除了Generation,还涉及Embedding、Indexing等等,PaperAgent团队RAG专栏进行过详细的归纳总结:高级RAG之36技(术),可私信留言试看:RAG专栏。

本文转载自PaperAgent