字节豆包全新图像Tokenizer:生成图像最低只需32个token,最高提速410倍 精华

在生成式模型的迅速发展中,Image Tokenization 扮演着一个很重要的角色,例如Diffusion依赖的VAE或者是Transformer依赖的VQGAN。这些Tokenizers会将图像编码至一个更为紧凑的隐空间(latent space),使得生成高分辨率图像更有效率。

然而,现有的Tokenizer通常会将输入图像映射为隐空间的一个降采样后的2D矩阵,这一设计隐式的限制了token与图像之间的映射关系,导致其很难有效的利用图像中的冗余信息(比如相邻的区域经常会有类似的特征)来获得一个更加有效的图像编码。

为了解决这一问题,字节跳动豆包大模型团队和慕尼黑工业大学提出了全新的1D图像Tokenizer:TiTok,这一Tokenizer打破了2D Tokenizer的设计局限,可以将整个图片压缩至更为紧凑的Token序列。

- 论文链接:https://arxiv.org/abs/2406.07550

- 项目链接:https://yucornetto.github.io/projects/titok.html

- 代码链接:https://github.com/bytedance/1d-tokenizer

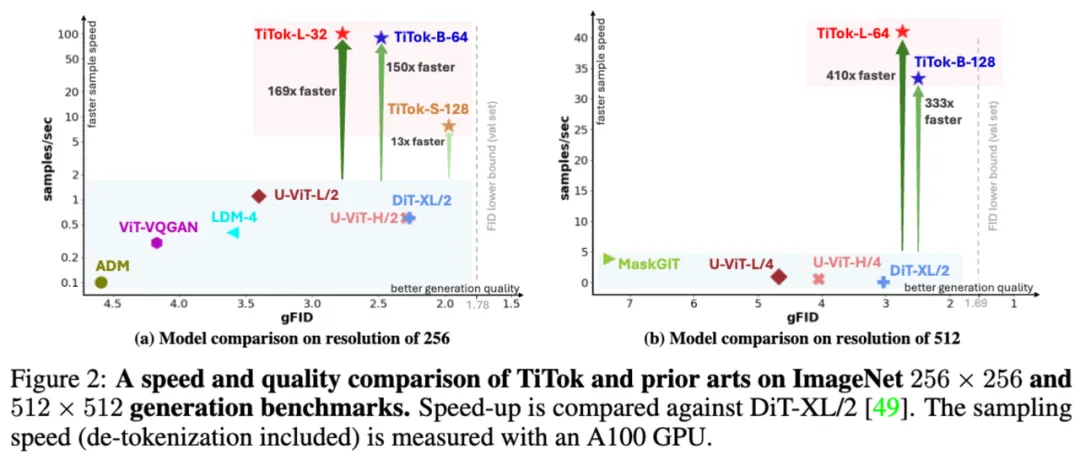

对于256 x 256分辨率的图片,TiTok最少仅需32个Token就可以表达,比通常2D Tokenizer的256或1024个Token显著减少。对于512 x 512分辨率的图片,TiTok最少仅需64个Token,64倍小于Stable Diffusion的VAE Tokenizer。此外,在ImageNet图像生成这一任务上,使用TiTok作为Tokenizer的生成器在生成质量和生成速度上都有显著提高。

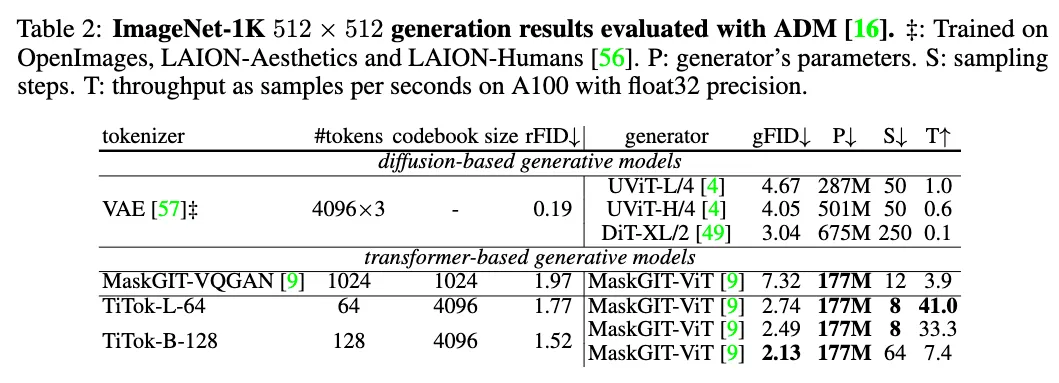

在256分辨率,TiTok获得了1.97的FID,显著超过使用同样生成器的MaskGIT 4.21。在512分辨率TiTok可以获得2.74的FID,不仅超过了DiT(3.04),并且相比DiT在图像生成上加速了惊人的410倍!TiTok的最好变种取得了2.13的FID,显著超过DiT的同时仍旧有着74倍的加速。

TiTok仅用32个Token就可以完成高质量的图像重建与生成

图像所需Token的显著减少带来了明显更快的生成速度,但是同时维持了高质量的图像生成。

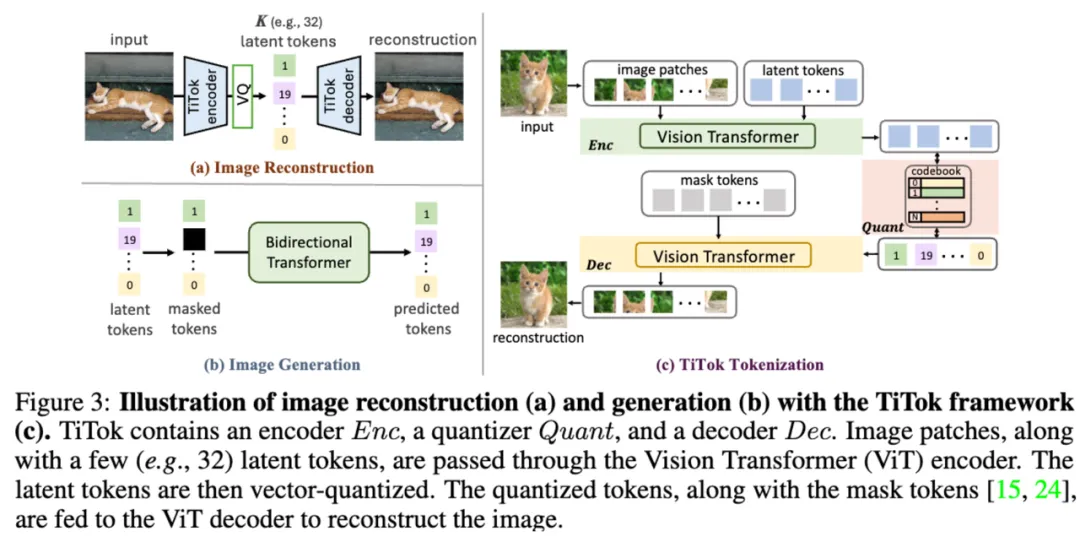

模型结构

TiTok的结构非常简单,编码器和解码器部分各自是一个ViT,在编码过程中,一组latent tokens会拼接在image patches后,在过完编码器后,仅保留latent tokens并进行quantization的过程。获得的quantized latent tokens将会与一组mask tokens拼接在一起,一并送入解码器,从mask token序列中重建出图像。

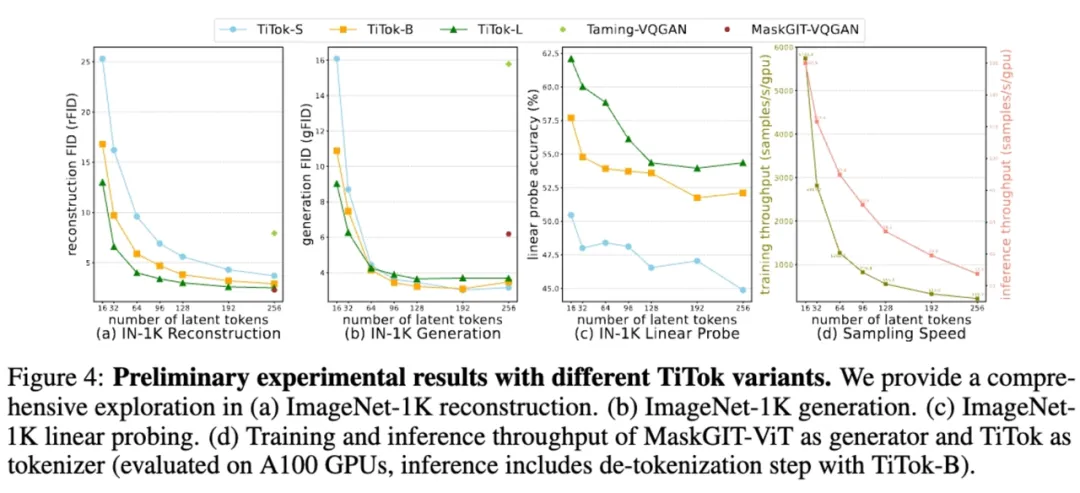

1D Tokenization 性质研究

研究者进行了一系列实验研究关于不同数量的用于表示图像的token,不同的tokenizer大小,重建表现,生成表现,linear probing准确率,以及训练和推理速度的比较。在这一过程中,研究者发现(1)仅需32个Token便能取得很好的重建与生成效果(2)通过增大Tokenizer的模型大小,研究者可以使用更少的Token来表示图片(3)当图片使用较少的Token来表示时,Tokenizer会学到更强的语义信息(4)使用更少的Token来表示图片时,训练和推理速度都有了显著的提升。

此外,视频中展示了使用不同的Tokenizer大小以及Token数目时所重建出的图片,可以看到更大的Tokenizer可以在有限的Token下重建出质量更好的图像。此外,当仅有有限Token时,模型更倾向于保留显著区域有更好的重建效果。

实验验证

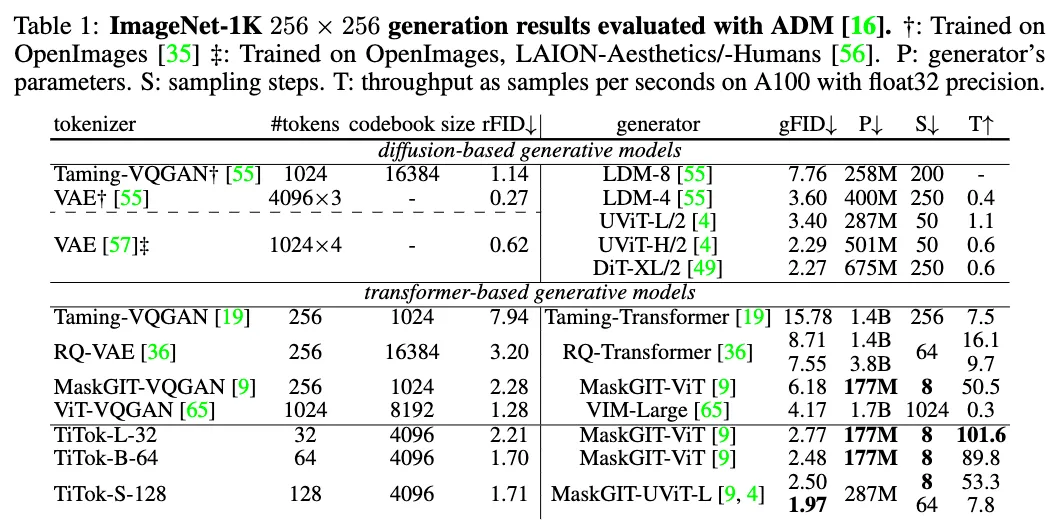

研究者主要在ImageNet-1k的256 x 256分辨率以及512 x 512分辨率上进行了与其他方法的比较。可以看到,尽管TiTok使用有限的Token数目,但是可以和其他使用更多Token的方法取得相当的重建效果(rFID),使用较少的Token数目让TiTok在维持较高的生成图片质量(gFID)的同时有着显著快于其他方法的生成速度。

例如TiTok-L-32获得了2.77的gFID score,同时可以以每秒101.6张图片的速度进行图片生成,这一速度显著快于其他Diffusion Models (169倍快于DiT)或者Transformer Models (339倍快于ViT-VQGAN).

TiTok使用较少Token的优势在更高分辨率的图像生成上更加明显,其中TiTok-L-64仅使用64个Token就能完成高质量的512分辨率图像的重建与生成,生成图像的质量不仅高于DiT (2.74 v.s. 3.04),同时生成速度提高了近410倍。

结论

在本文中,研究者专注于一个全新的1D Image Tokenizer,并提出了一种全新的Tokenizer来打破现有2D Tokenizer中的局限,进而更好的利用图像中的冗余信息。TiTok仅需少量的Token(比如32个)来表示图像,同时仍旧能进行高质量的图像重建与生成。在ImageNet的256分辨率和512分辨率生成实验中,TiTok不仅取得了超过Diffusion Models的生成质量,同时有着百倍更快的生成速度。

本文转自 机器之心 ,作者:机器之心